Introduzione

L'intelligenza artificiale sta trasformando il panorama delle frodi finanziarie in modi senza precedenti. All'inizio del 2024, i truffatori hanno usato deepfakes generati dall'intelligenza artificiale per impersonare i dirigenti in una videochiamata, inducendo un impiegato di Hong Kong a trasferire $25 milioni ai truffatori[1][2]. Episodi come questo dimostrano come l'IA generativa stia consentendo ai criminali di creare truffe altamente convincenti che prendono di mira le banche e i loro clienti. Le autorità di regolamentazione stanno lanciando l'allarme: la FinCEN del Tesoro degli Stati Uniti ha emesso un avviso alla fine del 2024, mettendo in guardia dall'aumento delle frodi che utilizzano media "deepfake" generati dall'IA, tra cui documenti d'identità falsi per aggirare le verifiche bancarie.[3][4]. Questo whitepaper esamina le ultime novità Tendenze delle frodi AI nei servizi finanziari e discutiamo di come le istituzioni possano rafforzare le loro difese. Esploriamo come i truffatori si stiano armando di IA generativa - dalle impersonificazioni deepfake alle identità sintetiche - e delineiamo la tecnologia e le strategie (tra cui strumenti di rilevamento avanzati come TruthScan) che i team antifrode e i dirigenti possono impiegare per contrastare questa minaccia in evoluzione.

Principali tendenze delle frodi dell'intelligenza artificiale nei servizi finanziari

L'intelligenza artificiale e l'apprendimento automatico vengono sfruttati dai malintenzionati per condurre frodi sempre più sofisticate e su larga scala. Notevole Tattiche di frode guidate dall'intelligenza artificiale che impattano sulle banche, sulle fintech e sugli assicuratori:

- Truffe di impersonificazione Deepfake: I criminali usano Video e audio generati dall'intelligenza artificiale per impersonare persone fidate (CEO, clienti, ecc.) in tempo reale. Ad esempio, le voci realistiche di deepfake sono state utilizzate negli attacchi di vishing (phishing vocale) per autorizzare bonifici fraudolenti e i video creati dall'intelligenza artificiale hanno ingannato i dipendenti facendogli approvare transazioni false.[1][5]. Questi mezzi di comunicazione sintetici rendono difficile sapere se si sta parlando davvero con la persona che si pensa di essere, rendendo possibili rapine di alto valore come il caso $25M deepfake di cui sopra. I deepfake stanno diventando accessibile e facile da produrreche richiede solo 20-30 secondi di audio per clonare una voce o meno di un'ora per generare un video apparentemente autentico.[6].

- Phishing e BEC potenziati dall'intelligenza artificiale: L'intelligenza artificiale generativa sta mettendo il turbo agli schemi di ingegneria sociale, come le e-mail di phishing e le compromissione della posta elettronica aziendale (BEC). I chatbot AI sono in grado di redigere e-mail truffa altamente personalizzate in perfetto linguaggio commerciale, imitando lo stile di scrittura di un amministratore delegato o creando fatture false convincenti su larga scala. In effetti, strumenti sotterranei come FrodeGPT e VermeGPT (versioni non filtrate di ChatGPT) sono emerse per aiutare i criminali informatici ad automatizzare la creazione di phishing e malware.[7][8]. Ciò significa che un aspirante truffatore con competenze minime può generare campagne di phishing o codice maligno con facilità. Con l'intelligenza artificiale, un singolo criminale può inviare migliaia di e-mail o messaggi di testo truffaldini su misura, aumentando notevolmente la portata dei tentativi di frode tradizionali. Il Centro criminalità su Internet dell'FBI ha già osservato oltre $2,7 miliardi persi a causa di truffe BEC nel 2022, e l'IA generativa minaccia di far lievitare ulteriormente tali perdite nei prossimi anni.[9][10].

- Identità sintetiche e frodi documentali: L'intelligenza artificiale generativa sta alimentando un boom di frodi di identità sinteticheuno dei tipi di crimine finanziario in più rapida crescita[11][12]. I truffatori combinano dati personali veri e falsi per creare identità "Frankenstein", quindi utilizzano l'intelligenza artificiale per produrre documenti di supporto realistici - dai passaporti falsi, agli estratti conto bancari, alle buste paga...[7]. I generatori di immagini AI e gli strumenti di editing possono creare documenti d'identità e foto dall'aspetto autentico che superano un'ispezione casuale. Anche i controlli di vivacità o la verifica dei selfie possono essere potenzialmente sconfitti da immagini o video manipolati dall'intelligenza artificiale. Automatizzando la creazione di migliaia di personaggi falsi (ciascuno con foto del profilo, social media, ecc. generati dall'IA), i criminali possono aprire conti bancari o richiedere prestiti in massa e riciclare denaro o non pagare il credito. Le perdite derivanti dalle frodi di identità sintetiche sono state stimate in circa $35 miliardi nel 2023[13]e l'intelligenza artificiale generativa sta solo accelerando questa tendenza, rendendo le identità false più economiche e difficili da individuare.

- Frode ed evasione automatizzata: Oltre a creare contenuti falsi, l'intelligenza artificiale aiuta anche i truffatori massimizzare il successo dei loro schemi. I bot avanzati possono testare rapidamente i dati delle carte di credito rubate sui siti di e-commerce, utilizzando il ML per evitare i trigger di rilevamento. L'intelligenza artificiale può aiutare i criminali a identificare gli anelli più deboli della sicurezza di un'organizzazione o persino a sintetizzare le risposte vocali per eludere la verifica dell'identità basata sul telefono. Un'industria del dark web vende strumenti di IA "fraud as a service" a partire da $20.[14]. Questa democratizzazione delle capacità dell'IA significa che anche i criminali di basso livello possono lanciare attacchi fraudolenti altamente sofisticati. La corsa agli armamenti si estende all'elusione del rilevamento: i truffatori usano l'IA per sondare i sistemi antifrode delle banche e perfezionare il loro approccio fino a trovare un metodo che sfugga ai filtri.[15]. In breve, l'intelligenza artificiale sta permettendo di condurre frodi a una scala e a un'efficienza mai viste primasfidando le difese convenzionali.

Queste tattiche abilitate dall'intelligenza artificiale sono già proliferano ad un ritmo allarmante. Gli schemi di frode tradizionali, come la falsificazione di assegni o il phishing, esistono da anni, ma l'intelligenza artificiale ne sta aumentando il volume e il realismo. I dati raccontano una storia chiara: Le frodi AI sono in aumento.

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

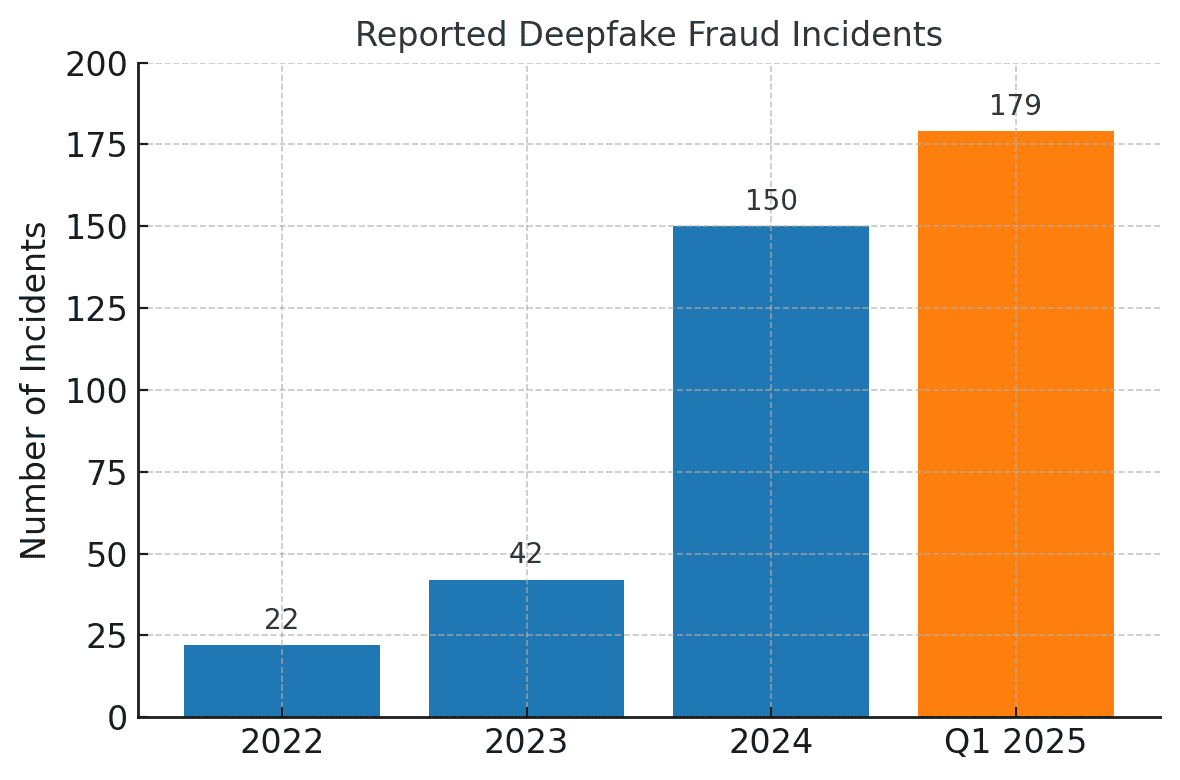

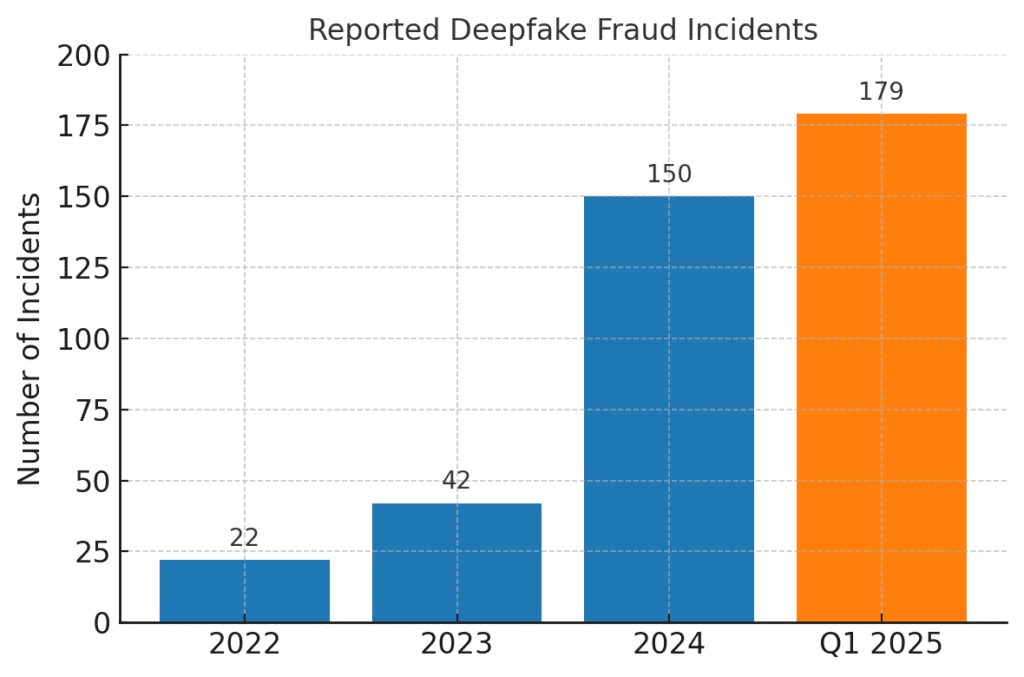

Gli incidenti di frode legati ai deepfake sono saliti alle stelle. Nel 2022 sono stati registrati solo 22 casi di frode deepfake, ma nel 2023 sono stati 42 e nel 2024 gli incidenti sono esplosi fino a 150. Solo nel primo trimestre del 2025, 179 episodi di frode deepfake sono stati segnalati, superando il totale di tutto il 2024.[16][17].

Recenti analisi del settore fanno eco a queste tendenze. Un rapporto ha rilevato un 700% aumento degli incidenti di deepfake che si rivolge alle imprese fintech nel 2023[18]. Ancora più sconcertante è il fatto che il Nord America abbia visto una 1.740% aumento dei casi di frode deepfake tra il 2022 e il 2023[19]. I criminali finanziari stanno adottando rapidamente questi strumenti perché funzionano: molte banche e vittime non sono ancora pronte a rilevare gli inganni generati dall'intelligenza artificiale.

Impatti e sfide per le istituzioni finanziarie

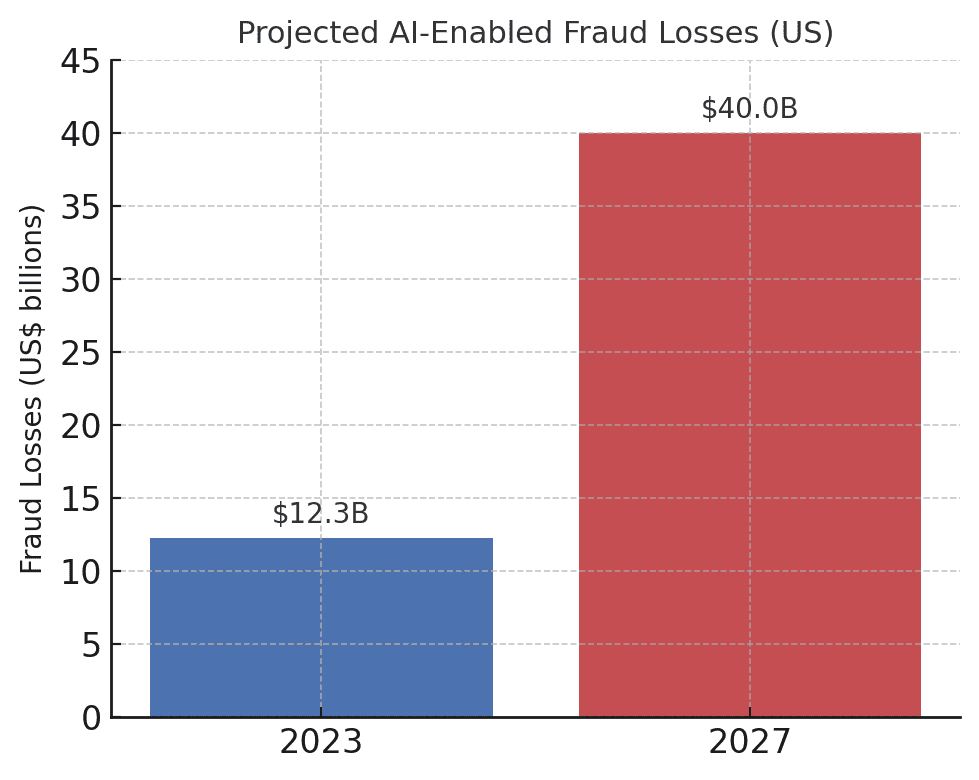

L'ascesa delle frodi guidate dall'intelligenza artificiale pone impatti significativi sulle istituzioni finanziarie, sui loro clienti e sul sistema finanziario in generale. L'impatto più immediato è la perdita monetaria. Le previsioni del settore prevedono che entro il 2027, le perdite di frodi grazie all'IA generativa potrebbero raggiungere $40 miliardi negli Stati Unitida $12,3 miliardi di euro nel 2023.[20]. Questo aumento più che triplicato (un 32% CAGR) riflette la velocità con cui il rischio di frode cresce in termini di dollari.

Le perdite previste per le frodi basate sull'IA stanno aumentando drasticamente. Deloitte stima che le perdite di frodi finanziarie statunitensi legate all'intelligenza artificiale generativa aumenteranno da Da $12,3 miliardi nel 2023 a $40 miliardi nel 2027[20].

Al di là delle perdite dirette, ci sono quelle reputazionali e di costi del trust. I consumatori si aspettano che le loro banche li proteggano, ma le truffe che utilizzano l'intelligenza artificiale stanno minando la fiducia nei canali digitali. Ad esempio, se un cliente è vittima di una truffa deepfake convincente (come una finta videochiamata di un banchiere), può incolpare la banca di una sicurezza inadeguata. Fiducia del pubblico nella verifica vocale, nelle e-mail e perfino nelle videoconferenze, può essere erosa se "ciò che si vede/sente" non può più essere considerato reale.[21]. Secondo i sondaggi, 85% dei professionisti della finanza negli Stati Uniti e nel Regno Unito considerano le truffe deepfake una minaccia "esistenziale" per la sicurezza della loro organizzazione.[22]. Più della metà delle aziende di questi mercati ha dichiarato di essere stata presa di mira da una truffa alimentata da deepfake, e in modo allarmante 43% delle persone prese di mira hanno ammesso che l'attacco è riuscito. nell'ingannarli[23]. Ogni incidente di successo non solo provoca un danno finanziario, ma intacca anche la fiducia dei clienti nell'istituto.

Anche le società finanziarie sono alle prese con sfide operative e di conformità dalle frodi AI. I team antifrode si trovano ad affrontare un'impennata di avvisi e incidenti, che mette a dura prova le risorse investigative. I modelli di rilevamento delle frodi esistenti (molti dei quali si basano su regole o su vecchie tecniche di apprendimento automatico) possono avere difficoltà a riconoscere i contenuti sintetizzati dall'IA che sembrano legittimi. Infatti, i sistemi di rilevamento deepfake all'avanguardia sviluppati in laboratorio vedono la loro accuratezza diminuire di quasi 50% quando si trovano di fronte a deepfakes del mondo reale in natura[24]. Il personale umano non se la cava molto meglio: alcuni studi hanno rilevato che le persone sono in grado di individuare video deepfake di alta qualità solo intorno a 55%-60% del tempo, appena meglio del caso[25]. Ciò indica che, senza nuovi strumenti, le banche non riusciranno a individuare gran parte dei tentativi di frode guidati dall'intelligenza artificiale.

C'è anche un dimensione normativa. Le autorità di regolamentazione e le forze dell'ordine sono consapevoli dei rischi (come dimostra l'allarme della FinCEN) e si aspettano che le istituzioni finanziarie si adattino. Le banche potrebbero trovarsi di fronte a linee guida più severe sulla verifica dei clienti e sulla segnalazione delle frodi nell'era dell'IA. Ad esempio, se un dipendente di una banca viene ingannato da un deepfake per approvare un trasferimento di $10 milioni, le autorità di regolamentazione potrebbero esaminare i controlli e i processi di due diligence della banca. Il Legge sul segreto bancario ora include esplicitamente la segnalazione di sospetti di criminalità informatica e di attività legate ai deepfake[26][4]Ciò significa che le banche devono addestrare il personale a riconoscere e segnalare gli indicatori di frode generati dall'IA nelle segnalazioni di attività sospette (SAR). Non riuscire a tenere il passo con le tecniche di frode potenziate dall'intelligenza artificiale potrebbe portare a violazioni della conformità o a responsabilità legali se i clienti o le controparti sostengono che la banca non ha fatto abbastanza per prevenire le truffe prevedibili abilitate dall'intelligenza artificiale.

Forse la sfida più grande è la natura asimmetrica di questa nuova minaccia. L'intelligenza artificiale generativa abbassa notevolmente i costi e le barriere di abilità per gli aggressori, aumentando al contempo in modo esponenziale il volume e il realismo degli attacchi. Una singola voce virale deepfake o una chiamata convincente di un clone vocale possono vanificare milioni di dollari di investimenti per l'autenticazione. Nel frattempo, i difensori devono verificare l'autenticità di ogni transazione e interazione, un compito molto più difficile. È una vera e propria corsa agli armamenti: L'intelligenza artificiale offre ai truffatori un kit di strumenti che si aggiornano da soli per aggirare la sicurezza, richiedendo alle banche di aggiornare costantemente anche le loro difese.[15][27]. Molte istituzioni finanziarie ammettono di non essere adeguatamente preparate -. oltre l'80% delle aziende non ha un piano di risposta formale agli attacchi deepfakee più della metà non ha fornito alcuna formazione ai dipendenti sui rischi di deepfake.[28][29]. Questo gap di preparazione significa che le organizzazioni sono attualmente vulnerabili, ma evidenzia anche dove è necessario intervenire.

Una metrica degna di nota e preoccupante proviene da un recente rapporto di settore: Il 42,5% dei tentativi di frode nel settore finanziario ora coinvolge qualche forma di IA[30]. In altre parole, quasi la metà degli attacchi fraudolenti che le banche subiscono ha una componente di IA, che si tratti di un documento generato dall'IA, di una voce sintetizzata o di un messaggio di phishing generato dalla macchina. Questa statistica sottolinea che l'IA non è un'ipotetica minaccia futura, ma è già presente e costringe le istituzioni finanziarie ad adattarsi o ad affrontare perdite crescenti.

Difendersi dalle frodi basate sull'intelligenza artificiale: Strategie e soluzioni

Affrontare le frodi guidate dall'intelligenza artificiale richiede un'evoluzione delle strategie di prevenzione delle frodi. Gli approcci tradizionali (come la verifica manuale o i motori di regole statiche) non sono all'altezza delle truffe dell'intelligenza artificiale in continua evoluzione. Le banche devono invece abbracciare technology (like making sure they have a Secure SSL Certificate), training, and teamwork per invertire la tendenza. Di seguito, illustriamo le strategie chiave e le soluzioni emergenti:

- Sfruttare l'IA per combattere l'IA (strumenti di rilevamento avanzato): Le istituzioni finanziarie si rivolgono sempre più spesso a Soluzioni di rilevamento basate sull'intelligenza artificiale per identificare i contenuti generati dall'intelligenza artificiale e le anomalie. In sostanza, è necessario combattere il fuoco con il fuoco. Nuovi strumenti aziendali come TruthScan offrire il rilevamento multimodale dell'intelligenza artificiale attraverso testo, immagini, voce e video per aiutare ad autenticare i contenuti in tempo reale[31]. Ad esempio, le banche possono impiegare rilevatori di testo AI per analizzare le comunicazioni in entrata (e-mail, messaggi di chat) alla ricerca di segni di linguaggio generato dall'AI che potrebbero indicare un'e-mail di phishing o una finta richiesta di informazioni da parte del cliente. Il sistema di rilevamento del testo dell'intelligenza artificiale di TruthScan è in grado di identificare i contenuti scritti dall'intelligenza artificiale da modelli come GPT-4 con 99%+ precisionee persino di individuare quali frasi sono probabilmente generate dall'intelligenza artificiale.[32][33]. Allo stesso modo, gli strumenti di AI image forensics sono in grado di verificare documenti e immagini. Rilevatore di immagini AI può segnalare se una patente o una bolletta presentata è stata creata o manipolata digitalmente, confrontandola con modelli noti di immagini generate dall'intelligenza artificiale.[34]. Per le minacce audio, le banche stanno iniziando a utilizzare rilevatori di fake vocali - che analizzano l'audio delle chiamate alla ricerca delle impronte acustiche del parlato sintetico. L'AI Voice Detector di TruthScan, ad esempio, è in grado di rilevare i segni rivelatori della clonazione della voce e di verificare l'autenticità dell'oratore per evitare chiamate fittizie[35]. Integrando questi rilevatori tramite API nei loro flussi di lavoro, gli istituti finanziari possono controllare automaticamente la presenza di contenuti AI in background nelle transazioni e nelle interazioni. In questo modo si ottiene un ulteriore livello di difesa che opera alla velocità della macchina, cogliendo ciò che gli occhi/gli occhi umani potrebbero non notare.

- Implementare la verifica a più fattori e fuori banda: Poiché l'intelligenza artificiale rende più difficile fidarsi di voci o immagini, le banche dovrebbero affidarsi maggiormente a metodi di verifica che l'intelligenza artificiale non può facilmente falsificare. Ciò include l'autenticazione a più fattori (MFA) utilizzando canali sicuri. Ad esempio, se una richiesta di bonifico arriva tramite e-mail o videochiamata, è necessario richiedere un secondo fattore, come un codice di accesso unico inviato al dispositivo mobile noto del richiedente o una richiamata su un numero di telefono attendibile in archivio. Alcune banche stanno aggiungendo controlli di "vivacità" per le transazioni ad alto rischio, ad esempio chiedendo al cliente di scattare un selfie dal vivo con un gesto o una parola specifica, più difficile da replicare per un video deepfake. Gli autenticatori biometrici possono essere potenziati con misure anti-spoofing (ad esempio la scansione della profondità del volto in 3D o il monitoraggio dei sottili movimenti oculari che i deepfake spesso non riescono a imitare).[27]). La chiave è evitare singoli punti di fallimento. Anche se un deepfake dell'intelligenza artificiale può ingannare un canale (ad esempio la verifica vocale), un controllo coordinato fuori banda o un test biometrico possono fornire la sfida necessaria per rivelare la frode. Principi di fiducia zero Si dovrebbe applicare il principio: trattare qualsiasi istruzione non richiesta o inaspettata (anche se proveniente da un dirigente o cliente "noto") come sospetta fino a quando non viene verificata attraverso un canale indipendente.

- Formazione dei dipendenti e sensibilizzazione alle frodi: La tecnologia da sola non è una pallottola d'argento, soprattutto perché i truffatori prendono di mira l'anello più debole, che spesso è la fiducia umana. Gli istituti finanziari dovrebbero investire in una formazione regolare per i team di prevenzione delle frodi e per il personale in prima linea sulle truffe basate sull'intelligenza artificiale. I dipendenti devono imparare a riconoscere le bandiere rosse dei deepfakes e dell'ingegneria sociale. Ciò potrebbe includere una formazione sulle anomalie più sottili (ad esempio, problemi di sincronizzazione labiale in una videochiamata, o audio che contiene intonazioni innaturali o troppo poco rumore di fondo - potenziali segni di una voce sintetica). Incoraggiare una cultura di verifica: i dipendenti devono sentirsi autorizzati a sospendere una transazione o una richiesta sospetta e a verificarla in modo indipendente, anche se sembra provenire dal CEO. Il caso del Tentativo di spoofing della voce del CEO della Ferrari è istruttivo: un dirigente ha scoperto lo stratagemma solo facendo una domanda personale a cui l'impostore non ha saputo rispondere.[36]. Anche le esercitazioni di phishing/deepfake simulate possono essere utili. Così come le aziende effettuano simulazioni di phishing per addestrare il personale, possono simulare un falso messaggio vocale o un falso incontro video e vedere se i dipendenti lo individuano. In questo modo si costruisce la memoria muscolare per resistere agli attacchi reali. Dato che più di 50% delle aziende non hanno protocolli di risposta ai deepfake e hanno una scarsa formazione in atto[29]L'istituzione di tali programmi è un frutto a portata di mano per migliorare la resilienza.

- Analisi delle frodi e rilevamento delle anomalie: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier suoni generati dall'intelligenza artificiale o eccessivamente formule (in combinazione con il rilevamento del testo dell'intelligenza artificiale menzionato in precedenza). Banche come JPMorgan hanno iniziato a utilizzare modelli linguistici di grandi dimensioni sulle loro comunicazioni interne per individuare frasi o contesti che potrebbero indicare un tentativo di ingegneria sociale.[37]. Le reti di pagamento come Mastercard stanno analizzando vasti set di dati (miliardi di transazioni) con l'intelligenza artificiale per identificare le transazioni fraudolente che le regole tradizionali non riuscirebbero a individuare.[38]. Il risultato è che AI difensiva deve essere innovativa quanto l'IA offensiva. Le aziende dovrebbero considerare lo sviluppo o l'acquisto di modelli di IA specifici per rilevare contenuti deepfake, identità sintetiche e modelli di attacco generativi. In particolare, questi modelli dovrebbero essere continuamente riqualificati sugli ultimi esempi di frode AI (una pratica chiamata apprendimento online o apprendimento federato) in modo da tenere il passo con le tattiche in rapida evoluzione dei criminali.[39][40].

- Collaborazione e condivisione delle informazioni: La lotta alle frodi abilitate dall'intelligenza artificiale richiederà una collaborazione sia all'interno che tra le istituzioni. Gli sforzi isolati sono meno efficaci contro una minaccia che trascende i confini organizzativi. Team di prevenzione delle frodi, team di cybersicurezza e IT devono lavorare fianco a fianco: ad esempio, i team di sicurezza possono implementare il rilevamento di deepfake negli strumenti di videoconferenza, mentre i team antifrode integrano le scansioni dei contenuti nel monitoraggio delle transazioni. A livello più ampio, le banche dovrebbero partecipare a gruppi di settore come il Financial Services Information Sharing and Analysis Center (FS-ISAC) per scambiare informazioni sui nuovi schemi di frode AI.[41]. Se una banca scopre un nuovo vettore di attacco deepfake, condividerlo può aiutare le altre a colmare la lacuna prima di essere colpite. Esercitazioni congiunte o simulazioni di "red team" con scenari che coinvolgono l'IA (ad esempio, una truffa esecutiva deepfake o un aggiramento della verifica dell'identità generato dall'IA) possono essere condotte attraverso consorzi di settore o con il supporto delle autorità di regolamentazione. Le stesse autorità di regolamentazione si stanno concentrando sui rischi legati all'IA, quindi è saggio impegnarsi con loro in modo proattivo. Contribuendo alla definizione di standard e linee guida per l'utilizzo dell'IA, le banche possono contribuire a creare un ecosistema più sicuro. In definitiva, poiché una minaccia per una banca è una minaccia per tutte in questo spazio[42]Un approccio di difesa collettiva rafforzerà la capacità di tutti di individuare e scoraggiare le frodi potenziate dall'intelligenza artificiale.

- Misure di educazione dei clienti e di fiducia: Infine, le istituzioni finanziarie non dovrebbero trascurare il ruolo della consapevolezza dei clienti. Con i deepfake e le truffe dell'intelligenza artificiale rivolte al grande pubblico (ad esempio, le voci false nelle truffe ai nonni o le false chat di "assistenza tecnica" generate dall'intelligenza artificiale), le banche possono contribuire a educare i clienti su questi pericoli. Molte banche inviano già avvisi sul phishing; possono ampliarli per menzionare la clonazione vocale dell'IA e i video deepfake, fornendo suggerimenti su come verificare le richieste. Alcune organizzazioni progressiste inviano notifiche push o avvisi nelle loro applicazioni se è in circolazione una truffa nota (ad esempio, "Attenzione: i truffatori possono usare cloni vocali dei membri della famiglia per chiedere denaro")[43]. Pur non prevenendo direttamente gli attacchi, l'educazione può ridurre il tasso di successo e rafforzare il fatto che la banca è un partner nella sicurezza. Inoltre, le banche che investono nella prevenzione delle frodi all'avanguardia dovrebbero evidenziarlo ai clienti come una differenziatore - Per esempio, far sapere ai clienti che tutte le videochiamate o i documenti inviati vengono analizzati dall'intelligenza artificiale per verificarne l'autenticità (senza divulgare metodi sensibili) può rassicurare i clienti sul fatto che la banca sta utilizzando tutti gli strumenti disponibili per proteggerli. Preservare la fiducia digitale sarà fondamentale per consentire alle banche di sfruttare appieno i vantaggi dell'IA nei servizi, quindi la trasparenza e le salvaguardie incentrate sul cliente fanno parte di una difesa olistica.

Ruolo dei servizi di rilevamento dei contenuti AI

Una pietra miliare dello strumentario antifrode nell'era dell'intelligenza artificiale è l'uso di Servizi di rilevamento dei contenuti AI. Questi servizi sono specializzati nell'individuare le "impronte digitali" dei contenuti generati dall'intelligenza artificiale che potrebbero sfuggire ai revisori umani. TruthScan è uno di questi fornitori che offre un servizio di livello aziendale. Suite di rilevamento AI che abbracciano più tipi di contenuto. Gli istituti finanziari possono integrare questi strumenti per controllare automaticamente la presenza di indicatori di falsificazione e frode:

- Verifica di documenti e immagini: La piattaforma di TruthScan consente alle banche di verificare in tempo reale la presenza di frodi generate dall'intelligenza artificiale sui documenti finanziari[44]. Ciò significa che quando viene aperto un nuovo conto o arriva una richiesta di prestito con un documento d'identità con foto e una busta paga, il sistema è in grado di analizzare istantaneamente queste immagini alla ricerca di segni di generazione sintetica o manomissione. Con una precisione di oltre 99%[45]L'AI Image Detector è in grado di individuare immagini di documenti d'identità falsi o PDF falsificati che un essere umano potrebbe approvare al valore nominale. Questo tipo di verifica dell'autenticità dei documenti è fondamentale per fermare le frodi di identità sintetiche prima ancora che vengano aperti i conti.

- Monitoraggio delle transazioni in tempo reale: Grazie all'implementazione di integrazioni API, TruthScan può agganciarsi all'elaborazione delle transazioni delle banche e segnalare le anomalie in tempo reale. Se arriva un'istruzione via e-mail che sembra sospetta, l'Email Scam Detector è in grado di analizzare il contenuto del messaggio e rilevare se è stato probabilmente scritto da un modello AI che cerca di simulare un fornitore o un dirigente.[46]. Allo stesso modo, il Rilevatore AI in tempo reale può monitorare le comunicazioni in tempo reale (come le chat o le piattaforme di collaborazione) per fornire avvisi immediati se, ad esempio, viene rilevato un feed video deepfake di un impostore durante una riunione di grande importanza[47][48]. Il monitoraggio continuo con avvisi immediati e risposte automatiche aiuta a ridurre la finestra in cui le frodi possono verificarsi senza essere scoperte.

- Difesa da Deepfake vocali e video: Per i call center e i gestori delle relazioni, l'incorporazione del sistema TruthScan Rilevatore vocale AI aggiunge un ulteriore livello di sicurezza. Se un truffatore chiama impersonando un cliente utilizzando un clone vocale, il sistema può analizzare l'audio della chiamata e segnalare se contiene elementi sintetizzati dall'intelligenza artificiale (come micro-pause naturali mancanti o artefatti nelle onde sonore).[35]. Sul fronte video, il Rilevatore di deepfake applica algoritmi di visione computerizzata ai fotogrammi video per individuare le incongruenze, come movimenti facciali innaturali, illuminazione strana o sincronia labiale non corrispondente, che rivelano un falso.[49][50]. Verificando l'integrità delle voci e dei volti nelle interazioni chiave, le banche possono contrastare gli impostori che tentano di ingannare i propri dipendenti. Questi strumenti agiscono come una macchina della verità high-tech per i contenuti digitali, operando in modo invisibile in background.

Vale la pena notare che l'implementazione di questa tecnologia di rilevamento non è una panacea plug-and-play; deve essere calibrata e sintonizzata sui flussi di lavoro dell'istituto. I falsi positivi devono essere gestiti (ad esempio, un rilevatore di testo AI potrebbe segnalare come sospette le comunicazioni legittime basate su modelli finché non impara la differenza). Tuttavia, se correttamente integrati, questi strumenti migliorano sensibilmente la capacità di un'organizzazione di individuare i contenuti fraudolenti prima che causino danni. Inoltre, generano audit trail e report analitici utili per la conformità e per il miglioramento continuo dei modelli di frode.

In particolare, l'efficacia degli strumenti di rilevamento dell'IA dipende da aggiornamenti costanti. Proprio come il software antivirus richiede nuove firme per i nuovi virus, i rilevatori di IA devono essere riqualificati sulle più recenti tecniche di deepfake e sui modelli di IA. Fornitori come TruthScan aggiornano i loro algoritmi per gestire i nuovi modelli generativi e le tattiche di evasione, mantenendo un'elevata precisione anche con l'evoluzione dell'IA.[51]. In questo modo si toglie l'onere ai team interni e si garantisce che le banche non combattano la guerra di ieri mentre i criminali passano a nuovi trucchi dell'IA.

Conclusione

Il settore dei servizi finanziari si trova a un bivio nella lotta contro le frodi. Da un lato, i criminali stanno rapidamente abbracciando l'IA generativa per lanciare truffe più convincenti e diffuse che mai. Dall'altro, le banche e i combattenti contro le frodi hanno a disposizione un arsenale in espansione di difese guidate dall'IA. Le istituzioni che prospereranno sono quelle che riconoscere il nuovo panorama delle minacce e rispondere con altrettanta ingegnosità. Ciò significa investire in capacità di rilevamento avanzate, integrare processi di verifica a più livelli, educare sia il personale che i clienti e promuovere una cultura di vigilanza e adattamento.

Le frodi basate sull'intelligenza artificiale sono un obiettivo in rapida evoluzione: la truffa deepfake che ha ingannato un'azienda oggi potrebbe essere contrastata da nuove tecniche di rilevamento domani, solo che i truffatori modificheranno i loro metodi la settimana successiva. Pertanto, una strategia di prevenzione delle frodi "standard del settore" nel 2025 è quella che enfatizza l'agilità e il miglioramento continuo. Le organizzazioni finanziarie dovrebbero trattare i loro sistemi di difesa dalle frodi come entità che vivono e imparano che si evolvono di pari passo con le tattiche criminali. Sfruttare le partnership con i fornitori di tecnologia è una scorciatoia intelligente per costruire queste capacità. Ad esempio, la collaborazione con aziende specializzate come TruthScan (che offre soluzioni su misura per il settore bancario e finanziario) può accelerare la capacità dell'istituto di prevenire le frodi abilitate dall'intelligenza artificiale mantenendo la conformità normativa e la fiducia dei clienti[52].

In definitiva, la protezione contro le frodi guidate dall'IA non è solo una questione di tecnologia, ma anche di preservare i principi fondamentali dell'IA. fiducia che sta alla base della finanza. I clienti devono essere certi che la loro banca sia in grado di distinguere una transazione reale da una falsa, un cliente reale da un impostore dell'IA. Impiegando strumenti di rilevamento dell'IA all'avanguardia, rafforzando i protocolli di verifica e rimanendo al passo con le minacce emergenti, le società di servizi finanziari possono mantenere questa fiducia. La strada da percorrere sarà senza dubbio caratterizzata da ulteriori tentativi di frode da parte degli avversari, ma con la preparazione e i giusti investimenti, le banche possono garantire che L'intelligenza artificiale diventa più una risorsa che una minaccia nel campo della prevenzione delle frodi. È un obiettivo raggiungibile: le stesse tecnologie AI che minacciano di distruggere possono essere sfruttate per salvaguardare l'integrità del nostro sistema finanziario. È il momento per i team di prevenzione delle frodi e per i dirigenti di livello C di agire con decisione, adottare soluzioni e strategie avanzate per superare in astuzia i truffatori e garantire il futuro della finanza digitale.

Fonti: Si è fatto riferimento a recenti rapporti di settore, avvisi normativi e whitepaper tecnologici (Deloitte[20][18], Forum economico mondiale[19][24], Tesoro degli Stati Uniti FinCEN[3][4], Federal Reserve[13], Keepnet Labs[16][30], tra gli altri) per fornire dati ed esempi. Tutti i dati e gli esempi sono citati in linea per consentire ai lettori di approfondire.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking e rischio di frode AI | Approfondimenti Deloitte

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Individuare le IA pericolose è essenziale nell'era dei deepfake | World Economic Forum

[3] [4] [26] La FinCEN lancia un allarme sugli schemi di frode che coinvolgono i Deepfake Media e che prendono di mira gli istituti finanziari | FinCEN.gov

[7] [8] FraudGPT e GenAI: come i truffatori useranno l'AI? | Lega

[11] Frodi d'identità sintetiche: Come l'intelligenza artificiale sta cambiando il gioco - Federal Reserve Bank of Boston

[12] [13] L'intelligenza artificiale generativa aumenta le minacce di frode dell'identità sintetica

[16] [17] [22] [23] [28] [29] [30] Statistiche e tendenze del Deepfake 2025 | Dati e approfondimenti chiave - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Rilevamento dell'intelligenza artificiale e sicurezza dei contenuti per le imprese

[32] [33] [51] AI Detector: Rilevamento del testo AI di livello aziendale - TruthScan

[44] [45] [52] Rilevamento delle frodi nel settore bancario | Soluzioni CRO | TruthScan

[49] [50] Deepfake Detector - Identificare i video falsi e di intelligenza artificiale - TruthScan