Le frodi assicurative stanno entrando in una nuova era alimentata dall'intelligenza artificiale. Sofisticati gruppi di truffatori e truffatori solitari sfruttano strumenti di intelligenza artificiale generativa per produrre richieste di risarcimento false, identità sintetiche, prove falsificate e truffe altamente convincenti. Questo whitepaper esamina le ultime tendenze delle frodi assicurative guidate dall'IA - dalle richieste di risarcimento e dai documenti generati dall'IA alle truffe con voce falsa - e illustra come gli assicuratori possono reagire. Presentiamo dati recenti, casi reali e spunti strategici per sottoscrittori, investigatori di frodi, team di cybersecurity, gestori di sinistri e dirigenti della direzione generale che devono comprendere questo panorama di minacce in rapida evoluzione.

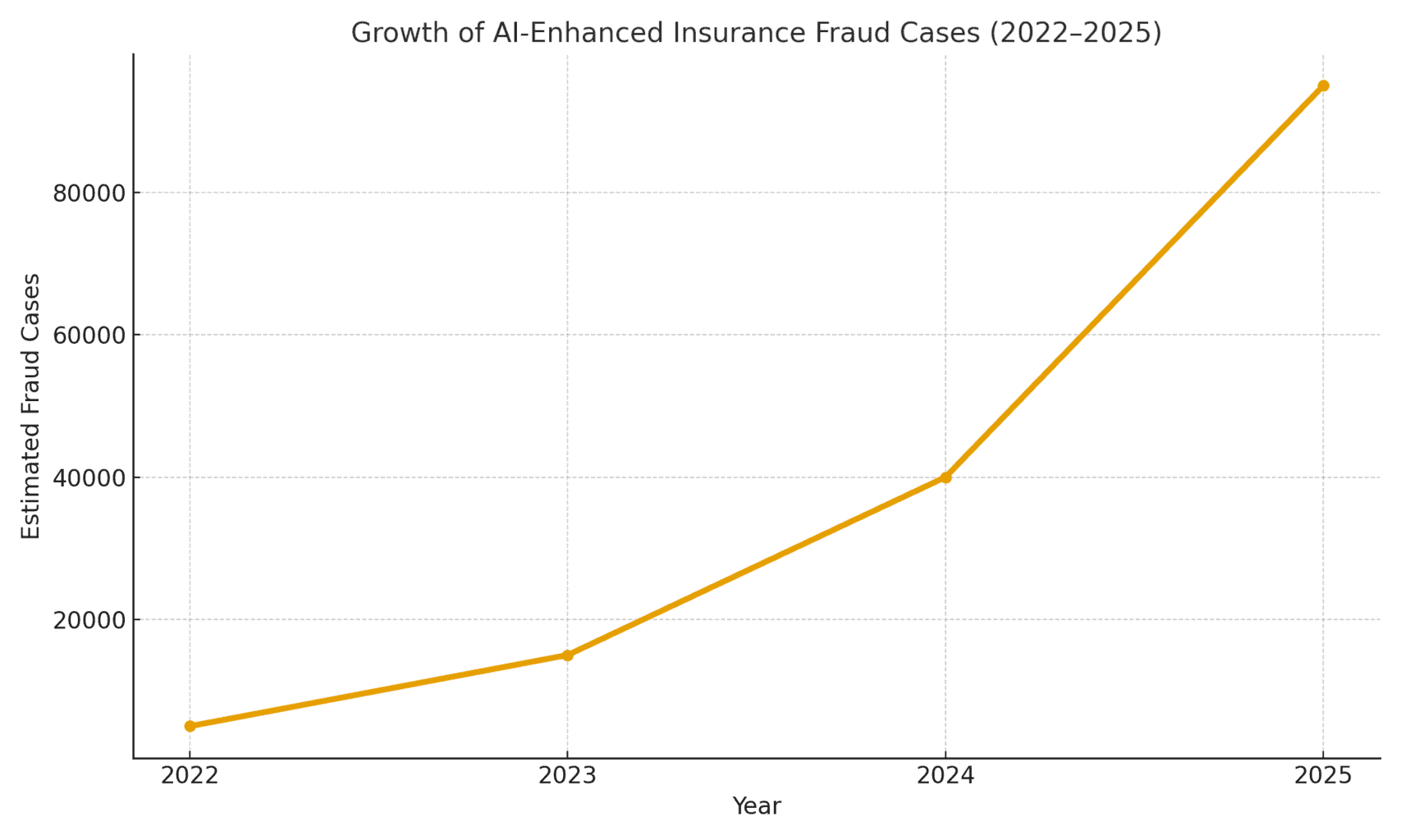

L'entità della minaccia: Le frodi abilitate dall'intelligenza artificiale sono in aumento. Un rapporto di contabilità forense del 2025 ha rilevato che Le truffe guidate dall'intelligenza artificiale rappresentano ormai oltre la metà di tutte le frodi finanziarie digitali[1]. Nello specifico delle assicurazioni, la società di sicurezza vocale Pindrop ha osservato una 475% aumento degli attacchi di frode vocale sintetica alle compagnie assicurative nel 2024contribuendo ad un aumento del 19% rispetto all'anno precedente dei tentativi di frode assicurativa complessivi[2]. Gli assicuratori devono affrontare circa Esposizione alle frodi 20 volte superiore a quella delle bancheanche a causa della forte dipendenza da documenti, immagini e verifiche vocali nelle richieste di risarcimento.[3]. La figura 1 qui sotto illustra la crescita esplosiva degli incidenti di frode assicurativa con l'intelligenza artificiale dal 2022 al 2025, dato che diversi rapporti di settore hanno indicato aumenti percentuali a tre o quattro cifre di anno in anno nel coinvolgimento dell'intelligenza artificiale nelle frodi.

Figura 1: Rapido aumento dei casi di frode assicurativa potenziata dall'intelligenza artificiale (crescita indicizzata 2022-2025). I dati del settore indicano un aumento esponenziale dei contenuti generati dall'intelligenza artificiale trovati nelle richieste di risarcimento fraudolente, soprattutto a partire dal 2023.[4][2]

Affermazioni generate dall'intelligenza artificiale e prove false

Una delle tendenze più diffuse è l'utilizzo dell'intelligenza artificiale generativa per creare richieste di risarcimento assicurative completamente inventate. Grazie a generatori di testo avanzati, i truffatori possono scrivere descrizioni realistiche di incidenti, rapporti medici o dichiarazioni della polizia con un semplice clic. Queste narrazioni scritte dall'intelligenza artificiale spesso appaiono curate e plausibili, rendendo più difficile per i periti individuare le incongruenze. Ad esempio, i truffatori hanno usato ChatGPT per redigere descrizioni dettagliate di incidenti o rapporti di lesioni che sembrano professionali e convincenti - un compito che un tempo richiedeva sforzi significativi e abilità di scrittura.

Ancora più preoccupante è il fatto che i criminali ora abbinano queste false narrazioni a Prove di supporto generate dall'IA. I modelli di generazione delle immagini (come Midjourney o DALL-E) e gli strumenti di editing possono produrre foto di danni e lesioni fotorealistiche. Secondo quanto riportato dal settore, alcuni conducenti hanno iniziato a presentare immagini generate dall'intelligenza artificiale per esagerare i danni ai veicoli nei sinistri auto[5]. L'intelligenza artificiale generativa può creare una foto di un'auto distrutta o di una casa allagata che in realtà non è mai esistita. Queste immagini sono spesso più realistico di quello che potevano ottenere le vecchie tecniche di Photoshop.[6]che li rende difficili da individuare a occhio nudo. Nell'aprile 2025, Zurich Insurance ha rilevato un aumento dei sinistri con fatture falsificate, preventivi di riparazione inventati e foto alterate digitalmente.compresi i casi in cui I numeri di immatricolazione dei veicoli sono stati inseriti dall'intelligenza artificiale in immagini di auto recuperate.[7][8]. Tali prove false, se combinate con un modulo di richiesta di risarcimento ben scritto dall'intelligenza artificiale, possono sfuggire alle revisioni manuali.

Un caso eclatante nel Regno Unito ha coinvolto dei truffatori che hanno preso una foto sui social media del furgone di un commerciante e l'utilizzo dell'intelligenza artificiale per aggiungere un paraurti incrinato.e poi l'ha presentata insieme a una falsa fattura di riparazione per 1.000 sterline come parte di una falsa richiesta di risarcimento per incidente.[9]. La truffa è stata scoperta solo quando gli investigatori si sono accorti della stesso foto del furgone (prima del danno) sulla pagina Facebook del proprietario[10]. Questo dato illustra un fenomeno più ampio: gli assicuratori segnalano una 300% salto nelle modifiche di immagini "shallowfake (semplici manipolazioni digitali per aggiungere danni o alterare dettagli) in un solo anno (2021-2022 vs 2022-2023)[4]. Allianz UK ha avvertito nel 2024 che le distorsioni digitali delle foto e i documenti falsi hanno "tutti i crismi per diventare l'ultima grande truffa che colpisce il settore".[4]. Anche il responsabile di Zurich per le frodi sui sinistri ha osservato che Ciò che prima richiedeva la messa in scena di un incidente stradale fisico, ora può essere fatto interamente dietro a un computer. - I truffatori possono "creare una richiesta di risarcimento fraudolenta da dietro la loro tastiera ed estorcere somme significative" con foto e rapporti di perdita totale falsi.[11][12]. Questo spostamento non solo aumenta il volume delle richieste di risarcimento false, ma abbassa anche la barriera d'ingresso per gli aspiranti truffatori.

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

Oltre le auto, sinistri di proprietà e infortuni stanno assistendo a un'inflazione delle perdite assistita dall'intelligenza artificiale. Sono state segnalate foto false per le assicurazioni di viaggio (ad esempio "danni" ai bagagli o scene di furto inscenate) e ricevute generate dall'intelligenza artificiale per articoli costosi che non sono mai stati acquistati. Sinistri vita e salute Non sono immuni nemmeno i truffatori che hanno generato false fatture mediche e certificati di morte utilizzando falsificatori di documenti AI. In effetti, Zurich ha notato che la tecnologia deepfake è stata usata per creare valutazioni ingegneristiche e relazioni mediche del tutto fittizie nei pacchetti sinistri[11]. Questi documenti generati dall'intelligenza artificiale, spesso completi di loghi e firme realistiche, possono essere indistinguibili da documenti autentici. Una preoccupazione emergente per gli assicuratori vita è frodi nei necrologi e nei certificati di morteI criminali possono usare l'intelligenza artificiale per produrre falsi necrologi o lettere di medici a sostegno di una richiesta di morte per qualcuno che in realtà è ancora vivo (o che non è mai esistito, come si dirà in seguito).

Assicurati e identità sintetiche

Forse lo sviluppo più insidioso è frode di identità sintetica nelle assicurazioni. La frode di identità sintetica consiste nel creare una persona o un'entità fittizia combinando dati reali (numeri di previdenza sociale rubati, indirizzi, ecc.) con dettagli inventati (nomi falsi, documenti d'identità falsi). I progressi dell'Intelligenza Artificiale hanno reso banalmente semplice generare profili personali realistici - compresi foto e documenti d'identità - per persone che non esistono.[13][14]. I truffatori possono ora creare in modo algoritmico un cliente completamente falso, acquistare una polizza a suo nome e in seguito presentare richieste di risarcimento o prestazioni di polizza per quella falsa identità.

Nel settore delle assicurazioni sulla vita, gli schemi di identità sintetica hanno salito alle stelle. Una ricerca di settore nel 2025 stima che le frodi di identità sintetiche costino oltre $30 miliardi all'annoche rappresentano fino a 80-85% di tutti i casi di frode d'identità nei servizi finanziari[15][16]. Gli assicuratori del ramo vita sono stati particolarmente colpiti: i truffatori sono stati noti per Assicurare polizze di assicurazione sulla vita per una persona fittizia e poi "ucciderla" sulla carta per riscuotere il premio di morte.[17]. Ad esempio, un truffatore potrebbe creare un cliente sintetico "John Doe", pagare i premi per un anno, quindi presentare una richiesta di risarcimento con un certificato di morte e un necrologio falsi per la sua prematura scomparsa. Poiché l'identità è stata costruita con cura (storia creditizia, registri pubblici, ecc.), la richiesta di risarcimento può apparire legittima, fino a quando non si riesce a trovare il corpo o i parenti reali. Quando la frode viene scoperta, gli autori sono già lontani dal pagamento.

Anche gli schemi di identità sintetica affliggono assicurazione sanitaria e assicurazione auto. Le associazioni criminali creano identità "Frankenstein" utilizzando i numeri di previdenza sociale di bambini o anziani (che non hanno una storia creditizia) combinati con nomi e patenti di guida generati dall'intelligenza artificiale[15]. Poi acquistano polizze sanitarie o auto per questi falsi individui e poco dopo presentano ingenti richieste di risarcimento.. Una variante è costituita dai consorzi che creano imprese fittizie (società di comodo) - per esempio, una società di autotrasporti fittizia e l'acquisto di un'assicurazione commerciale per essa, solo per poi rivendicare incidenti inscenati o infortuni fantasma dei dipendenti[18][19]. Poiché l'attività esiste solo sulla carta (con registrazioni aziendali e codici fiscali generati dall'intelligenza artificiale), questo frode sintetica "basata su entità" spesso si scopre solo dopo il pagamento dei sinistri[18][20].

Perché le identità sintetiche sono così efficaci? Innanzitutto, spesso superano i controlli automatici di verifica dell'identità. Gli uffici di credito e i sistemi KYC possono trovare nessuna bandiera rossa perché l'identità include alcuni dati reali e validi (ad esempio un SSN reale con una fedina penale pulita)[21]. Nel frattempo, le foto profilo e le scansioni dei documenti d'identità generate dall'IA possono sembrare completamente autentiche: l'IA di oggi è in grado di produrre un volto umano che persino il riconoscimento facciale avanzato potrebbe accettare come reale. Il risultato: la maggior parte dei sistemi automatici riconosce questi profili come legittimi e le frodi vengono scoperte (se mai lo sono) solo dopo gravi perdite[22].

Impatto sul mondo reale: RGA riferisce che La frode di identità sintetica nelle assicurazioni sulla vita costa al settore circa $30B all'anno ed è cresciuta di quasi 400% dal 2020[15][16]. Secondo le stime della Federal Trade Commission degli Stati Uniti, i documenti d'identità sintetici costituiscono la maggior parte delle frodi d'identità.[16]. Queste perdite si ripercuotono in ultima analisi sui portafogli degli assicurati onesti: ogni famiglia paga circa 700 euro in più di premi ogni anno a causa del maggior carico di frodi che grava sugli assicuratori.[15]. Gli assicuratori stanno rispondendo rafforzando la verifica all'atto dell'adesione e dei sinistri: implementando controlli sui database per il collegamento dell'identità, monitorando la presenza di polizze multiple allo stesso indirizzo e persino eseguendo test di "vivacità" (controlli video dei selfie per garantire che il richiedente sia una persona reale, non solo un'immagine AI).[23][24]. Ma come vedremo, i truffatori stanno rispondendo con l'intelligenza artificiale nella prossima arena: voci e video falsi.

Voci e affermazioni video deepfake

Generato dall'intelligenza artificiale deepfakes audio e video aggiungono una nuova allarmante dimensione alle frodi assicurative. Nel 2023 e nel 2024 si sono verificati diversi episodi di criminali che hanno utilizzato clonazione vocale per impersonare persone al telefono, una tattica originariamente vista nelle rapine in banca (come la famigerata telefonata del CEO deepfake che ha rubato $35 milioni nel 2020) ma che ora si sta diffondendo nel settore assicurativo. I truffatori clonano le voci degli assicurati, dei medici o dei liquidatori dei sinistri e le utilizzano nelle truffe di ingegneria sociale. L'analisi di Pindrop per il 2024 avverte che "deepfakes, tecnologia vocale sintetica e truffe guidate dall'intelligenza artificiale stanno ridisegnando il panorama delle frodi"., con frode vocale scalare ad un ritmo senza precedenti[25]. Hanno scoperto che i call center assicurativi sono stati bombardati da attori malintenzionati d'oltreoceano che hanno utilizzato dei "deepfakes" vocali: ad esempio, arrivavano chiamate che fornivano l'SSN e i dati personali rubati di un vero assicurato e, se un agente rispondeva, la voce del cliente si trasformava in un'altra. La voce clonata dell'IA del chiamante potrebbe ingannare l'agente attraverso l'autenticazione basata sulla conoscenza e richiedere un esborso fraudolento[26]. Nel caso di un assicuratore della costa occidentale, gli aggressori hanno ripetutamente utilizzato questo metodo per cercare di impossessarsi dei conti e reindirizzare i pagamenti, sfruttando il fatto che la verifica dell'identità da parte del call center si basava su informazioni vocali e personali che possono essere falsificate.[26].

L'impersonificazione vocale è stata utilizzata anche dal lato dei consumatori: I truffatori hanno chiamato le vittime di incidenti o i beneficiari mentre fingendo di essere rappresentanti assicurativiutilizzando voci AI per sembrare ufficiali, al fine di carpire informazioni sensibili o addirittura pagamenti. Al contrario, un truffatore potrebbe impersonare un cliente in una hotline di reclami per presentare una richiesta di risarcimento per telefono utilizzando una voce falsa che corrisponde al sesso/età del clienteaggirando così i controlli biometrici vocali. Le recenti statistiche sulle frodi sono preoccupanti: gli esperti del settore prevedono una 162% crescita degli attacchi di frode deepfake contro gli assicuratori nel prossimo anno[27]e Pindrop ha registrato un 475% picco di attacchi vocali sintetici nel 2024 come già detto[2]. Questi attacchi stanno rapidamente superando i vettori di frode informatica più tradizionali.

Al di là delle telefonate, deepfakes basati su video stanno emergendo nel processo di liquidazione dei sinistri. Molti assicuratori hanno adottato ispezioni virtuali dei sinistri e videoconferenze (accelerate dalla pandemia), per verificare i danni o intervistare i richiedenti a distanza. Ora i truffatori stanno sfruttando gli avatar dell'intelligenza artificiale e i video deepfake per ingannare le verifiche.. Ci sono state segnalazioni di richiedenti che hanno utilizzato Avatar generati dall'intelligenza artificiale nelle videochiamate in diretta con i periti, per mascherarsi da qualcun altro o per nascondere segni di incoerenza.[28]. Ad esempio, un giro di frodi potrebbe utilizzare un deepfake video "live" di un presunto richiedente che mostra il proprio danno tramite smartphonequando in realtà la persona ripresa è un composito sintetizzato dall'IA o un attore ingaggiato con filtri che alterano il volto. Uno scenario speculativo ma plausibile è l'utilizzo di un deepfake di un deceduto persona: In una frode sulle rendite o sulle assicurazioni sulla vita, un membro della famiglia potrebbe utilizzare un video deepfake del defunto recente durante una chiamata di prova di routine per continuare a ricevere i pagamenti.[29]. Sebbene non sia ancora stato reso noto alcun caso di alto profilo di questa natura, gli assicuratori si stanno preparando. Anche le autorità di regolamentazione stanno prendendo nota - Negli Stati Uniti e in Europa sono in corso discussioni sulla classificazione dei deepfakes tra i furti di identità e sull'aggiornamento delle linee guida per la verifica delle prove nelle assicurazioni.[30].

L'individuazione di video e audio deepfake è molto impegnativa senza strumenti tecnici. I periti umani non sono addestrati a riconoscere sottili problemi di sincronizzazione labiale o stranezze acustiche. Tuttavia, in alcuni casi ci sono stati dei segnali di allarme: ad esempio, lampeggiamenti innaturali o glitch facciali in un video, o artefatti audio di sottofondo in una chiamata che hanno messo in guardia gli investigatori. Nel complesso, però, il risultato è buono, La frode assicurativa deepfake è ancora in fase inizialee l'azione penale rimane rara: nel 2023, le definizioni legali non erano chiare e dimostrare che un video era stato generato dall'intelligenza artificiale era difficile senza l'analisi di esperti.[31]. Questo dà ai truffatori un senso di impunità. La corsa agli armamenti è in corso: gli assicuratori si rivolgono ora a AI forense per combattere l'AIche utilizza algoritmi di rilevamento deepfake per esaminare i video sospetti fotogramma per fotogramma alla ricerca di segni di manipolazione.[24]. I fornitori di biometria vocale stanno lanciando sul mercato rilevatori di voce falsa che analizzano i modelli spettrali e la cadenza vocale per verificarne l'autenticità.[32]. Discuteremo di queste tecnologie difensive in una sezione successiva.

Truffe di phishing e impersonificazione potenziate dall'intelligenza artificiale

Non tutte le frodi abilitate dall'intelligenza artificiale passano attraverso il reparto sinistri; alcuni obiettivi sono clienti e dipendenti attraverso l'ingegneria sociale. Email e testi di phishing creati dall'intelligenza artificiale sono diventate una minaccia importante nel settore assicurativo. In questi schemi, i truffatori utilizzano chatbot AI e strumenti di traduzione per generare comunicazioni truffaldine molto convincenti. Ad esempio, i criminali possono impersonare il marchio e lo stile di scrittura di una compagnia assicurativa per inviare email di phishing di massa agli assicurati, dicendo loro che "è necessaria un'azione urgente per evitare la cancellazione della polizza" e indirizzandoli a un sito web falso. A differenza delle maldestre e-mail di truffa del passato, L'intelligenza artificiale garantisce una grammatica impeccabile e anche la personalizzazionerendendoli molto più credibili. Abbiamo visto che l'intelligenza artificiale viene utilizzata per analizzare i social media alla ricerca di dettagli che vengono inseriti nei messaggi di spear-phishing, come ad esempio il riferimento a un recente acquisto di auto in un falso avviso di assicurazione auto.

Un altro vettore è Impersonificazione di agenti o dirigenti assistita dall'IA. Ci sono stati casi in cui i truffatori hanno clonato la voce del proprietario di un'agenzia assicurativa e hanno lasciato messaggi vocali ai clienti chiedendo aggiornamenti sulle informazioni bancarie - in pratica un attacco di phishing vocale. Allo stesso modo, le frodi interne possono derivare dall'impersonificazione dell'intelligenza artificiale: il dipartimento finanziario di una compagnia assicurativa è quasi caduto vittima quando i truffatori hanno inviato un messaggio audio contraffatto. presumibilmente dall'amministratore delegato autorizzare un trasferimento di fondi (una variante della "frode dell'amministratore delegato" ora coperta da alcune polizze di assicurazione contro il crimine elettronico).[33]). Secondo Liberty Specialty Markets, questo tipo di truffe con l'intelligenza artificiale sono aumentate di 17% nel 2023.[33]e si prevede che continueranno ad aumentare.

I consumatori vengono presi di mira anche con truffe sui mezzi di comunicazione sintetici legati alle assicurazioni. La Coalizione contro le frodi assicurative rileva casi di impostori che si spacciano per periti assicurativi, contattano le vittime di incidenti sostenendo di occuparsi del loro sinistro e poi richiedere un pagamento immediato o dati sensibili[23]. I clienti ignari, sollevati dall'ascolto di un presunto rappresentante, possono aderire, soprattutto se l'interlocutore conosce i dettagli del loro incidente (che l'IA potrebbe ricavare dall'hacking o da fonti pubbliche). La consapevolezza di queste tattiche da parte del pubblico è scarsa; per questo gli esperti di prevenzione delle frodi invitano gli assicuratori a educare gli assicurati a verificare l'identità di chi chiama e di chi invia messaggi di posta elettronica[23][34]. Così come le banche mettono in guardia i clienti dal phishing, gli assicuratori nel 2025 stanno iniziando a includere avvisi di truffa deepfake nelle loro comunicazioni.

Un filo conduttore di questi schemi potenziati dall'intelligenza artificiale è l'uso di kit "fraud-as-a-service" facilmente reperibili.[35]. Sul dark web, i criminali possono acquistare o abbonarsi a strumenti che forniscono voci deepfake preconfezionate, modelli di documenti falsi, generatori di e-mail di phishing e altro ancora. Questa democratizzazione degli strumenti di IA significa anche i truffatori poco qualificati possono sferrare attacchi fraudolenti sofisticati[35]. Per le compagnie assicurative, questo si traduce in una marea di tentativi di frode sempre più convincenti, provenienti da tutti i fronti: sinistri, servizio clienti, e-mail e persino social media. Ciò sottolinea la necessità di una strategia di difesa su più fronti, che combini tecnologia, vigilanza umana e collaborazione intersettoriale.

Rilevamento e difesa: Una risposta alimentata dall'intelligenza artificiale

La lotta alle frodi guidate dall'IA richiede Difesa guidata dall'intelligenza artificiale. Gli assicuratori si rivolgono sempre più spesso a tecnologie di rilevamento avanzate e a processi rinnovati per contrastare l'assalto. In sostanza, gli assicuratori devono incorporare punti di controllo dell'autenticazione dei contenuti in tutto il ciclo di vita dell'assicurazione, dalla sottoscrizione ai sinistri fino alle interazioni con i clienti, per individuare i falsi dell'IA. La Figura 2 fornisce una ripartizione dei principali tipi di frode abilitati dall'IA e la loro prevalenza, mentre le sezioni seguenti illustrano in dettaglio come individuare e scoraggiare ciascuno di essi.

Figura 2: Tipi di frodi assicurative potenziate dall'intelligenza artificiale nel 2025 (quota stimata per schema). Le immagini false (foto falsificate dei danni) e le identità sintetiche sono tra le categorie più numerose, seguite dai documenti falsificati dall'intelligenza artificiale (ad esempio ricevute, certificati) e dalle truffe audio/video deepfake.

1. Strumenti di rilevamento dei contenuti dell'intelligenza artificiale: I nuovi servizi di rilevamento dell'intelligenza artificiale possono analizzare testi, immagini, audio e video per determinare se sono stati generati o manipolati dalla macchina. Ad esempio, gli assicuratori possono sfruttare soluzioni come Rilevatori di testo e immagini AI di TruthScan che utilizzano l'AI accurata 99%+ per segnalare documenti scritti dall'AI o foto falsificate.[36]Una compagnia assicurativa potrebbe integrare questi rilevatori nel proprio sistema di gestione dei sinistri: quando viene presentata una richiesta di risarcimento e le relative prove, la descrizione del testo può essere scansionata automaticamente alla ricerca di modelli linguistici generati dall'intelligenza artificiale, mentre le immagini caricate possono essere analizzate alla ricerca di segni rivelatori di CGI o di modifiche. Gli strumenti di livello aziendale possono identificare il testo generato dall'intelligenza artificiale in documenti, e-mail e comunicazioni con una precisione di 99%[36]e allo stesso modo rilevare le immagini generate o manipolate dall'intelligenza artificiale per garantire l'autenticità dei contenuti visivi[36]. Ciò significa che una falsa narrazione dell'incidente prodotta da ChatGPT o una foto dei danni falsificata a metà viaggio verrebbero segnalate per una revisione manuale prima che la richiesta di risarcimento venga elaborata. Nel 2025 gli assicuratori stanno adottando sempre più spesso l'autenticazione dei contenuti da parte dell'intelligenza artificiale, 83% dei professionisti dell'antifrode prevedono di integrare il rilevamento generativo dell'IA entro il 2025secondo un'indagine dell'ACFE, rispetto agli appena 18% che lo utilizzano oggi.[37][38].

2. Verifica dell'identità e controlli biometrici: Per affrontare le identità sintetiche, gli assicuratori stanno migliorando i protocolli KYC anche con l'AI. I servizi di convalida dell'identità possono effettuare una verifica incrociata dei dati dei richiedenti rispetto a più database e utilizzare il riconoscimento facciale con test di vivacità. Ad esempio, la richiesta di un breve video selfie durante l'onboarding (e l'utilizzo della corrispondenza del volto con l'ID fornito) può contrastare molti ID sintetici. Ancora più tecnologicamente avanzate, aziende come TruthScan offrono immagini forensi che possono individuare foto profilo, avatar e immagini personali sintetiche generate dall'intelligenza artificiale - il loro rilevatore di immagini AI è addestrati a identificare volti realizzati da generatori come StyleGAN o ThisPersonDoesNotExist.[39]. Utilizzando tali strumenti, un assicuratore può rilevare se il selfie di un richiedente di assicurazione sulla vita non è un essere umano reale. Per quanto riguarda la voce, autenticazione biometrica vocale per le chiamate al servizio clienti può essere d'aiuto; i moderni rilevatori di IA vocale sono in grado di identificare le voci sintetiche e i tentativi di clonazione vocale in tempo reale[40]. Ad esempio, il sistema TruthScan Rilevamento vocale AI Il sistema utilizza l'analisi acustica per Riconoscere le voci generate dall'intelligenza artificiale e i deepfakes audio prima che ingannino il personale del call center.[40]. Queste soluzioni agiscono come un firewall: se qualcuno chiama fingendo di essere John Doe e la sua impronta vocale non corrisponde alla voce autentica di John Doe (o corrisponde a caratteristiche note di deepfake), la chiamata può essere segnalata o può essere richiesta un'ulteriore prova di identità. L'autenticazione a più fattori (conferma via e-mail/SMS, codici di accesso unici, ecc.) aggiunge ulteriori ostacoli da superare per gli imitatori.

3. Deepfake Video & Image Forensics: Per quanto riguarda le prove video, gli assicuratori stanno iniziando a implementare analisi forensi specializzate. Un software avanzato è in grado di analizzare i metadati video, la coerenza dei fotogrammi e i livelli di errore per individuare i deepfake. Alcuni strumenti esaminano i riflessi, le ombre e gli indizi fisiologici (come le pulsazioni nella gola di una persona in un video) per garantire che un video sia autentico. Metadati forensi è altrettanto prezioso: l'esame dei metadati dei file e delle impronte di generazione nelle immagini o nei PDF può rivelare se qualcosa è stato probabilmente prodotto da uno strumento di intelligenza artificiale.[41]. Gli assicuratori dovrebbero richiedere i file originali delle foto (che contengono metadati) piuttosto che semplici screenshot o copie stampate, ad esempio. Il team antifrode di Zurich ha riscontrato un successo nell'individuare immagini di auto false notando anomalie nei metadati dell'immagine e nell'analisi del livello di errore.[41]. Rilevatori di truffe via e-mail può anche scansionare le comunicazioni in entrata alla ricerca di segni di contenuti di phishing scritti dall'intelligenza artificiale o di firme dannose conosciute.[42]. Molte compagnie assicurative ora eseguono simulazioni di phishing ed esempi di truffa elaborati dall'intelligenza artificiale nella formazione dei dipendenti per aumentare la consapevolezza.

4. Cambiamenti di processo e formazione umana: La tecnologia da sola non è una pallottola d'argento. Miglioramenti del processo Come ad esempio controlli casuali a campione più frequenti per le richieste di risarcimento di alto valore, o la richiesta di documentazione fisica in alcuni casi. Alcuni assicuratori hanno ritardato l'elaborazione diretta e completamente automatizzata dei sinistri, reinserendo la revisione umana per i sinistri che ottengono un punteggio elevato nel modello di rischio di frode dell'IA. Dal punto di vista umano, la formazione è fondamentale. Gli investigatori e i periti antifrode vengono addestrati a riconoscere le bandiere rosse dell'IA: ad esempio, sinistri multipli che utilizzano formulazioni identiche (lo "stile" ChatGPT), immagini prive di vera casualità (ad esempio, schemi ripetuti in quelli che dovrebbero essere danni organici), o voci che suonano quasi ma con una cadenza robotica. Gli assicuratori stanno anche educando i clienti: inviano avvisi di frode sugli schemi deepfake e consigliano come verificare l'identità di un rappresentante assicurativo (ad esempio, fornendo un numero di chiamata noto).

5. Sforzi di collaborazione: La collaborazione a livello di settore si sta intensificando. Nel Regno Unito, l'Insurance Fraud Bureau e l'Associazione degli assicuratori britannici hanno formato dei gruppi di lavoro sulle frodi legate all'IA, e il governo Carta delle frodi assicurative (2024) sta promuovendo la condivisione dei dati e le iniziative congiunte[43]. A livello globale, gli assicuratori stanno collaborando con aziende di cybersecurity e startup di AI. In particolare, stanno comparendo nuovi prodotti assicurativi: Liberty Mutual ha lanciato un Assicurazione e-crime per le PMI che copre specificamente le truffe deepfake e le frodi dei CEO[44][33]evidenziando che questo rischio è molto reale. Ciò significa anche che gli assicuratori potrebbero trovarsi a essere allo stesso tempo vittime e risolutori di frodi AI - pagando per una truffa deepfake se non viene individuata, ma anche offrendo una copertura per altri che subiscono tali attacchi.

L'integrazione della tecnologia di rilevamento nei flussi di lavoro può essere visualizzata come una difesa a più punti nel ciclo di vita dei sinistri. Come mostrato in Figura 3gli assicuratori possono inserire fasi di verifica dell'intelligenza artificiale a applicazione della politica (per verificare la presenza di identità sintetiche attraverso il controllo dei documenti d'identità e dei selfie), a presentazione della richiesta di risarcimento (per analizzare automaticamente i documenti, le foto o l'audio caricati per la generazione dell'intelligenza artificiale), durante revisione/indagine dei sinistri (per eseguire l'analisi forense deepfake su prove sospette e verificare eventuali interazioni vocali), e subito prima di pagamento (un'ultima autenticazione dell'identità per garantire che il beneficiario sia legittimo). Individuando precocemente le frodi, idealmente al momento dell'onboarding o della prima notifica di sinistro, gli assicuratori risparmiano sui costi di indagine ed evitano rimborsi errati.

Figura 3: Integrazione dei punti di rilevamento dell'IA nel ciclo di vita dell'assicurazione. Al momento dell'adesione alla polizza, la convalida dell'identità basata sull'IA verifica la presenza di identità sintetiche o false. Quando viene presentata una richiesta di risarcimento, i rilevatori automatici analizzano il testo, i documenti e le immagini della richiesta di risarcimento alla ricerca di contenuti generati dall'intelligenza artificiale. Durante la revisione dei sinistri, strumenti specializzati di deepfake e di analisi vocale verificano qualsiasi prova audio/video. Prima del pagamento, la verifica dell'identità biometrica conferma l'identità del beneficiario. Questo approccio a più livelli aiuta a intercettare le frodi in più fasi.

Gli assicuratori non sono costretti a creare tutte queste funzionalità internamente: molti si stanno rivolgendo a soluzioni aziendali come Suite di rilevamento dell'intelligenza artificiale di TruthScanche offre una serie di strumenti che possono essere integrati tramite API nei sistemi degli assicuratori. Ad esempio, Servizio di rilevamento AI di immagini e deepfake di TruthScan può essere utilizzato per verificare l'autenticità di immagini e video con una precisione superiore a 99%[45]. Il loro Rilevatore di testo AI segnala il testo scritto dall'intelligenza artificiale nelle richieste di risarcimento o nelle e-mail[36], mentre il Rilevatore vocale AI Rilevamento della clonazione vocale e verifica dell'altoparlante per bloccare gli impostori telefonici.[40]. Esistono anche strumenti di nicchia come un Rilevatore di ricevute false per analizzare istantaneamente le fatture/ricevute alla ricerca di segni di manomissione o di font/layout generati dall'IA[46] - estremamente utile vista la prevalenza di fatture di riparazione false nei sinistri. Utilizzando una combinazione di questi strumenti, un assicuratore può migliorare drasticamente il tasso di rilevamento delle frodi. Un assicuratore della Fortune 500 ha riferito di aver catturato 97% di tentativi di deepfake nel 2024 utilizzando un approccio di screening AI a più livelli (testo, immagine, voce) ed evitando così perdite stimate in circa $20 milioni di euro.[47][48].

Conclusione

L'intelligenza artificiale sta trasformando il campo di battaglia delle frodi assicurative su scala globale. I truffatori stanno innovando con l'IA generativa per creare falsità più convincenti che mai, da persone e incidenti completamente inventati a imitazioni che possono ingannare anche professionisti esperti. I dati relativi al periodo 2024-2025 mostrano una crescita allarmante di questi schemi alimentati dall'IA, ma evidenziano anche che gli assicuratori che investono nel rilevamento e nella prevenzione possono essere un passo avanti. Combinando tecnologia di rilevamento AI all'avanguardia - Come l'image forensics, l'autenticazione vocale e l'analisi del testo, con flussi di lavoro aggiornati e formazione, il settore può ridurre i rischi senza sacrificare l'efficienza dei processi digitali.

Si tratta di una corsa agli armamenti tecnologici.[49]. Come ha notato un esperto di prevenzione delle frodi, "In questa nuova realtà, la vigilanza è il premio da pagare".[50]. Le compagnie assicurative devono promuovere una cultura della vigilanza e sfruttare i migliori strumenti disponibili per preservare la fiducia nel processo di liquidazione dei sinistri. Ciò significa verificare la veridicità di documenti, voci e immagini con lo stesso rigore con cui i sottoscrittori valutano il rischio. Significa anche collaborare con il settore per condividere le informazioni sulle tattiche di frode AI emergenti e sviluppare congiuntamente degli standard (ad esempio, requisiti standard di metadati per i media inviati o liste nere di settore di identità false conosciute).

Il 2025 è un punto di svolta: gli assicuratori che adattarsi in modo proattivo alle frodi guidate dall'IA proteggeranno i loro clienti e i loro bilanci, mentre chi è lento a reagire potrebbe ritrovarsi bersaglio di truffe da prima pagina. La notizia incoraggiante è che la tecnologia per reagire esiste e sta maturando rapidamente: la stessa IA che dà potere ai truffatori può dare potere agli assicuratori. Implementando soluzioni come la suite di rilevamento AI multimodale di TruthScan per la verifica dei sinistri e dell'identità, gli assicuratori possono ridurre drasticamente il tasso di successo dei tentativi di frode generati dall'AI.[51][52]. In questo modo, non solo prevengono le perdite, ma inviano anche un chiaro messaggio ai potenziali truffatori: non importa quanto siano abili gli strumenti, le frodi saranno scoperte.

In sintesi, le frodi assicurative guidate dall'intelligenza artificiale sono una sfida formidabile, ma che può essere affrontata con una difesa altrettanto intelligente. Con la vigilanza, una strategia interfunzionale e i giusti partner tecnologici, il settore assicurativo può continuare a mantenere la promessa fondamentale alla base della sua attività: pagare solo i sinistri legittimi e farlo in modo rapido e sicuro in un mondo sempre più digitale.

Riferimenti:

- Associazione degli assicuratori britannici - Statistiche sulle frodi 2023[53][54]

- Allianz e Zurich sull'aumento dei sinistri "shallowfake" causati dall'intelligenza artificiale. The Guardian, 2024[4][11]

- Facia.ai - "Frodi assicurative deepfake: Come l'intelligenza artificiale sta riscrivendo le regole". Ottobre 2025[55][56]

- Coalizione contro le frodi assicurative Frodi sintetiche nelle assicurazioni (Quantexa), Dicembre 2024[21][17]

- RGA - "La nuova frontiera della lotta alle frodi: le identità sintetiche". Giugno 2025[15][16]

- Goccia di pino - Rapporto sulle frodi vocali, via FierceHealthcare, giugno 2025[2][3]

- Numeri che girano - "I principali schemi di frode finanziaria 2025". Ottobre 2025[1][57]

- TruthScan - Piattaforma di rilevamento dell'intelligenza artificiale (panoramica dei servizi), 2025[51][52]

- TruthScan - Pagina del prodotto AI Image Detector, 2025[45][39]

- TruthScan - Pagina del prodotto AI Voice Detector, 2025[40]

- TruthScan - Pagina del prodotto di Fake Receipt Detector, 2025[46]

- Mercati speciali Liberty - Comunicato stampa di Deepfake/Assicurazione contro le frodi informatiche, Mar 2025[33]

- Facia.ai - Blog: Corsa agli armamenti per la prevenzione delle frodi assicurative, 2025[24][32]

- Assicurazione Business UK - "Immagini generate dall'intelligenza artificiale utilizzate per le frodi automobilistiche". Aprile 2025[7][58]

- The Guardian - "Le foto false dei danni alle auto mettono in allarme gli assicuratori". Maggio 2024[9][12]

[1] [35] [57] 2025 Schemi di frode finanziaria: Minacce e bandiere rosse dell'intelligenza artificiale

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Le frodi assicurative aumenteranno di 19% a causa degli attacchi vocali nel 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Truffatori modificano le foto dei veicoli per aggiungere danni falsi in una truffa assicurativa nel Regno Unito | Settore assicurativo | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Le immagini generate dall'intelligenza artificiale vengono ora utilizzate per le frodi assicurative - rapporto | Insurance Business UK

[13] [14] [15] [16] La nuova frontiera della lotta alle frodi: identità sintetiche e corsa agli armamenti dell'intelligenza artificiale | RGA

[17] [18] [19] [20] [21] [22] JIFA: Frode sintetica: Con le frodi sintetiche già presenti nel loro ecosistema, gli assicuratori devono pensare più come le banche - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Frodi assicurative deepfake: Come l'intelligenza artificiale sta riscrivendo le regole dei sinistri assicurativi

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] La minaccia silenziosa: Perché le frodi assicurative si spostano sulla linea telefonica

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] L'assicurazione contro il crimine elettronico per le PMI mira alle frodi dei CEO e ai deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Rilevamento dell'intelligenza artificiale e sicurezza dei contenuti per le imprese

[37] Studio: 8 frodatori su 10 prevedono di impiegare l'IA generativa entro il 2025

[38] Approfondimenti dal rapporto di benchmarking sulle tecnologie antifrode 2024

[39] [45] Rilevatore di immagini AI per individuare foto false e manipolate - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] Rilevatore vocale AI per deepfakes e clonazione vocale | TruthScan

https://truthscan.com/ai-voice-detector

[46] Rilevatore di ricevute false TruthScan - Verifica dell'autenticità delle ricevute

https://truthscan.com/fake-receipt-detector

[47] L'assicuratore di Fortune 500 individua 97% di deepfakes e blocca i ...