Introduzione

L'intelligenza artificiale generativa sta rivoluzionando l'assistenza sanitaria, e non sempre in meglio. Nel 2025, gli schemi di frode sanitaria sono cresciuti sempre più digitale e sofisticato, alimentato dalle violazioni dei dati, dall'automazione e dall'IA generativa.[1]. I criminali sfruttano gli strumenti di intelligenza artificiale per creare identità false di pazienti, richieste di risarcimento sintetiche, documenti medici generati dall'intelligenza artificiale, prescrizioni falsificate e persino interazioni medico-paziente falsificate.. Questi inganni ad alta tecnologia portano le frodi a livelli mai raggiunti prima, minacciando le finanze degli assicuratori e la sicurezza dei pazienti in tutto il mondo. La sfida è enorme: le frodi sanitarie costano già decine di miliardi all'anno, e l'ascesa dell'intelligenza artificiale sta intensificando sia la scala che la complessità di truffe[2][3]. Questo whitepaper fornisce uno sguardo dettagliato sulle ultime tendenze delle frodi guidate dall'IA nel settore sanitario, sui casi reali del 2025 e sulle strategie - dai rilevatori di contenuti IA alla verifica dell'identità - per combattere questa minaccia in evoluzione.

L'ascesa degli schemi di frode basati sull'intelligenza artificiale nel settore sanitario

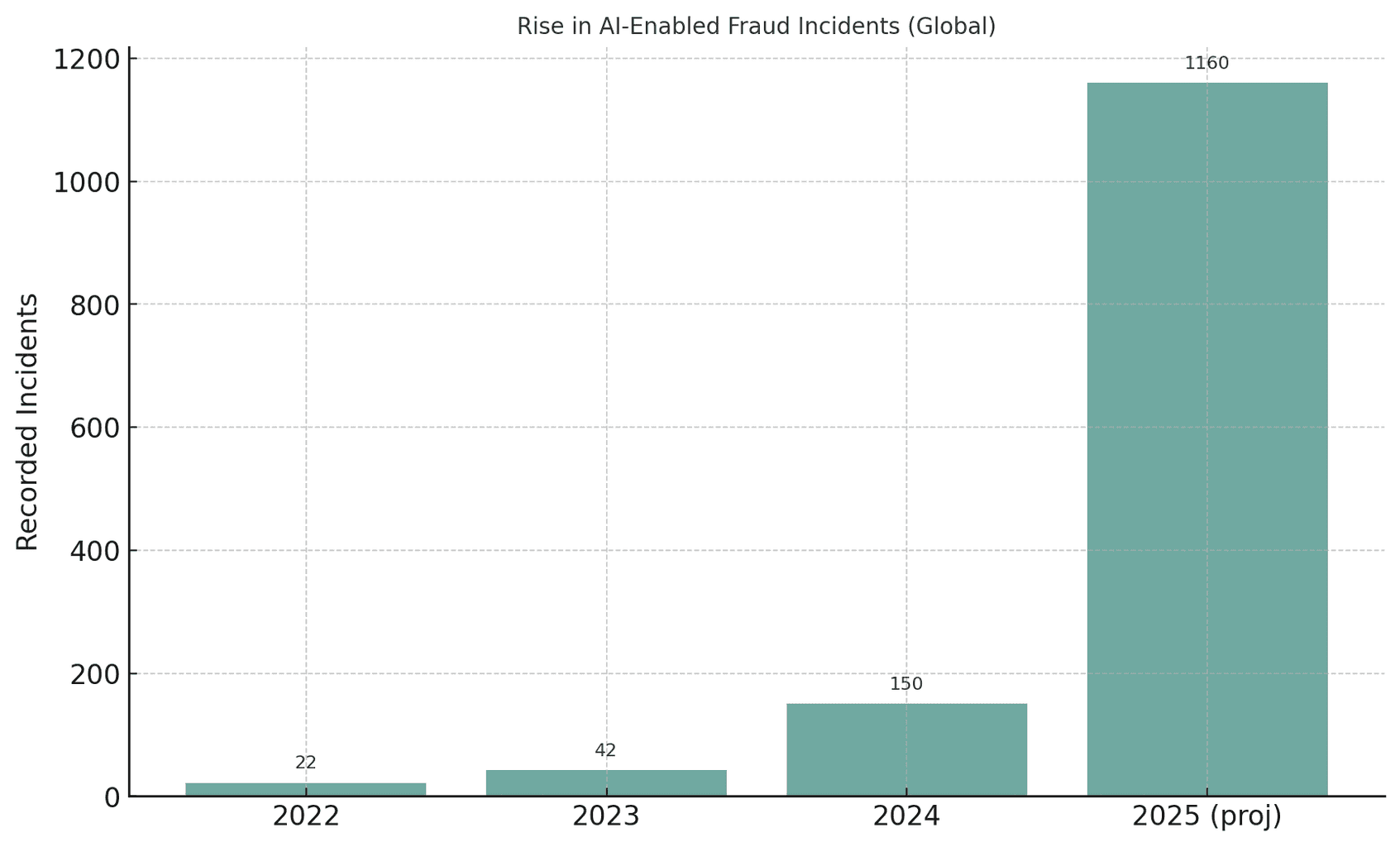

Il settore sanitario mondiale sta vivendo un un'impennata senza precedenti nei tentativi di frode basati sull'AI. Quando l'intelligenza artificiale generativa diventa accessibile, i truffatori possono automatizzare quelle che un tempo erano truffe manuali, producendo identità, documenti e persino voci o video falsi e convincenti su larga scala. Per esempio, le autorità hanno notato che i tentativi di frode con deepfake media sono aumentati di 3.000% nel 2023 solo[4][5]. Gli incidenti legati ai deepfake sono quasi raddoppiati da 22 nel 2022 a 42 nel 2023, per poi esplodere a 150 incidenti nel 2024; sorprendentemente, il primo trimestre del 2025 ha visto 179 casi di frode deepfake, superando già il totale del 2024.[6][7]. Questa tendenza suggerisce un crescita vertiginosa delle frodi guidate dall'IAGli analisti prevedono che l'intelligenza artificiale generativa potrebbe portare a perdite di frodi da Da $12,3 miliardi nel 2023 a $40 miliardi nel 2027 (32% CAGR)[8].

Figura: La crescita esplosiva degli incidenti di frode basati sull'IA negli ultimi anni. I casi rilevati di deepfake o di frodi assistite dall'IA sono aumentati drasticamente dal 2022 al 2025, illustrando come gli strumenti di IA generativa abbiano potenziato i tentativi di truffa.[4][7].

Non preoccupatevi più delle frodi dell'IA. TruthScan Può aiutarvi:

- Rilevare l'IA generata immagini, testo, voce e video.

- Evitare frodi di grande portata guidate dall'intelligenza artificiale.

- Proteggete i vostri prodotti più sensibile beni dell'impresa.

L'assistenza sanitaria è particolarmente vulnerabile a questa ondata di criminalità alimentata dall'intelligenza artificiale. Il vasto e frammentato ecosistema del settore - che comprende ospedali, cliniche, assicurazioni, farmacie e piattaforme di teleassistenza - offre migliaia di punti di attacco.[9][10]. Le truffe tradizionali (ad esempio tessere assicurative false o documenti d'identità rubati ai pazienti) hanno si è evoluto in uno sfruttamento sistemico utilizzando l'intelligenza artificiale[10][11]. In un'acquisizione statunitense del 2025, il Dipartimento di Giustizia ha accusato 324 imputati in schemi per un totale di $14,6 miliardi in false richieste di risarcimento - il più grande caso di frode sanitaria di sempre[12][13]. Molte truffe hanno riguardato consulti di telemedicina e frodi sui test genetici, e un nuovo DOJ Centro di fusione dei dati sulle frodi sanitarie ha utilizzato l'analisi dell'intelligenza artificiale per rilevare in modo proattivo i modelli[14][15]. È chiaro che l'intelligenza artificiale è un'arma a doppio taglio: aiuta gli investigatori a catturare le frodi, ma anche consentendo ai criminali di perpetrare frodi di portata e sofisticazione senza precedenti.[11][2].

Tecniche di frode AI comuni nel settore sanitario (2025)

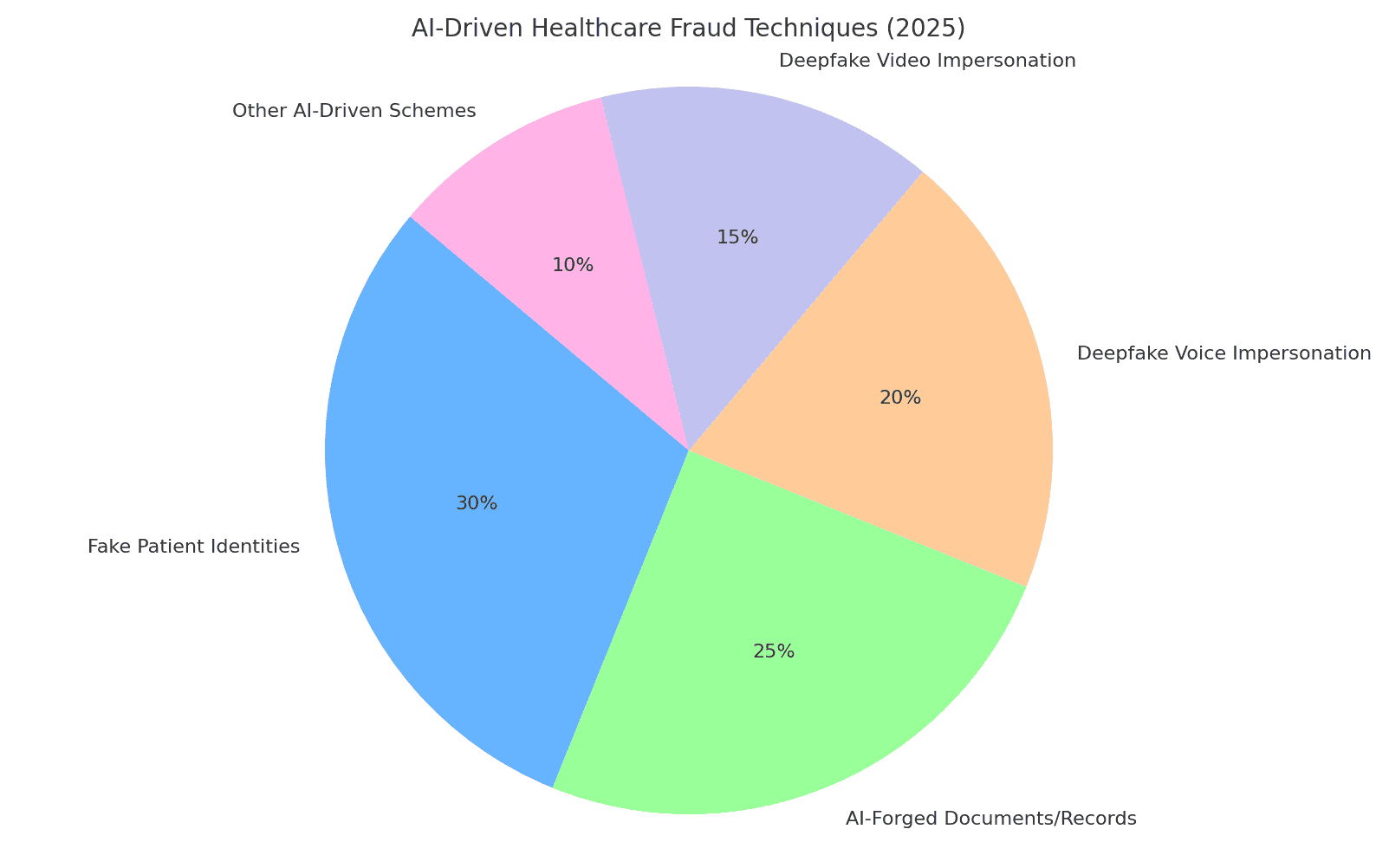

I truffatori nel 2025 hanno a disposizione una serie di tattiche abilitate dall'intelligenza artificiale per frodare i sistemi sanitari e le assicurazioni. Gli schemi principali includono la falsificazione di identità e documenti, la generazione di dati medici falsi e l'impersonificazione di personale fidato tramite deepfake. Di seguito analizziamo le tecniche di frode basate sull'intelligenza artificiale più diffuse e il modo in cui vengono utilizzate contro le organizzazioni sanitarie:

Figura: Ripartizione delle principali tecniche di frode sanitaria guidate dall'IA nel 2025. False identità di pazienti e Documenti falsificati dall'intelligenza artificiale (ad esempio, cartelle cliniche, richieste di risarcimento) comprendono un'ampia quota di schemi, mentre i deepfake voce e imitazioni video sono una minaccia in rapida crescita. "Altri schemi guidati dall'intelligenza artificiale" includono e-mail di phishing create dall'intelligenza artificiale, bot che attaccano i portali dei pazienti ed exploit simili (percentuali stimate sulla base di rapporti di settore).[8][16]).

Identità sintetiche del paziente

False identità di pazienti - spesso creati con l'aiuto dell'intelligenza artificiale, sono una tattica di frode fondamentale. Invece di rubare l'identità di una persona, i criminali combinano i dati reali di più persone con dettagli falsificati per creare un'identità di un'altra persona. identità sintetiche che passano per nuovi pazienti[17][18]. L'IA generativa accelera questo processo producendo documenti personali realistici. Ad esempio, l'IA può generare dati plausibili ID, profili, persino storie di famiglia ("genitori sintetici") per un finto paziente[19][20]. Questi pazienti fantasma vengono poi utilizzati per aprire conti, ottenere polizze assicurative o fatturare servizi che non si sono mai verificati. Durante la pandemia COVID-19, i truffatori hanno usato documenti d'identità sintetici per attingere ai sussidi sanitari d'emergenza; ora li usano per presentare false richieste di rimborso assicurativo o ottenere prescrizionisapendo che un'identità ben creata può eludere il rilevamento[21][22]. Secondo la Federal Reserve degli Stati Uniti, le perdite dovute a frodi di identità sintetiche hanno raggiunto il livello di $35 miliardi nel 2023 e continuare a crescere[23]. L'impatto sull'assistenza sanitaria è grave: i truffatori potrebbero utilizzare il numero di previdenza sociale rubato di un bambino per creare un falso paziente con un credito perfetto, o mescolare i dati rubati del paziente per aggirare la verifica dell'assicuratore.[17][24]. Ogni paziente sintetico introdotto nel sistema mina l'integrità dei dati e può portare a pagamenti errati o addirittura errori clinici se la falsa identità si intreccia con le vere cartelle cliniche.

Documenti medici e richieste di rimborso assicurativo generati dall'intelligenza artificiale

L'IA generativa viene ora utilizzata per forgiare documenti medici, cartelle cliniche e intere richieste di risarcimento assicurativo. I modelli linguistici possono produrre note mediche, riassunti di dimissioni, risultati di laboratorio o estratti conto pieni di gergo medico dall'aspetto autentico, tutti fatti su misura per sostenere una richiesta di risarcimento fraudolenta. In effetti, gli osservatori del settore riferiscono di un 89% aumento dei documenti medici generati dall'intelligenza artificiale in corso di presentazione, rispetto agli anni precedenti[25][26]. I truffatori sfruttano queste false registrazioni per giustificare procedure o farmaci costosi che non sono mai stati forniti o per gonfiare i codici di rimborso. Per esempio, un'intelligenza artificiale potrebbe generare un falso referto di diagnostica per immagini o risultato di laboratorio per giustificare una richiesta di risarcimento per farmaci oncologici ad alto costo. Gli assicuratori e i sistemi sanitari si trovano ad affrontare una marea di richieste di questo tipo. carta sinteticarendendo più difficile distinguere le richieste di risarcimento legittime da quelle false. Nel Regno Unito, gli assicuratori notano una l'uso in rapida crescita di deepfakes e documenti falsificati nelle frodi sui sinistrispesso in richieste di risarcimento apparentemente di routine e di scarso valore per evitare il controllo[27]. Anche l'immaginario clinico non è immune: è dimostrato che I truffatori usano l'intelligenza artificiale generativa per imitare le immagini mediche come radiografie o scansioni[3]. Le conseguenze vanno oltre la perdita finanziaria: se le cartelle cliniche falsificate entrano nelle cartelle dei pazienti, possono portare a diagnosi errate o a trattamenti impropri. Quindi, I documenti sanitari scritti dall'intelligenza artificiale rappresentano un grave rischio per l'integrità e la sicurezza.

Prescrizioni falsificate e frodi in farmacia

Le frodi sulle prescrizioni sono entrate nell'era digitale grazie all'intelligenza artificiale. Prescrizioni falsificate - tradizionalmente realizzati con ricettari rubati o con un editing rudimentale, ora possono essere generati automaticamente con dettagli realistici e firme di medici. I generatori di immagini AI o i modelli consentono di creare in modo semplice stampe di ricette elettroniche dall'aspetto autentico o i moduli d'ordine delle farmacie. Più insidiosamente, i criminali utilizzano clonazione vocale per spacciarsi per medici nelle telefonate con i farmacisti. In un caso, i truffatori si sono introdotti nelle cartelle cliniche per rubare i numeri di registrazione DEA dei medici e poi hanno usato queste credenziali per inviare prescrizioni elettroniche di sostanze controllate.[28]. Ci sono stati casi di Icone vocali false usate per autorizzare le ricariche - un farmacista riceve una chiamata che suona esattamente come un medico conosciuto che conferma una prescrizione, ma in realtà è una voce generata dall'intelligenza artificiale. Di conseguenza, i farmaci controllati (come gli oppioidi o gli stimolanti) possono essere ottenuti illegalmente e deviati. La frode delle prescrizioni falsificate non solo causa perdite finanziarie alle assicurazioni e alle farmacie, ma mette in pericolo i pazienti, che potrebbero ricevere farmaci errati nella loro cartella clinica. Ad esempio, se un truffatore si spaccia per un paziente per ottenere prescrizioni di oppioidi, il paziente può ricevere farmaci non corretti nella sua cartella clinica. la cartella clinica di un vero paziente potrebbe essere aggiornata con farmaci che non ha mai assunto, causando interazioni pericolose o segnalando il paziente come richiedente di farmaci[29]. Questa miscela di criminalità informatica e sfruttamento dell'intelligenza artificiale ha suscitato l'allarme delle autorità di regolamentazione. Le organizzazioni sanitarie devono ora verificare che ogni prescrizione, in particolare quella di farmaci ad alto rischio, sia legittima e che sia stata fatta in modo corretto. veramente provenienti dal fornitore autorizzato, non un deepfake o una violazione dei dati.

Deepfake: imitazioni di medici e pazienti

Forse lo sviluppo più interessante è l'uso di deepfakes per impersonare personale sanitario o pazienti. Nella telemedicina e nel servizio clienti, i truffatori utilizzano video e audio generati dall'intelligenza artificiale per ingannare le persone dall'altra parte. Ad esempio, i criminali hanno creato video deepfake di pazienti per i consulti di teleassistenza, ingannando i medici e convincendoli a fornire "trattamenti" o referti che vengono poi fatturati alle assicurazioni.[30][31]. Al contrario, un truffatore potrebbe simulare le sembianze di un medico - utilizzando il volto e la voce di un medico rispettabile - in una videochiamata per convincere un paziente a pagare un servizio fraudolento o a divulgare informazioni personali. Gli esperti di informatica sanitaria avvertono che La telesalute è diventata un bersaglio facile da raggiungere: si può fissare un appuntamento virtuale utilizzando una falsa identità di paziente, quindi far intervenire un avatar AI in video per ottenere prescrizioni o consigli medici con un pretesto.[31][32]. Al di là della telemedicina, i deepfakes stanno saturando i social media sotto forma di Video di "medici" che promuovono cure miracolose. Nel 2024, gli esperti hanno osservato che i video deepfaked di medici famosi "è decollato davveroche si rivolge al pubblico più anziano con falsi consigli sulla salute e prodotti truffaldini.[33][34]. Medici televisivi di fiducia nel Regno Unito e in Francia hanno clonato le loro sembianze per promuovere false cure per il diabete e integratori per la pressione sanguigna.[35][36]. Fino alla metà degli spettatori non è riuscita a capire che questi video medici deepfake erano falsi[37]. Questa erosione della verità ha dei costi tangibili: i pazienti potrebbero seguire i consigli dannosi di un falso video medico, oppure i truffatori potrebbero fatturare alle assicurazioni consulenze che non sono mai avvenute se non come registrazioni deepfake. In tutto, L'impersonificazione guidata dall'IA mina la fiducia fondamentale nelle interazioni sanitarie - se non ci si può fidare che la persona sullo schermo o sul telefono sia chi dice di essere, l'intero sistema è a rischio.

Impatto e scala: le frodi del 2025 in cifre

Le frodi guidate dall'Intelligenza Artificiale non sono più un problema marginale, ma una grave minaccia per la sicurezza e la finanza dei sistemi sanitari globali. Si considerino le seguenti statistiche e i casi recenti che illustrano il fenomeno. dimensione del problema:

- Perdite annuali: Le frodi sanitarie costano agli Stati Uniti una cifra stimata in $68 miliardi o più ogni anno[25], all'incirca 3-10% di tutte le spese sanitarie[38]. A livello globale, le frodi possono consumare circa 6% di spesa sanitaria[39] - una cifra sconcertante se si considera che la spesa sanitaria mondiale ammonta a trilioni di dollari. Queste perdite si traducono in un aumento dei premi, dei costi ospedalieri e delle risorse destinate all'assistenza dei pazienti.

- Aumento delle frodi nel 2023-2025: L'avvento dell'IA generativa ha portato a un'esplosione dei tentativi di frode. Gli incidenti di frode legati a Deepfake sono aumentati decuplicare dal 2022 al 2023[4]. Nel 2024, gli incidenti deepfake segnalati sono saliti a 150 (un aumento di 257%).[40]e il 2025 è sulla buona strada per superarlo (580 incidenti solo nella prima metà del 2025, quasi 4 volte il totale del 2024).[7]. Gli esperti di frodi notano che 46% hanno riscontrato frodi di identificazione sintetica, 37% frodi vocali e 29% frodi video. nelle loro indagini[8] - evidenziando quanto siano diventate comuni queste tecniche di IA.

- Takedown da record: Gli enti preposti all'applicazione della legge stanno rispondendo con misure di repressione più ampie. Nel giugno 2025, il Dipartimento di Giustizia degli Stati Uniti ha annunciato la la più grande frode sanitaria della storiaaccusando 324 persone e scoprendo $14,6 miliardi in richieste di risarcimento fraudolente[1][13]. Gli schemi comprendevano truffe per consulenze di teleassistenza, frodi per test genetici e truffe di attrezzature mediche durevoli su vasta scala.[13]. Nell'ambito di questo sforzo, Medicare sospesi $4 miliardi di euro di pagamenti in sospeso ritenuti sospetti[41]per prevenire tali perdite. Un caso fondamentale ("Operazione Gold Rush") ha rivelato un giro internazionale che utilizzava identità rubate per depositare $10,6 miliardi di euro di false dichiarazioni per forniture mediche[42] - una testimonianza di quanto i criminali siano disposti a spingersi oltre quando sono armati di dati violati e automazione.

- Impatto degli assicuratori: Gli assicuratori di tutto il mondo stanno assistendo ad un aumento delle frodi legate all'intelligenza artificiale. Nel Regno Unito, gli assicuratori segnalano un crescente utilizzo di deepfakes nei sinistri (spesso "low touch" per evitare di essere scoperti).[27]. Un'importante società di riassicurazione avverte che le cartelle cliniche falsificate e le condizioni di salute false stanno compromettendo la sottoscrizione e potrebbero far aumentare le perdite nel settore delle assicurazioni vita e malattia.[43]. Un'analisi Deloitte del 2024 prevede che entro il 2027, le frodi generate dall'intelligenza artificiale potrebbero rappresentare $40 miliardi di perdite annue negli Stati Uniti. (da $12,3 miliardi nel 2023)[8]. Questa traiettoria implica un colpo significativo ai profitti degli assicuratori se non vengono adottate solide contromisure.

- Vittime del paziente: Anche i pazienti e il pubblico stanno perdendo denaro a causa di queste truffe. Gli anziani, in particolare, sono stati presi di mira dalle truffe vocali dell'intelligenza artificiale (telefonate "nipote in difficoltà") e dalle truffe sanitarie fittizie. Nel 2023, gli anziani statunitensi hanno riportato $3,4 miliardi in perdite per frode, con un aumento di 11% rispetto all'anno precedente[44][45] - alcuni di questi sono guidati da schemi potenziati dall'intelligenza artificiale. Al di là del costo monetario, c'è un'altra questione. costo umanoI consigli medici fraudolenti e i falsi trattamenti pubblicizzati tramite l'IA possono portare a danni fisici o alla perdita di fiducia nelle indicazioni sanitarie legittime.

Nel complesso, il 2025 ha chiarito che L'intelligenza artificiale sta mettendo il turbo alle frodi sanitarie tradizionali. Quelli che una volta erano piccoli schemi opportunistici si sono trasformati in operazioni industrializzate che coprono tutti i continenti. La combinazione di big data (spesso provenienti da violazioni) e generazione di intelligenza artificiale significa che le truffe possono essere messe in atto con una velocità e una plausibilità spaventose. Le perdite globali si aggirano sulle decine di miliardi e sono in aumento.e tutte le parti interessate, dagli ospedali alle assicurazioni, fino ai pazienti, sono a rischio. La prossima sezione illustra come il settore può reagire utilizzando tecnologie e strategie altrettanto avanzate.

Difendersi dalle frodi guidate dall'intelligenza artificiale: Strategie e soluzioni

Affrontare le frodi sanitarie basate sull'intelligenza artificiale richiede un arsenale di difese altrettanto avanzate. I dirigenti del settore sanitario, i team di cybersecurity, i responsabili della compliance e gli assicuratori devono coordinarsi per incorporare misure antifrode in ogni punto vulnerabile - dall'inserimento del paziente al pagamento dei sinistri. Di seguito sono riportate le strategie chiave e le soluzioni tecniche per contrastare le frodi guidate dall'intelligenza artificiale:

- Strumenti di rilevamento dei contenuti AI: Così come i criminali usano l'IA per creare contenuti, le organizzazioni possono usare l'IA per rilevarli. Avanzato Rilevatori di contenuti scritti dall'intelligenza artificiale (come la suite di TruthScan) analizzano testi, immagini, audio e video per identificare i segni rivelatori della generazione di IA. Ad esempio, la piattaforma di TruthScan applica l'apprendimento automatico per individuare gli schemi statistici e le stranezze linguistiche che indicano la presenza di testo generato dall'IA, con oltre Precisione 99%[46][47]. Questi strumenti possono essere integrati nei sistemi di gestione dei sinistri o nelle cartelle cliniche elettroniche per contrassegnare automaticamente documenti sospetti - ad esempio, un referto medico che probabilmente è stato scritto da ChatGPT - per una revisione manuale. Allo stesso modo, l'AI forense delle immagini può rilevare scansioni mediche manipolate o documenti d'identità falsi, e gli algoritmi di rilevamento deepfake possono analizzare i video alla ricerca di segni di sintesi (artefatti nei pixel, tempi strani dei movimenti del viso, ecc.)[48][49]. Impiegando rilevatori di intelligenza artificiale multimodali, le organizzazioni sanitarie possono escludere in tempo reale gran parte dei contenuti falsificati dall'intelligenza artificiale. prima che provochi danni.

- Verifica della cartella clinica e dei documenti: Gli operatori sanitari si rivolgono a soluzioni specializzate per verificare l'autenticità dei documenti e dei sinistri. Ciò include l'hashing e la firma digitale dei documenti legittimi, nonché l'utilizzo di database di modelli di documenti noti e validi da confrontare con quelli inviati. I servizi di verifica basati sull'intelligenza artificiale (per esempio, TruthScan Autenticazione dei documenti medici ) è in grado di analizzare istantaneamente il contenuto e i metadati di un documento per determinare se è stato generato o alterato da una macchina.[50][51]. Esaminano le incongruenze che potrebbero sfuggire a un essere umano, come sottili anomalie di formattazione o metadati che indicano che un'immagine è stata prodotta dall'IA. Monitoraggio in tempo reale delle cartelle cliniche e delle richieste di rimborso assicurativo per le anomalie è anche essenziale[52]. Analizzando continuamente le nuove voci (risultati di laboratorio, note mediche, allegati alle richieste di risarcimento), questi sistemi possono individuare i record falsi. prima che portano a pagamenti fraudolenti o a errori clinici. Alcuni assicuratori hanno implementato regole per cui qualsiasi documentazione di richiesta di rimborso identificata come generata dall'intelligenza artificiale viene automaticamente estratta per le indagini sulle frodi. L'obiettivo è garantire che ogni cartella clinica o richiesta di risarcimento che entra nel flusso di lavoro è affidabile e inalterata.

- Prova e convalida dell'identità: Il rafforzamento della verifica dell'identità è fondamentale nell'era dei documenti d'identità sintetici. Gli enti sanitari devono far rispettare rigorosa verifica dell'identità dei nuovi pazienti, fornitori e venditori. Ciò può comportare l'autenticazione a più fattori, i controlli biometrici (come il riconoscimento facciale o le impronte digitali al momento della registrazione) e l'utilizzo di servizi di verifica dell'identità che sfruttano l'intelligenza artificiale per rilevare le impronte digitali. documenti d'identità falsi o dati personali non corrispondenti. Ad esempio, il riconoscimento facciale può essere combinato con test di vivacità per evitare che un volto generato dall'IA possa passare per un paziente reale attraverso una foto. Sul retro, gli algoritmi possono effettuare una verifica incrociata dei dettagli di un paziente (indirizzo, telefono, e-mail, presenza sui social media) per individuare le identità "sottili" che non hanno una storia normale - un indizio noto dei documenti d'identità sintetici.[53]. Gli istituti finanziari hanno utilizzato con grande successo i controlli di coerenza del background guidati dall'intelligenza artificiale.[54]e l'assistenza sanitaria possono fare lo stesso: ad esempio, segnalare un nuovo richiedente di Medicare se non ha un'impronta digitale precedente a quest'anno. Convalida delle identità dei fornitori è altrettanto importante: garantire che il medico in un video di teleassistenza sia autorizzato e che sia effettivamente chi dice di essere, magari rilasciando certificati digitali o video filigranati difficili da imitare per i deepfake. Nelle farmacie, il personale dovrebbe ricontrollare le richieste di prescrizione insolite tramite chiamate dirette ai fornitori e utilizzare frasi in codice o domande di verifica per sconfiggere i potenziali impostori vocali dell'intelligenza artificiale.

- Rilevazione integrata delle frodi nei flussi di lavoro: Per proteggere veramente il sistema, la rilevazione delle frodi non può essere una fase a sé stante: deve essere In ogni flusso di lavoro in un'organizzazione sanitaria.

In pratica, questo significa che ospedali e assicurazioni stanno implementando integrazioni API per chiamare servizi di rilevamento delle frodi nei momenti critici. Ad esempio, quando un fornitore invia una richiesta di rimborso con documenti allegati, un servizio di intelligenza artificiale potrebbe valutare automaticamente l'autenticità di tali allegati in pochi secondi. Se viene avviato un appuntamento di teleassistenza, la piattaforma potrebbe eseguire l'analisi della voce passiva in background per assicurarsi che il chiamante non stia usando una voce sintetizzata. Monitoraggio continuo è fondamentale: le moderne piattaforme di frode offrono dashboard che tracciano i segnali di frode in tutta l'organizzazione (convalide fallite, segnalazione frequente di richieste di risarcimento da parte di una determinata clinica, ecc. Trattando le frodi sanitarie in modo più simile alle minacce informatiche - con Monitoraggio 24 ore su 24, 7 giorni su 7, rilevamento delle anomalie e risposta rapida agli incidenti. - le organizzazioni possono cogliere i problemi prima che si trasformino in una spirale[55].

- AI per l'analisi delle frodi e il riconoscimento dei modelli: Il volume dei dati sanitari è così grande che l'intelligenza artificiale è indispensabile per trovare modelli di frode che sfuggono agli esseri umani. I modelli di apprendimento automatico possono essere addestrati su casi di frode storici per individuarne di nuovi (ad esempio, raggruppando le richieste di risarcimento che hanno codici ICD simili e insoliti, o identificando quando la fatturazione di un medico si discosta notevolmente da quella degli altri). Gli assicuratori stanno già usando l'analisi predittiva per valutare le richieste di risarcimento per il rischio di frode in tempo reale. Tecniche emergenti come le reti neurali a grafo possono mappare le relazioni tra pazienti, fornitori, diagnosi e richieste di risarcimento per individuare connessioni improbabili (come lo stesso numero di serie del dispositivo utilizzato in richieste di risarcimento di Stati diversi). La suite di TruthScan per le frodi assicurative, ad esempio, comprende riconoscimento dei modelli di sinistro e la modellazione predittiva per individuare i circuiti di frode organizzati e i modelli atipici prima che le perdite si accumulino.[56][57]. Il Fusion Center del DOJ del 2025 ha esemplificato questo approccio, aggregando i dati di Medicare e delle assicurazioni private per individuare in modo proattivo i gruppi di attività sospette.[58]. Anche le organizzazioni sanitarie dovrebbero condividere dati e modelli di intelligenza artificiale in consorzi per ampliare i segnali di frode che ciascuno può rilevare. Più dati (entro i limiti della privacy) alimentano questi modelli, più diventano bravi a discernere il comportamento normale da quello fraudolento.

- Formazione del personale e controllo dei processi: La tecnologia è fondamentale, ma la consapevolezza umana rimane una difesa potente. Il personale sanitario e gli amministratori dovrebbero essere istruiti sulle tattiche di frode abilitate dall'intelligenza artificiale, ad esempio sapendo che un un'e-mail perfettamente scritta da un amministratore delegato potrebbe essere un phishing creato dall'intelligenza artificiale.o che dovrebbero verificare l'identità dei videochiamanti se qualcosa sembra "fuori posto" (strani movimenti oculari o ritardo audio possono far pensare a un deepfake). Per le nuove minacce, come le truffe telefoniche deepfake, si possono implementare esercitazioni e suggerimenti regolari (come la formazione sulla consapevolezza del phishing). Semplici controlli di processo aggiungono livelli di sicurezza: richiedere richiami o verifiche secondarie per richieste di pagamento grandi o insolite, utilizzare canali di comunicazione sicuri per le informazioni sensibili e mantenere un piano di risposta agli incidenti specifico per le sospette frodi mediate dall'intelligenza artificiale. È importante che le organizzazioni coltivino una cultura in cui i dipendenti si sentono autorizzati a mettere in discussione le anomalieanche se si tratta di un "medico" in video che fa una richiesta strana. Molte truffe deepfake hanno successo sfruttando la fiducia e l'autorità; una forza lavoro vigile che conosce questi trucchi può fermare gli incidenti in anticipo. Come ha osservato un esperto, affrontare i deepfake potrebbe diventare una routine come individuare le e-mail di phishing, una parte standard dell'igiene della sicurezza informatica.[32][59].

- Sfruttare i servizi specializzati: Data la rapida evoluzione delle minacce dell'IA, molte organizzazioni sanitarie collaborano con fornitori specializzati nella prevenzione delle frodi. Servizi come TruthScan per la sanità offrono soluzioni end-to-end personalizzate per i casi d'uso in campo medico, tra cui: il monitoraggio in tempo reale dell'integrità delle cartelle cliniche elettroniche (EMR), verifica dei documenti del paziente contro la manipolazione dell'IA, il rilevamento di deepfake per la teleassistenza e la segnalazione di conformità (ad esempio, tracce di audit che dimostrino la dovuta diligenza nel rilevamento delle frodi per le autorità di regolamentazione).[60][51]. Tali piattaforme spesso forniscono Integrazione API per integrarsi perfettamente nei sistemi esistenti e sono costruiti per soddisfare le normative sanitarie (HIPAA, GDPR).[61][62]. Utilizzando strumenti di livello aziendale, anche le cliniche più piccole o gli assicuratori regionali possono accedere a funzionalità avanzate di rilevamento dell'intelligenza artificiale senza doverle sviluppare internamente. Inoltre, assicuratori e fornitori dovrebbero tenere d'occhio gli aggiornamenti delle normative e degli standard di settore, ad esempio le nuove leggi contro le frodi deepfake (alcune giurisdizioni ora vietano esplicitamente i deepfake medici e gli Stati Uniti stanno ampliando le leggi sul furto d'identità per coprire l'impersonificazione dell'IA).[63]). L'allineamento a questi standard e l'impiego di strumenti all'avanguardia non solo ridurranno le perdite dovute alle frodi, ma dimostreranno anche una solida posizione di sicurezza a partner, revisori e pazienti.

Conclusioni e prospettive

Il 2025 ha dimostrato che il il genio è uscito dalla bottiglia - L'IA generativa e l'automazione sono ora intrecciate con le frodi sanitarie. In futuro, i truffatori continueranno probabilmente a innovare: potremmo vedere modelli di IA che imparano a imitare lo stile di scrittura di specifici medici o deepfakes che reagiscono in tempo reale alle domande di sfida. La battaglia sarà una continua corsa agli armamenti. Tuttavia, il settore sanitario sta rispondendo con altrettanto vigore, investendo in difese basate sull'IA e in flussi di lavoro più rigidi per la sicurezza. Combinando tecnologia di rilevamento all'avanguardia, processi di verifica rigorosi, condivisione dei dati tra i vari settori e vigilanza da parte dei dipendenti.Le organizzazioni sanitarie possono mitigare in modo sostanziale la minaccia di frode facilitata dall'IA.

È fondamentale che non si tratti solo di un problema informatico, ma di una questione di governance e di fiducia. I consigli di amministrazione e i dirigenti del settore sanitario devono riconoscere le frodi legate all'IA come un rischio strategico per le finanze e la fiducia dei pazienti, che merita attenzione e risorse regolari. I team di conformità dovrebbero aggiornare le valutazioni del rischio di frode per includere gli aspetti dell'IA e gli assicuratori potrebbero rivedere le ipotesi di sottoscrizione sapendo che una certa percentuale di richieste di risarcimento potrebbe essere una frode assistita dall'IA. D'altro canto, l'utilizzo dell'IA in modo etico nel settore sanitario (per il supporto alle decisioni cliniche, l'efficienza della fatturazione, ecc.

In sintesi, L'IA generativa ha cambiato il gioco delle frodi ma, grazie alla consapevolezza e alle contromisure avanzate, non deve sopraffare il sistema. Le organizzazioni che avranno successo saranno quelle che si terranno informate sulle minacce emergenti, si adatteranno rapidamente con difese basate sull'IA e promuoveranno una cultura di "verifica e fiducia" piuttosto che di "fiducia di default". In questo modo, l'assistenza sanitaria può sfruttare in modo sicuro gli aspetti positivi dell'IA e neutralizzarne l'uso improprio, proteggendo sia i profitti che il benessere dei pazienti nell'era digitale.

Fonti: Rapporti e casi recenti del settore citati in precedenza, tra cui Pymnts (luglio 2025).[2][3], Istituto Swiss Re (giugno 2025)[27], Federal Reserve Bank di Boston (aprile 2025)[19], BMJ (2024)[37]e le schede delle soluzioni TruthScan (2025).[51][64], tra gli altri. Tutti i dati e le citazioni riflettono gli ultimi disponibili nel 2024-2025, illustrando lo stato attuale delle frodi guidate dall'IA nel settore sanitario e le risposte per combatterle.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] Il Dipartimento di Giustizia riconosce gli strumenti di intelligenza artificiale nella storica repressione delle frodi sanitarie

[4] [5] [6] [7] [16] [40] [44] [45] Statistiche e tendenze del Deepfake 2025 | Dati e approfondimenti chiave - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes e la crisi del sapere | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] La Gen AI sta aumentando la minaccia di frodi di identità sintetiche - Federal Reserve Bank of Boston

[25] [26] [56] [57] [62] [64] Rilevazione delle frodi nell'assicurazione sanitaria e sulla vita - TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Come deepfakes, disinformazione e IA amplificano le frodi assicurative | Swiss Re

[28] La DEA mette in guardia dalle frodi sulle prescrizioni elettroniche - Pharmacy Practice News

[29] [39] Cybersecurity e frodi nel settore sanitario: Un'immersione profonda nei rischi e nelle difese più importanti di oggi | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] L'evoluzione della minaccia delle truffe di telemedicina deepfake, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Gli esperti mettono in guardia dai truffatori che usano "falsi profondi" di medici famosi sui social media

[35] [36] [37] Medici televisivi di fiducia "falsificati" per promuovere truffe sanitarie sui social media - Gruppo BMJ

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [Stato attuale della ricerca Ajit Appari e M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - Rilevamento dell'intelligenza artificiale e sicurezza dei contenuti per le imprese

[50] [51] [52] [60] [61] Rilevamento delle frodi nelle cartelle cliniche AI | Soluzioni CRO per la sanità | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Quanto sono pericolosi i Deepfake e le altre frodi basate sull'intelligenza artificiale?