A biztosítási csalás új korszakba lép, amelyet a mesterséges intelligencia hajt. A kifinomult csalóhálózatok és a magányos csalók egyaránt kihasználják a generatív mesterséges intelligencia eszközeit hamis igények, szintetikus személyazonosságok, mélyen hamisított bizonyítékok és rendkívül meggyőző megszemélyesítő csalások előállítására. Ez a fehér könyv megvizsgálja az AI által vezérelt biztosítási csalások legújabb, 2025 trendjét - az AI által generált követelésektől és dokumentumoktól a mélyen hamisított hanggal történő csalásokig -, és felvázolja, hogy a biztosítók hogyan reagálhatnak. Bemutatjuk a legfrissebb adatokat, valós eseteket és stratégiai meglátásokat a biztosítók, csalásnyomozók, kiberbiztonsági csapatok, kárrendezési menedzserek és C-suite vezetők számára, akiknek meg kell érteniük ezt a gyorsan változó fenyegetettségi környezetet.

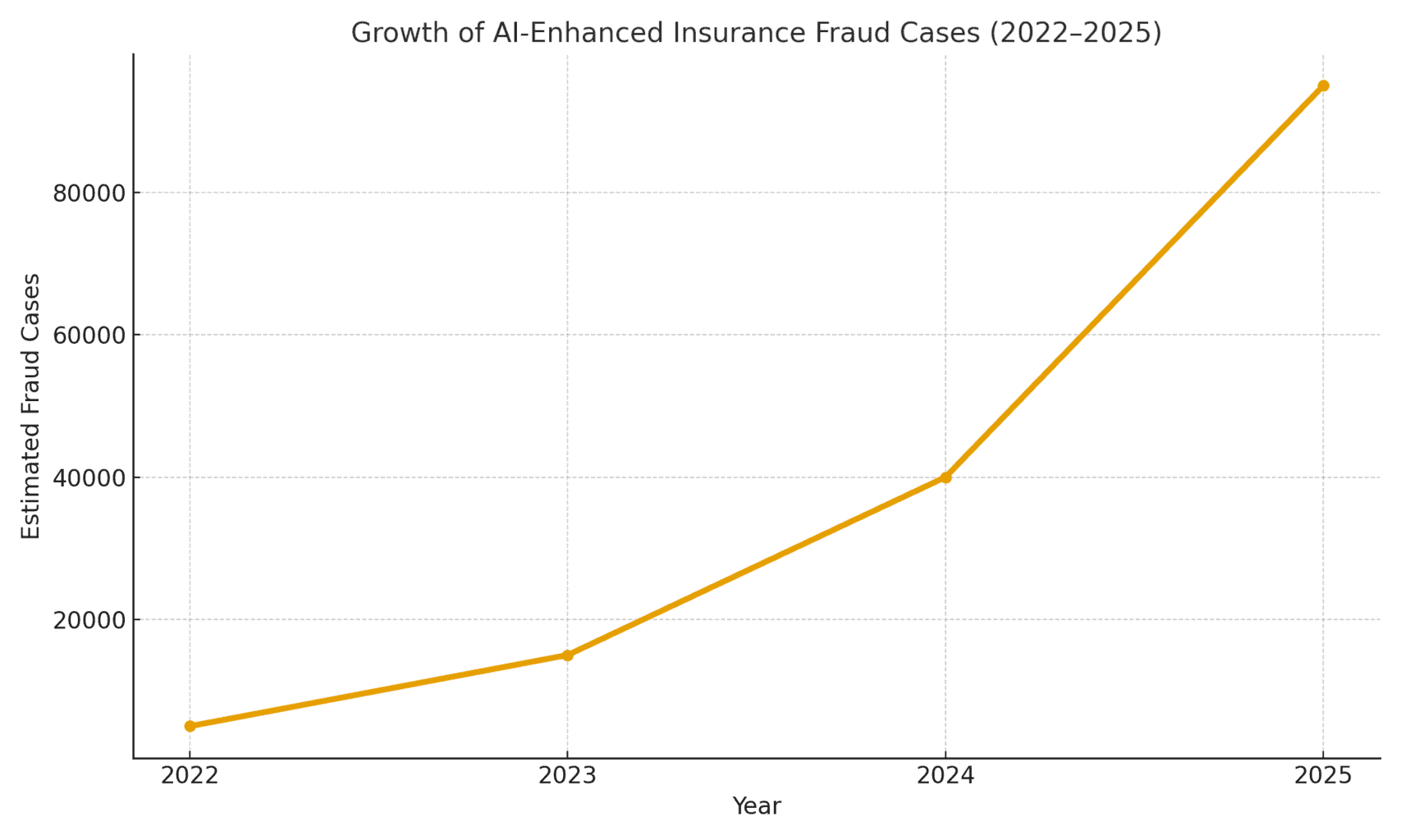

A fenyegetés mértéke: A mesterséges intelligencia által lehetővé tett csalások száma egyre nő. Egy 2025-ös törvényszéki könyvelési jelentés megállapította, hogy A mesterséges intelligencia által vezérelt csalások már az összes digitális pénzügyi csalás több mint felét teszik ki[1]. A biztosítási kifejezetten, hang biztonsági cég Pindrop megfigyelt egy 475% 2024-ben a biztosítótársaságoknál elkövetett szintetikus hangalapú csalások száma növekszik, hozzájárulva a biztosítási csalási kísérletek 19%-os növekedéséhez az előző évhez képest.[2]. A biztosítók szembe nagyjából 20-szor nagyobb csalási kockázat, mint a bankoknál, részben a dokumentumokra, képekre és hangalapú igazolásokra való nagyfokú támaszkodásnak köszönhetően[3]. Az alábbi 1. ábra az AI által támogatott biztosítási csalások robbanásszerű növekedését mutatja 2022 és 2025 között, mivel több iparági jelentés is három- vagy négyszámjegyű százalékos növekedést jelzett az AI csalásban való részvételének észlelésében.

1. ábra: A mesterséges intelligenciával támogatott biztosítási csalások gyors növekedése (indexált növekedés 2022-2025). Az iparági adatok azt mutatják, hogy exponenciálisan nő az AI-generált tartalom, amelyet csalárd kárigényekben találnak, különösen 2023 óta.[4][2]

Mesterséges intelligencia által generált állítások és hamis bizonyítékok

Az egyik legelterjedtebb trend a generatív mesterséges intelligencia használata a kézműves teljesen hamisított biztosítási igények. A fejlett mesterséges intelligencia szöveggenerátorok segítségével a csalók egyetlen gombnyomással valósághű leírásokat, orvosi jelentéseket vagy rendőrségi nyilatkozatokat írhatnak. Ezek a mesterséges intelligenciával írt elbeszélések gyakran csiszoltnak és hihetőnek tűnnek, ami megnehezíti a kárbecslők számára, hogy észrevegyék a következetlenségeket. A csalók például a ChatGPT segítségével részletes baleseti leírásokat vagy sérülésjelentéseket készítettek, amelyek professzionálisnak és meggyőzőnek tűnnek - ez a feladat korábban jelentős erőfeszítést és írói készséget igényelt.

Ennél is aggasztóbb, hogy a bűnözők ezeket a hamis narratívákat most azzal párosítják. Mesterséges intelligencia által generált alátámasztó bizonyítékok. A képgeneráló modellek (mint a Midjourney vagy a DALL-E) és a szerkesztőeszközök fotorealisztikus sérülés- és sérülésfotókat tudnak készíteni. Az iparági jelentések szerint néhány járművezető elkezdett mesterséges intelligencia által generált képek benyújtása a járműkárok eltúlzása érdekében az autós kárigényekben[5]. A generatív mesterséges intelligencia képes olyan fotót készíteni egy összetört autóról vagy egy elárasztott házról, amely valójában soha nem is létezett. Ezek a képek gyakran valósághűbb, mint amit a régebbi Photoshop technikákkal el lehetett érni[6], így szabad szemmel nehezen észlelhetők. 2025 áprilisában a Zurich Insurance a kárigények növekedését észlelte a hamisított számlák, hamisított javítási becslések és digitálisan módosított fényképek.beleértve azokat az eseteket, amikor a jármű rendszámát mesterséges intelligenciával illesztették be a megmentett autók képeire.[7][8]. Az ilyen hamis bizonyítékok, ha egy jól megírt, mesterséges intelligenciával írt igénylőlappal kombinálják őket, átcsúszhatnak a kézi felülvizsgálatokon.

Az Egyesült Királyságban egy feltűnő eset során csalók egy közösségi média fotó egy kereskedő furgonjáról, és a mesterséges intelligencia segítségével hozzáad egy repedt lökhárítót., majd egy hamis javítási számlával együtt benyújtotta egy hamis baleseti kárigény részeként 1000 fontról szóló hamis javítási számlával együtt.[9]. Az átverés csak akkor derült ki, amikor a nyomozók észrevették a ugyanaz kisteherautó fotó (a sérülés előtt) a tulajdonos Facebook-oldalán[10]. Ez egy szélesebb körű jelenséget illusztrál: a biztosítók jelentenek egy 300% ugrás a "sekélyes" képszerkesztésben (egyszerű digitális manipulációk sérülések hozzáadására vagy részletek megváltoztatására) mindössze egy év alatt (2021-2022 vs. 2022-2023)[4]. Az Allianz UK 2024-ben arra figyelmeztetett, hogy a digitális fényképek torzításai és a hamis dokumentumok "minden jel arra mutat, hogy a legújabb nagy átveréssé válnak, amely az iparágat sújtja".[4]. A Zurich követelés csalásért felelős vezetője szintén megjegyezte, hogy ami korábban egy fizikai autóbaleset megrendezését igényelte, ma már teljes egészében a számítógép mögött történhet. - a csalók "a billentyűzetük mögül csalárd követelést hozhatnak létre, és jelentős összegeket vonhatnak ki" hamis totálkáros fotókkal és jelentésekkel.[11][12]. Ez az elmozdulás nemcsak a hamisított követelések mennyiségét növeli, hanem csökkenti a belépési korlátot is a leendő csalók számára.

Soha többé ne aggódjon az AI-csalások miatt. TruthScan Segíthet:

- AI generált érzékelése képek, szöveg, hang és videó.

- Kerülje a jelentős mesterséges intelligencia által vezérelt csalás.

- Védje a leg érzékeny vállalati eszközök.

Az autókon túl, vagyon- és baleseti kárigények a veszteségek mesterséges intelligencia által támogatott inflációját látják. Vannak jelentések hamis fotókról az utasbiztosításhoz (pl. poggyász "sérülése" vagy megrendezett lopási jelenetek) és AI által generált számlák drága tárgyakról, amelyeket soha nem vásároltak meg. Élet- és egészségbiztosítási igények sem immunisak - a csalók hamis orvosi számlák és halotti bizonyítványok mesterséges intelligencia dokumentumhamisítókkal. Valójában a Zürich megjegyezte, hogy a deepfake technológiát arra használják, hogy létrehozzanak teljesen fiktív mérnöki értékelések és orvosi jelentések kárrendezési csomagokban[11]. Ezek a mesterséges intelligencia által generált, gyakran valósághű logókkal és aláírásokkal ellátott dokumentumok megkülönböztethetetlenek lehetnek a valódi papírmunkától. Az életbiztosítók számára egyre nagyobb aggodalomra ad okot, hogy gyászjelentés- és halotti anyakönyvi csalás: a bűnözők a mesterséges intelligencia segítségével hamis gyászjelentéseket vagy orvosi leveleket állíthatnak elő, hogy alátámasszák egy olyan személy halálhírét, aki valójában még mindig él (vagy aki soha nem is létezett, amint azt a következőkben tárgyaljuk).

Szintetikus kötvénytulajdonosok és identitások

Talán a leg alattomosabb fejlemény szintetikus személyazonossággal kapcsolatos csalás a biztosításban. A szintetikus személyazonossággal való csalás során fiktív személyt vagy szervezetet hoznak létre valós adatok (lopott társadalombiztosítási számok, címek stb.) és hamisított adatok (hamis nevek, hamis személyazonosító okmányok) kombinálásával. A mesterséges intelligencia fejlődésének köszönhetően triviálisan egyszerűvé vált a következők előállítása valósághű személyes profilok - fényképekkel és személyazonossági adatokkal együtt - olyan emberek számára, akik nem is léteznek.[13][14]. A csalók most már algoritmikusan létrehozhatnak egy teljesen hamis ügyfelet, a nevükre kötvényt vásárolhatnak, és később a hamis személyazonossághoz tartozó követeléseket vagy biztosítási juttatásokat állíthatnak be.

Az életbiztosítási ágazatban a szintetikus személyazonossági rendszerek az egekbe szökött. A 2025-ös iparági kutatás becslései szerint a szintetikus személyazonossággal kapcsolatos csalás költségei évente több mint $30 milliárd, ami akár a 80-85% az összes személyazonossággal kapcsolatos csalási esetek száma a pénzügyi szolgáltatások területén[15][16]. Az életbiztosítókat különösen keményen sújtotta: a csalókról ismert, hogy életbiztosítási kötvényeket kötnek egy fiktív személyre, majd papíron "megölik" ezt a személyt, hogy felvegyék a haláleseti juttatást.[17]. Egy csaló például létrehozhat egy "John Doe" nevű szintetikus ügyfelet, egy évig fizethet díjakat, majd hamis halotti anyakönyvi kivonattal és gyászjelentéssel nyújthat be igényt John Doe korai elhalálozásáról. Mivel a személyazonosságot gondosan felépítették (hiteltörténet, közhiteles nyilvántartások stb.), a halálesetre vonatkozó kérelem törvényesnek tűnhet - egészen addig, amíg nem találnak valódi holttestet vagy valódi hozzátartozókat. Mire a csalásra fény derül, az elkövetők már rég eltűntek a kifizetéssel együtt.

Szintetikus identitási rendszerek is sújtják egészségbiztosítás és autóbiztosítás. A bűnszövetkezetek "Frankenstein" személyazonosságokat hoznak létre azáltal, hogy gyermekek vagy idősek társadalombiztosítási számainak (amelyeknek nincs hiteltörténete) használata mesterséges intelligencia által generált nevekkel és jogosítványokkal kombinálva.[15]. Aztán egészségbiztosítást vagy autóbiztosítást vásárolnak ezeknek a hamis személyeknek, és röviddel ezután nagy összegű követeléseket nyújtanak be.. Az egyik változat a szindikátusok létrehozása álvállalkozások (fedőcégek) - például egy kamionos kamionos cég - és kereskedelmi biztosítást kötnek rá, hogy aztán később megrendezett balesetekre vagy a dolgozók álsérüléseire hivatkozzanak.[18][19]. Mivel a vállalkozás csak papíron létezik (mesterséges intelligencia által generált cégbejegyzésekkel és adóazonosítókkal), ez a "entitás alapú" szintetikus csalás gyakran csak a kárigények kifizetése után derül ki.[18][20].

Miért olyan hatékonyak a szintetikus identitások? Egyrészt gyakran átjutnak az automatikus személyazonosság-ellenőrzésen. A hitelintézetek és a KYC-rendszerek találhatnak nincsenek piros zászlók mert a személyazonosság valós, érvényes adatokat tartalmaz (pl. valós SSN azonosító, tiszta nyilvántartással).[21]. Eközben a mesterséges intelligencia által generált profilképek és személyazonossági szkennelések teljesen hitelesnek tűnhetnek - a mai mesterséges intelligencia képes olyan emberi arcot létrehozni, amelyet még a fejlett arcfelismerés is valósnak fogadhat el. Az eredmény: a legtöbb automatizált rendszer ezeket a profilokat legitimnek ismeri fel és a csalás csak akkor bukik le (ha egyáltalán), amikor már nagy veszteségek keletkeztek.[22].

Valós hatás: Az RGA jelentése szerint a szintetikus személyazonossággal kapcsolatos csalás az életbiztosítások terén most évente mintegy $30B-ba kerül az ágazatnak és 2020 óta csaknem 400%-tal nőtt[15][16]. Az Egyesült Államok Szövetségi Kereskedelmi Bizottságának becslése szerint a személyazonossággal kapcsolatos csalások túlnyomó többsége szintetikus személyazonossági igazolványokból áll.[16]. Ezek a veszteségek végső soron a becsületes biztosítottak pénztárcáját sújtják - minden család becslések szerint évente \$700 \$700 többletdíjat fizet a biztosítókra nehezedő szélesebb körű csalási teher miatt.[15]. A biztosítók válaszul fokozzák az ellenőrzést a beszálláskor és a kárigényléskor: adatbázis-ellenőrzéseket hajtanak végre a személyazonosság összekapcsolására, figyelemmel kísérik, hogy ugyanazon a címen több kötvényt kötnek-e, és még "élethűségi" teszteket is futtatnak (selfie-videó-ellenőrzések annak biztosítására, hogy az igénylő valódi személy legyen, ne csak egy AI-kép).[23][24]. De amint látni fogjuk, a csalók a következő területen a mesterséges intelligenciával lépnek fel: a mély hamisított hangok és videók.

Deepfake hangok és videó állítások

AI-generált audio és video deepfakes a biztosítási csalás egy riasztó új dimenzióját adják. 2023-ban és 2024-ben több olyan eset is történt, amikor a bűnözők a következő módszereket használták hangklónozás hogy telefonon keresztül adják ki magukat magánszemélyeknek - ez a taktika eredetileg bankrablásoknál volt megfigyelhető (mint például a hírhedt deepfake vezérigazgatói telefonhívás, amellyel 2020-ban $35 millió dollárt loptak el), de mostanra már a biztosítási szektorban is elterjedt. A csalók klónozzák a biztosítottak, orvosok vagy kárrendezők hangját, és felhasználják őket a social engineering csalásokban. A Pindrop 2024-es elemzése arra figyelmeztetett, hogy "a mély hamisítványok, a szintetikus hangtechnológia és az AI által vezérelt csalások átformálják a csalási tájképet", hangcsalással példátlan ütemben skálázódik[25]. Megállapították, hogy a biztosítási call centereket tengerentúli rossz szereplők bombázták a hangmásolatok segítségével: például hívások érkeztek, amelyek egy valódi biztosított ellopott SSN-jét és személyes adatait adták meg, és ha egy ügynök válaszolt, a a hívó mesterséges intelligenciával klónozott hangja becsaphatja az ügynököt a tudásalapú hitelesítésen keresztül és kérjen csalárd kifizetést.[26]. Az egyik nyugati parti biztosító esetében a támadók többször használták ezt a módszert, hogy megpróbálják átvenni a számlákat és átirányítani a kifizetéseket, kihasználva azt a tényt, hogy a call center azonosító ellenőrzése hangra és személyes adatokra támaszkodott, amelyek hamisíthatók.[26].

A hangutánzást a fogyasztói oldalon is alkalmazták: A csalók felhívták a balesetek áldozatait vagy a kedvezményezetteket, miközben akik biztosítási képviselőnek adják ki magukat, a mesterséges intelligencia hangjainak hivatalosnak tűnő hangját használják, hogy érzékeny információkat vagy akár fizetéseket csaljanak ki. Ezzel szemben egy csaló kiadhatja magát ügyfélnek egy kárigénykezelési forródróton, hogy telefonon keresztül, az ügyfél nemének/korának megfelelő mély, hamis hangon történő igényérvényesítés.így megkerülve a hangbiometriai ellenőrzést. A legújabb csalási statisztikák kijózanítóak: az iparági szakértők előrejelzései szerint a 162% a biztosítók elleni deepfake csalási támadások növekedése a következő évben[27], és Pindrop rögzített egy 475% 2024-ben a szintetikus hangtámadások száma megugrik mint korábban említettük[2]. Ezek a támadások gyorsan megelőzik a hagyományosabb kibercsalási vektorokat.

A telefonhívásokon túl, videó alapú deepfakes a kárigénylési folyamat során merülnek fel. Sok biztosító virtuális kárrendezési vizsgálatokat és videokonferenciákat vezetett be (a világjárvány által felgyorsított módon), hogy távolról ellenőrizze a károkat, illetve interjúkat folytasson a kárigénylőkkel. Most a csalók a mesterséges intelligencia avatarok és hamisított videók felhasználásával becsapják ezeket az ellenőrzéseket.. Jelentések szerint az igénylők a Mesterséges intelligencia által generált avatárok élő videóhívásokban a kiigazítókkal, hogy valaki másnak adják ki magukat, vagy hogy elrejtsék a következetlenség jeleit.[28]. Például egy csalóhálózat használhat egy deepfake-et. "élő" videó egy állítólagos igénylőről, aki okostelefonon keresztül mutatja be a kárát, miközben a kamerában látható személy valójában egy mesterséges intelligenciával szintetizált kompozit vagy egy felbérelt színész, aki arcváltoztató szűrőket visel. Az egyik spekulatív, de hihető forgatókönyv szerint egy deepfake-et használnak egy elhunyt személy: Egy életjáradék- vagy életbiztosítási csalás során a családtag egy rutinszerű életbiztosítási hívás során a közelmúltban elhunytról készült hamis videót használhat, hogy továbbra is kapjon kifizetéseket.[29]. Bár még nem került nyilvánosságra ilyen jellegű nagy horderejű eset, a biztosítók felkészülnek rá. A szabályozó hatóságok is tudomásul veszik - az Egyesült Államokban és Európában tárgyalások folynak a mély hamisítványok személyazonosság-lopás alá történő besorolásáról és a biztosítási bizonyítékok ellenőrzésére vonatkozó iránymutatások frissítéséről.[30].

A deepfake videók és hangok felderítése technikai eszközök nélkül nagy kihívást jelent. Az emberi beállítókat nem képezték ki arra, hogy felismerjék a finom ajakszinkronizációs problémákat vagy akusztikai furcsaságokat. Néhány esetben azonban voltak már piros zászlós jelek: például természetellenes pislogás vagy archibák a videón, vagy olyan háttérhang-artifaktumok egy hívás során, amelyek a nyomozókat figyelmeztették. Összességében azonban, a deepfake biztosítási csalás még korai stádiumban van, és a büntetőeljárás továbbra is ritka - 2023-ban a jogi meghatározások nem voltak egyértelműek, és szakértői elemzés nélkül nehéz volt bizonyítani, hogy egy videó mesterséges intelligencia által generált volt.[31]. Ez büntetlenséget biztosít a csalóknak. A fegyverkezési verseny folytatódik: a biztosítók most a törvényszéki mesterséges intelligencia a mesterséges intelligencia elleni küzdelemben, Deepfake detektáló algoritmusok alkalmazása a gyanús videók képkockáról képkockára történő átvizsgálására a manipuláció jelei miatt[24]. A hangbiometriai gyártók olyan mély hamis hangdetektorokat hoznak forgalomba, amelyek a spektrális mintákat és az énekhang kadenciáját elemzik a hitelesség érdekében.[32]. Ezeket a védelmi technológiákat egy későbbi szakaszban tárgyaljuk.

AI-fejlesztett adathalász és megszemélyesítő csalások

Nem minden mesterséges intelligenciával támogatott csalás történik a kárigénylési osztályon keresztül; egyes célpontok ügyfelek és alkalmazottak social engineering segítségével. Mesterséges intelligencia által készített adathalász e-mailek és szövegek jelentős fenyegetést jelentenek a biztosítási területen. Ezekben a rendszerekben a csalók mesterséges intelligencia chatbotokat és fordítóeszközöket használnak, hogy rendkívül meggyőző átverési kommunikációt hozzanak létre. A bűnözők például egy biztosítótársaság márkajelzését és írásmódját megszemélyesítve tömeges adathalász e-maileket küldhetnek a biztosítottaknak, amelyekben azt mondják nekik, hogy "sürgős cselekvésre van szükség a biztosítási szerződés felmondásának megakadályozásához", és egy hamis weboldalra irányítják őket. A múltbeli ügyetlen csaló e-mailekkel ellentétben, Az AI biztosítja a kifogástalan nyelvtant és még a személyre szabást is, ami sokkal hihetőbbé teszi őket. Láttuk, hogy a mesterséges intelligenciát arra használják, hogy a közösségi médiát olyan részletekért kutassák fel, amelyeket beleszőnek a spear-phishing üzenetekbe, például egy nemrég történt autóvásárlásra való hivatkozással egy hamis autóbiztosítási értesítésben.

Egy másik vektor Ügynökök vagy vezetők mesterséges intelligenciával támogatott megszemélyesítése. Voltak olyan esetek, amikor csalók klónozták a hangját egy biztosítási ügynökség tulajdonosának, és hangposta üzeneteket hagytak az ügyfeleknek, amelyekben banki információk frissítését kérték - gyakorlatilag egy hangalapú adathalász támadás. Hasonlóképpen, a belső csalás is eredhet mesterséges intelligencia megszemélyesítéséből: az egyik biztosító pénzügyi osztálya majdnem áldozatul esett, amikor csalók egy mélyen hamisított hangüzenetet küldtek. állítólag a vezérigazgatótól pénzátutalás engedélyezése (a "vezérigazgatói csalás" egyik változata, amely ma már egyes elektronikus bűnözésre vonatkozó biztosítási kötvények hatálya alá tartozik).[33]). Az ilyen típusú mesterséges intelligencia által vezérelt megszemélyesítő csalások száma a Liberty Specialty Markets szerint 2023-ban 17%-ra nőtt.[33], és várhatóan tovább emelkedik.

A fogyasztókat szintetikus médiacsalások is megcélozzák biztosításhoz kötve. A Koalíció a biztosítási csalás ellen nevű szervezet megállapítja, hogy csalók biztosítási ügyintézőnek adják ki magukat, és a balesetek áldozataival kapcsolatba lépve azt állítják, hogy ők kezelik a kárigényüket, majd pedig azonnali fizetés vagy érzékeny adatok követelése[23]. A gyanútlan ügyfelek, megkönnyebbülve, hogy egy állítólagos képviselőtől hallanak a hívó féltől, esetleg engedelmeskednek, különösen, ha a hívó fél ismeri a balesetük részleteit (amit az AI hackelésből vagy nyilvános forrásokból megtudhat). A közvélemény kevéssé ismeri ezeket a taktikákat, ezért a csalásmegelőzési szakértők arra ösztönzik a biztosítókat, hogy a biztosítottak felvilágosítása a hívók és az e-mailek személyazonosságának ellenőrzéséről[23][34]. Ahogy a bankok figyelmeztetik az ügyfeleket az adathalászatra, úgy a biztosítók 2025-ben kezdik a kommunikációjukba foglalni a deepfake csalásra vonatkozó figyelmeztetéseket.

Az egyik közös pont ezekben a mesterséges intelligenciával kiegészített rendszerekben a könnyen elérhető "csalás mint szolgáltatás" készletek használata.[35]. A sötét weben a bűnözők olyan eszközöket vásárolhatnak vagy iratkozhatnak fel, amelyek előre elkészített deepfake hangokat, hamis dokumentumsablonokat, adathalász e-mail generátorokat és egyebeket kínálnak. A mesterséges intelligencia eszközök demokratizálódása azt jelenti, hogy még az alacsonyan képzett csalók is képesek kifinomult csalási támadásokat indítani[35]. A biztosítótársaságok számára ez azt jelenti, hogy mindenhonnan - kárigények, ügyfélszolgálat, e-mail, sőt még a közösségi médiából is - meggyőzőbb csalási kísérletek özöne érkezik. Ez aláhúzza, hogy többoldalú védelmi stratégiára van szükség, amely egyesíti a technológiát, az emberi éberséget és az iparágak közötti együttműködést.

Felderítés és védelem: A mesterséges intelligencia által vezérelt válasz

A mesterséges intelligencia által vezérelt csalás elleni küzdelemhez AI-vezérelt védelem. A biztosítók egyre inkább a fejlett felderítési technológiák és a megújított folyamatok felé fordulnak, hogy ellensúlyozzák a támadást. A biztosítóknak lényegében be kell építeniük tartalmi hitelesítési ellenőrzési pontok az egész biztosítási életciklus során - a kockázatvállalástól a kárigénylésen át az ügyfélkapcsolatokig -, hogy kiszimatolja az AI-hamisításokat. A 2. ábra a mesterséges intelligencia által lehetővé tett legfontosabb csalástípusokat és azok elterjedtségét mutatja be, a következő szakaszok pedig részletezik, hogyan lehet felismerni és megakadályozni az egyes típusokat.

2. ábra: A mesterséges intelligenciával támogatott biztosítási csalások típusai 2025-ben (becsült részesedés rendszerenként). A legnagyobb kategóriák közé tartoznak a hamis képek (manipulált kárfotók) és a szintetikus személyazonosságok, majd az AI-hamisított dokumentumok (pl. nyugták, igazolások) és a mélyhamisított audio/video csalások.

1. AI tartalomérzékelő eszközök: Az új mesterséges intelligencia-felismerő szolgáltatások képesek elemezni a szöveget, képeket, hangokat és videókat, hogy megállapítsák, hogy azok gépi előállításúak vagy manipuláltak-e. A biztosítók például olyan megoldásokat használhatnak fel, mint például a A TruthScan AI szöveg- és képdetektorai amelyek a 99%+ pontos mesterséges intelligenciát használják a mesterséges intelligenciával írt dokumentumok vagy hamisított fényképek megjelölésére.[36]. Egy biztosítótársaság integrálhatná ezeket a detektorokat a kárigénylési rendszerébe: amikor egy kárigényt és annak bizonyítékait benyújtják, a szöveges leírást automatikusan át lehet vizsgálni mesterséges intelligencia által generált nyelvi mintákra, és a feltöltött képeket is át lehet vizsgálni a CGI vagy a szerkesztés árulkodó jelei után. A vállalati szintű eszközök 99% pontossággal azonosítja az AI által generált szöveget dokumentumokban, e-mailekben és kommunikációban.[36]és hasonlóképpen a mesterséges intelligencia által generált vagy manipulált képek felismerése a vizuális tartalom hitelességének biztosítása érdekében[36]. Ez azt jelenti, hogy a ChatGPT által készített hamis baleseti beszámolót vagy egy útközbeni hamisított kárfotót kézi felülvizsgálatra jelölnek, mielőtt a kárigényt feldolgozzák. A biztosítók 2025-ben egyre inkább elfogadják az ilyen AI tartalomhitelesítést - sőt, A csalás elleni szakemberek 83%-je tervezi, hogy 2025-ig integrálja a generatív mesterséges intelligencia felismerést.az ACFE felmérése szerint, a mai 18%-ről mindössze 18% használja ezt a módszert.[37][38].

2. Személyazonosság-ellenőrzés és biometrikus ellenőrzések: A szintetikus személyazonosságok kezelése érdekében a biztosítók a KYC-protokollokat mesterséges intelligenciával is továbbfejlesztik. A személyazonosság-ellenőrzési szolgáltatások több adatbázisban is képesek a kérelmező adatait összevetni, és arcfelismerést használnak az élethűség tesztelésével. Például, ha a bejelentkezés során egy rövid videós szelfit kérnek (és a megadott azonosítóval való arcillesztést alkalmaznak), sok szintetikus azonosítót meghiúsíthatnak. A még csúcstechnológiásabb vállalatok, mint a TruthScan, olyan képi törvényszéki vizsgálatokat kínálnak, amelyekkel mesterséges intelligencia által generált profilképek, avatárok és szintetikus személyiségképek helyszínei - az AI képdetektoruk a StyleGAN vagy a ThisPersonDoesNotExist generátorok által készített arcok azonosítására képzettek[39]. Az ilyen eszközök alkalmazásával a biztosító felismerheti, ha az életbiztosítási kérelmező szelfije nem valódi ember. A hangoldalon, hangalapú biometrikus hitelesítés az ügyfélszolgálati hívásoknál segíthet; a modern hangalapú mesterséges intelligencia detektorok képesek arra, hogy szintetikus hangok és hangklónozási kísérletek azonosítása valós időben[40]. Például a TruthScan AI hangfelismerés a rendszer akusztikai elemzést használ felismeri a mesterséges intelligencia által generált hangokat és hanghamisításokat, mielőtt azok becsapnák a telefonközpontok személyzetét.[40]. Ezek a megoldások tűzfalként működnek - ha valaki John Doe-nak adja ki magát, és a hangmintája nem egyezik John Doe hiteles hangjával (vagy nem felel meg az ismert deepfake jellemzőknek), a hívást megjelölhetik, vagy további személyazonossági bizonyítékot kérhetnek. A többfaktoros hitelesítés (e-mail/SMS megerősítés, egyszeri jelszavak stb.) további akadályokat gördít a megszemélyesítők elé.

3. Deepfake Video & Image Forensics: A videobizonyítékok tekintetében a biztosítók kezdik alkalmazni a speciális törvényszéki elemzést. A fejlett szoftverek képesek elemezni a videó metaadatait, a képkockák konzisztenciáját és a hibaszinteket, hogy felismerjék a mély hamisítványokat. Egyes eszközök a tükröződéseket, árnyékokat és fiziológiai jeleket (például a személy torkában lévő pulzust a videón) vizsgálják, hogy megbizonyosodjanak arról, hogy a videó valódi. Metaadatok törvényszéki vizsgálata szintén értékes: a fájlok metaadatainak és a képek vagy PDF-ek generációs nyomainak vizsgálata felfedheti, hogy valamit valószínűleg mesterséges intelligencia eszközzel állítottak-e elő.[41]. A biztosítóknak például eredeti (metaadatokat tartalmazó) fényképfájlokat kellene kérniük, nem pedig csak képernyőképeket vagy nyomtatott másolatokat. A Zürich csalással foglalkozó csoportja sikerrel járt a hamisított autókról készült képek kiszűrésében a kép metaadataiban és a hibaszint-elemzésben található rendellenességek észlelésével.[41]. Email átverés detektorok hasonlóképpen vizsgálhatja a bejövő kommunikációt az AI által írt adathalász tartalmak vagy ismert rosszindulatú jelek után.[42]. Sok biztosító mostanában adathalász-szimulációkat és mesterséges intelligenciával készített átverési példákat futtat az alkalmazottak képzésében, hogy növelje a tudatosságot.

4. Folyamatváltozások és emberi képzés: A technológia önmagában nem jelent megoldást. Folyamatfejlesztések készülnek, mint például a nagyobb értékű követelések gyakoribb szúrópróbaszerű, személyes helyszíni ellenőrzése, vagy bizonyos esetekben a fizikai dokumentáció megkövetelése. Egyes biztosítók elhalasztották a teljesen automatizált, egyenes feldolgozású kárigények feldolgozását, és újra emberi felülvizsgálatot alkalmaznak azon kárigények esetében, amelyek magas pontszámot kaptak a mesterséges intelligencia csaláskockázati modellben. Az emberi oldalon a képzés kulcsfontosságú. A csalási nyomozókat és a kárbecslőket arra képzik ki, hogy felismerjék a mesterséges intelligenciára utaló jeleket: pl. több azonos megfogalmazású követelés (ChatGPT "stílus"), a valódi véletlenszerűséget nélkülöző képek (pl. ismétlődő minták olyan esetekben, amikor szerves károknak kellene lenniük), vagy olyan hangok, amelyek úgy hangzanak, hogy majdnem jobbra, de robotikus ritmusú. A biztosítók is oktatják az ügyfeleket: csalásra figyelmeztető üzeneteket küldenek a deepfake rendszerekről, és tanácsot adnak, hogyan lehet ellenőrizni a biztosítási képviselő személyazonosságát (például ismert visszahívási szám megadásával).

5. Együttműködési erőfeszítések: Az iparági szintű együttműködés fokozódik. Az Egyesült Királyságban az Insurance Fraud Bureau és a Brit Biztosítók Szövetsége munkacsoportokat hozott létre az AI csalással kapcsolatban, a kormány pedig a A biztosítási csalásról szóló charta (2024) elősegíti az adatmegosztást és a közös kezdeményezéseket[43]. A biztosítók világszerte együttműködnek kiberbiztonsági cégekkel és AI startupokkal. Különösen új biztosítási termékek jelennek meg: A Liberty Mutual elindított egy e-bűnözés elleni biztosítás a kkv-k számára, amely kifejezetten a deepfake csalásokra és a vezérigazgatói csalásokra terjed ki.[44][33], kiemelve, hogy ez a kockázat nagyon is valós. Ez azt is jelenti, hogy a biztosítók egyszerre lehetnek az AI-csalások áldozatai és megoldói: ha nem fedezik fel a deepfake csalást, akkor kifizetik a kártérítést, de fedezetet kínálnak másoknak is, akiket ilyen támadások érnek.

Az észlelési technológia munkafolyamatokba történő integrálása a követelések életciklusában többpontos védelemként jeleníthető meg. Amint azt a 3. ábra, a biztosítók a mesterséges intelligencia ellenőrzési lépéseket a politika alkalmazása (a szintetikus személyazonosságok kiszűrése személyazonosító okmányok és szelfik ellenőrzése révén), a kárigény benyújtása (a feltöltött dokumentumok, fényképek vagy hangok automatikus elemzése AI-generálás céljából), a kárigény felülvizsgálata/vizsgálat (a gyanús bizonyítékokon mélyreható hamisításos törvényszéki elemzés elvégzésére és a hanginterakciók ellenőrzésére), valamint közvetlenül a kifizetés (végső személyazonosság-hitelesítés, amely biztosítja a kedvezményezett jogszerűségét). A csalás korai észlelésével - ideális esetben már az induláskor vagy a káresemény első bejelentésekor - a biztosítók vizsgálati költségeket takarítanak meg, és elkerülhetik a jogtalan kifizetéseket.

3. ábra: A mesterséges intelligencia észlelési pontjainak integrálása a biztosítási életciklusba. A biztosítási kötvények kötésekor a mesterséges intelligencia alapú személyazonosság-ellenőrzés ellenőrzi a szintetikus vagy hamis személyazonosságokat. A kárigény benyújtásakor az automatikus érzékelők a kárigény szövegét, dokumentumait és képeit vizsgálják a mesterséges intelligencia által generált tartalomra. A kárigények felülvizsgálata során speciális deepfake és hangelemző eszközök ellenőrzik az audio/videó bizonyítékokat. A kifizetés előtt a biometrikus személyazonosság-ellenőrzés megerősíti a kedvezményezett személyazonosságát. Ez a többrétegű megközelítés segít a csalás több szakaszban történő feltartóztatásában.

A biztosítóknak nem kell mindezeket a képességeket házon belül kiépíteniük - sokan fordulnak olyan vállalati megoldásokhoz, mint például a A TruthScan AI Detection Suite, amely számos olyan eszközt kínál, amelyek API-integrálhatók a biztosítók rendszereibe. Például, A TruthScan AI Image & Deepfake Detection szolgáltatása több mint 99% pontossággal használható képek és videók hitelességének ellenőrzésére[45]. Az ő AI szövegdetektor jelöli a mesterséges intelligenciával írt szöveget az állításokban vagy e-mailekben[36], míg a AI hangdetektor hangklón-felismerést és hangszóró-ellenőrzést biztosít a telefonos csalók megállításához[40]. Vannak még olyan hiánypótló eszközök is, mint a Hamis nyugta detektor a számlák/bevallások azonnali elemzése hamisítás vagy mesterséges intelligencia által generált betűtípusok/layoutok után.[46] - rendkívül hasznos, tekintettel a hamis javítási számlák elterjedtségére a kárigényekben. Ezen eszközök kombinációjának alkalmazásával egy biztosító drasztikusan javíthatja a csalások felderítési arányát. Az egyik Fortune 500 biztosító arról számolt be, hogy 97% a deepfake kísérletekből 2024-ben a többszintű mesterséges intelligencia-szűrési megközelítés (szöveg, kép, hang) alkalmazásával, és ezáltal a becslések szerint \$20M veszteségek elkerülése révén[47][48].

Következtetés

A mesterséges intelligencia globális szinten átalakítja a biztosítási csalások csataterét. A csalók a generatív mesterséges intelligencia segítségével olyan hamisítványokat hoznak létre, amelyek minden eddiginél meggyőzőbbek - a teljesen kitalált emberektől és balesetektől kezdve a személyazonosságot megszemélyesítő, tapasztalt szakembereket is megtévesztő hamisítványokig. A 2024-2025-ös adatok az ilyen, mesterséges intelligencia által táplált rendszerek riasztó növekedését mutatják, de arra is rávilágítanak, hogy azok a biztosítók, akik a felderítésbe és megelőzésbe fektetnek be, egy lépéssel előrébb járhatnak. A következők kombinálásával csúcstechnológiás mesterséges intelligencia-érzékelési technológia - mint például a képi törvényszéki vizsgálat, a hanghitelesítés és a szövegelemzés - naprakész munkafolyamatokkal és oktatással az iparág csökkentheti a kockázatokat anélkül, hogy feláldozná a digitális folyamatok által biztosított hatékonyságot.

A lényeget tekintve ez egy technológiai fegyverkezési verseny.[49]. Ahogy egy csalásmegelőzési szakértő megjegyezte, "Ebben az új valóságban az éberség az a prémium, amit meg kell fizetni"[50]. A biztosítótársaságoknak elő kell mozdítaniuk az éberség kultúráját, és a rendelkezésre álló legjobb eszközöket kell felhasználniuk a kárigénylési folyamatba vetett bizalom megőrzése érdekében. Ez azt jelenti, hogy a dokumentumok, hangok és képek valódiságát ugyanolyan szigorúan kell ellenőrizni, mint ahogyan a biztosítók a kockázatértékelés során teszik. Ez azt is jelenti, hogy az ágazaton belül együtt kell működni az újonnan megjelenő AI csalási taktikákkal kapcsolatos információk megosztása és a szabványok közös kidolgozása érdekében (például a benyújtott médiára vonatkozó szabványos metaadat-követelmények vagy az ismert hamis személyazonosságokat tartalmazó ágazati feketelisták).

2025 egy fordulópont: a biztosítók, amelyek proaktívan alkalmazkodni a mesterséges intelligencia által vezérelt csalásokhoz megvédik ügyfeleiket és mérlegüket, míg a lassan reagálók a címlapokra kerülő átverések célpontjaivá válhatnak. A biztató hír az, hogy a visszavágáshoz szükséges technológia már létezik, és gyorsan fejlődik - ugyanaz a mesterséges intelligencia, amely a csalóknak ad erőt, a biztosítóknak is adhat erőt. Az olyan megoldások bevezetésével, mint a TruthScan multimodális AI-felismerő csomagja a kárigények és a személyazonosság ellenőrzéséhez, a biztosítók drámaian csökkenthetik az AI által generált csalási kísérletek sikerességi arányát.[51][52]. Ezzel nemcsak a veszteségeket előzik meg, hanem egyértelmű üzenetet küldenek a leendő csalóknak: nem számít, milyen okos eszközökkel dolgoznak, a csalás lelepleződik.

Összefoglalva, a mesterséges intelligencia által vezérelt biztosítási csalás komoly kihívás, de ugyanilyen intelligens védelemmel is meg lehet vele küzdeni. Éberséggel, többfunkciós stratégiával és a megfelelő technológiai partnerekkel a biztosítási ágazat továbbra is fenntarthatja az üzleti tevékenységének középpontjában álló alapvető ígéretet: csak a jogos kárigények kifizetését, méghozzá gyorsan és biztonságosan, egy egyre inkább digitális világban.

Hivatkozások:

- Brit Biztosítók Szövetsége - Csalási statisztikák 2023[53][54]

- Allianz & Zurich az AI-"shallowfake" kárigény hullámról - The Guardian, 2024[4][11]

- Facia.ai - "Deepfake biztosítási csalás: A szabályok átírása a mesterséges intelligencia által"," Október 2025[55][56]

- Koalíció a biztosítási csalás ellen - Szintetikus csalás a biztosításban (Quantexa), december 2024[21][17]

- RGA - "A csalás elleni küzdelem új határa: szintetikus identitások"," június 2025[15][16]

- Pindrop - Hangcsalási jelentés, via FierceHealthcare, június 2025[2][3]

- A számok forgatása - "Top pénzügyi csalási rendszerek 2025," Október 2025[1][57]

- TruthScan - AI Detection Platform (szolgáltatások áttekintése), 2025[51][52]

- TruthScan - AI Image Detector termékoldal, 2025[45][39]

- TruthScan - AI Voice Detector termékoldal, 2025[40]

- TruthScan - Fake Receipt Detector termékoldal, 2025[46]

- Liberty Specialty Markets - Deepfake/Cyber Fraud Insurance sajtóközlemény, március 2025[33]

- Facia.ai - Blog: A biztosítási csalások megelőzésének fegyverkezési versenye, 2025[24][32]

- Insurance Business UK - "A mesterséges intelligencia által generált képeket motoros csalásra használják". április 2025[7][58]

- The Guardian - "Hamis autós kárfotók riasztják a biztosítókat," május 2024[9][12]

[1] [35] [57] 2025 Pénzügyi csalási rendszerek: Vörös zászlók

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] A biztosítási csalások száma 2024-ben 19%-tel nőtt a hangalapú támadások miatt

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Csalók szerkesztés jármű fotók hozzá hamis kárt brit biztosítási átverés | Biztosítási ágazat | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] AI-generált képeket használnak gépjármű-felelősségbiztosítási csalásra - jelentés | Insurance Business UK

[13] [14] [15] [16] A csalás elleni küzdelem új határa: szintetikus identitások és az AI fegyverkezési versenye | RGA

[17] [18] [19] [20] [21] [22] JIFA: Szintetikus csalás: A szintetikus csalás már az ökoszisztémájukban van, a biztosítóknak jobban kell gondolkodniuk, mint a bankoknak - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake biztosítási csalás: Hogyan írja át a biztosítási kárigények szabályait az AI?

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] A csendes fenyegetés: Miért a biztosítási csalás költözik a telefonvonalra

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] A kkv-knak szóló elektronikus bűnügyi biztosítás a vezérigazgatói csalásokat és a deepfakes-t célozza - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Vállalati AI felderítés és tartalombiztonság

[37] Tanulmány: 2025-re generatív AI alkalmazására számít 8 a 10 csalás elleni harcosból

[38] A 2024-es csalás elleni technológiai benchmarking jelentés meglátásai

[39] [45] AI Image Detector | Hamis és manipulált fotók felismerése - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI hangdetektor a mély hamisítások és hangklónozás ellen | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Hamis nyugta detektor | Ellenőrizze a nyugta hitelességét

https://truthscan.com/fake-receipt-detector

[47] Fortune 500 Biztosító észleli 97% a Deepfakes és leállítja a szintetikus ...