Bevezetés: A mesterséges intelligencia által vezérelt támadások új korszaka

A 2025-ös év fordulópontot jelent a kiberbiztonságban. A generatív mesterséges intelligencia felturbózta a kibertámadásokat, lehetővé téve a fenyegető szereplők számára, hogy több gyakori, reális és skálázható kampányok, mint valaha. Valójában az elmúlt évben a becslések szerint A bejelentett kiberincidensek 16%-ében a támadók mesterséges intelligencia eszközöket használtak fel. (pl. kép- és nyelvi generációs modellek) a társadalmi mérnöki tevékenység fokozására.[1]. A rendkívül meggyőző adathalász e-mailektől a mélyen hamisított audio/video átverésekig a rosszindulatú szereplők minden ágazatban fegyverként használják a mesterséges intelligenciát. A biztonsági szakemberek többsége mostanában a a kibertámadások megugrása a generatív mesterséges intelligenciának köszönhető, ami a rosszfiúknak gyorsabb és okosabb módot ad az áldozatok kihasználására.[2]. A generatív mesterséges intelligencia hatékonyan csökkenti a kiberbűnözés képességeit, miközben növeli annak erejét.

Miért olyan aggasztó ez? A mesterséges intelligencia azonnal képes olyan csiszolt, kontextustudatos tartalmat előállítani, amely még a képzett felhasználókat is megtéveszti. Ijesztő pontossággal képes hangokat és arcokat megszemélyesíteni, és még olyan rosszindulatú kódot is képes generálni, amely a felismerés elkerülése érdekében átalakul. Ennek eredményeképpen a kibertámadásokat nehezebbé vált felderíteni és könnyebbé végrehajtani. A Világgazdasági Fórum arra figyelmeztet, hogy a szervezetek 72%-je tapasztalta a kiberkockázatok - különösen a social engineering és a csalás - növekedését a generatív mesterséges intelligencia növekvő képességei miatt.[3]. Ezt a valós események is alátámasztják: 2024 elején bűnözők egy mesterséges intelligenciával generált deepfake videóhívás hogy egy cég pénzügyi igazgatójának adja ki magát, és rávesz egy alkalmazottat, hogy átutaljon $25,6 millió a csalóknak[4]. Egy másik esetben pedig észak-koreai hackerek használtak AI-generált hamis személyi igazolványok a biztonsági ellenőrzések megkerülése egy védelmi adathalász kampányban[5]. Ezek a példák rávilágítanak a tétre - a generatív mesterséges intelligencia olyan csalásokat tesz lehetővé, amelyek megkerülik mind az emberi, mind a technikai ellenőrzéseket.

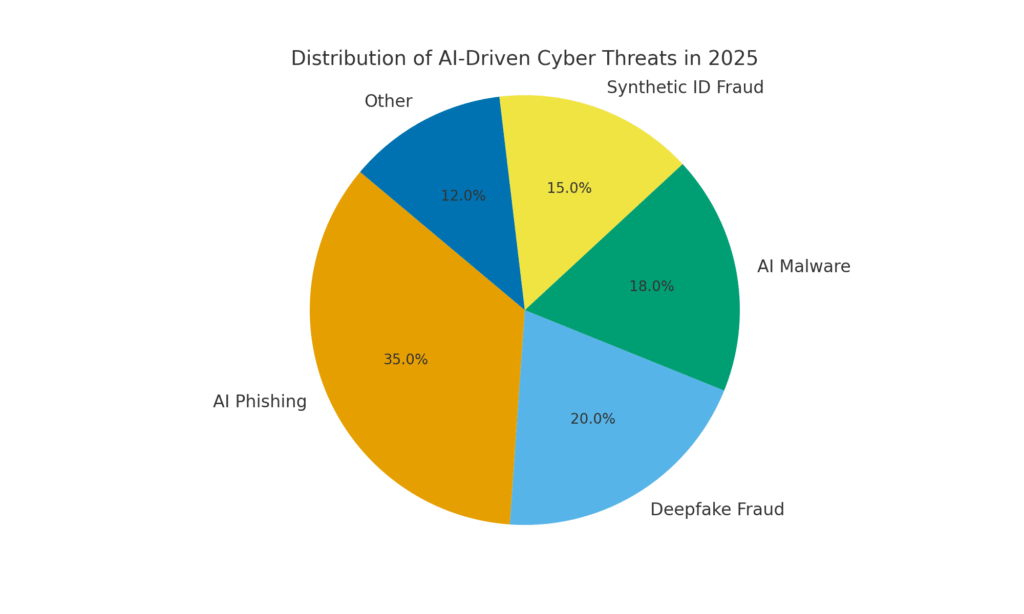

A mesterséges intelligencia azonban szintén a megoldás része. A fejlett észlelőeszközök (mint például a TruthScan eszközei) a mesterséges intelligenciát használják. a ellen. AI - a tartalom elemzése a gépi generáció finom jeleiért. Ebben a fehér könyvben megvizsgáljuk a 2025-ös év legfontosabb AI-vezérelt kiberfenyegetéseit, és azt, hogy a szervezetek hogyan enyhíthetik ezeket. A weboldalról. AI-generált adathalászat a címre. deepfake vezérigazgatói csalás, Mesterséges intelligenciával létrehozott rosszindulatú szoftverek, szintetikus identitások, és még sok más, feltárjuk, hogyan alakítja át a generatív mesterséges intelligencia a támadásokat. Konkrét védelmi intézkedéseket is megvitatunk, többek között a következőket AI tartalomérzékelés, a deepfake forensics és a személyazonosság-ellenőrzési technológiák, amelyek segítségével a biztonsági csapatok visszanyerhetik a fölényt. A cél annak megvilágítása, hogy a vállalkozások, az MSSP-k, a CISO-k és a csalás elleni nyomozók hogyan tudnak integrálják a mesterséges intelligencia észlelő eszközöket a kiberbiztonsági rendszerükbe. a mesterséges intelligencia által vezérelt fenyegetések hulláma ellen.

Soha többé ne aggódjon az AI-csalások miatt. TruthScan Segíthet:

- AI generált érzékelése képek, szöveg, hang és videó.

- Kerülje a jelentős mesterséges intelligencia által vezérelt csalás.

- Védje a leg érzékeny vállalati eszközök.

AI-generált adathalászat és BEC: soha nem látott mértékű csalások

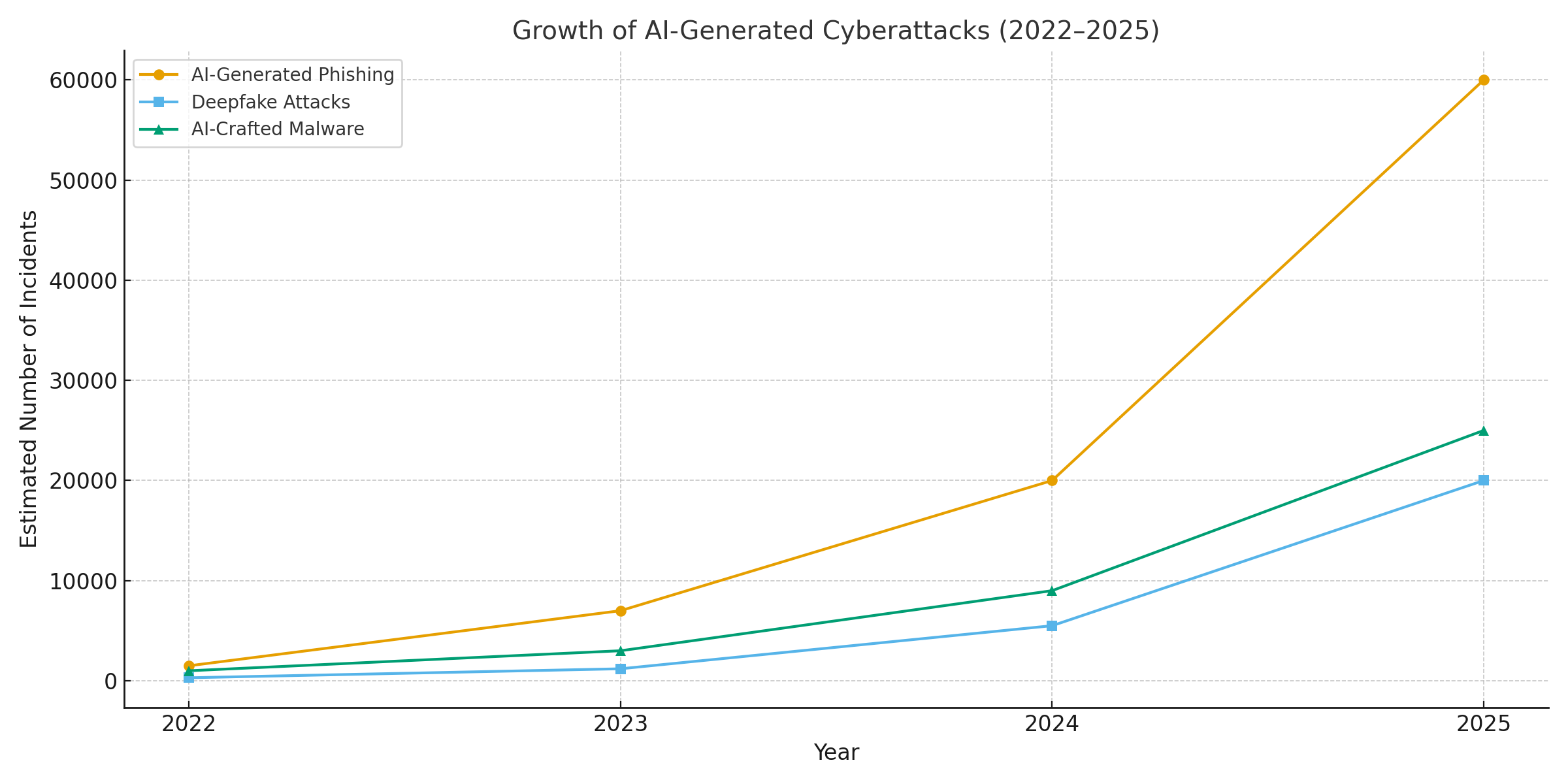

A generatív mesterséges intelligencia egyik legegyértelműbb hatása az adathalászatra és a üzleti e-mail kompromittálás (BEC) rendszerek. A mesterséges intelligencia-nyelvi modellek másodpercek alatt képesek folyékony, a kontextusra szabott e-maileket szerkeszteni - kiküszöbölve az árulkodó nyelvtani hibákat és a kínos megfogalmazásokat, amelyek korábban elárulták az adathalászatot. Az eredmény a rendkívül meggyőző csaló e-mailek és szövegek áradata. 2025 áprilisára, a spam e-mailek több mint felét (51%) mesterséges intelligencia írta., a két évvel ezelőtti gyakorlatilag nulláról[6]. Még riasztóbb, a kutatók megállapították, hogy körülbelül 14% a BEC támadás e-mailek AI-generáltak voltak 2025-ig[7] - ez a szám várhatóan emelkedni fog, ahogy a bűnözők olyan eszközöket alkalmaznak, mint a ChatGPT. Egyes tanulmányok becslései szerint 80% felett az adathalász e-mailek készítésében most már mesterséges intelligencia is segíthet.[8].

Ezeknek az AI által generált csaliknak a mennyisége robbanásszerűen megnőtt. A biztonsági elemzések szerint a generatív mesterséges intelligenciával kapcsolatos adathalász-támadások száma az elmúlt években 1,265% rövid időn belül[9]. Egy időszak alatt az adathalász incidensek száma megugrott 466% egyetlen negyedév alatt, nagyrészt az automatizált adathalász készletek és a személyre szabott csalikat kiszivattyúzó botok miatt.[9][10]. Miért ilyen nagy a tüske? Mert a mesterséges intelligencia lehetővé teszi a támadók skála drámai mértékben megváltoztatják a működésüket. Egyetlen bűnöző is használhat egy AI chatbotot, hogy generáljon ezer különböző alkalmazottakat vagy ügyfeleket célzó, személyre szabott átverő e-mailek, mindezt annyi idő alatt, amennyit egy ilyen e-mail elkészítése igényelt. Ez a tömeges automatizálás arra késztette az FBI-t, hogy figyelmeztessen, hogy a BEC veszteségek (amelyek 2022-ben már $2,7 milliárdot tettek ki) csak felgyorsulnak, mivel az AI "azzal fenyeget, hogy még magasabbra emeli ezeket a veszteségeket".[11][12].

Nemcsak több az adathalász e-mail, hanem az is. hatékonyabb. Az áldozatokat nagyobb arányban csapják be a csiszolt nyelvezet és a szövegkörnyezeti részletek, amelyeket a mesterséges intelligencia képes beépíteni. A laboratóriumi tesztek során az AI által írt adathalász e-mailek a következő eredményeket érték el 54% átkattintási arány - messze a hagyományos adathalász kísérletek ~12% értékét meghaladó érték.[13]. Ezek az üzenetek valódi vezérigazgatói stílusban olvashatók, vagy valódi vállalati eseményekre utalnak, így csökkentve a címzettek óvatosságát. A támadók még mesterséges intelligenciát is használnak a különböző megfogalmazások A/B tesztelésére, és a legsikeresebb fogások kiválasztására.[14]. És az emberekkel ellentétben a mesterséges intelligencia nem hibázik vagy fárad el - végtelen számú változatot képes kiadni, amíg az egyik át nem csúszik a szűrőkön, és át nem ver valakit.

Példa erre: 2025 közepén egy Reuters a vizsgálat feltárta, hogy a délkelet-ázsiai csalók hogyan használták a ChatGPT-t a csalási kommunikáció automatizálására[15]. Meggyőző banki e-maileket és ügyfélszolgálati szövegeket generáltak tömegesen, ezzel jelentősen megnövelve terveik hatókörét. Az európai rendőrség hasonlóképpen arról számolt be, hogy mesterséges intelligencia által vezérelt adathalász készleteket árultak a sötét interneten $20 alatt, lehetővé téve az alacsony képzettségű szereplők számára, hogy kifinomult kampányokat indítsanak.[16][17]. A BEC és az adathalászat belépési korlátja lényegében elpárolgott.

Védekező intézkedések - Az AI Phish megállítása: A támadás miatt a szervezeteknek meg kell erősíteniük e-mail és üzenetküldő csatornáikat. Ez az a terület, ahol AI tartalomérzékelés segíthet. Az olyan eszközök, mint A TruthScan AI szövegdetektora és speciális e-mail szkennerek képes elemezni a bejövő üzeneteket a mesterséges intelligencia által generált szöveg statisztikai jellemzői szempontjából. Például a TruthScan Email átverés detektor természetes nyelvi elemzést használ, hogy megjelölje a valószínűleg mesterséges intelligenciától származó e-maileket, még akkor is, ha azok legitimnek tűnnek.[18]. Ezek az érzékelők olyan dolgokat vizsgálnak, mint a tökéletesen csiszolt nyelvtan, a mondatok összetettsége és az emberi íróknál szokatlan stilisztikai minták. A valós idejű szkennelés, a gyanús e-maileket karanténba lehet helyezni, vagy ellenőrzésre lehet jelölni, mielőtt azok eljutnának a felhasználókhoz. A vállalati biztonsági csapatok kezdik az ilyen mesterséges intelligencia által vezérelt szűrők telepítését az e-mail átjárókon és az üzenetküldő platformokon. A gyakorlatban ez egy új védelmi réteget jelent a hagyományos spamszűrőkön felül, amely kifejezetten az AI által írt tartalmak kiszűrésére van hangolva. 2025-től a vezető vállalatok API-n keresztül integrálják a TruthScanhez hasonló megoldásokat biztonságos e-mail átjáróikba és felhőalapú együttműködési csomagjaikba, létrehozva ezzel egy automatikus ellenőrzési pontot a következők számára AI-generált adathalászat tartalom.

Deepfake hang- és videó-imitáció: A "Látás csal" csalás

A 2025-ös év talán legvizionálisabb AI-vezérelt fenyegetése a deepfake hang- és videotámadások. A bűnözők mesterséges intelligenciamodellek segítségével néhány másodpercnyi hanganyagból klónozhatják egy személy hangját, vagy egy maroknyi fotóból valósághű videót készíthetnek valakinek az arcáról. Ezeket a mély hamisítványokat nagy tétekkel járó csalásokhoz használják fel - a vezérigazgatói csalástól ("hamis vezérigazgatói" hívások) a hamis videokonferenciákig és azon túl. Egy nemrégiben készült iparági jelentés szerint 47% szervezet tapasztalt már deepfake támadást valamilyen[19]. És ez nem csak elméleti kérdés: 2023-2025-ben több rablás is bebizonyította, hogy a deepfakes képes legyőzni a végső hitelesítést - a saját szemünket és fülünket.

Az egyik hírhedt eset egy nemzetközi banki átutalást érintett. $25 millió miután egy alkalmazottat megtévesztettek egy deepfake videokonferenciával. A támadók mesterséges intelligenciával szintetizálták a vállalat pénzügyi igazgatójának képmását egy Zoom hívás során, a hangjával és a viselkedésével együtt, és utasították az alkalmazottat, hogy utaljon át pénzeszközöket...[4][20]. Egy másik ausztráliai incidens során egy helyi önkormányzat elveszett $2,3 millió amikor a csalók a városi tisztviselők hangját és videóját is meghamisították, hogy jóváhagyják a csalárd kifizetéseket.[21]. És ami nyugtalanító, hogy a bűnözők mesterséges intelligenciával klónozott hangokat használnak "nagyszülői csalásokhoz" - időseket hívnak fel, és a bajba jutott rokonaiknak adják ki magukat. A FBI és FinCEN 2024 végén riasztást adott ki a csalások megnövekedett számáról, amelyek során Mesterséges intelligencia által generált "deepfake" média, beleértve a hamis ügyfélszolgálati ügynököket és szintetikus személyazonosságokat a KYC-ellenőrzések megkerülése érdekében.[22].

A deepfake-alapú bűncselekmények gyakorisága gyorsan emelkedik. Az egyik elemzés szerint 2024 végére ötpercenként egy új deepfake átverés történt. átlagosan[23]. Csak 2025 első negyedévében a jelentett deepfake incidensek száma 19%-re ugrott, szemben a minden 2024[24][25]. A mély hamisítványok mostanra a becslések szerint Az összes csalási támadás 6,5%-je, a 2,137% növekedés 2022 óta[26][27]. A szükséges technológia könnyen hozzáférhetővé vált - gyakran mindössze annyit kell hozzá, hogy 30 másodpercnyi hang egy hang klónozásához, vagy egy órányi mintafelvétel alatt egy személy arcának meggyőző modellezéséhez.[20]. Röviden, soha nem volt még ilyen egyszerű a egy megbízható személy személyazonosságának "meghamisítása". és az áldozatokat pénz vagy információk átadására csábítják.

Védekező intézkedések - A valóság hitelesítése: A deepfake fenyegetések elhárítása érdekében a szervezetek a fejlett szintetikus média észlelése eszközök. Például, A TruthScan AI hangdetektora és TruthScan Deepfake Detector a mesterséges intelligencia segítségével elemzi a hang- és videófelvételeket manipulációra utaló jelek után kutatva. Ezek a rendszerek képkockánként és hullámforma-elemzést végeznek, hogy kiszúrják az olyan műtermékeket, mint a természetellenes arcmozgások, a szájszinkronizációs problémák vagy a hang spektrumának szabálytalanságai, amelyek elárulják, hogy az AI által generált klipeket. A tesztek során a TruthScan algoritmusai a következőket érték el 99%+ pontosság az AI által generált hangok azonosításában és a manipulált videóképek valós időben történő észlelése[28][29]. Valójában a Genians Security Center kutatói nemrégiben a TruthScan képi törvényszéki elemzését használták egy észak-koreai hackerek által használt hamis személyi igazolvány elemzésére - a TruthScan deepfake image detectora a dokumentumot nem hitelesnek jelölte meg. 98% bizalom, a spear-phishing kísérlet meghiúsítása[5][30].

A gyakorlati védekezés érdekében a vállalatok ezeket az észlelési képességeket a kulcsfontosságú torokpontokon telepítik. Hangellenőrzés a call centerek munkafolyamataihoz - például amikor egy "ügyfél" nagy összegű átutalást kér telefonon, a hangot egy hanghamisítás-érzékelőn lehet lefuttatni, hogy megbizonyosodjunk arról, hogy valóban ő az (és nem egy mesterséges intelligencia utánzója). Hasonlóképpen, videokonferencia platformok integrálni tudja a résztvevők videófolyamainak élő mélyhamisításos szkennelését, hogy elkapja a szintetikus arcokat. A TruthScan mélyhamisítás-felismerő csomagja például a következőket kínálja valós idejű videóhívás-elemzés és architelesítés amely API-n keresztül csatlakoztatható a Zoomhoz vagy a WebExhez[31][29]. Ez azt jelenti, hogy ha valaki megpróbál csatlakozni egy megbeszéléshez az Ön vezérigazgatójáról készült, mesterséges intelligenciával létrehozott videó segítségével, a rendszer megjelölheti a "lehetséges deepfake" jelzőt, mielőtt bármilyen kár keletkezne. Emellett a fontos tranzakciók ma már gyakran tartalmaznak egy (sávon kívüli vagy többfaktoros) ellenőrzési lépést, amely felhasználhatja a tartalomhitelesítést - például egy rövid szóbeli megerősítést igényel, amelyet aztán egy mesterséges intelligencia hangdetektor ellenőriz a hitelesség szempontjából. Ezen eszközök rétegzésével a vállalatok biztonsági hálót hoznak létre: még akkor is, ha az alkalmazottak lásd vagy hallani valami hihető, egy színfalak mögötti AI törvényszéki szakértő megkérdőjelezi annak valóságtartalmát. Az AI által átszőtt fenyegető tájban, "Ne bízz - ellenőrizd" lesz a mantrája minden olyan hang- vagy videokommunikációnak, amely pénzzel vagy érzékeny hozzáféréssel kapcsolatos.

Mesterséges intelligenciával készített rosszindulatú programok és elfedett kód: Fejlődő fenyegetések a kódban

A mesterséges intelligencia hatása nem korlátozódik a social engineeringre - a rosszindulatú programok és a kitérő támadási kódok fejlesztése terén is megváltoztatja a játékot. 2025-ben a Google fenyegetéselemző csoportja felfedte a első malware törzsek az AI segítségével a weboldalon. végrehajtás a viselkedésük megváltoztatására[32][33]. Az egyik példa, a PROMPTFLUX, egy rosszindulatú szkript volt, amely valójában egy AI API-t (a Google Gemini modelljét) hívott, hogy menet közben újraírja saját kódját, új, homályos változatok előállítása a vírusirtók észlelésének megkerülése érdekében[34][35]. Ez a "just-in-time" mesterséges intelligencia-fejlődés ugrás az autonóm, polimorfikus rosszindulatú programok felé. Egy másik példa, PROMPTSTEAL, egy mesterséges intelligencia kódolási asszisztenst használt arra, hogy egysoros Windows-parancsokat generáljon az adatlopáshoz, lényegében valós időben kiszervezve a logika egyes részeit egy mesterséges intelligencia motornak.[36][37]. Ezek az innovációk egy olyan jövő felé mutatnak, ahol a rosszindulatú szoftverek folyamatosan képesek átalakulni - hasonlóan egy emberi pen-tesztelőhöz -, hogy legyőzzék a védelmet.

A támadók a fejlesztés során a mesterséges intelligenciát még a működés közbeni mesterséges intelligencia nélkül is felhasználják, hogy még hatékonyabb rosszindulatú kódot hozzanak létre. A generatív mesterséges intelligencia olyan rosszindulatú szoftvereket hozhat létre, amelyek erősen homályos, amely zavaros logikai rétegeket tartalmaz, amelyek akadályozzák a visszafejtést. A fenyegetésekről szóló jelentések szerint, a 2025-ben történt nagyobb betörések több mint 70%-je valamilyen polimorf rosszindulatú szoftverrel történt amely megváltoztatja az aláírását vagy viselkedését, hogy elkerülje a felderítést[38]. Továbbá, 76% adathalász kampányok most már polimorf taktikákat alkalmaznak, mint például dinamikus URL-ek vagy mesterséges intelligenciával átírt hasznos terhelések.[38]. Olyan eszközök, mint a dark-web ajánlatok WormGPT és FraudGPT (a ChatGPT korlátlan klónjai) lehetővé teszik még a nem szakértők számára is, hogy malware droppereket, keyloggereket vagy ransomware kódot generáljanak, egyszerűen leírva, hogy mit akarnak.[39]. Az eredmény az új kártevőprogram-változatok sokasága. Például 2024-ben egy infólopó, az úgynevezett BlackMamba kiderült, hogy volt teljesen AI-generált, a ChatGPT segítségével szegmensekben írja a kódját - minden egyes végrehajtás egy kissé eltérő bináris fájlt eredményezett, megzavarva a hagyományos aláírás-alapú vírusirtókat.[38]. A biztonsági kutatók olyan mesterséges intelligencia által generált polimorfikus proof-of-concepteket is bemutattak, amelyek számos végponti védelmet megkerülhetnek.[40].

Ráadásul a támadók a mesterséges intelligencia segítségével finomhangolják a szállítás malware. A mesterséges intelligencia képes intelligens módon olyan adathalász e-maileket írni (amint azt már említettük), amelyek rosszindulatú szoftvereket tartalmazó linkeket tartalmaznak. Segíthet az exploitok fejlesztésében is - például a mesterséges intelligencia segítségével új sebezhetőségeket találhat, vagy optimalizálhatja a shellcode-ot. A jelentések szerint a nemzetállami szereplők fejlett mesterséges intelligenciamodelleket használtak a nulladik napi kihasználások felfedezéséhez és a célpontok számára testre szabott rosszindulatú szoftverek kifejlesztéséhez.[41]. Mindezek a trendek azt jelentik, hogy a rosszindulatú szoftverek 2025-ben lopakodóbbak és alkalmazkodóbbak lesznek. Gyakran "közösen alkották" a mesterséges intelligenciával, ami megnehezíti a hagyományos szabályokkal való felderítését.

Védekező intézkedések - AI vs. AI a rosszindulatú szoftverek elleni védelemben: A mesterséges intelligenciával létrehozott rosszindulatú szoftverek elleni védekezéshez a fejlett észlelés és a mesterséges intelligencia alapú elemzés kombinációjára van szükség a védelmi oldalon. Számos szervezet bővíti a végpontvédelem és EDR (Endpoint Detection & Response) AI/ML modellekkel, amelyek az AI által generált kód viselkedési mintáit keresik. Például a hirtelen kódátalakítások vagy a szokatlan API-hívási minták jelezhetik, hogy a PROMPTFLUX például regenerálja önmagát. Hasonlóképpen, a hálózatfigyelés olyan anomáliákat is észlelhet, mint például a rosszindulatú szoftverek, amelyek elérik az AI-szolgáltatásokat (ami nem "normális" a felhasználói alkalmazások esetében). A gyártók ML-alapú detektorokat képeznek ki a családok az eddig azonosított, mesterséges intelligenciával támogatott rosszindulatú szoftvereket, javítva ezen újszerű fenyegetések felismerését.

Az egyik kialakulóban lévő megoldás integrált AI tartalomellenőrzés a fejlesztői és építési pipelinekben. Ez azt jelenti, hogy a mesterséges intelligencia által vezérelt detektorok segítségével szkripteket, szoftverösszeállításokat vagy akár konfigurációs módosításokat elemeznek rosszindulatú vagy mesterséges intelligencia által generált tartalomra. Például, A TruthScan valós idejű érzékelője nem csak a szöveges fájlokat lehet használni - a multimodális elemzés potenciálisan jelezheti a gyanús kódot vagy konfigurációs fájlokat azáltal, hogy felismeri, hogy gépi generálásból származnak-e, obfuszkációs mintákkal.[42][43]. A fejlesztőcsapatok és az MSSP-k elkezdik vizsgálni az infrastruktúra mint kód szkripteket, PowerShell naplókat és más leleteket az AI által írt szegmensek jelei után, amelyek egy támadó kezére utalhatnak. Bár ez a terület még kialakulóban van, ígéretesnek tűnik: egy esetben egy biztonsági csapat egy mesterséges intelligencia detektor segítségével elkapott egy olyan elkendőzött adathalász készletfájlt, amely "úgy tűnt", hogy mesterséges intelligencia által generált, és valóban egy támadás része volt.[44]. A fájl kódja túlságosan összetett és bőbeszédű volt (a mesterséges intelligencia generálásának jellemzői), és a mesterséges intelligencia tartalomvizsgálata megerősítette, hogy nagy valószínűséggel nem emberi kézzel írták.[40].

Végezetül, a mesterséges intelligenciát fenyegető fenyegetésekre összpontosító fenyegetettségi információk megosztása kulcsfontosságú. Amikor a Google GTIG közzéteszi a Prompt-alapú rosszindulatú programok részleteit, vagy amikor a kutatók új AI-kikerülési technikákról számolnak be, a szervezeteknek ezeket be kell táplálniuk az észlelési technikáikba. Viselkedéselemzés - az olyan műveletek keresése, mint például egy folyamat, amely olyan szkriptet indít, amely újraírja ugyanannak a folyamatnak a kódját - elkaphatja a mesterséges intelligenciával támogatott rosszindulatú szoftverek által mutatott anomáliákat. Röviden, a védőknek tűzzel kell harcolniuk a tűz ellen: telepítsenek AI-vezérelt biztonsági eszközök amely olyan gyorsan tud alkalmazkodni, mint a mesterséges intelligencia által vezérelt kártevők. Ez a mesterséges intelligenciával feljavított vírusirtóktól kezdve a felhasználói viselkedéselemzésig mindent magában foglal, amely képes azonosítani, ha egy fiók vagy rendszer "nem egészen emberi módon" kezd el viselkedni. Azáltal, hogy az AI-t a védelemben alkalmazzák, a biztonsági csapatok ellensúlyozhatják a támadóknak az AI által biztosított gyorsasági és méretbeli előnyöket.

Szintetikus személyazonosságok és mesterséges intelligencia által vezérelt csalási rendszerek

A rosszindulatú programoktól a csalások világába való átmenet: szintetikus személyazonossággal kapcsolatos csalás a generatív mesterséges intelligencia segítségével robbanásszerűen megnőtt. A szintetikus személyazonossággal kapcsolatos csalás során fiktív személyazonosságokat hoznak létre valós és hamis adatok kombinálásával (pl. valós SSN + hamis név és dokumentumok). Ezeket a "Frankenstein" személyazonosságokat aztán bankszámlanyitáshoz, hitelkérelemhez vagy KYC-ellenőrzéshez használják - ami végül kifizetetlen hitelekhez vagy pénzmosáshoz vezet. Ez már eddig is az egyik leggyorsabban növekvő csalástípus volt, és a mesterséges intelligencia most olaj a tűzre. A szintetikus személyazonossági csalásból származó veszteségek átlépte az $35 milliárdot 2023-ban[45], és 2025 elejére egyes becslések szerint az összes banki csalási veszteség közel 25%-je szintetikus azonosságoknak voltak köszönhetőek[46]. Az Experian elemzői megállapították, hogy több mint 80% új számlacsalás bizonyos piacokon már szintetikus azonosítókhoz kötődik[19] - egy megdöbbentő statisztika, amely aláhúzza, hogy ez az átverés mennyire elterjedt.

A generatív mesterséges intelligencia többféleképpen is felerősíti a szintetikus csalást. Először is, a mesterséges intelligencia triviálissá teszi a "tenyésztői dokumentumok" és a hamis személyazonosság eladásához szükséges digitális lábnyomok. A múltban a csalók photoshoppal készítettek egy személyazonossági igazolványt, vagy kézzel készítettek hamis közüzemi számlákat. Ma már léteznek olyan eszközök, amelyekkel hitelesnek tűnő profilképek, személyi igazolványok, útlevelek, bankszámlakivonatok, sőt még a közösségi média profilok is. mesterséges intelligencia képgenerátorok és nyelvi modellek használatával[47][48]. Például egy mesterséges intelligencia segítségével létrehozhatunk egy nem létező személy valósághű fejképét (megakadályozva a könnyű fordított képkeresést), és létrehozhatunk egy megfelelő hamis jogosítványt ezzel a fotóval. A mesterséges intelligencia képes szimulálni a személyazonosság "életjeleit" is - pl. létrehozhat szintetikus szülőkről, címekről vagy a közösségi médiában közzétett bejegyzésekről szóló feljegyzések a háttértörténet kibontásához[49]. A bostoni Fed megjegyezte, hogy a Gen AI akár még a deepfake audio és videó egy hamis személyről - például egy szintetikus felhasználó "megjelenhet" egy szelfi ellenőrző videóban, egyedi arccal és hanggal, mindezt mesterséges intelligencia által generálva.[50].

Másodszor, a mesterséges intelligencia segít a csalóknak növelni a létszámot a műveleteik. Ahelyett, hogy egyszerre egy vagy két személyazonosságot hamisítanának, programozottan több száz vagy ezer teljes személyazonossági csomagot generálhatnak, és tömegesen tölthetnek ki automatikusan új számlaigényléseket.[51][52]. Egyes sötét webes szolgáltatások hatékonyan kínálnak "Szintetikus identitások mint szolgáltatás", automatizálással ellenőrzött számlákat gyártanak eladásra. A COVID-19 világjárvány segélyprogramok során például a bűnözők mesterséges intelligencia által generált személyazonossággal rendelkező botokat használtak, hogy tömegesen nyújtsanak be kölcsönökre és juttatásokra vonatkozó kérelmeket, és hamis kérelmezőkkel árasztották el a rendszert. A Juniper Research előrejelzései szerint a digitális személyazonossággal kapcsolatos (ilyen taktikák által táplált) csalások globális költségei a következők lesznek emelkedés 153% 2030-ig 2025-höz képest[53].

Védőintézkedések - A személyazonosság ellenőrzése a mesterséges intelligencia világában: A hagyományos személyazonosságot igazoló módszerek küzdenek az AI által létrehozott hamisítványokkal szemben. Az alkalmazkodás érdekében a szervezetek a következő módszereket alkalmazzák többrétegű személyazonosság- és viselkedésellenőrzés a mesterséges intelligencia által támogatva. Egy kulcsfontosságú réteg a fejlett dokumentum- és képszakértés. Például, A TruthScan AI képdetektora és Hamis dokumentum detektor lehetővé teszi a feltöltött személyazonosító igazolványok, szelfik vagy dokumentumok elemzését a szintetizálás vagy hamisítás jelei miatt. Ezek az eszközök megvizsgálják a pixelszintű leleteket, a világítási ellentmondásokat és a metaadatokat annak megállapítására, hogy egy kép mesterséges intelligencia által generált vagy manipulált-e. Olyan finom jeleket is észrevesznek, mint például a GAN által generált fényképek azonos háttérmintái, vagy a személyi igazolványon lévő betűtípusok és betűtávolságok, amelyek nem egyeznek egyetlen ismert kormányzati sablonnal sem. Az ilyen detektorok bevetésével a felvételkor a bankok automatikusan megjelölhetik a kérelmező jogosítványát vagy szelfijét, ha az valószínűleg mesterséges intelligencia által generált (például a TruthScan rendszere megjelölte volna a Kimsuky APT adathalász-ügyben használt hamis katonai igazolványt).[5]). A TruthScan sajtóközleménye szerint platformjukat pénzügyi intézmények használják a dokumentumok hitelességének széleskörű érvényesítésére, rendkívül nagy pontossággal azonosítva a mély hamisítványokat.[54].

Egy másik réteg viselkedéselemzés és kereszthivatkozások ellenőrzése. A valódi személyazonosságoknak mélységük van - több éves előzmények, nyilvános feljegyzések, közösségi média aktivitás stb. A mesterséges intelligencia által generált személyazonosságoknak, legyenek bármilyen kifinomultak is, gyakran hiányoznak ezek a mély gyökerek. A bankok és a hitelezők ma már mesterséges intelligenciát használnak a kérelmezési adatok nyilvános és saját adatokkal való keresztkorrelációjára: A személy telefonszáma és e-mail címe mutat-e használati előzményeket? Van-e értelme az eszköz vagy az IP földrajzi elhelyezkedésének? Emberi módon gépeli be az adatokat az űrlapokba, vagy copy-paste (ahogy a botok teszik)? A mesterséges intelligenciamodelleket be lehet tanítani arra, hogy megkülönböztessék a valódi vásárlói viselkedést a szintetikus mintáktól. A Federal Reserve megjegyezte, hogy "A szintetikus identitások sekélyesek, és az AI ezt látja" - A mesterséges intelligencia-alapú ellenőrzés gyorsan megkeresi a személyazonosság digitális lábnyomát, és riasztást ad, ha nem vagy alig talál valamit.[55]. A gyakorlatban a személyazonosság-ellenőrző szolgáltatások ma már olyan mesterséges intelligenciát alkalmaznak, amely ellenőrzi, hogy a felhasználó szelfije egyezik-e a korábbi fotókkal (az arccserék felismerése érdekében), és még véletlenszerű műveletekkel (például bizonyos pózokkal vagy mondatokkal) is megkérdezi a felhasználókat az élethűség ellenőrzése során, ami megnehezíti a mély hamisítványok számára a helyes választ.[56][57].

Végre, folyamatos ellenőrzés a fiókok viselkedése a beszállás után segít elkapni az átcsúszott szintetikus fiókokat. Mivel ezek a számlák nem kötődnek valódi személyhez, a felhasználási szokásaik végül gyakran feltűnőek (pl. tökéletesen időzített tranzakciók a hitel felépítése érdekében, majd a hitelkeret maximalizálása). A mesterséges intelligencia által vezérelt csalásfigyelés (mint például a Sift vagy a Feedzai platformjai) képes azonosítani a számlák használatának anomáliáit, és így jelzi a potenciális szintetikus számlákat felülvizsgálatra. Összefoglalva, a mesterséges intelligencia alapú személyazonossági csalás elleni küzdelemhez a következőkre van szükség Mesterséges intelligencia alapú személyazonosság-ellenőrzés - az iratelemzés, a biometrikus ellenőrzések, az adatkorreláció és a viselkedéselemzés kombinálása. A jó hír az, hogy ugyanazokat a mesterséges intelligenciafejlesztéseket, amelyek lehetővé teszik a csalást, a csalás felderítésére is használják. A TruthScan például egy olyan személyazonosság-ellenőrzési csomag amely szöveg-, kép- és hangelemzést integrál az új felhasználók ellenőrzéséhez. Ezen eszközök kihasználásával az egyik nagy bank jelentős csökkenést tapasztalt a sikeres szintetikus számlanyitások számában, még akkor is, amikor az iparági átlagok emelkedtek. A fegyverkezési verseny folytatódik, de a védők megtanulják kiszúrni a szintetikus fiókok gyenge "digitális árulkodó jeleit", függetlenül attól, hogy az AI mennyire igyekszik eltüntetni a nyomokat.

A mesterséges intelligencia észlelés integrálása a biztonsági rendszerbe

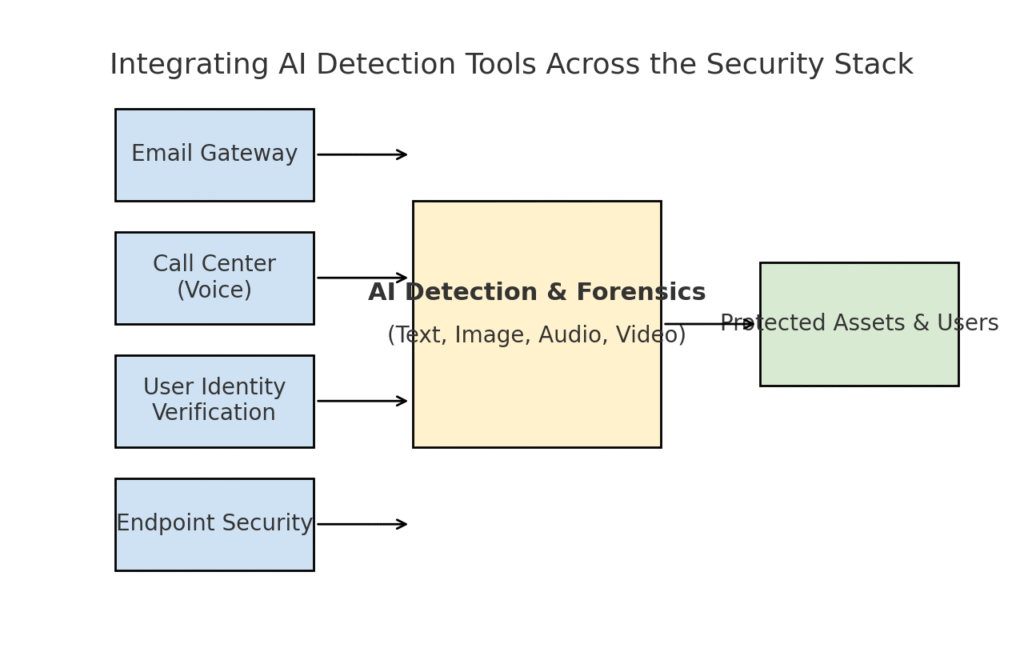

Számos különböző fenyegetési területet vizsgáltunk - adathalászat, mély hamisítványok, rosszindulatú szoftverek, szintetikus csalás -, amelyek mindegyike mesterséges intelligencia által felturbózott. Egyértelmű, hogy nincs egyetlen eszköz vagy egyszeri megoldás megoldja a kihívást. Ehelyett a vállalkozásoknak átfogó stratégiára van szükségük, hogy mesterséges intelligencia alapú észlelés és ellenőrzés beágyazása minden rétegben a kiberbiztonsági csomagjukat. A megközelítésnek tükröznie kell a támadási felületet, lefedve az e-mailt, a webet, a hangot, a dokumentumokat, a személyazonosságot és azon túl. Az alábbi ábra azt szemlélteti, hogy a szervezetek hogyan integrálhatják a TruthScan AI-érzékelő eszközeit (és hasonló megoldásokat) a közös vállalati biztonsági rétegekbe:

A mesterséges intelligencia-érzékelő eszközök integrálása a biztonsági stack több rétegébe - az e-mail átjáróktól és a hívásközpontoktól a felhasználói ellenőrzésig és a végpontok védelméig. Az AI tartalomérzékelés (központ) valós időben elemzi a szöveget, a képeket, a hangot és a videót, és olyan végrehajtási pontokba táplálja, amelyek védik az eszközöket és a felhasználókat.

Ebben a modellben, a multimodális AI detektorok központi agyként működnek amely különböző biztonsági ellenőrzésekhez kapcsolódik:

- Email kapuk: A bejövő e-mailek egy mesterséges intelligencia szöveg/csalás detektoron mennek keresztül, mielőtt eljutnak a postaládába. Ez kapcsolódik az adathalászat elleni védekezéshez, amelyről már beszéltünk - pl. a A TruthScan e-mail átverés detektora API-n keresztül az Ön e-mail szolgáltatójánál, hogy automatikusan karanténba helyezze a gyanús, mesterséges intelligencia által generált e-maileket.[18]. Alkalmazható üzenetküldő platformokra (csevegőalkalmazások, SMS-kapuk) is, hogy a tartalmat adathalász vagy átverési mintákra vizsgálja.

- Call Centerek és hangrendszerek: A telefon- és VOIP-csatornák biztonsága a hanghamisítás-érzékelés integrálásával biztosított. Például egy bank ügyfélszolgálati vonala használhatna A TruthScan AI hangdetektora a bejövő hívó hangjának valós idejű elemzése és riasztás, ha a hívó hangmintája szintetikus vagy nem felel meg az ismert profiljának.[58][59]. Ez segít megelőzni a vishing és a hangutánzó támadások (például a hamis vezérigazgatói hívások) sikerét.

- Felhasználói személyazonosság-ellenőrzési folyamatok: A számlanyitás vagy a kockázatos felhasználói műveletek (jelszó-visszaállítás, átutalás) során a mesterséges intelligencia által vezérelt személyazonosság-ellenőrzés lép működésbe. A feltöltött fényképes azonosítót egy képi törvényszéki eszköz vizsgálja (pl. ellenőrzi, hogy az AI által generált vagy egy fénykép fotója), a szelfit vagy videohívást pedig egy deepfake detektor vizsgálja. A TruthScan Deepfake detektor itt lehet használni az arc hitelesítésére - biztosítva, hogy a kamerán látható személy valódi legyen, és megfeleljen az azonosítónak.[60][61]. A viselkedési jelek (gépelési gyakoriság, eszközkonzisztencia) szintén betáplálhatók az AI-modellekbe, hogy felismerjék a botokat vagy a szintetikus személyazonosságokat.

- Végpontok és hálózat: A végponti biztonsági ügynökök és proxykiszolgálók képesek a fájlok és parancsfájlok mesterséges intelligencia alapú tartalomelemzésére. Ha például egy végponti EDR egy új szkript vagy EXE végrehajtását észleli, elküldheti a fájl szöveges tartalmát egy mesterséges intelligencia detektornak, hogy ellenőrizze, hasonlít-e az ismert mesterséges intelligencia által generált rosszindulatú szoftverre, vagy mutat-e a mesterséges intelligencia kódjának jellemzőit. Hasonlóképpen, a DLP (adatvesztés-megelőző) rendszerek is használhatják az AI szövegérzékelést, hogy jelezzék az AI által generált érzékeny szöveget (ami arra utalhat, hogy egy bennfentes AI-t használ az adatszivárgási üzenetek megfogalmazására vagy a jelentések meghamisítására). A TruthScan Valós idejű érzékelő az ilyen munkafolyamatokba való illesztésre tervezték, és a tartalom élő elemzését kínálja a különböző platformokon, automatizált válaszlehetőségekkel.[42][62] (például egy fájl vagy üzenet automatikus blokkolása, ha azt mesterséges intelligencia által generált rosszindulatú szoftverként vagy dezinformációként azonosították).

A kulcsfontosságú előny ennek az integrált megközelítésnek a lényege sebesség és következetesség. A mesterséges intelligencia támadások gyorsan mozognak - az adathalász e-mailek, a hamis hangok és a szintetikus adatok egyszerre több csatornát is elérhetnek. Azáltal, hogy mindezen csatornákat mesterséges intelligencia-érzékeléssel látja el, a szervezet valós idejű átláthatóságot és mélységében védekező képességet nyer. Az egyik csapat ezt úgy írta le, mintha egy "AI immunrendszert" hoznának létre a vállalatuk számára: amikor valamit kommunikálnak (legyen az e-mail, dokumentumfeltöltés, hanghívás stb.), az AI immunrendszer "kiszimatolja" azt idegen (AI által generált) aláírások után, és semlegesíti azt, ha rosszindulatúnak találják.

A TruthScan vállalati csomagja jól példázza ezt, mivel egy olyan egységes platform szöveg, kép, hang és videó mesterséges intelligencia-érzékelés, amely modulárisan vagy egészben is telepíthető[63][64]. Sok vállalat egy vagy két képesség bevezetésével kezdi (mondjuk, szövegfelismerés az e-mailekben és képfelismerés a belépési folyamat során), majd ha látják az értéket, kiterjesztik a többi képességre is. Fontos, hogy az integráció fejlesztőbarát - A TruthScan és a hasonló szolgáltatások API-kat és SDK-kat biztosítanak, hogy a biztonsági csapatok a meglévő rendszerekhez masszív áttervezés nélkül csatlakoztathassák az észlelést. Legyen szó SIEM-ről, e-mail átjáróról, egyéni banki alkalmazásról vagy CRM-rendszerről, az észlelés a színfalak mögött futhat, és riasztásokat vagy automatizált műveleteket táplálhat. Egy nagy közösségi médiaplatform például integrált tartalommoderációs API-kat, hogy a feltöltést követő perceken belül automatikusan eltávolítsa a deepfake videókat.[65][66], megakadályozva a mesterséges intelligencia által generált félretájékoztatás terjedését.

Következtetés: A görbe előtt maradva

A mesterséges intelligencia által vezérelt fenyegetések gyors terjedése 2025-ben új kihívások elé állította a szervezeteket. A támadók megtalálták az emberi bizalom méretarányos kihasználásának eszközeit - hangok és személyazonosságok megszemélyesítésével, a social engineering automatizálásával, a védelem megkerülésével adaptív kóddal és teljes hamis valóságok gyártásával. Ez ijesztő, de nem reménytelen kilátás a védők számára. Ahogyan a bűnözők kihasználják a mesterséges intelligenciát, úgy mi is a biztonság oldalára állíthatjuk a mesterséges intelligenciát. Az újonnan megjelenő Mesterséges intelligencia tartalomérzékelés, mély hamisítással kapcsolatos törvényszéki vizsgálatok és szintetikus személyazonosság-ellenőrzők erőteljes ellenszert ad nekünk ezekkel az új fenyegetésekkel szemben. Ezeknek az eszközöknek a bevetésével és integrálásuk az összes rétegben védekezéssel a vállalatok drámaian csökkenthetik a mesterséges intelligencia alapú támadások átcsúszásának kockázatát. A korai alkalmazók már több millió dolláros csalási kísérleteket hiúsítottak meg azzal, hogy tetten érték a hamisítványokat.[26], vagy megakadályozta az adathalász-katasztrófákat az AI által készített e-mailek kiszűrésével.

A technológián túl a szervezeteknek a "bízz, de ellenőrizd" kultúráját kell kialakítaniuk. Az alkalmazottaknak tisztában kell lenniük azzal, hogy a mesterséges intelligencia korában a látás (vagy hallás) nem mindig jelent hitet - az egészséges szkepticizmus, párosulva az ellenőrzési munkafolyamatokkal, számos social engineering trükköt megállíthat. A képzés és a tudatosság, kombinálva a automatizált ellenőrző eszközök, mint a TruthScan, félelmetes védelmet alkotnak. Bizonyos értelemben meg kell emelnünk az információk hitelesítésének és érvényesítésének mércéjét. A digitális közléseket és dokumentumokat többé nem lehet névértéken elfogadni; eredetüket ellenőrizni kell, akár géppel, akár eljárással.

Ahogy haladunk előre, számíthatunk arra, hogy a támadók tovább finomítják mesterséges intelligencia taktikáikat, de a védekező mesterséges intelligencia terén is folyamatos innovációra számíthatunk. A macska-egér dinamika továbbra is fennmarad. A védők sikere a következőkön múlik majd agilitás és hírszerzési információk megosztása. Azok, akik gyorsan beépítik az új fenyegetésekkel kapcsolatos információkat (pl. új, mélyreható hamisítás-felismerési technikák vagy frissített mesterséges intelligenciamodell-aláírások), a legújabb mesterséges intelligencia-eszközöket használó támadók előtt maradnak. Az ipar, a tudományos élet és a kormányzat közötti együttműködés szintén létfontosságú lesz ebben a küzdelemben, amint azt az olyan ügynökségek által kiadott figyelmeztetések és keretrendszerek, mint a NIST AI Risk Management Framework, valamint a bankközi együttműködések a csalás mesterséges intelligencia felderítésében mutatják.

Végezetül, a kiberbiztonsági iparág az AI által vezérelt paradigmaváltás kellős közepén van. A fenyegetések nem hasonlítanak az egy évtizeddel ezelőttihez, de ugyanilyen példa nélküli védekezéssel válaszolunk rájuk. A fejlett észlelési technológia és a robusztus biztonsági stratégia kombinációjával lehet enyhíteni a generatív mesterséges intelligencia kockázatait, sőt, akár előnyünkre is fordíthatjuk. Az olyan eszközök, mint a TruthScan AI-felismerő csomagja lehetővé teszi számunkra, hogy a bizalom helyreállítása egy bizalmatlan világban - hogy megbizonyosodjunk arról, hogy a vonal másik végén lévő személy valódi, hogy a postaládánkban lévő dokumentum hiteles, és hogy a hálózatunkon futó kódot nem egy rosszindulatú mesterséges intelligencia manipulálta. Ha már most befektetnek ezekbe a képességekbe, a szervezetek nemcsak a mai, mesterséges intelligenciával támogatott támadások ellen védekezhetnek, hanem a jövő fejlődő fenyegetéseivel szemben is ellenálló képességet építhetnek ki. A tanulság egyértelmű: A mesterséges intelligencia felerősítheti a kibertámadásokat, de a megfelelő megközelítéssel a védelmünket is felerősítheti.

Források: A vonatkozó adatok és példák 2025 fenyegetés-felderítési jelentésből és szakértői jelentésből származnak, beleértve a Mayer Brown Cyber Incident Trends című kiadványát is.[1][67], A Fortinet 2025-ös fenyegetés-összefoglalója[2][19], Barracuda kutatás az AI e-mail támadásokról[6][7], Google GTIG AI fenyegetettségi jelentése[34], A bostoni szövetségi tartalékbank betekintést nyer a szintetikus csalásokba[45][50], valamint a TruthScan által közzétett esettanulmányok és sajtóközlemények[30][26]többek között. Ezek jól szemléltetik a mesterséges intelligencia által vezérelt fenyegetések körét és a mesterséges intelligenciára összpontosító ellenintézkedések hatékonyságát valós forgatókönyvekben. Az ilyen intelligenciából való tanulás és a legmodernebb eszközök alkalmazása révén magabiztosan navigálhatunk az AI által felerősített kiberkockázatok korában.

[1] [67] 2025 Cyber Incident Trends - Mit kell tudnia a vállalkozásának | Insights | Mayer Brown

[2] [3] [19] A kiberbiztonsági statisztikák csúcsa: Tények, statisztikák és betörések 2025-ig

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Mesterséges intelligencia által vezérelt csalás a pénzügyi szolgáltatásokban: TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] A TruthScan észlelte az észak-koreai Deepfake támadást a védelmi tisztviselők ellen - Bryan County Magazine

[6] [7] [14] A beérkező spamek fele mesterséges intelligencia által generált - a fejlett támadásokban való felhasználása még korai stádiumban van | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] 2025 második negyedév Digitális bizalmi index: AI Fraud Data and Insights | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] AI Cybersecurity Threats 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Legfrissebb fenyegetettségi információk | TruthScan

[18] [63] [64] TruthScan - Vállalati AI felderítés és tartalombiztonság

[23] [46] [56] [57] Deepfakes és betétek: Hogyan küzdjünk a generatív mesterséges intelligencia csalás ellen?

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake támadások és AI-generált adathalászat: 2025 statisztikák

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI hangdetektor a mély hamisítások és hangklónozás ellen | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Hamis és AI videók azonosítása - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Az AI-eszközök fenyegetőszereplők általi felhasználásának fejlődése | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackerek elfedtek malware-t a szószátyár AI kóddal

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Valós idejű AI-érzékelés - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI operátorok AI-generált kódot és hamis alkalmazásokat használnak a messzi ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] A mesterséges intelligencia generációja növeli a szintetikus személyazonossággal kapcsolatos csalás veszélyét - Federal Reserve Bank of Boston

[53] Szintetikus személyazonossággal kapcsolatos csalás 2025: Megelőzési stratégiák