Introduction : Une nouvelle ère d'attaques basées sur l'IA

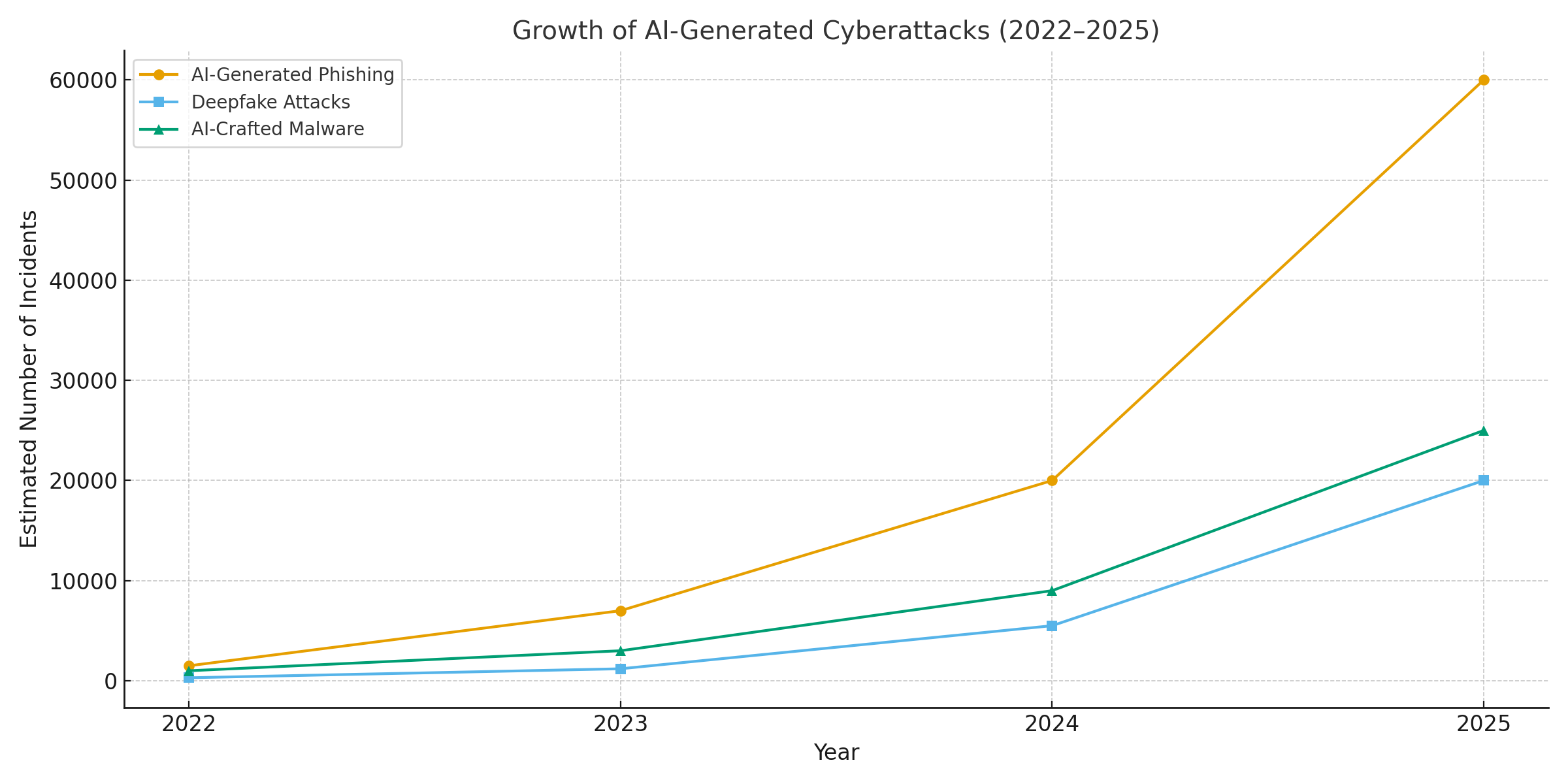

L'année 2025 a marqué un tournant dans la cybersécurité. L'IA générative a donné un coup de fouet aux cyberattaques, permettant aux acteurs de la menace de lancer davantage d'attaques. fréquents, réalistes et évolutifs que jamais auparavant. En fait, au cours de l'année écoulée, on estime que 16% des cyberincidents signalés impliquaient des attaquants exploitant des outils d'IA. (par exemple, modèles de génération d'images et de langage) pour améliorer l'ingénierie sociale[1]. Qu'il s'agisse de courriels d'hameçonnage ultra convaincants ou de fausses escroqueries audio/vidéo, les acteurs malveillants utilisent l'IA dans tous les secteurs. La majorité des professionnels de la sécurité attribuent désormais à l L'augmentation des cyberattaques est due à l'IA générativequi offre aux acteurs malveillants des moyens plus rapides et plus intelligents d'exploiter les victimes.[2]. L'IA générative abaisse effectivement le niveau de compétence de la cybercriminalité tout en augmentant sa puissance.

Pourquoi est-ce si préoccupant ? L'IA peut produire instantanément un contenu soigné et adapté au contexte qui trompe même les utilisateurs expérimentés. Elle peut se faire passer pour une voix ou un visage avec une précision effrayante, et même générer un code malveillant qui se transforme pour échapper à la détection. En conséquence, les cyberattaques sont devenues plus difficiles à détecter et plus faciles à exécuter. Les Forum économique mondial avertit que 72% des organisations ont constaté une augmentation des cyber-risques - en particulier l'ingénierie sociale et la fraude - en raison des capacités croissantes de l'IA générative.[3]. Des incidents réels le confirment : Au début de l'année 2024, des criminels ont utilisé une faux appel vidéo pour se faire passer pour le directeur financier d'une entreprise et inciter un employé à transférer des fonds. $25,6 millions aux fraudeurs[4]. Dans un autre cas, des pirates informatiques nord-coréens ont utilisé des Faux documents d'identité générés par l'IA pour contourner les contrôles de sécurité dans le cadre d'une campagne d'hameçonnage de défense[5]. Ces exemples mettent en évidence les enjeux - l'IA générative permet des escroqueries qui contournent les contrôles humains et techniques.

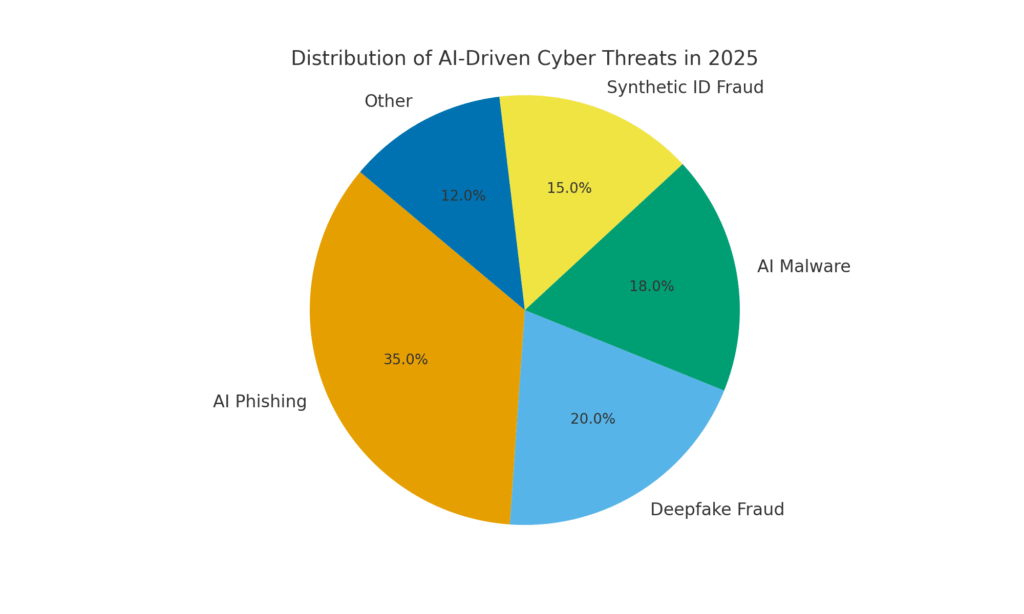

Cependant, l'IA fait également partie de la solution. Les outils de détection avancés (comme ceux de TruthScan) utilisent l'IA contre IA - analyse du contenu pour détecter les signatures subtiles de la génération de machines. Dans ce livre blanc, nous examinons les principales cybermenaces liées à l'IA en 2025 et la manière dont les entreprises peuvent les atténuer. A partir de Hameçonnage généré par l'IA à fraude deepfake CEO, Logiciels malveillants conçus par l'IA, identités synthétiquesNous examinerons comment l'IA générative redéfinit les attaques. Nous discuterons également de mesures défensives concrètes, notamment Détection de contenu par l'IAL'objectif est d'éclairer la façon dont les entreprises, les MSSP, les RSSI et les enquêteurs sur les fraudes peuvent utiliser les technologies d'authentification et de vérification de l'identité pour reprendre le dessus. L'objectif est de montrer comment les entreprises, les MSSP, les RSSI et les enquêteurs de fraude peuvent intégrer des outils de détection de l'IA dans leur pile de cybersécurité. pour contrer cette vague de menaces alimentées par l'IA.

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

Phishing et BEC générés par l'IA : des escroqueries d'une ampleur sans précédent

L'un des impacts les plus évidents de l'IA générative a été sur le phishing et le compromission du courrier électronique professionnel (BEC) Les modèles linguistiques de l'IA peuvent rédiger des courriels fluides et adaptés au contexte en quelques secondes. Les modèles linguistiques de l'IA peuvent rédiger en quelques secondes des courriels fluides et adaptés au contexte, en éliminant les fautes de grammaire révélatrices et les formulations maladroites qui trahissaient autrefois l'hameçonnage. Il en résulte un flot de courriels et de textes frauduleux très convaincants. D'ici à avril 2025, plus de la moitié des courriers électroniques non sollicités (51%) étaient rédigés par l'IA, alors qu'elle était pratiquement nulle deux ans auparavant[6]. Plus alarmant encore, les chercheurs ont constaté qu'environ 14% des courriels d'attaques BEC ont été générés par l'IA d'ici à 2025[7] - un chiffre qui devrait augmenter à mesure que les criminels adoptent des outils tels que ChatGPT. Certaines études estiment que plus de 80% des courriels de phishing peuvent désormais bénéficier de l'aide de l'IA pour les concevoir[8].

Le volume de ces leurres générés par l'IA a explosé. Les analyses de sécurité montrent que les attaques de phishing liées à l'IA générative ont fait un bond de 1,265% en peu de temps[9]. Au cours d'une période, les rapports d'incidents d'hameçonnage ont fait un bond. 466% en un seul trimestreLa plupart du temps, il s'agit de kits de phishing automatisés et de robots qui envoient des appâts personnalisés.[9][10]. Pourquoi un tel pic ? Parce que l'IA permet aux attaquants échelle leurs opérations de manière spectaculaire. Un seul criminel peut utiliser un chatbot d'IA pour générer milliers de courriels frauduleux personnalisés ciblant différents employés ou clients, tout cela dans le temps qu'il fallait pour en créer un. Cette automatisation massive a conduit le FBI à avertir que les pertes liées aux BEC (qui s'élevaient déjà à $2,7 milliards en 2022) ne feront que s'accélérer, car l'IA "menace de faire grimper ces pertes encore plus haut"[11][12].

Non seulement les courriels de phishing sont plus nombreux, mais ils sont également plus fréquents. plus efficace. Les victimes sont trompées plus rapidement grâce au langage soigné et aux détails contextuels que l'IA peut intégrer. Lors de tests en laboratoire, les courriels d'hameçonnage rédigés par l'IA ont obtenu un taux de réussite de 54% taux de clics - bien plus que les ~12% des tentatives d'hameçonnage traditionnelles[13]. Ces messages ressemblent à s'y méprendre au style d'un véritable PDG ou font référence à des événements réels de l'entreprise, ce qui fait baisser la garde des destinataires. Les attaquants utilisent même l'IA pour tester différentes formulations et itérer sur les accroches les plus réussies[14]. Et contrairement aux humains, l'IA ne fait pas de fautes de frappe et ne se fatigue pas - elle peut émettre un nombre infini de variantes jusqu'à ce que l'une d'entre elles passe les filtres et trompe quelqu'un.

Un exemple concret : À la mi-2025, un Reuters L'enquête a révélé comment des escrocs d'Asie du Sud-Est ont utilisé ChatGPT pour automatiser les communications frauduleuses.[15]. Ils ont généré en masse des courriels bancaires et des textes du service clientèle convaincants, augmentant ainsi considérablement la portée de leurs stratagèmes. La police européenne a également signalé que des kits d'hameçonnage pilotés par l'IA étaient vendus sur le dark web pour moins de $20, ce qui permettait à des acteurs peu qualifiés de lancer des campagnes sophistiquées[16][17]. La barrière à l'entrée pour le BEC et le phishing s'est pratiquement évaporée.

Mesures défensives - Stopping AI Phish : Face à cet assaut, les entreprises doivent renforcer leurs canaux de courrier électronique et de messagerie. C'est là que les Détection de contenu par l'IA peut vous aider. Des outils tels que Détecteur de texte AI de TruthScan et spécialisés scanners de courrier électronique peut analyser les messages entrants pour y déceler les marqueurs statistiques d'un texte généré par l'IA. Par exemple, le système Détecteur d'escroquerie par courriel TruthScan utilise l'analyse du langage naturel pour signaler les courriels qui proviennent probablement d'une IA, même s'ils ont l'air légitimes[18]. Ces détecteurs examinent des éléments tels qu'une grammaire parfaitement soignée, la complexité des phrases et des modèles stylistiques inhabituels pour les rédacteurs humains. Avec analyse en temps réelGrâce à ce système, les courriels suspects peuvent être mis en quarantaine ou signalés pour être examinés avant d'atteindre les utilisateurs. Les équipes de sécurité des entreprises commencent à déployer de tels filtres pilotés par l'IA au niveau des passerelles de messagerie et des plateformes de messagerie. En pratique, cela ajoute une nouvelle couche de défense aux filtres anti-spam traditionnels, une couche explicitement conçue pour détecter les contenus rédigés par l'IA. À partir de 2025, les grandes entreprises intègrent des solutions telles que TruthScan via API dans leurs passerelles de messagerie sécurisée et leurs suites de collaboration en nuage, créant ainsi un point de contrôle automatisé pour les contenus rédigés par l'IA. Hameçonnage généré par l'IA le contenu.

Usurpation d'identité vocale et vidéo Deepfake : La fraude "voir, c'est tromper".

La menace la plus viscérale liée à l'IA en 2025 est peut-être la montée en puissance de l'intelligence artificielle. les fausses attaques vocales et vidéo. Grâce à des modèles d'IA, les criminels peuvent cloner la voix d'une personne à partir de quelques secondes de son, ou générer une vidéo réaliste du visage d'une personne à partir d'une poignée de photos. Ces "deepfakes" sont utilisés dans le cadre d'escroqueries à l'usurpation d'identité aux enjeux considérables, qu'il s'agisse d'escroquerie au poste de PDG (appels de "faux PDG"), de fausses vidéoconférences ou d'autres types d'escroqueries. Un rapport récent de l'industrie a révélé que 47% des organisations ont subi des attaques de type deepfake d'un genre ou d'un autre[19]. Et ce n'est pas qu'une question de théorie : de nombreux cambriolages survenus entre 2023 et 2025 ont prouvé que les "deepfakes" peuvent déjouer l'authentification ultime, à savoir nos propres yeux et nos propres oreilles.

Un cas tristement célèbre concernait un virement bancaire international d'un montant de $25 millions après qu'un employé a été trompé par une fausse vidéoconférence. Les pirates ont utilisé l'IA pour synthétiser l'image de la directrice financière de l'entreprise lors d'un appel Zoom, avec sa voix et ses manières, et ont demandé à l'employé de virer des fonds.[4][20]. Dans un autre incident survenu en Australie, un gouvernement local perdu $2,3 millions lorsque des escrocs ont falsifié la voix et la vidéo de fonctionnaires municipaux pour approuver des paiements frauduleux[21]. Fait inquiétant, des criminels utilisent des voix clonées par l'IA dans le cadre d'"escroqueries aux grands-parents", en appelant des personnes âgées et en se faisant passer pour leurs proches en détresse. Les FBI et FinCEN a émis des alertes à la fin de l'année 2024 concernant une recrudescence de la fraude à l'aide d'une carte de crédit. Médias "deepfake" générés par l'IAles faux agents de service à la clientèle et les identités synthétiques pour contourner les vérifications KYC.[22].

La fréquence des délits fondés sur les "deepfakes" augmente rapidement. D'ici à la fin de 2024, une analyse a montré que une nouvelle escroquerie de type "deepfake" se produisait toutes les cinq minutes en moyenne[23]. Au cours du seul premier trimestre 2025, les incidents de deepfake signalés ont fait un bond de 19% par rapport à la même période de l'année précédente. tous de 2024[24][25]. Les "deepfakes" représentent aujourd'hui environ 6,5% de toutes les attaques frauduleuses, a 2,137% augmentation depuis 2022[26][27]. La technologie requise est devenue facilement accessible - il suffit souvent de quelques centimètres pour la mettre en œuvre. 30 secondes d'audio pour cloner une voix, ou moins d'une heure d'images pour modeler le visage d'une personne de manière convaincante.[20]. En bref, il n'a jamais été aussi facile de "falsifier l'identité d'une personne de confiance et incitent les victimes à leur remettre de l'argent ou des informations.

Mesures défensives - Authentification de la réalité : Pour contrer les menaces de "deepfake", les organisations se tournent vers des solutions de pointe. détection des médias synthétiques des outils. Par exemple, Détecteur de voix AI de TruthScan et TruthScan Deepfake Detector (Détecteur de fausses pistes) utilisent l'IA pour analyser les fichiers audio et vidéo afin d'y déceler des signes de manipulation. Ces systèmes effectuent une analyse image par image et de la forme d'onde pour repérer les artefacts tels que les mouvements faciaux non naturels, les problèmes de synchronisation labiale ou les irrégularités spectrales audio qui trahissent un clip généré par l'IA. Lors des tests, les algorithmes de TruthScan ont obtenu les résultats suivants 99%+ précision dans l'identification des voix générées par l'IA et détecté les images vidéo manipulées en temps réel[28][29]. En fait, les chercheurs du Genians Security Center ont récemment utilisé l'analyse judiciaire d'images de TruthScan pour analyser une fausse carte d'identité utilisée par des pirates nord-coréens - le détecteur d'images truquées de TruthScan a signalé le document comme étant inauthentique avec 98% confianceLe site Web de la Commission européenne, qui a déjoué la tentative de spear-phishing, a été mis à jour.[5][30].

Pour des raisons pratiques de défense, les entreprises déploient ces capacités de détection aux principaux points d'étranglement. Vérification vocale est ajouté aux flux de travail des centres d'appels - par exemple, lorsqu'un "client" demande un transfert important par téléphone, l'audio peut être soumis à un détecteur d'imitation de voix pour s'assurer qu'il s'agit bien de lui (et non d'une imitation par l'IA). De même, plates-formes de vidéoconférence peuvent intégrer l'analyse en direct des flux vidéo des participants pour détecter les visages synthétiques. La suite de détection de deepfake de TruthScan, par exemple, offre analyse des appels vidéo en temps réel et authentification faciale qui peut se connecter à Zoom ou WebEx via l'API[31][29]. Cela signifie que si quelqu'un tente de se joindre à une réunion en utilisant une vidéo de votre PDG créée par l'IA, le système peut signaler qu'il s'agit d'un "deepfake" possible avant qu'il n'y ait des dégâts. En outre, les transactions importantes comportent souvent une étape de vérification (hors bande ou multifacteur) qui peut tirer parti de l'authentification du contenu, par exemple en exigeant une brève confirmation orale dont l'authenticité est ensuite vérifiée par un détecteur vocal d'IA. En superposant ces outils, les entreprises créent un filet de sécurité : même si les employés voir ou entendre Si l'on considère qu'une menace est plausible, une analyse judiciaire de l'IA en coulisses remettra en question sa réalité. Dans un paysage de menaces imprégné d'IA, "Ne faites pas confiance - vérifiez devient le mantra de toute communication vocale ou vidéo impliquant de l'argent ou un accès sensible.

Logiciels malveillants conçus par l'IA et code obscurci : Évolution des menaces dans le code

L'influence de l'IA ne se limite pas à l'ingénierie sociale : elle change également la donne en matière de développement de logiciels malveillants et de codes d'attaque évasifs. En 2025, le Threat Intelligence Group de Google a mis au jour la premières souches de logiciels malveillants utilisant l'IA pendant l'exécution pour modifier leur comportement[32][33]. Un exemple, baptisé PROMPTFLUXIl s'agissait d'un script malveillant qui faisait appel à une API d'IA (le modèle Gemini de Google) pour réécrire son propre code à la voléeLa production de nouvelles variantes obscurcies afin d'échapper à la détection des antivirus[34][35]. Cette évolution de l'IA "juste à temps" marque un pas vers des logiciels malveillants autonomes et polymorphes. Autre exemple, PROMPTSTEALa utilisé un assistant de codage IA pour générer des commandes Windows en une ligne pour le vol de données, externalisant essentiellement des parties de sa logique à un moteur IA en temps réel.[36][37]. Ces innovations laissent entrevoir un avenir où les logiciels malveillants pourront se transformer en permanence - comme le ferait un pen-tester humain - pour déjouer les défenses.

Même en l'absence d'IA à la volée, les attaquants utilisent l'IA pendant le développement pour créer des codes malveillants plus puissants. L'IA générative peut produire des logiciels malveillants qui sont très obscurIl s'agit d'un système qui contient des couches de logique confuse qui empêchent la rétro-ingénierie. Selon les rapports de renseignements sur les menaces, plus de 70% des violations majeures en 2025 impliquaient une forme ou une autre de logiciel malveillant polymorphe qui modifie sa signature ou son comportement pour éviter d'être détecté[38]. En outre, 76% de campagnes de phishing utilisent désormais des tactiques polymorphes telles que les URL dynamiques ou les charges utiles réécrites par l'IA[38]. Des outils comme les offres du dark-web WormGPT et FraudeGPT (clones non limités de ChatGPT) permettent même aux non-experts de générer des droppers de logiciels malveillants, des keyloggers ou du code de ransomware en décrivant simplement ce qu'ils veulent.[39]. Il en résulte une abondance de nouvelles variantes de logiciels malveillants. Par exemple, en 2024, un voleur d'informations appelé BlackMamba a émergé qui a été entièrement généré par l'IAIl utilise ChatGPT pour écrire son code par segments - chaque exécution produisant un binaire légèrement différent, ce qui permet de déjouer les antivirus traditionnels basés sur des signatures[38]. Les chercheurs en sécurité ont également démontré des preuves de concept polymorphes générées par l'IA qui peuvent échapper à de nombreuses protections des points d'accès.[40].

En outre, les attaquants tirent parti de l'IA pour affiner leurs attaques. livraison de logiciels malveillants. L'IA peut écrire intelligemment des courriels d'hameçonnage (comme nous l'avons vu) qui contiennent des liens vers des logiciels malveillants. Elle peut également contribuer au développement d'exploits, par exemple en utilisant l'IA pour trouver de nouvelles vulnérabilités ou optimiser le shellcode. Des acteurs étatiques auraient utilisé des modèles d'IA avancés pour découvrir des exploits de type "zero-day" et développer des logiciels malveillants sur mesure pour leurs cibles.[41]. Toutes ces tendances signifient qu'en 2025, les logiciels malveillants seront plus furtifs et plus adaptatifs. Ils sont souvent "co-créé" avec l'IAce qui le rend plus difficile à détecter à l'aide de règles conventionnelles.

Mesures défensives - AI vs. AI dans la défense contre les logiciels malveillants : La défense contre les logiciels malveillants conçus par l'IA nécessite une combinaison de détection avancée et d'analyse alimentée par l'IA du côté défensif. De nombreuses organisations renforcent leur protection des points d'accès et EDR (Endpoint Detection & Response) avec des modèles IA/ML qui recherchent les schémas comportementaux du code généré par l'IA. Par exemple, des transformations soudaines du code sur l'hôte ou des schémas d'appel d'API inhabituels peuvent indiquer que PROMPTFLUX se régénère. De même, la surveillance du réseau peut détecter des anomalies telles que des logiciels malveillants s'adressant à des services d'IA (ce qui n'est pas "normal" pour des applications d'utilisateur). Les fournisseurs forment des détecteurs basés sur la ML sur le réseau de l familles de logiciels malveillants assistés par l'IA identifiés à ce jour, améliorant ainsi la reconnaissance de ces nouvelles menaces.

Une solution émergente est l'analyse de contenu par l'IA intégrée dans les pipelines de développement et de construction. Il s'agit d'utiliser des détecteurs pilotés par l'IA pour analyser les scripts, les constructions logicielles ou même les changements de configuration afin de détecter les contenus malveillants ou générés par l'IA. En voici un exemple, Le détecteur en temps réel de TruthScan peut être déployé au-delà du simple texte - son analyse multimodale peut potentiellement signaler un code ou des fichiers de configuration suspects en reconnaissant s'ils ont été générés par une machine avec des schémas d'obscurcissement.[42][43]. Les équipes de développement et les MSSP commencent à analyser les scripts d'infrastructure en tant que code, les journaux PowerShell et d'autres artefacts à la recherche de segments rédigés par l'IA qui pourraient indiquer la main d'un attaquant. Bien qu'il s'agisse d'un domaine naissant, il est prometteur : dans un cas, une équipe de sécurité a utilisé un détecteur d'IA pour attraper un fichier de kit de phishing obscurci qui "semblait" avoir été généré par l'IA et qui faisait en fait partie d'une attaque[44]. Le code du fichier était excessivement complexe et verbeux (caractéristiques de la génération d'IA), et une analyse du contenu par l'IA a confirmé la forte probabilité qu'il n'ait pas été écrit par un être humain[40].

Enfin, le partage de renseignements sur les menaces axé sur les menaces liées à l'IA est crucial. Lorsque le GTIG de Google publie des détails sur les logiciels malveillants basés sur Prompt ou lorsque des chercheurs signalent de nouvelles techniques d'évasion de l'IA, les organisations doivent les intégrer dans leur ingénierie de détection. Analyse comportementale - à la recherche d'actions telles qu'un processus qui génère un script qui réécrit le code de ce même processus - peut détecter des anomalies que les logiciels malveillants assistés par l'IA présentent. En résumé, les défenseurs doivent lutter contre le feu par le feu : déployer des systèmes de détection de virus et des systèmes de sécurité. Outils de sécurité pilotés par l'IA qui peuvent s'adapter aussi rapidement que les logiciels malveillants pilotés par l'IA. Cela va de l'antivirus amélioré par l'IA à l'analyse du comportement des utilisateurs, qui permet d'identifier le moment où un compte ou un système commence à se comporter de manière "pas tout à fait humaine". En adoptant l'IA pour la défense, les équipes de sécurité peuvent contrer les avantages de vitesse et d'échelle que l'IA offre aux attaquants.

Identités synthétiques et fraudes alimentées par l'IA

Passer des logiciels malveillants au monde de la fraude : fraude à l'identité synthétique a explosé avec l'aide de l'IA générative. La fraude à l'identité synthétique consiste à créer des personas fictifs en combinant des données réelles et fausses (par exemple, un vrai SSN + un faux nom et de faux documents). Ces identités "Frankenstein" sont ensuite utilisées pour ouvrir des comptes bancaires, demander des crédits ou passer des contrôles KYC, ce qui peut aboutir à des prêts impayés ou à du blanchiment d'argent. Il s'agissait déjà de l'un des types de fraude à la croissance la plus rapide, et l'IA a maintenant jeté de l'huile sur le feu. Pertes liées à la fraude par identification synthétique franchi $35 milliards d'euros en 2023[45]Au début de l'année 2025, certaines estimations indiquaient près de 25% de l'ensemble des pertes liées à la fraude bancaire étaient dues à des identités synthétiques[46]. Les analystes d'Experian ont constaté que plus de 80% de fraude sur les nouveaux comptes sur certains marchés est désormais lié à des identifiants synthétiques.[19] - une statistique stupéfiante qui souligne à quel point cette escroquerie est devenue omniprésente.

L'IA générative amplifie la fraude synthétique de plusieurs façons. Tout d'abord, l'IA rend triviale la production des "documents de l'éleveur" et les empreintes numériques nécessaires pour vendre une fausse identité. Dans le passé, un fraudeur pouvait photoshoper une pièce d'identité ou créer manuellement de fausses factures de services publics. Aujourd'hui, il existe des outils permettant de générer des des photos de profil, des pièces d'identité, des passeports, des relevés bancaires et même des profils de médias sociaux d'apparence authentique en utilisant des générateurs d'images et des modèles linguistiques d'IA[47][48]. Par exemple, on peut utiliser une IA pour créer une photo réaliste d'une personne qui n'existe pas (ce qui permet d'éviter les recherches d'images inversées), et générer un faux permis de conduire correspondant à cette photo. L'IA peut également simuler les "signes vitaux" d'une identité, en créant par exemple les dossiers des parents synthétiques, les adresses ou les messages sur les médias sociaux pour étoffer une histoire[49]. La Fed de Boston a noté que Gen AI peut même produire des deepfake audio et vidéo d'une fausse personne - Par exemple, un utilisateur synthétique pourrait "apparaître" dans une vidéo de vérification de selfie, avec un visage et une voix uniques, tous générés par l'IA.[50].

Deuxièmement, l'IA aide les fraudeurs augmenter leurs opérations. Au lieu de falsifier une ou deux identités à la fois, ils peuvent générer par programme des centaines ou des milliers de dossiers d'identité complets et remplir automatiquement et en masse les demandes d'ouverture de nouveaux comptes[51][52]. Certains services du dark web proposent effectivement des "Les identités synthétiques en tant que serviceLes criminels, quant à eux, utilisent l'automatisation pour produire des comptes vérifiés à vendre. Pendant les programmes d'aide à la pandémie COVID-19, par exemple, les criminels ont utilisé des bots avec des identités générées par l'IA pour demander en masse des prêts et des prestations, submergeant le système de faux demandeurs. Selon les prévisions de Juniper Research, le coût global de la fraude à l'identité numérique (alimentée par ces tactiques) s'élèvera à augmenter 153% d'ici 2030 par rapport à 2025[53].

Mesures défensives - Vérifier l'identité dans un monde d'IA : Les méthodes traditionnelles de vérification de l'identité ont du mal à résister aux contrefaçons créées par l'IA. Pour s'adapter, les organisations adoptent vérification multicouche de l'identité et du comportement renforcée par l'IA. Une couche clé est l'intelligence artificielle avancée. la criminalistique des documents et des images. Par exemple, Détecteur d'images AI de TruthScan et Détecteur de faux documents permettent d'analyser les pièces d'identité, les selfies ou les documents téléchargés afin d'y déceler des signes de synthèse ou de falsification. Ces outils examinent les artefacts au niveau des pixels, les incohérences d'éclairage et les métadonnées afin de déterminer si une image a été générée ou manipulée par l'IA. Ils peuvent détecter des indices subtils, comme des motifs d'arrière-plan identiques sur des photos générées par GAN, ou des polices et un espacement sur une pièce d'identité qui ne correspondent à aucun modèle gouvernemental connu. En déployant de tels détecteurs lors de l'intégration, les banques peuvent automatiquement signaler le permis de conduire ou le selfie d'un candidat s'il est susceptible d'avoir été généré par l'IA (par exemple, le système de TruthScan aurait signalé la fausse carte d'identité militaire utilisée dans l'affaire d'hameçonnage de l'APT Kimsuky).[5]). Selon un communiqué de presse de TruthScan, leur plateforme a été utilisée par des institutions financières pour valider l'authenticité de documents à grande échelle, en identifiant les "deepfakes" avec une très grande précision.[54].

Une autre couche est analyse comportementale et des vérifications de références croisées. Les vraies identités ont de la profondeur - des années d'histoire, des dossiers publics, des activités sur les médias sociaux, etc. Les identités générées par l'IA, aussi perfectionnées soient-elles, manquent souvent de ces racines profondes. Les banques et les prêteurs utilisent désormais l'IA pour recouper les données de la demande avec des données publiques et propriétaires : Le numéro de téléphone et l'adresse électronique de cette personne montrent-ils un historique d'utilisation ? La géolocalisation de l'appareil ou de l'IP est-elle logique ? La personne saisit-elle les données dans les formulaires d'une manière humaine ou fait-elle du copier-coller (comme le font les robots) ? Les modèles d'IA peuvent être entraînés à distinguer les comportements authentiques des clients des modèles synthétiques. La Réserve fédérale a noté que "Les identités synthétiques sont superficielles, et l'IA peut le voir. - La vérification basée sur l'IA peut rapidement rechercher l'empreinte numérique d'une identité et déclencher des alarmes en cas d'absence d'empreinte.[55]. Dans la pratique, les services de vérification d'identité utilisent désormais l'IA pour vérifier si le selfie d'un utilisateur correspond à des photos antérieures (afin de détecter les échanges de visages) et même pour inviter les utilisateurs à effectuer des actions aléatoires (comme des poses ou des phrases spécifiques) lors des vérifications de la vivacité, ce qui rend plus difficile pour les deepfakes de répondre correctement[56][57].

Enfin , surveillance continue Le suivi du comportement des comptes après l'intégration permet d'identifier les comptes synthétiques qui se sont glissés dans le système. Comme ces comptes ne sont pas liés à une personne réelle, leurs schémas d'utilisation finissent souvent par se démarquer (par exemple, en effectuant des transactions parfaitement synchronisées pour augmenter le crédit, puis en l'épuisant). Le contrôle des fraudes basé sur l'IA (comme les plateformes de Sift ou de Feedzai) peut identifier les anomalies dans la façon dont les comptes sont utilisés, signalant ainsi les comptes synthétiques potentiels pour examen. En résumé, la lutte contre la fraude à l'identité basée sur l'IA nécessite Preuve d'identité basée sur l'IA - combinant la recherche de documents, les contrôles biométriques, la corrélation des données et l'analyse comportementale. La bonne nouvelle, c'est que les mêmes avancées en matière d'IA qui permettent la fraude sont également utilisées pour la détecter. TruthScan, par exemple, offre un service de détection des fraudes à l'aide de l'IA. suite de vérification d'identité qui intègre l'analyse du texte, de l'image et de la voix pour contrôler les nouveaux utilisateurs. En tirant parti de ces outils, une grande banque a constaté une baisse significative des ouvertures de comptes synthétiques réussies, alors même que les moyennes du secteur augmentaient. La course aux armements se poursuit, mais les défenseurs apprennent à repérer les faibles "signes numériques" d'une personne synthétique, quelle que soit la façon dont l'IA tente de brouiller les pistes.

Intégrer la détection de l'IA dans la pile de sécurité

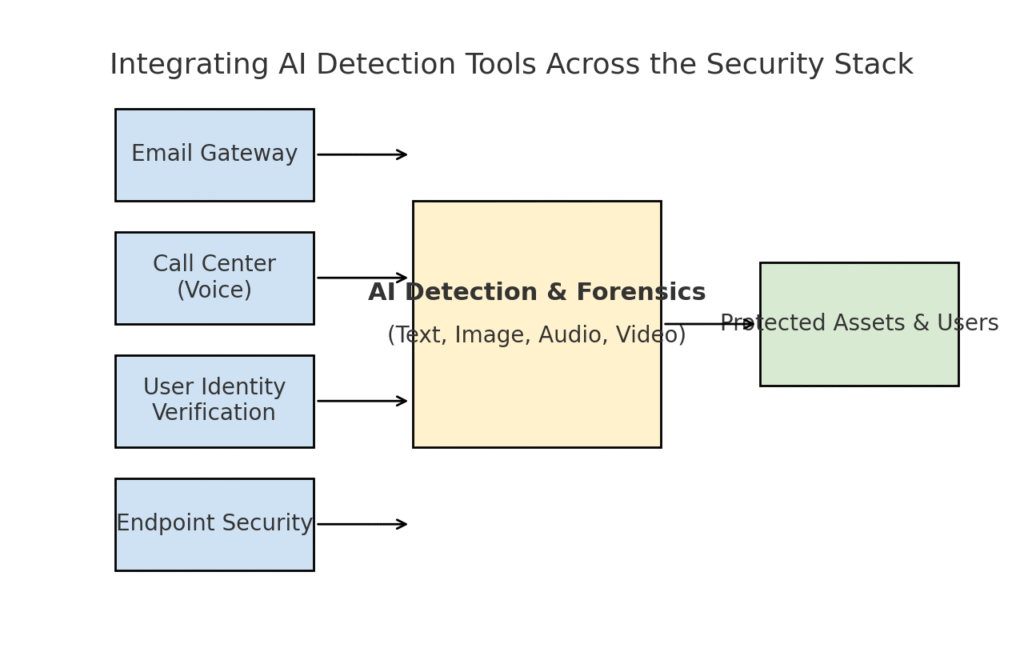

Nous avons exploré plusieurs domaines de menace distincts - phishing, deepfakes, logiciels malveillants, fraude synthétique - tous dopés par l'IA. Il est clair que pas d'outil unique ou de solution ponctuelle ne résoudra pas le problème. Les entreprises ont plutôt besoin d'une stratégie globale pour intégrer la détection et la vérification alimentées par l'IA à chaque couche de leur pile de cybersécurité. L'approche doit refléter la surface d'attaque, couvrant le courrier électronique, le web, la voix, les documents, l'identité et au-delà. Le diagramme ci-dessous illustre la manière dont les organisations peuvent intégrer les outils de détection de l'IA de TruthScan (et des solutions similaires) dans les couches de sécurité communes de l'entreprise :

Intégrer des outils de détection de l'IA à plusieurs niveaux de la pile de sécurité - des passerelles de messagerie et des centres d'appels à la vérification des utilisateurs et à la protection des points d'extrémité. La détection de contenu par l'IA (centre) analyse le texte, les images, l'audio et la vidéo en temps réel, et alimente les points d'application qui protègent les actifs et les utilisateurs.

Dans ce modèle, Les détecteurs multimodaux d'IA agissent comme un cerveau central qui s'interface avec différents contrôles de sécurité :

- Passerelles de courrier électronique : Les courriels entrants passent par un détecteur de texte et d'escroquerie avant d'arriver dans la boîte de réception. Ceci est lié à la défense contre l'hameçonnage dont nous avons parlé - par exemple, l'utilisation de Détecteur d'escroquerie par courriel de TruthScan via l'API de votre fournisseur de messagerie pour mettre automatiquement en quarantaine les courriels suspects générés par l'IA[18]. Elle peut également être appliquée aux plateformes de messagerie (applications de chat, passerelles SMS) pour analyser le contenu à la recherche de modèles de phishing ou d'escroquerie.

- Centres d'appel et systèmes vocaux : Les canaux téléphoniques et VOIP sont sécurisés par l'intégration de la détection des fausses pistes vocales. Par exemple, la ligne d'assistance à la clientèle d'une banque pourrait utiliser la technologie Détecteur de voix AI de TruthScan analyser en temps réel le son des appels entrants et alerter si l'empreinte vocale d'un appelant est synthétique ou ne correspond pas à son profil connu[58][59]. Cela permet d'éviter que les attaques par vishing et par usurpation d'identité vocale (comme les faux appels du PDG) n'aboutissent.

- Processus de vérification de l'identité des utilisateurs : Lors de la création d'un compte ou d'actions à haut risque (réinitialisation du mot de passe, virements bancaires), la vérification d'identité pilotée par l'IA entre en action. Une photo d'identité téléchargée est vérifiée par un outil d'analyse d'image (par exemple, en vérifiant si elle est générée par l'IA ou s'il s'agit de la photo d'une photo), et un selfie ou un appel vidéo est examiné par un détecteur de faux. Le système TruthScan Détecteur de fausses pistes peut être utilisé ici pour effectuer une authentification faciale - en s'assurant que la personne filmée est réelle et qu'elle correspond à l'ID[60][61]. Les signaux comportementaux (cadence de frappe, cohérence des appareils) peuvent également être introduits dans les modèles d'IA pour détecter les robots ou les identités synthétiques.

- Points finaux et réseau : Les agents de sécurité des terminaux et les serveurs proxy peuvent intégrer l'analyse du contenu de l'IA pour les fichiers et les scripts. Par exemple, si un EDR voit un nouveau script ou EXE s'exécuter, il peut envoyer le contenu textuel du fichier à un détecteur d'IA pour vérifier s'il ressemble à un logiciel malveillant connu généré par l'IA ou s'il présente les caractéristiques d'un code d'IA obscurci. De même, les systèmes DLP (prévention des pertes de données) peuvent utiliser la détection de texte d'IA pour signaler un texte sensible généré par l'IA (ce qui pourrait indiquer qu'un initié utilise l'IA pour rédiger des messages d'exfiltration de données ou falsifier des rapports). La solution de TruthScan Détecteur en temps réel est conçu pour s'intégrer dans de tels flux de travail, offrant une analyse en direct du contenu sur toutes les plateformes avec des options de réponse automatisées.[42][62] (par exemple, le blocage automatique d'un fichier ou d'un message s'il est identifié comme un logiciel malveillant ou une désinformation générés par l'IA).

Le avantage essentiel de cette approche intégrée est vitesse et cohérence. Les attaques d'IA se déplacent rapidement - les courriels de phishing, les fausses voix et les données synthétiques peuvent toucher de nombreux canaux à la fois. En dotant tous ces canaux d'instruments de détection de l'IA, une organisation bénéficie d'une visibilité en temps réel et d'une défense en profondeur. Une équipe a décrit cela comme la création d'un "système immunitaire d'IA" pour son entreprise : chaque fois que quelque chose est communiqué (qu'il s'agisse d'un courriel, d'un téléchargement de document, d'un appel vocal, etc.), le système immunitaire d'IA le "renifle" à la recherche de signatures étrangères (générées par l'IA) et le neutralise s'il s'avère malveillant.

La suite d'entreprise de TruthScan en est l'illustration, puisqu'elle offre une gamme de produits et de services de qualité. plateforme unifiée couvrant la détection de l'IA du texte, de l'image, de l'audio et de la vidéo, qui peut être déployée de manière modulaire ou dans son ensemble[63][64]. De nombreuses entreprises commencent par déployer une ou deux fonctionnalités (par exemple, la détection de texte dans le courrier électronique et la détection d'images dans l'accueil), puis les étendent à d'autres lorsqu'elles en constatent la valeur. Il est important de noter que l'intégration est facilitée pour les développeurs - TruthScan et les services similaires fournissent des API et des SDK afin que les équipes de sécurité puissent intégrer la détection dans les systèmes existants sans devoir procéder à une refonte massive. Qu'il s'agisse d'un SIEM, d'une passerelle de messagerie, d'une application bancaire personnalisée ou d'un système CRM, la détection peut s'effectuer en arrière-plan et alimenter des alertes ou des actions automatisées. Par exemple, une grande plateforme de médias sociaux a intégré des API de modération de contenu pour retirer automatiquement les vidéos "deepfake" dans les minutes qui suivent leur mise en ligne[65][66]et d'empêcher la diffusion de fausses informations générées par l'IA.

Conclusion : Garder une longueur d'avance

La prolifération rapide des menaces liées à l'IA en 2025 a posé de nouveaux défis aux organisations. Les attaquants ont trouvé des moyens d'exploiter la confiance humaine à grande échelle - en usurpant des voix et des identités, en automatisant l'ingénierie sociale, en échappant aux défenses grâce à un code adaptatif et en fabriquant de fausses réalités entières. C'est une perspective décourageante pour les défenseurs, mais pas sans espoir. Tout comme les criminels exploitent l'IA, nous pouvons également la mettre au service de la sécurité. L'émergence de l Détection de contenu par l'IA, recherche de fausses informations (deepfake forensics) et analyseurs d'identités synthétiques nous permet de contrer efficacement ces nouvelles menaces. En déployant ces outils et les intégrer à tous les niveaux Grâce à la mise en place d'un système de défense efficace, les entreprises peuvent réduire considérablement le risque que des attaques alimentées par l'IA se faufilent entre les mailles du filet. Les premiers utilisateurs ont déjà déjoué des tentatives de fraude de plusieurs millions de dollars en prenant les "deepfakes" en flagrant délit.[26]ou a évité les catastrophes dues au phishing en filtrant les courriels conçus par l'IA.

Au-delà de la technologie, les organisations devraient cultiver une culture de "confiance mais vérification". Les employés doivent être conscients qu'à l'ère de l'IA, voir (ou entendre) n'est pas toujours croire - un scepticisme sain associé à des flux de travail de vérification peut mettre fin à de nombreux stratagèmes d'ingénierie sociale. La formation et la sensibilisation, combinées à des outils de vérification automatisés tels que TruthScanLe système d'authentification et de validation de l'information constitue une défense redoutable. En un sens, nous devons relever la barre de l'authentification et de la validation de l'information. Les communications et les documents numériques ne peuvent plus être pris pour argent comptant ; leur provenance doit être vérifiée, soit par une machine, soit par un processus.

À mesure que nous avançons, il faut s'attendre à ce que les attaquants affinent encore leurs tactiques d'IA, mais aussi à ce que l'innovation en matière d'IA défensive se poursuive. La dynamique du chat et de la souris persistera. Le succès des défenseurs dépendra agilité et partage de l'information. Ceux qui intègrent rapidement de nouveaux renseignements sur les menaces (par exemple, de nouvelles techniques de détection des " deepfake " ou des signatures de modèles d'IA mises à jour) garderont une longueur d'avance sur les attaquants qui utilisent les outils d'IA les plus récents. Les collaborations entre l'industrie, le monde universitaire et les pouvoirs publics seront également essentielles dans cette lutte, comme en témoignent les alertes et les cadres émanant d'organismes tels que le cadre de gestion des risques liés à l'IA du NIST et les collaborations interbancaires sur la détection de l'IA frauduleuse.

En conclusion, le secteur de la cybersécurité est au cœur d'un changement de paradigme induit par l'IA. Les menaces sont différentes de celles d'il y a dix ans, mais nous y répondons par des défenses tout aussi inédites. Grâce à la combinaison d'une technologie de détection avancée et d'une stratégie de sécurité robuste, nous pouvons peut atténuer les risques de l'IA générative et même la tourner à notre avantage. Des outils tels que la suite de détection de l'IA de TruthScan nous permettent de restaurer la confiance dans un monde où la confiance est nulle - pour s'assurer que la personne à l'autre bout du fil est réelle, que le document dans notre boîte de réception est authentique et que le code qui s'exécute dans notre réseau n'a pas été altéré par une IA malveillante. En investissant dès maintenant dans ces capacités, les organisations se protégeront non seulement contre les attaques actuelles basées sur l'IA, mais elles renforceront également leur résilience face aux menaces en constante évolution de demain. La conclusion est claire : L'IA est peut-être en train de renforcer les cyberattaques, mais avec la bonne approche, elle peut aussi renforcer nos défenses.

Sources : Les données et les exemples pertinents ont été tirés de 2025 rapports de veille sur les menaces et d'experts, notamment le rapport de Mayer Brown intitulé "Cyber Incident Trends" (tendances en matière de cyberincidents).[1][67]Le point sur les menaces en 2025 selon Fortinet[2][19]Barracuda : recherche sur les attaques de courrier électronique par l'IA[6][7]Rapport sur les menaces liées à l'IA de Google GTIG[34]La Réserve fédérale de Boston s'intéresse à la fraude synthétique[45][50]et les études de cas et communiqués de presse publiés par TruthScan[30][26]entre autres. Ces exemples illustrent l'ampleur des menaces liées à l'IA et l'efficacité des contre-mesures axées sur l'IA dans des scénarios réels. En tirant les leçons de cette intelligence et en déployant des outils de pointe, nous pourrons naviguer en toute confiance dans l'ère des cyberrisques renforcés par l'IA.

[1] [67] 2025 Cyber Incident Trends What Your Business Needs to Know | Insights | Mayer Brown

[2] [3] [19] Principales statistiques sur la cybersécurité : Faits, statistiques et violations pour 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] La fraude par l'IA dans les services financiers : Tendances récentes et solutions | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan détecte une attaque Deepfake nord-coréenne contre des fonctionnaires de la défense - Bryan County Magazine

[6] [7] [14] La moitié des spams de votre boîte de réception est générée par l'IA - son utilisation dans les attaques avancées est à un stade précoce | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Indice de confiance numérique du deuxième trimestre 2025 : Données et aperçus sur la fraude à l'IA | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Menaces de cybersécurité liées à l'IA en 2025 : $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Dernières informations sur les menaces | TruthScan

[18] [63] [64] TruthScan - Détection de l'IA en entreprise et sécurité du contenu

[23] [46] [56] [57] Deepfakes et dépôts : Comment lutter contre la fraude à l'IA générative

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Attaques par Deepfake et hameçonnage généré par l'IA : statistiques de 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Détecteur de voix AI pour les Deepfakes et le clonage vocal | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifier les fausses vidéos et les vidéos d'IA - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker : Progrès dans l'utilisation des outils d'IA par les acteurs de la menace | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Les pirates ont obscurci les logiciels malveillants avec un code d'IA verbeux

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Détection de l'IA en temps réel - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Les opérateurs d'EvilAI utilisent des codes générés par l'IA et de fausses applications pour ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] L'intelligence artificielle accroît la menace de fraude à l'identité synthétique - Banque fédérale de réserve de Boston

[53] Fraude à l'identité synthétique 2025 : Stratégies de détection et de prévention par l'IA