La fraude à l'assurance entre dans une nouvelle ère alimentée par l'intelligence artificielle. Des réseaux de fraudeurs sophistiqués et des escrocs solitaires exploitent des outils d'IA générative pour produire de fausses demandes d'indemnisation, des identités synthétiques, des preuves falsifiées et des escroqueries à l'usurpation d'identité très convaincantes. Ce livre blanc examine les dernières tendances de 2025 en matière de fraude à l'assurance basée sur l'IA - des demandes d'indemnisation et des documents générés par l'IA aux escroqueries à la fausse voix - et indique comment les assureurs peuvent y répondre. Nous présentons des données récentes, des cas concrets et des idées stratégiques pour les souscripteurs, les enquêteurs de fraude, les équipes de cybersécurité, les gestionnaires de sinistres et les dirigeants qui ont besoin de comprendre ce paysage de menaces en évolution rapide.

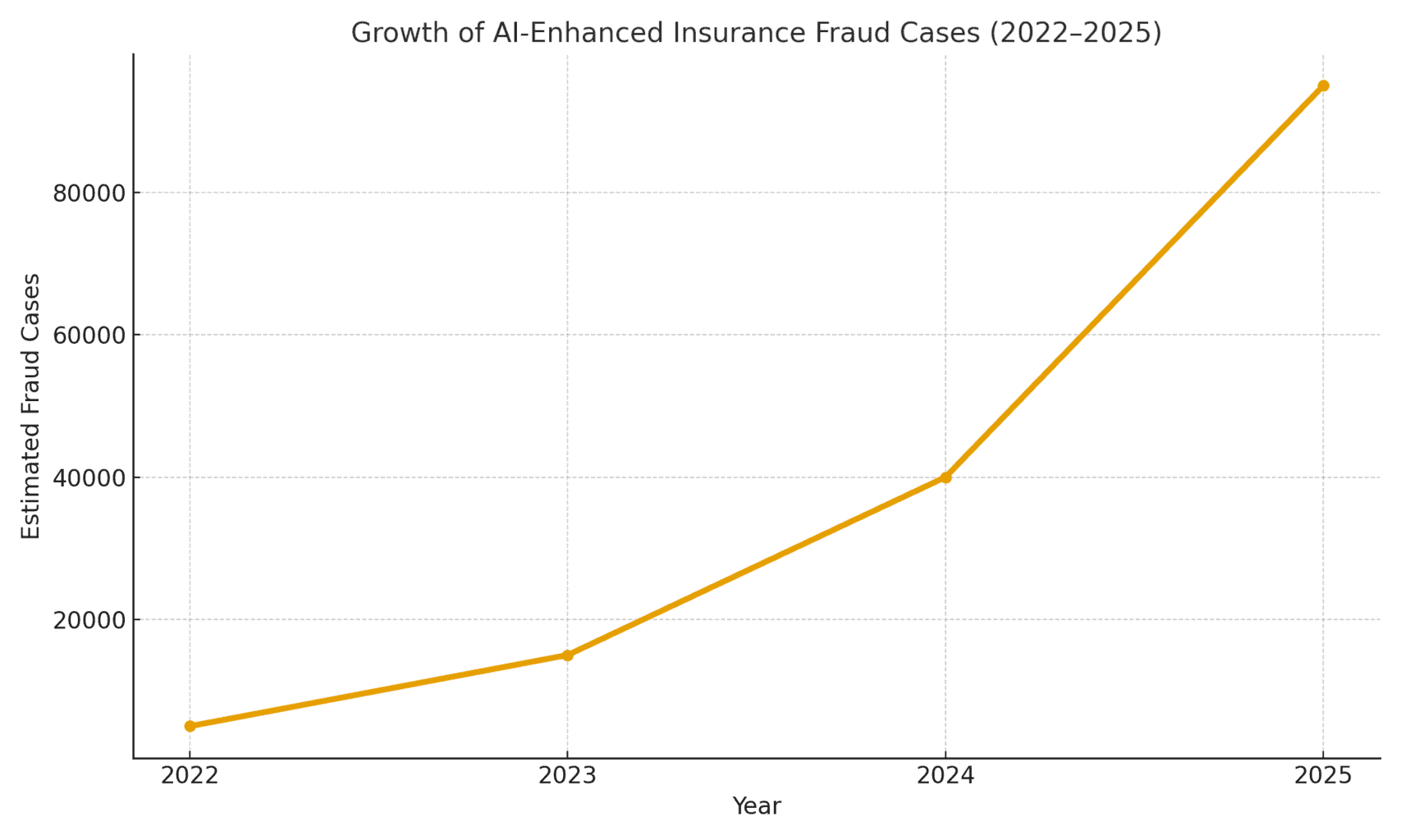

L'ampleur de la menace : La fraude permise par l'IA est en plein essor. Un rapport de 2025 sur la comptabilité légale a révélé que Les escroqueries fondées sur l'IA représentent désormais plus de la moitié de l'ensemble des fraudes financières numériques.[1]. En matière d'assurance, la société Pindrop, spécialisée dans la sécurité vocale, a observé une augmentation de la fréquence des appels d'urgence. 475% augmentation des attaques de fraude à la voix synthétique contre les compagnies d'assurance en 2024contribuant à une augmentation de 19% d'une année sur l'autre de l'ensemble des tentatives de fraude à l'assurance.[2]. Les assureurs doivent faire face à environ Exposition à la fraude 20 fois supérieure à celle des banquesEn raison notamment de la forte dépendance à l'égard des documents, des images et des vérifications vocales dans les demandes d'indemnisation.[3]. La figure 1 ci-dessous illustre la croissance explosive des incidents de fraude à l'assurance renforcés par l'IA entre 2022 et 2025, car de nombreux rapports du secteur ont indiqué des augmentations de pourcentage à trois ou quatre chiffres d'une année sur l'autre dans l'implication détectée de l'IA dans la fraude.

Figure 1 : Augmentation rapide des cas de fraudes à l'assurance renforcées par l'IA (croissance indexée 2022-2025). Les données du secteur indiquent une augmentation exponentielle des contenus générés par l'IA trouvés dans les demandes d'indemnisation frauduleuses, en particulier depuis 2023.[4][2]

Affirmations générées par l'IA et fausses preuves

L'une des tendances les plus répandues est l'utilisation de l'IA générative pour concevoir des produits de qualité. des déclarations d'assurance entièrement fabriquées. Grâce à des générateurs de texte IA avancés, les fraudeurs peuvent rédiger des descriptions d'incidents réalistes, des rapports médicaux ou des déclarations de police en cliquant sur un bouton. Ces récits rédigés par l'IA paraissent souvent soignés et plausibles, ce qui rend plus difficile la détection des incohérences par les experts en sinistres. Par exemple, des fraudeurs ont utilisé ChatGPT pour rédiger des descriptions détaillées d'accidents ou des rapports de blessures qui paraissent professionnels et convaincants - une tâche qui nécessitait autrefois des efforts et des compétences rédactionnelles considérables.

Plus inquiétant encore, les criminels associent désormais ces faux récits à des Preuves à l'appui générées par l'IA. Des modèles de génération d'images (comme Midjourney ou DALL-E) et des outils d'édition permettent de produire des photos photoréalistes des dommages et des blessures. Selon les rapports de l'industrie, certains conducteurs ont commencé à soumettre des images générées par l'IA pour exagérer les dommages subis par les véhicules dans le cadre de sinistres automobiles[5]. L'IA générative peut créer une photo d'une voiture accidentée ou d'une maison inondée qui n'a jamais existé. Ces images sont souvent plus réalistes que ce que les anciennes techniques Photoshop permettaient d'obtenir[6]Ils sont donc difficiles à détecter à l'œil nu. En avril 2025, Zurich Insurance a constaté une augmentation des sinistres avec des des factures trafiquées, des devis de réparation fabriqués de toutes pièces et des photos modifiées numériquementy compris les cas où les numéros d'immatriculation des véhicules ont été insérés par l'IA sur des images de voitures récupérées[7][8]. Ces fausses preuves, associées à un formulaire de demande bien rédigé par l'IA, peuvent échapper aux contrôles manuels.

Un cas frappant survenu au Royaume-Uni est celui d'escrocs qui se sont emparés d'une somme d'argent d'un million d'euros. photo d'une camionnette d'artisan sur les réseaux sociaux et utilisation de l'IA pour ajouter un pare-chocs fissuréIl l'a ensuite présenté avec une fausse facture de réparation de 1 000 livres sterling dans le cadre d'une fausse déclaration d'accident.[9]. L'escroquerie n'a été découverte que lorsque les enquêteurs ont remarqué que les même photo de la camionnette (avant les dommages) sur la page Facebook du propriétaire[10]. Cela illustre un phénomène plus large : les assureurs font état d'une augmentation de la consommation d'énergie. 300% saut dans les éditions d'images "superficielles" (shallowfake) (simples manipulations numériques pour ajouter des dommages ou modifier des détails) en seulement un an (2021-2022 vs 2022-2023)[4]. Allianz UK a averti en 2024 que les déformations de photos numériques et les faux documents avaient "tous les signes de devenir la dernière grande escroquerie à frapper l'industrie"[4]. Le responsable des fraudes en matière de sinistres de Zurich a également observé que Ce qui nécessitait autrefois la mise en scène d'un accident de voiture peut désormais se faire entièrement derrière un ordinateur. - les escrocs peuvent "créer une demande d'indemnisation frauduleuse derrière leur clavier et soutirer des sommes importantes" grâce à de fausses photos et de faux rapports de perte totale[11][12]. Ce changement n'augmente pas seulement le volume des fausses déclarations, mais abaisse également la barrière à l'entrée pour les fraudeurs potentiels.

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

Au-delà de l'automobile, sinistres dommages sont témoins d'un gonflement des pertes assisté par l'IA. Des rapports font état de fausses photos pour l'assurance voyage (par exemple, des bagages "endommagés" ou des scènes de vol mises en scène) et de reçus générés par l'IA pour des articles coûteux qui n'ont jamais été achetés. Déclarations sur la vie et la santé ne sont pas non plus à l'abri - des fraudeurs ont créé de fausses les factures médicales et les certificats de décès l'utilisation de faussaires de documents utilisant l'IA. En fait, Zurich a constaté que la technologie "deepfake" était utilisée pour créer des faux documents. des évaluations d'ingénieurs et des rapports médicaux entièrement fictifs dans les dossiers de demande d'indemnisation[11]. Ces documents générés par l'IA, souvent accompagnés de logos et de signatures réalistes, peuvent être impossibles à distinguer des documents administratifs authentiques. Les assureurs-vie sont de plus en plus préoccupés par fraude à l'obituaire et à l'acte de décèsLes criminels peuvent utiliser l'IA pour produire de fausses notices nécrologiques ou de fausses lettres de médecin afin d'étayer une demande d'indemnisation pour une personne qui est en fait toujours en vie (ou qui n'a jamais existé du tout, comme nous le verrons plus loin).

Titulaires de polices synthétiques et identités

L'évolution la plus insidieuse est peut-être fraude à l'identité synthétique en matière d'assurance. La fraude à l'identité synthétique consiste à créer une personne ou une entité fictive en combinant des données réelles (numéros de sécurité sociale volés, adresses, etc.) avec des détails fabriqués (faux noms, faux documents d'identité). Grâce aux progrès de l'intelligence artificielle, il est aujourd'hui très facile de générer de telles données. des profils personnels réalistes - y compris des photos et des identifiants - pour des personnes qui n'existent pas[13][14]. Les fraudeurs peuvent désormais produire algorithmiquement un client complètement faux, souscrire une police en son nom et, par la suite, mettre en place des demandes d'indemnisation ou des prestations de police pour cette fausse identité.

Dans le secteur de l'assurance-vie, les systèmes d'identité synthétique ont monté en flèche. Les recherches menées par l'industrie en 2025 estiment que les coûts de l'usurpation d'identité synthétique sont les suivants plus de $30 milliards d'euros par an, ce qui représente jusqu'à 80-85% de tous les cas de fraude d'identité dans l'ensemble des services financiers[15][16]. Les assureurs vie ont été particulièrement touchés : les escrocs sont connus pour souscrire des polices d'assurance-vie pour une personne fictive, puis "tuer" cette personne sur papier afin de percevoir le capital décès[17]. Par exemple, un fraudeur peut créer un client synthétique "Jean Dupont", payer des primes pendant un an, puis soumettre une demande d'indemnisation avec un faux certificat de décès et une fausse notice nécrologique pour le décès prématuré de Jean Dupont. Comme l'identité a été construite avec soin (historique de crédit, dossiers publics, etc.), la demande d'indemnisation peut sembler légitime - jusqu'à ce qu'aucun corps ou parent réel ne puisse être trouvé. Lorsque la fraude est découverte, les auteurs sont partis depuis longtemps avec le paiement.

Les systèmes d'identité synthétique sont également un fléau l'assurance maladie et l'assurance automobile. Les réseaux criminels créent des identités "Frankenstein" en l'utilisation de numéros de sécurité sociale d'enfants ou de personnes âgées (qui n'ont pas d'antécédents en matière de crédit) combinés à des noms et des permis de conduire générés par l'IA[15]. Ils ont ensuite souscrire des polices d'assurance maladie ou automobile pour ces faux individus et, peu de temps après, déposer des demandes d'indemnisation importantes. Une variante consiste en la mise en place de syndicats les fausses entreprises (sociétés fictives) - par exemple, une société de camionnage fictive - et la souscription d'une assurance commerciale pour cette société, dans le but d'obtenir ensuite une indemnisation pour des accidents mis en scène ou des blessures subies par des employés fictifs[18][19]. Comme l'entreprise n'existe que sur papier (avec des enregistrements commerciaux et des numéros d'identification fiscale générés par l'IA), cela ne peut être que bénéfique. "Fraude synthétique "à base d'entités n'est souvent découverte qu'après le versement des indemnités[18][20].

Pourquoi les identités synthétiques sont-elles si efficaces ? Tout d'abord, elles passent souvent à travers les contrôles automatisés de vérification de l'identité. Les agences d'évaluation du crédit et les systèmes KYC peuvent trouver des identités synthétiques. pas de drapeaux rouges parce que l'identité comprend des données réelles et valides (par exemple, un vrai numéro de sécurité sociale avec un casier judiciaire vierge)[21]. Par ailleurs, les photos de profil et les scans d'identité générés par l'IA peuvent sembler tout à fait authentiques - l'IA d'aujourd'hui peut produire un visage humain que même la reconnaissance faciale avancée pourrait accepter comme réel. Le résultat : la plupart des systèmes automatisés reconnaissent ces profils comme légitimes et la fraude n'est détectée (si elle l'est) qu'après des pertes importantes[22].

L'impact sur le monde réel : La RGA rapporte que la fraude à l'identité synthétique dans l'assurance-vie coûte désormais au secteur environ $30B par an et a augmenté de près de 400% depuis 2020[15][16]. La Commission fédérale du commerce des États-Unis estime que les cartes d'identité synthétiques constituent la grande majorité des cas d'usurpation d'identité[16]. Ces pertes se répercutent en fin de compte sur les portefeuilles des assurés honnêtes - chaque famille paie environ 700 euros de plus en primes chaque année en raison de l'augmentation de la charge de la fraude pour les assureurs.[15]. Les assureurs réagissent en renforçant les vérifications lors de l'accueil et des demandes d'indemnisation : ils mettent en œuvre des vérifications dans les bases de données pour établir des liens entre les identités, contrôlent les polices multiples à la même adresse et effectuent même des tests de "vivacité" (vérifications par vidéo selfie pour s'assurer que le demandeur est une personne réelle et non une simple image d'IA).[23][24]. Mais comme nous le verrons, les fraudeurs utilisent l'IA dans un autre domaine : les fausses voix et les fausses vidéos.

Voix et vidéos truquées (Deepfake Voices and Video Claims)

Généré par l'IA audio et vidéo deepfakes ajoutent une nouvelle dimension alarmante à la fraude à l'assurance. En 2023 et 2024, plusieurs incidents ont eu lieu au cours desquels des criminels ont utilisé des clonage de la voix pour usurper l'identité d'une personne au téléphone - une tactique initialement utilisée pour les cambriolages de banques (comme le fameux appel téléphonique du PDG deepfake qui a permis de voler $35 millions d'euros en 2020), mais qui se répand désormais dans le secteur des assurances. Les fraudeurs clonent les voix des assurés, des médecins ou des experts en sinistres et les utilisent dans des escroqueries d'ingénierie sociale. L'analyse de Pindrop pour 2024 prévient que "les deepfakes, la technologie de la voix synthétique et les escroqueries basées sur l'IA redessinent le paysage de la fraude"avec fraude vocale une mise à l'échelle à un rythme sans précédent[25]. Ils ont découvert que les centres d'appels des compagnies d'assurance étaient bombardés par des acteurs malveillants étrangers utilisant des imitations de voix : par exemple, des appels étaient reçus avec le numéro de sécurité sociale et les données personnelles volées d'un véritable assuré, et si un agent répondait, la voix de l'acteur malveillant était remplacée par celle de l'acteur malveillant. La voix clonée par l'IA de l'appelant pourrait tromper l'agent grâce à l'authentification basée sur les connaissances et demander un déboursement frauduleux[26]. Dans le cas d'un assureur de la côte ouest, les attaquants ont utilisé cette méthode à plusieurs reprises pour tenter de s'emparer de comptes et de rediriger les paiements, en exploitant le fait que la vérification de l'identité par le centre d'appel reposait sur la voix et des informations personnelles qui peuvent être usurpées.[26].

L'usurpation d'identité vocale a également été utilisée du côté des consommateurs : Des escrocs ont appelé des victimes d'accidents ou des bénéficiaires alors qu'ils étaient en train de se faire passer pour eux. se faire passer pour des représentants d'assuranceUn fraudeur peut aussi se faire passer pour un client, en utilisant des voix d'IA pour avoir l'air officiel, afin d'extorquer des informations sensibles ou même des paiements. À l'inverse, un fraudeur peut se faire passer pour un client sur une ligne d'assistance téléphonique en cas de sinistre pour déposer une demande d'indemnisation par téléphone en utilisant une fausse voix qui correspond au sexe ou à l'âge du clientcontournant ainsi les contrôles biométriques vocaux. Les statistiques récentes sur la fraude donnent à réfléchir : les experts du secteur prévoient une augmentation de 1,5 milliard d'euros par an. 162% Augmentation des attaques frauduleuses de type "deepfake" contre les assureurs au cours de l'année à venir[27]et Pindrop a enregistré un 475% : hausse des attaques par voix de synthèse en 2024 comme indiqué précédemment[2]. Ces attaques dépassent rapidement les vecteurs de cyberfraude plus traditionnels.

Au-delà des appels téléphoniques, les "deepfakes" basés sur la vidéo apparaissent dans le processus d'indemnisation. De nombreux assureurs ont adopté l'inspection virtuelle des sinistres et la vidéoconférence (accélérée par la pandémie) pour vérifier les pertes ou interroger les sinistrés à distance. Aujourd'hui, les fraudeurs l'utilisation d'avatars d'IA et de fausses vidéos pour tromper ces vérifications. Il a été rapporté que des demandeurs d'asile utilisaient des Avatars générés par l'IA lors d'appels vidéo en direct avec des experts, afin de se faire passer pour quelqu'un d'autre ou de dissimuler des signes d'incohérence[28]. Par exemple, un réseau de fraudeurs peut utiliser un deepfake vidéo "en direct" d'un demandeur supposé montrant ses dommages à l'aide d'un smartphonealors que la personne filmée est en fait un composite synthétisé par l'IA ou un acteur engagé portant des filtres qui modifient son visage. Un scénario spéculatif mais plausible consiste à utiliser un deepfake d'un décédé personne : Dans le cas d'une fraude à la rente ou à l'assurance-vie, un membre de la famille pourrait utiliser une fausse vidéo de la personne récemment décédée lors d'un appel de routine de preuve de vie afin de continuer à recevoir des paiements.[29]. Bien qu'aucune affaire de cette nature n'ait encore été rendue publique, les assureurs s'y préparent. Les régulateurs en prennent également note - des discussions sont en cours aux États-Unis et en Europe pour classer les "deepfakes" dans la catégorie des vols d'identité et mettre à jour les lignes directrices relatives à la vérification des preuves dans le domaine de l'assurance[30].

La détection des vidéos et des sons truqués est très difficile sans outils techniques. Les experts humains ne sont pas formés pour discerner les problèmes subtils de synchronisation des lèvres ou les bizarreries acoustiques. Toutefois, il y a eu des signaux d'alarme dans certains cas : par exemple, des clignements d'yeux non naturels ou des anomalies faciales sur une vidéo, ou encore des artefacts audio en arrière-plan lors d'un appel qui ont mis la puce à l'oreille des enquêteurs. Dans l'ensemble, La fausse fraude à l'assurance n'en est qu'à ses débutsEn 2023, les définitions juridiques n'étaient pas claires et il était difficile de prouver qu'une vidéo avait été générée par l'IA sans l'aide d'un expert.[31]. Cela donne aux fraudeurs un sentiment d'impunité. La course aux armements est lancée : les assureurs se tournent désormais vers les L'IA judiciaire pour lutter contre l'IALa Commission européenne a mis en place un système de détection des faux pour examiner les vidéos suspectes image par image afin d'y déceler des signes de manipulation.[24]. Les fournisseurs de solutions biométriques vocales mettent en place des détecteurs de fausses voix qui analysent les modèles spectraux et la cadence vocale pour en vérifier l'authenticité.[32]. Nous aborderons ces technologies défensives dans une section ultérieure.

Hameçonnage et usurpation d'identité renforcés par l'IA

Les fraudes fondées sur l'IA ne passent pas toutes par le service des réclamations ; certaines cibles sont les clients et les employés par le biais de l'ingénierie sociale. Courriels et textes d'hameçonnage conçus par l'IA sont devenus une menace majeure dans le domaine de l'assurance. Dans ces schémas, les fraudeurs utilisent des chatbots d'IA et des outils de traduction pour générer des communications frauduleuses très convaincantes. Par exemple, les criminels peuvent se faire passer pour la marque et le style d'écriture d'une compagnie d'assurance pour envoyer des courriels de phishing en masse aux assurés, en leur disant qu'une "action urgente est nécessaire pour éviter l'annulation de la police" et en les dirigeant vers un faux site web. Contrairement aux courriels d'escroquerie maladroits du passé, L'IA assure une grammaire impeccable et même une personnalisationce qui les rend beaucoup plus crédibles. Nous avons vu l'IA utilisée pour fouiller les médias sociaux à la recherche de détails qui sont intégrés dans des messages de spear-phishing, comme la mention d'un achat récent de voiture dans un faux avis d'assurance automobile.

Un autre vecteur est Usurpation d'identité d'agents ou de dirigeants assistée par l'IA. Dans certains cas, des escrocs ont imité la voix du propriétaire d'une agence d'assurance et ont laissé des messages vocaux à des clients pour leur demander de mettre à jour leurs informations bancaires, ce qui constitue en fait une attaque de phishing vocal. De même, la fraude interne peut découler de l'usurpation d'identité par l'IA : le service financier d'un assureur a failli être victime de fraudeurs qui lui ont envoyé un faux message audio. prétendument de la part du directeur général autoriser un transfert de fonds (une variante de la "fraude au PDG" désormais couverte par certaines polices d'assurance contre la cybercriminalité)[33]). Ces types d'escroqueries à l'usurpation d'identité pilotées par l'IA ont augmenté de 17% en 2023 selon Liberty Specialty Markets.[33]et devraient continuer à augmenter.

Les consommateurs sont également la cible d'escroqueries liées aux médias synthétiques liés à l'assurance. La Coalition contre la fraude à l'assurance signale des cas d'imposteurs se faisant passer pour des experts en sinistres, contactant les victimes d'accidents en prétendant qu'ils s'occupent de leur dossier, puis exiger un paiement immédiat ou des données sensibles[23]. Les clients peu méfiants, soulagés d'entendre un soi-disant représentant, peuvent s'exécuter, surtout si l'appelant connaît les détails de leur accident (que l'IA peut glaner en piratant des données ou en consultant des sources publiques). Le public est peu sensibilisé à ces tactiques ; c'est pourquoi les experts en prévention de la fraude invitent les assureurs à sensibiliser les assurés à la vérification de l'identité des appelants et des courriels[23][34]. Tout comme les banques mettent en garde leurs clients contre l'hameçonnage, les assureurs de 2025 commencent à inclure des avertissements contre les escroqueries de type "deepfake" dans leur communication.

L'utilisation de kits de "fraude en tant que service" facilement disponibles constitue le point commun de ces stratagèmes renforcés par l'IA[35]. Sur le dark web, les criminels peuvent acheter ou s'abonner à des outils qui fournissent des voix de deepfake préfabriquées, des modèles de faux documents, des générateurs d'emails de phishing, et bien plus encore. Cette démocratisation des outils d'IA signifie même des escrocs peu qualifiés peuvent lancer des attaques frauduleuses sophistiquées[35]. Pour les compagnies d'assurance, cela se traduit par un déluge de tentatives de fraude plus convaincantes provenant de tous les horizons - demandes d'indemnisation, service clientèle, courrier électronique, voire médias sociaux. Cela souligne la nécessité d'une stratégie de défense sur plusieurs fronts, combinant la technologie, la vigilance humaine et la collaboration intersectorielle.

Détection et défense : Une réponse alimentée par l'IA

La lutte contre la fraude induite par l'IA nécessite Défense pilotée par l'IA. Les assureurs se tournent de plus en plus vers des technologies de détection avancées et des processus réorganisés pour contrer cette attaque. Essentiellement, les assureurs doivent intégrer points de contrôle de l'authentification du contenu tout au long du cycle de vie de l'assurance - de la souscription aux sinistres en passant par les interactions avec les clients - pour détecter les falsifications de l'IA. La figure 2 présente une ventilation des principaux types de fraude rendus possibles par l'IA et leur prévalence, et les sections suivantes expliquent en détail comment détecter et décourager chacun d'entre eux.

Figure 2 : Types de fraudes à l'assurance renforcées par l'IA en 2025 (part estimée par système). Les fausses images (photos de dommages trafiquées) et les identités synthétiques figurent parmi les catégories les plus importantes, suivies par les documents falsifiés par l'IA (par exemple, les reçus, les certificats) et les escroqueries audio/vidéo de type "deepfake".

1. Outils de détection de contenu par l'IA : Les nouveaux services de détection de l'IA peuvent analyser le texte, les images, le son et la vidéo pour déterminer s'ils ont été générés par une machine ou manipulés. Par exemple, les assureurs peuvent s'appuyer sur des solutions telles que Détecteurs de textes et d'images AI de TruthScan qui utilisent l'IA précise 99%+ pour signaler les documents écrits par l'IA ou les photos trafiquées.[36]. Une compagnie d'assurance pourrait intégrer ces détecteurs dans son système de gestion des sinistres : lorsqu'un sinistre et ses preuves sont soumis, la description du texte peut être automatiquement analysée à la recherche de modèles de langage générés par l'IA, et toutes les images téléchargées peuvent être analysées à la recherche de signes révélateurs d'images de synthèse ou d'édition. Les outils d'entreprise peuvent identifier le texte généré par l'IA dans les documents, les courriels et les communications avec une précision de 99%[36]et de la même manière détecter les images générées ou manipulées par l'IA pour garantir l'authenticité du contenu visuel[36]. Cela signifie qu'un faux récit d'accident produit par ChatGPT ou une photo de dommages falsifiée en cours de route seraient signalés pour un examen manuel avant que la demande d'indemnisation ne soit traitée. En 2025, les assureurs adoptent de plus en plus ce type d'authentification du contenu par l'IA, 83% des professionnels de la lutte contre la fraude prévoient d'intégrer la détection générative de l'IA d'ici 2025.Selon une enquête de l'ACFE, 18% seulement l'utilisent aujourd'hui.[37][38].

2. Vérification de l'identité et contrôles biométriques : Pour lutter contre les identités synthétiques, les assureurs améliorent également les protocoles KYC grâce à l'IA. Les services de validation d'identité peuvent croiser les données des demandeurs avec plusieurs bases de données et utiliser la reconnaissance faciale avec des tests de vivacité. Par exemple, le fait d'exiger un court selfie vidéo lors de l'accueil (et d'utiliser la correspondance des visages avec la pièce d'identité fournie) peut contrecarrer de nombreuses identités synthétiques. Encore plus high-tech, des entreprises comme TruthScan offrent des services d'analyse d'images qui peuvent repérer les photos de profil, les avatars et les images de synthèse générés par l'IA - leur détecteur d'images IA est entraîné à identifier les visages créés par des générateurs tels que StyleGAN ou ThisPersonDoesNotExist[39]. En déployant de tels outils, un assureur peut détecter si le selfie d'un candidat à l'assurance vie n'est pas celui d'un vrai humain. Du côté de la voix, authentification biométrique vocale pour les appels au service clientèle peut être utile ; les détecteurs d'IA vocale modernes sont capables de identifier les voix synthétiques et les tentatives de clonage de voix en temps réel[40]. Par exemple, l'enquête TruthScan Détection de la voix par l'IA Le système utilise l'analyse acoustique pour reconnaître les voix générées par l'IA et les imitations audio avant qu'elles ne trompent le personnel du centre d'appels[40]. Ces solutions agissent comme un pare-feu - si quelqu'un appelle en prétendant être Jean Dupont et que son empreinte vocale ne correspond pas à la voix authentique de Jean Dupont (ou correspond à des caractéristiques connues de deepfake), l'appel peut être signalé ou une preuve d'identité supplémentaire peut être exigée. L'authentification multifactorielle (confirmation par courriel/SMS, codes de passe à usage unique, etc.) constitue un obstacle supplémentaire pour les usurpateurs d'identité.

3. Deepfake Video & Image Forensics : En ce qui concerne les preuves vidéo, les assureurs commencent à mettre en œuvre des analyses médico-légales spécialisées. Des logiciels avancés peuvent analyser les métadonnées vidéo, la cohérence des images et les niveaux d'erreur pour détecter les contrefaçons. Certains outils examinent les reflets, les ombres et les indices physiologiques (comme le pouls dans la gorge d'une personne sur une vidéo) pour s'assurer de l'authenticité d'une vidéo. L'analyse judiciaire des métadonnées est également utile : l'examen des métadonnées des fichiers et des empreintes de génération dans les images ou les PDF peut révéler si un élément a probablement été produit par un outil d'intelligence artificielle.[41]. Les assureurs devraient exiger des fichiers photo originaux (qui contiennent des métadonnées) plutôt que de simples captures d'écran ou des copies imprimées, par exemple. L'équipe de lutte contre la fraude de Zurich a constaté qu'elle parvenait à repérer les fausses images de voitures en remarquant les anomalies dans les métadonnées de l'image et l'analyse du niveau d'erreur.[41]. Détecteurs d'escroquerie par courriel peut également analyser les communications entrantes à la recherche de signes de contenu d'hameçonnage rédigé par l'IA ou de signatures malveillantes connues.[42]. De nombreux assureurs organisent désormais des simulations de phishing et des exemples d'escroquerie élaborés par l'IA dans le cadre de la formation de leurs employés afin de les sensibiliser à la question.

4. Changements de processus et formation des personnes : La technologie seule n'est pas une solution miracle. Amélioration des processus Des mesures sont prises, telles que des contrôles aléatoires plus fréquents en personne pour les sinistres de grande valeur, ou l'exigence de documents physiques dans certains cas. Certains assureurs ont retardé l'automatisation complète du traitement direct des demandes d'indemnisation, en réintroduisant un examen humain pour les demandes qui obtiennent un score élevé dans un modèle de risque de fraude par l'IA. Sur le plan humain, la formation est cruciale. Les enquêteurs et les experts en sinistres sont formés à reconnaître les signaux d'alerte de l'IA : par exemple, plusieurs demandes d'indemnisation utilisant un libellé identique (le "style" ChatGPT), des images dépourvues de véritable caractère aléatoire (par exemple, des motifs répétitifs dans ce qui devrait être des dommages organiques), ou des voix qui ressemblent à celles de la police. presque mais ont une cadence robotique. Les assureurs informent également leurs clients : ils envoient des alertes à la fraude sur les systèmes de "deepfake" et indiquent comment vérifier l'identité d'un représentant de l'assurance (par exemple, en fournissant un numéro de rappel connu).

5. Efforts de collaboration : La collaboration à l'échelle du secteur s'intensifie. Au Royaume-Uni, l'Insurance Fraud Bureau et l'Association of British Insurers ont formé des groupes de travail sur la fraude à l'IA. Charte sur la fraude à l'assurance (2024) favorise le partage des données et les initiatives communes[43]. À l'échelle mondiale, les assureurs établissent des partenariats avec des entreprises de cybersécurité et des startups spécialisées dans l'IA. Notamment, de nouveaux produits d'assurance apparaissent : Liberty Mutual a lancé un produit d'assurance une assurance contre la cybercriminalité pour les PME, qui couvre spécifiquement les escroqueries de type "deepfake" et les fraudes commises par les chefs d'entreprise[44][33]Ce risque est donc bien réel. Cela signifie également que les assureurs pourraient se retrouver à la fois victimes et solutionneurs de la fraude à l'IA - en payant pour une escroquerie de type "deepfake" si elle n'est pas détectée, mais aussi en offrant une couverture pour d'autres personnes victimes de telles attaques.

L'intégration de la technologie de détection dans les flux de travail peut être visualisée comme une défense multi-points dans le cycle de vie des réclamations. Comme le montre l'image Figure 3Les assureurs peuvent insérer des étapes de vérification de l'IA à application de la politique (pour détecter les identités synthétiques par la vérification des documents d'identité et des selfies), à l'adresse suivante soumission de la demande (pour analyser automatiquement les documents, les photos ou les fichiers audio téléchargés en vue d'une génération d'IA), au cours de examen de la demande/enquête (pour effectuer une analyse deepfake forensic sur les preuves suspectes et vérifier toute interaction vocale), et juste avant paiement (une dernière authentification de l'identité pour s'assurer que le bénéficiaire est légitime). En détectant la fraude à un stade précoce - idéalement au moment de l'intégration ou de la première déclaration de sinistre - les assureurs économisent des frais d'enquête et évitent les paiements injustifiés.

Figure 3 : Intégration des points de détection de l'IA dans le cycle de vie de l'assurance. Lors de l'adhésion à la police, la validation de l'identité basée sur l'IA vérifie la présence d'identités synthétiques ou falsifiées. Lorsqu'une demande d'indemnisation est soumise, des détecteurs automatisés analysent le texte, les documents et les images de la demande d'indemnisation à la recherche de contenu généré par l'IA. Lors de l'examen des demandes d'indemnisation, des outils spécialisés d'analyse des fausses identités et de la voix vérifient toute preuve audio/vidéo. Avant le paiement, la vérification biométrique de l'identité confirme l'identité du bénéficiaire. Cette approche multicouche permet d'intercepter la fraude à plusieurs stades.

Les assureurs n'ont pas besoin de développer toutes ces capacités en interne - beaucoup se tournent vers des solutions d'entreprise telles que Suite de détection de l'IA de TruthScanqui offre une gamme d'outils pouvant être intégrés par API dans les systèmes des assureurs. En voici un exemple, Service de détection d'images et de Deepfake par l'IA de TruthScan peut être utilisé pour vérifier l'authenticité des images et des vidéos avec une précision de plus de 99%[45]. Leur Détecteur de texte AI signale les textes rédigés par l'IA dans les réclamations ou les courriels[36], tandis que le Détecteur de voix AI détecte le clonage de la voix et vérifie le haut-parleur pour empêcher les imposteurs de téléphoner.[40]. Il existe même des outils de niche tels qu'un Détecteur de faux reçus pour analyser instantanément les factures/reçus afin d'y déceler des signes de falsification ou des polices/mises en page générées par l'IA[46] - extrêmement utile étant donné la prévalence de fausses factures de réparation dans les sinistres. En combinant ces outils, un assureur peut améliorer considérablement son taux de détection des fraudes. Un assureur de la liste Fortune 500 a déclaré avoir attrapé 97% de tentatives de deepfake en 2024 en utilisant une approche de filtrage par IA à plusieurs niveaux (texte, image, voix) et en évitant ainsi des pertes estimées à 20 millions d'euros.[47][48].

Conclusion

L'IA transforme le champ de bataille de la fraude à l'assurance à l'échelle mondiale. Les fraudeurs innovent avec l'IA générative pour créer des faussetés plus convaincantes que jamais, qu'il s'agisse de personnes ou d'accidents entièrement inventés ou d'usurpations d'identité qui peuvent tromper même des professionnels chevronnés. Les données de 2024-2025 montrent une croissance alarmante de ces stratagèmes alimentés par l'IA, mais elles soulignent également que les assureurs qui investissent dans la détection et la prévention peuvent garder une longueur d'avance. En combinant une technologie de détection de l'IA à la pointe du progrès - comme la criminalistique des images, l'authentification vocale et l'analyse de texte - grâce à des flux de travail actualisés et à la formation, le secteur peut atténuer les risques sans sacrifier les gains d'efficacité qu'apportent les processus numériques.

Au fond, il s'agit d'une course à l'armement technologique[49]. Comme l'a fait remarquer un expert en prévention de la fraude, "Dans cette nouvelle réalité, la vigilance est la prime à payer.[50]. Les compagnies d'assurance doivent promouvoir une culture de la vigilance et exploiter les meilleurs outils disponibles pour préserver la confiance dans le processus d'indemnisation. Cela signifie qu'il faut vérifier la véracité des documents, des voix et des images avec la même rigueur que celle utilisée par les souscripteurs pour évaluer les risques. Cela signifie également qu'il faut collaborer avec l'ensemble du secteur pour partager des informations sur les tactiques émergentes de fraude à l'IA et élaborer conjointement des normes (par exemple, des exigences normalisées en matière de métadonnées pour les médias soumis, ou des listes noires de fausses identités connues du secteur).

2025 est un point de basculement : les assureurs qui s'adapter de manière proactive à la fraude induite par l'IA Les assureurs les plus rapides protégeront leurs clients et leurs bilans, tandis que ceux qui tardent à réagir risquent d'être la cible d'escroqueries qui feront la une des journaux. La bonne nouvelle, c'est que la technologie nécessaire pour riposter existe et qu'elle évolue rapidement - l'IA qui donne du pouvoir aux fraudeurs peut aussi en donner aux assureurs. En mettant en œuvre des solutions telles que la suite de détection multimodale de l'IA de TruthScan pour les réclamations et la vérification de l'identité, les assureurs peuvent réduire considérablement le taux de réussite des tentatives de fraude générées par l'IA[51][52]. Ce faisant, ils évitent non seulement les pertes, mais envoient également un message clair aux fraudeurs potentiels : quelle que soit l'ingéniosité des outils, la fraude sera découverte.

En résumé, la fraude à l'assurance pilotée par l'IA est un défi formidable, mais qui peut être relevé par une défense tout aussi intelligente. Avec de la vigilance, une stratégie transversale et les bons partenaires technologiques, le secteur de l'assurance peut continuer à tenir la promesse fondamentale au cœur de son activité - ne payer que les sinistres légitimes, et le faire rapidement et en toute sécurité dans un monde de plus en plus numérique.

Références :

- Association des assureurs britanniques - Statistiques sur la fraude 2023[53][54]

- Allianz et Zurich s'inquiètent de la hausse des sinistres dus à l'IA - The Guardian, 2024[4][11]

- Facia.ai - "Deepfake Insurance Fraud : Comment l'IA réécrit les règles". Oct 2025[55][56]

- Coalition contre la fraude à l'assurance - Fraude synthétique à l'assurance (Quantexa), Déc. 2024[21][17]

- RGA - "La nouvelle frontière de la lutte contre la fraude : les identités synthétiques". Juin 2025[15][16]

- Pindrop - Rapport sur la fraude vocale, via FierceHealthcare, juin 2025[2][3]

- Les chiffres qui tournent - "Top Financial Fraud Schemes 2025," (Les principales fraudes financières en 2025) Oct 2025[1][57]

- TruthScan - Plateforme de détection de l'IA (aperçu des services), 2025[51][52]

- TruthScan - Page produit du détecteur d'images AI, 2025[45][39]

- TruthScan - Page produit du détecteur de voix AI, 2025[40]

- TruthScan - Page du produit Fake Receipt Detector, 2025[46]

- Liberty Specialty Markets - Communiqué de presse de l'assurance Deepfake/Cyber Fraud, Mars 2025[33]

- Facia.ai - Blog : Course aux armements pour la prévention de la fraude à l'assurance, 2025[24][32]

- Insurance Business UK - "Des images générées par l'IA utilisées pour la fraude automobile". Avril 2025[7][58]

- The Guardian - "Les fausses photos de dommages automobiles inquiètent les assureurs". mai 2024[9][12]

[1] [35] [57] 2025 Fraudes financières : Menaces et signaux d'alerte liés à l'IA

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] La fraude à l'assurance a augmenté de 19% en raison des attaques vocales en 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Des fraudeurs modifient des photos de véhicules pour y ajouter de faux dommages dans le cadre d'une escroquerie à l'assurance au Royaume-Uni | Insurance industry | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Les images générées par l'IA sont désormais utilisées pour la fraude à l'assurance automobile - rapport | Insurance Business UK

[13] [14] [15] [16] La nouvelle frontière de la lutte contre la fraude : les identités synthétiques et la course à l'armement de l'IA | RGA

[17] [18] [19] [20] [21] [22] JIFA : Fraude synthétique : Avec la fraude synthétique déjà présente dans leur écosystème, les assureurs doivent penser davantage comme les banques - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Fraude à l'assurance "Deepfake" : Comment l'IA réécrit les règles des réclamations d'assurance

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] La menace silencieuse : Pourquoi la fraude à l'assurance se déplace vers la ligne téléphonique

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] L'assurance contre la cybercriminalité pour les PME cible la fraude des PDG et les "deepfakes" - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Détection de l'IA en entreprise et sécurité du contenu

[37] Étude : 8 organismes de lutte contre la fraude sur 10 prévoient de déployer l'IA générative d'ici 2025

[38] Aperçu du rapport d'évaluation comparative des technologies anti-fraude pour 2024

[39] [45] Détecteur d'images AI - Repérer les photos truquées et manipulées - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] Détecteur de voix AI pour les Deepfakes et le clonage vocal | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Fake Receipt Detector | Vérifier l'authenticité des reçus

https://truthscan.com/fake-receipt-detector

[47] L'assureur Fortune 500 détecte 97% de Deepfakes et arrête les ...