Introduction

L'IA générative est en train de révolutionner les soins de santé - et pas toujours pour le mieux. En 2025, les fraudes aux soins de santé ont augmenté de plus numérique et sophistiquée, alimentée par les violations de données, l'automatisation et l'IA générative.[1]. Les criminels exploitent les outils d'IA pour créer des fausses identités de patients, demandes d'assurance synthétiques, documents médicaux générés par l'IA, fausses ordonnances et même interactions médecin-patient truquées en profondeur.. Ces tromperies de haute technologie portent la fraude à de nouveaux sommets, menaçant les finances des assureurs et la sécurité des patients dans le monde entier. Le défi est de taille : la fraude dans le secteur de la santé coûte déjà des dizaines de milliards par an, et l'essor de l'IA est en train d'enrayer le phénomène. intensifiant à la fois l'échelle et la complexité d'escroqueries[2][3]. Ce livre blanc présente en détail les dernières tendances en matière de fraude liée à l'IA dans le secteur de la santé, des cas concrets datant de 2025 et des stratégies - des détecteurs de contenu d'IA à la vérification de l'identité - pour lutter contre cette menace en constante évolution.

La montée en puissance des fraudes à l'IA dans le secteur de la santé

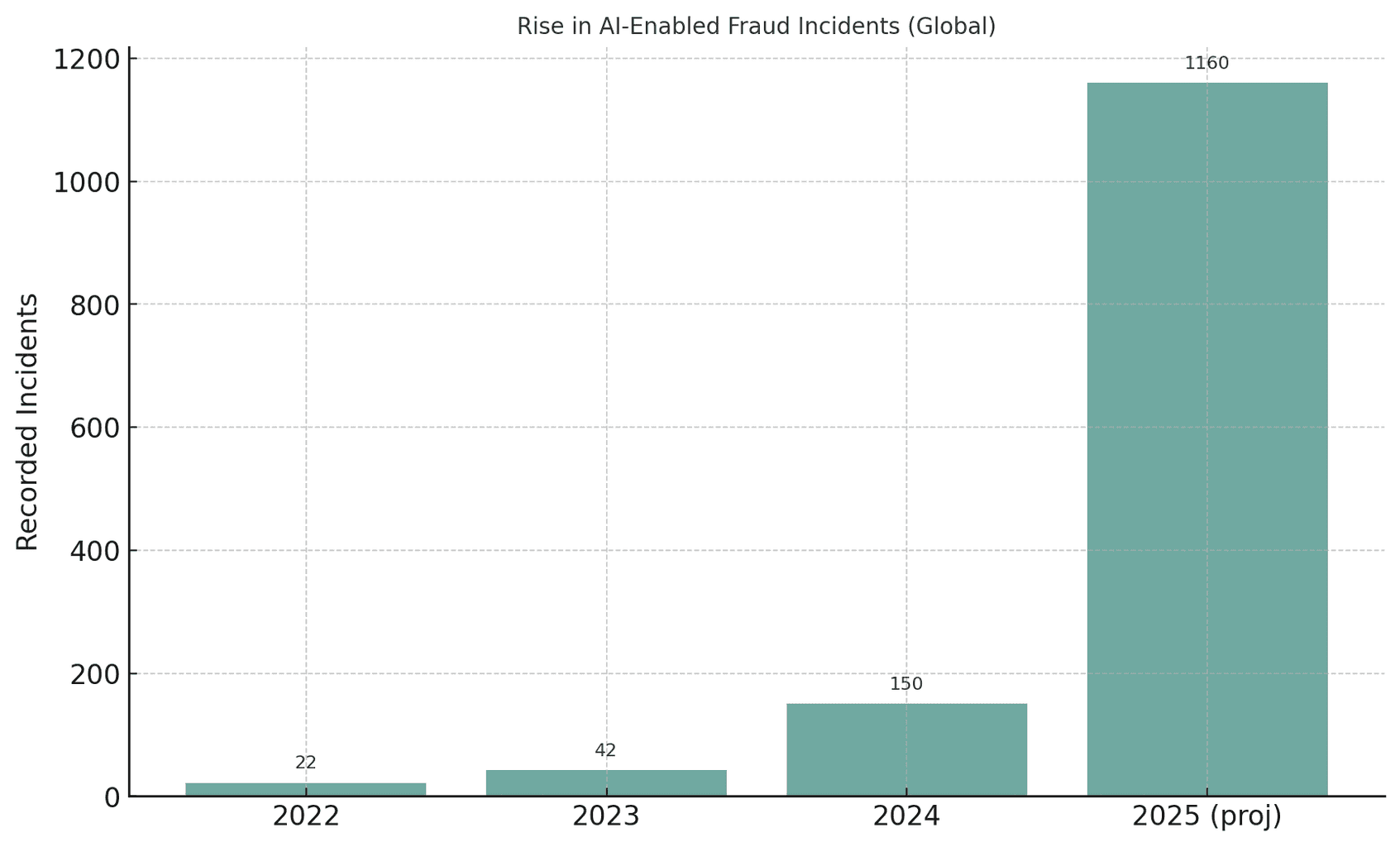

Le secteur mondial des soins de santé connaît une pic sans précédent des tentatives de fraude par l'IA.. À mesure que l'IA générative devient accessible, les fraudeurs peuvent automatiser ce qui était auparavant des escroqueries manuelles, en produisant à grande échelle de fausses identités, de faux documents et même de fausses voix ou de fausses vidéos convaincantes. Par exemple, les autorités ont noté que les tentatives de fraude impliquant des deepfake media ont augmenté de 3 000% en 2023 seul[4][5]. Les incidents liés aux deepfakes ont presque doublé, passant de 22 en 2022 à 42 en 2023, puis ont explosé pour atteindre 150 incidents en 2024 ; étonnamment, le premier trimestre 2025 a vu 179 cas de fraude par deepfake - dépassant déjà le total de 2024[6][7]. Cette tendance suggère une la croissance fulgurante de la fraude induite par l'IALes analystes prévoient que l'IA générative pourrait faire passer les pertes dues à la fraude de 1,5 milliard d'euros à 1,5 milliard d'euros. $12,3 milliards en 2023 à $40 milliards en 2027 (32% CAGR)[8].

Figure : La croissance explosive des incidents de fraude assistée par l'IA au cours des dernières années. Les cas détectés de deepfake ou de fraude assistée par l'IA ont augmenté de façon spectaculaire entre 2022 et 2025, illustrant la façon dont les outils d'IA générative ont amplifié les tentatives d'escroquerie.[4][7].

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

Le secteur de la santé est particulièrement vulnérable à cette vague de criminalité alimentée par l'IA. L'écosystème vaste et fragmenté du secteur - qui englobe les hôpitaux, les cliniques, les assureurs, les pharmacies et les plateformes de télésanté - offre des milliers de points d'attaque[9][10]. Les escroqueries traditionnelles (par exemple, les fausses cartes d'assurance ou les cartes d'identité de patients volées) ont a évolué vers une exploitation systémique utiliser l'IA[10][11]. Lors d'un démantèlement aux États-Unis en 2025, le ministère de la Justice a inculpé 324 personnes pour des combines d'un montant total de $14,6 milliards en fausses déclarations - la plus grande affaire de fraude dans le domaine des soins de santé jamais réalisée[12][13]. De nombreuses escroqueries concernaient des consultations de télémédecine et des tests génétiques frauduleux. Centre de fusion des données sur la fraude aux soins de santé a utilisé l'analyse de l'IA pour détecter de manière proactive des modèles[14][15]. Il est clair que l'IA est une arme à double tranchant : elle aide les enquêteurs à attraper les fraudes, mais elle est aussi une arme à double tranchant. permettant aux criminels de perpétrer des fraudes d'une ampleur et d'une sophistication sans précédent[11][2].

Techniques courantes de fraude par l'IA dans le secteur de la santé (2025)

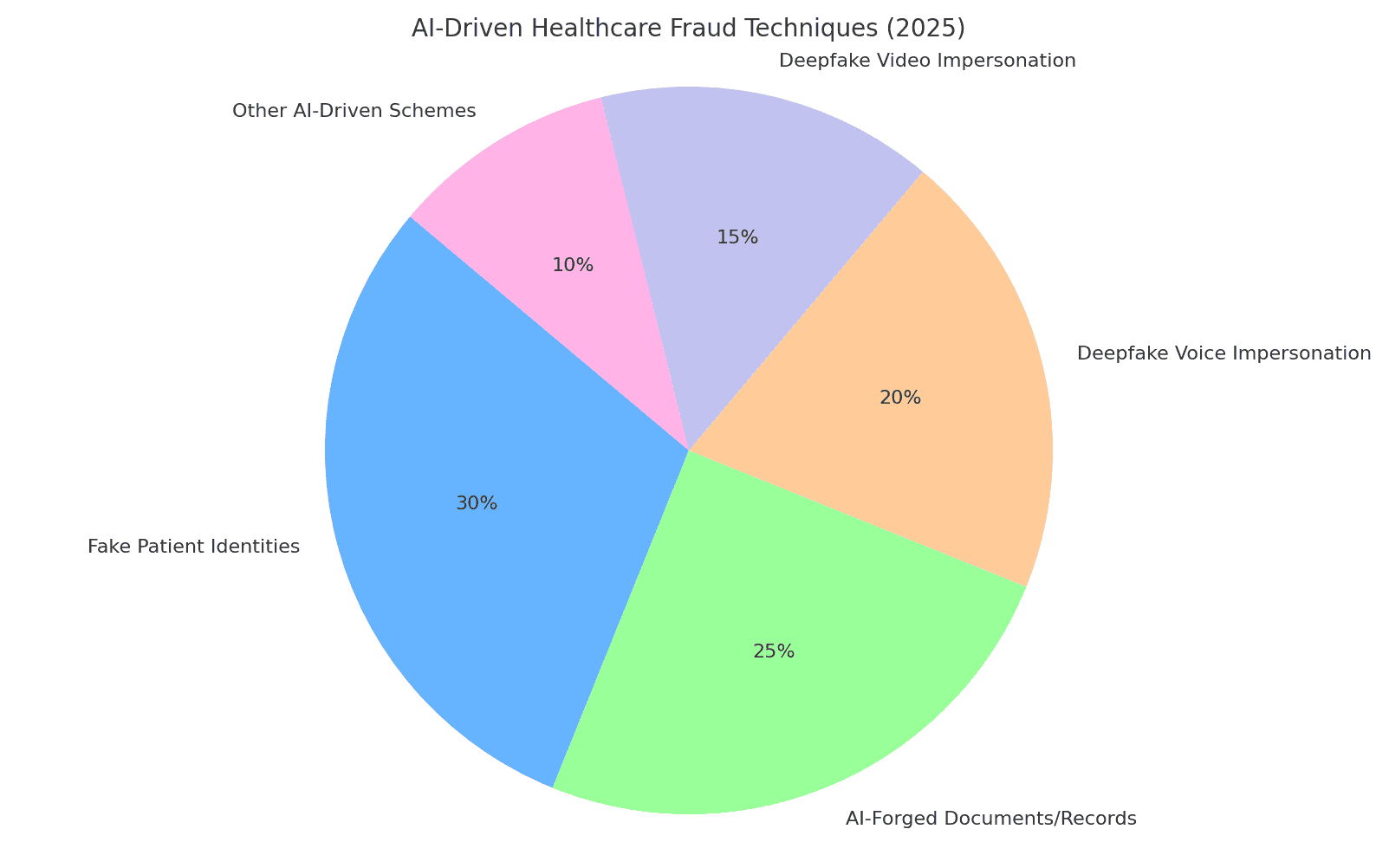

En 2025, les fraudeurs disposent d'une boîte à outils de tactiques fondées sur l'IA pour escroquer les systèmes de santé et les assureurs. Les principaux stratagèmes comprennent la falsification d'identités et de documents, la production de fausses données médicales et l'usurpation de l'identité de personnes de confiance par le biais de " deepfakes ". Nous présentons ci-dessous les techniques de fraude les plus courantes basées sur l'IA et la manière dont elles sont utilisées contre les organismes de santé :

Figure : Répartition des principales techniques de fraude aux soins de santé pilotées par l'IA en 2025. Fausses identités de patients et Documents falsifiés par l'IA (par exemple, les dossiers médicaux, les demandes d'indemnisation) constituent une grande partie des systèmes, tandis que les deepfake voix et imitations vidéo constituent une menace en pleine expansion. Les "autres stratagèmes pilotés par l'IA" comprennent les courriels d'hameçonnage conçus par l'IA, les robots qui attaquent les portails des patients et d'autres exploits similaires (pourcentages estimés sur la base de rapports de l'industrie).[8][16]).

Identités synthétiques des patients

Fausses identités de patients - souvent créées avec l'aide de l'IA - sont une tactique de fraude fondamentale. Au lieu d'usurper l'identité d'une personne, les criminels combinent les données réelles de plusieurs personnes avec des détails fabriqués de toutes pièces pour créer une identité. identités synthétiques qui se font passer pour de nouveaux patients[17][18]. L'IA générative accélère ce processus en produisant des dossiers personnels réalistes. Par exemple, l'IA peut générer des Identifications, profils, voire historiques familiaux ("parents synthétiques") pour un faux patient[19][20]. Ces patients fantômes sont ensuite utilisés pour ouvrir des comptes, obtenir des polices d'assurance ou facturer des services qui n'ont jamais eu lieu. Pendant la pandémie de COVID-19, les fraudeurs ont utilisé des cartes d'identité synthétiques pour obtenir des prestations de santé d'urgence ; aujourd'hui, ils les utilisent pour déposer de fausses demandes d'assurance ou obtenir des ordonnancesLe fait de savoir qu'une identité bien conçue peut échapper à la détection[21][22]. Selon la Réserve fédérale américaine, les pertes dues à la fraude à l'identité synthétique s'élèvent à $35 milliards en 2023 et continuent d'augmenter[23]. L'impact sur les soins de santé est grave : les escrocs peuvent utiliser le numéro de sécurité sociale volé d'un enfant pour créer un faux patient avec un crédit parfait, ou mélanger des données de patients volées pour contourner la vérification de l'assureur[17][24]. Chaque patient synthétique introduit dans le système compromet l'intégrité des données et peut conduire à des paiements injustifiés ou même des erreurs cliniques si la fausse identité est mêlée aux vrais dossiers médicaux.

Documents médicaux et demandes d'indemnisation générés par l'IA

L'IA générative est aujourd'hui utilisée pour forger des les documents médicaux, les dossiers et l'ensemble des demandes d'indemnisation. Les modèles de langage peuvent produire des notes de médecin, des résumés de sortie, des résultats de laboratoire ou des relevés de facturation remplis de jargon médical d'apparence authentique, tous conçus pour étayer une demande de remboursement frauduleuse. En fait, les observateurs du secteur font état d'une 89% Augmentation des documents médicaux générés par l'IA par rapport aux années précédentes[25][26]. Les escrocs utilisent ces faux dossiers pour justifier des procédures coûteuses ou des médicaments qui n'ont jamais été fournis, ou pour gonfler les codes de remboursement. Par exemple, une IA pourrait générer un faux dossier de rapport d'imagerie diagnostique ou résultat de laboratoire pour justifier une demande de remboursement de médicaments oncologiques très coûteux. Les assureurs et les systèmes de santé sont confrontés à un afflux de demandes de remboursement de médicaments oncologiques. papier synthétiqueIl est donc plus difficile de distinguer les demandes légitimes des fausses. Au Royaume-Uni, les assureurs constatent une augmentation de la fréquence des demandes d'indemnisation. l'utilisation de plus en plus fréquente de faux documents et de documents falsifiés dans le cadre de la fraude aux réclamationssouvent dans des réclamations apparemment routinières et de faible valeur afin d'éviter un examen minutieux[27]. Même l'imagerie clinique n'est pas à l'abri. Les fraudeurs utilisent l'IA générative pour imiter les images médicales comme les radiographies ou les scanners[3]. Les conséquences vont au-delà des pertes financières : si des dossiers médicaux falsifiés sont introduits dans les dossiers des patients, ils peuvent conduire à des diagnostics erronés ou à des traitements inappropriés. C'est pourquoi, Les documents de santé rédigés par l'IA présentent un risque sérieux pour l'intégrité et la sécurité.

Fausses ordonnances et fraude à la pharmacie

La fraude aux ordonnances est entrée dans l'ère numérique grâce à l'IA. Fausses ordonnances - traditionnellement réalisées avec des carnets de prescription volés ou une édition rudimentaire - peuvent désormais être générées automatiquement avec des détails réalistes et des signatures de médecins. Les générateurs d'images AI ou les modèles facilitent la création d'ordonnances. des imprimés d'ordonnances électroniques d'apparence authentique ou les bons de commande des pharmacies. Plus insidieusement, les criminels utilisent clonage de la voix pour se faire passer pour des médecins lors d'appels avec des pharmaciens. Dans une tendance signalée, des escrocs ont piraté des dossiers médicaux pour voler les numéros d'enregistrement des médecins auprès de la DEA et ont ensuite utilisé ces informations d'identification pour envoyer des ordonnances électroniques pour des substances contrôlées.[28]. Il y a eu des cas de Fausses voix d'IA utilisées pour autoriser les recharges - un pharmacien reçoit un appel qui ressemble à s'y méprendre à celui d'un médecin confirmant une ordonnance, mais il s'agit en fait d'une voix générée par l'IA. En conséquence, des médicaments contrôlés (comme les opioïdes ou les stimulants) peuvent être obtenus illégalement et détournés. La fraude aux fausses ordonnances n'entraîne pas seulement des pertes financières pour les assureurs et les pharmacies ; elle met aussi en danger les patients, qui peuvent recevoir des médicaments erronés dans leur dossier. Par exemple, si un fraudeur se fait passer pour un patient afin d'obtenir des ordonnances d'opioïdes, la le dossier médical d'un vrai patient peut être mis à jour avec des médicaments qu'il n'a jamais pris, ce qui entraîne des interactions dangereuses ou le signale comme étant à la recherche de médicaments.[29]. Ce mélange de cybercriminalité et d'exploitation de l'IA a suscité des mises en garde de la part des régulateurs. Les organismes de santé doivent désormais vérifier que chaque ordonnance - en particulier les médicaments à haut risque - est légitime et qu'elle n'a pas été falsifiée. provenant réellement du fournisseur autoriséIl ne s'agit pas d'un deepfake ou d'une violation de données.

Fausses imitations de médecins et de patients par Deepfake

L'évolution la plus marquante est sans doute l'utilisation de la technologie les "deepfakes" visant à usurper l'identité du personnel de santé ou des patients. Dans le cadre de la télémédecine et du service à la clientèle, les escrocs utilisent des vidéos et des sons générés par l'IA pour tromper les personnes à l'autre bout du fil. Par exemple, les criminels ont créé des Vidéos fictives de patients pour des consultations de télésanté, en incitant les médecins à fournir des "traitements" ou des références qui sont ensuite facturés à l'assurance.[30][31]. À l'inverse, un escroc peut usurper l'identité d'un médecin - en utilisant le visage et la voix d'un médecin réputé - lors d'un appel vidéo pour convaincre un patient de payer un service frauduleux ou de divulguer des informations personnelles. Les experts en informatique de santé mettent en garde contre la télésanté est devenue une cible toute désignéeLe système d'information sur les médicaments : il est possible de prendre un rendez-vous virtuel en utilisant une fausse identité de patient, puis de faire intervenir un avatar d'IA sur la vidéo pour obtenir des ordonnances ou des conseils médicaux sous de faux prétextes.[31][32]. Au-delà de la télémédecine, les deepfakes saturent les médias sociaux sous la forme de Vidéos de "médecins" vantant les mérites de remèdes miracles. En 2024, des experts ont observé que des vidéos truquées de médecins célèbres "a vraiment décolléLa Commission européenne a lancé une campagne de sensibilisation à l'égard des personnes âgées en leur donnant de faux conseils en matière de santé et en leur proposant des produits frauduleux.[33][34]. Des médecins de confiance de la télévision britannique et française ont vu leur image clonée pour promouvoir de faux remèdes contre le diabète et des suppléments pour la tension artérielle.[35][36]. Près de la moitié des téléspectateurs n'ont pas pu deviner que ces vidéos médicales "deepfake" étaient fausses.[37]. Cette érosion de la vérité a des coûts tangibles : des patients peuvent suivre les conseils néfastes d'une fausse vidéo de médecin, ou des escrocs peuvent facturer aux assureurs des consultations qui n'ont jamais eu lieu, si ce n'est sous la forme d'un faux enregistrement. Au total, L'usurpation d'identité pilotée par l'IA sape la confiance fondamentale dans les interactions en matière de soins de santé - si l'on ne peut pas s'assurer que la personne à l'écran ou au téléphone est bien celle qu'elle prétend être, c'est tout le système qui est en danger.

Impact et ampleur : la fraude de 2025 en chiffres

La fraude induite par l'IA n'est plus une question marginale - c'est désormais un gouffre financier majeur et une menace pour la sécurité dans les systèmes de santé mondiaux. Les statistiques et les cas récents suivants illustrent le problème de la fraude à l'aide de l'IA. l'ampleur du problème:

- Pertes annuelles : On estime que la fraude dans le domaine de la santé coûte aux États-Unis environ $68 milliards d'euros ou plus chaque année[25], en gros 3-10% de toutes les dépenses de santé[38]. Au niveau mondial, la fraude pourrait consommer environ 6% de dépenses de santé[39] - un chiffre stupéfiant si l'on considère que les dépenses de santé dans le monde s'élèvent à des milliers de milliards de dollars. Ces pertes se traduisent en fin de compte par des primes plus élevées, une augmentation des frais d'hospitalisation et une réduction des ressources consacrées aux soins des patients.

- La montée en puissance de la fraude en 2023-2025 : L'avènement de l'IA générative a entraîné une explosion des tentatives de fraude. Les incidents de fraude liés à Deepfake ont augmenté de décuplée entre 2022 et 2023[4]. En 2024, les incidents de deepfake signalés sont passés à 150 (soit une augmentation de 257%).[40]et l'année 2025 est en passe de dépasser largement ce chiffre (580 incidents au cours du seul premier semestre 2025, soit près de 4 fois le total de 2024).[7]. Les experts en matière de fraude notent que 46% ont été confrontés à des fraudes à la carte d'identité synthétique, 37% à des fraudes vocales et 29% à des fraudes vidéo. dans leurs enquêtes[8] - soulignant à quel point ces techniques d'intelligence artificielle sont devenues courantes.

- Takedowns record : Les agences chargées de l'application de la loi réagissent en prenant des mesures de répression plus importantes. En juin 2025, le ministère de la justice des États-Unis a annoncé la mise en place d'un programme de lutte contre le blanchiment d'argent. le plus grand démantèlement de fraude aux soins de santé de l'histoireL'enquête a permis d'inculper 324 personnes et de mettre au jour $14,6 milliards dans les demandes frauduleuses[1][13]. Il s'agit notamment d'escroqueries aux consultations de télésanté, de fraudes aux tests génétiques et d'escroqueries massives à l'équipement médical durable[13]. Dans le cadre de cet effort, Medicare a suspendu $4 milliards d'euros de paiements en attente jugée suspecte[41]La Commission a donc décidé de mettre en place un système d'alerte et de prévention de ces pertes. L'une des principales affaires ("Operation Gold Rush") a révélé l'existence d'un réseau international utilisant des identités volées pour déposer des demandes d'indemnisation. $10,6 milliards d'euros de fausses demandes de remboursement de fournitures médicales[42] - ce qui prouve que les criminels sont prêts à aller très loin lorsqu'ils sont armés d'un système d'automatisation et d'informations provenant d'une intrusion.

- Impacts sur les assureurs : Les assureurs du monde entier constatent une La montée en puissance de la fraude liée à l'IA. Au Royaume-Uni, les assureurs signalent que les deepfakes sont de plus en plus utilisés dans les sinistres (souvent des sinistres "low touch" pour éviter la détection).[27]. Un grand cabinet de réassurance met en garde contre les falsifications de dossiers médicaux et les faux problèmes de santé qui minent la tarification et pourraient faire augmenter les pertes des assurances vie et maladie.[43]. Une analyse de Deloitte réalisée en 2024 prévoit que d'ici 2027, La fraude générative par l'IA pourrait représenter $40 milliards de pertes annuelles aux États-Unis. (contre $12,3 milliards en 2023)[8]. Cette trajectoire implique un impact significatif sur les résultats des assureurs si des contre-mesures robustes ne sont pas adoptées.

- Les patients victimes : Les patients et le public perdent également de l'argent à cause de ces escroqueries. Les personnes âgées, en particulier, ont été la cible d'escroqueries à la voix d'IA (appels téléphoniques "petit-enfant en détresse") et d'escroqueries à la santé de type "deepfake". En 2023, les personnes âgées américaines ont déclaré $3.4 milliards de pertes dues à la fraude, soit une augmentation de 11% par rapport à l'année précédente[44][45] - en partie grâce à des systèmes améliorés par l'intelligence artificielle. Et au-delà du coût monétaire, il y a une coût humainLes conseils médicaux frauduleux et les faux traitements annoncés par l'IA peuvent entraîner des dommages physiques ou une perte de confiance dans les conseils légitimes en matière de soins de santé.

Dans l'ensemble, 2025 a clairement indiqué que L'IA met un coup d'accélérateur à la fraude traditionnelle en matière de soins de santé. Ce qui n'était auparavant que de petits projets opportunistes s'est transformé en opérations industrialisées s'étendant sur plusieurs continents. La combinaison des données de grande taille (souvent issues de brèches) et de la génération d'IA signifie que les escroqueries peuvent être déployées avec une rapidité et une plausibilité effrayantes. Les pertes globales se chiffrent en dizaines de milliards et sont en augmentationLe secteur de la santé est en danger, et toutes les parties prenantes, des hôpitaux aux patients en passant par les assureurs, sont menacées. La section suivante examine comment le secteur peut riposter en utilisant des technologies et des stratégies tout aussi avancées.

Se défendre contre la fraude induite par l'IA : Stratégies et solutions

La lutte contre la fraude dans le secteur de la santé basée sur l'IA nécessite un arsenal de défenses tout aussi avancées. Les responsables des soins de santé, les équipes de cybersécurité, les responsables de la conformité et les assureurs doivent se coordonner pour intégrer des mesures anti-fraude à chaque point vulnérable - de l'accueil du patient au paiement des indemnités. Vous trouverez ci-dessous des stratégies clés et des solutions techniques pour contrer la fraude induite par l'IA :

- Outils de détection de contenu par l'IA : Tout comme les criminels utilisent l'IA pour fabriquer du contenu, les organisations peuvent utiliser l'IA pour le détecter. Avancée Détecteurs de contenu rédigé par l'IA (comme la suite de TruthScan) analysent le texte, les images, le son et la vidéo pour identifier les signes révélateurs de la génération d'IA. Par exemple, la plateforme de TruthScan applique l'apprentissage automatique pour repérer les modèles statistiques et les bizarreries linguistiques qui indiquent un texte généré par l'IA, avec plus de 99% précision[46][47]. Ces outils peuvent être intégrés dans les systèmes de gestion des demandes d'indemnisation ou dans les dossiers médicaux électroniques afin de signaler automatiquement les cas d'urgence. documents suspects - par exemple, un rapport médical probablement rédigé par ChatGPT - en vue d'un examen manuel. De même, l'IA d'analyse d'images peut détecter des scans médicaux manipulés ou de fausses cartes d'identité, et les algorithmes de détection de faux peuvent analyser des vidéos pour y déceler des signes de synthèse (artefacts dans les pixels, synchronisation inhabituelle des mouvements du visage, etc.)[48][49]. En déployant des détecteurs d'IA multimodaux, les organismes de santé peuvent éliminer en temps réel une grande partie du contenu forgé par l'IA avant qu'il ne cause des dommages.

- Vérification des dossiers médicaux et des documents : Les prestataires de soins de santé se tournent vers des solutions spécialisées pour vérifier l'authenticité des dossiers et des documents relatifs aux demandes d'indemnisation. Il s'agit notamment de hacher et de signer numériquement les enregistrements légitimes, ainsi que d'utiliser des bases de données de modèles de documents connus pour les comparer aux soumissions. Les services de vérification pilotés par l'IA (par exemple, TruthScan's Authentification des documents médicaux ) permet d'analyser instantanément le contenu et les métadonnées d'un document afin de déterminer s'il a été généré ou modifié par une machine.[50][51]. Ils recherchent les incohérences qui pourraient échapper à un être humain, telles que de subtiles anomalies de formatage ou des métadonnées indiquant qu'une image a été produite par l'IA. Suivi en temps réel des dossiers des patients et des demandes d'indemnisation la recherche d'anomalies est également essentielle[52]. En analysant en permanence les nouvelles entrées (résultats de laboratoire, notes de médecin, pièces jointes aux demandes de remboursement), ces systèmes peuvent détecter les faux dossiers avant ils conduisent à des paiements frauduleux ou à des erreurs cliniques. Certains assureurs ont mis en place des règles selon lesquelles tout document relatif à une demande de remboursement identifié comme étant généré par l'IA est automatiquement retiré en vue d'une enquête sur les fraudes. L'objectif est de s'assurer que chaque dossier médical ou demande qui entre dans le flux de travail est fiable et n'a pas été modifié.

- Preuve et validation de l'identité : Le renforcement de la vérification de l'identité est essentiel à l'ère des cartes d'identité synthétiques. Les organismes de santé doivent appliquer une vérification rigoureuse de l'identité des nouveaux patients, des fournisseurs et des vendeurs. Il peut s'agir d'une authentification multifactorielle, de contrôles biométriques (comme la reconnaissance faciale ou les empreintes digitales lors de l'inscription) et de l'utilisation de services de vérification de l'identité qui exploitent l'intelligence artificielle pour détecter les éléments suivants fausses cartes d'identité ou données personnelles non concordantes. Par exemple, la reconnaissance faciale peut être associée à des tests de vivacité afin d'éviter qu'un visage généré par l'IA ne se fasse passer pour un vrai patient par le biais d'une photo. En aval, les algorithmes peuvent procéder à une vérification croisée des données d'un patient (adresse, téléphone, courriel, présence sur les médias sociaux) afin de repérer les identités "minces" qui n'ont pas d'antécédents normaux - un indice connu de l'existence d'identités synthétiques.[53]. Les institutions financières ont utilisé ces contrôles de cohérence des antécédents pilotés par l'IA avec beaucoup d'efficacité[54]Les services de santé peuvent faire de même : par exemple, signaler un nouveau demandeur d'assurance maladie s'il n'a pas d'empreinte numérique antérieure à cette année. Validation des identités des fournisseurs est tout aussi important : il s'agit de s'assurer que le médecin qui apparaît sur une vidéo de télésanté est agréé et qu'il est bien celui qu'il prétend être, peut-être en émettant des certificats numériques ou des flux vidéo en filigrane difficiles à imiter par des "deepfakes". Dans les pharmacies, le personnel doit revérifier les demandes de prescription inhabituelles en rappelant directement les fournisseurs et en utilisant des phrases codées ou des questions de vérification pour déjouer les imposteurs vocaux de l'IA.

- Détection intégrée des fraudes dans les flux de travail : Pour protéger véritablement le système, la détection de la fraude ne peut pas être une étape isolée - elle doit être intégrée dans le système. intégré dans chaque flux de travail dans un organisme de santé.

En pratique, cela signifie que les hôpitaux et les assureurs déploient des intégrations API pour appeler des services de détection de la fraude à des moments critiques. Par exemple, lorsqu'un prestataire soumet une demande de remboursement avec des documents joints, un service d'IA peut automatiquement évaluer l'authenticité de ces pièces jointes en quelques secondes. Si un rendez-vous de télésanté est initié, la plateforme pourrait effectuer une analyse de la voix passive en arrière-plan pour s'assurer que l'appelant n'utilise pas une voix synthétisée. Contrôle continu Les plateformes modernes de lutte contre la fraude offrent des tableaux de bord qui suivent les signaux de fraude dans l'ensemble de l'organisation (validations échouées, signalements fréquents des demandes d'une certaine clinique, etc.) afin d'identifier des schémas, tels qu'un réseau de fraude organisé opérant sur plusieurs demandes. En traitant la fraude dans le secteur de la santé comme des cybermenaces - avec des Surveillance 24 heures sur 24, 7 jours sur 7, détection des anomalies et réaction rapide en cas d'incident - les organisations peuvent détecter les problèmes avant qu'ils ne s'aggravent[55].

- L'IA pour l'analyse des fraudes et la reconnaissance des formes : Le volume de données sur les soins de santé est si important que l'IA est indispensable pour trouver des schémas de fraude qui échappent aux humains. Des modèles d'apprentissage automatique peuvent être formés sur des cas de fraude historiques pour en détecter de nouveaux (par exemple, en regroupant les demandes de remboursement qui présentent des codes CIM inhabituels similaires, ou en identifiant les cas où la facturation d'un médecin s'écarte considérablement de celle de ses pairs). Les assureurs utilisent déjà l'analyse prédictive pour évaluer les demandes d'indemnisation en fonction du risque de fraude en temps réel. Des techniques émergentes telles que les réseaux neuronaux graphiques peuvent cartographier les relations entre les patients, les prestataires, les diagnostics et les demandes d'indemnisation afin de repérer les connexions improbables (telles que le même numéro de série d'appareil utilisé dans des demandes d'indemnisation provenant de différents États). La suite de TruthScan pour la fraude à l'assurance, par exemple, comprend les éléments suivants reconnaissance des modèles de réclamations et la modélisation prédictive pour détecter les réseaux de fraude organisés et les schémas atypiques avant que les pertes ne s'accumulent[56][57]. Le centre de fusion du ministère de la justice (2025) a illustré cette approche en regroupant les données relatives à Medicare et aux assureurs privés afin de repérer de manière proactive les groupes d'activités suspectes.[58]. Les organismes de santé devraient également partager les données et les modèles d'IA dans des consortiums afin d'élargir les signaux de fraude qu'ils peuvent détecter. Plus ces modèles seront alimentés en données (dans le respect de la vie privée), plus ils seront à même de discerner les comportements normaux des comportements frauduleux.

- Formation du personnel et contrôle des processus : La technologie est cruciale, mais la conscience humaine reste un puissant moyen de défense. Le personnel et les administrateurs du secteur de la santé doivent être formés aux tactiques de fraude basées sur l'intelligence artificielle - par exemple, savoir qu'un patient peut être victime d'une fraude. Un courriel parfaitement rédigé par un PDG peut être un hameçonnage créé par l'IAou qu'ils devraient vérifier l'identité des appelants vidéo si quelque chose semble "bizarre" (des mouvements oculaires étranges ou un décalage audio peuvent indiquer un deepfake). Des exercices et des conseils réguliers (semblables à une formation de sensibilisation au phishing) peuvent être mis en œuvre pour les nouvelles menaces telles que les escroqueries téléphoniques de type "deepfake". De simples contrôles de processus ajoutent des couches de sécurité : exiger des rappels ou une vérification secondaire pour les demandes de paiement importantes ou inhabituelles, utiliser des canaux de communication connus et sûrs pour les informations sensibles, et maintenir un plan de réponse aux incidents spécifiquement pour les suspicions de fraude médiée par l'IA. Il est important que les organisations cultivent une culture dans laquelle les employés se sentent habilités à remettre en question les anomaliesMême s'il s'agit d'un "médecin" sur vidéo qui demande une requête étrange. De nombreuses escroqueries de type "deepfake" réussissent en exploitant la confiance et l'autorité ; une main-d'œuvre vigilante qui connaît ces astuces peut stopper les incidents à temps. Comme l'a fait remarquer un expert, la lutte contre les "deepfakes" pourrait devenir aussi routinière que le repérage des courriels d'hameçonnage, qui fait partie intégrante de l'hygiène en matière de cybersécurité.[32][59].

- Tirer parti des services spécialisés : Compte tenu de l'évolution rapide des menaces liées à l'IA, de nombreux organismes de santé s'associent à des prestataires spécialisés dans la prévention des fraudes. Des services tels que TruthScan pour les soins de santé offrent des solutions de bout en bout adaptées aux cas d'utilisation médicale, notamment : le contrôle en temps réel de l'intégrité des dossiers médicaux électroniques (DME), vérification des documents du patient contre la manipulation de l'IA, la détection des faux pour la télésanté et les rapports de conformité (par exemple, les pistes d'audit qui prouvent la diligence raisonnable dans la détection des fraudes pour les régulateurs).[60][51]. Ces plates-formes fournissent souvent Intégration de l'API pour une intégration transparente dans les systèmes existants et sont conçus pour répondre aux réglementations en matière de santé (HIPAA, GDPR).[61][62]. En utilisant des outils de niveau entreprise, même les petites cliniques ou les assureurs régionaux peuvent avoir accès à des capacités de détection d'IA avancées sans les développer en interne. En outre, les assureurs et les prestataires doivent surveiller les mises à jour des réglementations et des normes industrielles - par exemple, les nouvelles lois contre la fraude par deepfake (certaines juridictions interdisent désormais explicitement les deepfakes médicaux, et les États-Unis étendent les lois sur le vol d'identité pour couvrir l'usurpation d'identité par l'IA).[63]). S'aligner sur ces normes et déployer des outils de pointe permettra non seulement de réduire les pertes dues à la fraude, mais aussi de démontrer aux partenaires, aux auditeurs et aux patients que l'on dispose d'une solide position en matière de sécurité.

Conclusion et perspectives

L'année 2025 a montré que la le génie est sorti de la bouteille - L'IA générative et l'automatisation sont désormais intimement liées à la fraude aux soins de santé. À l'avenir, les fraudeurs continueront probablement à innover : nous pourrions voir des modèles d'IA qui apprennent à imiter le style d'écriture de certains médecins ou des "deepfakes" qui réagissent en temps réel aux questions posées. La bataille sera une course aux armements permanente. Cependant, le secteur des soins de santé réagit avec la même vigueur, en investissant dans des défenses alimentées par l'IA et dans des flux de travail de sécurité plus stricts. En combinant une technologie de détection de pointe, des processus de vérification rigoureux, le partage des données entre les secteurs et la vigilance des employés.Les organismes de santé peuvent donc atténuer considérablement la menace de fraude facilitée par l'IA.

Il ne s'agit pas seulement d'un problème informatique, mais aussi d'un problème de gouvernance et de confiance. Les conseils d'administration et les dirigeants du secteur de la santé doivent reconnaître que la fraude liée à l'IA constitue un risque stratégique pour les finances et la confiance des patients, et qu'elle mérite une attention et des ressources régulières. Les équipes de conformité devraient mettre à jour les évaluations des risques de fraude pour y inclure les aspects liés à l'IA, et les assureurs pourraient repenser les hypothèses de souscription en sachant qu'un certain pourcentage de réclamations pourrait être une fraude assistée par l'IA. D'un autre côté, l'exploitation éthique de l'IA dans les soins de santé (pour l'aide à la décision clinique, l'efficacité de la facturation, etc.) continuera d'apporter de grands avantages - tant que des garanties solides sont en place pour prévenir les abus.

En résumé, L'IA générative a changé la donne en matière de fraude Dans le secteur de la santé, les menaces sont nombreuses, mais grâce à la sensibilisation et à des contre-mesures avancées, elles ne doivent pas nécessairement submerger le système. Les organisations qui réussiront seront celles qui resteront informées des menaces émergentes, qui s'adapteront rapidement grâce à des défenses basées sur l'IA et qui encourageront une culture de "vérification et de confiance" plutôt que de "confiance par défaut". Ce faisant, le secteur de la santé peut exploiter en toute sécurité les aspects positifs de l'IA tout en neutralisant ses utilisations abusives, protégeant ainsi les résultats financiers et le bien-être des patients à l'ère numérique.

Sources : Rapports et cas récents de l'industrie cités ci-dessus, y compris Pymnts (juillet 2025)[2][3]Institut Swiss Re (juin 2025)[27]Banque fédérale de réserve de Boston (avril 2025)[19], BMJ (2024)[37]et les fiches de solution TruthScan (2025)[51][64]entre autres. Toutes les données et citations reflètent les dernières données disponibles en 2024-2025, illustrant l'état actuel de la fraude induite par l'IA dans les soins de santé et les réponses pour la combattre.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] Le ministère de la justice reconnaît l'utilité des outils d'IA dans la répression historique des fraudes dans le secteur de la santé

[4] [5] [6] [7] [16] [40] [44] [45] Statistiques et tendances Deepfake 2025 | Données clés et perspectives - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes et la crise de la connaissance | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] L'intelligence artificielle accroît la menace de fraude à l'identité synthétique - Banque fédérale de réserve de Boston

[25] [26] [56] [57] [62] [64] Détection des fraudes à l'assurance maladie et à l'assurance vie par l'IA | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Comment les deepfakes, la désinformation et l'IA amplifient la fraude à l'assurance | Swiss Re

[28] La DEA met en garde contre la fraude aux ordonnances électroniques - Pharmacy Practice News

[29] [39] Cybersécurité et fraude dans le secteur de la santé : Une plongée en profondeur dans les plus grands risques et défenses d'aujourd'hui | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] La menace évolutive des escroqueries Deepfake en télémédecine, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Des experts mettent en garde contre les escrocs qui utilisent des "imitations profondes" de médecins célèbres sur les réseaux sociaux

[35] [36] [37] Des médecins de confiance à la télévision ont fait de l'intoxication pour promouvoir des escroqueries à la santé sur les médias sociaux - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] état actuel de la recherche Ajit Appari et M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - Détection de l'IA en entreprise et sécurité du contenu

[50] [51] [52] [60] [61] Détection des fraudes dans les dossiers médicaux grâce à l'IA | Solutions CRO pour la santé | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Quelle est la dangerosité des Deepfakes et autres fraudes basées sur l'IA ?