Introduction

L'intelligence artificielle transforme le paysage de la fraude financière comme jamais auparavant. Au début de l'année 2024, des fraudeurs ont utilisé des "deepfakes" générés par l'IA pour se faire passer pour des cadres lors d'un appel vidéo. $25 millions aux escrocs[1][2]. Des incidents comme celui-ci démontrent comment l'IA générative permet aux criminels de concevoir des escroqueries très convaincantes qui ciblent les banques et leurs clients. Les régulateurs tirent la sonnette d'alarme : fin 2024, le FinCEN (Trésor américain) a lancé une alerte sur l'augmentation des fraudes utilisant des médias "deepfake" générés par l'IA, notamment de faux documents d'identité permettant de contourner les vérifications bancaires[3][4]. Ce livre blanc examine les dernières Tendances de la fraude à l'IA dans les services financiers et explique comment les institutions peuvent renforcer leurs défenses. Nous explorons la manière dont les fraudeurs utilisent l'IA générative - des fausses identités profondes aux identités synthétiques - et décrivons les technologies et les stratégies (y compris les outils de détection avancés tels que le TruthScan) que les équipes de lutte contre la fraude et les dirigeants peuvent déployer pour contrer cette menace en constante évolution.

Principales tendances de la fraude à l'IA dans les services financiers

L'IA et l'apprentissage automatique sont exploités par les mauvais acteurs pour mener des fraudes à plus grande échelle et plus sophistiquées. A noter Tactiques de fraude basées sur l'IA impactant les banques, les fintechs et les assureurs incluent :

- Escroqueries à l'usurpation d'identité Deepfake : Les criminels utilisent Vidéo et audio générés par l'IA pour se faire passer pour des personnes de confiance (PDG, clients, etc.) en temps réel. Par exemple, de fausses voix réalistes ont été utilisées dans des attaques de vishing (hameçonnage vocal) pour autoriser des virements électroniques frauduleux, et des vidéos conçues par l'IA ont trompé des employés en les incitant à approuver de fausses transactions[1][5]. Grâce à ces médias synthétiques, il est difficile de savoir si l'on parle vraiment à la personne que l'on croit être, ce qui permet des vols de grande valeur comme l'affaire du deepfake $25M mentionnée ci-dessus. Les "deepfakes" deviennent abordable et facile à produireIl suffit de 20 à 30 secondes d'audio pour cloner une voix, ou de moins d'une heure pour générer une vidéo apparemment authentique.[6].

- Phishing et BEC renforcés par l'IA : L'IA générative donne un coup de fouet aux systèmes d'ingénierie sociale tels que les courriels d'hameçonnage et la compromission du courrier électronique professionnel (BEC). Les chatbots d'IA peuvent rédiger des courriels frauduleux hautement personnalisés dans un langage commercial parfait, en imitant le style d'écriture d'un PDG ou en créant de fausses factures de fournisseurs convaincantes à grande échelle. En fait, des outils souterrains comme FraudeGPT et WormGPT (versions non filtrées de ChatGPT) sont apparus pour aider les cybercriminels à automatiser l'hameçonnage et la création de logiciels malveillants.[7][8]. Cela signifie qu'un fraudeur en puissance disposant de compétences minimales peut facilement générer des campagnes d'hameçonnage ou des codes malveillants sophistiqués. Grâce à l'IA, un seul criminel peut envoyer des milliers de courriels ou de SMS frauduleux personnalisés, ce qui accroît considérablement la portée des tentatives de fraude traditionnelles. Le Centre de lutte contre la criminalité sur Internet du FBI a déjà observé plus de $2,7 milliards perdues à cause d'escroqueries BEC en 2022, et l'IA générative menace d'augmenter encore ces pertes dans les années à venir.[9][10].

- Identités synthétiques et fraude documentaire : L'IA générative alimente l'essor de la fraude à l'identité synthétiquel'un des types de criminalité financière dont la croissance est la plus rapide[11][12]. Les fraudeurs combinent de vraies et de fausses données personnelles pour créer des identités "Frankenstein", puis utilisent l'IA pour produire des documents justificatifs réalistes - des faux passeports aux relevés bancaires en passant par les fiches de paie[7]. Les générateurs d'images et les outils d'édition AI peuvent forger des images de qualité. des pièces d'identité et des photos d'apparence authentique qui passent l'inspection ordinaire. Même les contrôles de présence ou les vérifications par selfie peuvent potentiellement être déjoués par des images ou des vidéos manipulées par l'IA. En automatisant la création de milliers de fausses identités (chacune avec des photos de profil générées par l'IA, des médias sociaux, etc.), les criminels peuvent ouvrir des comptes bancaires ou demander des prêts en masse et blanchir de l'argent ou manquer à leurs obligations en matière de crédit. Les pertes liées à la fraude à l'identité synthétique ont été estimées à environ $35 milliards en 2023[13]L'IA générative ne fait qu'accélérer cette tendance en rendant les fausses identités moins chères et plus difficiles à détecter.

- Fraude et évasion automatisées : Au-delà de la création de faux contenus, l'IA aide aussi les fraudeurs maximiser le succès de leurs projets. Des robots avancés peuvent rapidement tester les données de cartes de crédit volées sur des sites de commerce électronique, en utilisant l'intelligence artificielle pour éviter les déclencheurs de détection. L'IA peut aider les criminels à identifier les maillons faibles de la sécurité d'une organisation ou même à synthétiser des réponses vocales pour déjouer la vérification d'identité par téléphone. Une industrie artisanale sur le dark web vend maintenant des outils d'IA "fraude en tant que service" pour aussi peu que $20.[14]. Cette démocratisation des capacités de l'IA signifie que même des criminels de bas niveau peuvent lancer des attaques frauduleuses très sophistiquées. La course aux armements s'étend à l'évitement de la détection - les fraudeurs utilisent l'IA pour sonder les systèmes anti-fraude des banques et affiner leur approche jusqu'à ce qu'ils trouvent une méthode qui passe à travers les filtres[15]. En bref, l'IA permet de réaliser des fraudes à une échelle et avec une efficacité inéditeset défier les défenses conventionnelles.

Ces tactiques fondées sur l'IA sont déjà proliférer à un rythme alarmant. Les fraudes traditionnelles telles que la falsification de chèques ou l'hameçonnage existent depuis des années, mais l'IA augmente considérablement leur volume et leur réalisme. Les données sont claires : La fraude à l'IA est surabondant.

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

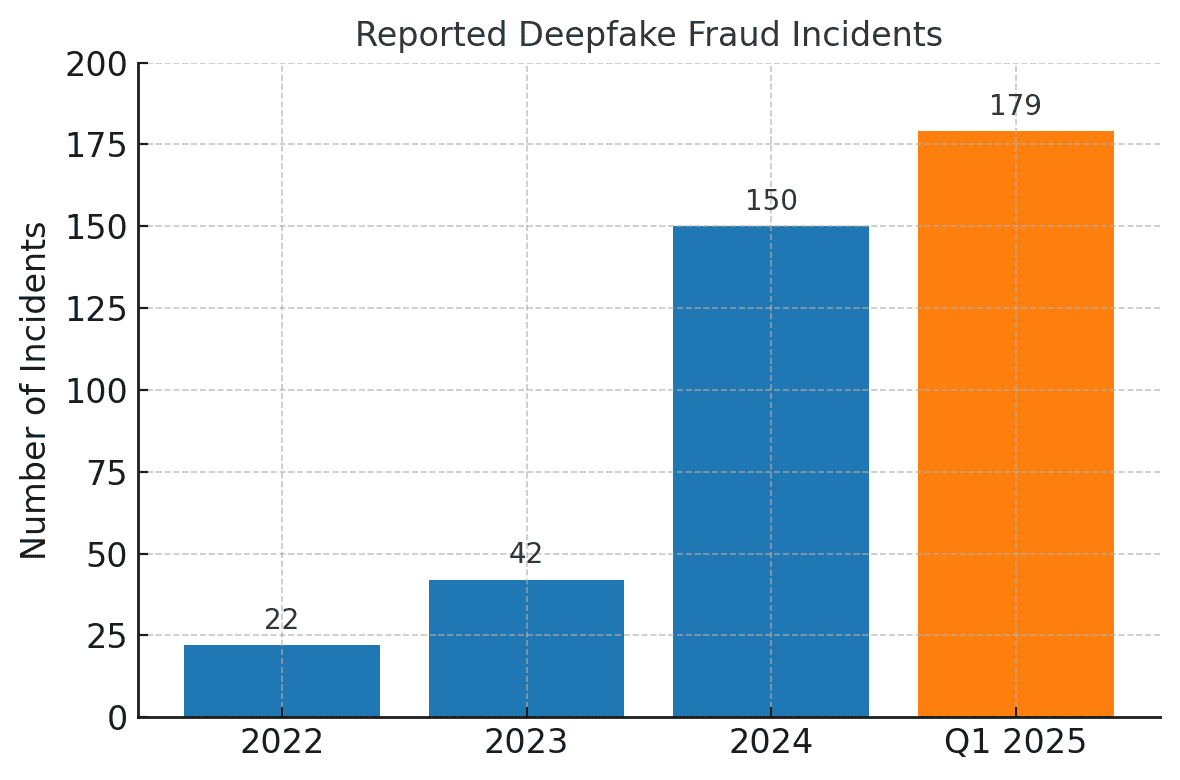

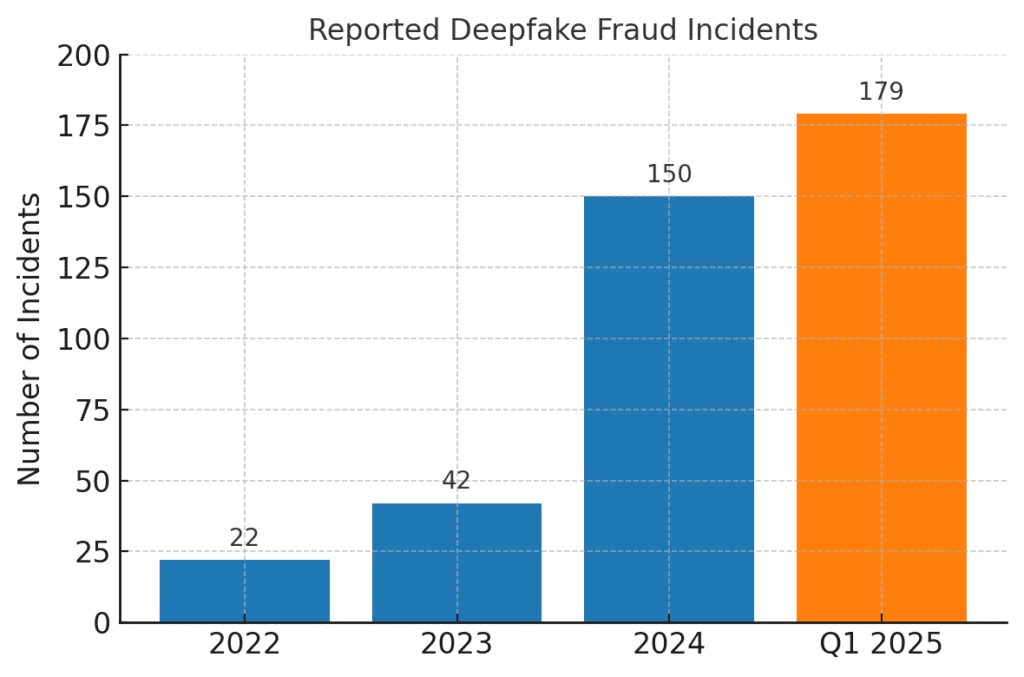

Les incidents de fraude liés aux deepfakes sont montés en flèche. En 2022, seuls 22 cas de fraude par deepfake ont été enregistrés, mais en 2023 il y en a eu 42, et en 2024 les incidents ont explosé pour atteindre 150. Au cours du seul premier trimestre 2025, 179 incidents de fraude "deepfake ont été signalées - dépassant le total pour toute l'année 2024[16][17].

Des analyses récentes du secteur font écho à ces tendances. Un rapport fait état d'une 700% Augmentation des incidents de deepfake ciblant les entreprises fintech en 2023[18]. Plus étonnant encore, l'Amérique du Nord a connu un 1,740% Augmentation du nombre de cas de fraude de type deepfake entre 2022 et 2023[19]. Les criminels financiers adoptent rapidement ces outils parce qu'ils fonctionnent - de nombreuses banques et victimes ne sont pas encore prêtes à détecter les tromperies générées par l'IA.

Impacts et défis pour les institutions financières

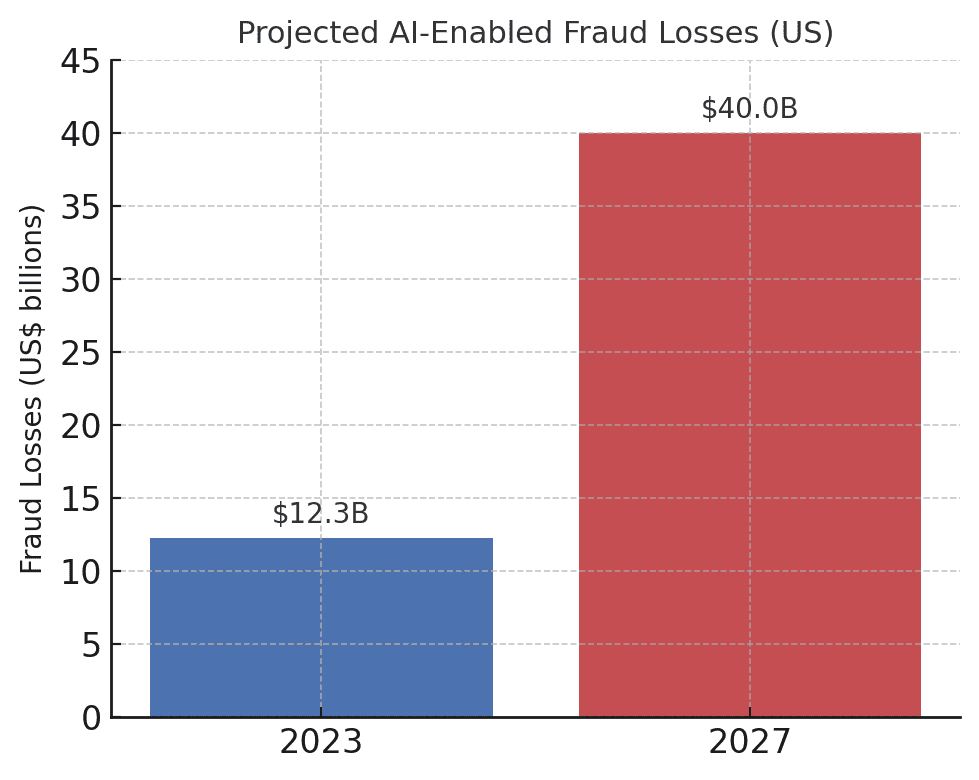

La montée en puissance de la fraude pilotée par l'IA pose impacts significatifs sur les institutions financières, leurs clients et le système financier dans son ensemble. L'impact le plus immédiat est la perte monétaire. Les prévisions du secteur annoncent que d'ici 2027, les pertes liées à la fraude permises par l'IA générative pourraient atteindre $40 milliards aux États-Unis., contre $12,3 milliards en 2023[20]. Cette multiplication par plus de trois (a 32% CAGR) reflète la rapidité avec laquelle le risque de fraude augmente en termes de dollars.

Les pertes prévues liées à la fraude par l'IA augmentent de façon spectaculaire. Deloitte estime que les pertes de fraude financière aux États-Unis liées à l'IA générative passeront de 1,5 milliard d'euros à 1,5 milliard d'euros. $12,3 milliards en 2023 à $40 milliards en 2027[20].

Au-delà des pertes brutes, il y a les pertes de réputation et les pertes d'argent. coûts de la fiducie. Les consommateurs attendent de leurs banques qu'elles les protègent, mais les escroqueries utilisant l'IA sapent la confiance dans les canaux numériques. Par exemple, si un client est victime d'une escroquerie par deepfake convaincante (comme un faux appel vidéo d'un banquier), il peut reprocher à la banque une sécurité insuffisante. Confiance du public dans la vérification vocale, les courriels et même les vidéoconférences peut s'éroder si "ce que vous voyez/entendez" ne peut plus être considéré comme réel.[21]. Selon des enquêtes, 85% des professionnels de la finance aux États-Unis et au Royaume-Uni considèrent les escroqueries de type "deepfake" comme une menace "existentielle" pour la sécurité de leur organisation.[22]. Plus de la moitié des entreprises de ces marchés déclarent avoir été ciblées par une escroquerie de type "deepfake" et, fait alarmant, elles ont été victimes d'une fraude de type "deepfake". 43% des personnes visées ont admis que l'attaque avait réussi en les trompant[23]. Chaque incident réussi ne cause pas seulement un préjudice financier, mais ébranle également la confiance des clients dans l'institution.

Les entreprises financières sont également aux prises avec défis opérationnels et de conformité de la fraude par l'IA. Les équipes de lutte contre la fraude sont confrontées à un afflux d'alertes et d'incidents, ce qui met à rude épreuve les ressources d'investigation. Les modèles existants de détection des fraudes (dont beaucoup reposent sur des règles ou d'anciennes techniques d'apprentissage automatique) peuvent avoir du mal à reconnaître les contenus synthétisés par l'IA qui semblent légitimes. En fait, les systèmes de pointe de détection des fraudes profondes développés en laboratoire voient leur précision chuter de près de 50% lorsqu'ils sont confrontés aux éléments suivants les deepfakes du monde réel dans la nature[24]. Le personnel humain n'est pas beaucoup plus performant - des études montrent que les gens ne peuvent repérer que des vidéos deepfake de haute qualité, autour de 55%-60% du tempsà peine mieux que la chance[25]. Cela indique que sans nouveaux outils, les banques passeront à côté d'une grande partie des tentatives de fraude pilotées par l'IA.

Il y a également un dimension réglementaire. Les régulateurs et les forces de l'ordre sont parfaitement conscients des risques (comme en témoigne l'alerte du FinCEN) et attendent des institutions financières qu'elles s'adaptent. Les banques pourraient être confrontées à des directives plus strictes en matière de vérification des clients et de signalement des fraudes à l'ère de l'IA. Par exemple, si un employé d'une banque est dupé par un deepfake pour approuver un transfert de $10 millions, les régulateurs pourraient examiner minutieusement les contrôles et les processus de diligence raisonnable de la banque. Les Loi sur le secret bancaire inclut désormais explicitement le signalement des activités suspectées de cybercriminalité et de "deepfake".[26][4]Les banques doivent donc former leur personnel à reconnaître et à signaler les indicateurs de fraude générés par l'IA dans les rapports d'activité suspecte (SAR). Le fait de ne pas se tenir au courant des techniques de fraude améliorées par l'IA pourrait conduire à des violations de la conformité ou à une responsabilité juridique si les clients ou les contreparties affirment que la banque n'a pas fait assez pour prévenir les escroqueries prévisibles basées sur l'IA.

Le défi le plus important est peut-être celui de la la nature asymétrique de cette nouvelle menace. L'IA générative réduit considérablement les coûts et les compétences des attaquants, tout en augmentant de manière exponentielle le volume et le réalisme des attaques. Une seule rumeur virale "deepfake" ou un appel vocal cloné convaincant peuvent mettre à mal des millions de dollars d'investissements en matière d'authentification. Pendant ce temps, les défenseurs doivent vérifier l'authenticité de chaque transaction et interaction, une tâche beaucoup plus difficile. Il s'agit véritablement d'une course aux armements : L'IA offre aux fraudeurs une boîte à outils qui s'actualise elle-même pour contourner la sécurité, ce qui oblige les banques à mettre constamment à jour leurs défenses.[15][27]. De nombreuses institutions financières admettent qu'elles ne sont pas suffisamment préparées - plus de 80% des entreprises n'ont pas de plan d'intervention formel en cas d'attaques par deepfakeet plus de la moitié d'entre eux n'ont fourni aucune formation à leurs employés sur les risques liés aux "deepfakes".[28][29]. Ce déficit de préparation signifie que les organisations sont actuellement vulnérables, mais il met également en évidence les domaines dans lesquels une action est nécessaire.

Un rapport récent du secteur fait état d'une mesure remarquable qui donne à réfléchir : 42,5% des tentatives de fraude dans le secteur financier impliquent désormais une forme d'IA[30]. En d'autres termes, près de la moitié des attaques frauduleuses auxquelles les banques sont confrontées ont une composante IA - qu'il s'agisse d'un document généré par l'IA, d'une voix synthétisée ou d'un message d'hameçonnage généré par une machine. Cette statistique souligne que l'IA n'est pas une menace future hypothétique ; elle est déjà là, obligeant les institutions financières à s'adapter ou à faire face à des pertes croissantes.

Se défendre contre la fraude basée sur l'IA : Stratégies et solutions

La lutte contre la fraude induite par l'IA nécessite une évolution des stratégies de prévention de la fraude. Les approches traditionnelles (comme la vérification manuelle ou les moteurs de règles statiques) ne font pas le poids face aux escroqueries à l'IA en constante évolution. Au lieu de cela, les banques doivent adopter technology (like making sure they have a Secure SSL Certificate), training, and teamwork pour inverser la tendance. Nous présentons ci-dessous les stratégies clés et les solutions émergentes :

- Tirer parti de l'IA pour lutter contre l'IA (outils de détection avancée) : Les institutions financières se tournent de plus en plus vers les Solutions de détection alimentées par l'IA pour identifier le contenu généré par l'IA et les anomalies. En somme, il faut combattre le feu par le feu. Les nouveaux outils d'entreprise tels que TruthScan offrent une détection multimodale de l'IA à travers le texte, les images, la voix et la vidéo pour aider à authentifier le contenu en temps réel[31]. Par exemple, les banques peuvent déployer des détecteurs de texte d'IA pour analyser les communications entrantes (courriels, messages de chat) à la recherche de signes de langage généré par l'IA qui pourraient indiquer un courriel d'hameçonnage ou une fausse demande de renseignements de la part d'un client. Le système de détection de texte d'IA de TruthScan peut identifier le contenu écrit par l'IA à partir de modèles tels que GPT-4 avec 99%+ précisionIl est même possible de déterminer quelles phrases sont probablement générées par l'IA.[32][33]. De même, les outils d'analyse d'images de l'IA peuvent vérifier des documents et des images. Détecteur d'images AI peut signaler si un permis de conduire ou une facture d'électricité a été créé ou manipulé numériquement en le comparant à des modèles connus d'images générées par l'IA[34]. Pour les menaces audio, les banques commencent à utiliser Détecteurs de fausses voix - qui analysent le son des appels pour y déceler les empreintes acoustiques de la parole synthétique. Le détecteur de voix AI de TruthScan, par exemple, est à l'écoute des signes révélateurs de clonage de voix et peut vérifier l'authenticité de l'orateur pour éviter les appels d'imposteurs[35]. En intégrant ces détecteurs via l'API dans leurs flux de travail, les institutions financières peuvent automatiquement rechercher du contenu IA en arrière-plan des transactions et des interactions. Il s'agit d'une couche de défense supplémentaire qui fonctionne à la vitesse de la machine et qui détecte ce que les yeux/oreilles humains pourraient manquer.

- Mise en œuvre de la vérification multifactorielle et hors bande : L'IA rendant plus difficile la confiance dans les voix ou les images, les banques devraient s'appuyer davantage sur des méthodes de vérification que l'IA ne peut pas facilement falsifier. Cela inclut l'authentification multifactorielle (MFA) utilisant des canaux sécurisés. Par exemple, si une demande de virement bancaire est envoyée par courriel ou par appel vidéo, il faut exiger un deuxième facteur, tel qu'un code d'accès à usage unique envoyé à l'appareil mobile connu du demandeur, ou un rappel sur un numéro de téléphone de confiance figurant dans le dossier. Certaines banques ajoutent des contrôles de "vivacité" pour les transactions à haut risque - par exemple, en demandant à un client de prendre un selfie en direct avec un geste ou un mot spécifique, ce qui est plus difficile à reproduire pour une vidéo "deepfake". Les authentificateurs biométriques peuvent être renforcés par des mesures anti-spoofing (par exemple en scannant la profondeur du visage en 3D, ou en surveillant les mouvements subtils des yeux que les deepfakes ne parviennent souvent pas à imiter).[27]). L'essentiel est d'éviter les points de défaillance uniques. Même si une IA deepfake peut tromper un canal (par exemple la vérification vocale), une vérification hors bande coordonnée ou un test biométrique peut fournir le défi nécessaire pour révéler la fraude. Principes de la confiance zéro doit être appliquée : traiter toute instruction non sollicitée ou inattendue (même provenant d'un cadre ou d'un client "connu") comme suspecte jusqu'à ce qu'elle soit vérifiée par un canal indépendant.

- Formation des employés et sensibilisation à la fraude : La technologie seule n'est pas une solution miracle, d'autant plus que les fraudeurs s'attaquent au maillon le plus faible, qui est souvent la confiance humaine. Les institutions financières devraient investir dans une formation régulière des équipes de prévention des fraudes et du personnel de première ligne sur les escroqueries basées sur l'IA. Les employés doivent apprendre à reconnaître les signaux d'alerte des deepfakes et de l'ingénierie sociale. Cela peut inclure une formation sur les anomalies subtiles (par exemple, des problèmes de synchronisation des lèvres lors d'un appel vidéo, ou un son qui contient une intonation non naturelle ou trop peu de bruit de fond - signes potentiels d'une voix synthétique). Encourager une culture de vérificationLes employés doivent se sentir habilités à interrompre une transaction ou une demande suspecte et à la vérifier de manière indépendante, même si elle semble provenir du directeur général. Le cas du Tentative d'usurpation de la voix du PDG de Ferrari est instructif - un cadre n'a découvert la ruse qu'en posant une question personnelle à laquelle l'imposteur n'a pas pu répondre[36]. Les exercices de simulation de phishing/deepfake peuvent également s'avérer utiles. Tout comme les entreprises organisent des simulations de phishing pour former leur personnel, elles peuvent simuler un faux message vocal ou une fausse réunion vidéo et voir si les employés les détectent. Cela permet de développer la mémoire musculaire nécessaire pour résister aux attaques réelles. Étant donné que les plus de 50% des entreprises n'ont pas de protocole de réponse aux deepfakes et peu de formation en place[29]La mise en place de tels programmes est un moyen facile d'améliorer la résilience.

- Analyse des fraudes et détection des anomalies : Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier sons générés par l'IA ou trop formelles (en association avec la détection de texte par l'IA mentionnée plus haut). Des banques comme JPMorgan ont commencé à utiliser de grands modèles de langage pour leurs communications internes afin de repérer les phrases ou les contextes susceptibles d'indiquer une tentative d'ingénierie sociale.[37]. Les réseaux de paiement tels que Mastercard analysent de vastes ensembles de données (des milliards de transactions) à l'aide de l'IA afin d'identifier les transactions frauduleuses qui échapperaient aux règles traditionnelles.[38]. Il en ressort que IA défensive doit être aussi innovante que l'IA offensive. Les entreprises devraient envisager de développer ou d'acheter des modèles d'IA spécifiquement destinés à détecter les faux contenus, les identités synthétiques et les modèles d'attaque génératifs. Il est essentiel que ces modèles soient continuellement ré-entraînés sur les derniers exemples de fraude par IA (une pratique appelée apprentissage en ligne ou apprentissage fédéré) afin de rester en phase avec les tactiques des criminels qui évoluent rapidement[39][40].

- Collaboration et partage d'informations : La lutte contre la fraude basée sur l'IA nécessitera une collaboration à la fois au sein des institutions et entre elles. Des efforts cloisonnés sont moins efficaces contre une menace qui transcende les frontières organisationnelles. Équipes de prévention de la fraude, équipes de cybersécurité et services informatiques doivent travailler main dans la main - par exemple, les équipes de sécurité peuvent déployer la détection de deepfake dans les outils de vidéoconférence, tandis que les équipes de lutte contre la fraude intègrent les analyses de contenu dans le suivi des transactions. Plus généralement, les banques devraient participer à des groupes sectoriels tels que le Financial Services Information Sharing and Analysis Center (FS-ISAC) afin d'échanger des informations sur les nouveaux schémas de fraude par l'IA[41]. Si une banque découvre un nouveau vecteur d'attaque par deepfake, le partage de cette information peut aider d'autres banques à combler le fossé avant qu'elles ne soient touchées. Des exercices communs ou des simulations en "équipe rouge" avec des scénarios impliquant l'IA (par exemple, une escroquerie exécutive de type deepfake ou un contournement de vérification d'identité généré par l'IA) peuvent être menés par des consortiums sectoriels ou avec le soutien des autorités de réglementation. Les régulateurs eux-mêmes se concentrent sur les risques liés à l'IA, il est donc judicieux de s'engager avec eux de manière proactive. En contribuant à l'élaboration de normes et de lignes directrices pour l'utilisation de l'IA, les banques peuvent aider à façonner un écosystème plus sûr. En fin de compte, étant donné que une menace pour une banque est une menace pour toutes les banques dans cet espace[42]En outre, une approche de défense collective renforcera la capacité de chacun à détecter et à décourager la fraude liée à l'IA.

- Éducation des clients et mesures de confiance : Enfin, les institutions financières ne doivent pas négliger le rôle de la sensibilisation des clients. Les deepfakes et les escroqueries à l'IA ciblant le grand public (par exemple, les fausses voix dans les escroqueries aux grands-parents ou les faux chats de "support technique" générés par l'IA), les banques peuvent contribuer à éduquer les clients sur ces dangers. De nombreuses banques envoient déjà des alertes sur le phishing ; elles peuvent les étendre pour mentionner le clonage de voix d'IA et les vidéos de deepfake, en donnant des conseils sur la manière de vérifier les demandes. Certaines organisations progressistes envoient des notifications push ou des avertissements dans leurs applications si une escroquerie connue circule (par exemple, "Attention : des fraudeurs peuvent utiliser des clones vocaux de membres de la famille pour demander de l'argent").[43]. Même si elle ne prévient pas directement les attaques, l'éducation peut réduire le taux de réussite et renforcer l'idée que la banque est un partenaire en matière de sécurité. En outre, les banques qui investissent dans la prévention de la fraude à la pointe de la technologie devraient le faire savoir à leurs clients en tant qu'élément de leur stratégie de sécurité. différentiateur - Par exemple, faire savoir aux clients que tous les appels vidéo ou les documents soumis sont analysés par l'IA pour en vérifier l'authenticité (sans divulguer de méthodes sensibles) peut les rassurer sur le fait que la banque utilise tous les outils disponibles pour les protéger. La préservation de la confiance numérique sera essentielle pour que les banques puissent exploiter pleinement les avantages de l'IA dans les services, de sorte que la transparence et les mesures de protection axées sur les clients font partie d'une défense holistique.

Rôle des services de détection de contenu par l'IA

La pierre angulaire de la boîte à outils anti-fraude à l'ère de l'IA est l'utilisation de Services de détection de contenu par l'IA. Ces services sont spécialisés dans la détection des "empreintes digitales" des contenus générés par l'IA qui pourraient échapper aux réviseurs humains. TruthScan est l'un de ces fournisseurs qui propose un service d'analyse de contenu de qualité professionnelle. AI Detection Suite couvrant plusieurs types de contenu. Les institutions financières peuvent intégrer ces outils pour détecter automatiquement les indicateurs de falsification et de fraude :

- Vérification de documents et d'images : La plateforme de TruthScan permet aux banques de tester en temps réel les documents financiers pour détecter les fraudes générées par l'IA[44]. Cela signifie que lorsqu'un nouveau compte est ouvert ou qu'une demande de prêt est accompagnée d'une photo d'identité et d'un talon de chèque de paie, le système peut instantanément analyser ces images pour y déceler des signes de création synthétique ou de falsification. Avec une précision de plus de 99%[45]L'AI Image Detector peut détecter des images d'identité falsifiées ou des PDF trafiqués qu'un humain pourrait approuver à première vue. Ce type de vérification de l'authenticité des documents est essentiel pour stopper la fraude à l'identité synthétique avant même l'ouverture d'un compte.

- Contrôle des transactions en temps réel : En déployant des intégrations API, TruthScan peut se connecter au traitement des transactions des banques et signaler les anomalies dans les domaines suivants temps réel. Si une instruction semble suspecte par courriel, le détecteur d'escroquerie par courriel peut analyser le contenu du message et détecter s'il a été rédigé par un modèle d'IA essayant d'usurper l'identité d'un vendeur ou d'un cadre.[46]. De même, le Détecteur d'IA en temps réel peut surveiller les communications en direct (comme les chats ou les plateformes de collaboration) afin de fournir des alertes instantanées si, par exemple, un flux vidéo imposteur deepfake est détecté au cours d'une réunion à fort enjeu.[47][48]. Une surveillance continue avec des alertes instantanées et des réponses automatisées permet de réduire la période pendant laquelle la fraude peut se produire sans être détectée.

- Défense contre la fraude vocale et vidéo (Deepfake Defense) : Pour les centres d'appel et les responsables des relations avec les clients, l'incorporation de l'outil TruthScan Détecteur de voix AI ajoute une couche supplémentaire de sécurité. Si un fraudeur appelle en se faisant passer pour un client à l'aide d'un clone vocal, le système peut analyser le son de l'appel et signaler s'il contient des éléments synthétisés par l'IA (comme des micro-pauses naturelles manquantes ou des artefacts dans les ondes sonores).[35]. En ce qui concerne la vidéo, le Détecteur de fausses pistes applique des algorithmes de vision artificielle aux images vidéo pour détecter les incohérences - mouvements faciaux non naturels, éclairage étrange ou synchronisation labiale inadaptée - qui révèlent un faux.[49][50]. En vérifiant l'intégrité des voix et des visages lors d'interactions clés, les banques peuvent déjouer les imposteurs qui tentent de tromper leurs employés. Ces outils agissent comme un détecteur de mensonges de haute technologie pour le contenu numérique, fonctionnant de manière invisible en arrière-plan.

Il convient de noter que le déploiement d'une telle technologie de détection n'est pas une panacée prête à l'emploi ; elle doit être calibrée et adaptée aux flux de travail de l'institution. Les faux positifs doivent être gérés (par exemple, un détecteur de texte IA peut considérer comme suspectes des communications légitimes basées sur des modèles jusqu'à ce qu'il apprenne la différence). Toutefois, lorsqu'ils sont correctement intégrés, ces outils améliorent considérablement la capacité d'une organisation à repérer les contenus frauduleux avant qu'ils ne causent des dommages. Ils génèrent également des pistes d'audit et des rapports analytiques qui sont utiles pour le respect de la législation et pour l'amélioration continue des modèles de fraude.

L'efficacité des outils de détection de l'IA dépend essentiellement des éléments suivants des mises à jour constantes. Tout comme les logiciels antivirus nécessitent de nouvelles signatures pour les nouveaux virus, les détecteurs d'IA ont besoin de se recycler sur les dernières techniques de deepfake et les derniers modèles d'IA. Des fournisseurs comme TruthScan mettent à jour leurs algorithmes pour gérer les nouveaux modèles génératifs et les tactiques d'évasion, afin de maintenir une précision élevée même si l'IA évolue.[51]. Cela permet de soulager les équipes internes et de garantir que les banques ne mènent pas une guerre d'hier alors que les criminels passent à de nouvelles astuces d'IA.

Conclusion

Le secteur des services financiers se trouve à la croisée des chemins dans la lutte contre la fraude. D'un côté, les criminels adoptent rapidement l'IA générative pour lancer des escroqueries plus convaincantes et plus répandues que jamais. De l'autre, les banques et les chasseurs de fraude disposent d'un arsenal croissant de défenses basées sur l'IA. Les institutions qui prospéreront sont celles qui reconnaître le nouveau paysage des menaces et y répondre avec la même ingéniosité. Cela signifie qu'il faut investir dans des capacités de détection avancées, intégrer des processus de vérification à plusieurs niveaux, former le personnel et les clients et encourager une culture de la vigilance et de l'adaptation.

La fraude basée sur l'IA est une cible qui évolue rapidement - l'escroquerie deepfake qui a trompé une entreprise aujourd'hui peut être contrée par de nouvelles techniques de détection demain, avant que les fraudeurs ne modifient leurs méthodes la semaine suivante. Par conséquent, une stratégie de prévention de la fraude "standard" en 2025 est une stratégie qui met l'accent sur l'agilité et l'amélioration continue. Les organisations financières devraient considérer leurs systèmes de défense contre la fraude comme des entités vivantes et apprenantes qui évoluent en même temps que les tactiques criminelles. L'établissement de partenariats avec des fournisseurs de technologie est un raccourci intelligent pour développer ces capacités. Par exemple, la collaboration avec des entreprises spécialisées comme TruthScan (qui propose des solutions adaptées au secteur bancaire et financier) peut accélérer la capacité d'une institution à prévenir les fraudes basées sur l'IA tout en maintenant la conformité réglementaire et la confiance des clients.[52].

En fin de compte, la protection contre la fraude induite par l'IA n'est pas seulement une question de technologie - il s'agit de préserver les principes fondamentaux de l'économie de marché. confiance qui sous-tend la finance. Les clients ont besoin de savoir que leur banque peut distinguer une vraie transaction d'une fausse, un vrai client d'un imposteur de l'IA. En déployant des outils de détection de l'IA de pointe, en renforçant les protocoles de vérification et en gardant une longueur d'avance sur les menaces émergentes, les entreprises de services financiers peuvent maintenir cette confiance. Le chemin à parcourir sera sans aucun doute jalonné de nouvelles tentatives de fraude de la part des adversaires, mais en se préparant et en réalisant les bons investissements, les banques peuvent s'assurer que L'IA devient plus un atout qu'une menace dans le domaine de la prévention de la fraude. C'est un objectif réalisable : les mêmes technologies d'IA qui menacent de perturber peuvent être exploitées pour sauvegarder l'intégrité de notre système financier. Le moment est venu pour les équipes de prévention de la fraude et les cadres dirigeants d'agir de manière décisive, adopter des solutions et des stratégies avancées pour déjouer les fraudeurs et assurer l'avenir de la finance numérique.

Sources : Des rapports sectoriels récents, des alertes réglementaires et des livres blancs sur la technologie ont été référencés tout au long du document (Deloitte[20][18]Forum économique mondial[19][24]Trésor américain FinCEN[3][4]Réserve fédérale[13]Keepnet Labs[16][30]entre autres) pour fournir des données et des exemples. Toutes les données et tous les exemples sont cités en ligne pour permettre aux lecteurs d'aller plus loin.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking et risque de fraude à l'IA | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] La détection des IA dangereuses est essentielle à l'ère du deepfake | World Economic Forum

[3] [4] [26] FinCEN émet une alerte sur les stratagèmes de fraude impliquant Deepfake Media ciblant les institutions financières | FinCEN.gov

[7] [8] FraudGPT et GenAI : Comment les fraudeurs vont-ils utiliser l'IA ? | Alloy

[11] Fraude à l'identité synthétique : Comment l'IA change la donne - Federal Reserve Bank of Boston

[12] [13] L'intelligence artificielle générative accroît les menaces de fraude à l'identité synthétique

[16] [17] [22] [23] [28] [29] [30] Statistiques et tendances Deepfake 2025 | Données clés et perspectives - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Détection de l'IA en entreprise et sécurité du contenu

[32] [33] [51] Détecteur d'IA : Détection de texte AI de niveau entreprise - TruthScan

[44] [45] [52] Banque AI Détection de la fraude | Solutions CRO | TruthScan

[49] [50] Deepfake Detector - Identifier les fausses vidéos et les vidéos d'IA - TruthScan