Un guide complet pour comprendre, détecter et prévenir la fraude vocale liée à l'IA dans l'entreprise

L'appel vocal de $25 millions qui n'a jamais eu lieu

En février 2024, une employée d'une multinationale de Hong Kong reçoit un appel vidéo de son directeur financier.

La voix à l'autre bout du fil était incomparable ; chaque inflexion, chaque pause et même le léger accent étaient immédiatement reconnus.

Il lui a demandé de procéder d'urgence à 15 virements, pour un montant total de $25 millions, afin de finaliser une acquisition confidentielle.

Ne vous inquiétez plus jamais de la fraude à l'IA. TruthScan peut vous aider :

- Détecter l'IA générée des images, du texte, de la voix et de la vidéo.

- Éviter la fraude majeure induite par l'IA.

- Protégez vos plus sensible les actifs de l'entreprise.

Le directeur financier n'a jamais pris cette décision. Il a été entièrement généré par l'IA.

Il ne s'agit pas d'un cas isolé. Les institutions financières constatent une forte augmentation des fraudes de type "deepfake".

Au cours des trois dernières années, les cas ont augmenté de 2 137%, et l'IA est désormais à l'origine de 42,5% de toutes les tentatives de fraude dans le secteur.

Malgré la montée en puissance de la fraude vocale par IA, plus de la moitié des chefs d'entreprise admettent que leurs employés n'ont pas été formés pour repérer les attaques par deepfake ou y répondre ; près de 80% des entreprises n'ont pas mis en place de protocoles formels pour gérer ces incidents.

Comment fonctionne le clonage vocal par l'IA et pourquoi il constitue une menace

La synthèse vocale de l'IA moderne nécessite étonnamment peu de données. Quelques secondes d'audio suffisent pour cloner une voix avec une précision allant jusqu'à 85%.

Le processus se déroule en trois étapes principales :

- Collecte des données : Les escrocs recueillent des échantillons de voix à partir de sources publiques telles que des conférences téléphoniques, des interviews de podcasts, des clips de médias sociaux ou même des messages vidéo de LinkedIn.

- Modèle de formation : L'IA analyse les caractéristiques vocales telles que la hauteur, le ton, l'accent, le rythme et les schémas respiratoires.

- Génération : Le système crée un discours synthétique suffisamment convaincant pour tromper même des collègues proches.

Le problème de l'accessibilité

Ce qui rend cette menace encore plus dangereuse, c'est sa démocratisation. Les escrocs n'ont plus besoin de ressources dignes d'Hollywood.

Il suffit d'un logiciel accessible pour cloner une voix à partir d'un court extrait de média social ; les outils open-source et les services d'IA basés sur le cloud ont rendu le clonage de voix accessible à toute personne ayant des compétences techniques de base.

Pourquoi les cadres sont les principales cibles de la fraude

Les cadres sont confrontés à un dangereux mélange de facteurs de risque.

Leur exposition publique par le biais des médias sociaux rend les échantillons vocaux faciles à trouver, et leur autorité incite souvent les employés à agir rapidement sur les demandes urgentes.

En moyenne, un cadre sur quatre n'a qu'une compréhension limitée de la technologie "deepfake".

Les statistiques actuelles dressent un tableau inquiétant

Dans un 2024 Enquête Deloitte25,9% des dirigeants ont déclaré que leur entreprise avait été confrontée à au moins un incident de deepfake ciblant des données financières ou comptables au cours de l'année écoulée, et la moitié des personnes interrogées pensaient que ces attaques allaient se multiplier au cours des 12 prochains mois.

Plus inquiétant : seulement 52% des organisations se sentent sûres de pouvoir repérer un deepfake de leur PDG.

Comment repérer les escroqueries liées à l'IA vocale

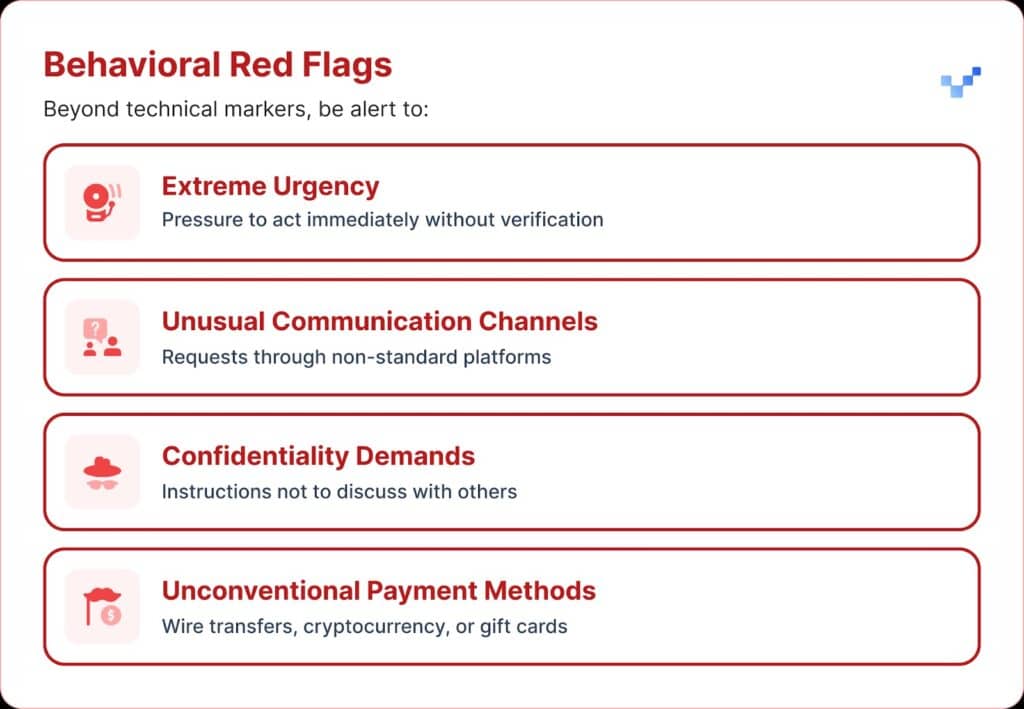

Lorsque vous recevez une communication vocale suspecte, vous devez être attentif à certains signes d'alerte.

Les voix d'IA frauduleuses sont souvent monotones ou plates. Vous pouvez également remarquer une cadence inhabituelle, avec des pauses bizarres ou un rythme peu naturel.

Le son peut également contenir de faibles bourdonnements ou échos électroniques, en particulier lors d'appels prolongés.

Et dans de nombreux cas, la voix répète des phrases limitées qui semblent écrites ou répétées.

Impact financier et coût réel

La plupart des organisations ont perdu environ $450 000 en moyenne, mais dans le secteur des services financiers, les pertes ont grimpé à plus de $603 000.

Dans les cas les plus graves, 1 organisation sur 10 a déclaré des pertes supérieures à $1 million.

Cette tendance s'est rapidement développée. Des recherches antérieures menées en 2022 indiquaient que la charge financière moyenne de l'usurpation d'identité s'élevait à environ $230 000, soit près de la moitié du chiffre actuel.

Pertes futures prévues

Selon le Center for Financial Services de Deloitte, les pertes d'argent dues à la fraude par IA aux États-Unis pourraient passer de $12,3 milliards en 2023 à $40 milliards d'ici 2027. Cela représente une croissance d'environ 32% chaque année.

Vulnérabilité régionale

L'Amérique du Nord a connu une augmentation de 1740% des fraudes de type "deepfake".

Cette augmentation régionale significative suggère que l'Amérique du Nord pourrait être une cible privilégiée pour les fraudeurs de type "deepfake", probablement en raison de l'importance de son économie numérique et de l'utilisation répandue des services en ligne.

Approches stratégiques de la protection des cadres

1. Mettre en œuvre des protocoles de vérification

L'un des moyens de renforcer les défenses consiste à utiliser un système de "mots sûrs", c'est-à-dire des phrases d'authentification convenues à l'avance et partagées avec le personnel clé.

Un escroc utilisant le clonage vocal par IA ne connaîtra pas les bonnes réponses aux questions de vérification personnelle.

Une autre mesure de protection est la vérification multicanal.

Toute demande financière inhabituelle doit être confirmée par un canal de communication distinct, sans jamais se fier uniquement à la méthode de contact initiale.

Les entreprises devraient également établir des règles claires pour la remontée des informations, avec des périodes d'attente et des étapes d'approbation pour les transactions financières importantes, quel que soit l'auteur de la demande.

2. Attention à l'exposition numérique

Une autre couche de protection consiste à limiter la quantité d'audio et de vidéo exécutives disponibles en ligne. Plus les escrocs peuvent collecter d'échantillons, plus leurs clones deviennent convaincants.

Il est également utile d'établir des lignes directrices claires pour les cadres sur les médias sociaux, notamment en ce qui concerne la publication de vidéos avec un son clair.

En ce qui concerne les conférences, les organisations doivent faire attention aux enregistrements de conférences ou d'interviews qui donnent de longs extraits de voix.

3. Déployer des solutions techniques

C'est là que la technologie de détection avancée de l'IA devient essentielle.

Les entreprises ont besoin d'une authentification et d'une Détection de fausses informations (deepfake) qui fournissent :

- Analyse en temps réel : Détecter les voix synthétiques pendant les communications en direct

- Vérification historique : Analyser les appels et les messages enregistrés pour en vérifier l'authenticité

- Capacités d'intégration : Travailler en toute transparence avec les plateformes de communication existantes

- Taux de précision élevés : Minimiser les faux positifs tout en détectant les contrefaçons sophistiquées

4. Programmes de formation complets

Les équipes dirigeantes ont besoin d'une formation ciblée sur les menaces vocales de l'IA et les procédures de vérification.

Il est tout aussi important de sensibiliser les employés.

Toute personne, quel que soit son rôle, doit être en mesure de repérer les "deepfakes" potentiels et d'empêcher les cybermenaces de pénétrer dans l'organisation.

Des exercices de simulation réguliers peuvent renforcer cette préparation en utilisant des tentatives fictives de fraude vocale pour tester et affiner les procédures de réponse.

Solutions avancées de détection de la voix par l'IA

Les défenses traditionnelles ont été conçues pour les menaces basées sur les réseaux, pas pour l'usurpation d'identité humaine par l'IA.

Les principales raisons pour lesquelles les outils de cybersécurité standard ne peuvent pas faire face à l'ingénierie sociale basée sur la voix :

- Pas de signature de logiciel malveillant : Les appels vocaux ne déclenchent pas les systèmes de sécurité traditionnels

- Facteur de confiance humaine : Les gens font naturellement confiance à ce qu'ils entendent, en particulier aux voix familières

- Lacunes technologiques en matière de détection : Malgré l'augmentation des tentatives de fraude basées sur l'IA, y compris les deepfakes, seulement 22% des institutions financières ont mis en place des outils de prévention de la fraude basés sur l'IA.

La nécessité d'une détection vocale spécialisée

La fraude vocale moderne nécessite des capacités de détection modernes.

Qualité de l'entreprise Systèmes de détection vocale par IA peut :

- Analyser les biomarqueurs vocaux : Détecter les incohérences subtiles dans les discours synthétiques

- Traitement en temps réel : Fournir des alertes immédiates en cas d'appels suspects

- Apprentissage continu : S'adapter aux nouvelles techniques de synthèse vocale

- Prêt pour l'intégration : Travailler avec l'infrastructure de communication existante

Les entreprises qui souhaitent se protéger contre la fraude vocale doivent investir dans une technologie de détection de l'IA spécialement conçue pour répondre à la sophistication des menaces auxquelles elles sont confrontées.

La fraude vocale existe et s'intensifie

Au cours du premier trimestre 2025, les fraudes de type "deepfake" et les vols d'identité ont causé plus de $200 millions de pertes.

L'hameçonnage vocal avec des clones d'IA a bondi de 442%, et plus de 400 entreprises sont touchées chaque jour par des escroqueries au faux PDG ou au faux directeur financier.

Alors que 56% des entreprises se disent très confiantes dans la détection des "deepfakes", seules 6% ont effectivement évité de subir des pertes financières à cause d'eux.

L'important n'est pas de savoir si votre organisation sera ciblée, mais si vous êtes prêt à l'être.

La fraude vocale change le visage de la cybersécurité. Les défenses traditionnelles ne peuvent pas faire face à l'usurpation d'identité alimentée par l'IA.

Pour rester protégées, les organisations ont besoin de meilleurs outils de détection, de programmes de formation solides et de procédures de vérification claires.

La technologie nécessaire pour riposter est déjà là. La vraie question est de savoir si vous l'utiliserez avant votre premier incident de fraude vocale ou après.