Johdanto

Tekoäly on muuttamassa talouspetoksia ennennäkemättömällä tavalla. Vuoden 2024 alussa huijarit käyttivät tekoälyn luomia väärennöksiä esiintyäkseen johtajina videopuhelussa ja huijatakseen hongkongilaista työntekijää siirtämään rahaa. $25 miljoonaa huijareille[1][2]. Tämänkaltaiset tapaukset osoittavat, miten generatiivinen tekoäly antaa rikollisille mahdollisuuden luoda erittäin vakuuttavia huijauksia, jotka kohdistuvat pankkeihin ja niiden asiakkaisiin. Sääntelyviranomaiset hälyttävät: Yhdysvaltain valtiovarainministeriön FinCEN antoi vuoden 2024 lopulla varoituksen, jossa se varoitti kasvavista petoksista, joissa käytetään tekoälyn tuottamaa "deepfake"-mediaa, mukaan lukien väärennettyjä henkilöllisyystodistuksia, joilla ohitetaan pankkitarkastukset.[3][4]. Tässä whitepaperissa tarkastellaan viimeisimpiä Tekoälypetostrendit rahoituspalveluissa ja keskustelee siitä, miten laitokset voivat vahvistaa puolustustaan. Tutkimme, miten huijarit käyttävät apunaan generatiivista tekoälyä, kuten väärennettyjä henkilöllisyyksiä ja synteettisiä henkilöllisyyksiä, ja hahmotamme teknologiaa ja strategioita (mukaan lukien kehittyneet havaintotyökalut, kuten esim. TruthScan), joita petostentorjuntaryhmät ja johtajat voivat käyttää tämän kehittyvän uhan torjumiseksi.

Tärkeimmät tekoälypetostrendit rahoituspalveluissa

Pahantekijät hyödyntävät tekoälyä ja koneoppimista yhä laajempien ja kehittyneempien petosten tekemiseen. Huomionarvoista Tekoälyyn perustuvat petostaktiikat pankkeihin, fintech-yrityksiin ja vakuutusyhtiöihin vaikuttavat muun muassa seuraavat:

- Deepfake-imitaatiohuijaukset: Rikolliset käyttävät Tekoälyn luoma video ja ääni esiintyä luotettuina henkilöinä (toimitusjohtajina, asiakkaina jne.) reaaliaikaisesti. Esimerkiksi elävän näköisiä väärennettyjä ääniä on käytetty vishing-hyökkäyksissä (voice phishing) vilpillisten tilisiirtojen hyväksymiseksi, ja tekoälyn luomat videot ovat huijanneet työntekijöitä hyväksymään väärennettyjä liiketoimia.[1][5]. Näiden synteettisten viestimien ansiosta on vaikea tietää, puhutko todella sille henkilölle, jolle luulet puhuvasi, mikä mahdollistaa arvokkaat ryöstöt, kuten edellä mainitun $25M deepfake -tapauksen. Syväväärennöksistä on tulossa edullinen ja helppo tuottaaääni voidaan kloonata vain 20-30 sekunnin kuluessa tai alle tunnissa, jotta voidaan luoda näennäisen aito video.[6].

- Tekoälyllä tehostettu phishing & BEC: Generatiivinen tekoäly tehostaa sosiaalista manipulointia, kuten phishing-sähköposteja, ja yrityssähköpostin vaarantaminen (BEC). Tekoälyn chatbotit voivat laatia erittäin yksilöllisiä huijaussähköposteja täydellisellä liikekielellä, jäljitellä toimitusjohtajan kirjoitustyyliä tai luoda vakuuttavia väärennettyjä myyjän laskuja mittakaavassa. Itse asiassa maanalaiset työkalut, kuten FraudGPT ja WormGPT (suodattamattomat versiot ChatGPT:stä) ovat ilmaantuneet auttamaan tietoverkkorikollisia automatisoimaan phishing- ja haittaohjelmien luomista.[7][8]. Tämä tarkoittaa sitä, että petoksen tekijäksi aikova henkilö, jolla on vain vähän taitoja, voi luoda helposti hiottuja phishing-kampanjoita tai haittakoodia. Tekoälyn avulla yksittäinen rikollinen voi lähettää tuhansia räätälöityjä huijaussähköposteja tai tekstiviestejä, mikä lisää huomattavasti perinteisten petosyritysten ulottuvuutta. FBI:n Internet Crime Center on jo havainnut, että yli $2,7 miljardia euroa menetetään BEC-huijausten vuoksi vuonna 2022, ja generatiivinen tekoäly uhkaa nostaa näitä tappioita vielä suuremmiksi tulevina vuosina.[9][10].

- Synteettiset henkilöllisyydet ja asiakirjapetokset: Geneerinen tekoäly edistää synteettisten identiteettipetosten nousuayksi nopeimmin kasvavista talousrikollisuuden muodoista.[11][12]. Huijarit yhdistävät oikeita ja väärennettyjä henkilötietoja luodakseen "Frankenstein"-identiteettejä ja käyttävät sitten tekoälyä... tuottaa realistisia tositteita - väärennetyistä passeista ja tiliotteista palkkakuitteihin.[7]. AI-kuvageneraattorit ja muokkaustyökalut voivat väärentää aidon näköiset henkilöllisyystodistukset ja valokuvat jotka läpäisevät satunnaisen tarkastuksen. Jopa elävyystarkastukset tai selfie-tarkastukset voidaan mahdollisesti ohittaa tekoälyn manipuloimilla kuvilla tai videoilla. Luomalla automaattisesti tuhansia väärennettyjä henkilöitä (joista jokaisella on tekoälyn luomat profiilikuvat, sosiaalinen media jne.) rikolliset voivat avata pankkitilejä tai hakea lainoja massoittain ja pestä rahaa tai laiminlyödä luottoja. Synteettisistä identiteettipetoksista aiheutuvien tappioiden arvioitiin olevan noin $35 miljardia euroa vuonna 2023[13], ja generatiivinen tekoäly vain kiihdyttää tätä suuntausta tekemällä väärennetyistä henkilöllisyyksistä halvempia ja vaikeammin havaittavia.

- Automatisoidut petokset ja veronkierto: Tekoäly auttaa myös huijareita väärennetyn sisällön luomisen lisäksi. maksimoida järjestelmiensä menestys. Kehittyneet botit voivat nopeasti testata varastettuja luottokorttitietoja verkkokauppasivustoilla ja käyttää ML:ää havaitsemisen välttämiseksi. Tekoäly voi auttaa rikollisia tunnistamaan heikoimmat lenkit organisaation turvallisuudessa tai jopa syntetisoimaan äänivastauksia, jotta he voivat päihittää puhelinpohjaisen henkilöllisyyden tarkistuksen. Pimeässä verkossa on nykyään pimeä teollisuus, joka myy "petos palveluna" -tyyppisiä tekoälytyökaluja niinkin edulliseen hintaan kuin $20.[14]. Tekoälyominaisuuksien demokratisoituminen tarkoittaa, että jopa matalan tason rikolliset voivat käynnistää erittäin kehittyneitä petoshyökkäyksiä. Petosrikolliset käyttävät tekoälyä pankkien petostentorjuntajärjestelmien kartoittamiseen ja kehittävät lähestymistapojaan, kunnes he löytävät menetelmän, joka läpäisee suodattimet.[15]. Lyhyesti sanottuna tekoäly mahdollistaa petosten tekemisen. ennennäkemättömällä mittakaavalla ja tehokkuudella, mikä haastaa perinteisen puolustuksen.

Nämä tekoälyä hyödyntävät taktiikat ovat jo lisääntyvät hälyttävää vauhtia. Perinteisiä petosmenetelmiä, kuten shekkien väärentämistä tai phishingiä, on ollut olemassa jo vuosia, mutta tekoäly lisää niiden määrää ja realistisuutta. Tiedot kertovat selkeän tarinan: Tekoälypetokset ovat vellova.

Älä enää koskaan ole huolissasi tekoälypetoksista. TruthScan Voi auttaa sinua:

- Tunnista AI luotu kuvat, teksti, ääni ja video.

- Vältä merkittävä tekoälyyn perustuva petos.

- Suojaa kaikkein herkkä yrityksen omaisuuserät.

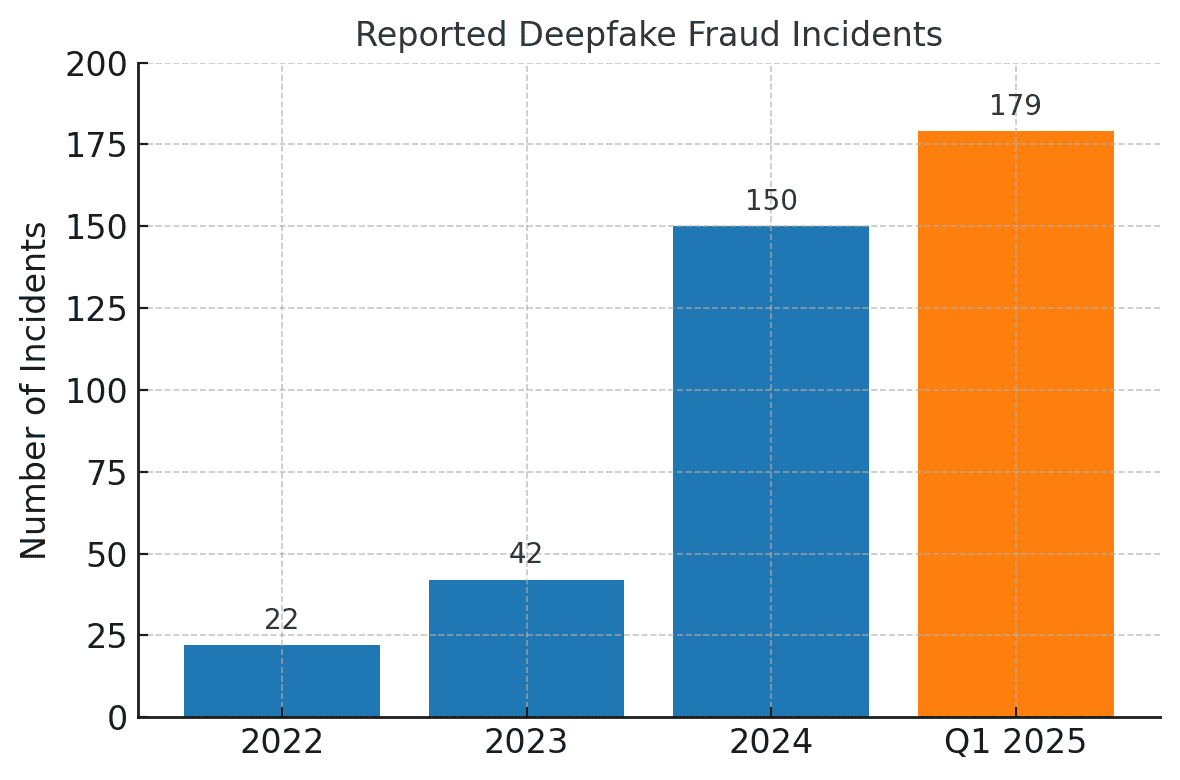

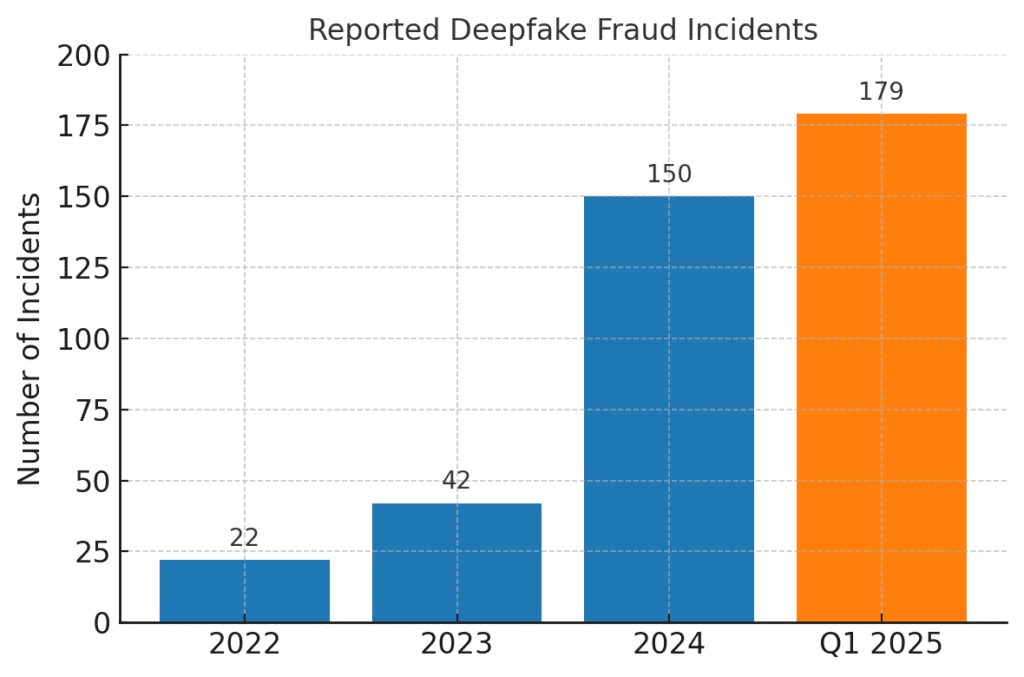

Deepfake-petoksiin liittyvät petostapaukset ovat lisääntyneet räjähdysmäisesti. Vuonna 2022 kirjattiin vain 22 deepfake-petostapausta, mutta vuonna 2023 niitä oli 42, ja vuoteen 2024 mennessä tapauksia oli jo 150. Pelkästään vuoden 2025 ensimmäisellä neljänneksellä, 179 deepfake-petostapausta ilmoitettiin - enemmän kuin vuonna 2024 yhteensä.[16][17].

Alan viimeaikaiset analyysit heijastavat näitä suuntauksia. Eräässä raportissa todettiin 700% Deepfake-tapausten lisääntyminen fintech-yritykset vuonna 2023[18]. Vielä hämmästyttävämpää on, että Pohjois-Amerikassa nähtiin - 1,740% deepfake-petostapausten lisääntyminen vuosina 2022-2023[19]. Talousrikolliset ottavat nämä välineet nopeasti käyttöön, koska ne toimivat - monet pankit ja uhrit eivät ole vielä valmiita havaitsemaan tekoälyn tuottamaa petosta.

Vaikutukset ja haasteet rahoituslaitoksille

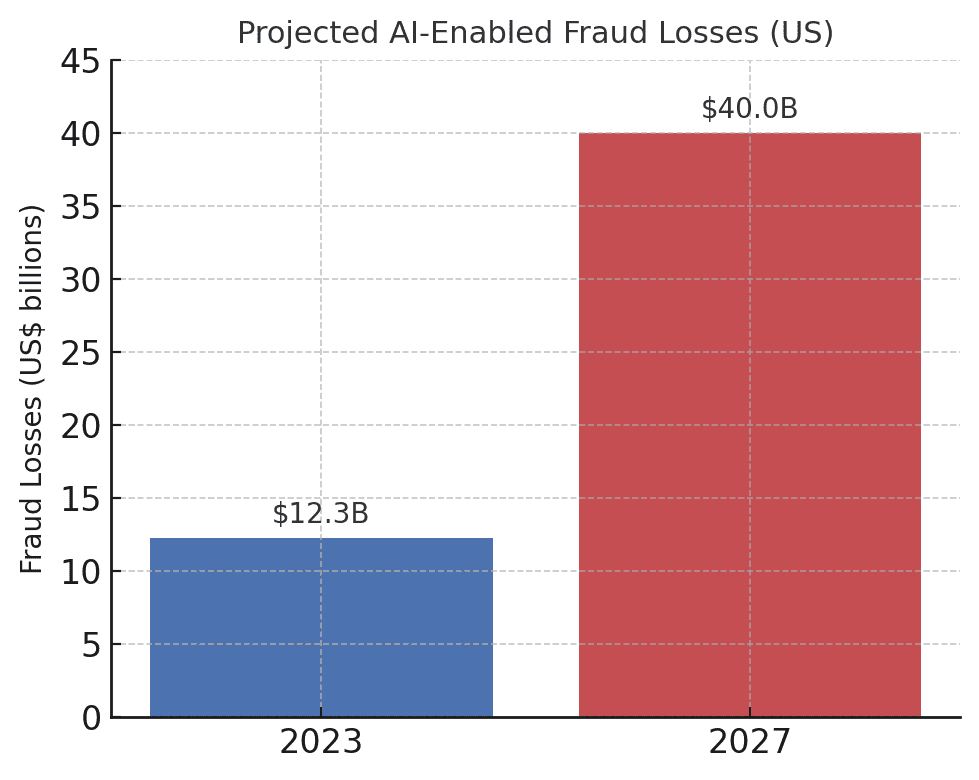

Tekoälypohjaisten petosten yleistyminen aiheuttaa ongelmia merkittävät vaikutukset rahoituslaitoksiin, niiden asiakkaisiin ja rahoitusjärjestelmään laajemmin. Välittömin vaikutus on rahallinen menetys. Alan ennusteiden mukaan vuoteen 2027 mennessä Generatiivisen tekoälyn mahdollistamat petostappiot voivat nousta $40 miljardiin Yhdysvalloissa., kun se vuonna 2023 oli $12,3 miljardia euroa.[20]. Tämä yli kolminkertainen kasvu (a 32% CAGR) kuvastaa sitä, kuinka nopeasti petosriski kasvaa dollareissa mitattuna.

Tekoälyyn perustuvien petosten ennustetut tappiot kasvavat dramaattisesti. Deloitte arvioi, että tekoälyyn liittyvien taloudellisten petosten aiheuttamat tappiot Yhdysvalloissa kasvavat vuodesta 2000 vuoteen 2020. $12,3 miljardista vuonna 2023 $40 miljardiin vuoteen 2027 mennessä.[20].

Raaka tappioiden lisäksi on olemassa maine- ja vahinkoja. luottamuskustannukset. Kuluttajat odottavat pankkiensa suojelevan heitä, mutta tekoälyä hyödyntävät huijaukset heikentävät luottamusta digitaalisiin kanaviin. Jos asiakas esimerkiksi joutuu vakuuttavan väärennetyn huijauksen (kuten väärennetyn pankkiirin videopuhelun) uhriksi, hän saattaa syyttää pankkia riittämättömästä turvallisuudesta. Yleinen luottamus äänivarmennuksessa, sähköposteissa ja jopa videoneuvotteluissa voi heikentyä, jos "sitä, mitä näkee/kuulee" ei enää voida pitää todellisena.[21]. Tutkimusten mukaan 85% Yhdysvaltojen ja Yhdistyneen kuningaskunnan rahoitusalan ammattilaisista pitää huijauksia "eksistentiaalisena" uhkana organisaationsa turvallisuudelle.[22]. Yli puolet näillä markkinoilla toimivista yrityksistä on ilmoittanut joutuneensa deepfake-huijauksen kohteeksi, ja hälyttävästi 43% kohteena olleista myönsi hyökkäyksen onnistuneen. huijaamalla heitä[23]. Jokainen onnistunut tapaus ei aiheuta ainoastaan taloudellista vahinkoa, vaan se myös murentaa asiakkaiden luottamusta laitokseen.

Rahoitusyritykset kamppailevat myös toiminnalliset ja sääntöjen noudattamiseen liittyvät haasteet tekoälypetoksilta. Petostentorjuntaryhmät joutuvat kohtaamaan hälytysten ja tapausten määrän kasvun, mikä rasittaa tutkintaresursseja. Nykyiset petosten havaitsemismallit (joista monet perustuvat sääntöihin tai vanhoihin koneoppimismenetelmiin) voivat olla vaikeuksissa tunnistamaan tekoälyn syntetisoimaa, lailliselta näyttävää sisältöä. Itse asiassa laboratorioissa kehitettyjen huipputason syväfake-tunnistusjärjestelmien tarkkuus laskee lähes 50%, kun ne joutuvat kohtaamaan seuraavat tekijät reaalimaailman väärennöksiä luonnossa[24]. Ihmishenkilöstö ei pärjää paljon paremmin - tutkimusten mukaan ihmiset pystyvät havaitsemaan korkealaatuisia deepfake-videoita vain noin kello ... 55%-60% ajasta, tuskin parempi kuin sattuma[25]. Tämä osoittaa, että ilman uusia työkaluja pankit eivät huomaa suurta osaa tekoälyyn perustuvista petosyrityksistä.

On myös sääntelyulottuvuus. Sääntelyviranomaiset ja lainvalvontaviranomaiset ovat hyvin tietoisia riskeistä (kuten FinCENin hälytys osoittaa), ja ne odottavat rahoituslaitosten sopeutuvan. Pankit saattavat joutua kohtaamaan tekoälyn aikakaudella tiukemmat ohjeet asiakkaiden todentamisesta ja petoksista ilmoittamisesta. Jos esimerkiksi pankin työntekijää huijataan deepfake-ohjelmalla hyväksymään $10 miljoonan euron siirto, sääntelyviranomaiset saattavat tutkia tarkkaan pankin valvontaa ja due diligence -prosesseja. . Pankkisalaisuuslaki sisältää nyt nimenomaisesti raportoinnin epäillystä tietoverkkorikollisuudesta ja deepfake-toiminnasta.[26][4], mikä tarkoittaa, että pankkien on koulutettava henkilökunta tunnistamaan tekoälyn tuottamat petosindikaattorit ja ilmoittamaan niistä epäilyttäviä toimintoja koskevissa raporteissa (SAR-raportit). Jos pankki ei pysy tekoälyä hyödyntävien petostekniikoiden perässä, se voi johtaa sääntöjen noudattamatta jättämiseen tai oikeudelliseen vastuuseen, jos asiakkaat tai vastapuolet väittävät, että pankki ei ole tehnyt tarpeeksi estääkseen ennakoitavissa olevat tekoälyä hyödyntävät huijaukset.

Ehkä suurin haaste on tämän uuden uhan epäsymmetrinen luonne. Generatiivinen tekoäly alentaa huomattavasti hyökkääjien kustannuksia ja taitoja ja lisää samalla räjähdysmäisesti hyökkäysten määrää ja realistisuutta. Yksittäinen virusperäinen deepfake-huhu tai vakuuttava äänikloonipuhelu voi tuhota miljoonien dollarien arvosta tehtyjä todennusinvestointeja. Samaan aikaan puolustajien on tarkistettava jokaisen tapahtuman ja vuorovaikutuksen aitous, mikä on paljon vaikeampi tehtävä. Kyseessä on todellinen asevarustelukilpailu: Tekoäly antaa petoksentekijöille itsestään päivittyvän työkalupakin, jonka avulla he voivat ohittaa tietoturvan, mikä edellyttää, että myös pankkien on jatkuvasti päivitettävä suojauksiaan.[15][27]. Monet rahoituslaitokset myöntävät, etteivät ne ole riittävästi valmistautuneet - yli 80%:llä yrityksistä ei ole virallista vastesuunnitelmaa väärennöshyökkäyksiä varten., ja yli puolet ei ole kouluttanut työntekijöitään deepfake-riskeistä.[28][29]. Tämä valmiusvaje tarkoittaa, että organisaatiot ovat tällä hetkellä haavoittuvaisia, mutta se osoittaa myös, missä tarvitaan toimia.

Huomattava ja raitistuttava mittari on peräisin alan tuoreesta raportista: 42,5% rahoitusalan petosyrityksistä liittyy nyt jonkinlaiseen tekoälyyn.[30]. Toisin sanoen lähes puolessa pankkien kohtaamista petoshyökkäyksistä on tekoälykomponentti - olipa kyseessä sitten tekoälyn luoma asiakirja, syntetisoitu ääni tai koneellisesti luotu phishing-viesti. Tämä tilasto korostaa, että tekoäly ei ole hypoteettinen tulevaisuuden uhka, vaan se on jo täällä ja pakottaa rahoituslaitokset sopeutumaan tai kohtaamaan kasvavia tappioita.

Puolustautuminen tekoälyyn perustuvia petoksia vastaan: Strategiat ja ratkaisut

Tekoälyyn perustuvien petosten torjunta edellyttää petostentorjuntastrategioiden kehittämistä. Perinteiset lähestymistavat (kuten manuaalinen todentaminen tai staattiset sääntömoottorit) eivät pärjää muuntuville tekoälyhuijauksille. Sen sijaan pankkien on omaksuttava technology (like making sure they have a Secure SSL Certificate), training, and teamwork kääntää vuoroveden. Seuraavassa esitellään keskeisiä strategioita ja uusia ratkaisuja:

- Hyödynnä tekoälyä tekoälyn torjumiseksi (kehittyneet havaintotyökalut): Rahoituslaitokset käyttävät yhä useammin Tekoälypohjaiset havaintoratkaisut tunnistaa tekoälyn tuottamaa sisältöä ja poikkeamia. Pohjimmiltaan sinun on torjuttava tulta tulella. Uudet yritystyökalut, kuten TruthScan tarjota monimodaalista tekoälyn tunnistusta tekstin, kuvien, äänen ja videon osalta, mikä auttaa sisällön todentamisessa reaaliajassa.[31]. Pankit voivat esimerkiksi ottaa käyttöön tekoälytekstin tunnistimia, joilla voidaan skannata saapuvaa viestintää (sähköpostit, chat-viestit) sellaisten tekoälyn luoman kielen merkkien varalta, jotka saattavat viitata phishing-sähköpostiin tai väärennettyyn asiakaskyselyyn. TruthScanin tekoälytekstin havaitsemisjärjestelmä voi tunnistaa tekoälyllä kirjoitetun sisällön malleista, kuten GPT-4:stä. 99%+ tarkkuus, ja jopa osoittaa, mitkä lauseet ovat todennäköisesti tekoälyn luomia.[32][33]. Vastaavasti tekoälyn kuvantutkimustyökalut voivat tarkistaa asiakirjoja ja kuvia. AI Image Detector voi merkitä, jos toimitettu ajokortti tai sähkölasku on digitaalisesti luotu tai manipuloitu, vertaamalla sitä tekoälyn tuottamien kuvien tunnettuihin kuvamalleihin.[34]. Pankit alkavat käyttää ääniuhkien varalta voice deepfake-ilmaisimet - ratkaisut, jotka analysoivat puheluääntä synteettisen puheen akustisten sormenjälkien löytämiseksi. Esimerkiksi TruthScanin AI Voice Detector kuuntelee äänikloonauksen paljastavia merkkejä, ja se voi myös tarkistaa puhujan aitouden estämään huijaripuhelut[35]. Integroimalla nämä ilmaisimet API:n kautta työnkulkuihinsa rahoituslaitokset voivat automaattisesti seuloa tekoälyä sisältävää sisältöä transaktioiden ja vuorovaikutuksen taustalta. Tämä tarjoaa ylimääräisen puolustuskerroksen, joka toimii koneen nopeudella ja havaitsee sen, mikä ihmissilmiltä tai -korvilta saattaa jäädä huomaamatta.

- Toteuta monitekijätodennus ja kaistan ulkopuolinen todentaminen: Koska tekoäly vaikeuttaa ääniin tai kuviin luottamista, pankkien olisi luotettava enemmän sellaisiin todentamismenetelmiin, joita tekoäly ei voi helposti väärentää. Tähän kuuluu monitekijätodennus (MFA), jossa käytetään suojattuja kanavia. Jos esimerkiksi tilisiirtopyyntö tulee sähköpostitse tai videopuhelun välityksellä, vaaditaan toinen tekijä, kuten kertakäyttökoodi, joka lähetetään pyynnön esittäjän tunnettuun mobiililaitteeseen, tai takaisinsoitto tiedostoon tallennettuun luotettavaan puhelinnumeroon. Jotkin pankit lisäävät "elävyystarkistuksia" korkean riskin tapahtumiin - esimerkiksi pyytämällä asiakasta ottamaan selfie-kuvan suorassa lähetyksessä tietyllä eleellä tai sanalla, jota väärennetyn videon on vaikeampi kopioida. Biometrisiä tunnistuslaitteita voidaan parantaa väärentämisen estävillä toimenpiteillä (esim. kasvojen 3D-syvyyden skannaaminen tai silmien hienovaraisten liikkeiden seuranta, joita väärennökset eivät useinkaan pysty jäljittelemään).[27]). Tärkeintä on välttää yksittäisiä vikapisteitä. Vaikka tekoälyllä voidaan huijata yhtä kanavaa (esimerkiksi äänitarkistusta), koordinoitu kaistan ulkopuolinen tarkistus tai biometrinen testi voi tarjota tarvittavan haasteen petoksen paljastamiseksi. Nollaluottamusperiaatteet olisi sovellettava: kaikkia pyytämättä annettuja tai odottamattomia ohjeita (jopa "tunnetulta" johtajalta tai asiakkaalta) on pidettävä epäilyttävinä, kunnes ne on tarkistettu riippumattoman kanavan kautta.

- Työntekijöiden koulutus ja petostietoisuus: Pelkkä teknologia ei ole hopealuoti - varsinkaan, koska huijarit ottavat kohteekseen heikoimman lenkin, joka on usein ihmisten luottamus. Rahoituslaitosten olisi investoitava petostentorjuntaryhmien ja etulinjan henkilöstön säännölliseen koulutukseen tekoälyyn perustuvista huijauksista. Työntekijöiden on opittava tunnistamaan väärennösten ja sosiaalisen manipuloinnin punaiset liput. Tähän voi kuulua koulutusta hienovaraisista poikkeavuuksista (esim. huulisynkronointiongelmat videopuhelussa tai ääni, joka sisältää epäluonnollista intonaatiota tai liian vähän taustahälyä - mahdollisia merkkejä synteettisestä äänestä). Rohkaise kulttuuria, jossa todentaminen: Työntekijöillä pitäisi olla valtuudet keskeyttää epäilyttävä liiketoimi tai pyyntö ja tarkistaa se itsenäisesti, vaikka se näyttäisi tulevan toimitusjohtajalta. Tapaus Ferrarin toimitusjohtajan ääni väärennösyritys on opettavainen - toimeenpaneva virkamies paljasti huijauksen vain kysymällä henkilökohtaisen kysymyksen, johon huijari ei pystynyt vastaamaan.[36]. Myös simuloidut phishing/syväpetos-harjoitukset voivat olla hyödyllisiä. Aivan kuten yritykset tekevät phishing-simulaatioita kouluttaakseen henkilökuntaa, ne voivat simuloida väärennettyä ääniviestiä tai väärennettyä videokokousta ja katsoa, havaitsevatko työntekijät sen. Tämä kehittää lihasmuistia todellisten hyökkäysten torjumiseksi. Koska yli 50% yrityksistä ei ole käytössä minkäänlaisia deepfake-reaktioprotokollia eikä juurikaan koulutusta.[29], tällaisten ohjelmien käynnistäminen on helppo keino parantaa vastustuskykyä.

- Petosanalytiikka ja poikkeamien havaitseminen: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier kuulostaa tekoälyn luomalta tai liian kaavamainen (yhdistettynä aiemmin mainittuun tekoälytekstin havaitsemiseen). Pankit, kuten JPMorgan, ovat alkaneet käyttää suuria kielimalleja sisäisessä viestinnässään havaitakseen lauseita tai asiayhteyksiä, jotka saattavat viitata sosiaalisen suunnittelun yritykseen.[37]. Maksuverkostot, kuten Mastercard, tutkivat tekoälyn avulla laajoja tietokokonaisuuksia (miljardeja maksutapahtumia) ja tunnistavat petolliset maksutapahtumat, jotka perinteiset säännöt jäisivät huomaamatta.[38]. Lopputulos on, että puolustava tekoäly on oltava yhtä innovatiivinen kuin hyökkäävä tekoäly. Yritysten tulisi harkita tekoälymallien kehittämistä tai hankkimista erityisesti väärennetyn sisällön, synteettisten identiteettien ja generatiivisten hyökkäysmallien havaitsemiseen. Tärkeintä on, että näitä malleja koulutetaan jatkuvasti uusimpien tekoälypetosten esimerkkien perusteella (tätä kutsutaan verkko-oppimiseksi tai yhdistetyksi oppimiseksi), jotta ne pysyvät rikollisten nopeasti kehittyvien taktiikoiden tahdissa.[39][40].

- Yhteistyö ja tietojen jakaminen: Tekoälyyn perustuvien petosten torjunta edellyttää yhteistyötä sekä laitosten sisällä että niiden välillä. Siiloutuneet toimet eivät ole yhtä tehokkaita organisaatiorajat ylittävää uhkaa vastaan. Petostentorjuntaryhmät, tietoverkkoturvaryhmät ja tietotekniikkaryhmät. on työskenneltävä käsi kädessä - esimerkiksi tietoturvatiimit voivat käyttää väärennösten tunnistusta videoneuvottelutyökaluissa, kun taas petostentorjuntatiimit voivat integroida sisällön skannauksen tapahtumien seurantaan. Laajemmalla tasolla pankkien olisi osallistuttava alan ryhmiin, kuten Financial Services Information Sharing and Analysis Centeriin (FS-ISAC), jotta ne voivat vaihtaa tietoja uusista tekoälypetosjärjestelmistä.[41]. Jos yksi pankki löytää uudenlaisen deepfake-hyökkäysvektorin, sen jakaminen voi auttaa muita pankkeja kuromaan umpeen kuilun, ennen kuin ne joutuvat hyökkäyksen kohteeksi. Yhteisiä harjoituksia tai "punaisen ryhmän" simulaatioita, joissa on tekoälyä sisältäviä skenaarioita (esim. deepfake executive -huijaus tai tekoälyllä luotu henkilöllisyyden todentamisen ohitus), voidaan toteuttaa alan yhteenliittymien kautta tai sääntelyn tuella. Sääntelyviranomaiset itse keskittyvät tekoälyriskeihin, joten on viisasta toimia niiden kanssa ennakoivasti. Osallistumalla tekoälyn käyttöä koskevien standardien ja ohjeiden laatimiseen pankit voivat auttaa muokkaamaan turvallisempaa ekosysteemiä. Viime kädessä, koska uhka yhdelle pankille on uhka kaikille. tässä tilassa[42], kollektiivinen puolustusmalli vahvistaa kaikkien kykyä havaita ja estää tekoälyyn perustuvat petokset.

- Asiakaskoulutus ja luottamustoimenpiteet: Rahoituslaitosten ei pitäisi myöskään unohtaa asiakkaiden tietoisuuden merkitystä. Koska deepfakes- ja tekoälyhuijaukset kohdistuvat suurelle yleisölle (esimerkiksi tekoälyn tuottamat väärennetyt äänet isovanhempien huijauksissa tai tekoälyn tuottamat valheelliset "teknisen tuen" chatit), pankit voivat auttaa valistamaan asiakkaita näistä vaaroista. Monet pankit lähettävät jo nyt varoituksia tietojenkalastelusta; ne voivat laajentaa näitä varoituksia mainitsemalla tekoälyn äänikloonauksen ja deepfake-videot ja antamalla vinkkejä pyyntöjen tarkistamisesta. Jotkut edistykselliset organisaatiot lähettävät push-ilmoitukset tai varoituksia sovelluksissaan, jos tiedossa on huijaus (esim. "Varo: huijarit saattavat käyttää perheenjäsenten ääniklooneja pyytääkseen rahaa").[43]. Vaikka koulutus ei suoranaisesti estä hyökkäyksiä, se voi vähentää onnistumisprosenttia ja vahvistaa sitä, että pankki on yhteistyökumppani turvallisuudessa. Lisäksi pankkien, jotka investoivat huippuluokan petostentorjuntaan, olisi korostettava tätä asiakkaille. erottaja - Jos asiakkaille esimerkiksi kerrotaan, että tekoäly skannaa kaikki videopuhelut tai toimitetut asiakirjat aitouden varmistamiseksi (paljastamatta arkaluonteisia menetelmiä), asiakkaat voivat vakuuttua siitä, että pankki käyttää kaikkia käytettävissä olevia välineitä heidän suojaamiseensa. Digitaalisen luottamuksen säilyttäminen on ratkaisevan tärkeää, jotta pankit voivat hyödyntää tekoälyn edut palveluissa täysimääräisesti, joten läpinäkyvyys ja asiakaslähtöiset suojatoimet ovat osa kokonaisvaltaista puolustusta.

Tekoälyn sisällöntunnistuspalvelujen rooli

Tekoälyn aikakauden petostentorjunnan työkalupakissa kulmakiviä ovat Tekoälyn sisällöntunnistuspalvelut. Nämä palvelut ovat erikoistuneet havaitsemaan tekoälyn tuottaman sisällön "sormenjäljet", jotka saattavat livahtaa ohi ihmisten tarkastajien. TruthScan on yksi tällainen palveluntarjoaja, joka tarjoaa yritystason AI Detection Suite jotka kattavat useita sisältötyyppejä. Rahoituslaitokset voivat integroida nämä työkalut väärennösten ja petosten automaattiseen seulontaan:

- Asiakirjojen ja kuvien todentaminen: TruthScanin alustan avulla pankit voivat testata rahoitusasiakirjoja tekoälyn tuottamien petosten varalta reaaliajassa.[44]. Tämä tarkoittaa, että kun uusi tili avataan tai lainahakemus saapuu kuvallisen henkilöllisyystodistuksen ja palkkakuitin kanssa, järjestelmä voi välittömästi analysoida kuvat synteettisen luomisen tai väärentämisen merkkien varalta. Yli 99%:n tavoitetarkkuus[45], AI Image Detector voi havaita väärennetyt henkilökorttikuvat tai väärennetyt PDF-tiedostot, jotka ihminen saattaisi hyväksyä sellaisenaan. Tällainen asiakirjan aitouden todentaminen on ratkaisevan tärkeää synteettisten identiteettipetosten estämiseksi ennen kuin tilejä edes avataan.

- Reaaliaikainen tapahtumien seuranta: Ottamalla käyttöön API-integraatioita TruthScan voi kytkeytyä pankkien tapahtumankäsittelyyn ja merkitä poikkeavuudet. reaaliaikainen. Jos sähköpostitse tulee epäilyttävältä vaikuttava ohje, Email Scam Detector voi analysoida viestin sisällön ja havaita, onko sen todennäköisesti kirjoittanut tekoälymalli, joka yrittää huijata myyjää tai johtajaa.[46]. Samoin Reaaliaikainen tekoälyilmaisin voi valvoa suoraa viestintää (kuten keskusteluja tai yhteistyöalustoja) ja antaa välittömiä hälytyksiä, jos vaikkapa korkean panoksen kokouksessa havaitaan väärennetty deepfake-videosyöte.[47][48]. Jatkuva seuranta, välittömät hälytykset ja automaattiset reaktiot auttavat pienentämään aikaa, jolloin petos voi tapahtua huomaamatta.

- Puhe- ja videoväärennösten torjunta: Puhelinkeskuksille ja asiakassuhteiden hoitajille TruthScanin sisältämien AI Voice Detector lisää ylimääräisen turvakerroksen. Jos huijari soittaa ja esiintyy asiakkaana äänikloonin avulla, järjestelmä voi analysoida puhelun äänen ja merkitä, jos se sisältää tekoälyn syntetisoimia elementtejä (kuten puuttuvia luonnollisia mikrotaukoja tai artefakteja ääniaalloissa).[35]. Videorintamalla Deepfake-ilmaisin soveltaa tietokonenäköalgoritmeja videokuviin havaitakseen epäjohdonmukaisuudet - kuten luonnottomat kasvojen liikkeet, outo valaistus tai huulisynkronointi - jotka paljastavat väärennöksen.[49][50]. Varmentamalla äänten ja kasvojen eheyden keskeisissä vuorovaikutustilanteissa pankit voivat estää huijareita, jotka yrittävät huijata työntekijöitään. Nämä työkalut toimivat kuin digitaalisen sisällön valheenpaljastin, joka toimii näkymättömästi taustalla.

On syytä huomata, että tällaisen havaintotekniikan käyttöönotto ei ole mikään "plug-and-play"-parannuskeino, vaan se on kalibroitava ja viritettävä laitoksen työnkulkuihin. Vääriä positiivisia tuloksia on hallittava (esimerkiksi tekoälytekstin tunnistin saattaa merkitä mallipohjaisen laillisen viestinnän epäilyttäväksi, kunnes se oppii eron). Oikein integroituna nämä työkalut parantavat kuitenkin huomattavasti organisaation kykyä toimia seuraavasti havaita vilpillinen sisältö ennen kuin se aiheuttaa vahinkoa. Ne tuottavat myös kirjausketjuja ja analyyttisiä raportteja, jotka ovat hyödyllisiä sääntöjen noudattamisen ja petosmallien jatkuvan parantamisen kannalta.

Tekoälyn havaitsemisvälineiden tehokkuus riippuu ennen kaikkea seuraavista tekijöistä jatkuvat päivitykset. Aivan kuten virustorjuntaohjelmistot tarvitsevat uusia allekirjoituksia uusia viruksia varten, tekoälyilmaisimet tarvitsevat uudelleenkoulutusta uusimpiin deepfake-tekniikoihin ja tekoälymalleihin. TruthScanin kaltaiset toimittajat päivittävät algoritmejaan käsittelemään uusia generatiivisia malleja ja kiertotaktiikoita ja säilyttämään korkean tarkkuuden tekoälyn kehittyessä.[51]. Tämä keventää sisäisten tiimien taakkaa ja varmistaa, että pankit eivät taistele eilisen sotaa vastaan rikollisten siirtyessä uusiin tekoälytemppuihin.

Päätelmä

Rahoituspalveluala on risteyskohdassa petosten torjunnassa. Toisaalta rikolliset hyödyntävät nopeasti generatiivista tekoälyä, jonka avulla he voivat toteuttaa entistä vakuuttavampia ja laajempia huijauksia. Toisaalta pankeilla ja petostentorjujilla on käytössään yhä laajeneva arsenaali tekoälyyn perustuvia torjuntakeinoja. Ne laitokset, jotka menestyvät, ovat niitä, jotka tunnistaa uusi uhkakuva ja vastata siihen yhtä nerokkaasti.. Tämä tarkoittaa investointeja kehittyneisiin havaitsemisvalmiuksiin, monikerroksisten tarkastusprosessien integrointia, henkilöstön ja asiakkaiden kouluttamista sekä valppaan ja mukautuvan toimintakulttuurin edistämistä.

Tekoälyä hyödyntävä petos on nopeasti muuttuva kohde - tänään yritystä huijannut deepfake-huijaus saatetaan huomenna torjua uusilla havaitsemistekniikoilla, ja huijarit voivat muuttaa menetelmiään jo ensi viikolla. Näin ollen vuonna 2025 "alan standardi" petostentorjuntastrategia on sellainen, jossa korostetaan ketteryyttä ja jatkuvaa parantamista. Rahoitusorganisaatioiden tulisi kohdella petostentorjuntajärjestelmiään eläviä, oppivia kokonaisuuksia jotka kehittyvät samaan aikaan rikollisten taktiikoiden kanssa. Kumppanuuksien hyödyntäminen teknologiatoimittajien kanssa on älykäs tapa rakentaa näitä valmiuksia. Esimerkiksi yhteistyö TruthScanin kaltaisten erikoistuneiden yritysten kanssa (joka tarjoaa pankki- ja rahoitusalalle räätälöityjä ratkaisuja) voi nopeuttaa laitoksen kykyä toimia seuraavasti ehkäistä tekoälyyn perustuvia petoksia säilyttäen samalla sääntelyn noudattaminen ja asiakkaiden luottamus.[52].

Viime kädessä tekoälyyn perustuvilta petoksilta suojautumisessa ei ole kyse vain teknologiasta, vaan myös perustavanlaatuisen luottaa joka on rahoituksen perusta. Asiakkaat tarvitsevat luottamusta siihen, että heidän pankkinsa pystyy erottamaan aidon transaktion väärennöksestä ja oikean asiakkaan tekoälyn huijarista. Rahoituspalveluyritykset voivat ylläpitää tätä luottamusta ottamalla käyttöön huippuluokan tekoälyn tunnistustyökaluja, vahvistamalla varmennusprotokollia ja pysymällä uusien uhkien edellä. Tulevaisuudessa vastustajat yrittävät epäilemättä yhä enemmän petosinnovaatioita, mutta valmistautumisen ja oikeiden investointien avulla pankit voivat varmistaa, että Tekoälystä tulee enemmän etu kuin uhka petostentorjunnan alalla. Tavoite on saavutettavissa: samat tekoälyteknologiat, jotka uhkaavat aiheuttaa häiriöitä, voidaan valjastaa rahoitusjärjestelmämme eheyden turvaamiseen. Nyt on petostentorjuntaryhmien ja C-tason johtajien aika toimia päättäväisesti, kehittyneiden ratkaisujen ja strategioiden käyttöönotto huijareiden päihittämiseksi. ja turvata digitaalisen rahoituksen tulevaisuus.

Lähteet: Viimeaikaisiin toimialaraportteihin, sääntelyä koskeviin varoituksiin ja teknologiajulkaisuihin on viitattu kautta linjan (Deloitte[20][18], Maailman talousfoorumi[19][24], Yhdysvaltain valtiovarainministeriö FinCEN[3][4], Federal Reserve[13], Keepnet Labs[16][30], muun muassa) tietojen ja esimerkkien antamiseksi. Kaikki tiedot ja esimerkit mainitaan rivissä, jotta lukijat voivat tutkia asiaa tarkemmin.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake-pankkitoiminta ja tekoälypetosriski | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Vaarallisen tekoälyn havaitseminen on tärkeää väärennösten aikakaudella | World Economic Forum

[3] [4] [26] FinCEN julkaisee varoituksen rahoituslaitoksiin kohdistuvista Deepfake Mediaa käyttävistä petosjärjestelmistä | FinCEN.gov

[7] [8] FraudGPT ja GenAI: Miten huijarit käyttävät tekoälyä seuraavaksi? | Alloy

[11] Synteettinen identiteettipetos: Federal Reserve Bank of Boston - Bostonin keskuspankki

[12] [13] Generatiivinen tekoäly lisää synteettisten identiteettipetosten uhkia

[16] [17] [22] [23] [28] [29] [30] Deepfake-tilastot ja trendit 2025 | Avaintiedot ja -katsaukset - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Yritysten tekoälyn havaitseminen ja sisällön suojaus

[32] [33] [51] AI Detector: Yritysluokan tekoälytekstin tunnistus - TruthScan

[44] [45] [52] Pankkitoiminnan tekoälypetosten havaitseminen | CRO Solutions | TruthScan

[49] [50] Deepfake Detector - Tunnista väärennetyt ja tekoälyvideot - TruthScan