Kattava opas tekoälyn äänipetosten ymmärtämiseen, havaitsemiseen ja ehkäisemiseen yrityksissä.

$25 miljoonan äänipuhelu, jota ei koskaan tapahtunutkaan

Helmikuussa 2024 Hongkongissa sijaitsevan monikansallisen yrityksen taloushallinnon työntekijä sai videopuhelun talousjohtajaltaan.

Toisessa päässä oleva ääni oli erehtymättömän kuuloinen; jokainen äänensävy, jokainen tauko ja jopa lievä aksentti tunnistettiin välittömästi.

Hän pyysi häntä kiireellisesti käsittelemään 15 tilisiirtoa, joiden yhteismäärä oli $25 miljoonaa euroa, luottamuksellisen yrityskaupan loppuunsaattamiseksi.

Älä enää koskaan ole huolissasi tekoälypetoksista. TruthScan Voi auttaa sinua:

- Tunnista AI luotu kuvat, teksti, ääni ja video.

- Vältä merkittävä tekoälyyn perustuva petos.

- Suojaa kaikkein herkkä yrityksen omaisuuserät.

Talousjohtaja ei koskaan tehnyt tätä puhelua. Se oli täysin tekoälyn luoma.

Tämä ei ollut yksittäistapaus. Rahoituslaitokset ovat havainneet deepfake-petosten jyrkkää kasvua.

Kolmen viime vuoden aikana tapaukset ovat lisääntyneet 2137%:llä, ja tekoäly aiheuttaa nyt 42,5% kaikista alan petosyrityksistä.

Vaikka tekoälyn äänihuijaukset ovat lisääntyneet, yli puolet yritysjohtajista myöntää, että heidän työntekijöitään ei ole koulutettu havaitsemaan deepfake-hyökkäyksiä tai reagoimaan niihin; lähes 80% yrityksistä ei ole käyttänyt virallisia protokollia näiden tapausten käsittelemiseksi.

Miten tekoälyn äänikloonaus toimii ja miksi se on uhka?

Nykyaikainen tekoälyn äänisynteesi tarvitsee yllättävän vähän dataa. Jo muutaman sekunnin ääni voi kloonata äänen jopa 85%:n tarkkuudella.

Prosessi koostuu kolmesta päävaiheesta:

- Tiedonkeruu: Huijarit keräävät ääninäytteitä julkisista lähteistä, kuten konferenssipuheluista, podcast-haastatteluista, sosiaalisen median pätkistä tai jopa LinkedIn-videopostauksista.

- Malliharjoittelu: Tekoäly analysoi äänenkorkeuden, äänensävyn, aksentin, tahdin ja hengitysmallin kaltaisia ääniominaisuuksia.

- Sukupolvi: Järjestelmä luo synteettistä puhetta, joka on tarpeeksi vakuuttavaa huijatakseen jopa läheisiä kollegoita.

Saavutettavuusongelma

Tämän uhan tekee entistäkin vaarallisemmaksi sen demokratisoituminen. Huijarit eivät enää tarvitse Hollywood-tason resursseja.

Avoimen lähdekoodin työkalut ja pilvipohjaiset tekoälypalvelut ovat tuoneet äänen kloonauksen kenen tahansa saataville, jolla on tekniset perustaidot.

Miksi johtajat ovat petosten ensisijaisia kohteita?

Johtajat kohtaavat vaarallisen yhdistelmän riskitekijöitä.

Heidän julkinen näkyvyytensä sosiaalisessa mediassa tekee ääninäytteistä helposti löydettäviä, ja heidän auktoriteettinsa saa työntekijät usein toimimaan nopeasti kiireellisten pyyntöjen suhteen.

Keskimäärin yksi neljästä johtajasta ymmärtää vain vähän deepfake-teknologiaa.

Nykyiset tilastot antavat huolestuttavan kuvan

A 2024 Deloitten tutkimus25,9% johtajista ilmoitti, että heidän organisaationsa oli kohdannut vähintään yhden talous- tai kirjanpitotietoihin kohdistuneen väärennöshyökkäyksen viime vuoden aikana, ja puolet vastaajista uskoi tällaisten hyökkäysten lisääntyvän seuraavien 12 kuukauden aikana.

Huolestuttavinta on, että vain 52% organisaatiosta luottaa siihen, että he voisivat havaita toimitusjohtajastaan tehdyn väärennöksen.

Kuinka havaita AI Voice -huijaukset

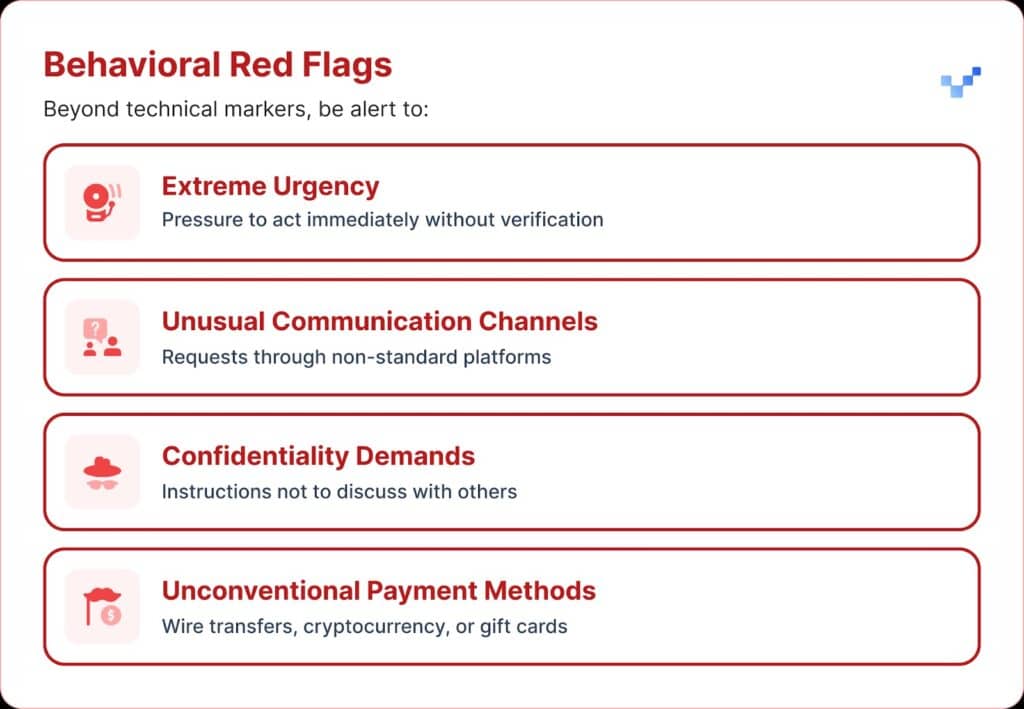

Kun saat epäilyttävän ääniviestin, on olemassa muutamia varoitusmerkkejä, joita kannattaa tarkkailla.

Tekoälyn äänihuijaukset kuulostavat usein monotonisilta tai latteilta. Saatat myös huomata epätavallisen tahdin, jossa on outoja taukoja tai epäluonnollinen rytmi.

Äänessä voi olla myös heikkoa elektronista surinaa tai kaikuja, erityisesti pidempien puheluiden aikana.

Monissa tapauksissa ääni toistaa rajoitettuja lauseita, jotka vaikuttavat käsikirjoitetuilta tai harjoitelluilta.

Taloudelliset vaikutukset ja todelliset kustannukset

Useimmat organisaatiot menettivät keskimäärin noin $450 000, mutta rahoituspalvelualalla tappiot nousivat yli $603 000:een.

Vakavimmissa tapauksissa yksi kymmenestä organisaatiosta ilmoitti yli $1 miljoonan euron tappioista.

Tämä suuntaus on kasvanut nopeasti. Aiemmassa, vuonna 2022 tehdyssä tutkimuksessa todettiin, että identiteettipetoksesta aiheutuva keskimääräinen taloudellinen rasite oli noin $230 000, mikä on lähes puolet nykyisestä luvusta.

Ennakoidut tulevat tappiot

Deloitten rahoituspalvelukeskuksen mukaan tekoälypetosten vuoksi Yhdysvalloissa menetetyt varat voivat nousta $12,3 miljardista eurosta $40 miljardiin euroon vuonna 2023 ja $40 miljardiin euroon vuoteen 2027 mennessä. Se on noin 32% kasvua vuosittain.

Alueellinen haavoittuvuus

Pohjois-Amerikassa deepfake-petosten määrä kasvoi 1740%.

Tämä merkittävä alueellinen kasvu viittaa siihen, että Pohjois-Amerikka saattaa olla deepfake-huijaajien ensisijainen kohde, mikä johtuu todennäköisesti sen suuresta digitaalisesta taloudesta ja verkkopalvelujen laajasta käytöstä.

Strategiset lähestymistavat johtajien suojeluun

1. Tarkastusprotokollien käyttöönotto

Yksi tapa vahvistaa suojausta on käyttää "turvasanajärjestelmää", joka koostuu ennalta sovituista todennuslausekkeista, jotka jaetaan avainhenkilöiden kanssa.

Tekoälyn äänikloonausta käyttävä huijari ei tiedä oikeita vastauksia henkilökohtaisiin varmistuskysymyksiin.

Toinen suojatoimi on monikanavainen todentaminen.

Kaikki epätavalliset rahoituspyynnöt on vahvistettava erillisen viestintäkanavan kautta, eikä koskaan saa luottaa vain alkuperäiseen yhteydenottotapaan.

Yritysten olisi myös laadittava selkeät eskalointisäännöt, joihin sisältyy odotusaikoja ja hyväksymisvaiheita suurille rahoitustapahtumille riippumatta siitä, kuka niitä pyytää.

2. Ole tarkkana digitaalisesta valotuksesta

Toinen suojauskeino on rajoittaa, kuinka paljon johtajien ääni- ja videomateriaalia on saatavilla verkossa. Mitä enemmän näytteitä huijarit voivat kerätä, sitä vakuuttavammiksi heidän klooninsa tulevat.

On myös hyödyllistä laatia selkeät sosiaalisen median ohjeet johtajille, erityisesti sellaisten videoiden lähettämisen osalta, joissa on puhdas ääni.

Konferensseissa organisaatioiden on syytä varoa nauhoitettuja puheita tai haastatteluja, joissa ääninäytteitä annetaan pitkiä pätkiä.

3. Teknisten ratkaisujen käyttöönotto

Tässä vaiheessa kehittynyt tekoälyn havaitsemisteknologia on ratkaisevan tärkeää.

Organisaatiot tarvitsevat yritystason äänitunnistusta ja deepfake-tunnistus valmiudet, jotka tarjoavat:

- Reaaliaikainen analyysi: Synteettisten äänten havaitseminen suoran viestinnän aikana

- Historiallinen todentaminen: Analysoi nauhoitetut puhelut ja viestit aitouden varmistamiseksi

- Integrointikyvyt: Toimii saumattomasti nykyisten viestintäalustojen kanssa

- Korkea tarkkuusaste: Minimoi vääriä positiivisia tuloksia ja nappaa kehittyneet väärennökset.

4. Kattavat koulutusohjelmat

Johtoryhmät tarvitsevat kohdennettua koulutusta tekoälyn ääniuhkista ja todentamismenettelyistä.

Yhtä tärkeää on lisätä työntekijöiden tietoisuutta.

Jokaisella, missä tahansa roolissa tahansa, pitäisi olla valmiudet tunnistaa mahdolliset väärennökset ja estää kyberuhkien pääsy organisaatioon.

Tätä valmiutta voidaan vahvistaa säännöllisillä simulaatioharjoituksilla, joissa testataan ja tarkennetaan reagointimenettelyjä äänipetosyritysten avulla.

Kehittyneet AI-äänentunnistusratkaisut

Perinteiset suojausjärjestelmät on rakennettu verkkopohjaisia uhkia varten, ei tekoälyn avulla tapahtuvaa ihmisen esittämistä varten.

Tärkeimmät syyt siihen, että tavanomaiset kyberturvallisuustyökalut eivät pysty puuttumaan äänipohjaiseen sosiaaliseen manipulointiin:

- Ei haittaohjelman allekirjoitusta: Äänipuhelut eivät käynnistä perinteisiä turvajärjestelmiä

- Ihmisen luottamustekijä: Ihmiset luottavat luonnostaan siihen, mitä he kuulevat, erityisesti tuttuihin ääniin.

- Tunnistusteknologian puutteet: Huolimatta tekoälyyn perustuvien petosyritysten, kuten väärennösten, lisääntymisestä vain 22% rahoituslaitoksista on ottanut käyttöön tekoälyyn perustuvia petostentorjuntatyökaluja.

Erikoistuneen äänentunnistuksen tarve

Nykyaikaiset puhepetokset edellyttävät nykyaikaisia havaitsemisominaisuuksia.

Yritystason AI-äänentunnistusjärjestelmät voi:

- Analysoi äänen biomarkkereita: Hienovaraisen epäjohdonmukaisuuden havaitseminen synteettisessä puheessa

- Reaaliaikainen käsittely: Välittömät hälytykset epäilyttävien puhelujen aikana

- Jatkuva oppiminen: Sopeutuminen uusiin äänisynteesitekniikoihin

- Integraatiovalmis: Työskentely olemassa olevan viestintäinfrastruktuurin kanssa

Organisaatioiden, jotka haluavat tosissaan suojautua puhepetoksilta, on investoitava tarkoitusta varten kehitettyyn tekoälyn tunnistusteknologiaan, joka vastaa niiden kohtaamien uhkien kehittyneisyyttä.

Voice Fraud on nyt täällä, ja se on kasvussa.

Vuoden 2025 ensimmäisellä vuosineljänneksellä deepfake-petokset ja identiteettivarkaudet aiheuttivat yli $200 miljoonan euron tappiot.

Tekoälykloonien avulla tapahtuva puhehuijaus lisääntyi 442%, ja yli 400 yritystä päivässä joutuu tekaistujen toimitusjohtajien tai talousjohtajien huijausten kohteeksi.

Vaikka 56% yrityksistä sanoo olevansa hyvin luottavaisia väärennösten havaitsemisessa, vain 6% yrityksistä on tosiasiassa välttänyt taloudelliset tappiot.

Ratkaisevaa ei ole se, joutuuko organisaatiosi hyökkäyksen kohteeksi, vaan se, oletko valmis siihen.

Puhepetokset muuttavat tietoverkkoturvallisuutta. Perinteiset suojausmenetelmät eivät pysy tekoälyllä toimivan henkilöitymisen perässä.

Suojautuakseen organisaatiot tarvitsevat parempia havaintovälineitä, vahvoja koulutusohjelmia ja selkeitä todentamismenettelyjä.

Teknologia vastaiskuun on jo olemassa. Todellinen kysymys on, käytätkö sitä ennen ensimmäistä äänipetostapausta vai sen jälkeen.