Introducción: Una nueva era de ataques basados en IA

El año 2025 ha marcado un punto de inflexión en la ciberseguridad. La IA generativa ha potenciado los ciberataques, permitiendo a los actores de amenazas lanzar más... frecuentes, realistas y ampliables que nunca. De hecho, se calcula que el año pasado 16% de los incidentes cibernéticos notificados implicaban a atacantes que utilizaban herramientas de IA (por ejemplo, modelos de generación de imágenes y lenguaje) para mejorar la ingeniería social[1]. Desde los correos electrónicos de phishing ultraconvincentes hasta las estafas con audio y vídeo falsificados, los delincuentes están utilizando la inteligencia artificial en todos los sectores. La mayoría de los profesionales de la seguridad atribuyen la aumento de los ciberataques a la IA generativaque ofrece a los delincuentes formas más rápidas e inteligentes de explotar a las víctimas.[2]. La IA generativa está bajando el listón de la ciberdelincuencia al tiempo que aumenta su potencia.

¿Por qué es tan preocupante? La IA puede producir al instante contenidos sofisticados y adaptados al contexto que engañan incluso a usuarios entrenados. Puede hacerse pasar por voces y rostros con una precisión aterradora, e incluso generar código malicioso que se transforma para eludir la detección. Como resultado, los ciberataques son ahora más difíciles de detectar y más fáciles de ejecutar. El sitio Foro Económico Mundial advierte de que 72% de las organizaciones han visto aumentar los riesgos cibernéticos -especialmente la ingeniería social y el fraude- debido a las crecientes capacidades de la IA generativa.[3]. Los incidentes del mundo real lo confirman: A principios de 2024, los delincuentes utilizaron una IA generada videollamada deepfake hacerse pasar por el director financiero de una empresa y engañar a un empleado para que transfiera $25,6 millones a los defraudadores[4]. Y en otro caso, hackers norcoreanos utilizaron Documentos de identidad falsos generados por IA para eludir los controles de seguridad en una campaña de phishing defensiva[5]. Estos ejemplos ponen de relieve lo que está en juego: la IA generativa está permitiendo estafas que eluden los controles humanos y técnicos.

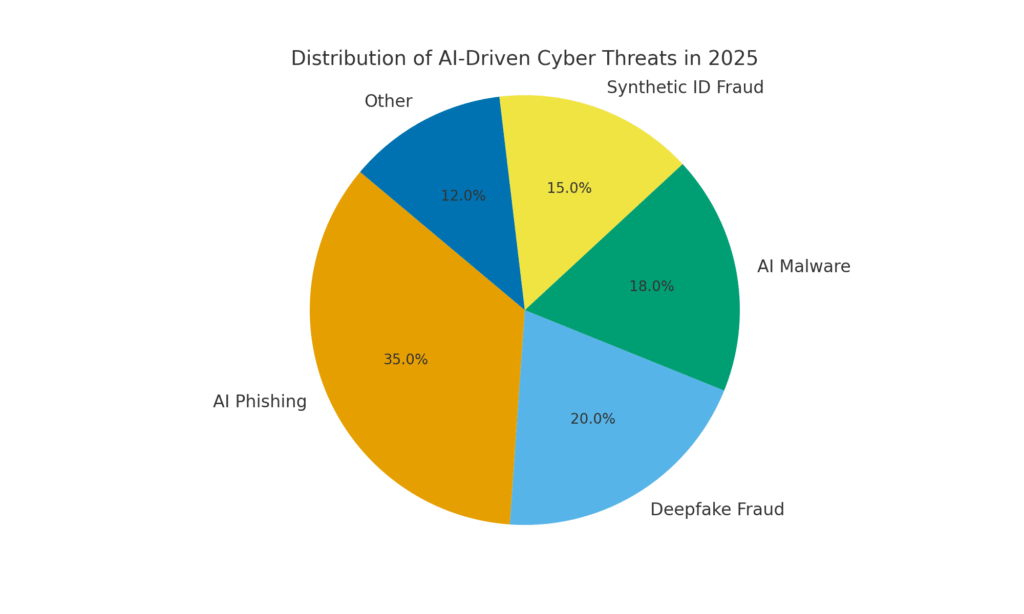

Sin embargo, la IA también forma parte de la solución. Las herramientas de detección avanzadas (como las de TruthScan) utilizan IA contra IA: análisis de contenidos en busca de las sutiles firmas de la generación de máquinas. En este informe técnico, examinaremos las principales ciberamenazas impulsadas por IA de 2025 y cómo pueden mitigarlas las organizaciones. En Phishing generado por IA a fraude del CEO de deepfake, Malware creado con IA, identidades sintéticasExploraremos cómo la IA generativa está dando nueva forma a los ataques. También discutiremos medidas defensivas concretas, incluyendo Detección de contenidos mediante IAy tecnologías de verificación de identidad que pueden ayudar a los equipos de seguridad a recuperar la ventaja. El objetivo es explicar cómo las empresas, los MSSP, los CISO y los investigadores del fraude pueden integrar herramientas de detección de IA en toda su pila de ciberseguridad para contrarrestar esta oleada de amenazas impulsadas por la IA.

No vuelva a preocuparse por el fraude de IA. TruthScan puede ayudarle:

- Detectar IA generada imágenes, texto, voz y vídeo.

- Evite grandes fraudes impulsados por la IA.

- Proteja sus sensible activos de la empresa.

Phishing y BEC generados por IA: estafas a una escala sin precedentes

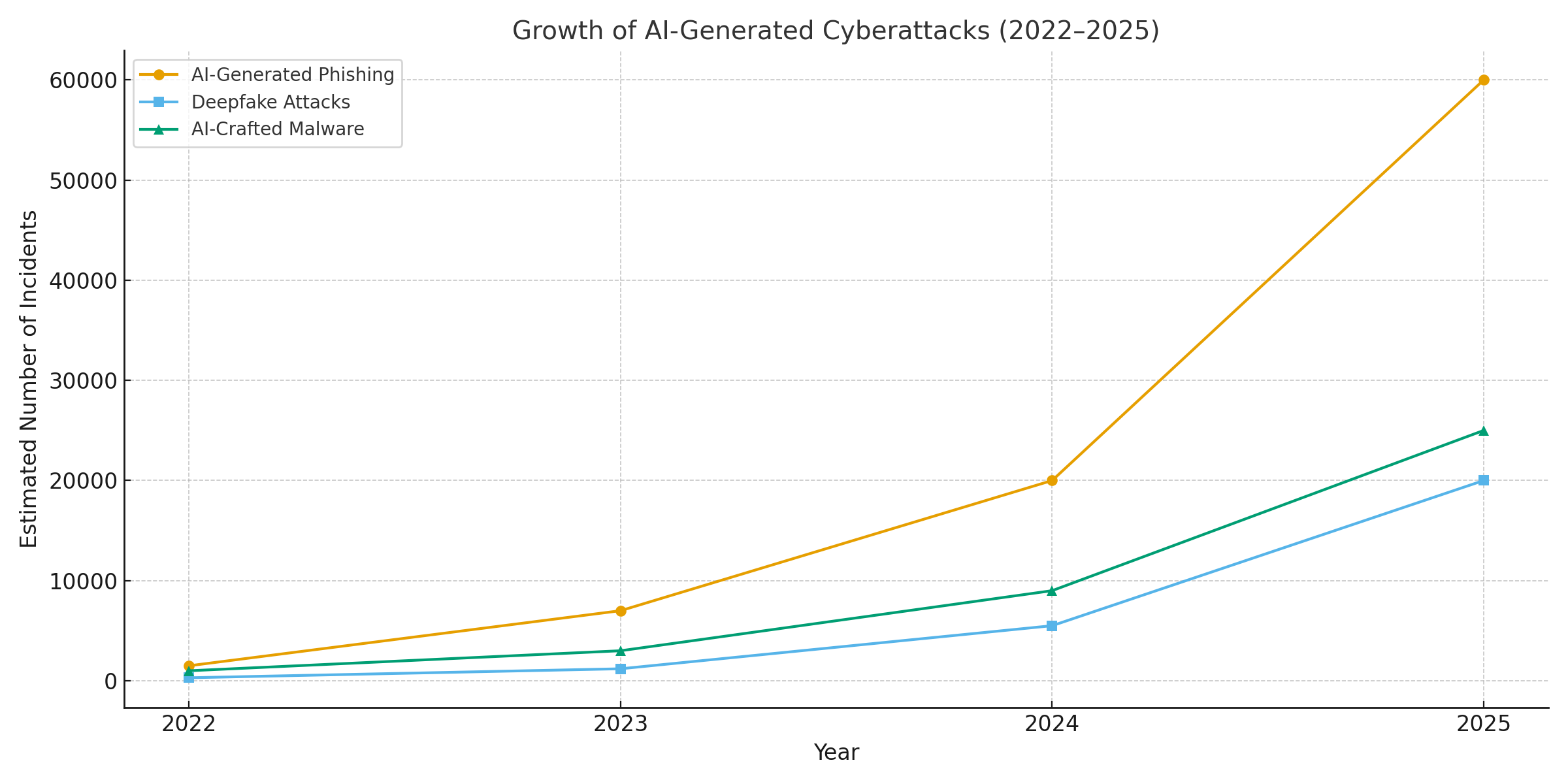

Una de las repercusiones más claras de la IA generativa ha sido en el phishing y el correo electrónico comercial comprometido (BEC) esquemas. Los modelos lingüísticos de inteligencia artificial pueden redactar correos electrónicos fluidos y adaptados al contexto en cuestión de segundos, eliminando los errores gramaticales reveladores y las frases incómodas que antes delataban el phishing. El resultado es una avalancha de mensajes y correos electrónicos fraudulentos muy convincentes. En abril de 2025, más de la mitad de los mensajes de spam (51%) los escribía la IAprácticamente cero dos años antes[6]. Y lo que es aún más alarmante, los investigadores 14% de los correos electrónicos de ataques BEC fueron generados por IA para 2025[7] - una cifra que se espera que aumente a medida que los delincuentes adopten herramientas como ChatGPT. Algunos estudios estiman que sobre 80% de correos electrónicos de phishing pueden contar ahora con la ayuda de la IA para elaborarlos[8].

El volumen de estos señuelos generados por IA se ha disparado. Los análisis de seguridad muestran que los ataques de phishing vinculados a la IA generativa aumentaron un 1,265% en poco tiempo[9]. En un periodo, los informes de incidentes de phishing aumentaron 466% en un solo trimestreen gran parte debido a los kits de phishing automatizados y a los bots que envían cebos personalizados.[9][10]. ¿Por qué ese repunte? Porque la IA permite a los atacantes escala sus operaciones de forma drástica. Un solo delincuente puede utilizar un chatbot de IA para generar miles de correos electrónicos fraudulentos personalizados dirigidos a diferentes empleados o clientes, todo ello en el tiempo que solía llevar elaborar uno. Esta automatización masiva llevó al FBI a advertir de que las pérdidas por BEC (que ya ascendían a 1.700 millones de euros en 2022) no harán más que acelerarse, ya que la IA "amenaza con aumentar aún más esas pérdidas".[11][12].

No sólo hay más correos electrónicos de phishing, sino que también son más eficaz. Las víctimas son engañadas en mayor medida por el lenguaje pulido y los detalles contextuales que puede incorporar la IA. En pruebas de laboratorio, los correos electrónicos de phishing escritos con IA alcanzaron un 54% porcentaje de clics - muy por encima del ~12% de los intentos de phishing tradicionales[13]. Estos mensajes parecen del estilo de un auténtico director general o hacen referencia a acontecimientos reales de la empresa, lo que baja la guardia de los destinatarios. Los atacantes incluso utilizan la IA para probar diferentes frases e iterar sobre los ganchos más exitosos.[14]. Y, a diferencia de los humanos, la IA no comete errores tipográficos ni se cansa: puede vomitar infinitas variantes hasta que una se cuela por los filtros y engaña a alguien.

Un ejemplo: A mediados de 2025, un Reuters una investigación puso al descubierto cómo los estafadores del sudeste asiático aprovechaban ChatGPT para automatizar las comunicaciones fraudulentas[15]. Generaban en masa correos electrónicos bancarios y mensajes de atención al cliente convincentes, lo que aumentaba enormemente el alcance de sus estafas. La policía europea también informó de la venta en la red oscura de kits de phishing basados en inteligencia artificial por menos de $20, lo que permite a actores poco cualificados lanzar campañas sofisticadas.[16][17]. La barrera de entrada para el BEC y el phishing se ha evaporado esencialmente.

Medidas defensivas - Detener el phishing de IA: Ante este ataque, las organizaciones deben reforzar sus canales de correo electrónico y mensajería. Aquí es donde Detección de contenidos mediante IA puede ayudar. Herramientas como Detector de texto AI de TruthScan y especializados escáneres de correo electrónico puede analizar los mensajes entrantes en busca de los marcadores estadísticos del texto generado por la IA. Por ejemplo, el Detector de estafas por correo electrónico TruthScan utiliza el análisis del lenguaje natural para señalar los correos electrónicos que probablemente proceden de una IA, aunque parezcan legítimos.[18]. Estos detectores examinan aspectos como una gramática perfectamente pulida, la complejidad de las frases y patrones estilométricos poco habituales en los escritores humanos. Con exploración en tiempo realLos correos sospechosos pueden ponerse en cuarentena o marcarse para su revisión antes de que lleguen a los usuarios. Los equipos de seguridad de las empresas están empezando a desplegar estos filtros basados en IA en las pasarelas de correo electrónico y las plataformas de mensajería. En la práctica, esto añade una nueva capa de defensa a los filtros de spam tradicionales: una capa ajustada explícitamente para detectar el contenido escrito con IA. A partir de 2025, las principales empresas están integrando soluciones como TruthScan a través de API en sus puertas de enlace de correo electrónico seguras y suites de colaboración en la nube, creando un punto de control automatizado para Phishing generado por IA contenido.

Suplantación de voz y vídeo Deepfake: El fraude de "ver para engañar

Tal vez la amenaza más visceral impulsada por la IA en 2025 sea el auge del ataques de voz y vídeo deepfake. Utilizando modelos de IA, los delincuentes pueden clonar la voz de una persona a partir de unos pocos segundos de audio o generar un vídeo realista de la cara de alguien a partir de un puñado de fotos. Estas falsificaciones se están utilizando para estafas de suplantación de identidad de alto riesgo, desde fraudes a directores ejecutivos (llamadas de "falsos directores ejecutivos") a videoconferencias falsas y mucho más. Un informe reciente del sector revela 47% de las organizaciones han sufrido ataques deepfake de algún tipo[19]. Y no es sólo teórico: múltiples atracos en 2023-2025 han demostrado que los deepfakes pueden derrotar a la autenticación definitiva: nuestros propios ojos y oídos.

Un caso tristemente célebre fue el de una transferencia bancaria internacional de 1.000 millones de euros. $25 millones después de que un empleado fuera engañado mediante una videoconferencia falsa. Los atacantes utilizaron IA para sintetizar la imagen de la directora financiera de la empresa en una llamada de Zoom, con su voz y sus gestos, y le dieron instrucciones al empleado para que transfiriera fondos.[4][20]. En otro incidente ocurrido en Australia, un gobierno local perdió $2,3 millones cuando los estafadores falsificaron la voz y el vídeo de funcionarios municipales para aprobar pagos fraudulentos[21]. Y, lo que es más inquietante, los delincuentes utilizan voces clonadas por inteligencia artificial para estafar a los abuelos, llamando a personas mayores y haciéndose pasar por sus familiares en apuros. En FBI y FinCEN emitió alertas a finales de 2024 sobre un aumento del fraude utilizando Medios "deepfake" generados por IAcomo falsos agentes de atención al cliente e identidades sintéticas para eludir las verificaciones KYC.[22].

La frecuencia de los delitos basados en deepfakes está aumentando rápidamente. Según un análisis, a finales de 2024 una nueva estafa deepfake estaba ocurriendo cada cinco minutos de media[23]. Sólo en el primer trimestre de 2025, los incidentes de deepfake denunciados aumentaron un 19% en comparación con el año anterior. todos de 2024[24][25]. Se calcula que los deepfakes representan 6,5% de todos los ataques fraudulentos, a 2,137% aumento desde 2022[26][27]. La tecnología necesaria es ahora de fácil acceso, y a menudo requiere tan sólo 30 segundos de audio para clonar una voz, o menos de una hora de metraje de muestra para modelar el rostro de una persona de forma convincente.[20]. En resumen, nunca ha sido tan fácil "falsificar" la identidad de una persona de confianza y engañan a las víctimas para que les entreguen dinero o información.

Medidas defensivas - Autentificar la realidad: Para contrarrestar las amenazas de deepfake, las organizaciones están recurriendo a sistemas avanzados. detección de medios sintéticos herramientas. Por ejemplo, Detector de voz AI de TruthScan y Detector de falsificaciones TruthScan utilizan IA para analizar audio y vídeo en busca de signos de manipulación. Estos sistemas realizan análisis fotograma a fotograma y de forma de onda para detectar artefactos como movimientos faciales poco naturales, problemas de sincronización labial o irregularidades en el espectro de audio que delatan un clip generado por IA. En las pruebas, los algoritmos de TruthScan lograron 99%+ precisión en la identificación de voces generadas por IA y detectó fotogramas de vídeo manipulados en tiempo real[28][29]. De hecho, investigadores del Genians Security Center utilizaron recientemente el análisis forense de imágenes de TruthScan para analizar un documento de identidad falso utilizado por piratas informáticos norcoreanos. 98% confianzafrustrando el intento de spear-phishing[5][30].

Para la defensa práctica, las empresas están desplegando estas capacidades de detección en puntos de estrangulamiento clave. Verificación de voz se está incorporando a los flujos de trabajo de los centros de llamadas. Por ejemplo, cuando un "cliente" solicita una transferencia de gran volumen por teléfono, el audio se puede pasar por un detector de falsificación de voz para garantizar que es realmente él (y no un imitador de la IA). De la misma forma, plataformas de videoconferencia puede integrar el escaneado en directo de deepfakes en los flujos de vídeo de los participantes, para detectar cualquier rostro sintético. La suite de detección de deepfakes de TruthScan, por ejemplo, ofrece análisis de videollamadas en tiempo real y autenticación facial que puede conectarse a Zoom o WebEx mediante API[31][29]. Esto significa que si alguien intenta unirse a una reunión utilizando un vídeo creado por la IA de su director general, el sistema puede marcar "posible deepfake" antes de que se produzca ningún daño. Además, las transacciones importantes incluyen ahora a menudo un paso de verificación (fuera de banda o multifactor) que puede aprovechar la autenticación de contenido, por ejemplo, requiriendo una breve confirmación hablada que luego es comprobada por un detector de voz de IA para verificar su autenticidad. Al superponer estas herramientas, las empresas crean una red de seguridad: incluso si los empleados véase o oiga algo plausible, un forense de la IA entre bastidores cuestionará su realidad. En un panorama de amenazas permeado por la IA, "No confíes - verifica" se convierte en el mantra para cualquier comunicación de voz o vídeo que implique dinero o acceso sensible.

Malware creado con inteligencia artificial y código ofuscado: Amenazas en evolución en el código

La influencia de la IA no se limita a la ingeniería social: también está cambiando las reglas del juego en el desarrollo de malware y código de ataque evasivo. En 2025, el Grupo de Inteligencia sobre Amenazas de Google descubrió la primeras cepas de malware que utilizan IA durante ejecución para alterar su comportamiento[32][33]. Un ejemplo, denominado PROMPTFLUXera un script malicioso que en realidad llamaba a una API de IA (el modelo Gemini de Google) para reescribir su propio código sobre la marcha, produciendo nuevas variantes ofuscadas para eludir la detección antivirus.[34][35]. Esta evolución de la IA "justo a tiempo" marca un salto hacia el malware autónomo y polimórfico. Otra muestra, PROMPTSTEALLa empresa, que utilizó un asistente de codificación de inteligencia artificial para generar comandos de Windows de una sola línea para el robo de datos, básicamente subcontrató partes de su lógica a un motor de inteligencia artificial en tiempo real.[36][37]. Estas innovaciones apuntan a un futuro en el que los programas maliciosos podrán transformarse continuamente -como lo haría un atacante humano- para vencer a las defensas.

Incluso sin IA sobre la marcha, los atacantes están utilizando la IA durante el desarrollo para crear códigos maliciosos más potentes. La IA generativa puede producir malware que es muy ofuscadoque contiene capas de lógica confusa que dificultan la ingeniería inversa. Según los informes de inteligencia de amenazas, más de 70% de las principales infracciones en 2025 implicaron algún tipo de malware polimórfico que cambia su firma o comportamiento para evitar ser detectado[38]. Además, 76% de campañas de phishing ahora emplean tácticas polimórficas como URL dinámicas o cargas útiles reescritas por IA.[38]. Herramientas como las ofertas dark-web WormGPT y FraudeGPT (clones sin restricciones de ChatGPT) permiten incluso a los no expertos generar droppers de malware, keyloggers o código de ransomware simplemente describiendo lo que quieren[39]. El resultado es una abundancia de nuevas variantes de malware. Por ejemplo, en 2024 un ladrón de información llamado BlackMamba surgió que se totalmente generada por IAque utiliza ChatGPT para escribir su código en segmentos: cada ejecución produce un binario ligeramente diferente, lo que confunde a los antivirus tradicionales basados en firmas.[38]. Los investigadores de seguridad también demostraron la existencia de pruebas de concepto polimórficas generadas por IA que podrían eludir muchas protecciones de puntos finales.[40].

Además, los atacantes están aprovechando la inteligencia artificial para afinar sus ataques. entrega de malware. La IA puede programar de forma inteligente correos electrónicos de phishing (como ya se ha comentado) que contengan enlaces a programas maliciosos. También puede ayudar en el desarrollo de exploits, por ejemplo, utilizando la IA para encontrar nuevas vulnerabilidades u optimizar el código shell. Al parecer, los agentes de los Estados-nación han utilizado modelos avanzados de IA para descubrir exploits de día cero y desarrollar malware a medida para sus objetivos.[41]. Todas estas tendencias hacen que el malware de 2025 sea más sigiloso y adaptable. A menudo "co-creado" con IAlo que dificulta su detección mediante reglas convencionales.

Medidas defensivas - IA contra IA en la defensa contra malware: La defensa contra el malware creado con IA requiere una combinación de detección avanzada y análisis basado en IA en el lado defensivo. Muchas organizaciones están aumentando sus protección de puntos finales y EDR (Endpoint Detection & Response) con modelos AI/ML que buscan los patrones de comportamiento del código generado por la IA. Por ejemplo, las transformaciones repentinas de código en el host o los patrones inusuales de llamadas a la API podrían indicar que algo como PROMPTFLUX se está regenerando. Del mismo modo, la supervisión de la red puede detectar anomalías, como la llegada de malware a los servicios de IA (lo que no es "normal" para las aplicaciones de usuario). Los proveedores están entrenando detectores basados en ML en la familias de malware asistido por IA identificado hasta ahora, mejorando el reconocimiento de estas nuevas amenazas.

Una solución emergente es exploración de contenidos de IA integrada en los procesos de desarrollo y creación. Esto significa utilizar detectores basados en IA para analizar scripts, compilaciones de software o incluso cambios de configuración en busca de contenido malicioso o generado por IA. Por ejemplo, Detector en tiempo real de TruthScan puede desplegarse más allá del texto: su análisis multimodal puede detectar código o archivos de configuración sospechosos reconociendo si han sido generados por máquinas con patrones de ofuscación.[42][43]. Los equipos de desarrollo y los MSSP están empezando a escanear scripts de infraestructura como código, registros de PowerShell y otros artefactos en busca de señales de segmentos escritos con IA que podrían indicar la mano de un atacante. Aunque se trata de un área incipiente, resulta prometedora: en un caso, un equipo de seguridad utilizó un detector de IA para detectar un archivo de kit de phishing ofuscado que "parecía" generado por IA y que, de hecho, formaba parte de un ataque.[44]. El código del archivo era demasiado complejo y prolijo (características de la generación de IA), y un análisis del contenido de la IA confirmó la alta probabilidad de que no hubiera sido escrito por un ser humano.[40].

Por último, el intercambio de inteligencia sobre amenazas centrado en las amenazas de IA es crucial. Cuando Google GTIG publique detalles sobre malware basado en Prompt o cuando los investigadores informen de nuevas técnicas de evasión de IA, las organizaciones deben introducirlas en su ingeniería de detección. Análisis del comportamiento - en busca de acciones como un proceso que genera un script que reescribe el código de ese mismo proceso, puede detectar anomalías que presenta el malware asistido por IA. En resumen, los defensores deben combatir el fuego con fuego: desplegar Herramientas de seguridad basadas en IA que puedan adaptarse tan rápidamente como lo hace el malware impulsado por la IA. Esto incluye todo, desde antivirus mejorados con IA hasta análisis del comportamiento del usuario que puedan identificar cuándo una cuenta o un sistema empieza a actuar "no del todo humano". Al adoptar la IA para la defensa, los equipos de seguridad pueden contrarrestar las ventajas de velocidad y escala que la IA otorga a los atacantes.

Identidades sintéticas y tramas de fraude alimentadas por inteligencia artificial

Del malware al mundo del fraude: fraude de identidad sintética se ha disparado con la ayuda de la IA generativa. El fraude de identidad sintética consiste en crear personas ficticias combinando datos reales y falsos (por ejemplo, un número de seguro social real con un nombre y documentos falsos). Estas identidades "Frankenstein" se utilizan a continuación para abrir cuentas bancarias, solicitar créditos o pasar controles KYC, lo que acaba dando lugar a préstamos impagados o blanqueo de dinero. Ya era uno de los tipos de fraude de más rápido crecimiento, y ahora la IA ha echado leña al fuego. Pérdidas por fraude de identidad sintética cruzó $35.000 millones en 2023[45]y, a principios de 2025, algunas estimaciones indicaban casi 25% de todas las pérdidas por fraude bancario se debieron a identidades sintéticas[46]. Los analistas de Experian descubrieron que más de 80% de fraude en cuentas nuevas en determinados mercados se vincula ahora a identificaciones sintéticas[19] - una estadística asombrosa que subraya lo generalizada que se ha vuelto esta estafa.

La IA generativa amplifica el fraude sintético de varias maneras. En primer lugar, la IA hace que sea trivial producir el "documentos de criador" y huellas digitales necesarias para vender una identidad falsa. En el pasado, un estafador podía retocar un documento de identidad con Photoshop o crear manualmente facturas de servicios falsas. Ahora existen herramientas para generar fotos de perfil, documentos de identidad, pasaportes, extractos bancarios e incluso perfiles de redes sociales que parezcan auténticos mediante generadores de imágenes y modelos lingüísticos de IA[47][48]. Por ejemplo, se puede utilizar una IA para crear un retrato realista de una persona que no existe (lo que impediría realizar búsquedas inversas de imágenes) y generar un carné de conducir falso con esa foto. La IA también puede simular "señales de vida" de una identidad - por ejemplo, creando registros de padres sintéticos, direcciones o publicaciones en redes sociales para dar cuerpo a una historia de fondo[49]. La Fed de Boston señaló que Gen AI puede incluso producir deepfake audio y video de una persona falsa - Por ejemplo, un usuario sintético podría "aparecer" en un vídeo de verificación de un selfie, con una cara y una voz únicas, generadas por la IA.[50].

En segundo lugar, la IA ayuda a los defraudadores ampliar sus operaciones. En lugar de falsificar una o dos identidades cada vez, pueden generar mediante programación cientos o miles de paquetes de identidad completos y rellenar automáticamente solicitudes de cuentas nuevas de forma masiva.[51][52]. Algunos servicios de la web oscura ofrecen efectivamente "Identidades sintéticas como servicio"El uso de la automatización para generar cuentas verificadas para la venta. Durante los programas de ayuda para la pandemia COVID-19, por ejemplo, los delincuentes utilizaron bots con identidades generadas por IA para solicitar en masa préstamos y prestaciones, saturando el sistema con solicitantes falsos. Según las previsiones de Juniper Research, el coste global del fraude de identidad digital (alimentado por estas tácticas) ascenderá a 1.000 millones de euros. aumento 153% en 2030 en comparación con 2025[53].

Medidas defensivas - Verificación de la identidad en un mundo de IA: Los métodos tradicionales de comprobación de identidades están luchando contra las falsificaciones creadas por la IA. Para adaptarse, las organizaciones están adoptando verificación de identidad y comportamiento a varios niveles reforzada por la IA. Una capa clave es la análisis forense de documentos e imágenes. Por ejemplo, Detector de imágenes AI de TruthScan y Detector de documentos falsos ofrecen la posibilidad de analizar documentos de identidad, selfies o documentos cargados en busca de signos de síntesis o manipulación. Estas herramientas examinan artefactos a nivel de píxel, incoherencias de iluminación y metadatos para determinar si una imagen está generada o manipulada por IA. Pueden detectar indicios sutiles, como patrones de fondo idénticos en fotos generadas por GAN, o fuentes y espaciado en un documento de identidad que no coinciden con ninguna plantilla gubernamental conocida. Al desplegar estos detectores en el momento de la contratación, los bancos pueden marcar automáticamente el carné de conducir o el selfie de un solicitante si es probable que haya sido generado por IA (por ejemplo, el sistema de TruthScan habría marcado el carné militar falso utilizado en el caso de phishing de Kimsuky APT).[5]). Según un comunicado de prensa de TruthScan, su plataforma ha sido utilizada por instituciones financieras para validar la autenticidad de documentos a escala, identificando falsificaciones profundas con una precisión extremadamente alta.[54].

Otra capa es análisis del comportamiento y comprobaciones cruzadas. Las identidades reales tienen profundidad: años de historia, registros públicos, actividad en las redes sociales, etc. Las identidades generadas por IA, por muy pulidas que sean, carecen a menudo de estas raíces profundas. Los bancos y los prestamistas utilizan ahora la IA para cruzar los datos de las solicitudes con datos públicos y privados: ¿Muestran el número de teléfono y el correo electrónico de esta persona un historial de uso? ¿Tiene sentido la geolocalización del dispositivo o la IP? ¿Están introduciendo datos en formularios de forma humana, o copiando y pegando (como hacen los bots)? Los modelos de IA pueden entrenarse para distinguir el comportamiento genuino de los clientes de los patrones sintéticos. La Reserva Federal señaló que "Las identidades sintéticas son superficiales, y la IA puede verlo" - La verificación basada en IA puede buscar rápidamente la huella digital de una identidad y hacer saltar las alarmas si no se encuentra ninguna o muy poca.[55]. En la práctica, los servicios de verificación de identidad emplean ahora IA que comprueba si el selfie de un usuario coincide con fotos anteriores (para detectar intercambios de caras) e incluso solicita a los usuarios acciones aleatorias (como poses o frases específicas) durante las comprobaciones de vitalidad, lo que dificulta que los deepfakes respondan correctamente.[56][57].

Por fin, control continuo del comportamiento de la cuenta después del alta ayuda a detectar las cuentas sintéticas que se han colado. Dado que estas cuentas no están vinculadas a una persona real, sus patrones de uso suelen destacar con el tiempo (por ejemplo, realizar transacciones perfectamente sincronizadas para acumular crédito y, a continuación, llegar al máximo). La supervisión del fraude basada en IA (como las plataformas de Sift o Feedzai) puede identificar anomalías en el uso de las cuentas, señalando posibles cuentas sintéticas para su revisión. En resumen, la lucha contra el fraude de identidad basado en IA requiere Pruebas de identidad basadas en IA - combinando análisis forense de documentos, comprobaciones biométricas, correlación de datos y análisis del comportamiento. La buena noticia es que los mismos avances en IA que permiten el fraude también se están utilizando para detectarlo. TruthScan, por ejemplo, ofrece un suite de verificación de la identidad que integra análisis de texto, imagen y voz para investigar a los nuevos usuarios. Al aprovechar estas herramientas, un gran banco observó un descenso significativo en la apertura de cuentas sintéticas, incluso cuando las medias del sector estaban aumentando. La carrera armamentística continúa, pero los defensores están aprendiendo a detectar los débiles "indicios digitales" de un sintético, por mucho que la IA intente ocultar sus huellas.

Integración de la detección por IA en toda la pila de seguridad

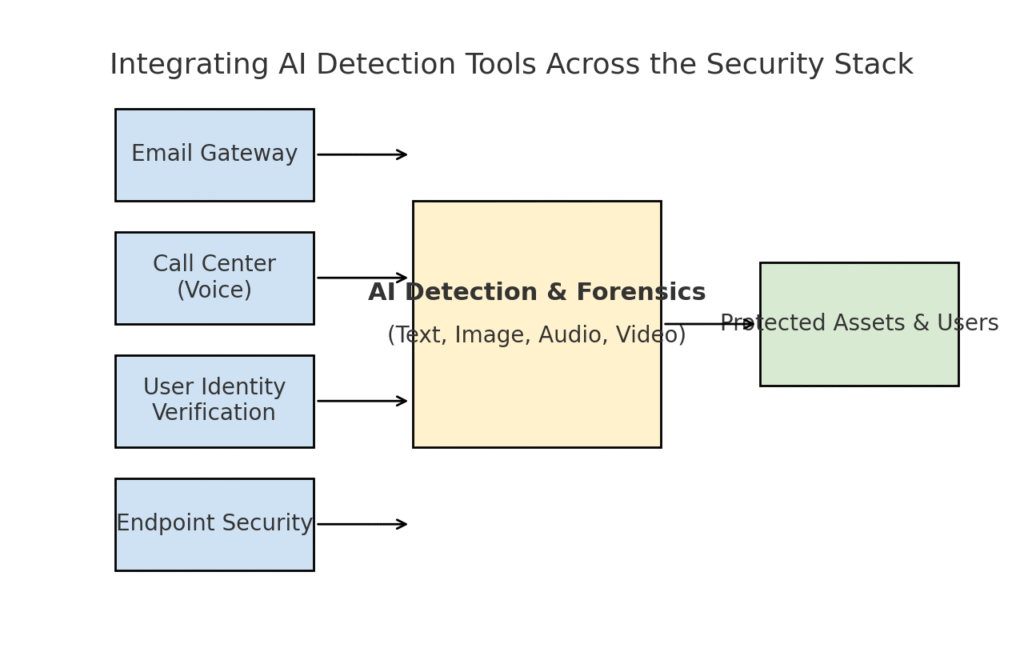

Hemos explorado varias áreas de amenaza distintas -phishing, deepfakes, malware, fraude sintético-, todas ellas potenciadas por la IA. Está claro que no hay una única herramienta ni un único remedio resolverá el reto. En su lugar, las empresas necesitan una estrategia global para Integrar la detección y verificación basadas en IA en todos los niveles de su pila de ciberseguridad. El enfoque debe reflejar la superficie de ataque, cubriendo correo electrónico, web, voz, documentos, identidad y más. El siguiente diagrama ilustra cómo las organizaciones pueden integrar las herramientas de detección de IA de TruthScan (y soluciones similares) en las capas de seguridad comunes de la empresa:

Integración de herramientas de detección de IA en múltiples capas de la pila de seguridad: desde pasarelas de correo electrónico y centros de llamadas hasta verificación de usuarios y protección de puntos finales. La detección de contenidos con IA (centro) analiza texto, imágenes, audio y vídeo en tiempo real, alimentando puntos de aplicación que protegen activos y usuarios.

En este modelo, los detectores multimodales de IA actúan como un cerebro central que interactúa con diversos controles de seguridad:

- Pasarelas de correo electrónico: Los correos electrónicos entrantes pasan por un detector de texto/estafa de IA antes de llegar a la bandeja de entrada. Esto enlaza con la defensa contra el phishing de la que hablamos, por ejemplo, utilizando Detector de estafas por correo electrónico de TruthScan a través de la API de su proveedor de correo electrónico para poner en cuarentena automáticamente los correos sospechosos generados por la IA[18]. También puede aplicarse a plataformas de mensajería (aplicaciones de chat, pasarelas de SMS) para escanear contenidos en busca de patrones de phishing o estafa.

- Centros de llamadas y sistemas de voz: Los canales telefónicos y VOIP se protegen integrando la detección de voz falsa. Por ejemplo, la línea de atención al cliente de un banco podría utilizar Detector de voz AI de TruthScan analizar en tiempo real el audio de las llamadas entrantes y alertar si la huella vocal de la persona que llama es sintética o no coincide con su perfil conocido.[58][59]. Esto ayuda a evitar que los ataques de vishing y de suplantación de voz (como las llamadas falsas al director general) tengan éxito.

- Procesos de verificación de la identidad del usuario: Durante la creación de una cuenta o las acciones de alto riesgo del usuario (restablecimiento de contraseñas, transferencias bancarias), entra en acción la verificación de identidad basada en IA. Una herramienta de análisis forense de imágenes verifica la identidad de una foto cargada (por ejemplo, comprobando si está generada por IA o es una foto de una foto), y un detector de falsificaciones profundas examina un selfie o una videollamada. TruthScan Detector de Deepfake para realizar la autenticación facial y garantizar que la persona que aparece en la cámara es real y coincide con la identificación.[60][61]. Las señales de comportamiento (cadencia de tecleo, consistencia de los dispositivos) también pueden introducirse en modelos de IA para detectar bots o identidades sintéticas.

- Puntos finales y red: Los agentes de seguridad de endpoints y los servidores proxy pueden incorporar análisis de contenido de IA para archivos y scripts. Por ejemplo, si un EDR de punto final ve que se está ejecutando un nuevo script o EXE, podría enviar el contenido del texto del archivo a un detector de IA para comprobar si se parece a malware generado por IA conocido o presenta rasgos de código de IA ofuscado. Del mismo modo, los sistemas DLP (prevención de pérdida de datos) podrían utilizar la detección de texto de IA para marcar texto sensible generado por IA (lo que podría indicar que un intruso utiliza IA para redactar mensajes de exfiltración de datos o falsificar informes). TruthScan Detector en tiempo real está diseñado para integrarse en este tipo de flujos de trabajo, ofreciendo análisis en directo de contenidos en todas las plataformas con opciones de respuesta automatizadas.[42][62] (por ejemplo, bloquear automáticamente un archivo o mensaje si se identifica como malware generado por IA o desinformación).

En principal ventaja de este enfoque integrado es velocidad y coherencia. Los ataques de IA se mueven con rapidez: correos electrónicos de phishing, voces falsas y datos sintéticos pueden afectar a muchos canales a la vez. Al instrumentar todos esos canales con detección de IA, una organización gana visibilidad en tiempo real y defensa en profundidad. Un equipo lo describió como la creación de un "sistema inmune a la IA" para su empresa: cada vez que se comunica algo (ya sea un correo electrónico, la carga de un documento, una llamada de voz, etc.), el sistema inmune a la IA lo "olfatea" en busca de firmas extrañas (generadas por la IA) y lo neutraliza si lo considera malicioso.

La suite empresarial de TruthScan es un ejemplo de ello, ya que ofrece un plataforma unificada que cubre la detección de IA de texto, imagen, audio y vídeo y que puede desplegarse modularmente o en su conjunto[63][64]. Muchas empresas empiezan desplegando una o dos funciones (por ejemplo, la detección de texto en el correo electrónico y la detección de imágenes en el onboarding) y luego amplían a otras una vez que ven el valor. Y lo que es más importante, la integración es más fácil para los desarrolladores - TruthScan y otros servicios similares proporcionan API y SDK para que los equipos de seguridad puedan conectar la detección a los sistemas existentes sin necesidad de una reingeniería masiva. Ya se trate de un SIEM, una pasarela de correo electrónico, una aplicación bancaria personalizada o un sistema CRM, la detección puede ejecutarse entre bastidores y alimentar alertas o acciones automatizadas. Por ejemplo, una gran plataforma de redes sociales integró API de moderación de contenidos para eliminar automáticamente los vídeos deepfake en cuestión de minutos.[65][66]evitando la propagación de la desinformación generada por la IA.

Conclusiones: Mantenerse a la vanguardia

La rápida proliferación de amenazas impulsadas por IA en 2025 ha desafiado a las organizaciones de nuevas maneras. Los atacantes han encontrado la forma de explotar la confianza humana a gran escala, suplantando voces e identidades, automatizando la ingeniería social, evadiendo las defensas mediante código adaptativo y fabricando realidades completamente falsas. Es una perspectiva desalentadora para los defensores, pero no desesperada. Al igual que los delincuentes aprovechan la IA, nosotros también podemos ponerla del lado de la seguridad. La aparición de Detección de contenidos mediante IA, análisis forense de falsificaciones y escáneres de identidad sintética nos ofrece poderosos contrapesos a estas nuevas amenazas. Al desplegar estas herramientas y integrándolos en todas las capas de defensa, las empresas pueden reducir drásticamente el riesgo de que se cuelen ataques impulsados por IA. Los primeros en adoptar esta tecnología ya han frustrado intentos de fraude multimillonarios atrapando a los deepfakes in fraganti.[26]o evitar catástrofes de phishing filtrando correos electrónicos creados con inteligencia artificial.

Más allá de la tecnología, las organizaciones deben cultivar una cultura de "confiar pero verificar". Los empleados deben ser conscientes de que en la era de la IA, ver (u oír) no siempre es creer - un sano escepticismo emparejado con flujos de trabajo de verificación puede detener muchas estratagemas de ingeniería social. La formación y la concienciación, combinadas con herramientas de verificación automatizada como TruthScanforman una defensa formidable. En cierto sentido, debemos subir el listón de la autenticación y validación de la información. Las comunicaciones y los documentos digitales ya no pueden tomarse al pie de la letra; es necesario comprobar su procedencia, ya sea mediante máquinas o procesos.

A medida que avancemos, cabe esperar que los atacantes sigan perfeccionando sus tácticas de IA, pero también que continúe la innovación en la IA defensiva. La dinámica del gato y el ratón persistirá. El éxito de los defensores dependerá de agilidad e intercambio de información. Aquellos que incorporen rápidamente nueva información sobre amenazas (por ejemplo, técnicas novedosas de detección de falsificaciones o firmas actualizadas de modelos de IA) irán por delante de los atacantes que utilicen las últimas herramientas de IA. La colaboración entre la industria, el mundo académico y la Administración también será vital en esta lucha, como demuestran las alertas y los marcos que están surgiendo de organismos como el Marco de Gestión de Riesgos de la IA del NIST y las colaboraciones interbancarias para la detección del fraude mediante IA.

Para terminar, el sector de la ciberseguridad se encuentra en medio de un cambio de paradigma impulsado por la IA. Las amenazas no se parecen a las de hace una década, pero les estamos haciendo frente con defensas igualmente sin precedentes. Con una combinación de tecnología de detección avanzada y una sólida estrategia de seguridad, podemos puede mitigar los riesgos de la IA generativa e incluso convertirla en nuestra ventaja. Herramientas como la suite de detección de IA de TruthScan nos permiten restaurar la confianza en un mundo de confianza cero - para garantizar que la persona al otro lado de la línea es real, que el documento que tenemos en la bandeja de entrada es auténtico y que el código que se ejecuta en nuestra red no ha sido manipulado por una IA maliciosa. Al invertir ahora en estas capacidades, las organizaciones no sólo se protegerán de los ataques actuales basados en IA, sino que también crearán resistencia frente a las amenazas en evolución del mañana. La conclusión es clara: Puede que la IA esté potenciando los ciberataques, pero con el enfoque adecuado, también puede potenciar nuestras defensas.

Fuentes: Los datos y ejemplos pertinentes se han extraído de 2025 informes de inteligencia sobre amenazas y de expertos, incluido el informe Cyber Incident Trends de Mayer Brown.[1][67]Resumen de amenazas 2025 de Fortinet[2][19]Investigación de Barracuda sobre los ataques de inteligencia artificial al correo electrónico[6][7]Informe del GTIG de Google sobre la amenaza de la IA[34]La Reserva Federal de Boston analiza el fraude sintético[45][50]y los estudios de casos y comunicados de prensa publicados por TruthScan[30][26]entre otros. Todo ello ilustra el alcance de las amenazas impulsadas por la IA y la eficacia de las contramedidas centradas en la IA en escenarios del mundo real. Aprendiendo de esta inteligencia y desplegando herramientas de vanguardia, podemos navegar con confianza en la era del ciberriesgo potenciado por la IA.

[1] [67] Tendencias en ciberincidentes en 2025 Lo que su empresa necesita saber | Insights | Mayer Brown

[2] [3] [19] Principales estadísticas sobre ciberseguridad: Datos, estadísticas e infracciones para 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] El fraude impulsado por la IA en los servicios financieros: Tendencias recientes y soluciones | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan detecta un ataque Deepfake norcoreano contra funcionarios de Defensa - Bryan County Magazine

[6] [7] [14] La mitad del spam de tu bandeja de entrada está generado por IA: su uso en ataques avanzados está en una fase temprana | Blog de Barracuda Networks

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Índice de confianza digital del segundo trimestre de 2025: AI Fraud Data and Insights | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Amenazas a la ciberseguridad de la IA 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Última información sobre amenazas | TruthScan

[18] [63] [64] TruthScan - Detección de IA empresarial y seguridad de contenidos

[23] [46] [56] [57] Deepfakes y depósitos: Cómo combatir el fraude de la IA generativa

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Ataques Deepfake y phishing generado por IA: estadísticas de 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI Voice Detector for Deepfakes & Voice Cloning | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifica Videos Falsos y AI - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] Rastreador de amenazas de IA de GTIG: Avances en el uso de herramientas de IA por parte de los actores de amenazas | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Los piratas informáticos ofuscan el malware con un código de inteligencia artificial verborreico

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Detección de IA en tiempo real - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Operadores de EvilAI utilizan código generado por IA y aplicaciones falsas para ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] La inteligencia artificial aumenta la amenaza del fraude de identidad sintética - Banco de la Reserva Federal de Boston

[53] Fraude de identidad sintética 2025: Estrategias de detección y prevención con IA