El fraude a las aseguradoras está entrando en una nueva era impulsado por la inteligencia artificial. Tanto las redes de fraude sofisticadas como los estafadores solitarios explotan las herramientas de IA generativa para producir reclamaciones falsas, identidades sintéticas, pruebas falsas y estafas de suplantación de identidad muy convincentes. Este informe examina las últimas 2025 tendencias en fraudes a aseguradoras basados en IA -desde reclamaciones y documentos generados por IA hasta estafas de voz falsa- y describe cómo pueden responder las aseguradoras. Presentamos datos recientes, casos reales y perspectivas estratégicas para suscriptores, investigadores de fraudes, equipos de ciberseguridad, gestores de siniestros y directivos que necesitan comprender este panorama de amenazas en rápida evolución.

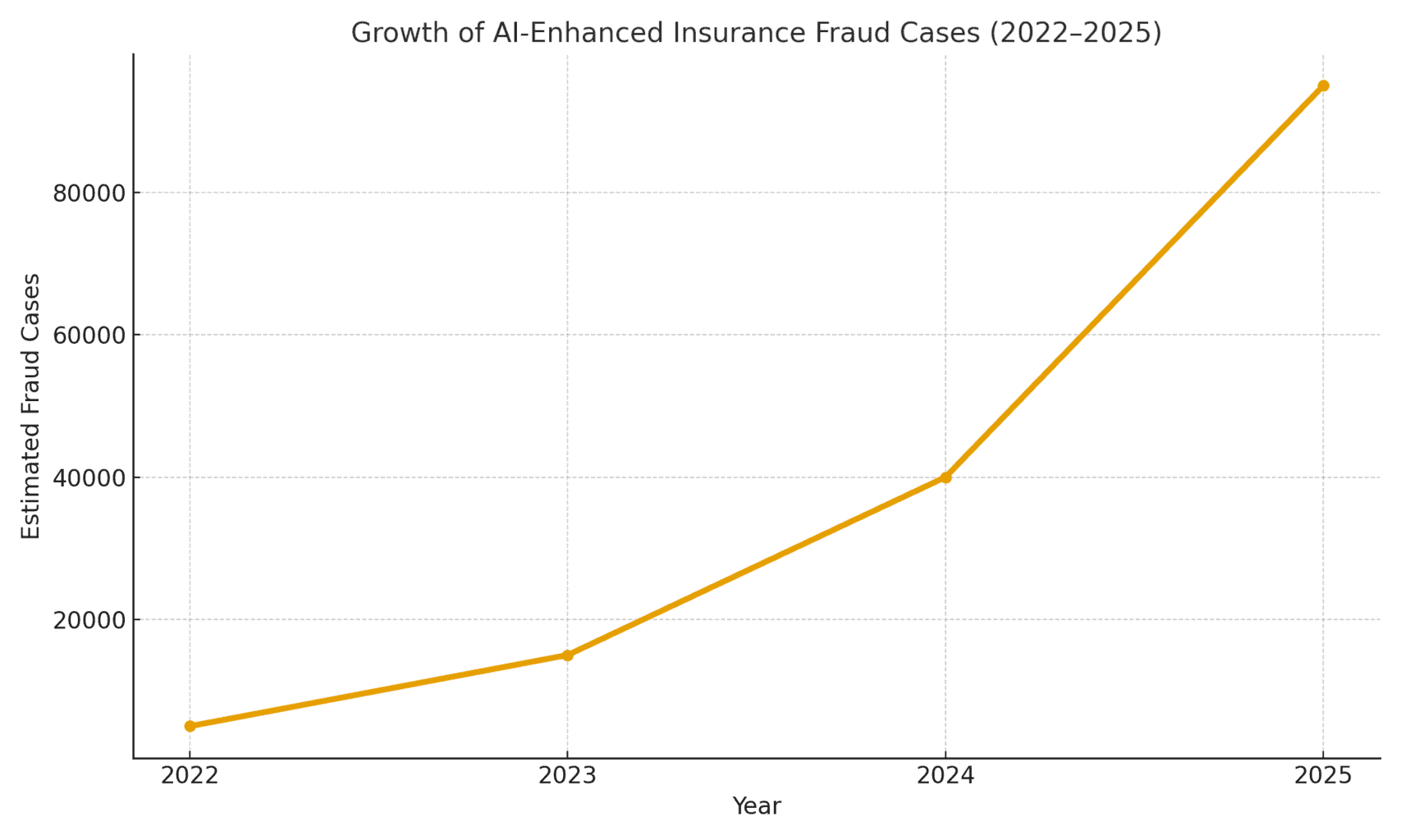

La magnitud de la amenaza: El fraude posibilitado por la IA está aumentando. Un informe de contabilidad forense de 2025 reveló que Las estafas impulsadas por la IA representan ya más de la mitad de los fraudes financieros digitales[1]. En los seguros, concretamente, la empresa de seguridad de voz Pindrop observó un 475% aumento de los ataques de fraude por voz sintética a las aseguradoras en 2024que contribuyen a un aumento interanual de 19% en el número total de intentos de fraude a las aseguradoras.[2]. Las aseguradoras se enfrentan a Exposición al fraude 20 veces superior a la de los bancosdebido en parte a la gran dependencia de documentos, imágenes y verificaciones de voz en las reclamaciones.[3]. La figura 1 ilustra el crecimiento explosivo de los incidentes de fraude a las aseguradoras potenciados por IA entre 2022 y 2025, ya que múltiples informes del sector han indicado aumentos porcentuales de tres o cuatro dígitos año tras año en la implicación detectada de IA en el fraude.

Figura 1: Rápido aumento de los casos de fraude de seguros mejorados por IA (crecimiento indexado 2022-2025). Los datos del sector indican un aumento exponencial de los contenidos generados por IA encontrados en reclamaciones fraudulentas, especialmente desde 2023.[4][2]

Alegaciones generadas por IA y pruebas falsas

Una de las tendencias más prevalentes es el uso de la IA generativa para elaborar reclamaciones de seguros totalmente inventadas. Con los generadores avanzados de texto de IA, los estafadores pueden escribir descripciones realistas de incidentes, informes médicos o declaraciones policiales con sólo pulsar un botón. Estas narraciones escritas con IA suelen parecer pulidas y verosímiles, lo que dificulta que los peritos detecten incoherencias. Por ejemplo, los estafadores han utilizado ChatGPT para redactar descripciones detalladas de accidentes o informes de lesiones que suenan profesionales y convincentes, una tarea que antes requería un esfuerzo y una habilidad de redacción considerables.

Lo más preocupante es que ahora los delincuentes emparejan estas falsas narrativas con Pruebas generadas por la IA. Los modelos de generación de imágenes (como Midjourney o DALL-E) y las herramientas de edición pueden producir fotos fotorrealistas de daños y lesiones. Según informes del sector, algunos conductores han empezado a presentación de imágenes generadas por IA para exagerar los daños del vehículo en siniestros de automóvil[5]. La IA generativa puede crear una foto de un coche destrozado o una casa inundada que en realidad nunca existió. Estas imágenes son a menudo más realistas de lo que las antiguas técnicas de Photoshop podían conseguir[6]por lo que son difíciles de detectar a simple vista. En abril de 2025, Zurich Insurance observó un aumento de los siniestros con facturas falsificadas, presupuestos de reparación inventados y fotos alteradas digitalmenteincluidos los casos en que se insertaron números de matrícula de vehículos en imágenes de coches desguazados.[7][8]. Estas pruebas falsas, combinadas con un formulario de reclamación bien redactado por la IA, pueden eludir las revisiones manuales.

Un caso llamativo en el Reino Unido fue el de unos estafadores que se llevaron un foto en las redes sociales de la furgoneta de un comerciante y utilizar la IA para añadir un parachoques agrietado.y la presentó junto con una factura de reparación falsa por valor de 1.000 libras como parte de una reclamación falsa por accidente.[9]. La estafa sólo se descubrió cuando los investigadores se percataron de la mismo foto de la furgoneta (antes de los daños) en la página de Facebook del propietario[10]. Esto ilustra un fenómeno más amplio: las aseguradoras informan de una 300% salto en "shallowfake" ediciones de imagen (simples manipulaciones digitales para añadir daños o alterar detalles) en sólo un año (2021-2022 frente a 2022-2023)[4]. Allianz UK advirtió en 2024 de que las distorsiones digitales de fotos y los documentos falsos tenían "todos los visos de convertirse en la última gran estafa que golpea al sector"[4]. El jefe de siniestros fraudulentos de Zurich observó asimismo que lo que antes requería escenificar un accidente de coche físico ahora puede hacerse completamente detrás de un ordenador - los estafadores pueden "crear una reclamación fraudulenta desde detrás de su teclado y extraer importantes sumas" con fotos e informes falsos de siniestro total.[11][12]. Este cambio no sólo aumenta el volumen de reclamaciones falsas, sino que también reduce la barrera de entrada para los posibles defraudadores.

No vuelva a preocuparse por el fraude de IA. TruthScan puede ayudarle:

- Detectar IA generada imágenes, texto, voz y vídeo.

- Evite grandes fraudes impulsados por la IA.

- Proteja sus sensible activos de la empresa.

Más allá de los coches, siniestros de bienes y accidentes están viendo cómo se inflan las pérdidas con ayuda de la IA. Hay informes de fotos falsas para seguros de viaje (por ejemplo, "daños" en el equipaje o escenas de robo escenificadas) y recibos generados por IA de artículos caros que nunca se compraron. Siniestros de vida y salud tampoco son inmunes: los defraudadores han generado falsas facturas médicas y certificados de defunción utilizando falsificadores de documentos por IA. De hecho, Zurich observó que se utilizaba tecnología deepfake para crear evaluaciones de ingenieros e informes médicos totalmente ficticios en paquetes de reclamaciones[11]. Estos documentos generados por IA, a menudo con logotipos y firmas realistas, pueden ser indistinguibles de los documentos auténticos. Una preocupación emergente para las aseguradoras de vida es fraude en las esquelas y certificados de defunciónLos delincuentes pueden utilizar la inteligencia artificial para crear falsas esquelas o cartas médicas que respalden la defunción de alguien que en realidad sigue vivo (o que nunca existió, como se explica a continuación).

Asegurados e identidades sintéticas

Quizá la novedad más insidiosa sea fraude de identidad sintética en los seguros. El fraude de identidad sintética consiste en crear una persona o entidad ficticia combinando datos reales (números de la Seguridad Social robados, direcciones, etc.) con detalles inventados (nombres falsos, documentos de identidad falsos). Los avances de la IA han facilitado trivialmente la generación de perfiles personales realistas -incluidas fotos y documentos de identidad- de personas que no existen[13][14]. Los defraudadores pueden ahora crear algorítmicamente un cliente completamente falso, contratar una póliza a su nombre y, más tarde, presentar reclamaciones o beneficios de la póliza para esa identidad falsa.

En el sector de los seguros de vida, los sistemas de identidad sintética han se disparó. Las investigaciones del sector en 2025 estiman que los costes del fraude de identidad sintética más de $30 mil millones anualesque representan hasta 80-85% de todos los casos de usurpación de identidad en todos los servicios financieros[15][16]. Las aseguradoras de vida se han visto especialmente afectadas. conseguir pólizas de seguro de vida para una persona ficticia y luego "matar" a esa persona sobre el papel para cobrar la indemnización por fallecimiento[17]. Por ejemplo, un estafador puede crear un cliente ficticio llamado "Juan Nadie", pagar primas durante un año y, a continuación, presentar una reclamación con un certificado de defunción y una esquela falsos por el fallecimiento prematuro de Juan Nadie. Dado que la identidad se ha construido cuidadosamente (historial crediticio, registros públicos, etc.), la reclamación por fallecimiento puede parecer legítima, hasta que no se encuentre el cuerpo o los familiares reales. Cuando se descubre el fraude, los autores ya se han ido con el dinero.

Las tramas de identidad sintética también plagan seguro de enfermedad y seguro de automóvil. Las redes criminales crean identidades "Frankenstein" mediante utilizar los números de la Seguridad Social de niños o ancianos (que no tienen historial crediticio) combinados con nombres y permisos de conducir generados por IA[15]. A continuación compran pólizas de salud o de automóvil para estas personas falsas, y poco después presentan grandes siniestros. Una variante es la creación de sindicatos empresas falsas (empresas pantalla) - por ejemplo, una empresa de camiones ficticia, y contratar un seguro comercial para ella, sólo para reclamar después por accidentes simulados o lesiones de empleados fantasma[18][19]. Dado que la empresa sólo existe sobre el papel (con registros comerciales e identificaciones fiscales generados por la IA), este "fraude sintético "basado en entidades a menudo no se descubre hasta después de pagar los siniestros[18][20].

¿Por qué son tan eficaces las identidades sintéticas? En primer lugar, a menudo pasan desapercibidas en los controles automáticos de verificación de identidad. Las agencias de crédito y los sistemas KYC pueden encontrar sin señales de alarma porque la identidad incluye algunos datos reales y válidos (por ejemplo, un SSN real con un historial limpio)[21]. Mientras tanto, las fotos de perfil y los escaneos de DNI generados por IA pueden parecer completamente auténticos: la IA actual puede producir un rostro humano que incluso el reconocimiento facial avanzado podría aceptar como real. El resultado: la mayoría de los sistemas automatizados reconocen estos perfiles como legítimos y el fraude sólo se descubre (si es que se descubre) después de grandes pérdidas[22].

Impacto en el mundo real: RGA informa de que el fraude de identidad sintética en los seguros de vida cuesta al sector unos $30B al año y ha crecido casi 400% desde 2020[15][16]. La Comisión Federal de Comercio de EE.UU. calcula que las identificaciones sintéticas constituyen la gran mayoría de los casos de fraude de identidad.[16]. En última instancia, estas pérdidas repercuten en los bolsillos de los asegurados honrados: se calcula que cada familia paga cada año \$700 más en primas debido a la mayor carga de fraude que soportan las aseguradoras.[15]. Las aseguradoras están respondiendo reforzando la verificación en la contratación y las reclamaciones: realizando comprobaciones en las bases de datos para vincular la identidad, controlando la existencia de varias pólizas en la misma dirección e incluso realizando pruebas de "vitalidad" (comprobaciones de vídeo selfie para asegurarse de que el reclamante es una persona real y no sólo una imagen de IA).[23][24]. Pero, como veremos, los estafadores están contraatacando con IA en el siguiente campo: las voces y vídeos deepfake.

Voces y vídeos falsos

Generado por IA deepfakes de audio y vídeo añaden una alarmante nueva dimensión al fraude a las aseguradoras. En 2023 y 2024, se produjeron varios incidentes de delincuentes que utilizaron clonación de voz para hacerse pasar por personas por teléfono, una táctica que se utilizaba originalmente en atracos a bancos (como la infame llamada falsa a un consejero delegado que robó $35 millones en 2020) pero que ahora se está extendiendo a los seguros. Los estafadores están clonando las voces de asegurados, médicos o peritos de siniestros y utilizándolas en estafas de ingeniería social. El análisis de Pindrop de 2024 advertía de que "Los deepfakes, la tecnología de voz sintética y las estafas impulsadas por la IA están remodelando el panorama del fraude"con fraude de voz escalando a un ritmo sin precedentes[25]. Descubrieron que los centros de atención telefónica de las aseguradoras eran bombardeados por malos actores extranjeros que utilizaban falsificaciones de voz: por ejemplo, recibían llamadas con el número de seguro social y los datos personales robados de un asegurado real y, si un agente contestaba, la llamada era falsificada. La voz clonada de la IA de la persona que llama podría engañar al agente mediante la autenticación basada en el conocimiento y solicitar un desembolso fraudulento[26]. En el caso de una aseguradora de la Costa Oeste, los atacantes utilizaron repetidamente este método para tratar de apoderarse de las cuentas y redirigir los pagos, aprovechando el hecho de que la verificación de identificación del centro de llamadas se basaba en la voz y en información personal que puede ser falsificada.[26].

La suplantación de voz también se ha utilizado en el lado del consumidor: Los estafadores han llamado a víctimas de accidentes o beneficiarios mientras haciéndose pasar por representantes de segurosLos estafadores pueden hacerse pasar por un cliente en una línea telefónica de reclamaciones para robar información confidencial o incluso pagos. A la inversa, un estafador podría hacerse pasar por un cliente en una línea telefónica de reclamaciones para presentar una reclamación por teléfono utilizando una voz falsa que coincida con el sexo o la edad del clienteeludiendo así los controles biométricos de voz. Las recientes estadísticas de fraude son aleccionadoras: los expertos del sector prevén un 162% crecimiento de los ataques fraudulentos deepfake contra las aseguradoras en el próximo año[27]y Pindrop registró un 475% pico de ataques de voz sintética en 2024 como ya se ha mencionado[2]. Estos ataques están superando rápidamente a los vectores de fraude cibernético más tradicionales.

Más allá de las llamadas telefónicas, deepfakes basados en vídeo están surgiendo en el proceso de tramitación de siniestros. Muchas aseguradoras adoptaron las inspecciones virtuales de siniestros y las videoconferencias (aceleradas por la pandemia), para verificar las pérdidas o entrevistar a los reclamantes a distancia. Ahora, los defraudadores aprovechando avatares de IA y vídeos deepfake para engañar a estas verificaciones.. Ha habido informes de reclamantes que utilizan Avatares generados por inteligencia artificial en videollamadas en directo con ajustadores, para hacerse pasar por otra persona u ocultar signos de incoherencia[28]. Por ejemplo, una red de fraude podría utilizar un deepfake vídeo "en directo" de un supuesto demandante mostrando sus daños a través de un smartphonecuando, en realidad, la persona que aparece en cámara es un retrato robot o un actor contratado con filtros que alteran el rostro. Un escenario especulativo pero plausible es el uso de un deepfake de un fallecido persona: En un fraude de rentas vitalicias o seguros de vida, un familiar podría emplear un vídeo deepfake del recién fallecido durante una llamada rutinaria de prueba de vida para seguir recibiendo pagos.[29]. Aunque todavía no se ha hecho público ningún caso destacado de esta naturaleza, las aseguradoras se preparan para ello. Los reguladores también toman nota - En EE.UU. y Europa se está debatiendo la clasificación de las falsificaciones profundas dentro de la usurpación de identidad y la actualización de las directrices para la verificación de pruebas en los seguros.[30].

Detectar vídeos y audio deepfake es muy difícil sin herramientas técnicas. Los ajustadores humanos no están entrenados para discernir sutiles problemas de sincronización labial o rarezas acústicas. Sin embargo, en algunos casos ha habido señales de alarma: por ejemplo, parpadeos antinaturales o fallos faciales en un vídeo, o artefactos de audio de fondo en una llamada que pusieron sobre aviso a los investigadores. Pero en general, el fraude del seguro deepfake aún está en sus primeras fasesEn 2023, las definiciones jurídicas no estaban claras y era difícil demostrar que un vídeo había sido generado por inteligencia artificial sin un análisis experto.[31]. Esto da a los defraudadores una sensación de impunidad. La carrera armamentística está en marcha: las aseguradoras recurren ahora a IA forense para luchar contra la IAUtilización de algoritmos de detección de falsificaciones profundas para examinar fotograma a fotograma los vídeos sospechosos en busca de indicios de manipulación.[24]. Los proveedores de biometría vocal están desarrollando detectores de voz falsa que analizan los patrones espectrales y la cadencia vocal en busca de autenticidad.[32]. Hablaremos de estas tecnologías defensivas en una sección posterior.

Estafas de suplantación de identidad y phishing mejoradas con IA

No todo el fraude posibilitado por la IA pasa por el departamento de reclamaciones; algunos objetivos son clientes y empleados mediante ingeniería social. Correos electrónicos y textos de phishing creados por la IA se han convertido en una gran amenaza en el ámbito de los seguros. En estas estafas, los estafadores utilizan chatbots de IA y herramientas de traducción para generar comunicaciones fraudulentas muy convincentes. Por ejemplo, los delincuentes pueden suplantar la marca y el estilo de escritura de una compañía de seguros para enviar correos electrónicos masivos de phishing a los asegurados, diciéndoles que "es necesario actuar urgentemente para evitar la cancelación de la póliza" y dirigiéndoles a un sitio web falso. A diferencia de los torpes correos electrónicos de estafa del pasado, La IA garantiza una gramática impecable e incluso la personalizacióny hacerlos mucho más creíbles. Hemos visto cómo se utiliza la IA para rastrear las redes sociales en busca de detalles que se entretejen en mensajes de spear-phishing, como la referencia a una compra reciente de un coche en un aviso falso de seguro de automóvil.

Otro vector es Suplantación de agentes o ejecutivos asistida por IA. Ha habido casos en los que los estafadores clonaron la voz del propietario de una agencia de seguros y dejaron mensajes de voz a los clientes solicitando actualizaciones de la información bancaria, lo que supone un ataque de phishing de voz. Del mismo modo, el fraude interno puede derivarse de la suplantación de la IA: el departamento financiero de una aseguradora estuvo a punto de ser víctima cuando los estafadores enviaron un mensaje de audio deepfake supuestamente del Director General autorizar una transferencia de fondos (una variante del "fraude del director general" que ahora cubren algunas pólizas de seguro contra delitos electrónicos).[33]). Este tipo de estafas de suplantación de identidad impulsadas por IA aumentaron 17% en 2023 según Liberty Specialty Markets[33]y se prevé que sigan subiendo.

Los consumidores también son objeto de estafas a través de medios sintéticos. relacionados con los seguros. La Coalición contra el Fraude al Seguro señala casos de impostores que se hacen pasar por peritos de seguros, se ponen en contacto con las víctimas de accidentes alegando que están tramitando su siniestro y luego exigir el pago inmediato o datos sensibles[23]. Los clientes desprevenidos, aliviados al oír hablar a un supuesto representante, pueden acceder, sobre todo si la persona que llama conoce los detalles de su accidente (que AI podría obtener de la piratería informática o de fuentes públicas). La opinión pública es poco consciente de estas tácticas, por lo que los expertos en prevención del fraude instan a las aseguradoras a educar a los asegurados para que verifiquen la identidad de las personas que llaman y de los correos electrónicos[23][34]. Al igual que los bancos advierten a sus clientes sobre el phishing, las aseguradoras en 2025 están empezando a incluir advertencias sobre estafas deepfake en sus comunicaciones.

Uno de los rasgos comunes de estos sistemas mejorados con IA es el uso de kits de "fraude como servicio" de fácil acceso.[35]. En la web oscura, los delincuentes pueden comprar o suscribirse a herramientas que ofrecen voces falsas, plantillas de documentos falsos, generadores de correos electrónicos de phishing y mucho más. Esta democratización de las herramientas de IA significa incluso los estafadores poco cualificados pueden lanzar sofisticados ataques fraudulentos[35]. Para las compañías de seguros, esto se traduce en una avalancha de intentos de fraude más convincentes procedentes de todos los ángulos: reclamaciones, atención al cliente, correo electrónico e incluso redes sociales. Esto subraya la necesidad de una estrategia de defensa múltiple, que combine tecnología, vigilancia humana y colaboración intersectorial.

Detección y defensa: Una respuesta impulsada por la IA

La lucha contra el fraude impulsado por la IA requiere Defensa basada en IA. Las aseguradoras recurren cada vez más a tecnologías avanzadas de detección y a procesos renovados para contrarrestar el ataque. En esencia, las aseguradoras deben integrar puntos de control de autenticación de contenidos a lo largo del ciclo de vida de los seguros -desde la suscripción hasta las reclamaciones y las interacciones con los clientes- para detectar las falsificaciones de IA. En la figura 2 se presenta un desglose de los principales tipos de fraude que permite la IA y su prevalencia, y en las secciones siguientes se detalla cómo detectar e impedir cada uno de ellos.

Figura 2: Tipos de fraude de seguros con IA en 2025 (porcentaje estimado por sistema). Las imágenes falsas (fotos trucadas de daños) y las identidades sintéticas se encuentran entre las categorías más importantes, seguidas de los documentos falsificados por IA (por ejemplo, recibos, certificados) y las estafas de audio/vídeo deepfake.

1. Herramientas de detección de contenidos AI: Los nuevos servicios de detección de IA pueden analizar texto, imágenes, audio y vídeo para determinar si han sido generados o manipulados por máquinas. Por ejemplo, las aseguradoras pueden aprovechar soluciones como Detectores de texto e imágenes AI de TruthScan que utilizan 99%+ IA precisa para marcar documentos escritos con IA o fotos manipuladas.[36]. Una compañía de seguros podría integrar estos detectores en su sistema de reclamaciones: cuando se presenta una reclamación y sus pruebas, la descripción del texto se puede escanear automáticamente en busca de patrones lingüísticos generados por IA, y cualquier imagen cargada se puede escanear en busca de signos reveladores de CGI o edición. Las herramientas para empresas pueden identificar texto generado por IA en documentos, correos electrónicos y comunicaciones con una precisión 99%[36]y del mismo modo detectar imágenes generadas o manipuladas por IA para garantizar la autenticidad de los contenidos visuales[36]. Esto significa que un relato de accidente falso producido por ChatGPT o una foto falsa de los daños a mitad del viaje se marcarían para su revisión manual antes de que se procese la reclamación. En 2025, las aseguradoras están adoptando cada vez más la autenticación de contenidos mediante IA, 83% de los profesionales de la lucha contra el fraude prevén integrar la detección por IA generativa de aquí a 2025según una encuesta de la ACFE, frente a los 18% que lo utilizan en la actualidad.[37][38].

2. Verificación de identidad y controles biométricos: Para hacer frente a las identidades sintéticas, las aseguradoras también están mejorando los protocolos KYC con IA. Los servicios de validación de identidad pueden cotejar los datos de los solicitantes con múltiples bases de datos y utilizar el reconocimiento facial con pruebas de vitalidad. Por ejemplo, exigir un breve vídeo selfie durante el proceso de contratación (y utilizar la comparación facial con el documento de identidad facilitado) puede frustrar muchas identificaciones sintéticas. Empresas de tecnología aún más avanzada, como TruthScan, ofrecen análisis forenses de imágenes que pueden ver fotos de perfil, avatares e imágenes de personajes sintéticos generados por IA - su detector de imágenes AI es entrenado para identificar caras hechas por generadores como StyleGAN o ThisPersonDoesNotExist[39]. Con este tipo de herramientas, una aseguradora puede detectar si el selfie de un solicitante de un seguro de vida no es una persona real. En cuanto a la voz, autenticación biométrica por voz para las llamadas de atención al cliente puede ayudar; los modernos detectores de IA por voz son capaces de identificar voces sintéticas e intentos de clonación de voces en tiempo real[40]. Por ejemplo, TruthScan Detección de voz AI utiliza el análisis acústico para reconocer voces generadas por IA y falsificaciones de audio antes de que engañen al personal del centro de llamadas[40]. Estas soluciones actúan como un cortafuegos: si alguien llama haciéndose pasar por John Doe y su huella vocal no coincide con la voz auténtica de John Doe (o coincide con características conocidas de deepfake), la llamada puede marcarse o se exigen más pruebas de identidad. La autenticación multifactor (confirmación por correo electrónico o SMS, contraseñas de un solo uso, etc.) añade obstáculos adicionales que los suplantadores deben superar.

3. Deepfake Video & Image Forensics: Cuando se trata de pruebas de vídeo, las aseguradoras están empezando a aplicar análisis forenses especializados. Un software avanzado puede analizar los metadatos de vídeo, la coherencia de los fotogramas y los niveles de error para detectar falsificaciones profundas. Algunas herramientas examinan reflejos, sombras y señales fisiológicas (como el pulso en la garganta de una persona en vídeo) para garantizar que un vídeo es auténtico. Metadatos forenses también es valioso: examinar los metadatos de los archivos y las huellas de generación en imágenes o PDF puede revelar si es probable que algo haya sido producido por una herramienta de IA.[41]. Por ejemplo, las aseguradoras deberían exigir archivos fotográficos originales (que contengan metadatos) en lugar de simples capturas de pantalla o copias impresas. El equipo de fraude de Zurich ha detectado con éxito imágenes falsas de coches gracias a la detección de anomalías en los metadatos de la imagen y al análisis del nivel de error.[41]. Detectores de fraudes por correo electrónico también puede escanear las comunicaciones entrantes en busca de señales de contenido de phishing escrito por IA o firmas maliciosas conocidas[42]. Muchas aseguradoras realizan ahora simulaciones de phishing y ejemplos de estafas elaborados con IA en la formación de sus empleados para concienciarlos.

4. Cambios en los procesos y formación humana: La tecnología por sí sola no es una bala de plata. Mejora de los procesos Se están realizando controles aleatorios en persona más frecuentes para las reclamaciones de alto valor, o exigiendo documentación física en determinados casos. Algunas aseguradoras han retrasado la tramitación automatizada de los siniestros, reintroduciendo la revisión humana de los siniestros que obtienen una puntuación alta en un modelo de riesgo de fraude basado en IA. Desde el punto de vista humano, la formación es crucial. Los investigadores de fraudes y los peritos están recibiendo formación para reconocer las señales de alarma de la IA: por ejemplo, varias reclamaciones con una redacción idéntica (el "estilo" ChatGPT), imágenes que carecen de verdadera aleatoriedad (por ejemplo, patrones repetitivos en lo que deberían ser daños orgánicos), o voces que suenan a casi correcta pero tienen cadencia robótica. Las aseguradoras también están educando a los clientes: envían alertas de fraude sobre los esquemas de deepfake y aconsejan cómo verificar la identidad de un representante de seguros (por ejemplo, proporcionando un número de devolución de llamada conocido).

5. Esfuerzos de colaboración: Se está intensificando la colaboración en todo el sector. En el Reino Unido, la Oficina contra el Fraude en los Seguros y la Asociación de Aseguradoras Británicas han creado grupos de trabajo sobre el fraude de la IA, y la agencia gubernamental Carta contra el fraude en los seguros (2024) fomenta el intercambio de datos y las iniciativas conjuntas[43]. En todo el mundo, las aseguradoras se están asociando con empresas de ciberseguridad y startups de IA. En particular, están apareciendo nuevos productos de seguros: Liberty Mutual lanzó un Seguro de ciberdelincuencia para PYME que cubre específicamente las estafas de deepfake y el fraude de los directores generales.[44][33]lo que pone de manifiesto que este riesgo es muy real. Esto también significa que las aseguradoras podrían ser a la vez víctimas y solucionadoras del fraude de IA, pagando por una estafa de deepfake si no se detecta, pero también ofreciendo cobertura a otros que sufran este tipo de ataques.

La integración de la tecnología de detección en los flujos de trabajo puede visualizarse como una defensa multipunto en el ciclo de vida de las reclamaciones. Como se muestra en Figura 3las aseguradoras pueden insertar pasos de verificación de la IA en aplicación de la política (para detectar identidades sintéticas mediante comprobaciones de documentos de identidad y selfies), en presentación de reclamaciones (para analizar automáticamente documentos, fotos o audio cargados para la generación de IA), durante revisión/investigación de siniestros (para realizar un análisis forense deepfake de las pruebas sospechosas y verificar cualquier interacción de voz), y justo antes de pago (una autenticación final de la identidad para garantizar que el beneficiario es legítimo). La detección precoz del fraude, idealmente en la contratación o en el primer aviso de siniestro, ahorra a las aseguradoras costes de investigación y evita pagos indebidos.

Figura 3: Integración de puntos de detección de IA en el ciclo de vida de los seguros. En la contratación de pólizas, la validación de identidad basada en IA comprueba si hay identidades sintéticas o falsas. Cuando se presenta una reclamación, detectores automatizados analizan el texto, los documentos y las imágenes de la reclamación en busca de contenido generado por IA. Durante la revisión de las reclamaciones, herramientas especializadas de análisis de voz y de falsificación profunda verifican cualquier prueba de audio o vídeo. Antes del pago, la verificación biométrica de la identidad confirma la identidad del beneficiario. Este enfoque multicapa ayuda a interceptar el fraude en múltiples etapas.

Las aseguradoras no tienen por qué crear todas estas capacidades internamente: muchas recurren a soluciones empresariales como Suite de detección de IA de TruthScanque ofrece una serie de herramientas que pueden integrarse mediante API en los sistemas de las aseguradoras. Por ejemplo, Servicio AI de detección de imágenes falsas y falsificaciones de TruthScan puede utilizarse para verificar la autenticidad de imágenes y vídeos con una precisión superior al 99%[45]. Su Detector de texto AI marca el texto escrito con IA en reclamaciones o correos electrónicos[36]mientras que el Detector de voz AI ofrece detección de clonación de voz y verificación del altavoz para detener a los impostores telefónicos[40]. Existen incluso herramientas especializadas como Detector de recibos falsos para analizar al instante facturas/recibos en busca de signos de manipulación o fuentes/formatos generados por IA[46] - extremadamente útil dada la prevalencia de facturas de reparación falsas en las reclamaciones. Combinando estas herramientas, una aseguradora puede mejorar drásticamente su tasa de detección de fraudes. Una aseguradora de la lista Fortune 500 declaró haber detectado 97% de intentos de deepfake en 2024 utilizando un método de detección de IA por capas (texto, imagen, voz) y evitando así pérdidas estimadas en \$20M.[47][48].

Conclusión

La IA está transformando el campo de batalla del fraude a las aseguradoras a escala mundial. Los estafadores están innovando con IA generativa para crear falsedades más convincentes que nunca, desde personas y accidentes totalmente inventados hasta suplantaciones que pueden engañar incluso a profesionales experimentados. Los datos de 2024-2025 muestran un crecimiento alarmante de estas estafas alimentadas por IA, pero también ponen de relieve que las aseguradoras que invierten en detección y prevención pueden ir un paso por delante. Combinando tecnología punta de detección de IA - como el análisis forense de imágenes, la autenticación de voz y el análisis de texto, con flujos de trabajo actualizados y formación, el sector puede mitigar los riesgos sin sacrificar la eficacia que aportan los procesos digitales.

En el fondo, se trata de una carrera armamentística tecnológica[49]. Como señaló un experto en prevención del fraude, "En esta nueva realidad, la vigilancia es la prima que hay que pagar"[50]. Las compañías de seguros deben fomentar una cultura de vigilancia y aprovechar las mejores herramientas disponibles para preservar la confianza en el proceso de reclamación. Esto significa verificar la veracidad de documentos, voces e imágenes con el mismo rigor que los suscriptores utilizan para evaluar el riesgo. También significa colaborar en todo el sector para compartir información sobre las nuevas tácticas de fraude de IA y desarrollar conjuntamente normas (por ejemplo, requisitos de metadatos estándar para los medios enviados o listas negras del sector de identidades falsas conocidas).

2025 es un punto de inflexión: las aseguradoras que adaptarse proactivamente al fraude impulsado por la IA protegerán a sus clientes y sus balances, mientras que las que tarden en responder pueden convertirse en blanco de estafas que acaparen titulares. La noticia alentadora es que la tecnología para contraatacar existe y está madurando rápidamente: la misma IA que da poder a los estafadores puede darlo a las aseguradoras. Mediante la implementación de soluciones como la suite de detección multimodal de IA de TruthScan para reclamaciones y verificación de identidad, las aseguradoras pueden reducir drásticamente la tasa de éxito de los intentos de fraude generados por IA.[51][52]. De este modo, no sólo evitan pérdidas, sino que también envían un mensaje claro a los posibles defraudadores: no importa lo ingeniosas que sean las herramientas, se descubrirá el fraude.

En resumen, el fraude de seguros impulsado por la IA es un reto formidable, pero al que se puede hacer frente con una defensa igualmente inteligente. Con vigilancia, una estrategia interfuncional y los socios tecnológicos adecuados, el sector de los seguros puede seguir manteniendo la promesa fundamental de su negocio: pagar solo las reclamaciones legítimas, y hacerlo con rapidez y seguridad en un mundo cada vez más digital.

Referencias:

- Asociación de Aseguradoras Británicas - Estadísticas de fraude 2023[53][54]

- Allianz y Zurich, sobre el aumento de los siniestros por "falsificación superficial" de inteligencia artificial. The Guardian, 2024[4][11]

- Facia.ai - "Fraude de seguros Deepfake: Cómo la IA está reescribiendo las reglas". Oct 2025[55][56]

- Coalición contra el Fraude en los Seguros - Fraude sintético en los seguros (Quantexa), Dic 2024[21][17]

- RGA - "La nueva frontera de la lucha contra el fraude: las identidades sintéticas". Junio de 2025[15][16]

- Pindrop - Informe sobre el fraude de voz, vía FierceHealthcare, Jun 2025[2][3]

- Números que giran - "Los principales fraudes financieros en 2025". Oct 2025[1][57]

- TruthScan - Plataforma de detección de IA (resumen de servicios), 2025[51][52]

- TruthScan - Página del producto AI Image Detector, 2025[45][39]

- TruthScan - Página del producto AI Voice Detector, 2025[40]

- TruthScan - Página de producto del Detector de Recibos Falsos, 2025[46]

- Liberty Specialty Markets - Comunicado de prensa de Deepfake/Cyber Fraud Insurance, Mar 2025[33]

- Facia.ai - Blog: Carrera armamentística en la prevención del fraude a las aseguradoras, 2025[24][32]

- Insurance Business UK - "Imágenes generadas por IA utilizadas para el fraude automovilístico". Abr 2025[7][58]

- The Guardian - "Las fotos falsas de daños en coches alarman a las aseguradoras". Mayo de 2024[9][12]

[1] [35] [57] 2025 Esquemas de fraude financiero: Amenazas de la IA y señales de alarma

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] El fraude a las aseguradoras aumentó en 19% por ataques de voz en 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Estafadores editan fotos de vehículos para añadir daños falsos en una estafa al seguro británico | Industria aseguradora | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] Las imágenes generadas por inteligencia artificial se utilizan ahora para el fraude en el seguro del automóvil | Insurance Business UK

[13] [14] [15] [16] La nueva frontera de la lucha contra el fraude: identidades sintéticas y carrera armamentística de la IA | RGA

[17] [18] [19] [20] [21] [22] JIFA: Fraude sintético: Con el fraude sintético ya en su ecosistema, las aseguradoras deben pensar más como los bancos - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Fraude de seguros Deepfake: Cómo la IA está reescribiendo las reglas de las reclamaciones de seguros

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] La amenaza silenciosa: Por qué el fraude al seguro se traslada a la línea telefónica

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] El seguro de ciberdelincuencia para PYMES se centra en el fraude de los directores ejecutivos y los "deepfakes" - LSM | Insurance Business UK

[36] [42] [51] TruthScan - Detección de IA empresarial y seguridad de contenidos

[37] Estudio: 8 de cada 10 luchadores contra el fraude esperan desplegar IA generativa en 2025

[38] Conclusiones del Informe de evaluación comparativa de la tecnología antifraude 2024

[39] [45] AI Image Detector - Detecta Fotos Falsas y Manipuladas - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI Voice Detector for Deepfakes & Voice Cloning | TruthScan

https://truthscan.com/ai-voice-detector

[46] Detector de recibos falsos TruthScan | Verificar la autenticidad de los recibos

https://truthscan.com/fake-receipt-detector

[47] La aseguradora Fortune 500 detecta 97% de Deepfakes y detiene ...