Una guía completa para comprender, detectar y prevenir el fraude de voz con IA en la empresa

La llamada de voz de $25 millones que nunca ocurrió

En febrero de 2024, una empleada de finanzas de una multinacional de Hong Kong recibe una videollamada de su director financiero.

La voz del otro lado era inconfundible; cada inflexión, cada pausa e incluso el ligero acento se reconocían al instante.

Le pidió urgentemente que tramitara 15 transferencias bancarias, por un total de $25 millones, para finalizar una adquisición confidencial.

No vuelva a preocuparse por el fraude de IA. TruthScan puede ayudarle:

- Detectar IA generada imágenes, texto, voz y vídeo.

- Evite grandes fraudes impulsados por la IA.

- Proteja sus sensible activos de la empresa.

El director financiero nunca tomó esa decisión. Fue completamente generada por la IA.

No se trata de un caso aislado. Las instituciones financieras están experimentando un fuerte aumento de los fraudes de deepfake.

En los últimos tres años, los casos se han disparado en 2.137%, y la IA protagoniza ya el 42,5% de todos los intentos de fraude en el sector.

Incluso con el aumento del fraude de voz por IA, más de la mitad de los líderes empresariales admiten que sus empleados no han recibido formación para detectar o responder a los ataques de deepfake; casi el 80% de las empresas no tienen protocolos formales para gestionar estos incidentes.

Cómo funciona la clonación de voz por IA y por qué es una amenaza

La síntesis de voz de la IA moderna necesita sorprendentemente pocos datos. Con solo unos segundos de audio se puede clonar una voz con una precisión de hasta 85%.

El proceso se reduce a tres pasos principales:

- Recogida de datos: Los estafadores recogen muestras de voz de fuentes públicas, como conferencias telefónicas, entrevistas de podcast, clips de redes sociales o incluso vídeos de LinkedIn.

- Formación de modelos: La IA analiza rasgos vocales como el tono, el timbre, el acento, el ritmo y los patrones de respiración.

- Generación: El sistema crea un habla sintética lo bastante convincente como para engañar incluso a colegas cercanos.

El problema de la accesibilidad

Lo que hace aún más peligrosa esta amenaza es su democratización. Los estafadores ya no necesitan recursos del nivel de Hollywood.

Todo lo que se necesita es un software accesible para clonar una voz a partir de un breve clip de las redes sociales; las herramientas de código abierto y los servicios de IA basados en la nube han puesto la clonación de voces al alcance de cualquiera con conocimientos técnicos básicos.

Por qué los ejecutivos son el principal objetivo del fraude

Los ejecutivos se enfrentan a una peligrosa mezcla de factores de riesgo.

Su exposición pública a través de las redes sociales hace que las muestras de voz sean fáciles de encontrar, y su autoridad suele impulsar a los empleados a actuar con rapidez ante peticiones urgentes.

Por término medio, uno de cada cuatro ejecutivos tiene un conocimiento limitado de la tecnología deepfake.

Las estadísticas actuales dibujan un panorama preocupante

En un 2024 Encuesta DeloitteEl 25,9% de los ejecutivos afirmaron que sus organizaciones se habían enfrentado al menos a un incidente de deepfake dirigido a datos financieros o contables en el último año, y la mitad de los encuestados creían que estos ataques aumentarían en los próximos 12 meses.

Lo más preocupante: sólo 52% de las organizaciones se sienten seguras de poder detectar un deepfake de su CEO.

Cómo detectar las estafas de AI Voice

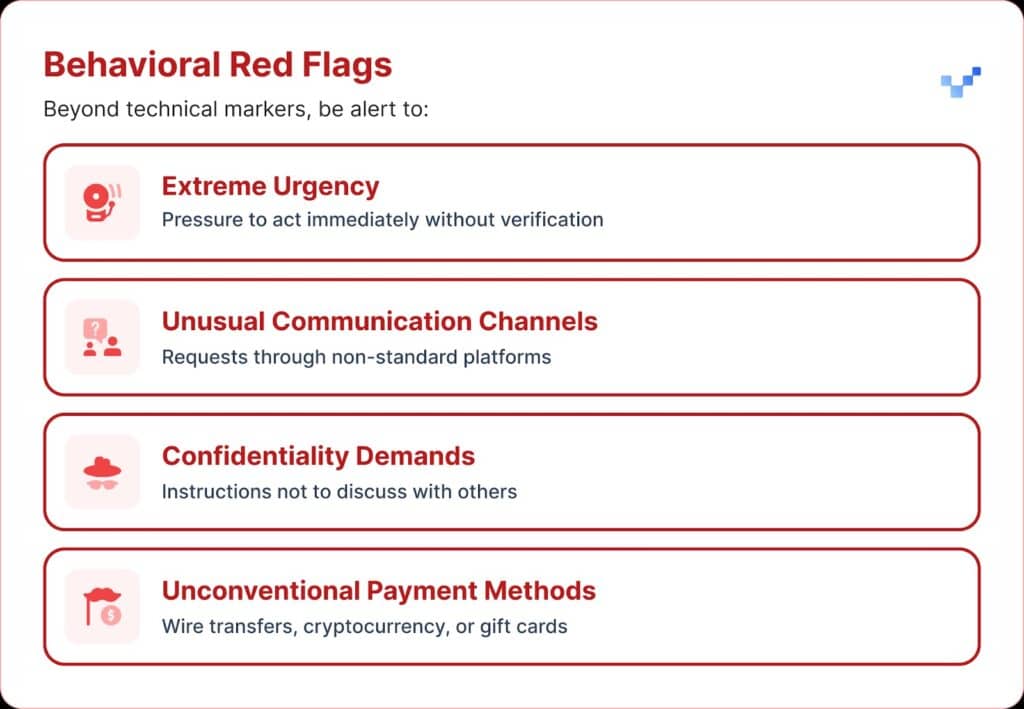

Cuando reciba una comunicación de voz sospechosa, debe prestar atención a algunas señales de advertencia.

Las estafas con voz de IA suelen sonar monótonas o planas. También puede notar un ritmo inusual, con pausas extrañas o un ritmo poco natural.

El audio también puede llevar débiles zumbidos electrónicos o ecos, especialmente durante las llamadas más largas.

Y en muchos casos, la voz repite frases limitadas que parecen escritas o ensayadas.

Impacto financiero y coste real

La mayoría de las organizaciones perdieron alrededor de $450.000 de media, pero en el sector de los servicios financieros las pérdidas superaron los $603.000.

Y en los casos más graves, 1 de cada 10 organizaciones declararon pérdidas de más de $1 millón.

Esta tendencia ha crecido rápidamente. Investigaciones anteriores de 2022 indicaban que la carga financiera media del fraude de identidad era de unos $230.000, casi la mitad de la cifra actual.

Pérdidas futuras previstas

Según el Centro de Servicios Financieros de Deloitte, el dinero perdido por fraude de IA en Estados Unidos podría pasar de $12.300 millones en 2023 a $40.000 millones en 2027. Eso supone un crecimiento de 32% cada año.

Vulnerabilidad regional

América del Norte experimentó un aumento de 1740% en fraudes de deepfake.

Este significativo aumento regional sugiere que Norteamérica puede ser un objetivo principal para los estafadores de deepfake, probablemente debido a su gran economía digital y al uso generalizado de servicios en línea.

Enfoques estratégicos para la protección de ejecutivos

1. Aplicar protocolos de verificación

Una forma de reforzar las defensas es utilizar un sistema de "palabras seguras", frases de autenticación acordadas previamente y compartidas con el personal clave.

Un estafador que utilice la clonación de voz por IA no sabrá las respuestas correctas a las preguntas de verificación personal.

Otra salvaguardia es la verificación multicanal.

Cualquier solicitud financiera inusual debe confirmarse a través de un canal de comunicación independiente, sin depender nunca únicamente del método de contacto original.

Las empresas también deben establecer normas claras de escalado, con periodos de espera y pasos de aprobación para las grandes transacciones financieras, independientemente de quién las solicite.

2. Cuidado con la exposición digital

Otra capa de protección consiste en limitar la cantidad de audio y vídeo ejecutivo disponible en Internet. Cuantas más muestras puedan recoger los estafadores, más convincentes resultarán sus clones.

También ayuda establecer directrices claras para los ejecutivos en las redes sociales, especialmente en lo que respecta a la publicación de vídeos con audio limpio.

Y cuando se trata de conferencias, las organizaciones deben tener cuidado con las charlas o entrevistas grabadas que ofrecen largas muestras de voz.

3. Implantar soluciones técnicas

Aquí es donde la tecnología avanzada de detección de IA resulta fundamental.

Las organizaciones necesitan autenticación de voz de nivel empresarial y detección de deepfake capacidades que proporcionan:

- Análisis en tiempo real: Detectar voces sintéticas durante las comunicaciones en directo

- Verificación histórica: Analizar la autenticidad de las llamadas y mensajes grabados

- Capacidades de integración: Funciona a la perfección con las plataformas de comunicación existentes

- Altos índices de precisión: Minimice los falsos positivos y detecte las falsificaciones más sofisticadas

4. Programas integrales de formación

Los equipos directivos necesitan formación específica sobre las amenazas de voz de la IA y los procedimientos de verificación.

Igual de importante es concienciar a los empleados.

Todo el mundo, en cualquier puesto, debería estar equipado para detectar posibles falsificaciones y evitar que las ciberamenazas entren en la organización.

Los ejercicios periódicos de simulación pueden reforzar esta preparación utilizando intentos simulados de fraude de voz para probar y perfeccionar los procedimientos de respuesta.

Soluciones avanzadas de IA para la detección de voz

Las defensas tradicionales se crearon para las amenazas basadas en la red, no para la suplantación humana impulsada por IA.

Las principales razones por las que las herramientas de ciberseguridad estándar no pueden hacer frente a la ingeniería social basada en la voz:

- Sin firma de malware: Las llamadas de voz no activan los sistemas de seguridad tradicionales

- Factor de confianza humana: La gente se fía de lo que oye, sobre todo de las voces familiares.

- Lagunas tecnológicas de detección: A pesar del aumento de los intentos de fraude impulsados por la IA, incluidos los deepfakes, solo el 22% de las instituciones financieras ha implementado herramientas de prevención del fraude basadas en IA

La necesidad de una detección de voz especializada

El fraude de voz moderno requiere capacidades de detección modernas.

Calidad empresarial Sistemas de detección de voz por IA puede:

- Analizar los biomarcadores vocales: Detectar sutiles incoherencias en el habla sintética

- Procesamiento en tiempo real: Alerta inmediata en caso de llamadas sospechosas

- Aprendizaje continuo: Adaptarse a las nuevas técnicas de síntesis vocal

- Preparado para la integración: Trabajar con la infraestructura de comunicación existente

Las organizaciones que se tomen en serio la protección contra el fraude de voz deben invertir en tecnología de detección de IA específica que pueda igualar la sofisticación de las amenazas a las que se enfrentan.

El fraude de voz ya está aquí y va en aumento

En el primer trimestre de 2025, el fraude por deepfake y el robo de identidad causaron más de $200 millones en pérdidas.

El phishing de voz con clones de IA se disparó 442%, y más de 400 empresas al día están siendo atacadas con estafas deepfake de CEO o CFO.

Mientras que 56% de las empresas afirman sentirse muy seguras a la hora de detectar deepfakes, sólo 6% han evitado realmente sufrir pérdidas económicas por su causa.

Lo importante no es si su organización será objeto de ataques, sino si está preparada para ello.

El fraude por voz está cambiando la cara de la ciberseguridad. Las defensas tradicionales no pueden hacer frente a la suplantación de identidad con IA.

Para mantenerse protegidas, las organizaciones necesitan mejores herramientas de detección, programas de formación sólidos y procedimientos de verificación claros.

La tecnología para contraatacar ya está aquí. La verdadera cuestión es si la utilizarás antes o después de tu primer incidente de fraude de voz.