Introducción

La IA generativa está revolucionando la atención sanitaria, y no siempre para mejor. En 2025, las tramas de fraude sanitario han crecido más digital y sofisticada, impulsada por las violaciones de datos, la automatización y la IA generativa.[1]. Los delincuentes aprovechan las herramientas de IA para crear identidades falsas de pacientes, reclamaciones de seguros sintéticas, documentos médicos generados por IA, recetas falsificadas e incluso interacciones médico-paciente falsificadas.. Estos engaños de alta tecnología elevan el fraude a nuevas cotas, amenazando las finanzas de las aseguradoras y la seguridad de los pacientes en todo el mundo. El reto es enorme: el fraude sanitario cuesta ya decenas de miles de millones al año, y el auge de la IA está intensificando tanto la escala como la complejidad de estafas[2][3]. Este informe técnico ofrece una visión detallada de las últimas tendencias de fraude impulsado por IA en sanidad, casos reales de 2025 y estrategias -desde detectores de contenido de IA hasta verificación de identidad- para combatir esta amenaza en evolución.

El auge de las tramas de fraude en la sanidad basadas en la inteligencia artificial

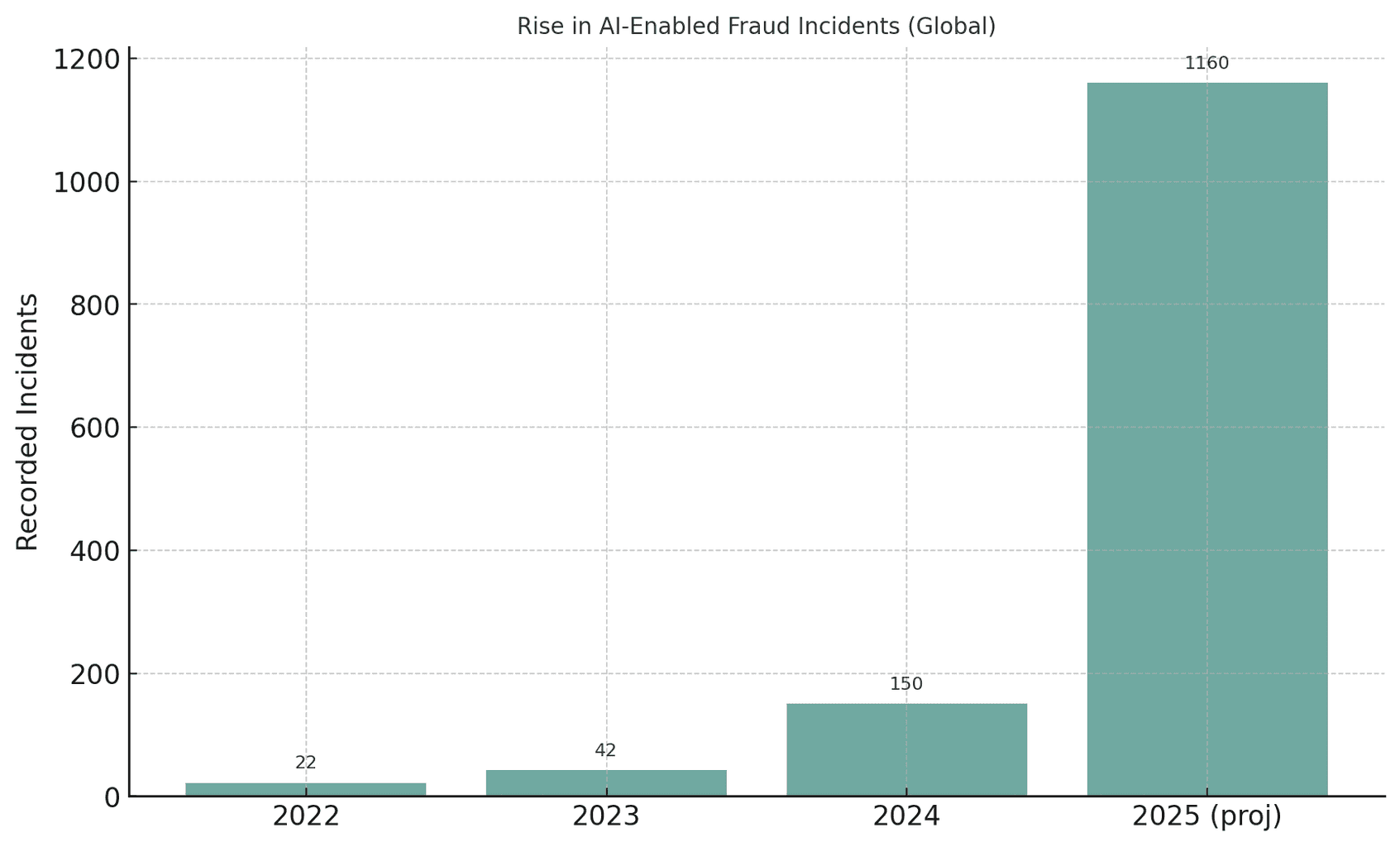

El sector sanitario mundial está experimentando un aumento sin precedentes de los intentos de fraude basados en IA. A medida que la IA generativa se hace accesible, los estafadores pueden automatizar lo que antes eran estafas manuales, produciendo a gran escala identidades, documentos e incluso voces o vídeos falsos y convincentes. Por ejemplo, las autoridades observaron que los intentos de fraude con deepfake media aumentaron un 3.000% en 2023 solo[4][5]. Los incidentes relacionados con deepfakes casi se duplicaron, pasando de 22 en 2022 a 42 en 2023, y luego se dispararon a 150 incidentes en 2024; asombrosamente, en el primer trimestre de 2025 se produjeron 179 casos de fraude por deepfake, superando ya el total de 2024.[6][7]. Esta tendencia sugiere una crecimiento galopante del fraude impulsado por la IALos analistas predicen que la IA generativa podría aumentar las pérdidas por fraude de 1.000 millones de euros a 2.000 millones de euros. $12.300 millones en 2023 a $40.000 millones en 2027 (32% CAGR)[8].

Figura: El crecimiento explosivo de los incidentes de fraude asistidos por IA en los últimos años. Los casos detectados de deepfake o fraude asistido por IA han aumentado drásticamente de 2022 a 2025, lo que ilustra cómo las herramientas de IA generativa han potenciado los intentos de estafa.[4][7].

No vuelva a preocuparse por el fraude de IA. TruthScan puede ayudarle:

- Detectar IA generada imágenes, texto, voz y vídeo.

- Evite grandes fraudes impulsados por la IA.

- Proteja sus sensible activos de la empresa.

La sanidad es especialmente vulnerable a esta ola de delincuencia alimentada por la IA. El vasto y fragmentado ecosistema del sector -que abarca hospitales, clínicas, aseguradoras, farmacias y plataformas de telesalud- ofrece miles de puntos de ataque[9][10]. Las estafas tradicionales (por ejemplo, tarjetas de seguro falsas o identificaciones de pacientes robadas) han evolucionó hacia una explotación sistémica utilizando la IA[10][11]. En una operación llevada a cabo en Estados Unidos en 2025, el Departamento de Justicia imputó a 324 acusados en tramas por un total de 1,5 millones de euros. $14.600 millones en reclamaciones falsas: el mayor caso de fraude sanitario de la historia[12][13]. Muchas de las estafas consistían en consultas de telemedicina y fraudes en pruebas genéticas. Centro de Fusión de Datos sobre Fraude Sanitario utilizó análisis de IA para detectar patrones de forma proactiva[14][15]. Está claro que la IA es un arma de doble filo: ayuda a los investigadores a descubrir el fraude, pero también permitiendo a los delincuentes cometer fraudes a una escala y con una sofisticación sin precedentes[11][2].

Técnicas habituales de fraude basado en IA en la sanidad (2025)

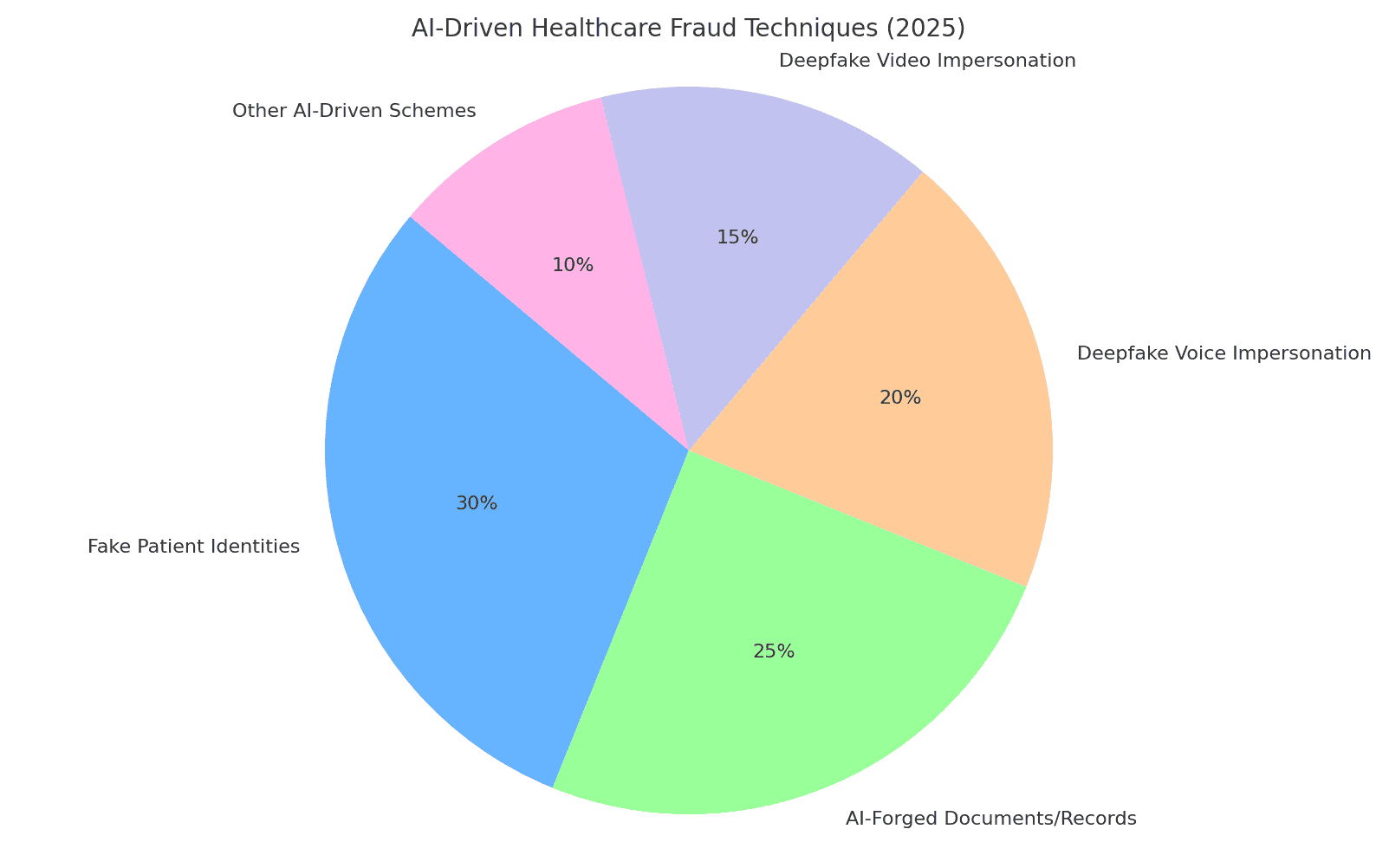

En 2025, los defraudadores dispondrán de un conjunto de tácticas basadas en IA para estafar a los sistemas sanitarios y las aseguradoras. Entre las principales maniobras se encuentran la falsificación de identidades y documentos, la generación de datos médicos falsos y la suplantación de personal de confianza mediante deepfakes. A continuación desglosamos las técnicas de fraude basadas en IA más frecuentes y cómo se utilizan contra las organizaciones sanitarias:

Figura: Desglose de las principales técnicas de fraude sanitario impulsadas por IA en 2025. Identidades falsas de pacientes y Documentos falsificados con IA (por ejemplo, historiales médicos, reclamaciones) constituyen una gran parte de las tramas, mientras que las deepfake voz y imitaciones en vídeo son una amenaza en rápido crecimiento. "Otros sistemas basados en IA" incluyen correos electrónicos de phishing elaborados con IA, bots que atacan portales de pacientes y exploits similares (porcentajes estimados basados en informes del sector).[8][16]).

Identidades sintéticas de pacientes

Identidades falsas de pacientes - creadas a menudo con ayuda de la IA, son una táctica de fraude fundamental. En lugar de robar la identidad de una persona, los delincuentes combinan datos reales de varias personas con detalles inventados para crear... identidades sintéticas que pasan por nuevos pacientes[17][18]. La IA generativa acelera este proceso produciendo registros personales realistas. Por ejemplo, la IA puede generar Identificaciones, perfiles, incluso historiales familiares ("padres sintéticos") para un paciente falso.[19][20]. Estos pacientes fantasma se utilizan para abrir cuentas, obtener pólizas de seguros o facturar servicios que nunca se produjeron. Durante la pandemia de COVID-19, los estafadores utilizaron identificaciones sintéticas para acceder a prestaciones sanitarias de emergencia; ahora las utilizan para presentar reclamaciones falsas al seguro u obtener recetassabiendo que una identidad bien elaborada puede eludir la detección[21][22]. Según la Reserva Federal de EE.UU., las pérdidas derivadas del fraude de identidad sintética ascendieron a 1.000 millones de euros. $35.000 millones en 2023 y seguir subiendo[23]. El impacto en la atención sanitaria es grave: los estafadores pueden utilizar el número de la Seguridad Social robado a un niño para crear un paciente falso con un crédito perfecto, o mezclar datos robados de pacientes para eludir la verificación de la aseguradora.[17][24]. Cada paciente sintético introducido en el sistema socava la integridad de los datos y puede dar lugar a pagos indebidos o incluso errores clínicos si la identidad falsa se entremezcla con los historiales médicos reales.

Documentos médicos y reclamaciones de seguros generados por IA

La IA generativa se utiliza ahora para forjar documentos médicos, historiales y reclamaciones de seguros completas. Los modelos lingüísticos pueden producir notas médicas, resúmenes de altas, resultados de laboratorio o extractos de facturación llenos de jerga médica que parezcan auténticos, todo ello adaptado para respaldar una reclamación fraudulenta. De hecho, los observadores del sector informan de un 89% aumento de los documentos médicos generados por IA que se presentan, en comparación con años anteriores[25][26]. Los estafadores aprovechan estos registros falsos para justificar procedimientos o medicamentos caros que nunca se suministraron, o para inflar los códigos de reembolso. Por ejemplo, una IA podría generar un informe de diagnóstico por imagen o resultado de laboratorio para justificar una solicitud de medicamentos oncológicos de alto coste. Las aseguradoras y los sistemas sanitarios se enfrentan a una avalancha de este tipo de reclamaciones. papeleo sintéticolo que hace más difícil distinguir las reclamaciones legítimas de las falsas. En el Reino Unido, las aseguradoras observan un rápido aumento del uso de deepfakes y documentos falsificados en el fraude de siniestros, a menudo en reclamaciones aparentemente rutinarias de poco valor para evitar el escrutinio.[27]. Ni siquiera la imaginería clínica es inmune: hay pruebas de que los estafadores utilizan IA generativa para imitar imágenes médicas como radiografías o escáneres[3]. Las consecuencias van más allá de las pérdidas económicas: si los historiales médicos falsificados entran en los expedientes de los pacientes, pueden dar lugar a diagnósticos erróneos o tratamientos inadecuados. Así pues, Los documentos sanitarios escritos con IA plantean un grave riesgo para la integridad y la seguridad.

Falsificación de recetas y fraude farmacéutico

El fraude en la prescripción ha entrado en la era digital con la IA. Recetas falsificadas - que tradicionalmente se hacían con talonarios de recetas robados o con una edición rudimentaria, ahora se pueden autogenerar con detalles realistas y firmas de médicos. Los generadores de imágenes AI o plantillas hacen que sea trivial crear impresiones de recetas electrónicas de aspecto auténtico o formularios de pedido de farmacias. De forma más insidiosa, los delincuentes utilizan clonación de voz para hacerse pasar por médicos en llamadas con farmacéuticos. En uno de los casos denunciados, los estafadores pirateaban los historiales médicos para robar los números de registro de la DEA de los médicos y luego utilizaban esas credenciales para enviar recetas electrónicas de sustancias controladas.[28]. Se han dado casos de Falsificaciones de voz con IA para autorizar recargas - un farmacéutico recibe una llamada que suena exactamente igual que la de un médico conocido confirmando una receta, pero en realidad es una voz generada por IA. Como resultado, pueden obtenerse y desviarse ilegalmente medicamentos controlados (como opioides o estimulantes). El fraude en la falsificación de recetas no sólo causa pérdidas económicas a aseguradoras y farmacias, sino que pone en peligro a los pacientes, que pueden recibir medicamentos incorrectos en sus historiales. Por ejemplo, si un defraudador se hace pasar por un paciente para obtener recetas de opioides, la el expediente médico de un paciente real podría actualizarse con medicamentos que nunca tomó, lo que daría lugar a interacciones peligrosas o lo señalaría como consumidor de medicamentos[29]. Esta mezcla de ciberdelincuencia y explotación de la IA ha suscitado advertencias de los organismos reguladores. Las organizaciones sanitarias ahora deben verificar que cada receta -especialmente los medicamentos de alto riesgo- sea legítima y... procedente realmente del proveedor autorizadono un deepfake o una violación de datos.

Imitaciones falsas de médicos y pacientes

Quizá lo que más llame la atención sea el uso de deepfakes para hacerse pasar por personal sanitario o pacientes. En los ámbitos de la telemedicina y la atención al cliente, los estafadores utilizan vídeo y audio generados por inteligencia artificial para engañar a los interlocutores. Por ejemplo, los delincuentes han creado vídeos deepfake de pacientes para consultas de telesalud, engañando a los médicos para que proporcionen "tratamientos" o derivaciones que luego se facturan a las aseguradoras.[30][31]. A la inversa, un estafador puede falsificar la imagen de un médico -utilizando la cara y la voz de un médico de buena reputación- en una videollamada para convencer a un paciente para que pague por un servicio fraudulento o divulgue información personal. Los expertos en informática sanitaria advierten de que la telesalud se ha convertido en un blanco fácilLa tecnología: se puede concertar una cita virtual con una identidad de paciente falsa y, a continuación, hacer que un avatar de inteligencia artificial intervenga en el vídeo para obtener recetas o consejos médicos de forma fraudulenta.[31][32]. Más allá de la telemedicina, los deepfakes están saturando las redes sociales en forma de vídeos de "médicos" promocionando curas milagrosas. En 2024, los expertos observaron que deepfaked vídeos de médicos famosos "realmente despegóDirigiéndose a un público de edad avanzada con falsos consejos de salud y productos fraudulentos.[33][34]. En el Reino Unido y Francia se clonó la imagen de médicos de confianza para promocionar falsos remedios contra la diabetes y suplementos para la tensión arterial.[35][36]. Hasta la mitad de los espectadores no pudieron distinguir si estos vídeos médicos de deepfake eran falsos[37]. Esta erosión de la verdad tiene costes tangibles: los pacientes pueden seguir consejos perjudiciales de un vídeo de un médico falso, o los estafadores pueden facturar a las aseguradoras consultas que nunca se produjeron salvo como una grabación deepfake. En definitiva, La suplantación impulsada por la IA socava la confianza fundamental en las interacciones sanitarias - si no se puede confiar en que la persona que aparece en la pantalla o en el teléfono es quien dice ser, todo el sistema está en peligro.

Impacto y escala: el fraude de 2025 en cifras

El fraude impulsado por la IA ha dejado de ser un problema marginal para convertirse en una importante sangría financiera y una amenaza para la seguridad en todos los sistemas sanitarios del mundo. Considérense las siguientes estadísticas y casos recientes que ilustran la magnitud del problema:

- Pérdidas anuales: Se calcula que el fraude en la atención sanitaria cuesta a EE.UU. unos 1.000 millones de euros al año. $68 mil millones o más al año[25]aproximadamente 3-10% de todos los gastos sanitarios[38]. En todo el mundo, el fraude puede consumir unos 6% del gasto sanitario[39] - una cifra asombrosa si se tiene en cuenta que el gasto sanitario mundial asciende a billones de dólares. En última instancia, estas pérdidas se traducen en primas más elevadas, mayores costes hospitalarios y menores recursos para la atención al paciente.

- Repunte del fraude en 2023-2025: La llegada de la IA generativa ha provocado una explosión de intentos de fraude. Los incidentes de fraude relacionados con Deepfake aumentaron diez veces de 2022 a 2023[4]. En 2024, los incidentes de deepfake denunciados ascendieron a 150 (un aumento de 257%)[40]y 2025 va camino de superarlo con creces (580 incidentes sólo en el primer semestre de 2025, casi el cuádruple que en 2024).[7]. Los expertos en fraude señalan que 46% se han enfrentado a fraudes de identidad sintéticos, 37% a falsificaciones de voz y 29% a falsificaciones de vídeo. en sus investigaciones[8] - que pone de relieve lo comunes que se han vuelto estas técnicas de IA.

- Récord de derribos: Los organismos encargados de hacer cumplir la ley están respondiendo con mayores medidas represivas. En junio de 2025, el Departamento de Justicia de EE.UU. anunció la el mayor fraude sanitario de la historiaacusando a 324 individuos y descubriendo $14.600 millones en reclamaciones fraudulentas[1][13]. Las estafas incluían consultas de telemedicina, pruebas genéticas y equipos médicos duraderos a gran escala.[13]. Como parte de este esfuerzo, Medicare suspendió $4.000 millones en pagos pendientes considerado sospechoso[41]evitar esas pérdidas. Un caso emblemático ("Operación Fiebre del Oro") reveló la existencia de una red internacional que utilizaba identidades robadas para presentar $10.600 millones en reclamaciones falsas por suministros médicos[42] - un testimonio de lo lejos que llegarán los delincuentes cuando dispongan de datos violados y automatización.

- Impactos de las aseguradoras: Las aseguradoras de todo el mundo aumento del fraude relacionado con la IA. En el Reino Unido, las aseguradoras informan de que cada vez se recurre más a las falsificaciones en los siniestros (a menudo, siniestros "poco delicados" para evitar ser detectados).[27]. Una de las principales empresas de reaseguros advierte de que la falsificación de historiales médicos y las enfermedades falsas están socavando la suscripción y podrían aumentar las pérdidas de los seguros de vida y salud.[43]. Un análisis de Deloitte de 2024 preveía que para 2027, El fraude generado por la IA podría suponer pérdidas anuales por valor de $40.000 millones en EE.UU. (frente a $12.300 millones en 2023)[8]. Si no se adoptan medidas contundentes, esta trayectoria supondrá un duro golpe para los resultados de las aseguradoras.

- Pacientes víctimas: Los pacientes y los ciudadanos también pierden dinero con estas estafas. Los adultos mayores, en particular, han sido blanco de estafas de voz AI (llamadas telefónicas de "nieto en peligro") y estafas de salud deepfake. En 2023, las personas mayores estadounidenses denunciaron $3.400 millones en pérdidas por fraude, un aumento de 11% respecto al año anterior.[44][45] - algunos de estos impulsados por esquemas mejorados de IA. Y más allá del coste monetario, hay un coste humanoconsejos médicos fraudulentos y tratamientos falsos anunciados a través de la IA pueden provocar daños físicos o la pérdida de confianza en la orientación sanitaria legítima.

En general, 2025 ha dejado claro que La IA está acelerando el fraude en la sanidad tradicional. Lo que antes eran pequeñas estafas oportunistas se han convertido en operaciones industrializadas que abarcan continentes. La combinación de grandes volúmenes de datos (a menudo procedentes de filtraciones) y la generación de inteligencia artificial permite desplegar estafas con una rapidez y verosimilitud aterradoras. Las pérdidas mundiales se cuentan por decenas de miles de millones y van en aumento.y todas las partes interesadas, desde hospitales y aseguradoras hasta pacientes, están en peligro. En la siguiente sección se analiza cómo el sector puede contraatacar utilizando tecnologías y estrategias igualmente avanzadas.

Defensa contra el fraude impulsado por la IA: Estrategias y soluciones

Enfrentarse al fraude en la atención sanitaria posibilitado por la IA requiere un arsenal de defensas igualmente avanzadas. Los directivos sanitarios, los equipos de ciberseguridad, los responsables de cumplimiento y las aseguradoras deben coordinarse para integrar medidas antifraude en todos los puntos vulnerables - desde el ingreso del paciente hasta el pago de las reclamaciones. A continuación se presentan estrategias y soluciones técnicas clave para contrarrestar el fraude impulsado por la IA:

- Herramientas de detección de contenidos AI: Al igual que los delincuentes utilizan la IA para fabricar contenidos, las organizaciones pueden utilizarla para detectarlos. Avanzado Detectores de contenidos escritos con IA (como la suite de TruthScan) analizan texto, imágenes, audio y vídeo para identificar signos reveladores de generación por IA. Por ejemplo, la plataforma de TruthScan aplica el aprendizaje automático para detectar los patrones estadísticos y las peculiaridades lingüísticas que indican la existencia de texto generado por IA con más de un millón de caracteres. Precisión 99%[46][47]. Estas herramientas pueden integrarse en los sistemas de gestión de reclamaciones o en los historiales médicos electrónicos para marcar automáticamente documentos sospechosos - por ejemplo, un informe médico probablemente redactado por ChatGPT, para su revisión manual. Del mismo modo, la IA forense de imágenes puede detectar exploraciones médicas manipuladas o documentos de identidad falsos, y los algoritmos de detección de falsificaciones profundas pueden analizar vídeos en busca de signos de síntesis (artefactos en píxeles, sincronización extraña de movimientos faciales, etc.).[48][49]. Mediante el despliegue de detectores multimodales de IA, las organizaciones sanitarias pueden filtrar en tiempo real una gran parte de los contenidos falsificados por la IA antes de que cause daños.

- Verificación de historiales médicos y documentos: Los proveedores sanitarios recurren a soluciones especializadas para verificar la autenticidad de los registros y documentos de siniestros. Esto incluye el hash y la firma digital de los registros legítimos, así como el uso de bases de datos de plantillas de documentos conocidos para compararlos con los presentados. Los servicios de verificación basados en IA (por ejemplo, TruthScan's Autenticación de documentos médicos ) puede analizar instantáneamente el contenido y los metadatos de un documento para determinar si ha sido generado o alterado por una máquina.[50][51]. Se fijan en las incoherencias que un humano podría pasar por alto, como sutiles anomalías de formato o metadatos que indiquen que una imagen ha sido producida por IA. Seguimiento en tiempo real de los historiales de los pacientes y las solicitudes de reembolso de seguros de anomalías también es esencial[52]. Al escanear continuamente las nuevas entradas (resultados de laboratorio, notas médicas, anexos de reclamaciones), estos sistemas pueden detectar registros falsos. antes de pueden dar lugar a pagos fraudulentos o errores clínicos. Algunas aseguradoras han implantado normas por las que toda la documentación de reclamaciones identificada como generada por IA se extrae automáticamente para investigar el fraude. El objetivo es garantizar que cada historial médico o reclamación que entra en el flujo de trabajo es fiable e inalterado.

- Comprobación y validación de la identidad: Reforzar la verificación de la identidad es fundamental en la era de las identificaciones sintéticas. Las entidades sanitarias deben hacer cumplir comprobación rigurosa de la identidad de nuevos pacientes, proveedores y vendedores. Esto puede implicar la autenticación multifactor, comprobaciones biométricas (como el reconocimiento facial o las huellas dactilares en el registro), y el uso de servicios de verificación de identidad que aprovechan la IA para detectar documentos de identidad falsos o datos personales no coincidentes. Por ejemplo, el reconocimiento facial puede combinarse con pruebas de vitalidad para evitar que un rostro generado por IA se haga pasar por un paciente real a través de una foto. Por otro lado, los algoritmos pueden verificar los datos de un paciente (dirección, teléfono, correo electrónico, presencia en redes sociales) para detectar identidades "débiles" que carecen de un historial normal, un indicio conocido de las identificaciones sintéticas.[53]. Las entidades financieras han utilizado con gran éxito este tipo de comprobaciones de la coherencia de los antecedentes basadas en la IA[54]y la sanidad pueden hacer lo mismo: por ejemplo, marcar a un nuevo solicitante de Medicare si no tiene huella digital anterior a este año. Validación de la identidad de los proveedores es igualmente importante: asegurarse de que el médico que aparece en un vídeo de telesalud está autorizado y es realmente quien dice ser, tal vez emitiendo certificados digitales o vídeos con marcas de agua que sean difíciles de imitar por los deepfakes. En las farmacias, el personal debe volver a comprobar las solicitudes de recetas inusuales mediante llamadas directas a los proveedores y utilizar frases en clave o preguntas de verificación para derrotar a los posibles impostores de voz de IA.

- Detección integrada de fraudes en los flujos de trabajo: Para proteger realmente el sistema, la detección del fraude no puede ser un paso aislado, sino que debe ser integrada en todos los flujos de trabajo en una organización sanitaria.

En la práctica, esto significa que los hospitales y las aseguradoras están desplegando integraciones API para llamar a los servicios de detección de fraudes en momentos críticos. Por ejemplo, cuando un proveedor envía una reclamación con documentos adjuntos, un servicio de IA podría evaluar automáticamente la autenticidad de esos documentos en cuestión de segundos. Si se inicia una cita de telesalud, la plataforma podría ejecutar un análisis de voz pasiva en segundo plano para garantizar que la persona que llama no está utilizando una voz sintetizada. Control continuo también es clave: las plataformas de fraude modernas ofrecen cuadros de mando que rastrean las señales de fraude en toda la organización (validaciones fallidas, señalización frecuente de las reclamaciones de una determinada clínica, etc.) para identificar patrones, como una red de fraude organizada que opera a través de múltiples reclamaciones. Al tratar el fraude sanitario de forma más parecida a las ciberamenazas -con Supervisión permanente, detección de anomalías y respuesta rápida ante incidentes - las organizaciones pueden detectar los problemas antes de que se agraven[55].

- IA para el análisis del fraude y el reconocimiento de patrones: El volumen de datos sanitarios es tan grande que la IA es indispensable para encontrar patrones de fraude que los humanos pasan por alto. Los modelos de aprendizaje automático pueden entrenarse en casos históricos de fraude para detectar otros nuevos (por ejemplo, agrupando reclamaciones que tengan códigos CIE inusuales similares, o identificando cuándo la facturación de un médico se desvía mucho de la de sus compañeros). Las aseguradoras ya utilizan el análisis predictivo para calificar las reclamaciones en función del riesgo de fraude en tiempo real. Las técnicas emergentes, como las redes neuronales gráficas, pueden trazar relaciones entre pacientes, proveedores, diagnósticos y reclamaciones para detectar conexiones improbables (como el mismo número de serie de dispositivo utilizado en reclamaciones de distintos estados). El paquete de TruthScan contra el fraude en seguros, por ejemplo, incluye reconocimiento de modelos de siniestros y modelos predictivos para detectar redes organizadas de fraude y pautas atípicas antes de que se acumulen las pérdidas.[56][57]. El Centro de Fusión del Departamento de Justicia de 2025 ejemplificó este enfoque agregando datos de Medicare y de aseguradoras privadas para detectar de forma proactiva grupos de actividades sospechosas.[58]. Asimismo, las organizaciones sanitarias deben compartir datos y modelos de IA en consorcios para ampliar las señales de fraude que cada uno puede detectar. Cuantos más datos (dentro de los límites de la privacidad) alimenten estos modelos, mejor podrán discernir entre comportamientos normales y fraudulentos.

- Formación del personal y controles de procesos: La tecnología es crucial, pero la conciencia humana sigue siendo una poderosa defensa. El personal sanitario y los administradores deben recibir formación sobre las tácticas de fraude basadas en la IA. un correo electrónico perfectamente redactado por un director general podría ser phishing creado por IAo que deberían verificar la identidad de las videollamadas si algo parece "raro" (movimientos extraños de los ojos o retrasos de audio pueden ser indicios de un deepfake). Se pueden poner en práctica ejercicios y consejos periódicos (similares a la formación de concienciación sobre el phishing) para las nuevas amenazas, como las estafas telefónicas por deepfake. Los controles de procesos sencillos añaden capas de seguridad: exigir devoluciones de llamada o verificaciones secundarias para solicitudes de pago grandes o inusuales, utilizar canales de comunicación seguros y conocidos para la información sensible, y mantener un plan de respuesta a incidentes específico para sospechas de fraude mediado por IA. Es importante que las organizaciones cultiven una cultura en la que los empleados se sienten capacitados para cuestionar las anomalíasincluso si se trata de un "médico" en vídeo haciendo una petición extraña. Muchas estafas de deepfake tienen éxito explotando la confianza y la autoridad; un personal vigilante que conozca estos trucos puede detener los incidentes a tiempo. Como señaló un experto, enfrentarse a los deepfakes puede llegar a ser tan rutinario como detectar los correos electrónicos de phishing, una parte estándar de la higiene de la ciberseguridad.[32][59].

- Aprovechar los servicios especializados: Dada la rápida evolución de las amenazas de la IA, muchas organizaciones sanitarias se asocian con proveedores especializados en la prevención del fraude. Servicios como TruthScan para sanidad ofrecen soluciones integrales adaptadas a casos de uso médico, entre ellas: supervisión en tiempo real de la integridad de los historiales médicos electrónicos (EMR), verificación de documentos del paciente contra la manipulación de la IA, la detección de falsificaciones para la telesalud y los informes de cumplimiento (por ejemplo, pistas de auditoría que demuestren la diligencia debida en la detección del fraude para los reguladores).[60][51]. Estas plataformas suelen ofrecer Integración API para una integración perfecta en los sistemas existentes y están diseñados para cumplir la normativa sanitaria (HIPAA, GDPR)[61][62]. Mediante el uso de herramientas de nivel empresarial, incluso las clínicas más pequeñas o las aseguradoras regionales pueden acceder a capacidades avanzadas de detección de IA sin necesidad de desarrollarlas internamente. Además, las aseguradoras y los proveedores deben estar atentos a las actualizaciones de las normativas y los estándares del sector, por ejemplo, las nuevas leyes contra el fraude por falsificación (algunas jurisdicciones prohíben explícitamente las falsificaciones médicas, y Estados Unidos está ampliando los estatutos de robo de identidad para incluir la suplantación de identidad mediante IA).[63]). La adaptación a estas normas y la utilización de herramientas de última generación no sólo reducirán las pérdidas por fraude, sino que también demostrarán una sólida postura de seguridad a socios, auditores y pacientes.

Conclusión y perspectivas

El año 2025 ha demostrado que la el genio ha salido de la botella - La IA generativa y la automatización están ahora entrelazadas con el fraude sanitario. En el futuro, es probable que los defraudadores sigan innovando: es posible que veamos modelos de IA que aprendan a imitar el estilo de escritura de determinados médicos o deepfakes que reaccionen en tiempo real a las preguntas que se les planteen. La batalla será una carrera armamentística continua. Sin embargo, el sector sanitario está respondiendo con el mismo vigor, invirtiendo en defensas basadas en IA y en flujos de trabajo de seguridad más estrictos. Combinando tecnología de detección de vanguardia, procesos de verificación rigurosos, intercambio de datos entre sectores y vigilancia por parte de los empleados.Las organizaciones sanitarias pueden mitigar sustancialmente la amenaza del fraude facilitado por la IA.

Y lo que es más importante, no se trata solo de un problema informático, sino de gobernanza y confianza. Las juntas directivas y los ejecutivos del sector sanitario deben reconocer el fraude de la IA como un riesgo estratégico para las finanzas y la confianza de los pacientes, que justifica una atención y unos recursos regulares. Los equipos de cumplimiento deben actualizar las evaluaciones del riesgo de fraude para incluir los aspectos de la IA, y las aseguradoras podrían replantearse los supuestos de suscripción sabiendo que un cierto porcentaje de las reclamaciones podría ser fraude asistido por IA. Por otro lado, el aprovechamiento ético de la IA en la atención sanitaria (para el apoyo a la toma de decisiones clínicas, la eficiencia de la facturación, etc.) seguirá aportando grandes beneficios, siempre que se establezcan salvaguardias sólidas para evitar abusos.

En resumen, la IA generativa ha cambiado el juego del fraude en la sanidad, pero con concienciación y contramedidas avanzadas, no tiene por qué abrumar al sistema. Las organizaciones que triunfen serán las que se mantengan informadas sobre las amenazas emergentes, se adapten rápidamente con defensas basadas en IA y fomenten una cultura de "verificar y confiar" en lugar de "confiar por defecto". De este modo, la sanidad podrá aprovechar con seguridad los aspectos positivos de la IA y neutralizar al mismo tiempo su uso indebido, protegiendo tanto los resultados como el bienestar de los pacientes en la era digital.

Fuentes: Informes y casos recientes del sector citados anteriormente, incluido Pymnts (julio de 2025).[2][3]Instituto Swiss Re (junio de 2025)[27]Banco de la Reserva Federal de Boston (abril de 2025)[19]BMJ (2024)[37]y resúmenes de soluciones TruthScan (2025)[51][64]entre otros. Todos los datos y citas reflejan los últimos disponibles en 2024-2025, lo que ilustra el estado actual del fraude impulsado por la IA en la atención sanitaria y las respuestas para combatirlo.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] El Departamento de Justicia recurre a herramientas de IA en una histórica represión del fraude sanitario

[4] [5] [6] [7] [16] [40] [44] [45] Deepfake Estadísticas y Tendencias 2025 | Datos e Información Clave - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes y la crisis del conocimiento | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] La inteligencia artificial aumenta la amenaza del fraude de identidad sintética - Banco de la Reserva Federal de Boston

[25] [26] [56] [57] [62] [64] Detección de fraudes en seguros de vida y salud | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Cómo los deepfakes, la desinformación y la IA amplifican el fraude a las aseguradoras | Swiss Re

[28] La DEA advierte del fraude en la prescripción electrónica - Noticias de práctica farmacéutica

[29] [39] Ciberseguridad sanitaria y fraude: A Deep Dive Into Today's Greatest Risks and Defenses | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] La amenaza cambiante de las estafas de telemedicina "deepfake", Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Expertos alertan de estafadores que usan 'deepfakes' de médicos famosos en las redes sociales

[35] [36] [37] Médicos de televisión de confianza "deepfaked" para promover estafas de salud en las redes sociales - Grupo BMJ

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] Estado actual de la investigación Ajit Appari y M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - Detección de IA empresarial y seguridad de contenidos

[50] [51] [52] [60] [61] AI Medical Record Fraud Detection (Detección de fraudes en historiales médicos mediante IA) | Soluciones CRO para sanidad | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] ¿Hasta qué punto son peligrosos los deepfakes y otros fraudes basados en inteligencia artificial?