Introducción

La inteligencia artificial está transformando el panorama del fraude financiero de una forma sin precedentes. A principios de 2024, unos estafadores utilizaron deepfakes generados por IA para hacerse pasar por ejecutivos en una videollamada, engañando a un empleado de Hong Kong para que transfiriera... $25 millones a los estafadores[1][2]. Incidentes como este demuestran que la IA generativa está permitiendo a los delincuentes elaborar estafas muy convincentes contra los bancos y sus clientes. Los organismos reguladores están dando la voz de alarma: la FinCEN del Tesoro de Estados Unidos emitió una alerta a finales de 2024 en la que advertía del aumento del fraude mediante el uso de medios "deepfake" generados por IA, incluidos documentos de identidad falsos para eludir las verificaciones bancarias.[3][4]. Este informe examina los últimos Tendencias del fraude de IA en los servicios financieros y analiza cómo las instituciones pueden reforzar sus defensas. Exploramos cómo los estafadores están utilizando como arma la IA generativa -desde suplantaciones de identidad hasta identidades sintéticas- y describimos la tecnología y las estrategias (incluidas herramientas de detección avanzadas como TruthScan) que los equipos de lucha contra el fraude y los ejecutivos pueden desplegar para contrarrestar esta amenaza en constante evolución.

Principales tendencias del fraude mediante IA en los servicios financieros

La IA y el aprendizaje automático están siendo aprovechados por los malos actores para llevar a cabo fraudes a mayor escala y sofisticación. Cabe destacar Tácticas de fraude basadas en la IA que afectan a los bancos, las fintech y las aseguradoras:

- Estafas de suplantación de identidad Deepfake: Los delincuentes utilizan Vídeo y audio generados por IA para hacerse pasar por personas de confianza (directores ejecutivos, clientes, etc.) en tiempo real. Por ejemplo, en ataques de vishing (suplantación de identidad por voz) se han utilizado voces falsas y realistas para autorizar transferencias fraudulentas, y vídeos creados con IA han engañado a empleados para que aprobaran transacciones falsas.[1][5]. Estos medios sintéticos dificultan saber si realmente se está hablando con la persona que se cree, lo que permite realizar robos de gran valor como el caso de deepfake $25M mencionado anteriormente. Los deepfakes se están convirtiendo en asequible y fácil de producircon tan sólo 20 o 30 segundos de audio para clonar una voz, o menos de una hora para generar un vídeo aparentemente auténtico.[6].

- Phishing y BEC mejorados con IA: La IA generativa está impulsando los esquemas de ingeniería social, como los correos electrónicos de phishing y los mensajes de texto. correo electrónico comercial comprometido (BEC). Los chatbots de IA pueden redactar correos electrónicos fraudulentos altamente personalizados en un lenguaje comercial perfecto, imitando el estilo de escritura de un director general o creando facturas falsas convincentes de proveedores a escala. De hecho, herramientas clandestinas como FraudeGPT y WormGPT (versiones no filtradas de ChatGPT) para ayudar a los ciberdelincuentes a automatizar la creación de phishing y malware.[7][8]. Esto significa que un posible estafador con conocimientos mínimos puede generar campañas de phishing o códigos maliciosos con facilidad. Con la IA, un solo delincuente puede enviar miles de mensajes de correo electrónico o de texto personalizados, lo que aumenta enormemente el alcance de los intentos de fraude tradicionales. El Centro de Delitos en Internet del FBI ya ha observado más de $2.700 millones perdidas por estafas BEC en 2022, y la IA generativa amenaza con aumentar aún más esas pérdidas en los próximos años.[9][10].

- Identidades sintéticas y fraude documental: La IA generativa está impulsando el fraude de identidad sintéticauno de los tipos de delitos financieros de más rápido crecimiento[11][12]. Los estafadores combinan datos personales reales y falsos para crear identidades "Frankenstein", y luego utilizan la IA para presentar justificantes realistas - desde pasaportes falsos y extractos bancarios hasta talones de pago[7]. Los generadores de imágenes AI y las herramientas de edición pueden forjar documentos de identidad y fotos auténticos que pasen una inspección casual. Incluso las comprobaciones de vida o las verificaciones de selfies pueden ser potencialmente derrotadas por imágenes o vídeos manipulados por la IA. Automatizando la creación de miles de personas falsas (cada una con fotos de perfil generadas por IA, redes sociales, etc.), los delincuentes pueden abrir cuentas bancarias o solicitar préstamos en masa y blanquear dinero o impagar créditos. Las pérdidas derivadas del fraude de identidad sintética se estiman en unos $35.000 millones en 2023[13]y la IA generativa no hace sino acelerar esta tendencia, abaratando y dificultando la detección de identidades falsas.

- Fraude y evasión automatizados: Más allá de la creación de contenidos falsos, la IA también ayuda a los defraudadores maximizar el éxito de sus planes. Los bots avanzados pueden probar rápidamente los datos de tarjetas de crédito robadas en sitios de comercio electrónico, utilizando ML para evitar los disparadores de detección. La IA puede ayudar a los delincuentes a identificar los eslabones más débiles de la seguridad de una organización o incluso sintetizar respuestas de voz para burlar la verificación de identidad por teléfono. Una industria artesanal en la web oscura vende ahora herramientas de IA de "fraude como servicio" por tan solo $20.[14]. Esta democratización de las capacidades de la IA significa que incluso los delincuentes de bajo nivel pueden lanzar ataques de fraude muy sofisticados. La carrera armamentística se extiende a la evasión de la detección: los defraudadores utilizan la IA para sondear los sistemas antifraude de los bancos y perfeccionar su enfoque hasta que encuentran un método que se cuela a través de los filtros...".[15]. En resumen, la IA está permitiendo realizar fraudes a una escala y con una eficacia nunca vistasdesafiando las defensas convencionales.

Estas tácticas basadas en la IA ya proliferan a un ritmo alarmante. Las estafas tradicionales, como la falsificación de cheques o el phishing, existen desde hace años, pero la IA está aumentando su volumen y realismo. Los datos hablan claro: El fraude con IA es surgiendo.

No vuelva a preocuparse por el fraude de IA. TruthScan puede ayudarle:

- Detectar IA generada imágenes, texto, voz y vídeo.

- Evite grandes fraudes impulsados por la IA.

- Proteja sus sensible activos de la empresa.

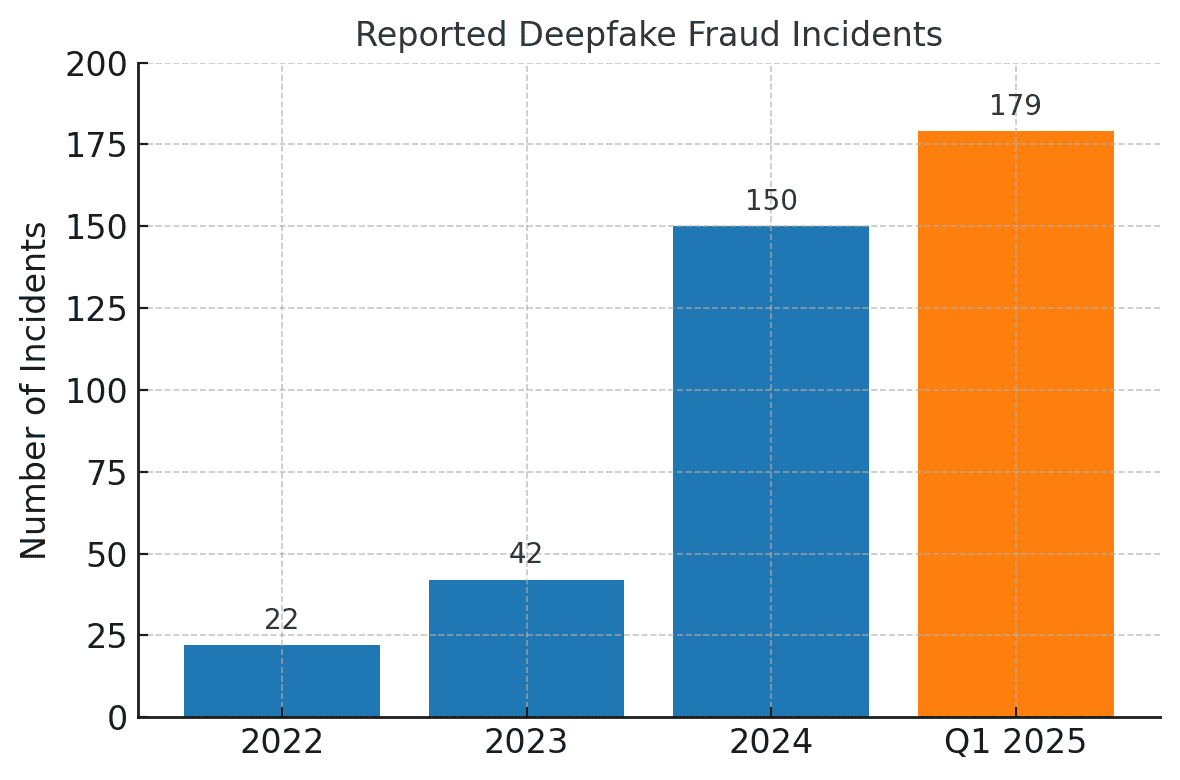

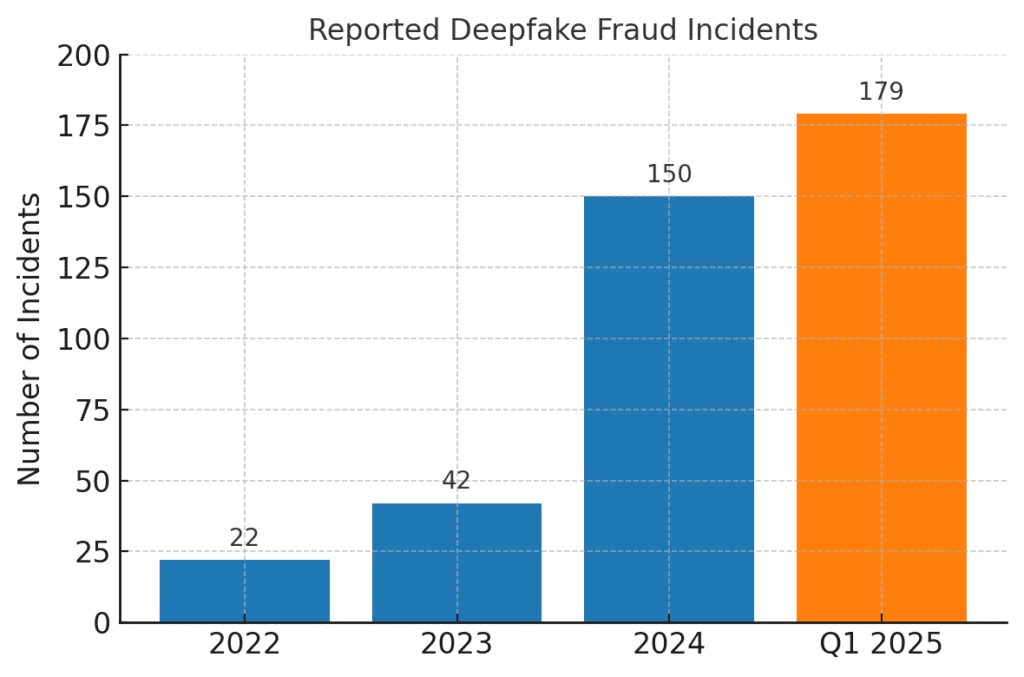

Los incidentes de fraude relacionados con deepfake se han disparado. En 2022, sólo se registraron 22 casos de fraude deepfake, pero en 2023 hubo 42, y en 2024 los incidentes se dispararon a 150. Solo en el primer trimestre de 2025, 179 incidentes de fraude deepfake superando el total de todo el año 2024.[16][17].

Recientes análisis del sector se hacen eco de estas tendencias. Un informe señala una 700% aumento de los incidentes de deepfake empresas de tecnología financiera en 2023[18]. Y lo que es aún más asombroso, en Norteamérica se registró un 1,740% aumento de los casos de fraude deepfake entre 2022 y 2023[19]. Los delincuentes financieros están adoptando rápidamente estas herramientas porque funcionan: muchos bancos y víctimas aún no están preparados para detectar el engaño generado por la IA.

Repercusiones y retos para las instituciones financieras

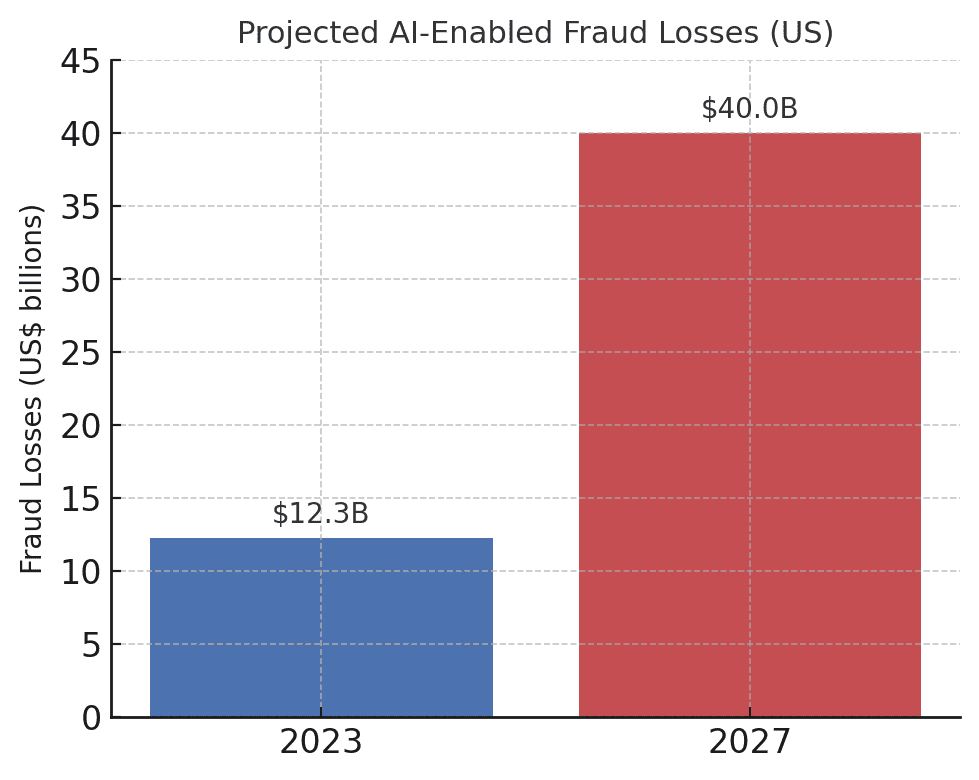

El aumento del fraude impulsado por la IA plantea impactos significativos sobre las instituciones financieras, sus clientes y el sistema financiero en general. El impacto más inmediato es la pérdida monetaria. Las previsiones del sector predicen que para 2027, las pérdidas por fraude gracias a la IA generativa podrían alcanzar los $40.000 millones en ee.uu., frente a los $12.300 millones de 2023[20]. Este aumento de más del triple (un 32% CAGR) refleja la rapidez con la que crece el riesgo de fraude en términos de dólares.

Las pérdidas previstas por fraudes basados en IA están aumentando drásticamente. Deloitte estima que las pérdidas por fraude financiero en EE.UU. vinculadas a la IA generativa aumentarán de 1.000 millones de euros en 2009 a 1.000 millones de euros en 2010. $12.300 millones en 2023 a $40.000 millones en 2027[20].

Más allá de las pérdidas brutas, están las de reputación y costes fiduciarios. Los consumidores esperan que sus bancos les protejan, pero las estafas que utilizan IA están minando la confianza en los canales digitales. Por ejemplo, si un cliente es víctima de una estafa de deepfake convincente (como una videollamada falsa de un banquero), puede culpar al banco de seguridad inadecuada. Confianza pública en la verificación de voz, los correos electrónicos e incluso las videoconferencias pueden erosionarse si "lo que se ve/oye" ya no puede asumirse como real.[21]. Según las encuestas, el 85% de los profesionales de las finanzas en EE.UU./Reino Unido considera las estafas de deepfake como una amenaza "existencial" para la seguridad de su organización.[22]. Más de la mitad de las empresas de esos mercados afirman haber sido objeto de una estafa basada en deepfakes y, lo que es alarmante, más de la mitad de las empresas de esos mercados afirman haber sido objeto de una estafa basada en deepfakes. 43% de los atacados admitieron que el ataque tuvo éxito en engañarlos[23]. Cada incidente que tiene éxito no sólo causa daños financieros, sino que también merma la confianza de los clientes en la institución.

Las empresas financieras también se enfrentan a retos operativos y de cumplimiento de la normativa del fraude de IA. Los equipos antifraude se enfrentan a un aumento de alertas e incidentes, lo que sobrecarga los recursos de investigación. Los modelos de detección de fraude existentes (muchos de los cuales se basan en reglas o técnicas de aprendizaje automático antiguas) pueden tener dificultades para reconocer contenidos sintetizados mediante IA que parecen legítimos. De hecho, los sistemas más avanzados de detección de falsificaciones profundas desarrollados en laboratorio ven reducida su precisión en casi 50% cuando se enfrentan a deepfakes del mundo real en la naturaleza[24]. El personal humano no lo hace mucho mejor: los estudios revelan que las personas sólo son capaces de detectar vídeos deepfake de alta calidad en torno al 55%-60% del tiempoapenas mejor que el azar[25]. Esto indica que, sin nuevas herramientas, los bancos pasarán por alto una gran parte de los intentos de fraude impulsados por la IA.

También hay un dimensión reglamentaria. Los reguladores y las fuerzas de seguridad son muy conscientes de los riesgos (como demuestra la alerta de FinCEN) y esperan que las instituciones financieras se adapten. En la era de la IA, los bancos podrían enfrentarse a directrices más estrictas en materia de verificación de clientes y notificación de fraudes. Por ejemplo, si un empleado de un banco es engañado por un deepfake para que apruebe una transferencia de $10 millones, los reguladores podrían examinar los controles y los procesos de diligencia debida del banco. El sitio Ley de Secreto Bancario ahora incluye explícitamente la notificación de sospechas de ciberdelincuencia y de actividades relacionadas con deepfake[26][4]Esto significa que los bancos deben formar a su personal para que reconozca y notifique los indicadores de fraude generados por IA en los informes de actividades sospechosas (SAR). No mantenerse al día con las técnicas de fraude mejoradas por IA podría dar lugar a infracciones de cumplimiento o responsabilidad legal si los clientes o las contrapartes argumentan que el banco no hizo lo suficiente para prevenir las estafas previsibles habilitadas por IA.

Quizá el mayor reto sea la naturaleza asimétrica de esta nueva amenaza. La IA generativa reduce enormemente el coste y la barrera de habilidad para los atacantes, al tiempo que aumenta exponencialmente el volumen y el realismo de los ataques. Un solo rumor viral de deepfake o una llamada de clonación de voz convincente pueden hacer fracasar millones de dólares de inversiones en autenticación. Mientras tanto, los defensores deben verificar la autenticidad de cada transacción e interacción, una tarea mucho más difícil. Es una auténtica carrera armamentística: La IA proporciona a los defraudadores un conjunto de herramientas que se actualizan automáticamente para eludir la seguridad, lo que obliga a los bancos a actualizar también constantemente sus defensas.[15][27]. Muchas instituciones financieras admiten que no están adecuadamente preparadas -. más del 80% de las empresas carecen de un plan formal de respuesta ante ataques de deepfakey más de la mitad no ha impartido formación a sus empleados sobre los riesgos del deepfake[28][29]. Este déficit de preparación significa que las organizaciones son actualmente vulnerables, pero también pone de relieve dónde es necesario actuar.

Un informe reciente de la industria ofrece un dato digno de mención y aleccionador: 42,5% de los intentos de fraude en el sector financiero implican ahora alguna forma de IA[30]. En otras palabras, casi la mitad de los ataques fraudulentos a los que se enfrentan los bancos tienen un componente de IA, ya sea un documento generado por IA, una voz sintetizada o un mensaje de phishing generado por una máquina. Esta estadística subraya que la IA no es una hipotética amenaza futura, sino que ya está aquí, obligando a las instituciones financieras a adaptarse o a afrontar pérdidas crecientes.

Defensa contra el fraude posibilitado por la IA: Estrategias y soluciones

Enfrentarse al fraude impulsado por la IA exige una evolución de las estrategias de prevención del fraude. Los enfoques tradicionales (como la verificación manual o los motores de reglas estáticos) no son rivales para las estafas de IA que cambian de forma. En su lugar, los bancos deben adoptar technology (like making sure they have a Secure SSL Certificate), training, and teamwork para invertir la tendencia. A continuación esbozamos estrategias clave y soluciones emergentes:

- Aprovechar la IA para luchar contra la IA (Herramientas de detección avanzada): Las entidades financieras recurren cada vez más a Soluciones de detección basadas en IA para identificar contenidos y anomalías generados por IA. En esencia, hay que combatir el fuego con fuego. Nuevas herramientas empresariales como TruthScan ofrecen detección multimodal de IA en texto, imágenes, voz y vídeo para ayudar a autenticar contenidos en tiempo real[31]. Por ejemplo, los bancos pueden desplegar detectores de texto de IA para escanear las comunicaciones entrantes (correos electrónicos, mensajes de chat) en busca de signos de lenguaje generado por IA que puedan indicar un correo electrónico de phishing o una consulta falsa de un cliente. El sistema de detección de texto de IA de TruthScan puede identificar contenido escrito con IA a partir de modelos como GPT-4 con Precisión 99%...incluso identificar qué frases son probablemente generadas por IA...[32][33]. Del mismo modo, las herramientas forenses de imagen de IA pueden verificar documentos e imágenes; una Detector de imágenes AI puede detectar si un permiso de conducir o una factura de servicios públicos han sido creados o manipulados digitalmente comparándolos con patrones conocidos de imágenes generadas por IA.[34]. Para las amenazas sonoras, los bancos están empezando a utilizar voz deepfake detectores - que analizan el audio de las llamadas en busca de huellas acústicas de voz sintética. El detector de voz AI de TruthScan, por ejemplo, escucha los signos reveladores de clonación de voz y puede verificar la autenticidad del orador para evitar llamadas impostadas[35]. Al integrar estos detectores a través de API en sus flujos de trabajo, las entidades financieras pueden detectar automáticamente contenidos de IA en el trasfondo de las transacciones e interacciones. Esto proporciona una capa adicional de defensa que opera a la velocidad de la máquina, captando lo que los ojos/orejas humanos podrían pasar por alto.

- Implantar la verificación multifactor y fuera de banda: A medida que la IA hace más difícil confiar en voces o imágenes, los bancos deberían confiar más en métodos de verificación que la IA no pueda falsificar fácilmente. Esto incluye la autenticación multifactor (AMF) mediante canales seguros. Por ejemplo, si una solicitud de transferencia llega por correo electrónico o videollamada, se requiere un segundo factor, como una contraseña de un solo uso enviada al dispositivo móvil conocido del solicitante, o una devolución de llamada a un número de teléfono de confianza registrado. Algunos bancos están añadiendo comprobaciones de "vitalidad" para las transacciones de alto riesgo, por ejemplo, pidiendo a un cliente que se haga un selfie en directo con un gesto o una palabra concretos, que es más difícil de replicar con un vídeo deepfake. Los autenticadores biométricos pueden mejorarse con medidas contra la suplantación (por ejemplo, escaneando la profundidad facial en 3D o vigilando los sutiles movimientos oculares que los deepfakes no suelen imitar).[27]). La clave es evitar puntos únicos de fallo. Incluso si una deepfake de IA puede engañar a un canal (por ejemplo, la verificación de voz), una comprobación coordinada fuera de banda o una prueba biométrica pueden proporcionar el desafío necesario para revelar el fraude. Principios de confianza cero debe aplicarse: tratar cualquier instrucción no solicitada o inesperada (incluso de un ejecutivo o cliente "conocido") como sospechosa hasta que se verifique a través de un canal independiente.

- Formación de los empleados y concienciación sobre el fraude: La tecnología por sí sola no es una panacea, sobre todo porque los estafadores se centran en el eslabón más débil, que suele ser la confianza humana. Las entidades financieras deben invertir en formación periódica para los equipos de prevención del fraude y el personal de primera línea sobre las estafas basadas en IA. Los empleados deben aprender a reconocer las señales de alerta de deepfakes e ingeniería social. Esto podría incluir formación sobre anomalías sutiles (por ejemplo, problemas de sincronización labial en una videollamada, o audio que contenga una entonación poco natural o demasiado poco ruido de fondo, signos potenciales de una voz sintética). Fomentar una cultura de verificaciónLos empleados deben sentirse capacitados para detener una transacción o solicitud sospechosa y verificarla de forma independiente, aunque parezca proceder del Director General. El caso del Intento de suplantación de la voz del CEO de Ferrari es instructivo: un ejecutivo sólo descubrió la treta al hacer una pregunta personal que el impostor no pudo responder[36]. Los simulacros de phishing y deepfake también pueden ser útiles. Del mismo modo que las empresas realizan simulaciones de phishing para formar al personal, pueden simular un mensaje de voz deepfake o una reunión de vídeo falsa y ver si los empleados lo detectan. De este modo se crea memoria muscular para resistir los ataques reales. Dado que más del 50% de las empresas carecen de protocolos de respuesta ante deepfakes y disponen de escasa formación[29]Por lo tanto, instituir este tipo de programas es una fruta al alcance de la mano para mejorar la resiliencia.

- Análisis de fraudes y detección de anomalías: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier sonidos generados por IA o demasiado formulista (junto con la detección de texto mediante IA mencionada anteriormente). Bancos como JPMorgan han empezado a utilizar grandes modelos lingüísticos en sus comunicaciones internas para detectar frases o contextos que podrían indicar un intento de ingeniería social.[37]. Las redes de pago, como Mastercard, están escaneando grandes conjuntos de datos (miles de millones de transacciones) con IA para identificar transacciones fraudulentas que las reglas tradicionales pasarían por alto.[38]. La conclusión es que IA defensiva debe ser tan innovadora como la IA ofensiva. Las empresas deben considerar la posibilidad de desarrollar o adquirir modelos de IA específicos para detectar contenidos falsificados, identidades sintéticas y patrones de ataque generativos. Y lo que es más importante, estos modelos deben reentrenarse continuamente con los ejemplos más recientes de fraude de IA (una práctica denominada aprendizaje en línea o aprendizaje federado) para que sigan el ritmo de las tácticas en rápida evolución de los delincuentes.[39][40].

- Colaboración e intercambio de información: La lucha contra el fraude posibilitado por la IA exigirá la colaboración tanto dentro de las instituciones como entre ellas. Los esfuerzos aislados son menos eficaces contra una amenaza que trasciende los límites de la organización. Equipos de prevención del fraude, equipos de ciberseguridad y TI Por ejemplo, los equipos de seguridad pueden implantar la detección de falsificaciones profundas en las herramientas de videoconferencia, mientras que los equipos de fraude integran los análisis de contenido en la supervisión de las transacciones. A un nivel más amplio, los bancos deberían participar en grupos del sector como el Centro de Análisis e Intercambio de Información de Servicios Financieros (FS-ISAC) para intercambiar información sobre nuevos esquemas de fraude con IA.[41]. Si un banco descubre un nuevo vector de ataque de deepfake, compartir esa información puede ayudar a otros a cerrar la brecha antes de ser atacados. Pueden realizarse ejercicios conjuntos o simulaciones de "equipo rojo" con escenarios en los que intervenga la IA (por ejemplo, una estafa ejecutiva por deepfake o un bypass de verificación de identidad generado por IA) a través de consorcios del sector o con el apoyo de las autoridades reguladoras. Los propios reguladores se están centrando en los riesgos de la IA, por lo que es aconsejable colaborar con ellos de forma proactiva. Al contribuir a las normas y directrices para el uso de la IA, los bancos pueden ayudar a dar forma a un ecosistema más seguro. En última instancia, puesto que una amenaza para un banco es una amenaza para todos en este espacio[42]Un enfoque de defensa colectiva reforzará la capacidad de todos para detectar y disuadir el fraude potenciado por la IA.

- Educación del cliente y medidas de confianza: Por último, las instituciones financieras no deben pasar por alto el papel de la concienciación de los clientes. Con las deepfakes y las estafas de IA dirigidas al público en general (por ejemplo, voces falsas en estafas a abuelos o falsos chats de "soporte técnico" generados por IA), los bancos pueden ayudar a educar a los clientes sobre estos peligros. Muchos bancos ya envían alertas sobre phishing; pueden ampliarlas para mencionar la clonación de voz por IA y los vídeos de deepfake, proporcionando consejos sobre cómo verificar las solicitudes. Algunas organizaciones progresistas envían notificaciones push o advertencias en sus aplicaciones si circula una estafa conocida (por ejemplo, "Cuidado: los estafadores pueden utilizar clones de voz de miembros de la familia pidiendo dinero").[43]. Aunque no impida directamente los ataques, la educación puede reducir la tasa de éxito y reforzar que el banco es un socio en materia de seguridad. Además, los bancos que invierten en la prevención del fraude más avanzada deberían destacarlo ante sus clientes como una ventaja competitiva. diferenciador - Por ejemplo, informar a los clientes de que todas las videollamadas o documentos enviados son escaneados por la IA para comprobar su autenticidad (sin divulgar métodos sensibles) puede tranquilizarlos en el sentido de que el banco utiliza todas las herramientas disponibles para protegerlos. Preservar la confianza digital será fundamental para que los bancos aprovechen plenamente las ventajas de la IA en los servicios, por lo que la transparencia y las salvaguardas centradas en el cliente forman parte de una defensa integral.

Papel de los servicios de detección de contenidos mediante IA

Una piedra angular de las herramientas antifraude en la era de la IA es el uso de Servicios de detección de contenidos mediante IA. Estos servicios se especializan en detectar las "huellas dactilares" de los contenidos generados por IA que podrían pasar desapercibidos a los revisores humanos. TruthScan es uno de estos proveedores, que ofrece un servicio de calidad empresarial. Suite de detección de IA que abarcan múltiples tipos de contenido. Las entidades financieras pueden integrar estas herramientas para detectar automáticamente indicadores de falsificación y fraude:

- Verificación de documentos e imágenes: La plataforma de TruthScan permite a los bancos compruebe en tiempo real si los documentos financieros contienen fraudes generados por IA[44]. Esto significa que cuando se abre una cuenta nueva o llega una solicitud de préstamo con un documento de identidad con fotografía y un talón de pago, el sistema puede analizar instantáneamente esas imágenes en busca de signos de generación sintética o manipulación. Con una precisión de más de 99%[45]El Detector de Imágenes AI puede detectar imágenes falsas de carnés de identidad o PDF manipulados que un humano podría aprobar a primera vista. Este tipo de verificación de la autenticidad de los documentos es crucial para detener el fraude sintético de identidad antes incluso de que se abran las cuentas.

- Supervisión de transacciones en tiempo real: Mediante el despliegue de integraciones API, TruthScan puede conectarse al procesamiento de transacciones de los bancos y detectar anomalías en las transacciones. en tiempo real. Si una instrucción llega por correo electrónico y parece sospechosa, el Detector de Estafas por Correo Electrónico puede analizar el contenido del mensaje y detectar si ha sido escrito por un modelo de inteligencia artificial que intenta suplantar a un proveedor o ejecutivo.[46]. Del mismo modo, el Detector de IA en tiempo real puede supervisar las comunicaciones en directo (como chats o plataformas de colaboración) para proporcionar alertas instantáneas si, por ejemplo, se detecta un video impostor deepfake durante una reunión de alto riesgo[47][48]. La supervisión continua con alertas instantáneas y respuestas automatizadas ayuda a reducir el margen en el que puede producirse un fraude sin ser detectado.

- Defensa contra falsificaciones de voz y vídeo: Para los centros de llamadas y los gestores de relaciones, la incorporación de TruthScan Detector de voz AI añade una capa adicional de seguridad. Si un estafador llama haciéndose pasar por un cliente mediante un clon de voz, el sistema puede analizar el audio de la llamada y señalar si contiene elementos sintetizados por IA (como micropausas naturales omitidas o artefactos en las ondas sonoras).[35]. En cuanto al vídeo, el Detector de Deepfake aplica algoritmos de visión por ordenador a los fotogramas de vídeo para detectar incoherencias -como movimientos faciales poco naturales, iluminación extraña o sincronización labial inadecuada- que revelen una falsificación.[49][50]. Al verificar la integridad de las voces y los rostros en interacciones clave, los bancos pueden frustrar a los impostores que intentan engañar a sus empleados. Estas herramientas actúan como un detector de mentiras de alta tecnología para contenidos digitales, operando de forma invisible en segundo plano.

Cabe señalar que el despliegue de este tipo de tecnología de detección no es una panacea; debe calibrarse y ajustarse a los flujos de trabajo de la institución. Deben gestionarse los falsos positivos (por ejemplo, un detector de texto basado en IA podría marcar como sospechosas comunicaciones legítimas basadas en plantillas hasta que aprenda la diferencia). Sin embargo, cuando se integran adecuadamente, estas herramientas mejoran notablemente la capacidad de una organización para detectar contenidos fraudulentos antes de que causen daños. También generan pistas de auditoría e informes analíticos que son útiles para el cumplimiento de la normativa y para mejorar continuamente los modelos de fraude.

Fundamentalmente, la eficacia de las herramientas de detección de IA depende de actualizaciones constantes. Al igual que el software antivirus requiere nuevas firmas para los nuevos virus, los detectores de IA necesitan reciclarse con las últimas técnicas de deepfake y modelos de IA. Proveedores como TruthScan actualizan sus algoritmos para manejar nuevos modelos generativos y tácticas de evasión, manteniendo una alta precisión incluso cuando la IA evoluciona.[51]. Esto alivia la carga de los equipos internos y garantiza que los bancos no estén luchando en la guerra de ayer mientras los delincuentes avanzan hacia nuevos trucos de IA.

Conclusión

El sector de los servicios financieros se encuentra en una encrucijada en la lucha contra el fraude. Por un lado, los delincuentes están adoptando rápidamente la IA generativa para lanzar estafas más convincentes y extendidas que nunca. Por otro, los bancos y los que luchan contra el fraude tienen a su disposición un arsenal cada vez mayor de defensas basadas en la IA. Las instituciones que prosperarán son las que reconocer el nuevo panorama de amenazas y responder con igual ingenio. Esto significa invertir en capacidades de detección avanzadas, integrar procesos de verificación de varios niveles, educar tanto al personal como a los clientes y fomentar una cultura de vigilancia y adaptación.

El fraude basado en IA es un objetivo que se mueve con rapidez: la estafa de deepfake que ha engañado a una empresa hoy puede ser contrarrestada por nuevas técnicas de detección mañana, solo para que los estafadores modifiquen sus métodos la semana siguiente. Por tanto, una estrategia de prevención del fraude "estándar del sector" en 2025 es aquella que hace hincapié en la agilidad y la mejora continua. Las organizaciones financieras deben tratar sus sistemas de defensa contra el fraude como entidades vivas que aprenden que evolucionan a la par que las tácticas delictivas. Aprovechar las asociaciones con proveedores de tecnología es un atajo inteligente para crear estas capacidades. Por ejemplo, colaborar con empresas especializadas como TruthScan (que ofrece soluciones adaptadas a la banca y las finanzas) puede acelerar la capacidad de una institución para prevenir el fraude basado en la IA, manteniendo al mismo tiempo el cumplimiento de la normativa y la confianza de los clientes[52].

En última instancia, la protección contra el fraude impulsado por la inteligencia artificial no es sólo una cuestión de tecnología, sino de preservar los valores fundamentales de la sociedad. confíe en que sustenta las finanzas. Los clientes necesitan confiar en que su banco puede distinguir una transacción real de una falsa, un cliente real de un impostor de IA. Mediante el despliegue de herramientas de detección de IA de vanguardia, el refuerzo de los protocolos de verificación y la anticipación a las amenazas emergentes, las empresas de servicios financieros pueden mantener esa confianza. En el camino que queda por recorrer habrá, sin duda, más intentos de fraude por parte de los adversarios, pero con la preparación y las inversiones adecuadas, los bancos pueden garantizar que La IA se convierte más en una ventaja que en una amenaza en el ámbito de la prevención del fraude. Es un objetivo alcanzable: las mismas tecnologías de IA que amenazan con perturbar pueden aprovecharse para salvaguardar la integridad de nuestro sistema financiero. Ahora es el momento de que los equipos de prevención del fraude y los ejecutivos de alto nivel actúen con decisión, adoptar soluciones y estrategias avanzadas para burlar a los defraudadores y asegurar el futuro de las finanzas digitales.

Fuentes: En todo el documento se hace referencia a informes recientes del sector, alertas normativas y libros blancos sobre tecnología (Deloitte[20][18]Foro Económico Mundial[19][24]Tesoro de EE.UU. FinCEN[3][4]Reserva Federal[13]Keepnet Labs[16][30]entre otros) para proporcionar datos y ejemplos. Todos los datos y ejemplos se citan en línea para que el lector pueda profundizar en ellos.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking y el riesgo de fraude de la IA | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Detectar la IA peligrosa es esencial en la era del deepfake | Foro Económico Mundial

[3] [4] [26] FinCEN emite una alerta sobre esquemas de fraude con Deepfake Media dirigidos a instituciones financieras | FinCEN.gov

[7] [8] FraudGPT y GenAI: ¿Cuál será el próximo uso de la IA por parte de los defraudadores? | Alloy

[11] Fraude de identidad sintética: Cómo la IA está cambiando las reglas del juego - Banco de la Reserva Federal de Boston

[12] [13] La inteligencia artificial generativa aumenta las amenazas de fraude de identidad sintética

[16] [17] [22] [23] [28] [29] [30] Deepfake Estadísticas y Tendencias 2025 | Datos e Información Clave - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Detección de IA empresarial y seguridad de contenidos

[32] [33] [51] Detector de IA: Detección de texto AI de nivel empresarial - TruthScan

[44] [45] [52] Detección de fraudes mediante IA bancaria | Soluciones CRO | TruthScan

[49] [50] Deepfake Detector - Identifica Videos Falsos y AI - TruthScan