Ένας ολοκληρωμένος οδηγός για την κατανόηση, την ανίχνευση και την πρόληψη της απάτης φωνητικής ΑΙ στην επιχείρηση

Η φωνητική κλήση $25 εκατομμυρίων που δεν έγινε ποτέ

Τον Φεβρουάριο του 2024, μια οικονομική υπάλληλος σε μια πολυεθνική εταιρεία στο Χονγκ Κονγκ δέχτηκε μια βιντεοκλήση από τον οικονομικό διευθυντή της.

Η φωνή στην άλλη άκρη ήταν αλάνθαστη- κάθε τόνος, κάθε παύση, ακόμη και η ελαφριά προφορά αναγνωρίστηκαν αμέσως.

Της ζήτησε επειγόντως να διεκπεραιώσει 15 εμβάσματα, συνολικού ύψους $25 εκατομμυρίων, για την ολοκλήρωση μιας εμπιστευτικής εξαγοράς.

Μην ανησυχείτε ποτέ ξανά για την απάτη με τεχνητή νοημοσύνη. TruthScan Μπορεί να σας βοηθήσει:

- Ανίχνευση AI που παράγεται εικόνες, κείμενο, φωνή και βίντεο.

- Αποφύγετε το σημαντική απάτη με βάση την τεχνητή νοημοσύνη.

- Προστατέψτε τα πιο ευαίσθητο περιουσιακά στοιχεία της επιχείρησης.

Ο οικονομικός διευθυντής δεν έκανε ποτέ αυτή την κλήση. Ήταν εντελώς τεχνητή νοημοσύνη.

Αυτό δεν ήταν μια μεμονωμένη περίπτωση. Τα χρηματοπιστωτικά ιδρύματα βλέπουν μια κατακόρυφη αύξηση της απάτης deepfake.

Κατά τα τελευταία τρία χρόνια, οι υποθέσεις αυξήθηκαν κατά 2.137% και η ΤΝ οδηγεί πλέον το 42,5% όλων των προσπαθειών απάτης στον τομέα.

Ακόμα και με την έξαρση της απάτης φωνής AI, περισσότεροι από τους μισούς ηγέτες επιχειρήσεων παραδέχονται ότι οι υπάλληλοί τους δεν έχουν εκπαιδευτεί για να εντοπίζουν ή να αντιδρούν σε επιθέσεις deepfake. σχεδόν 80% των εταιρειών δεν έχουν επίσημα πρωτόκολλα για τον χειρισμό αυτών των περιστατικών.

Πώς λειτουργεί η κλωνοποίηση φωνής AI και γιατί αποτελεί απειλή

Η σύγχρονη σύνθεση φωνής τεχνητής νοημοσύνης χρειάζεται εκπληκτικά λίγα δεδομένα. Μόλις μερικά δευτερόλεπτα ήχου μπορούν να κλωνοποιήσουν μια φωνή με ακρίβεια έως και 85%.

Η διαδικασία περιλαμβάνει τρία βασικά βήματα:

- Συλλογή δεδομένων: Οι απατεώνες συλλέγουν δείγματα φωνής από δημόσιες πηγές, όπως τηλεφωνικές συνδιασκέψεις, συνεντεύξεις σε podcast, αποσπάσματα από μέσα κοινωνικής δικτύωσης ή ακόμη και αναρτήσεις βίντεο στο LinkedIn.

- Μοντέλο εκπαίδευσης: Η τεχνητή νοημοσύνη αναλύει φωνητικά χαρακτηριστικά όπως το ύψος, τον τόνο, την προφορά, τον ρυθμό και τα μοτίβα αναπνοής.

- Γενιά: Το σύστημα δημιουργεί συνθετική ομιλία αρκετά πειστική για να ξεγελάσει ακόμη και στενούς συναδέλφους.

Το πρόβλημα της προσβασιμότητας

Αυτό που κάνει αυτή την απειλή ακόμη πιο επικίνδυνη είναι ο εκδημοκρατισμός της. Οι απατεώνες δεν χρειάζονται πλέον πόρους επιπέδου Χόλιγουντ.

Το μόνο που απαιτείται είναι ένα προσιτό λογισμικό για την κλωνοποίηση μιας φωνής από ένα σύντομο απόσπασμα από τα μέσα κοινωνικής δικτύωσης.Τα εργαλεία ανοικτού κώδικα και οι υπηρεσίες τεχνητής νοημοσύνης που βασίζονται στο σύννεφο έχουν καταστήσει την κλωνοποίηση φωνής διαθέσιμη σε οποιονδήποτε με βασικές τεχνικές δεξιότητες.

Γιατί τα στελέχη αποτελούν κορυφαίους στόχους για απάτη

Τα στελέχη αντιμετωπίζουν ένα επικίνδυνο μείγμα παραγόντων κινδύνου.

Η δημόσια έκθεσή τους μέσω των μέσων κοινωνικής δικτύωσης καθιστά τα δείγματα φωνής εύκολα ευρετά και η εξουσία τους συχνά ωθεί τους υπαλλήλους να ενεργούν γρήγορα σε επείγοντα αιτήματα.

Κατά μέσο όρο, ένα στα τέσσερα στελέχη έχει περιορισμένη κατανόηση της τεχνολογίας deepfake.

Τα τρέχοντα στατιστικά στοιχεία δίνουν μια ανησυχητική εικόνα

Σε μια 2024 έρευνα της Deloitte, 25,9% των στελεχών δήλωσαν ότι οι οργανισμοί τους αντιμετώπισαν τουλάχιστον ένα περιστατικό deepfake που στόχευε οικονομικά ή λογιστικά δεδομένα κατά το προηγούμενο έτος και οι μισοί από όλους τους ερωτηθέντες πίστευαν ότι οι επιθέσεις αυτές θα αυξηθούν κατά τους επόμενους 12 μήνες.

Το πιο ανησυχητικό: μόνο 52% των οργανισμών αισθάνονται σίγουροι ότι θα μπορούσαν να εντοπίσουν ένα deepfake του CEO τους.

Πώς να εντοπίσετε απάτες φωνής AI

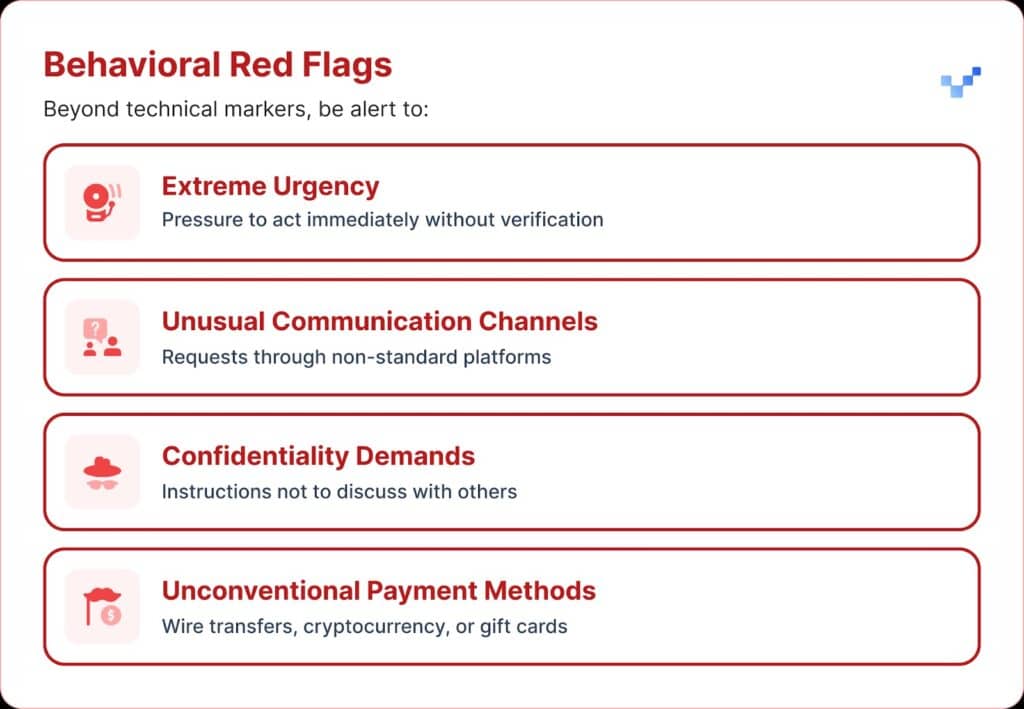

Όταν λαμβάνετε μια ύποπτη φωνητική επικοινωνία, υπάρχουν μερικά προειδοποιητικά σημάδια που πρέπει να προσέξετε.

Οι φωνητικές απάτες τεχνητής νοημοσύνης συχνά ακούγονται μονότονες ή επίπεδες. Μπορεί επίσης να παρατηρήσετε ασυνήθιστο ρυθμό, με περίεργες παύσεις ή αφύσικο ρυθμό.

Ο ήχος μπορεί επίσης να μεταφέρει αχνό ηλεκτρονικό βουητό ή ηχώ, ειδικά κατά τη διάρκεια μεγαλύτερων κλήσεων.

Και σε πολλές περιπτώσεις, η φωνή επαναλαμβάνει περιορισμένες φράσεις που μοιάζουν με σενάριο ή πρόβα.

Οικονομικός αντίκτυπος και τι πραγματικά κοστίζει

Οι περισσότεροι οργανισμοί έχασαν περίπου $450.000 κατά μέσο όρο, αλλά στον τομέα των χρηματοπιστωτικών υπηρεσιών οι απώλειες σκαρφάλωσαν πάνω από $603.000.

Και στις πιο σοβαρές περιπτώσεις, 1 στους 10 οργανισμούς ανέφερε απώλειες άνω του $1 εκατομμυρίου.

Η τάση αυτή αναπτύχθηκε γρήγορα. Παλαιότερη έρευνα του 2022 έδειξε ότι η μέση οικονομική επιβάρυνση από την απάτη ταυτότητας ήταν περίπου $230.000, σχεδόν το μισό του σημερινού ποσού.

Προβλεπόμενες μελλοντικές απώλειες

Σύμφωνα με το Κέντρο Χρηματοοικονομικών Υπηρεσιών της Deloitte, τα χρήματα που χάνονται λόγω απάτης με τεχνητή νοημοσύνη στις ΗΠΑ θα μπορούσαν να αυξηθούν από $12,3 δισεκατομμύρια το 2023 σε $40 δισεκατομμύρια έως το 2027. Αυτό σημαίνει περίπου 32% αύξηση κάθε χρόνο.

Περιφερειακή τρωτότητα

Η Βόρεια Αμερική παρουσίασε αύξηση 1740% στην απάτη deepfake.

Αυτή η σημαντική περιφερειακή αύξηση υποδηλώνει ότι η Βόρεια Αμερική μπορεί να αποτελεί πρωταρχικό στόχο για τους απατεώνες του deepfake, πιθανότατα λόγω της μεγάλης ψηφιακής οικονομίας της και της ευρείας χρήσης διαδικτυακών υπηρεσιών.

Στρατηγικές προσεγγίσεις για την προστασία στελεχών

1. Εφαρμογή πρωτοκόλλων επαλήθευσης

Ένας τρόπος για την ενίσχυση της άμυνας είναι η χρήση ενός συστήματος "ασφαλών λέξεων", δηλαδή προσυμφωνημένων φράσεων πιστοποίησης ταυτότητας που μοιράζονται με το προσωπικό-κλειδιά.

Ένας απατεώνας που χρησιμοποιεί κλωνοποίηση φωνής τεχνητής νοημοσύνης δεν θα γνωρίζει τις σωστές απαντήσεις σε ερωτήσεις προσωπικής επαλήθευσης.

Μια άλλη δικλείδα ασφαλείας είναι η επαλήθευση πολλαπλών καναλιών.

Οποιοδήποτε ασυνήθιστο οικονομικό αίτημα θα πρέπει να επιβεβαιώνεται μέσω ξεχωριστού διαύλου επικοινωνίας, χωρίς ποτέ να βασίζεται μόνο στην αρχική μέθοδο επικοινωνίας.

Οι εταιρείες θα πρέπει επίσης να θεσπίσουν σαφείς κανόνες κλιμάκωσης, με περιόδους αναμονής και βήματα έγκρισης για μεγάλες οικονομικές συναλλαγές, ανεξάρτητα από το ποιος τις ζητά.

2. Προσέξτε την ψηφιακή έκθεση

Ένα άλλο επίπεδο προστασίας προέρχεται από τον περιορισμό του όγκου του εκτελεστικού ήχου και βίντεο που είναι διαθέσιμο στο διαδίκτυο. Όσο περισσότερα δείγματα μπορούν να συλλέξουν οι απατεώνες, τόσο πιο πειστικοί γίνονται οι κλώνοι τους.

Βοηθάει επίσης ο καθορισμός σαφών κατευθυντήριων γραμμών στα μέσα κοινωνικής δικτύωσης για τα στελέχη, ιδίως όσον αφορά την ανάρτηση βίντεο με καθαρό ήχο.

Και όταν πρόκειται για συνέδρια, οι οργανισμοί θα πρέπει να προσέχουν τις ηχογραφημένες ομιλίες ή συνεντεύξεις που δίνουν μεγάλα τμήματα δειγμάτων φωνής.

3. Ανάπτυξη τεχνικών λύσεων

Εδώ είναι που η προηγμένη τεχνολογία ανίχνευσης AI αποκτά κρίσιμη σημασία.

Οι οργανισμοί χρειάζονται επιχειρησιακού επιπέδου φωνητικό έλεγχο ταυτότητας και ανίχνευση deepfake δυνατότητες που παρέχουν:

- Ανάλυση σε πραγματικό χρόνο: Ανίχνευση συνθετικών φωνών κατά τη διάρκεια ζωντανών επικοινωνιών

- Ιστορική επαλήθευση: Ανάλυση καταγεγραμμένων κλήσεων και μηνυμάτων για αυθεντικότητα

- Δυνατότητες ενσωμάτωσης: Λειτουργεί απρόσκοπτα με τις υπάρχουσες πλατφόρμες επικοινωνίας

- Υψηλά ποσοστά ακρίβειας: Ελαχιστοποίηση των ψευδώς θετικών αποτελεσμάτων, ενώ συλλαμβάνετε εξελιγμένες απομιμήσεις

4. Ολοκληρωμένα προγράμματα κατάρτισης

Οι ηγετικές ομάδες χρειάζονται στοχευμένη εκπαίδευση σχετικά με τις απειλές φωνής AI και τις διαδικασίες επαλήθευσης.

Εξίσου σημαντική είναι η ευαισθητοποίηση των εργαζομένων.

Ο καθένας, σε οποιοδήποτε ρόλο, θα πρέπει να είναι εξοπλισμένος για να εντοπίζει πιθανά deepfakes και να αποτρέπει τις απειλές στον κυβερνοχώρο από το να εισέλθουν στον οργανισμό.

Οι τακτικές ασκήσεις προσομοίωσης μπορούν να ενισχύσουν αυτή την ετοιμότητα με τη χρήση εικονικών προσπαθειών απάτης φωνής για τη δοκιμή και την τελειοποίηση των διαδικασιών αντίδρασης.

Προηγμένες λύσεις ανίχνευσης φωνής AI

Οι παραδοσιακές άμυνες κατασκευάστηκαν για απειλές που βασίζονται στο δίκτυο, όχι όμως για την ανθρώπινη μίμηση με τεχνητή νοημοσύνη.

Οι κύριοι λόγοι για τους οποίους τα τυποποιημένα εργαλεία κυβερνοασφάλειας δεν μπορούν να αντιμετωπίσουν τη φωνητική κοινωνική μηχανική:

- Δεν υπάρχει υπογραφή κακόβουλου λογισμικού: Οι φωνητικές κλήσεις δεν ενεργοποιούν τα παραδοσιακά συστήματα ασφαλείας

- Παράγοντας ανθρώπινης εμπιστοσύνης: Οι άνθρωποι εμπιστεύονται φυσικά αυτό που ακούνε, ειδικά τις οικείες φωνές.

- Τεχνολογικά κενά ανίχνευσης: Παρά την αύξηση των προσπαθειών απάτης με τεχνητή νοημοσύνη, συμπεριλαμβανομένων των deepfakes, μόνο το 22% των χρηματοπιστωτικών ιδρυμάτων έχουν εφαρμόσει εργαλεία πρόληψης της απάτης με βάση την τεχνητή νοημοσύνη.

Η ανάγκη για εξειδικευμένη ανίχνευση φωνής

Η σύγχρονη φωνητική απάτη απαιτεί σύγχρονες δυνατότητες ανίχνευσης.

Επιχειρησιακού επιπέδου Συστήματα ανίχνευσης φωνής AI μπορεί:

- Ανάλυση φωνητικών βιοδεικτών: Ανίχνευση λεπτών ασυνεπειών στη συνθετική ομιλία

- Επεξεργασία σε πραγματικό χρόνο: Παροχή άμεσων ειδοποιήσεων κατά τη διάρκεια ύποπτων κλήσεων

- Συνεχής μάθηση: Προσαρμογή σε νέες τεχνικές σύνθεσης φωνής

- Έτοιμη για ενσωμάτωση: Εργασία με την υπάρχουσα υποδομή επικοινωνίας

Οι οργανισμοί που επιθυμούν σοβαρά να προστατευθούν από τη φωνητική απάτη πρέπει να επενδύσουν σε τεχνολογία ανίχνευσης τεχνητής νοημοσύνης που μπορεί να ανταποκριθεί στην πολυπλοκότητα των απειλών που αντιμετωπίζουν.

Η φωνητική απάτη είναι εδώ τώρα, και κλιμακώνεται

Κατά το πρώτο τρίμηνο του 2025, η απάτη και η κλοπή ταυτότητας deepfake προκάλεσαν απώλειες άνω των $200 εκατομμυρίων.

Το φωνητικό phishing με κλώνους AI αυξήθηκε κατά 442% και περισσότερες από 400 επιχειρήσεις την ημέρα δέχονται απάτες με ψεύτικους CEO ή CFO.

Ενώ 56% των επιχειρήσεων δηλώνουν ότι αισθάνονται πολύ σίγουροι για τον εντοπισμό των απομιμήσεων, μόνο 6% έχουν πράγματι αποφύγει να υποστούν οικονομικές απώλειες από αυτές.

Αυτό που έχει σημασία δεν είναι αν ο οργανισμός σας θα γίνει στόχος, αλλά αν είστε έτοιμοι γι' αυτό.

Η απάτη μέσω φωνής αλλάζει το πρόσωπο της ασφάλειας στον κυβερνοχώρο. Οι παραδοσιακές άμυνες δεν μπορούν να συμβαδίσουν με την πλαστοπροσωπία με τεχνητή νοημοσύνη.

Για να παραμείνουν προστατευμένοι, οι οργανισμοί χρειάζονται καλύτερα εργαλεία ανίχνευσης, ισχυρά προγράμματα κατάρτισης και σαφείς διαδικασίες επαλήθευσης.

Η τεχνολογία για να αντεπιτεθούμε είναι ήδη εδώ. Το πραγματικό ερώτημα είναι αν θα τη χρησιμοποιήσετε πριν ή μετά το πρώτο περιστατικό απάτης με φωνητική επικοινωνία.