Einleitung: Eine neue Ära der KI-gesteuerten Angriffe

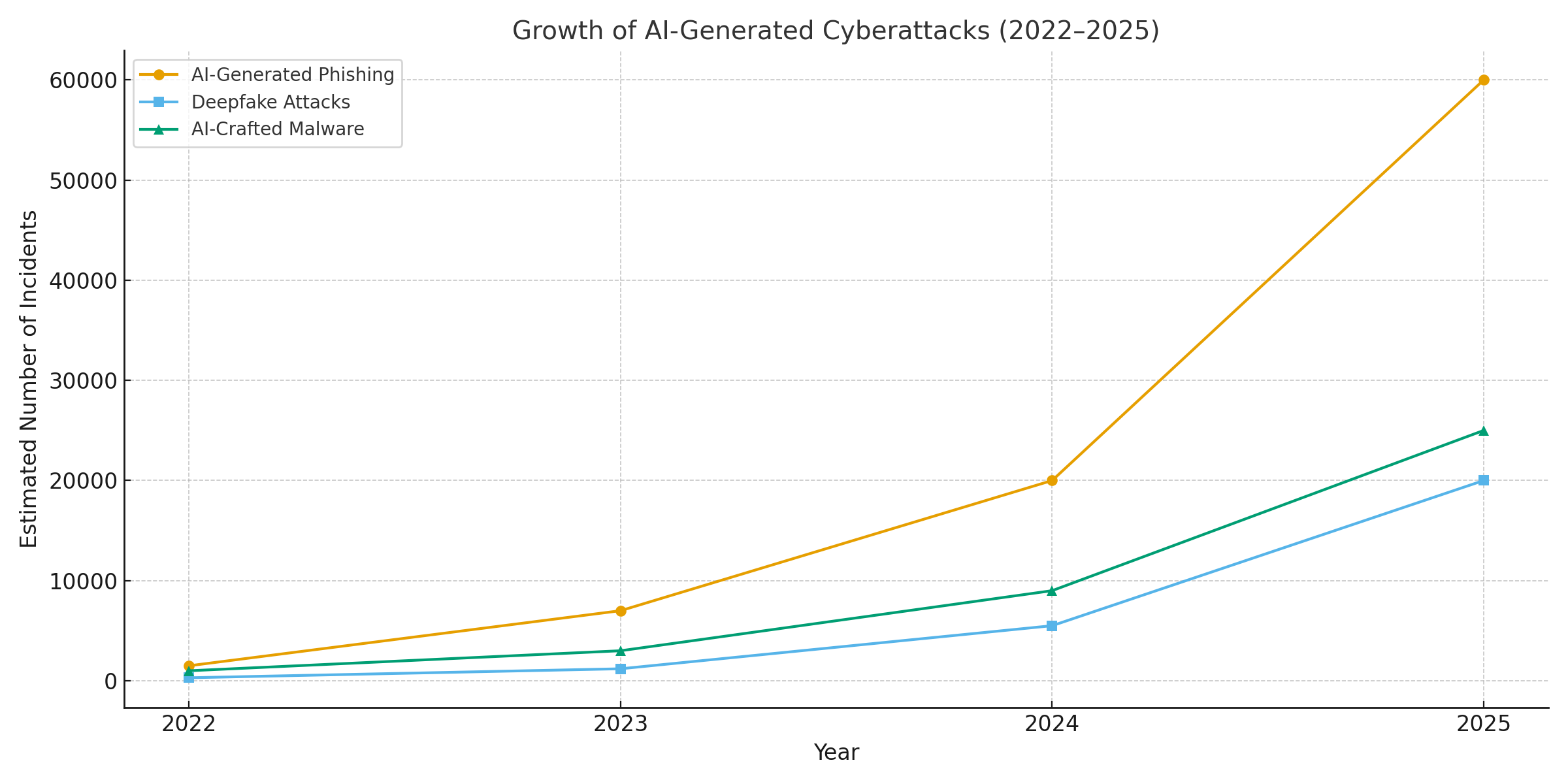

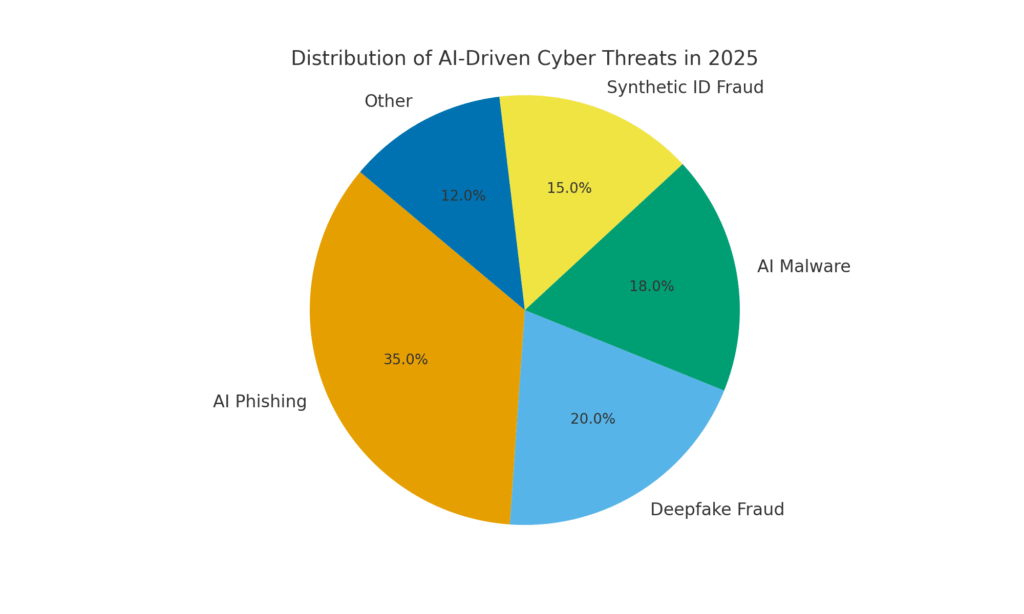

Das Jahr 2025 hat einen Wendepunkt in der Cybersicherheit markiert. Generative KI hat Cyberangriffe beschleunigt und ermöglicht es Bedrohungsakteuren, mehr häufig, realistisch und skalierbar Kampagnen als je zuvor. In der Tat wurden im vergangenen Jahr schätzungsweise 16% der gemeldeten Cyber-Vorfälle betrafen Angreifer, die KI-Tools nutzten (z. B. Bild- und Sprachgenerierungsmodelle) zur Verbesserung des Social Engineering[1]. Von extrem überzeugenden Phishing-E-Mails bis hin zu gefälschten Audio-/Videobetrügereien setzen böswillige Akteure KI in allen Bereichen als Waffe ein. Die Mehrheit der Sicherheitsexperten schreibt die Anstieg der Cyberangriffe auf generative KI zurückzuführendie böswilligen Akteuren schnellere und intelligentere Möglichkeiten bietet, ihre Opfer auszunutzen[2]. Die generative KI senkt die Hürde für Cyberkriminalität und erhöht gleichzeitig ihre Schlagkraft.

Warum ist dies so besorgniserregend? KI kann im Handumdrehen ausgefeilte, kontextabhängige Inhalte produzieren, die selbst geschulte Benutzer täuschen. Sie kann Stimmen und Gesichter mit erschreckender Genauigkeit imitieren und sogar bösartigen Code generieren, der sich verändert, um der Erkennung zu entgehen. Infolgedessen sind Cyberangriffe schwieriger zu erkennen und leichter auszuführen. Die Weltwirtschaftsforum warnt, dass 72% der Unternehmen aufgrund der wachsenden Fähigkeiten der generativen KI erhöhte Cyberrisiken - insbesondere Social Engineering und Betrug - festgestellt haben[3]. Vorfälle in der realen Welt bestätigen dies: Anfang 2024 benutzten Kriminelle eine KI-generierte Deepfake-Videoanruf sich als Finanzchef eines Unternehmens auszugeben und einen Angestellten zur Versetzung zu bewegen $25,6 Millionen an die Betrüger[4]. Und in einem anderen Fall haben nordkoreanische Hacker KI-generierte gefälschte ID-Dokumente Sicherheitsüberprüfungen in einer Phishing-Kampagne zur Verteidigung zu umgehen[5]. Diese Beispiele zeigen, was auf dem Spiel steht: Generative KI ermöglicht Betrügereien, die sowohl menschliche als auch technische Kontrollen umgehen.

Doch auch die KI ist Teil der Lösung. Fortschrittliche Erkennungstools (wie die von TruthScan) nutzen KI gegen KI - Analyse von Inhalten auf subtile Signaturen der Maschinengeneration. In diesem Whitepaper untersuchen wir die wichtigsten KI-gesteuerten Cyber-Bedrohungen des Jahres 2025 und zeigen, wie Unternehmen sie abwehren können. Von KI-generiertes Phishing zu deepfake CEO-Betrug, KI-programmierte Malware, synthetische Identitätenund mehr werden wir untersuchen, wie generative KI Angriffe umgestaltet. Außerdem werden wir konkrete Abwehrmaßnahmen erörtern, darunter AI-Inhaltserkennung, Deepfake-Forensik und Identitätsüberprüfungstechnologien, die Sicherheitsteams helfen können, die Oberhand zu gewinnen. Das Ziel ist es, zu beleuchten, wie Unternehmen, MSSPs, CISOs und Betrugsermittler KI-Erkennungstools in ihr Cybersecurity-Stack zu integrieren um dieser Welle von KI-gestützten Bedrohungen zu begegnen.

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

KI-generiertes Phishing und BEC: Betrug in noch nie dagewesenem Ausmaß

Eine der deutlichsten Auswirkungen der generativen KI war bei Phishing und Kompromittierung von Geschäfts-E-Mails (BEC) Schemata. KI-Sprachmodelle können in Sekundenschnelle flüssige, auf den jeweiligen Kontext zugeschnittene E-Mails verfassen und dabei die verräterischen Grammatikfehler und ungeschickten Formulierungen eliminieren, die früher Phishing verrieten. Das Ergebnis ist eine Flut von äußerst überzeugenden Betrugs-E-Mails und -Texten. Bis April 2025, mehr als die Hälfte der Spam-E-Mails (51%) wurden von KI geschriebengegenüber praktisch Null zwei Jahre zuvor[6]. Noch alarmierender ist, dass die Forscher feststellten, dass etwa 14% der BEC-Angriffs-E-Mails waren KI-generiert bis 2025[7] - eine Zahl, die voraussichtlich steigen wird, wenn Kriminelle Tools wie ChatGPT einsetzen. Einige Studien schätzen über 80% von Phishing-E-Mails können nun mit Hilfe von KI erstellt werden[8].

Das Volumen dieser KI-generierten Köder ist explodiert. Sicherheitsanalysen zeigen, dass Phishing-Angriffe in Verbindung mit generativer KI um 1,265% in einer kurzen Zeitspanne[9]. In einem Zeitraum stiegen die Berichte über Phishing-Vorfälle 466% in einem einzigen Quartalvor allem aufgrund von automatisierten Phishing-Kits und Bots, die maßgeschneiderte Köder auslegen[9][10]. Warum ein solcher Anstieg? Weil AI Angreifern erlaubt Skala ihre Operationen dramatisch. Ein einziger Krimineller kann einen KI-Chatbot nutzen, um Tausende von personalisierten Betrugs-E-Mails, die sich an verschiedene Mitarbeiter oder Kunden richten, und das alles in der Zeit, die für die Erstellung einer einzigen E-Mail erforderlich war. Diese Massenautomatisierung veranlasste das FBI zu der Warnung, dass die BEC-Verluste (die 2022 bereits $2,7 Mrd. betrugen) nur noch zunehmen werden, da die KI "diese Verluste noch weiter in die Höhe zu treiben droht".[11][12].

Es gibt nicht nur mehr Phishing-E-Mails, sie sind auch effektiver. Die Opfer werden durch die ausgefeilte Sprache und die kontextbezogenen Details, die KI einbauen kann, in höherem Maße getäuscht. In Labortests erreichten von KI geschriebene Phishing-E-Mails eine 54% Durchklickrate - weit über den ~12% für traditionelle Phishing-Versuche[13]. Diese Nachrichten lesen sich wie der Stil eines echten Geschäftsführers oder beziehen sich auf reale Unternehmensereignisse, wodurch die Empfänger unvorsichtig werden. Die Angreifer nutzen sogar KI, um verschiedene Formulierungen zu testen und die erfolgreichsten Aufhänger weiterzuentwickeln[14]. Und im Gegensatz zu Menschen macht die KI keine Tippfehler oder wird müde - sie kann endlose Varianten ausspucken, bis eine durch die Filter rutscht und jemanden täuscht.

Ein typisches Beispiel: Mitte 2025 wird ein Reuters Untersuchung zeigte, wie südostasiatische Betrüger ChatGPT zur Automatisierung der Betrugskommunikation nutzten[15]. Sie generierten massenhaft überzeugende Bank-E-Mails und Kundendiensttexte, wodurch sich die Reichweite ihrer Machenschaften enorm erhöhte. Die europäische Polizei berichtete ebenfalls von KI-gesteuerten Phishing-Kits, die im Dark Web für weniger als $20 verkauft werden und es wenig qualifizierten Akteuren ermöglichen, ausgefeilte Kampagnen zu starten[16][17]. Die Eintrittsbarriere für BEC und Phishing ist im Wesentlichen verschwunden.

Abwehrmaßnahmen - AI Phish stoppen: Angesichts dieses Ansturms müssen Unternehmen ihre E-Mail- und Messaging-Kanäle verstärken. Dies ist der Punkt AI-Inhaltserkennung kann helfen. Tools wie TruthScans AI-Text-Detektor und spezialisierte E-Mail-Scanner kann eingehende Nachrichten auf die statistischen Merkmale von KI-generiertem Text analysieren. Zum Beispiel kann die TruthScan E-Mail-Betrugsdetektor nutzt die Analyse natürlicher Sprache, um E-Mails zu kennzeichnen, die wahrscheinlich von einer KI stammen, auch wenn sie legitim aussehen[18]. Diese Detektoren untersuchen Dinge wie perfekt ausgefeilte Grammatik, Satzkomplexität und stilistische Muster, die für menschliche Schreiber ungewöhnlich sind. Mit Echtzeit-ScanningSo können verdächtige E-Mails unter Quarantäne gestellt oder zur Überprüfung markiert werden, bevor sie die Benutzer erreichen. Sicherheitsteams in Unternehmen beginnen damit, solche KI-gesteuerten Filter an E-Mail-Gateways und Messaging-Plattformen einzusetzen. In der Praxis bedeutet dies, dass zu den herkömmlichen Spam-Filtern eine neue Verteidigungsebene hinzugefügt wird - eine, die explizit auf das Abfangen von KI-geschriebenen Inhalten abgestimmt ist. Ab 2025 integrieren führende Unternehmen Lösungen wie TruthScan über eine API in ihre sicheren E-Mail-Gateways und Cloud-Collaboration-Suiten und schaffen damit einen automatischen Kontrollpunkt für KI-generiertes Phishing Inhalt.

Deepfake Voice & Video Impersonation: Der "Sehen trügt"-Betrug

Die vielleicht größte KI-bedingte Bedrohung im Jahr 2025 ist der Aufstieg der gefälschte Sprach- und Videoangriffe. Mithilfe von KI-Modellen können Kriminelle die Stimme einer Person aus nur wenigen Sekunden Audio klonen oder aus einer Handvoll Fotos ein realistisches Video des Gesichts einer Person erstellen. Diese Fälschungen werden für Betrügereien mit hohem Risiko eingesetzt - vom CEO-Betrug ("Fake CEO"-Anrufe) bis hin zu gefälschten Videokonferenzen und mehr. Ein kürzlich veröffentlichter Branchenbericht enthüllt 47% der Unternehmen haben Deepfake-Angriffe erlebt in irgendeiner Form[19]. Und das ist nicht nur theoretisch: Mehrere Raubüberfälle in den Jahren 2023-2025 haben bewiesen, dass Deepfakes die ultimative Authentifizierung - unsere eigenen Augen und Ohren - ausschalten können.

Ein berüchtigter Fall betraf eine internationale Banküberweisung von $25 Millionen nachdem ein Mitarbeiter durch eine gefälschte Videokonferenz getäuscht wurde. Die Angreifer nutzten KI, um in einem Zoom-Anruf das Abbild der Finanzchefin des Unternehmens mit ihrer Stimme und ihren Eigenheiten zu synthetisieren und den Mitarbeiter anzuweisen, Geld zu überweisen[4][20]. In einem anderen Fall in Australien hat eine Kommunalverwaltung $2,3 Millionen verloren als Betrüger sowohl die Stimme als auch das Video von Stadtbeamten fälschten, um betrügerische Zahlungen zu genehmigen[21]. Und beunruhigenderweise verwenden Kriminelle KI-geklonte Stimmen für "Großeltern-Betrügereien" - sie rufen Senioren an und geben sich als deren Verwandte in Not aus. Die FBI und FinCEN warnte Ende 2024 vor einem Anstieg der Betrugsfälle durch KI-generierte "gefälschte" Medieneinschließlich gefälschter Kundenbetreuer und synthetischer Identitäten zur Umgehung von KYC-Überprüfungen[22].

Die Häufigkeit von Deepfake-Delikten steigt schnell. Einer Analyse zufolge wird es bis Ende 2024 alle fünf Minuten ein neuer Deepfake-Betrug auftrat im Durchschnitt[23]. Allein im ersten Quartal 2025 stieg die Zahl der gemeldeten Deepfake-Vorfälle um 19% im Vergleich zu alle von 2024[24][25]. Deepfakes machen inzwischen schätzungsweise 6,5% aller Betrugsangriffe, a 2,137% Anstieg seit 2022[26][27]. Die erforderliche Technologie ist leicht zugänglich geworden - oft braucht man nur noch 30 Sekunden Audio um eine Stimme zu klonen, oder weniger als eine Stunde Filmmaterial, um das Gesicht einer Person überzeugend zu modellieren[20]. Kurz gesagt, es war noch nie so einfach "die Identität einer vertrauenswürdigen Person "fälschen und verleiten ihre Opfer zur Herausgabe von Geld oder Informationen.

Verteidigungsmaßnahmen - Authentifizierung der Realität: Um Deepfake-Bedrohungen abzuwehren, setzen Unternehmen auf fortschrittliche Erkennung synthetischer Medien Werkzeuge. Zum Beispiel, TruthScans AI-Sprachdetektor und TruthScan Deepfake-Detektor nutzen KI, um Audio- und Videomaterial auf Anzeichen von Manipulation zu analysieren. Diese Systeme führen Frame-für-Frame- und Wellenform-Analysen durch, um Artefakte wie unnatürliche Gesichtsbewegungen, Lippensynchronisationsprobleme oder Unregelmäßigkeiten im Audiospektrum zu erkennen, die einen KI-generierten Clip verraten. In Tests erreichten die Algorithmen von TruthScan 99%+ Genauigkeit bei der Erkennung von AI-generierten Stimmen und erkannte manipulierte Videobilder in Echtzeit[28][29]. Tatsächlich nutzten Forscher des Genians Security Center vor kurzem TruthScans Bildforensik, um eine gefälschte ID-Karte zu analysieren, die von nordkoreanischen Hackern verwendet wurde - TruthScans Deepfake-Bilddetektor kennzeichnete das Dokument als nicht authentisch mit 98% VertrauenVereitelung des Spear-Phishing-Versuchs[5][30].

Zur praktischen Verteidigung setzen Unternehmen diese Erkennungsfunktionen an wichtigen Knotenpunkten ein. Überprüfung der Stimme wird in die Arbeitsabläufe von Call-Centern integriert - wenn z. B. ein "Kunde" eine große Überweisung per Telefon anfordert, kann das Audiomaterial durch einen Stimmverfälschungsdetektor laufen, um sicherzustellen, dass es sich wirklich um ihn handelt (und nicht um eine KI-Imitation). Gleiches gilt, Videokonferenz-Plattformen können Live-Deefake-Scans der teilnehmenden Videostreams integrieren, um synthetische Gesichter zu erkennen. Die Deepfake-Erkennungssuite von TruthScan bietet zum Beispiel Analyse von Videogesprächen in Echtzeit und Authentifizierung von Gesichtern die sich über API mit Zoom oder WebEx verbinden können[31][29]. Das heißt, wenn jemand versucht, mit einem von der KI erstellten Video Ihres CEO an einer Besprechung teilzunehmen, kann das System einen "möglichen Deepfake" erkennen, bevor Schaden entsteht. Darüber hinaus beinhalten wichtige Transaktionen heute oft einen Verifizierungsschritt (Out-of-Band oder Multi-Faktor), der die Inhaltsauthentifizierung nutzen kann - z. B. eine kurze gesprochene Bestätigung, die dann von einem KI-Stimmdetektor auf Authentizität überprüft wird. Durch die Schichtung dieser Tools schaffen Unternehmen ein Sicherheitsnetz: Selbst wenn Mitarbeiter siehe oder hören etwas plausibel erscheint, wird eine KI-Forensik hinter den Kulissen ihre Realität in Frage stellen. In einer von KI durchdrungenen Bedrohungslandschaft, "Traue nicht - prüfe nach" wird zum Mantra für jede Sprach- oder Videokommunikation, bei der es um Geld oder sensible Daten geht.

KI-gestützte Malware und verschleierter Code: Sich entwickelnde Bedrohungen im Code

Der Einfluss der KI beschränkt sich nicht auf Social Engineering - sie verändert auch die Entwicklung von Malware und ausweichendem Angriffscode. Im Jahr 2025 entdeckte die Threat Intelligence Group von Google die erste Malware-Stämme mit KI während Ausführung, um ihr Verhalten zu ändern[32][33]. Ein Beispiel mit der Bezeichnung PROMPTFLUXwar ein bösartiges Skript, das tatsächlich eine KI-API (Googles Gemini-Modell) aufrief, um seinen eigenen Code im laufenden Betrieb umzuschreibenHerstellung neuer verschleierter Varianten, um die Erkennung durch Antivirenprogramme zu umgehen[34][35]. Diese "Just-in-Time"-KI-Entwicklung markiert einen Sprung in Richtung autonomer, polymorpher Malware. Ein weiteres Beispiel, PROMPTSTEALverwendete einen KI-Codierassistenten, um einzeilige Windows-Befehle für Datendiebstahl zu generieren, wobei Teile der Logik in Echtzeit an eine KI-Engine ausgelagert wurden[36][37]. Diese Innovationen deuten auf eine Zukunft hin, in der sich Malware kontinuierlich verändern kann - ähnlich wie ein menschlicher Pen-Tester es tun würde -, um Abwehrmaßnahmen zu umgehen.

Auch ohne fliegende KI nutzen Angreifer KI während der Entwicklung, um wirkungsvolleren bösartigen Code zu erstellen. Generative KI kann Malware erzeugen, die sehr verworrenund enthält verwirrende Logikebenen, die ein Reverse Engineering erschweren. Laut Berichten von Bedrohungsdaten, über 70% der größeren Sicherheitsverletzungen im Jahr 2025 betrafen eine Form von polymorpher Malware der seine Signatur oder sein Verhalten ändert, um nicht entdeckt zu werden[38]. Zusätzlich, 76% von Phishing-Kampagnen jetzt polymorphe Taktiken wie dynamische URLs oder von KI umgeschriebene Nutzdaten einsetzen[38]. Tools wie die Dark-Web-Angebote WormGPT und FraudGPT (uneingeschränkte Klone von ChatGPT) ermöglichen es auch Nicht-Experten, Malware-Dropper, Keylogger oder Ransomware-Code zu erstellen, indem sie einfach beschreiben, was sie wollen[39]. Das Ergebnis ist eine Fülle von neuen Malware-Varianten. Im Jahr 2024 wurde beispielsweise ein Infodiebstahlprogramm namens BlackMamba entstanden, die vollständig KI-generiertEr verwendet ChatGPT, um seinen Code in Segmenten zu schreiben - jede Ausführung erzeugt eine leicht unterschiedliche Binärdatei, die herkömmliche signaturbasierte Antivirenprogramme verwirrt.[38]. Sicherheitsforscher demonstrierten auch KI-generierte polymorphe Proof-of-Concepts, die viele Endpunkt-Schutzmaßnahmen umgehen können[40].

Darüber hinaus nutzen Angreifer KI zur Feinabstimmung ihrer Lieferung von Malware. KI kann auf intelligente Weise Phishing-E-Mails schreiben (wie bereits erwähnt), die Links zu Malware enthalten. Sie kann auch bei der Entwicklung von Exploits helfen - z. B. durch den Einsatz von KI, um neue Schwachstellen zu finden oder Shellcode zu optimieren. Staatliche Akteure haben Berichten zufolge fortschrittliche KI-Modelle eingesetzt, um Zero-Day-Exploits zu entdecken und maßgeschneiderte Malware für Ziele zu entwickeln.[41]. All diese Trends bedeuten, dass Malware im Jahr 2025 heimlicher und anpassungsfähiger ist. Sie ist oft mit KI "miterschaffen"Dadurch ist es schwieriger, sie mit herkömmlichen Regeln zu erkennen.

Abwehrmaßnahmen - KI vs. KI in der Malware-Abwehr: Die Abwehr von KI-generierter Malware erfordert eine Kombination aus fortschrittlicher Erkennung und KI-gestützter Analyse auf der Verteidigungsseite. Viele Unternehmen verstärken ihre Endpunktschutz und EDR (Endpoint Detection & Response) mit KI/ML-Modellen, die nach den Verhaltensmustern von KI-generiertem Code suchen. Plötzliche Codeumwandlungen auf dem Host oder ungewöhnliche API-Aufrufe könnten beispielsweise darauf hinweisen, dass sich PROMPTFLUX selbst regeneriert. In ähnlicher Weise kann die Netzwerküberwachung Anomalien aufspüren, z. B. Malware, die sich an KI-Dienste wendet (was für Benutzeranwendungen nicht "normal" ist). Die Anbieter trainieren ML-basierte Detektoren auf den Familien der bisher identifizierten KI-gestützten Malware, was die Erkennung dieser neuartigen Bedrohungen verbessert.

Eine neue Lösung ist integrierte KI-Inhaltsprüfung in Entwickler- und Build-Pipelines. Das bedeutet, dass KI-gesteuerte Detektoren Skripte, Software-Builds oder sogar Konfigurationsänderungen auf bösartige oder KI-generierte Inhalte analysieren. Zum Beispiel, Der Echtzeit-Detektor von TruthScan kann über den reinen Text hinaus eingesetzt werden - seine multimodale Analyse kann potenziell verdächtigen Code oder Konfigurationsdateien kennzeichnen, indem sie erkennt, ob sie maschinell mit Verschleierungsmustern generiert wurden[42][43]. Entwicklungsteams und MSSPs beginnen damit, Infrastruktur-als-Code-Skripte, PowerShell-Protokolle und andere Artefakte auf Anzeichen von KI-geschriebenen Segmenten zu scannen, die auf die Hand eines Angreifers hinweisen könnten. Dieser Bereich befindet sich zwar noch im Anfangsstadium, ist aber vielversprechend: In einem Fall hat ein Sicherheitsteam einen KI-Detektor eingesetzt, um eine verschleierte Phishing-Kit-Datei zu erkennen, die sich anfühlte, als sei sie von KI generiert worden, und tatsächlich Teil eines Angriffs war[44]. Der Code der Datei war übermäßig komplex und ausführlich (Kennzeichen der KI-Generierung), und ein KI-Inhaltsscan bestätigte, dass die Datei höchstwahrscheinlich nicht von einem Menschen geschrieben wurde[40].

Schließlich ist der Austausch von Bedrohungsdaten, die sich auf KI-Bedrohungen beziehen, von entscheidender Bedeutung. Wenn Google GTIG Details zu Prompt-basierter Malware veröffentlicht oder wenn Forscher über neue KI-Umgehungstechniken berichten, sollten Unternehmen diese in ihre Erkennungstechnik einfließen lassen. Verhaltensanalytik - Auf der Suche nach Aktionen wie einem Prozess, der ein Skript startet, das den Code desselben Prozesses umschreibt, können Anomalien erkannt werden, die KI-gestützte Malware aufweist. Kurzum, Verteidiger müssen Feuer mit Feuer bekämpfen: Einsatz KI-gesteuerte Sicherheitstools die sich so schnell anpassen können wie die KI-gesteuerte Malware. Das reicht von KI-gestütztem Virenschutz bis hin zu Analysen des Nutzerverhaltens, die erkennen können, wann ein Konto oder System beginnt, sich "nicht ganz menschlich" zu verhalten. Durch den Einsatz von KI zur Verteidigung können Sicherheitsteams den Geschwindigkeits- und Größenvorteilen begegnen, die KI Angreifern bietet.

Synthetische Identitäten und KI-gestützte Betrugsmaschen

Von der Malware zur Welt des Betrugs: Betrug mit synthetischer Identität hat sich mit Hilfe der generativen KI explosionsartig entwickelt. Bei synthetischem Identitätsbetrug werden fiktive Persönlichkeiten durch die Kombination echter und gefälschter Daten (z. B. echte SSN + gefälschter Name und Dokumente) erstellt. Diese "Frankenstein"-Identitäten werden dann zur Eröffnung von Bankkonten, zur Beantragung von Krediten oder zum Bestehen von KYC-Prüfungen verwendet - was schließlich zu unbezahlten Krediten oder Geldwäsche führt. Dies war bereits eine der am schnellsten wachsenden Betrugsarten, und die künstliche Intelligenz hat nun noch mehr Öl ins Feuer gegossen. Verluste durch synthetischen ID-Betrug über $35 Milliarden im Jahr 2023[45]und bis Anfang 2025 wurden einige Schätzungen fast 25% aller Verluste durch Bankbetrug waren auf synthetische Identitäten zurückzuführen[46]. Die Analysten von Experian stellten fest, dass über 80% Betrug bei neuen Konten in bestimmten Märkten jetzt mit synthetischen IDs verbunden ist[19] - eine erschütternde Statistik, die unterstreicht, wie weit verbreitet dieser Betrug inzwischen ist.

Generative KI verstärkt den synthetischen Betrug in mehrfacher Hinsicht. Erstens macht es die KI trivial, die "Züchterdokumente" und digitalen Fußabdrücken, die für den Verkauf einer gefälschten Identität erforderlich sind. In der Vergangenheit konnten Betrüger einen Ausweis mit Photoshop bearbeiten oder gefälschte Stromrechnungen manuell erstellen. Heute gibt es Tools zur Erstellung authentisch aussehende Profilfotos, Ausweise, Reisepässe, Kontoauszüge und sogar Profile in sozialen Medien mit AI-Bildgeneratoren und Sprachmodellen[47][48]. So kann eine KI beispielsweise ein realistisches Kopfbild einer Person erstellen, die nicht existiert (was eine einfache Rückwärtssuche verhindert), und einen passenden gefälschten Führerschein mit diesem Foto erstellen. KI kann auch die "Lebenszeichen" einer Identität simulieren - z. B. durch die Erstellung Aufzeichnungen über synthetische Eltern, Adressen oder Beiträge in sozialen Medien um eine Hintergrundgeschichte auszubauen[49]. Die Bostoner Fed stellte fest, dass Gen AI sogar Folgendes produzieren kann gefälschte Audio- und Videoaufnahmen einer gefälschten Person - Ein synthetischer Benutzer könnte zum Beispiel in einem Selfie-Verifizierungsvideo "erscheinen", komplett mit einzigartigem Gesicht und Stimme, alles KI-generiert[50].

Zweitens: KI hilft Betrügern aufstocken ihre Operationen. Anstatt jeweils nur eine oder zwei Identitäten zu fälschen, können sie programmgesteuert Hunderte oder Tausende von kompletten Identitätspaketen erstellen und neue Kontoanträge massenweise automatisch ausfüllen[51][52]. Einige Dark-Web-Dienste bieten tatsächlich "Synthetische Identitäten als Dienstleistung"und nutzen die Automatisierung, um verifizierte Konten für den Verkauf zu erstellen. Während der COVID-19-Pandemie-Hilfsprogramme setzten Kriminelle beispielsweise Bots mit KI-generierten Identitäten ein, um massenhaft Kredite und Sozialleistungen zu beantragen und das System mit gefälschten Antragstellern zu überschwemmen. Juniper Research geht davon aus, dass die globalen Kosten des digitalen Identitätsbetrugs (der durch diese Taktiken angeheizt wird) Anstieg 153% bis 2030 im Vergleich zu 2025[53].

Verteidigungsmaßnahmen - Identitätsüberprüfung in einer KI-Welt: Herkömmliche Methoden zum Identitätsnachweis haben es schwer gegen KI-gestützte Fälschungen. Um sich anzupassen, setzen Unternehmen auf mehrschichtige Identitäts- und Verhaltensüberprüfung unterstützt durch KI. Eine wichtige Ebene ist die fortgeschrittene Dokumenten- und Bildforensik. Zum Beispiel, TruthScans AI-Bild-Detektor und Detektor für gefälschte Dokumente bieten die Möglichkeit, hochgeladene IDs, Selfies oder Dokumente auf Anzeichen von Synthese oder Manipulation zu analysieren. Diese Tools untersuchen Artefakte auf Pixelebene, Unstimmigkeiten bei der Beleuchtung und Metadaten, um festzustellen, ob ein Bild KI-generiert oder manipuliert ist. Sie können subtile Hinweise erkennen - wie identische Hintergrundmuster von GAN-generierten Fotos oder Schriftarten und Abstände auf einem Ausweis, die mit keiner bekannten Regierungsvorlage übereinstimmen. Durch den Einsatz solcher Detektoren beim Onboarding können Banken den Führerschein oder das Selfie eines Bewerbers automatisch als wahrscheinlich KI-generiert kennzeichnen (das System von TruthScan hätte beispielsweise den gefälschten Militärausweis gekennzeichnet, der im Kimsuky APT-Phishing-Fall verwendet wurde[5]). Laut einer Pressemitteilung von TruthScan wurde ihre Plattform von Finanzinstituten zur Überprüfung der Echtheit von Dokumenten in großem Maßstab eingesetzt, wobei sie Fälschungen mit extrem hoher Genauigkeit identifiziert haben[54].

Eine weitere Ebene ist Verhaltensanalytik und Querverweisprüfungen. Echte Identitäten haben Tiefe - jahrelange Geschichte, öffentliche Aufzeichnungen, Aktivitäten in sozialen Medien usw. KI-generierten Identitäten, egal wie ausgefeilt sie sind, fehlt oft diese Tiefe. Banken und Kreditgeber nutzen inzwischen KI, um Antragsdaten mit öffentlichen und unternehmenseigenen Daten abzugleichen: Weisen die Telefonnummer und die E-Mail dieser Person eine Nutzungshistorie auf? Ergibt die Geolokalisierung des Geräts oder der IP-Adresse einen Sinn? Werden die Daten in den Formularen von Menschen eingegeben oder werden sie kopiert (wie es Bots tun)? KI-Modelle können trainiert werden, um echtes Kundenverhalten von synthetischen Mustern zu unterscheiden. Die Federal Reserve stellte fest, dass "Synthetische Identitäten sind oberflächlich, und KI kann das erkennen". - KI-basierte Überprüfung kann schnell nach dem digitalen Fußabdruck einer Identität suchen und Alarm schlagen, wenn wenig oder gar nichts gefunden wird[55]. In der Praxis setzen Identitätsüberprüfungsdienste inzwischen KI ein, die prüft, ob das Selfie eines Nutzers mit früheren Fotos übereinstimmt (um Gesichtsvertauschungen zu erkennen), und die den Nutzer sogar auffordert, während der Echtheitsprüfung nach dem Zufallsprinzip zu handeln (z. B. bestimmte Posen oder Phrasen), wodurch es für Fälschungen schwieriger wird, korrekt zu reagieren[56][57].

Endlich, kontinuierliche Überwachung des Kontoverhaltens nach dem Onboarding hilft, synthetische Konten zu erkennen, die durchgerutscht sind. Da diese Konten nicht mit einer realen Person verknüpft sind, fallen ihre Nutzungsmuster oft irgendwann auf (z. B. perfekt getimte Transaktionen, um Guthaben aufzubauen und dann das Maximum zu erreichen). KI-gestützte Betrugsüberwachung (wie die Plattformen von Sift oder Feedzai) kann Anomalien in der Nutzung von Konten erkennen und potenzielle synthetische Konten zur Überprüfung markieren. Zusammenfassend lässt sich sagen, dass die Bekämpfung von KI-gestütztem Identitätsbetrug Folgendes erfordert KI-gestützte Identitätsüberprüfung - eine Kombination aus Dokumentenforensik, biometrischen Prüfungen, Datenkorrelation und Verhaltensanalyse. Die gute Nachricht ist, dass die gleichen KI-Fortschritte, die den Betrug ermöglichen, auch zur Aufdeckung von Betrug eingesetzt werden. TruthScan zum Beispiel bietet eine Identitätsüberprüfungs-Suite die Text-, Bild- und Sprachanalyse zur Überprüfung neuer Benutzer integriert. Durch den Einsatz dieser Tools konnte eine große Bank einen deutlichen Rückgang der erfolgreichen synthetischen Kontoeröffnungen feststellen, obwohl der Branchendurchschnitt anstieg. Das Wettrüsten geht weiter, aber die Verteidiger lernen, die schwachen "digitalen Spuren" eines Betrügers zu erkennen, egal wie gut die KI versucht, ihre Spuren zu verwischen.

Integration von KI-Erkennung in den Sicherheitsstapel

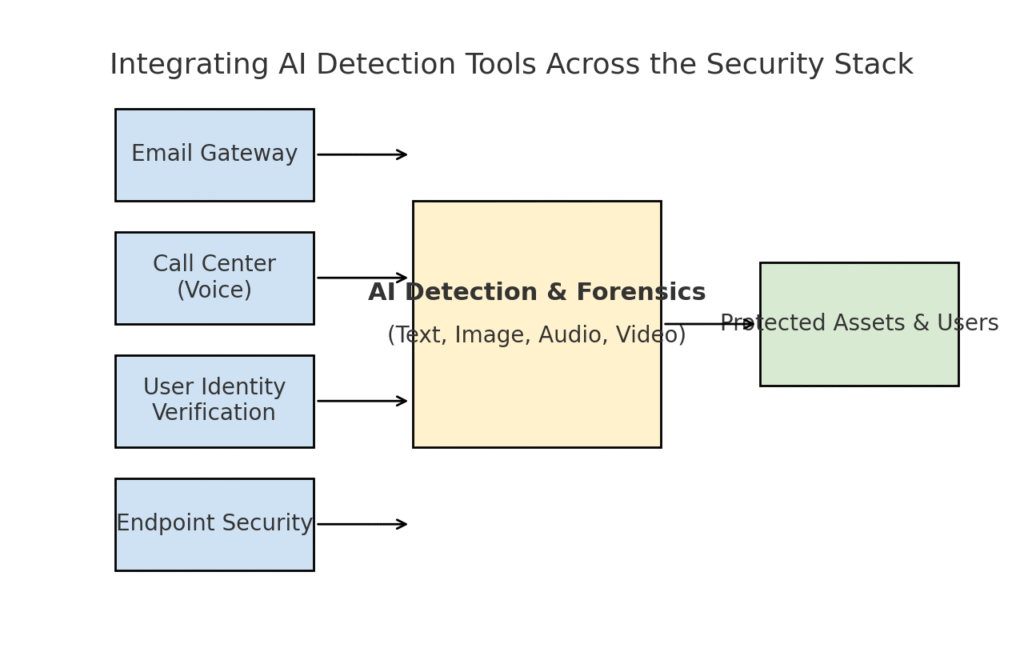

Wir haben mehrere verschiedene Bedrohungsbereiche untersucht - Phishing, Deepfakes, Malware, synthetischer Betrug - die alle durch KI verstärkt werden. Es ist klar, dass kein einziges Werkzeug oder eine einmalige Lösung wird die Herausforderung lösen. Stattdessen brauchen die Unternehmen eine umfassende Strategie, um KI-gestützte Erkennung und Überprüfung auf jeder Ebene einbetten ihres Cybersicherheits-Stacks. Der Ansatz muss die Angriffsfläche widerspiegeln und E-Mail, Web, Sprache, Dokumente, Identität und mehr abdecken. Das folgende Diagramm veranschaulicht, wie Unternehmen die KI-Erkennungstools von TruthScan (und ähnliche Lösungen) in die gängigen Sicherheitsebenen des Unternehmens integrieren können:

Integration von KI-Erkennungstools auf mehreren Ebenen des Sicherheitsstapels - von E-Mail-Gateways und Call-Centern bis hin zu Benutzerüberprüfung und Endpunktschutz. Die KI-Inhaltserkennung (Mitte) analysiert Text, Bilder, Audio und Video in Echtzeit und leitet daraus Durchsetzungsmaßnahmen zum Schutz von Ressourcen und Benutzern ab.

In diesem Modell, Multimodale AI-Detektoren wirken wie ein zentrales Gehirn die Schnittstellen zu verschiedenen Sicherheitskontrollen hat:

- E-Mail-Gateways: Eingehende E-Mails durchlaufen einen KI-Text-/Betrugsdetektor, bevor sie den Posteingang erreichen. Dies steht im Zusammenhang mit der besprochenen Phishing-Abwehr - z. B. mit TruthScans E-Mail-Betrugsdetektor über API bei Ihrem E-Mail-Anbieter, um verdächtige, von der KI generierte E-Mails automatisch unter Quarantäne zu stellen[18]. Es kann auch auf Messaging-Plattformen (Chat-Apps, SMS-Gateways) angewendet werden, um Inhalte auf Phishing- oder Betrugsmuster zu prüfen.

- Callcenter und Sprachsysteme: Telefon- und VOIP-Kanäle werden durch die Integration von Sprachfälschungserkennung gesichert. So könnte zum Beispiel der Kundensupport einer Bank TruthScans AI-Sprachdetektor Analyse der Audiodaten eingehender Anrufer in Echtzeit und Alarmierung, wenn der Stimmabdruck eines Anrufers synthetisch ist oder nicht mit dem bekannten Profil des Anrufers übereinstimmt[58][59]. Dies trägt dazu bei, dass Vishing- und Voice-Impersonation-Angriffe (wie gefälschte CEO-Anrufe) nicht erfolgreich sind.

- Verfahren zur Überprüfung der Benutzeridentität: Bei der Kontoerstellung oder bei risikoreichen Benutzeraktionen (Zurücksetzen von Passwörtern, Überweisungen) wird eine KI-gesteuerte Identitätsprüfung durchgeführt. Eine hochgeladene Foto-ID wird von einem Bildforensik-Tool überprüft (z. B. ob es sich um ein KI-generiertes Foto oder ein Foto eines Fotos handelt), und ein Selfie oder ein Videoanruf wird von einem Deepfake-Detektor überprüft. TruthScan's Deepfake-Detektor kann hier zur Gesichtsauthentifizierung verwendet werden, um sicherzustellen, dass die Person auf der Kamera echt ist und mit der ID übereinstimmt.[60][61]. Verhaltenssignale (Tipprhythmus, Gerätekonsistenz) können auch in KI-Modelle eingespeist werden, um Bots oder synthetische Identitäten zu erkennen.

- Endgeräte und Netzwerk: Endpunkt-Sicherheitsagenten und Proxy-Server können eine KI-Inhaltsanalyse für Dateien und Skripte integrieren. Wenn ein Endpunkt-EDR beispielsweise ein neues Skript oder eine EXE ausführt, könnte er den Textinhalt der Datei an einen KI-Detektor senden, um zu prüfen, ob er bekannter KI-generierter Malware ähnelt oder Merkmale von verschleiertem KI-Code aufweist. In ähnlicher Weise könnten DLP-Systeme (Data Loss Prevention) die KI-Texterkennung nutzen, um sensiblen Text zu markieren, der von KI generiert wurde (was darauf hindeuten könnte, dass ein Insider KI nutzt, um Nachrichten zur Datenexfiltration zu verfassen oder Berichte zu fälschen). TruthScan's Real-Time-Detektor ist so konzipiert, dass es sich in solche Arbeitsabläufe einfügt und eine Live-Analyse von Inhalten über verschiedene Plattformen hinweg mit automatischen Reaktionsmöglichkeiten bietet.[42][62] (z. B. automatisches Sperren einer Datei oder Nachricht, wenn sie als KI-generierte Malware oder Desinformation erkannt wird).

Die Hauptvorteil dieses integrierten Ansatzes ist Geschwindigkeit und Konsistenz. KI-Angriffe sind schnell - Phishing-E-Mails, gefälschte Stimmen und synthetische Daten können viele Kanäle auf einmal treffen. Wenn ein Unternehmen all diese Kanäle mit KI-Erkennung ausstattet, erhält es Echtzeit-Transparenz und eine tiefgreifende Verteidigung. Ein Team beschrieb dies als Schaffung eines "KI-Immunsystems" für sein Unternehmen: Wann immer etwas kommuniziert wird (sei es eine E-Mail, ein Dokumenten-Upload, ein Sprachanruf usw.), "schnüffelt" das KI-Immunsystem nach fremden (KI-generierten) Signaturen und neutralisiert es, wenn es sich als schädlich erweist.

Die Unternehmenssuite von TruthScan ist ein Beispiel dafür, denn sie bietet eine einheitliche Plattform für Text-, Bild-, Audio- und Video-KI-Erkennung, die modular oder als Ganzes eingesetzt werden kann[63][64]. Viele Unternehmen beginnen mit der Implementierung von ein oder zwei Funktionen (z. B. Texterkennung in E-Mails und Bilderkennung beim Onboarding) und erweitern diese dann, sobald sie den Wert erkannt haben. Wichtig ist, dass die Integration entwicklerfreundlich gestaltet ist - TruthScan und ähnliche Dienste stellen APIs und SDKs zur Verfügung, so dass Sicherheitsteams die Erkennung in bestehende Systeme einbinden können, ohne diese massiv umzugestalten. Egal, ob es sich um ein SIEM, ein E-Mail-Gateway, eine benutzerdefinierte Banking-App oder ein CRM-System handelt, die Erkennung kann im Hintergrund ablaufen und Warnmeldungen oder automatische Aktionen auslösen. So hat beispielsweise eine große Social-Media-Plattform APIs zur Inhaltsmoderation integriert, um Deepfake-Videos innerhalb von Minuten nach dem Hochladen automatisch zu entfernen.[65][66]um die Verbreitung von KI-generierten Fehlinformationen zu verhindern.

Schlussfolgerung: Der Kurve immer einen Schritt voraus

Die schnelle Verbreitung von KI-gesteuerten Bedrohungen im Jahr 2025 stellt Unternehmen vor neue Herausforderungen. Angreifer haben Mittel und Wege gefunden, menschliches Vertrauen in großem Umfang auszunutzen - sie geben sich als Stimmen und Identitäten aus, automatisieren Social Engineering, umgehen Verteidigungsmaßnahmen durch adaptiven Code und fabrizieren ganze falsche Realitäten. Das ist eine entmutigende Aussicht für Verteidiger, aber keine aussichtslose. So wie sich Kriminelle die KI zunutze machen, können auch wir die KI auf die Seite der Sicherheit ziehen. Das Aufkommen von KI-Inhaltserkennung, Deepfake-Forensik und Scanner für synthetische Identitäten gibt uns die Möglichkeit, diesen neuen Bedrohungen wirksam entgegenzutreten. Durch den Einsatz dieser Werkzeuge und sie über alle Ebenen hinweg zu integrieren können Unternehmen das Risiko von KI-gestützten Angriffen drastisch verringern. Erste Anwender haben bereits Betrugsversuche im Wert von mehreren Millionen Dollar vereitelt, indem sie Deepfakes auf frischer Tat ertappt haben[26]oder verhinderte Phishing-Katastrophen durch das Herausfiltern von KI-gestützten E-Mails.

Über die Technologie hinaus sollten Unternehmen eine Kultur des "Vertrauens, aber überprüfe" kultivieren. Mitarbeiter sollten sich darüber im Klaren sein, dass im Zeitalter der KI Sehen (oder Hören) nicht immer Glauben bedeutet - eine gesunde Skepsis gepaart mit Überprüfungsabläufen kann viele Social-Engineering-Methoden stoppen. Schulung und Bewusstsein, kombiniert mit automatisierte Prüfwerkzeuge wie TruthScanbilden eine gewaltige Verteidigung. In gewisser Weise müssen wir die Messlatte für die Authentifizierung und Validierung von Informationen höher legen. Digitale Mitteilungen und Dokumente können nicht mehr für bare Münze genommen werden; ihre Herkunft muss überprüft werden, entweder maschinell oder durch Verfahren.

Es ist zu erwarten, dass die Angreifer ihre KI-Taktiken weiter verfeinern werden, aber auch, dass die KI-Abwehr weiterhin innovativ bleibt. Das Katz-und-Maus-Spiel wird weitergehen. Der Erfolg von Verteidigern wird davon abhängen Agilität und Informationsaustausch. Diejenigen, die neue Bedrohungsdaten (z. B. neuartige Deepfake-Erkennungstechniken oder aktualisierte KI-Modellsignaturen) schnell einbeziehen, werden den Angreifern, die die neuesten KI-Tools einsetzen, einen Schritt voraus sein. Die Zusammenarbeit zwischen Industrie, Wissenschaft und Regierung wird in diesem Kampf ebenfalls von entscheidender Bedeutung sein, wie die Warnungen und Rahmenwerke von Behörden wie dem AI Risk Management Framework des NIST und die Zusammenarbeit zwischen Banken bei der Erkennung von KI-Betrug zeigen.

Abschließend lässt sich sagen, dass sich die Cybersicherheitsbranche inmitten eines KI-gesteuerten Paradigmenwechsels befindet. Die Bedrohungen sind anders als noch vor einem Jahrzehnt, aber wir begegnen ihnen mit ebenso beispiellosen Abwehrmaßnahmen. Mit einer Kombination aus fortschrittlicher Erkennungstechnologie und robuster Sicherheitsstrategie können wir kann die Risiken der generativen KI zu mindern und sie sogar zu unserem Vorteil zu nutzen. Mit Tools wie der KI-Erkennungssuite von TruthScan können wir Wiederherstellung des Vertrauens in einer Welt des Null-Vertrauens - um sicherzustellen, dass die Person am anderen Ende der Leitung echt ist, dass das Dokument in unserem Posteingang authentisch ist und dass der in unserem Netzwerk laufende Code nicht von einer bösartigen KI manipuliert wurde. Wenn Unternehmen jetzt in diese Fähigkeiten investieren, können sie sich nicht nur vor den heutigen KI-gestützten Angriffen schützen, sondern auch die Widerstandsfähigkeit gegen die sich entwickelnden Bedrohungen von morgen aufbauen. Die Schlussfolgerung ist klar: Die KI mag Cyberangriffe verstärken, aber mit dem richtigen Ansatz kann sie auch unsere Verteidigung verstärken.

Quellen: Relevante Daten und Beispiele stammen aus 2025 Berichten über Bedrohungsdaten und von Experten, darunter die Cyber Incident Trends von Mayer Brown.[1][67]Fortinets Übersicht über die Bedrohungen 2025[2][19]Barracuda-Forschung zu KI-E-Mail-Angriffen[6][7]Der KI-Bedrohungsbericht von Google GTIG[34]Boston Federal Reserve: Erkenntnisse über synthetischen Betrug[45][50]und TruthScan's veröffentlichte Fallstudien und Presseberichte[30][26]und andere. Sie veranschaulichen das Ausmaß von KI-gesteuerten Bedrohungen und die Wirksamkeit von KI-gestützten Gegenmaßnahmen in realen Szenarien. Indem wir aus solchen Erkenntnissen lernen und modernste Tools einsetzen, können wir das Zeitalter der KI-gestützten Cyberrisiken mit Zuversicht meistern.

[1] [67] 2025 Cyber Incident Trends Was Ihr Unternehmen wissen muss | Insights | Mayer Brown

[2] [3] [19] Top-Cybersicherheitsstatistiken: Fakten, Statistiken und Sicherheitsverletzungen für 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] KI-gesteuerter Betrug bei Finanzdienstleistungen: Aktuelle Trends und Lösungen | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan entdeckt nordkoreanischen Deepfake-Angriff auf Verteidigungsbeamte - Bryan County Magazine

[6] [7] [14] Die Hälfte des Spams in Ihrem Posteingang wird von KI generiert - ihr Einsatz bei fortgeschrittenen Angriffen ist in einem frühen Stadium | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Q2 2025 Digitaler Vertrauensindex: KI-Betrugsdaten und Einblicke | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] KI-Bedrohungen für die Cybersicherheit 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Neueste Bedrohungsdaten | TruthScan

[18] [63] [64] TruthScan - KI-Erkennung und Content-Sicherheit für Unternehmen

[23] [46] [56] [57] Deepfakes und Einlagen: Wie man den generativen KI-Betrug bekämpft

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-Angriffe und KI-generiertes Phishing: Statistik für 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI-Stimmdetektor für Deepfakes & Stimmenklonen | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifizieren Sie gefälschte & AI Videos - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Fortschritte bei der Nutzung von KI-Tools durch Bedrohungsakteure | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hacker verschleiern Malware mit ausführlichem KI-Code

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] AI-Detektion in Echtzeit - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI-Operatoren verwenden KI-generierten Code und gefälschte Apps für ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI steigert die Bedrohung durch synthetischen Identitätsbetrug - Federal Reserve Bank of Boston

[53] Synthetischer Identitätsbetrug 2025: AI-Erkennungs- und Präventionsstrategien