Der Versicherungsbetrug tritt in eine neue Ära ein, die von künstlicher Intelligenz angetrieben wird. Sowohl ausgeklügelte Betrügerringe als auch Einzelbetrüger nutzen generative KI-Tools, um gefälschte Ansprüche, synthetische Identitäten, gefälschte Beweise und äußerst überzeugende Betrugsversuche durch Nachahmung zu produzieren. Dieses Whitepaper untersucht die neuesten 2025 Trends bei KI-gesteuertem Versicherungsbetrug - von KI-generierten Ansprüchen und Dokumenten bis hin zu gefälschten Stimmen - und zeigt auf, wie Versicherer reagieren können. Wir präsentieren aktuelle Daten, reale Fälle und strategische Erkenntnisse für Underwriter, Betrugsermittler, Cybersecurity-Teams, Schadenmanager und Führungskräfte, die diese sich schnell entwickelnde Bedrohungslandschaft verstehen müssen.

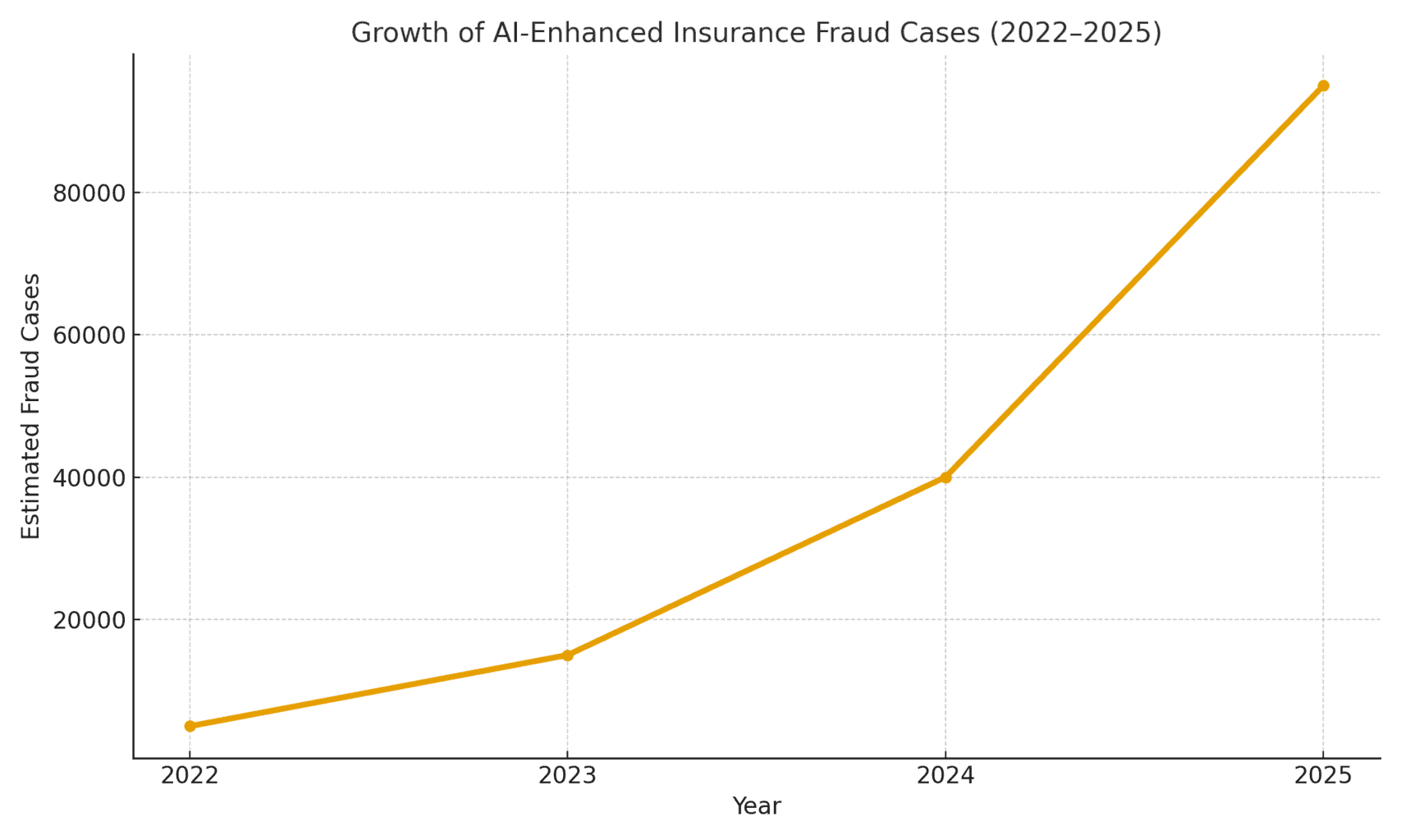

Das Ausmaß der Bedrohung: Der durch KI ermöglichte Betrug nimmt stark zu. Ein Bericht über forensische Buchhaltung aus dem Jahr 2025 ergab, dass KI-gesteuerte Betrügereien machen inzwischen mehr als die Hälfte aller digitalen Finanzbetrügereien aus[1]. In der Versicherungsbranche beobachtete das Sprachsicherheitsunternehmen Pindrop eine 475% Anstieg der Angriffe auf Versicherungsunternehmen durch synthetische Stimmen im Jahr 2024und trugen zu einem Anstieg der Versicherungsbetrugsversuche um 19% im Vergleich zum Vorjahr bei[2]. Die Versicherer müssen etwa 20-mal höheres Betrugsrisiko als Bankenzum Teil aufgrund des starken Rückgriffs auf Dokumente, Bilder und Sprachnachweise bei Schadensfällen[3]. Die nachstehende Abbildung 1 veranschaulicht das explosive Wachstum von KI-gestützten Versicherungsbetrugsfällen von 2022 bis 2025, da mehrere Branchenberichte einen drei- oder vierstelligen prozentualen Anstieg der festgestellten KI-Betrugsfälle im Vergleich zum Vorjahr angeben.

Abbildung 1: Rascher Anstieg von KI-gestützten Versicherungsbetrugsfällen (indiziertes Wachstum 2022-2025). Branchendaten deuten auf einen exponentiellen Anstieg von KI-generierten Inhalten in betrügerischen Schadensfällen hin, insbesondere ab 2023.[4][2]

KI-generierte Behauptungen und gefälschte Beweise

Einer der am weitesten verbreiteten Trends ist der Einsatz generativer KI zur Erstellung von vollständig erfundene Versicherungsansprüche. Mit fortschrittlichen KI-Textgeneratoren können Betrüger auf Knopfdruck realistische Unfallbeschreibungen, medizinische Berichte oder polizeiliche Aussagen verfassen. Diese von der KI verfassten Erzählungen lesen sich oft ausgefeilt und plausibel, so dass es für Schadensregulierer schwieriger ist, Ungereimtheiten zu erkennen. So haben Betrüger ChatGPT genutzt, um detaillierte Unfallbeschreibungen oder Verletzungsberichte zu verfassen, die professionell und überzeugend klingen - eine Aufgabe, die früher viel Mühe und Schreibkenntnisse erforderte.

Noch besorgniserregender ist, dass Kriminelle diese gefälschten Erzählungen nun mit AI-generierte Nachweise. Bilderzeugungsmodelle (wie Midjourney oder DALL-E) und Bearbeitungswerkzeuge können fotorealistische Fotos von Schäden und Verletzungen erstellen. Berichten der Branche zufolge haben einige Fahrer damit begonnen Einreichung von KI-generierten Bildern zur Übertreibung von Fahrzeugschäden bei Autoschäden[5]. Generative KI kann ein Foto eines Autowracks oder eines überschwemmten Hauses erstellen, das es in Wirklichkeit nie gab. Diese Bilder sind oft realistischer als das, was ältere Photoshop-Techniken erreichen konnten[6]Dadurch sind sie mit dem bloßen Auge schwer zu erkennen. Im April 2025 verzeichnete die Zurich Versicherung einen Anstieg der Schäden mit gefälschte Rechnungen, gefälschte Reparaturkostenvoranschläge und digital veränderte Fotoseinschließlich der Fälle, in denen KI-Kennzeichen wurden in Bilder von Schrottautos eingefügt[7][8]. Solche gefälschten Beweise können, wenn sie mit einem gut ausgearbeiteten KI-Antragsformular kombiniert werden, an manuellen Überprüfungen vorbeigehen.

In einem aufsehenerregenden Fall im Vereinigten Königreich haben Betrüger eine Social-Media-Foto eines Lieferwagens eines Handwerkers und Verwendung von KI, um eine zerbrochene Stoßstange hinzuzufügenund reichte sie dann zusammen mit einer gefälschten Reparaturrechnung über 1.000 Pfund als Teil einer falschen Unfallforderung ein.[9]. Der Betrug wurde erst aufgedeckt, als die Ermittler die dieselbe Foto des Lieferwagens (vor der Beschädigung) auf der Facebook-Seite des Eigentümers[10]. Dies veranschaulicht ein breiteres Phänomen: Die Versicherer melden eine 300% Sprung in den "shallowfake"-Bildbearbeitungen (einfache digitale Manipulationen, um Schäden hinzuzufügen oder Details zu verändern) in nur einem Jahr (2021-2022 gegenüber 2022-2023)[4]. Die Allianz UK warnte 2024, dass digitale Fotoverfälschungen und gefälschte Dokumente "alle Anzeichen dafür haben, der neueste große Betrug in der Branche zu werden".[4]. Auch der Leiter der Abteilung für Schadensbetrug der Zürich stellte fest, dass was früher die Inszenierung eines physischen Autounfalls erforderte, kann heute vollständig am Computer erledigt werden - Betrüger können mit gefälschten Fotos und Berichten über Totalschäden "hinter der Tastatur einen betrügerischen Antrag stellen und beträchtliche Summen herausholen".[11][12]. Diese Verlagerung erhöht nicht nur das Volumen der gefälschten Ansprüche, sondern senkt auch die Einstiegshürde für potenzielle Betrüger.

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

Jenseits von Autos, Sach- und Unfallschäden sehen eine KI-gestützte Aufblähung von Schäden. Es gibt Berichte über gefälschte Fotos für Reiseversicherungen (z. B. "Gepäckschäden" oder inszenierte Diebstahlszenen) und KI-generierte Quittungen für teure Gegenstände, die nie gekauft wurden. Ansprüche auf Leben und Gesundheit sind auch nicht immun - Betrüger haben gefälschte Arztrechnungen und Sterbeurkunden mit KI-Dokumentenfälschern. Tatsächlich hat Zurich festgestellt, dass die Deepfake-Technologie verwendet wird, um völlig fiktive Ingenieursbewertungen und medizinische Berichte in Schadenpaketen[11]. Diese KI-generierten Dokumente, die oft mit realistischen Logos und Unterschriften versehen sind, können von echten Papieren nicht unterschieden werden. Ein neues Problem für Lebensversicherer ist Betrug mit Todesanzeigen und SterbeurkundenKriminelle können mithilfe von KI gefälschte Todesanzeigen oder Arztbriefe erstellen, um den Tod einer Person zu belegen, die in Wirklichkeit noch am Leben ist (oder nie existiert hat, wie im Folgenden erläutert wird).

Synthetische Versicherungsnehmer und Identitäten

Die vielleicht heimtückischste Entwicklung ist Betrug mit synthetischer Identität in der Versicherung. Bei synthetischem Identitätsbetrug wird eine fiktive Person oder Einrichtung geschaffen, indem echte Daten (gestohlene Sozialversicherungsnummern, Adressen usw.) mit erfundenen Details (gefälschte Namen, gefälschte Ausweisdokumente) kombiniert werden. Dank der Fortschritte in der Künstlichen Intelligenz (KI) ist es jetzt ganz einfach, eine realistische persönliche Profile - einschließlich Fotos und IDs - für Personen, die nicht existieren[13][14]. Betrüger können nun algorithmisch einen völlig falschen Kunden erzeugen, eine Police in dessen Namen abschließen und später Ansprüche oder Versicherungsleistungen für diese falsche Identität geltend machen.

Im Lebensversicherungssektor haben synthetische Identitätssysteme in die Höhe geschossen. Industrieforschung im Jahr 2025 schätzt die Kosten für synthetischen Identitätsbetrug über $30 Milliarden jährlichmit einem Anteil von bis zu 80-85% aller Fälle von Identitätsbetrug über Finanzdienstleistungen[15][16]. Lebensversicherer sind besonders stark betroffen: Gauner sind dafür bekannt, dass sie Lebensversicherungspolicen für eine fiktive Person abschließen und diese Person dann auf dem Papier "umbringen", um die Todesfallleistung zu kassieren[17]. Ein Betrüger könnte zum Beispiel einen synthetischen Kunden "John Doe" anlegen, ein Jahr lang Prämien zahlen und dann einen Antrag mit einer gefälschten Sterbeurkunde und Todesanzeige für John Does vorzeitiges Ableben einreichen. Da die Identität sorgfältig aufgebaut wurde (Kreditgeschichte, öffentliche Aufzeichnungen usw.), kann der Antrag auf Todesfall legitim erscheinen - bis kein tatsächlicher Leichnam oder echte Verwandte gefunden werden können. Wenn der Betrug aufgedeckt wird, sind die Täter mit der Auszahlung schon lange weg.

Synthetische Identitätssysteme sind auch eine Plage Krankenversicherung und Autoversicherung. Verbrecherringe schaffen "Frankenstein"-Identitäten durch Verwendung der Sozialversicherungsnummern von Kindern oder älteren Menschen (die keine Kredithistorie haben) in Kombination mit KI-generierten Namen und Führerscheinen[15]. Sie haben dann Krankenversicherungen oder Kfz-Policen für diese gefälschten Personen kaufen und kurz darauf hohe Schadensersatzforderungen stellen. Eine Variante ist die Gründung von Syndikaten gefälschte Unternehmen (Mantelgesellschaften) - z. B. ein Schein-Lkw-Unternehmen, für das eine Versicherung abgeschlossen wird, um später Ansprüche wegen vorgetäuschter Unfälle oder vorgetäuschter Verletzungen von Mitarbeitern geltend zu machen[18][19]. Da das Unternehmen nur auf dem Papier existiert (mit KI-generierten Gewerbeanmeldungen und Steuer-IDs), ist dies "Synthetischer Betrug auf der Grundlage von Entitäten oft erst nach der Auszahlung der Schäden aufgedeckt wird[18][20].

Warum sind synthetische Identitäten so effektiv? Zum einen kommen sie oft durch automatische Identitätsüberprüfungen. Kreditbüros und KYC-Systeme finden möglicherweise keine roten Fahnen weil die Identität einige echte, gültige Daten enthält (z. B. eine echte SSN mit einem sauberen Eintrag)[21]. Inzwischen können von der KI generierte Profilfotos und Ausweisscans völlig authentisch aussehen - die heutige KI kann ein menschliches Gesicht erzeugen, das selbst eine fortgeschrittene Gesichtserkennung als echt akzeptieren könnte. Das Ergebnis: Die meisten automatischen Systeme erkennen diese Profile als rechtmäßig. und der Betrug wird (wenn überhaupt) erst nach großen Verlusten aufgedeckt[22].

Auswirkungen in der realen Welt: RGA berichtet, dass Synthetischer Identitätsbetrug bei Lebensversicherungen kostet die Branche inzwischen rund $30B pro Jahr und ist seit 2020 um fast 400% gewachsen[15][16]. Die U.S. Federal Trade Commission schätzt, dass die überwiegende Mehrheit der Fälle von Identitätsbetrug auf synthetische IDs zurückzuführen ist[16]. Diese Verluste treffen letztendlich die Geldbörsen der ehrlichen Versicherungsnehmer - jede Familie zahlt jedes Jahr schätzungsweise 700 Euro mehr an Prämien, weil die Versicherer mehr Betrug begehen[15]. Die Versicherer reagieren darauf, indem sie die Überprüfungen bei der Aufnahme und bei der Schadensregulierung verstärken: Sie führen Datenbanküberprüfungen für die Identitätsverknüpfung durch, überwachen mehrere Policen an derselben Adresse und führen sogar "Liveness"-Tests durch (Selfie-Videoprüfungen, um sicherzustellen, dass es sich bei einem Antragsteller um eine echte Person und nicht nur um ein KI-Bild handelt).[23][24]. Aber wie wir sehen werden, kontern die Betrüger mit KI in der nächsten Arena: gefälschte Stimmen und Videos.

Deepfake-Stimmen und Video-Behauptungen

KI-generiert Audio- und Video-Deepfakes fügen dem Versicherungsbetrug eine alarmierende neue Dimension hinzu. In den Jahren 2023 und 2024 gab es mehrere Vorfälle, bei denen Kriminelle Stimmenklonen Eine Taktik, die ursprünglich bei Banküberfällen angewandt wurde (z. B. der berüchtigte Deepfake-CEO-Anruf, bei dem im Jahr 2020 $35 Millionen gestohlen wurden), sich nun aber auch auf Versicherungen ausweitet. Betrüger klonen die Stimmen von Versicherungsnehmern, Ärzten oder Schadensregulierern und nutzen sie für Social Engineering-Betrügereien. Die Pindrop-Analyse von 2024 warnt, dass "Deepfakes, synthetische Sprachtechnologien und KI-gesteuerte Betrügereien verändern die Betrugslandschaft".mit Sprachbetrug Skalierung in einem noch nie dagewesenen Tempo[25]. Sie fanden heraus, dass Versicherungs-Callcenter von bösartigen Akteuren aus dem Ausland mit gefälschten Stimmen bombardiert wurden: So gingen beispielsweise Anrufe mit der gestohlenen SSN und den persönlichen Daten eines echten Versicherungsnehmers ein, und wenn ein Mitarbeiter antwortete, wurden die die KI-geklonte Stimme des Anrufers könnte den Agenten durch wissensbasierte Authentifizierung austricksen und beantragen eine betrügerische Auszahlung[26]. Im Fall eines Versicherers an der Westküste versuchten Angreifer mit dieser Methode wiederholt, Konten zu übernehmen und Auszahlungen umzuleiten, wobei sie die Tatsache ausnutzten, dass die ID-Verifizierung im Callcenter auf Stimme und persönlichen Daten beruhte, die gefälscht werden können[26].

Auch auf der Verbraucherseite wurden Stimmenimitatoren eingesetzt: Betrüger haben Unfallopfer oder Begünstigte angerufen, während die sich als Versicherungsvertreter ausgebenSie verwenden KI-Stimmen, die offiziell klingen, um sensible Informationen oder sogar Zahlungen zu ergaunern. Umgekehrt könnte sich ein Betrüger bei einer Schadenersatz-Hotline als Kunde ausgeben, um eine telefonische Reklamation mit einer falschen Stimme einreichen, die dem Geschlecht/Alter des Kunden entsprichtund umgehen so die stimmbiometrischen Kontrollen. Die jüngsten Betrugsstatistiken sind ernüchternd: Branchenexperten rechnen mit einem 162% Zunahme von Betrugsangriffen gegen Versicherer mit gefälschten Daten im kommenden Jahr[27]und Pindrop verzeichnete eine 475%-Spitze bei Angriffen auf synthetische Sprache im Jahr 2024 wie bereits erwähnt[2]. Diese Angriffe übertreffen schnell die traditionellen Cyberbetrugsmethoden.

Jenseits von Telefonanrufen, videobasierte Deepfakes in der Schadenbearbeitung entstehen. Viele Versicherer haben virtuelle Schadenbesichtigungen und Videokonferenzen eingeführt (was durch die Pandemie beschleunigt wurde), um Schäden zu überprüfen oder Antragsteller aus der Ferne zu befragen. Jetzt sind die Betrüger Nutzung von KI-Avataren und gefälschten Videos zur Täuschung dieser Überprüfungen. Es gibt Berichte über Antragsteller, die KI-generierte Avatare bei Live-Videoanrufen mit Einstellern, um sich als jemand anderes auszugeben oder Anzeichen von Ungereimtheiten zu verbergen[28]. Ein Betrügerring könnte zum Beispiel einen Deepfake verwenden "Live"-Video eines vermeintlichen Geschädigten, der seinen Schaden per Smartphone zeigtwenn es sich bei der Person vor der Kamera in Wirklichkeit um ein KI-synthetisiertes Kompositum oder einen angeheuerten Schauspieler mit gesichtsverändernden Filtern handelt. Ein spekulatives, aber plausibles Szenario ist die Verwendung eines Deepfake einer verstorben Person: Bei einem Renten- oder Lebensversicherungsbetrug könnte ein Familienmitglied ein gefälschtes Video des kürzlich Verstorbenen während eines routinemäßigen Anrufs zum Nachweis des Todes verwenden, um weiterhin Auszahlungen zu erhalten.[29]. Obwohl bisher noch kein derartiger Fall bekannt geworden ist, bereiten sich die Versicherer darauf vor. Auch die Regulierungsbehörden nehmen zur Kenntnis - In den USA und in Europa wird darüber diskutiert, Deepfakes als Identitätsdiebstahl einzustufen und die Richtlinien für die Überprüfung von Beweisen im Versicherungswesen zu aktualisieren.[30].

Die Erkennung von gefälschten Videos und Audios ist ohne technische Hilfsmittel sehr schwierig. Menschliche Einsteller sind nicht darauf trainiert, subtile Lippensynchronitätsprobleme oder akustische Merkwürdigkeiten zu erkennen. In einigen Fällen gab es jedoch Warnhinweise: z. B. unnatürliches Blinzeln oder Gesichtsstörungen im Video oder Audio-Artefakte im Hintergrund eines Anrufs, die die Ermittler alarmierten. Insgesamt jedoch, Versicherungsbetrug steckt noch in den Kinderschuhenund die strafrechtliche Verfolgung ist nach wie vor selten - bis 2023 waren die rechtlichen Definitionen unklar und der Nachweis, dass ein Video durch KI generiert wurde, war ohne Expertenanalyse schwierig[31]. Dies verschafft den Betrügern ein Gefühl der Straffreiheit. Das Wettrüsten hat begonnen: Die Versicherer wenden sich nun an Forensische KI zur Bekämpfung von KIEinsatz von Algorithmen zur Erkennung von Fälschungen, um verdächtige Videos Bild für Bild auf Anzeichen von Manipulation zu untersuchen[24]. Anbieter von Stimmbiometrien bringen Deepfake-Voice-Detektoren auf den Markt, die spektrale Muster und die Kadenz der Stimme auf Authentizität analysieren[32]. Wir werden diese Abwehrtechniken in einem späteren Abschnitt erörtern.

KI-gestütztes Phishing und Betrug durch Identitätswechsel

Nicht alle KI-gestützten Betrügereien erfolgen durch die Schadensabteilung; einige Ziele sind Kunden und Mitarbeiter über Social Engineering. Phishing-E-Mails und -Texte, die von KI erstellt wurden sind zu einer großen Bedrohung für den Versicherungsbereich geworden. Dabei nutzen die Betrüger KI-Chatbots und Übersetzungstools, um äußerst überzeugende Betrugsmitteilungen zu erstellen. So können Kriminelle beispielsweise das Branding und den Schreibstil eines Versicherungsunternehmens imitieren, um massenhaft Phishing-E-Mails an Versicherungsnehmer zu versenden, in denen ihnen mitgeteilt wird, dass "dringend gehandelt werden muss, um die Kündigung der Police zu verhindern", und sie auf eine gefälschte Website geleitet werden. Im Gegensatz zu den unbeholfenen Betrugs-E-Mails der Vergangenheit, KI garantiert einwandfreie Grammatik und sogar PersonalisierungDadurch werden sie viel glaubwürdiger. Wir haben gesehen, wie KI eingesetzt wurde, um soziale Medien nach Details zu durchsuchen, die in Spear-Phishing-Nachrichten eingeflochten werden, wie z. B. die Erwähnung eines kürzlich getätigten Autokaufs in einer gefälschten Autoversicherungsmitteilung.

Ein weiterer Vektor ist KI-gestützte Imitation von Agenten oder Führungskräften. Es gab Fälle, in denen Betrüger die Stimme des Inhabers einer Versicherungsagentur nachgeahmt und Sprachnachrichten für Kunden hinterlassen haben, in denen sie um die Aktualisierung von Bankdaten baten - praktisch ein Voice-Phishing-Angriff. Auch interner Betrug kann durch KI-Imitation entstehen: Die Finanzabteilung eines Versicherers wurde beinahe zum Opfer, als Betrüger eine gefälschte Sprachnachricht verschickten Vorgeblich vom CEO Genehmigung eines Geldtransfers (eine Variante des "CEO-Betrugs", die jetzt von einigen E-Kriminalitätsversicherungen abgedeckt wird)[33]). Diese Art von KI-gesteuerten Betrügereien stieg laut Liberty Specialty Markets im Jahr 2023 um 17%[33]und werden voraussichtlich weiter steigen.

Die Verbraucher werden auch mit synthetischen Medienbetrügereien angesprochen im Zusammenhang mit Versicherungen. Die Coalition Against Insurance Fraud (Koalition gegen Versicherungsbetrug) weist auf Fälle hin, in denen sich Betrüger als Versicherungssachverständige ausgeben, die Unfallopfer kontaktieren und behaupten, sie würden ihren Schaden bearbeiten und dann sofortige Zahlung oder sensible Daten verlangen[23]. Ahnungslose Kunden, die erleichtert sind, von einem vermeintlichen Vertreter zu hören, kommen dem Angebot möglicherweise nach, vor allem, wenn der Anrufer Einzelheiten über ihren Unfall kennt (die die KI durch Hacking oder öffentliche Quellen herausfinden könnte). Das öffentliche Bewusstsein für diese Taktiken ist gering; daher fordern Experten für Betrugsbekämpfung die Versicherer auf Aufklärung der Versicherungsnehmer über die Überprüfung der Identität von Anrufern und E-Mails[23][34]. So wie Banken ihre Kunden vor Phishing warnen, beginnen auch die Versicherer im Jahr 2025 damit, Warnungen vor Deepfake-Betrug in ihre Mitteilungen aufzunehmen.

Ein gemeinsamer Nenner dieser KI-gestützten Betrugsversuche ist die Verwendung von leicht erhältlichen "Betrugs-as-a-Service"-Kits[35]. Im Dark Web können Kriminelle Tools kaufen oder abonnieren, die vorgefertigte Deepfake-Stimmen, Vorlagen für gefälschte Dokumente, Generatoren für Phishing-E-Mails und vieles mehr anbieten. Diese Demokratisierung von KI-Tools bedeutet selbst wenig qualifizierte Betrüger können ausgeklügelte Betrugsangriffe starten[35]. Für die Versicherungsunternehmen bedeutet dies eine Flut überzeugenderer Betrugsversuche, die von allen Seiten kommen - von der Schadenregulierung, dem Kundendienst, per E-Mail und sogar über soziale Medien. Dies unterstreicht die Notwendigkeit einer mehrgleisigen Verteidigungsstrategie, die Technologie, menschliche Wachsamkeit und branchenübergreifende Zusammenarbeit kombiniert.

Erkennung und Abwehr: Eine KI-gestützte Antwort

Die Bekämpfung von KI-gesteuertem Betrug erfordert KI-gesteuerte Verteidigung. Die Versicherer setzen zunehmend auf fortschrittliche Erkennungstechnologien und überarbeitete Prozesse, um dem Ansturm zu begegnen. Im Wesentlichen müssen die Versicherer Kontrollpunkte für die Inhaltsauthentifizierung im gesamten Versicherungslebenszyklus - vom Underwriting über die Schadenregulierung bis hin zur Kundeninteraktion - um KI-Fälschungen zu erkennen. Abbildung 2 zeigt eine Aufschlüsselung der wichtigsten Betrugsarten, die durch KI ermöglicht werden, und deren Verbreitung. In den folgenden Abschnitten wird detailliert beschrieben, wie die einzelnen Betrugsarten erkannt und verhindert werden können.

Abbildung 2: Arten von KI-gestütztem Versicherungsbetrug im Jahr 2025 (geschätzter Anteil nach System). Gefälschte Bilder (manipulierte Fotos von Schäden) und synthetische Identitäten gehören zu den größten Kategorien, gefolgt von KI-gefälschten Dokumenten (z. B. Quittungen, Zertifikate) und Deepfake-Audio-/Videobetrug.

1. Tools zur Erkennung von AI-Inhalten: Neue KI-Erkennungsdienste können Text, Bilder, Audio und Video analysieren, um festzustellen, ob sie maschinell erstellt oder manipuliert wurden. Zum Beispiel können Versicherer Lösungen nutzen wie TruthScans AI-Text- und Bilddetektoren die 99%+ genaue KI verwenden, um mit KI geschriebene Dokumente oder manipulierte Fotos zu kennzeichnen[36]. Ein Versicherungsunternehmen könnte diese Detektoren in sein Schadensystem integrieren: Wenn ein Schadensfall und die dazugehörigen Beweise eingereicht werden, kann die Textbeschreibung automatisch auf KI-generierte Sprachmuster gescannt werden, und alle hochgeladenen Bilder können auf verräterische Anzeichen von CGI oder Bearbeitung untersucht werden. Unternehmenstaugliche Tools können KI-generierten Text in Dokumenten, E-Mails und Mitteilungen mit 99%-Genauigkeit identifizieren[36]und in ähnlicher Weise KI-generierte oder manipulierte Bilder zu erkennen, um die Authentizität visueller Inhalte zu gewährleisten[36]. Das bedeutet, dass ein gefälschter Unfallbericht, der von ChatGPT erstellt wurde, oder ein mitten in der Fahrt gefälschtes Schadensfoto zur manuellen Überprüfung markiert werden würde, bevor der Schaden bearbeitet wird. Die Versicherer im Jahr 2025 setzen zunehmend auf eine solche KI-Inhaltsauthentifizierung - in der Tat, 83% der Betrugsbekämpfungsexperten planen bis 2025 die Integration generativer KI-Erkennunglaut einer ACFE-Umfrage nur noch 18%, die es heute benutzen[37][38].

2. Identitätsüberprüfung und biometrische Kontrollen: Um synthetische Identitäten zu bekämpfen, verbessern die Versicherer auch die KYC-Protokolle mit KI. Identitätsvalidierungsdienste können die Daten von Antragstellern mit mehreren Datenbanken abgleichen und Gesichtserkennung mit Lebendigkeitstests verwenden. So kann beispielsweise ein kurzes Video-Selfie während des Onboardings (und ein Gesichtsabgleich mit der angegebenen ID) viele synthetische IDs vereiteln. Noch mehr Hightech bieten Unternehmen wie TruthScan mit der Bildforensik, die KI-generierte Profilfotos, Avatare und synthetische Persona-Bilder entdecken - ihr AI-Bilddetektor ist trainiert, um Gesichter zu erkennen, die von Generatoren wie StyleGAN oder ThisPersonDoesNotExist erzeugt wurden[39]. Durch den Einsatz solcher Tools kann ein Versicherer erkennen, ob es sich bei dem Selfie eines Lebensversicherungsantragstellers nicht um einen echten Menschen handelt. Auf der Seite der Stimme, stimmliche biometrische Authentifizierung für Kundendienstanrufe können helfen; moderne KI-Detektoren sind in der Lage synthetische Stimmen und Versuche des Stimmenklonens zu identifizieren in Realzeit[40]. Zum Beispiel, TruthScan's AI-Spracherkennung System nutzt die akustische Analyse, um KI-generierte Stimmen und Audio-Fälschungen zu erkennen, bevor sie Callcenter-Mitarbeiter täuschen[40]. Diese Lösungen wirken wie eine Firewall - wenn jemand anruft und vorgibt, John Doe zu sein, und sein Stimmabdruck nicht mit der authentischen Stimme von John Doe übereinstimmt (oder bekannte Merkmale eines Deepfakes aufweist), kann der Anruf gekennzeichnet oder ein weiterer Identitätsnachweis verlangt werden. Die Multi-Faktor-Authentifizierung (E-Mail-/SMS-Bestätigung, einmalige Passcodes usw.) stellt zusätzliche Hürden für Betrüger dar.

3. Deepfake Video & Image Forensics: Was Videobeweise betrifft, so beginnen die Versicherer, spezielle forensische Analysen durchzuführen. Fortgeschrittene Software kann Video-Metadaten, Bildkonsistenz und Fehlerebenen analysieren, um Fälschungen zu erkennen. Einige Tools untersuchen Reflexionen, Schatten und physiologische Anzeichen (wie den Puls einer Person auf dem Video), um sicherzustellen, dass ein Video echt ist. Metadaten-Forensik ist ebenfalls wertvoll: Die Untersuchung von Datei-Metadaten und Generierungsspuren in Bildern oder PDFs kann Aufschluss darüber geben, ob etwas wahrscheinlich von einem KI-Tool erstellt wurde.[41]. Die Versicherer sollten Original-Fotodateien (die Metadaten enthalten) verlangen und nicht nur Screenshots oder gedruckte Kopien. Das Betrugsteam von Zurich konnte gefälschte Fahrzeugbilder erfolgreich aufspüren, indem es Anomalien in den Bild-Metadaten und der Fehleranalyse feststellte[41]. E-Mail-Betrugsdetektoren kann ebenfalls eingehende Kommunikation auf Anzeichen von KI-geschriebenen Phishing-Inhalten oder bekannten bösartigen Signaturen überprüfen[42]. Viele Versicherer führen inzwischen Phishing-Simulationen und von KI erstellte Betrugsbeispiele in Mitarbeiterschulungen durch, um das Bewusstsein zu schärfen.

4. Prozessänderungen und menschliche Ausbildung: Technologie allein ist kein Allheilmittel. Prozessverbesserungen wie z. B. häufigere stichprobenartige persönliche Überprüfungen bei hohen Schadenssummen oder die Forderung nach physischen Unterlagen in bestimmten Fällen. Einige Versicherer haben die vollautomatische Durchlaufbearbeitung von Anträgen verzögert und setzen bei Anträgen, die in einem KI-Betrugsrisikomodell eine hohe Punktzahl erreichen, wieder die menschliche Prüfung ein. Auf der menschlichen Seite ist die Ausbildung entscheidend. Betrugsermittler und Schadensregulierer werden darin geschult, KI-Risikofaktoren zu erkennen: z. B. mehrere Schadensmeldungen mit identischem Wortlaut (ChatGPT-Stil"), Bilder, denen es an echter Zufälligkeit mangelt (z. B. sich wiederholende Muster bei organischen Schäden), oder Stimmen, die sich fast richtig, haben aber eine roboterhafte Kadenz. Auch die Versicherer klären ihre Kunden auf: Sie verschicken Betrugswarnungen über Betrugsversuche und geben Ratschläge, wie die Identität eines Versicherungsvertreters überprüft werden kann (z. B. durch Angabe einer bekannten Rückrufnummer).

5. Gemeinsame Anstrengungen: Die branchenweite Zusammenarbeit wird immer intensiver. Im Vereinigten Königreich haben das Insurance Fraud Bureau und die Association of British Insurers Arbeitsgruppen zum Thema KI-Betrug gebildet, und die Regierungsbehörde Charta über Versicherungsbetrug (2024) fördert den Datenaustausch und gemeinsame Initiativen[43]. Weltweit gehen Versicherer Partnerschaften mit Cybersicherheitsfirmen und KI-Start-ups ein. Auch neue Versicherungsprodukte sind auf dem Vormarsch: Liberty Mutual lancierte eine E-Kriminalitätsversicherung für KMU, die speziell Deepfake-Betrug und CEO-Betrug abdeckt[44][33]und unterstreicht damit, dass dieses Risiko sehr real ist. Das bedeutet auch, dass Versicherer sowohl Opfer als auch Aufklärer von KI-Betrug sein können - sie zahlen für einen Deepfake-Betrug, wenn er nicht entdeckt wird, bieten aber auch Versicherungsschutz für andere, die Opfer solcher Angriffe werden.

Die Integration von Erkennungstechnologien in Arbeitsabläufe kann als eine mehrstufige Verteidigung im Lebenszyklus von Forderungen dargestellt werden. Wie in Abbildung 3können die Versicherer AI-Überprüfungsschritte einfügen bei Anwendung der Politik (zur Überprüfung auf synthetische Identitäten mittels ID-Dokumenten und Selfie-Checks), bei Anspruchseinreichung (zur automatischen Analyse hochgeladener Dokumente, Fotos oder Audiodaten für die KI-Generierung), während Schadenprüfung/Untersuchung (um eine forensische Deepfake-Analyse verdächtiger Beweise durchzuführen und etwaige Sprachinteraktionen zu überprüfen), und unmittelbar vor Auszahlung (eine abschließende Identitätsprüfung, um sicherzustellen, dass der Zahlungsempfänger rechtmäßig ist). Durch die frühzeitige Erkennung von Betrug - idealerweise bei der Aufnahme der Versicherung oder bei der ersten Meldung eines Schadens - sparen die Versicherer Ermittlungskosten und vermeiden unrechtmäßige Auszahlungen.

Abbildung 3: Integration von KI-Erkennungspunkten in den Versicherungslebenszyklus. Beim Abschluss einer Police prüft die KI-basierte Identitätsprüfung auf synthetische oder gefälschte Identitäten. Bei der Einreichung eines Schadenfalls scannen automatische Detektoren Schadentext, Dokumente und Bilder auf KI-generierte Inhalte. Bei der Überprüfung von Ansprüchen verifizieren spezielle Deepfake- und Sprachanalyse-Tools alle Audio-/Videobeweise. Vor der Auszahlung bestätigt eine biometrische Identitätsprüfung die Identität des Begünstigten. Dieser mehrschichtige Ansatz hilft dabei, Betrug in mehreren Phasen abzuwehren.

Die Versicherer müssen nicht alle diese Funktionen selbst entwickeln - viele wenden sich an Unternehmenslösungen wie TruthScan's AI Detection Suitedas eine Reihe von Werkzeugen anbietet, die über eine API in die Systeme der Versicherer integriert werden können. Zum Beispiel, TruthScan's AI Image & Deepfake Detection Dienst kann verwendet werden, um die Echtheit von Bildern und Videos mit einer Genauigkeit von über 99% zu überprüfen[45]. Ihre AI-Text-Detektor kennzeichnet KI-geschriebenen Text in Forderungen oder E-Mails[36], während die AI Sprachdetektor bietet eine Erkennung von Stimmenklonen und eine Sprecherverifizierung, um Telefonbetrüger zu stoppen[40]. Es gibt sogar Nischen-Tools wie ein Detektor für gefälschte Quittungen um Rechnungen/Belege sofort auf Anzeichen von Manipulationen oder KI-generierten Schriften/Layouts zu analysieren[46] - Angesichts der Häufigkeit von gefälschten Reparaturrechnungen in Schadensfällen ist dies äußerst nützlich. Durch den Einsatz einer Kombination dieser Instrumente kann ein Versicherer seine Betrugsaufdeckungsrate drastisch verbessern. Ein Fortune-500-Versicherer meldete die Aufdeckung von 97% von Deepfake-Versuchen im Jahr 2024 durch den Einsatz eines mehrstufigen KI-Screening-Ansatzes (Text, Bild, Sprache) und dadurch Vermeidung von geschätzten Verlusten in Höhe von $20 Mio.[47][48].

Schlussfolgerung

Die KI verändert das Schlachtfeld des Versicherungsbetrugs auf globaler Ebene. Betrüger nutzen generative KI, um überzeugende Lügen zu erfinden - von komplett erfundenen Personen und Unfällen bis hin zu Nachahmungen, die selbst erfahrene Fachleute täuschen können. Die Daten für 2024-2025 zeigen ein alarmierendes Wachstum dieser KI-gestützten Betrügereien, aber sie machen auch deutlich, dass Versicherer, die in Erkennung und Prävention investieren, einen Schritt voraus sein können. Durch die Kombination modernste AI-Erkennungstechnologie - wie Bildforensik, Stimmauthentifizierung und Textanalyse - mit aktualisierten Arbeitsabläufen und Schulungen kann die Branche die Risiken mindern, ohne auf die Effizienz digitaler Prozesse zu verzichten.

Im Kern handelt es sich um ein technologisches Wettrüsten[49]. Wie ein Experte für Betrugsbekämpfung feststellte, "In dieser neuen Realität ist Wachsamkeit der Preis, den man zahlen muss".[50]. Versicherungsunternehmen müssen eine Kultur der Wachsamkeit pflegen und die besten verfügbaren Instrumente einsetzen, um das Vertrauen in den Schadenprozess zu erhalten. Das bedeutet, dass der Wahrheitsgehalt von Dokumenten, Stimmen und Bildern mit der gleichen Strenge überprüft werden muss, mit der die Underwriter das Risiko einschätzen. Es bedeutet auch, branchenweit zusammenzuarbeiten, um Erkenntnisse über neue KI-Betrugstaktiken auszutauschen und gemeinsam Standards zu entwickeln (z. B. Standard-Metadatenanforderungen für eingereichte Medien oder schwarze Listen bekannter gefälschter Identitäten).

Das Jahr 2025 ist ein Wendepunkt: Die Versicherer, die proaktive Anpassung an KI-gesteuerten Betrug werden ihre Kunden und Bilanzen schützen, während diejenigen, die zu langsam reagieren, sich als Zielscheibe für schlagzeilenträchtige Betrügereien wiederfinden könnten. Die ermutigende Nachricht ist, dass die Technologie, um sich zu wehren, existiert und schnell ausgereift ist - die gleiche KI, die Betrügern hilft, kann auch Versicherern helfen. Durch die Implementierung von Lösungen wie der multimodalen KI-Erkennungssuite von TruthScan für Schadensfälle und Identitätsüberprüfung können Versicherer die Erfolgsquote von KI-generierten Betrugsversuchen drastisch senken[51][52]. Auf diese Weise verhindern sie nicht nur Verluste, sondern senden auch eine klare Botschaft an potenzielle Betrüger: Egal, wie raffiniert die Werkzeuge sind, Betrug wird aufgedeckt werden.

Zusammenfassend lässt sich sagen, dass KI-gesteuerter Versicherungsbetrug eine gewaltige Herausforderung darstellt, der jedoch mit einer ebenso intelligenten Verteidigung begegnet werden kann. Mit Wachsamkeit, einer bereichsübergreifenden Strategie und den richtigen Technologiepartnern kann die Versicherungsbranche weiterhin das grundlegende Versprechen einhalten, das den Kern ihres Geschäfts ausmacht: nur rechtmäßige Schäden zu begleichen, und zwar schnell und sicher in einer zunehmend digitalen Welt.

Referenzen:

- Verband der britischen Versicherer - Betrugsstatistik 2023[53][54]

- Allianz und Zurich über KI-"shallowfake"-Schadensfallwelle - The Guardian, 2024[4][11]

- Facia.ai - "Deepfake Insurance Fraud: Wie KI die Regeln neu schreibt," Oktober 2025[55][56]

- Koalition gegen Versicherungsbetrug - Synthetischer Betrug bei Versicherungen (Quantexa), Dezember 2024[21][17]

- RGA - "Die neue Grenze der Betrugsbekämpfung: Synthetische Identitäten". Juni 2025[15][16]

- Pindrop - Bericht zum Sprachbetrug, über FierceHealthcare, Juni 2025[2][3]

- Zahlen drehen - "Top Financial Fraud Schemes 2025". Oktober 2025[1][57]

- TruthScan - AI Detection Platform (Übersicht über die Dienste), 2025[51][52]

- TruthScan - AI Image Detector Produktseite, 2025[45][39]

- TruthScan - AI Voice Detector Produktseite, 2025[40]

- TruthScan - Produktseite zum Detektor für gefälschte Quittungen, 2025[46]

- Liberty Specialty Markets - Pressemitteilung von Deepfake/Cyber Fraud Insurance, März 2025[33]

- Facia.ai - Blog: Wettrüsten bei der Prävention von Versicherungsbetrug, 2025[24][32]

- Insurance Business UK - "KI-generierte Bilder für Kfz-Betrug verwendet," Apr 2025[7][58]

- The Guardian - "Gefälschte Fotos von Autoschäden alarmieren Versicherer". Mai 2024[9][12]

[1] [35] [57] 2025 Finanzielle Betrugsschemata: AI-Bedrohungen und rote Flaggen

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Versicherungsbetrug durch Sprachangriffe im Jahr 2024 um 19% gestiegen

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Betrüger bearbeiten Fahrzeugfotos, um gefälschte Schäden in britischen Versicherungsbetrug einzufügen | Versicherungswirtschaft | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] KI-generierte Bilder werden jetzt für Kfz-Versicherungsbetrug verwendet - Bericht | Insurance Business UK

[13] [14] [15] [16] Die neue Grenze der Betrugsbekämpfung: Synthetische Identitäten und ein KI-Wettrüsten | RGA

[17] [18] [19] [20] [21] [22] JIFA: Synthetischer Betrug: Mit synthetischem Betrug bereits in ihrem Ökosystem, müssen Versicherer mehr wie Banken denken - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake Versicherungsbetrug: Wie KI die Regeln von Versicherungsansprüchen neu schreibt

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Die stille Bedrohung: Warum sich der Versicherungsbetrug auf die Telefonleitung verlagert

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] E-Kriminalitätsversicherung für KMU zielt auf CEO-Betrug und Deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - KI-Erkennung und Content-Sicherheit für Unternehmen

[37] Studie: 8 von 10 Betrugsbekämpfern erwarten den Einsatz generativer KI bis 2025

[38] Einblicke in den 2024 Anti-Fraud Technology Benchmarking Report

[39] [45] AI Bilddetektor | Erkennen von gefälschten und manipulierten Fotos - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI-Stimmdetektor für Deepfakes & Stimmenklonen | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Detektor für gefälschte Quittungen | Überprüfung der Echtheit von Quittungen

https://truthscan.com/fake-receipt-detector

[47] Fortune-500-Versicherer erkennt 97% von Deepfakes und stoppt synthetische ...