Einführung

Generative KI revolutioniert das Gesundheitswesen - und das nicht immer zum Besseren. Im Jahr 2025 haben die Betrugsfälle im Gesundheitswesen zugenommen immer digitaler und ausgefeilter, angetrieben durch Datenschutzverletzungen, Automatisierung und generative KI[1]. Kriminelle nutzen KI-Tools zur Erstellung von gefälschte Patientenidentitäten, synthetische Versicherungsansprüche, KI-generierte medizinische Dokumente, gefälschte Rezepte und sogar gefälschte Arzt-Patienten-Interaktionen. Diese Hightech-Täuschungen treiben den Betrug in neue Höhen und bedrohen die Finanzen der Versicherer und die Sicherheit der Patienten weltweit. Die Herausforderung ist enorm: Betrug im Gesundheitswesen kostet bereits jetzt jährlich zweistellige Milliardenbeträge, und der Aufstieg der KI ist die sowohl das Ausmaß als auch die Komplexität verstärken von Betrügereien[2][3]. Dieses Whitepaper bietet einen detaillierten Einblick in die neuesten KI-gesteuerten Betrugstrends im Gesundheitswesen, reale Fälle aus dem Jahr 2025 und Strategien - von KI-Inhaltsdetektoren bis zur Identitätsüberprüfung - zur Bekämpfung dieser sich entwickelnden Bedrohung.

Das Aufkommen von KI-gestützten Betrugsmaschen im Gesundheitswesen

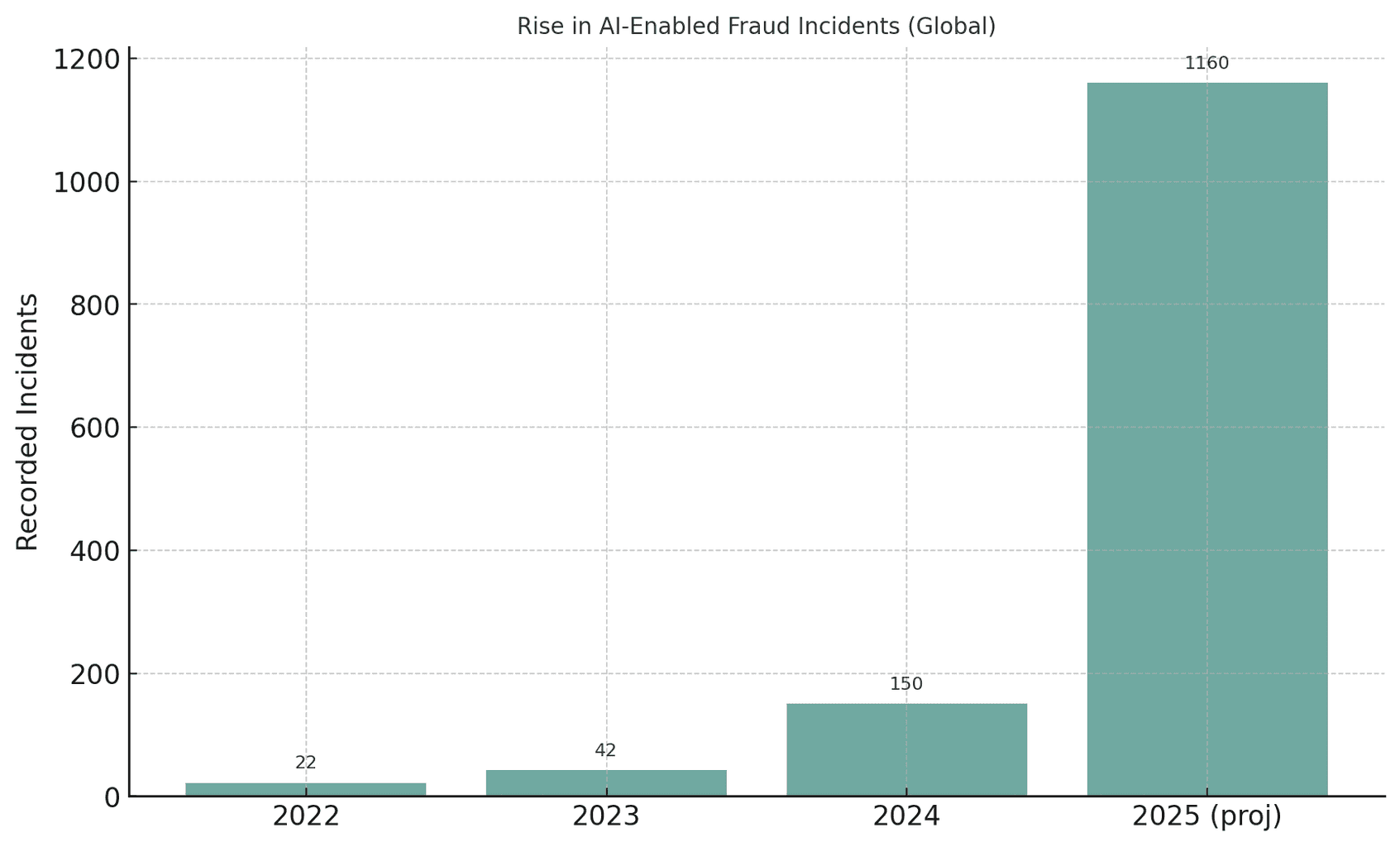

Der globale Gesundheitssektor erfährt derzeit eine noch nie dagewesene Zunahme von KI-gestützten Betrugsversuchen. Mit dem Zugang zu generativer KI können Betrüger automatisieren, was früher manuell durchgeführt wurde, und überzeugende gefälschte Identitäten, Dokumente und sogar Stimmen oder Videos in großem Umfang produzieren. Die Behörden haben zum Beispiel festgestellt, dass Betrugsversuche mit gefälschten Medien sind im Jahr 2023 um 3.000% gestiegen allein[4][5]. Die Vorfälle im Zusammenhang mit Deepfakes haben sich von 22 im Jahr 2022 auf 42 im Jahr 2023 fast verdoppelt und sind dann auf 150 Vorfälle im Jahr 2024 explodiert; erstaunlicherweise gab es im ersten Quartal 2025 179 Deepfake-Betrugsfälle - und damit bereits mehr als im gesamten Jahr 2024[6][7]. Dieser Trend deutet auf eine rasante Zunahme von KI-gesteuertem BetrugAnalysten sagen voraus, dass generative KI die Betrugsverluste von $12,3 Milliarden im Jahr 2023 bis $40 Milliarden bis 2027 (32% CAGR)[8].

Abbildung: Die explosionsartige Zunahme von KI-gestützten Betrugsfällen in den letzten Jahren. Erkannte Fälle von Deepfake- oder KI-gestütztem Betrug sind von 2022 bis 2025 dramatisch angestiegen, was zeigt, wie generative KI-Tools die Betrugsversuche vervielfacht haben[4][7].

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

Das Gesundheitswesen ist besonders anfällig für diese KI-getriebene Kriminalitätswelle. Das riesige, fragmentierte Ökosystem des Sektors - das Krankenhäuser, Kliniken, Versicherer, Apotheken und Telemedizin-Plattformen umfasst - bietet Tausende von Angriffspunkten[9][10]. Traditionelle Betrügereien (z. B. gefälschte Versicherungskarten oder gestohlene Patientenausweise) haben sich zu einer systematischen Ausbeutung entwickelt hat mit KI[10][11]. In einem US-Verfahren aus dem Jahr 2025 erhob das Justizministerium Anklage gegen 324 Angeklagte, die an Betrügereien in Höhe von $14,6 Milliarden in falschen Angaben - der größte Fall von Betrug im Gesundheitswesen aller Zeiten[12][13]. Viele Betrügereien betrafen telemedizinische Konsultationen und Gentests, und ein neues DOJ Health Care Fraud Data Fusion Center KI-Analysen eingesetzt, um proaktiv Muster zu erkennen[14][15]. KI ist eindeutig ein zweischneidiges Schwert: Sie hilft den Ermittlern bei der Betrugsbekämpfung, aber auch die es Kriminellen ermöglichen, Betrug in noch nie dagewesenem Ausmaß und mit noch nie dagewesener Raffinesse zu begehen[11][2].

Verbreitete KI-gestützte Betrugstechniken im Gesundheitswesen (2025)

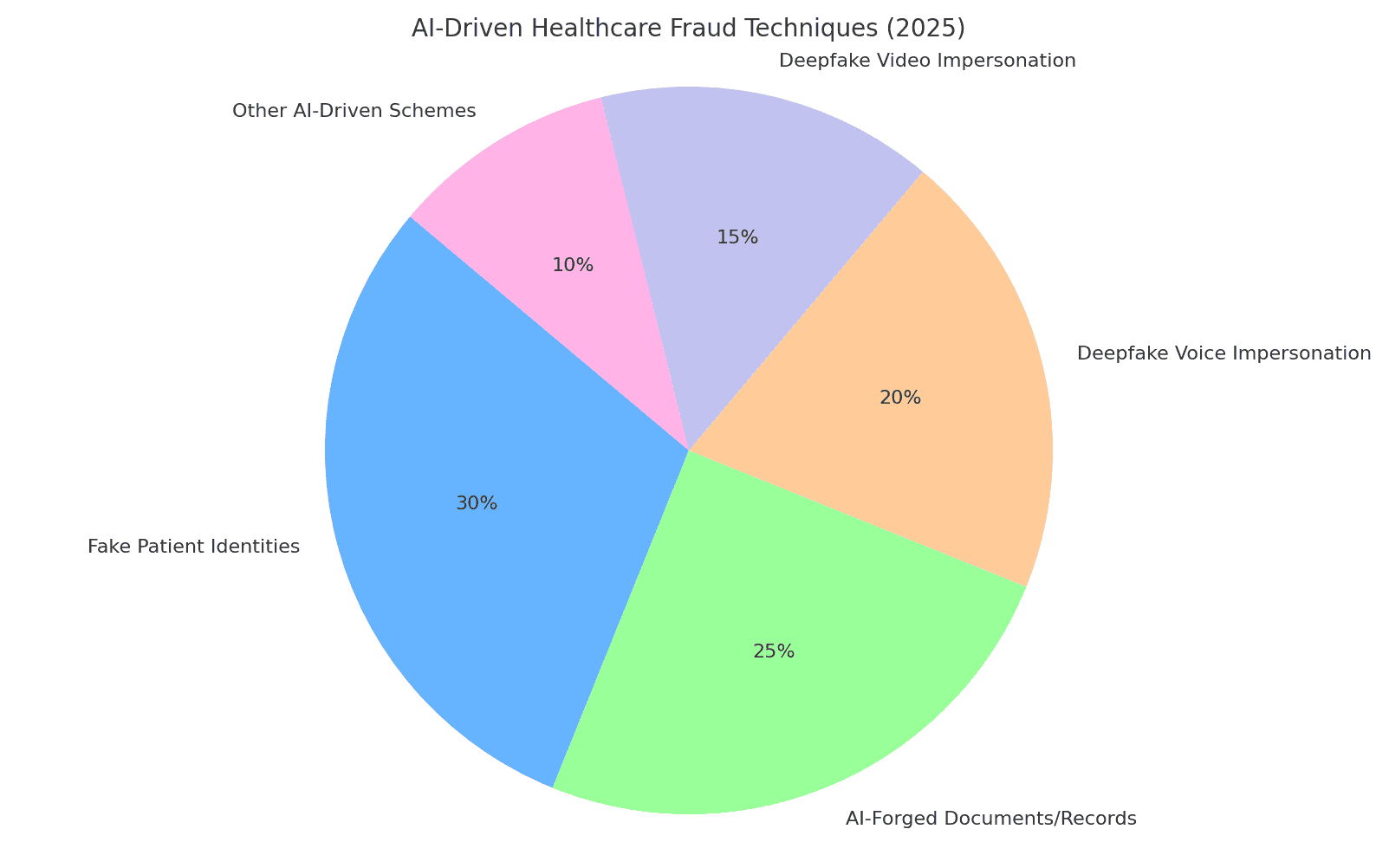

Im Jahr 2025 stehen Betrügern eine Reihe von KI-gestützten Taktiken zur Verfügung, um Gesundheitssysteme und Versicherer zu betrügen. Zu den wichtigsten Methoden gehören das Fälschen von Identitäten und Dokumenten, die Generierung gefälschter medizinischer Daten und das Vortäuschen von vertrauenswürdigem Personal durch Deepfakes. Im Folgenden werden die gängigsten KI-gestützten Betrugstechniken und deren Einsatz gegen Gesundheitsorganisationen beschrieben:

Abbildung: Aufschlüsselung der wichtigsten KI-gesteuerten Betrugsmethoden im Gesundheitswesen im Jahr 2025. Gefälschte Patientenidentitäten und KI-gefälschte Dokumente (z. B. Krankenakten, Forderungen) einen großen Teil der Betrugsfälle ausmachen, während Deepfake Stimme und Video-Imitationen sind eine schnell wachsende Bedrohung. Zu den "anderen KI-gesteuerten Schemata" gehören von KI erstellte Phishing-E-Mails, Bots, die Patientenportale angreifen, und ähnliche Angriffe (geschätzte Prozentsätze auf der Grundlage von Branchenberichten[8][16]).

Synthetische Patientenidentitäten

Gefälschte Patientenidentitäten - die oft mit Hilfe von KI erstellt werden - sind eine grundlegende Betrugstaktik. Anstatt die Identität einer Person zu stehlen, kombinieren Kriminelle echte Daten von mehreren Personen mit gefälschten Details, um eine synthetische Identitäten die sich als neue Patienten ausgeben[17][18]. Generative KI beschleunigt dies durch die Erstellung realistischer persönlicher Aufzeichnungen. KI kann zum Beispiel plausible IDs, Profile, sogar Familiengeschichten ("synthetische Eltern") für einen gefälschten Patienten[19][20]. Diese Phantompatienten werden dann verwendet, um Konten eröffnen, Versicherungspolicen abschließen oder Dienstleistungen in Rechnung stellen die nie stattgefunden haben. Während der COVID-19-Pandemie nutzten Betrüger synthetische Ausweise, um medizinische Notleistungen abzuzweigen; jetzt nutzen sie sie, um falsche Versicherungsanträge stellen oder Rezepte einholenin dem Wissen, dass eine gut gestaltete Identität der Entdeckung entgehen kann[21][22]. Nach Angaben der US-Notenbank beliefen sich die Verluste durch synthetischen Identitätsbetrug auf $35 Milliarden im Jahr 2023 und weiter ansteigen[23]. Die Auswirkungen auf das Gesundheitswesen sind gravierend: Betrüger könnten die gestohlene Sozialversicherungsnummer eines Kindes verwenden, um einen falschen Patienten mit perfekter Bonität zu erstellen, oder gestohlene Patientendaten mischen, um die Überprüfung durch den Versicherer zu umgehen.[17][24]. Jeder synthetische Patient, der in das System eingeführt wird untergräbt die Datenintegrität und kann zu unrechtmäßigen Auszahlungen führen oder sogar klinische Fehler, wenn die gefälschte Identität mit echten Krankenakten verwoben wird.

KI-generierte medizinische Dokumente und Versicherungsansprüche

Die generative KI wird jetzt zum Schmieden von medizinische Dokumente, Unterlagen und vollständige Versicherungsansprüche. Sprachmodelle können authentisch aussehende Arztbriefe, Entlassungsberichte, Laborergebnisse oder Abrechnungen mit medizinischem Fachjargon erstellen, die alle darauf zugeschnitten sind, eine betrügerische Forderung zu unterstützen. Tatsächlich berichten Branchenbeobachter von einer 89% Anstieg von KI-generierten medizinischen Dokumenten die im Vergleich zu den Vorjahren vorgelegt werden[25][26]. Betrüger nutzen diese gefälschten Aufzeichnungen, um teure Verfahren oder Medikamente zu rechtfertigen, die nie verabreicht wurden, oder um die Erstattungscodes aufzublähen. Eine KI könnte zum Beispiel eine gefälschte diagnostischer Bildgebungsbericht oder Laborergebnis um einen hohen Kostenanspruch für onkologische Arzneimittel zu begründen. Versicherer und Gesundheitssysteme sind mit einer Flut solcher synthetischer PapierkramDadurch wird es schwieriger, legitime Ansprüche von Fälschungen zu unterscheiden. Im Vereinigten Königreich stellen die Versicherer eine rapide zunehmende Verwendung von Fälschungen und gefälschten Dokumenten bei der Schadensregulierungoft bei scheinbar routinemäßigen Forderungen von geringem Wert, um eine Prüfung zu vermeiden[27]. Auch klinische Bilder sind nicht immun - es gibt Hinweise darauf, dass Betrüger nutzen generative KI, um medizinische Bilder zu imitieren wie Röntgenstrahlen oder Scans[3]. Die Folgen gehen über den finanziellen Verlust hinaus: Wenn gefälschte medizinische Aufzeichnungen in die Patientenakten gelangen, können sie zu Fehldiagnosen oder falscher Behandlung führen. Daher, KI-geschriebene Gesundheitsdokumente stellen ein ernstes Integritäts- und Sicherheitsrisiko dar.

Gefälschte Verschreibungen und Apothekenbetrug

Verschreibungsbetrug hat mit KI das digitale Zeitalter erreicht. Gefälschte Verschreibungen - die traditionell mit gestohlenen Rezeptblöcken oder rudimentären Bearbeitungen erstellt wurden, können jetzt automatisch mit realistischen Details und Arztunterschriften generiert werden. AI-Bildgeneratoren oder -Vorlagen machen es trivial zu erstellen authentisch aussehende elektronische Rezeptausdrucke oder Bestellscheine für Apotheken. Noch heimtückischer: Kriminelle nutzen Stimmenklonen um sich in Gesprächen mit Apothekern als Ärzte auszugeben. Bei einem gemeldeten Trend hackten sich Betrüger in Krankenakten ein, um die DEA-Registrierungsnummern von Ärzten zu stehlen, und nutzten dann diese Anmeldedaten, um elektronische Rezepte für kontrollierte Substanzen zu versenden[28]. Es gab Fälle von KI-Stimmfälschungen zur Autorisierung von Nachfüllungen - Ein Apotheker erhält einen Anruf, der sich genau wie ein bekannter Arzt anhört, der ein Rezept bestätigt, aber in Wirklichkeit ist es eine von einer künstlichen Intelligenz erzeugte Stimme. Infolgedessen können kontrollierte Medikamente (wie Opioide oder Stimulanzien) illegal beschafft und abgezweigt werden. Der Betrug mit gefälschten Rezepten verursacht nicht nur finanzielle Verluste für Versicherer und Apotheken, sondern gefährdet auch die Patienten, die möglicherweise falsche Medikamente in ihren Unterlagen finden. Wenn sich beispielsweise ein Betrüger als Patient ausgibt, um ein Opioidrezept zu erhalten, kann der Die Krankenakte eines echten Patienten könnte mit Medikamenten aktualisiert werden, die er nie eingenommen hat, was zu gefährlichen Wechselwirkungen führen oder ihn als drogensüchtig kennzeichnen könnte.[29]. Diese Mischung aus Cyberkriminalität und KI-Ausbeutung hat zu Warnungen von Regulierungsbehörden geführt. Organisationen des Gesundheitswesens müssen nun überprüfen, ob jede Verschreibung - insbesondere von Hochrisikomedikamenten - rechtmäßig ist und wirklich vom autorisierten Anbieter stammennicht um einen Deepfake oder eine Datenpanne.

Gefälschte Arzt-Patienten-Imitationen

Die vielleicht aufsehenerregendste Entwicklung ist die Verwendung von Fälschungen, um sich als medizinisches Personal oder Patienten auszugeben. In der Telemedizin und im Kundendienst setzen Betrüger KI-generierte Video- und Audiomaterialien ein, um die Menschen am anderen Ende der Leitung zu täuschen. Zum Beispiel haben Kriminelle Folgendes geschaffen gefälschte Videos von Patienten für telemedizinische Konsultationen, die Ärzte dazu verleiten, "Behandlungen" oder Überweisungen vorzunehmen, die dann der Versicherung in Rechnung gestellt werden[30][31]. Umgekehrt könnte ein Betrüger das Bild eines Arztes - unter Verwendung des Gesichts und der Stimme eines seriösen Arztes - in einem Videoanruf vortäuschen, um einen Patienten davon überzeugen, für eine betrügerische Dienstleistung zu bezahlen oder persönliche Daten preiszugeben. IT-Experten im Gesundheitswesen warnen, dass Die Telemedizin ist ein attraktives Ziel geworden.Man kann einen virtuellen Termin mit einer gefälschten Patientenidentität vereinbaren und dann einen KI-Avatar per Video einspringen lassen, um unter Vorspiegelung falscher Tatsachen Rezepte oder medizinische Ratschläge zu erhalten.[31][32]. Neben der Telemedizin durchdringen Deepfakes die sozialen Medien in Form von "Arzt"-Videos, die für Wunderheilungen werben. Im Jahr 2024 beobachteten Experten, dass gefälschte Videos von berühmten Ärzten "wirklich durchgestartet", das sich mit falschen Gesundheitstipps und Betrugsprodukten an ein älteres Publikum wendet[33][34]. Im Vereinigten Königreich und in Frankreich wurden vertrauenswürdige TV-Ärzte geklont, um für gefälschte Diabetes-Kuren und Blutdruckpräparate zu werben[35][36]. Bis zur Hälfte der Zuschauer konnte nicht erkennen, dass diese medizinischen Videos gefälscht waren[37]. Diese Aushöhlung der Wahrheit hat greifbare Kosten: Patienten könnten schädliche Ratschläge aus einem gefälschten Arztvideo befolgen, oder Betrüger könnten Versicherern Beratungen in Rechnung stellen, die nie stattgefunden haben, außer als gefälschte Aufnahme. Alles in allem, KI-gesteuerte Nachahmung untergräbt das grundlegende Vertrauen in Interaktionen im Gesundheitswesen - Wenn man sich nicht darauf verlassen kann, dass die Person auf dem Bildschirm oder am Telefon die ist, die sie vorgibt zu sein, ist das gesamte System gefährdet.

Auswirkungen und Ausmaß: Betrug im Jahr 2025 in Zahlen

KI-gesteuerter Betrug ist kein Randthema mehr - er stellt inzwischen eine große finanzielle Belastung und Sicherheitsbedrohung für die globalen Gesundheitssysteme dar. Die folgenden aktuellen Statistiken und Fälle veranschaulichen die Ausmaß des Problems:

- Jährliche Verluste: Betrug im Gesundheitswesen kostet die USA schätzungsweise $68 Milliarden oder mehr pro Jahr[25]etwa 3-10% der gesamten Gesundheitsausgaben[38]. Weltweit könnte der Betrug etwa 6% der Gesundheitsausgaben[39] - eine erschütternde Zahl, wenn man bedenkt, dass sich die weltweiten Gesundheitsausgaben auf Billionen von Dollar belaufen. Diese Verluste schlagen sich letztlich in höheren Prämien, höheren Krankenhauskosten und geringeren Ressourcen für die Patientenversorgung nieder.

- Betrugsspitze in den Jahren 2023-2025: Das Aufkommen der generativen KI hat zu einer explosionsartigen Zunahme von Betrugsversuchen geführt. Betrugsvorfälle im Zusammenhang mit Deepfake haben zugenommen von 2022 bis 2023 verzehnfachen[4]. Im Jahr 2024 stieg die Zahl der gemeldeten Deepfake-Vorfälle sprunghaft auf 150 (ein Anstieg um 257%)[40]und 2025 wird diese Zahl bei weitem übertroffen (580 Vorfälle allein in der ersten Hälfte des Jahres 2025, fast das Vierfache der Gesamtzahl für 2024)[7]. Betrugsexperten stellen fest, dass 46% hatten mit synthetischem ID-Betrug zu tun, 37% mit gefälschten Stimmen und 29% mit gefälschten Videos bei ihren Untersuchungen[8] - die verdeutlichen, wie verbreitet diese KI-Techniken inzwischen sind.

- Rekordverdächtige Takedowns: Die Strafverfolgungsbehörden reagieren darauf mit verstärktem Durchgreifen. Im Juni 2025 kündigte das US-Justizministerium die Größte Aufdeckung von Betrug im Gesundheitswesen in der Geschichteund 324 Personen angeklagt und aufgedeckt $14,6 Milliarden bei betrügerischen Forderungen[1][13]. Dazu gehörten Betrügereien bei der Telemedizin, Gentests und Betrug mit langlebigen medizinischen Geräten in großem Stil[13]. Als Teil dieser Bemühungen wird Medicare $4 Milliarden an ausstehenden Auszahlungen ausgesetzt als verdächtig befunden[41]und diese Verluste zu verhindern. Ein entscheidender Fall ("Operation Gold Rush") deckte einen internationalen Ring auf, der gestohlene Identitäten nutzte, um $10,6 Mrd. Euro an falschen Angaben für medizinische Hilfsmittel[42] - ein Beweis dafür, wie weit Kriminelle gehen, wenn sie über verletzte Daten und Automatisierung verfügen.

- Auswirkungen auf die Versicherer: Versicherer weltweit sehen einen Anstieg von Betrug im Zusammenhang mit KI. Im Vereinigten Königreich berichten die Versicherer, dass in der Schadenregulierung zunehmend gefälschte Anträge gestellt werden (oft "low touch"-Anträge, um nicht entdeckt zu werden).[27]. Ein führendes Rückversicherungsunternehmen warnt davor, dass gefälschte Krankenakten und vorgetäuschte Gesundheitszustände das Underwriting untergraben und die Verluste in der Lebens- und Krankenversicherung in die Höhe treiben könnten[43]. Eine Deloitte-Analyse aus dem Jahr 2024 prognostiziert, dass bis 2027, generativer KI-gestützter Betrug könnte in den USA jährliche Verluste in Höhe von $40 Mrd. verursachen. (Anstieg von $12,3 Milliarden im Jahr 2023)[8]. Diese Entwicklung bedeutet einen erheblichen Schlag für die Gewinne der Versicherer, wenn keine robusten Gegenmaßnahmen ergriffen werden.

- Patienten als Opfer: Auch Patienten und die Öffentlichkeit verlieren durch diese Betrügereien Geld. Vor allem ältere Erwachsene sind Zielscheibe von KI-Stimmenbetrug ("Enkel in Not"-Anrufe) und gefälschten Gesundheitsdatenbetrug. Im Jahr 2023 meldeten US-Senioren $3,4 Milliarden Verluste durch Betrug, ein Anstieg um 11% gegenüber dem Vorjahr[44][45] - einige davon werden durch KI-gestützte Systeme angetrieben. Und abgesehen von den finanziellen Kosten gibt es menschliche KostenBetrügerische medizinische Ratschläge und gefälschte Behandlungen, die über KI beworben werden, können zu körperlichen Schäden oder zum Verlust des Vertrauens in legitime Gesundheitsberatung führen.

Insgesamt hat das Jahr 2025 deutlich gemacht, dass KI beschleunigt den traditionellen Betrug im Gesundheitswesen. Was früher kleinere, opportunistische Betrügereien waren, hat sich zu einem industrialisierten Betrieb ausgeweitet, der Kontinente umspannt. Die Kombination von Big Data (oft aus Sicherheitsverletzungen) und KI bedeutet, dass Betrügereien mit erschreckender Geschwindigkeit und Plausibilität durchgeführt werden können. Die weltweiten Verluste gehen in die zweistellige Milliardenhöhe und steigen weiter.und alle Beteiligten - von Krankenhäusern und Versicherern bis hin zu Patienten - sind gefährdet. Im nächsten Abschnitt wird erörtert, wie sich die Branche mit ebenso fortschrittlichen Technologien und Strategien zur Wehr setzen kann.

Verteidigung gegen KI-gesteuerten Betrug: Strategien und Lösungen

Die Bekämpfung von KI-gestütztem Betrug im Gesundheitswesen erfordert ein Arsenal an ebenso fortschrittlichen Abwehrmaßnahmen. Führungskräfte im Gesundheitswesen, Cybersicherheitsteams, Compliance-Beauftragte und Versicherer müssen sich abstimmen, um Maßnahmen zur Betrugsbekämpfung an allen gefährdeten Stellen einführen - von der Aufnahme der Patienten bis zur Auszahlung der Ansprüche. Nachfolgend finden Sie die wichtigsten Strategien und technischen Lösungen zur Bekämpfung von KI-gesteuertem Betrug:

- Tools zur Erkennung von AI-Inhalten: So wie Kriminelle KI nutzen, um Inhalte zu fälschen, können Unternehmen KI nutzen, um sie zu erkennen. Fortgeschrittene KI-gesteuerte Inhaltsdetektoren (wie die Suite von TruthScan) analysieren Text, Bilder, Audio und Video, um verräterische Anzeichen für die Erzeugung von KI zu erkennen. Die Plattform von TruthScan wendet beispielsweise maschinelles Lernen an, um die statistischen Muster und sprachlichen Eigenheiten zu erkennen, die auf KI-generierten Text mit über 99% Genauigkeit[46][47]. Diese Instrumente können in Systeme zur Verwaltung von Ansprüchen oder in elektronische Gesundheitsakten integriert werden, um automatisch zu kennzeichnen verdächtige Dokumente - z. B. einen medizinischen Bericht, der wahrscheinlich von ChatGPT verfasst wurde - zur manuellen Überprüfung. Ebenso kann die KI-Bildforensik manipulierte medizinische Scans oder gefälschte Ausweise aufspüren, und Deepfake-Erkennungsalgorithmen können Videos auf Anzeichen von Synthese (Artefakte in Pixeln, seltsames Timing von Gesichtsbewegungen usw.) analysieren.[48][49]. Durch den Einsatz von multimodalen KI-Detektoren können Gesundheitsorganisationen einen großen Teil der von der KI gefälschten Inhalte in Echtzeit aussortieren bevor er Schaden anrichtet.

- Überprüfung von Krankenakten und Dokumenten: Gesundheitsdienstleister wenden sich an spezialisierte Lösungen, um die Echtheit von Aufzeichnungen und Schadensunterlagen zu überprüfen. Dazu gehören das Hashing und die digitale Signierung legitimer Datensätze sowie die Verwendung von Datenbanken mit bekannt guten Dokumentenvorlagen zum Vergleich mit eingereichten Dokumenten. KI-gesteuerte Überprüfungsdienste (z. B. TruthScan's Authentifizierung medizinischer Dokumente Lösung) kann den Inhalt und die Metadaten eines Dokuments sofort analysieren, um festzustellen, ob es maschinell erstellt oder verändert wurde[50][51]. Sie suchen nach Ungereimtheiten, die ein Mensch übersehen könnte, wie z. B. subtile Formatierungsanomalien oder Metadaten, die darauf hinweisen, dass ein Bild von einer KI erstellt wurde. Echtzeit-Überwachung von Patientenakten und Versicherungsansprüchen für Anomalien ist ebenfalls wesentlich[52]. Durch ständiges Scannen neuer Einträge (Laborergebnisse, Arztbriefe, Anhänge von Anträgen) können diese Systeme gefälschte Datensätze aufspüren. vor sie zu betrügerischen Auszahlungen oder klinischen Fehlern führen. Einige Versicherer haben Regeln eingeführt, nach denen alle Antragsunterlagen, die als KI-generiert identifiziert werden, automatisch zur Betrugsermittlung herangezogen werden. Das Ziel ist es, sicherzustellen, dass jede Krankenakte oder jeder Antrag, der in den Arbeitsablauf eingeht, vertrauenswürdig und unverändert ist.

- Identitätsnachweis und -validierung: Eine verstärkte Identitätsüberprüfung ist im Zeitalter der synthetischen IDs von entscheidender Bedeutung. Gesundheitseinrichtungen sollten Folgendes durchsetzen rigoroser Identitätsnachweis für neue Patienten, Anbieter und Lieferanten. Dies kann eine Multi-Faktor-Authentifizierung, biometrische Überprüfungen (wie Gesichtserkennung oder Fingerabdrücke bei der Registrierung) und die Nutzung von Identitätsüberprüfungsdiensten umfassen, die KI zur Erkennung nutzen gefälschte Ausweise oder nicht übereinstimmende persönliche Daten. So kann beispielsweise die Gesichtserkennung mit Lebendigkeitstests kombiniert werden, um zu verhindern, dass ein KI-generiertes Gesicht über ein Foto als echter Patient durchgeht. Im Hintergrund können Algorithmen die Daten eines Patienten (Adresse, Telefon, E-Mail, Präsenz in sozialen Medien) abgleichen, um "dünne" Identitäten zu erkennen, die keine normale Historie aufweisen - ein bekanntes Merkmal synthetischer IDs.[53]. Finanzinstitute haben solche KI-gesteuerten Hintergrundüberprüfungen mit großem Erfolg eingesetzt[54]und das Gesundheitswesen können dasselbe tun: z. B. einen neuen Medicare-Antragsteller kennzeichnen, wenn er vor diesem Jahr keinen digitalen Fußabdruck hat. Validierung von Anbieteridentitäten Ebenso wichtig ist es, sicherzustellen, dass der Arzt in einem Telemedizin-Video lizenziert ist und tatsächlich derjenige ist, für den er sich ausgibt, z. B. durch die Ausstellung digitaler Zertifikate oder mit Wasserzeichen versehene Videoübertragungen, die von Deepfakes nur schwer nachgeahmt werden können. In Apotheken sollte das Personal ungewöhnliche Rezeptanfragen durch direkte Rückrufe bei den Anbietern überprüfen und Codesätze oder Verifizierungsfragen verwenden, um potenzielle KI-Stimmenfälscher abzuwehren.

- Integrierte Betrugsermittlung in Arbeitsabläufen: Um das System wirklich zu schützen, kann die Aufdeckung von Betrug kein alleinstehender Schritt sein - sie muss in jeden Arbeitsablauf eingewoben in einer Gesundheitsorganisation.

In der Praxis bedeutet dies, dass Krankenhäuser und Versicherer API-Integrationen einsetzen, um Betrugserkennungsdienste zu kritischen Zeitpunkten aufzurufen. Wenn ein Leistungserbringer beispielsweise einen Antrag mit angehängten Dokumenten einreicht, könnte ein KI-Dienst diese Anhänge in Sekundenschnelle automatisch auf ihre Echtheit überprüfen. Wenn ein Termin im Rahmen der Telemedizin eingeleitet wird, könnte die Plattform im Hintergrund eine passive Sprachanalyse durchführen, um sicherzustellen, dass der Anrufer keine synthetische Stimme verwendet. Kontinuierliche Überwachung ist ebenfalls von entscheidender Bedeutung: Moderne Betrugsplattformen bieten Dashboards, die Betrugssignale in der gesamten Organisation verfolgen (fehlgeschlagene Validierungen, häufige Markierung von Ansprüchen einer bestimmten Klinik usw.), um Muster zu erkennen, z. B. einen organisierten Betrugsring, der über mehrere Ansprüche hinweg operiert. Indem wir Betrug im Gesundheitswesen eher wie Cyber-Bedrohungen behandeln - mit 24/7-Überwachung, Erkennung von Anomalien und schnelle Reaktion auf Zwischenfälle - Organisationen können Probleme erkennen, bevor sie sich zuspitzen[55].

- KI für Betrugsanalyse und Mustererkennung: Die Datenmenge im Gesundheitswesen ist so groß, dass KI unverzichtbar ist, um Betrugsmuster zu finden, die Menschen übersehen. Modelle für maschinelles Lernen können auf historische Betrugsfälle trainiert werden, um neue Betrugsfälle zu erkennen (z. B. das Clustern von Ansprüchen, die ähnliche ungewöhnliche ICD-Codes aufweisen, oder das Erkennen, wenn die Abrechnung eines Arztes stark von der seiner Kollegen abweicht). Die Versicherer nutzen bereits prädiktive Analysen, um Forderungen nach Betrugsrisiko bewerten in Echtzeit. Neue Techniken wie graphische neuronale Netze können Beziehungen zwischen Patienten, Leistungserbringern, Diagnosen und Ansprüchen abbilden, um unwahrscheinliche Verbindungen zu erkennen (z. B. dieselbe Geräteseriennummer in Ansprüchen aus verschiedenen Staaten). Die TruthScan-Suite für Versicherungsbetrug umfasst zum Beispiel Schadenmustererkennung und vorausschauende Modellierung, um organisierte Betrugsringe und atypische Muster zu erkennen, bevor sich die Verluste häufen[56][57]. Das DOJ Fusion Center aus dem Jahr 2025 ist ein Beispiel für diesen Ansatz - es sammelt Daten über Medicare und private Versicherer, um proaktiv Cluster verdächtiger Aktivitäten zu finden[58]. Organisationen des Gesundheitswesens sollten ebenfalls Daten und KI-Modelle gemeinsam nutzen in Konsortien, um die Betrugssignale zu erweitern, die sie erkennen können. Je mehr Daten (innerhalb der Grenzen des Datenschutzes) in diese Modelle einfließen, desto besser können sie zwischen normalem und betrügerischem Verhalten unterscheiden.

- Personalschulung und Prozesskontrollen: Die Technologie ist entscheidend, aber das menschliche Bewusstsein bleibt ein starker Schutz. Mitarbeiter und Administratoren im Gesundheitswesen sollten in Bezug auf KI-gestützte Betrugstaktiken geschult werden - zum Beispiel in dem Wissen, dass ein Perfekt geschriebene E-Mail von einem CEO könnte KI-gesteuertes Phishing seinoder dass sie die Identität der Videoanrufer zu überprüfen wenn etwas "komisch" erscheint (seltsame Augenbewegungen oder Audioverzögerungen können auf einen Deepfake hindeuten). Für neue Bedrohungen wie Deepfake-Telefonbetrug können regelmäßige Übungen und Tipps (ähnlich wie Phishing-Sensibilisierungsschulungen) durchgeführt werden. Einfache Prozesskontrollen sorgen für zusätzliche Sicherheit: Rückrufe oder sekundäre Verifizierungen für große oder ungewöhnliche Zahlungsanforderungen, die Verwendung bekannter sicherer Kommunikationskanäle für sensible Informationen und ein spezieller Reaktionsplan für vermuteten KI-vermittelten Betrug. Wichtig ist, dass Unternehmen eine Kultur kultivieren, in der die Mitarbeiter fühlen sich ermächtigt, Anomalien zu hinterfragenselbst wenn es sich um einen "Arzt" auf Video handelt, der eine seltsame Bitte äußert. Viele Deepfake-Betrügereien sind erfolgreich, indem sie Vertrauen und Autorität ausnutzen; eine wachsame Belegschaft, die diese Tricks kennt, kann Vorfälle frühzeitig stoppen. Wie ein Experte anmerkte, könnte die Bekämpfung von Deepfakes so routinemäßig werden wie das Erkennen von Phishing-E-Mails - ein Standardbestandteil der Cybersicherheitshygiene[32][59].

- Nutzung spezialisierter Dienste: Angesichts der rasanten Entwicklung von KI-Bedrohungen arbeiten viele Gesundheitsorganisationen mit spezialisierten Anbietern von Betrugsprävention zusammen. Dienste wie TruthScan für das Gesundheitswesen bieten End-to-End-Lösungen, die auf medizinische Anwendungsfälle zugeschnitten sind, darunter: Echtzeitüberwachung der Integrität elektronischer Krankenakten (EMR), Überprüfung von Patientendokumenten gegen KI-Manipulationen, Deepfake-Erkennung für die Telemedizin und Compliance-Berichterstattung (z. B. Prüfpfade, die den Aufsichtsbehörden die Sorgfaltspflicht bei der Betrugserkennung beweisen)[60][51]. Solche Plattformen bieten oft API-Einbindung für eine nahtlose Integration in bestehende Systeme und zur Einhaltung von Vorschriften im Gesundheitswesen (HIPAA, GDPR)[61][62]. Durch den Einsatz von Tools auf Unternehmensniveau können auch kleinere Kliniken oder regionale Versicherer Zugang zu fortschrittlichen KI-Erkennungsfunktionen erhalten, ohne diese selbst entwickeln zu müssen. Darüber hinaus sollten Versicherer und Anbieter auf Aktualisierungen von Vorschriften und Industriestandards achten - zum Beispiel auf neue Gesetze gegen Deepfake-Betrug (einige Gerichtsbarkeiten verbieten jetzt ausdrücklich medizinische Deepfakes, und die USA erweitern die Gesetze zum Identitätsdiebstahl, um KI-Imitationen zu erfassen[63]). Die Anpassung an solche Standards und der Einsatz modernster Tools verringern nicht nur Betrugsverluste, sondern demonstrieren Partnern, Prüfern und Patienten auch eine starke Sicherheitslage.

Schlussfolgerung und Ausblick

Das Jahr 2025 hat gezeigt, dass die der Geist ist aus der Flasche - Generative KI und Automatisierung sind nun mit Betrug im Gesundheitswesen verflochten. In Zukunft werden Betrüger wahrscheinlich weiter innovativ sein: Wir könnten KI-Modelle sehen, die lernen, den Schreibstil bestimmter Ärzte zu imitieren, oder Deepfakes, die in Echtzeit auf herausfordernde Fragen reagieren. Der Kampf wird ein ständiges Wettrüsten sein. Die Gesundheitsbranche reagiert jedoch mit der gleichen Entschlossenheit und investiert in KI-gestützte Abwehrmaßnahmen und strengere Sicherheitsabläufe. Durch die Kombination modernste Erkennungstechnologie, strenge Überprüfungsverfahren, branchenübergreifender Datenaustausch und Wachsamkeit der Mitarbeiterkönnen Organisationen des Gesundheitswesens die Bedrohung durch KI-gestützten Betrug erheblich eindämmen.

Entscheidend ist, dass es sich nicht nur um ein IT-Problem handelt, sondern um ein Problem der Unternehmensführung und des Vertrauens. Vorstände und Führungskräfte im Gesundheitswesen müssen KI-Betrug als strategisches Risiko für die Finanzen und das Vertrauen der Patienten erkennen, das regelmäßige Aufmerksamkeit und Ressourcen rechtfertigt. Compliance-Teams sollten Betrugsrisikobewertungen aktualisieren, um KI-Aspekte mit einzubeziehen, und Versicherer könnten Underwriting-Annahmen überdenken, wenn sie wissen, dass ein gewisser Prozentsatz der Ansprüche KI-gestützter Betrug sein könnte. Auf der anderen Seite wird der ethische Einsatz von KI im Gesundheitswesen (zur Unterstützung klinischer Entscheidungen, für eine effizientere Rechnungsstellung usw.) weiterhin große Vorteile bringen - solange strenge Schutzmaßnahmen zur Verhinderung von Missbrauch vorhanden sind.

Zusammengefasst, Generative KI hat das Betrugsspiel verändert im Gesundheitswesen, aber mit Bewusstsein und fortschrittlichen Gegenmaßnahmen müssen sie das System nicht überwältigen. Die Organisationen, die erfolgreich sein werden, sind diejenigen, die über neue Bedrohungen informiert bleiben, sich schnell mit KI-gesteuerten Abwehrmaßnahmen anpassen und eine Kultur des "Überprüfens und Vertrauens" statt des "standardmäßigen Vertrauens" fördern. Auf diese Weise kann das Gesundheitswesen die positiven Aspekte der KI sicher nutzen und gleichzeitig ihren Missbrauch neutralisieren, um sowohl den Gewinn als auch das Wohlbefinden der Patienten im digitalen Zeitalter zu schützen.

Quellen: Jüngste Berichte und Fälle aus der Branche, wie oben zitiert, einschließlich Pymnts (Juli 2025)[2][3]Swiss Re Institut (Juni 2025)[27]Federal Reserve Bank of Boston (Apr 2025)[19], BMJ (2024)[37]und TruthScan Solution Briefs (2025)[51][64]und andere. Alle Daten und Zitate spiegeln die neuesten verfügbaren Daten für 2024-2025 wider und veranschaulichen den aktuellen Stand des KI-gesteuerten Betrugs im Gesundheitswesen und die Maßnahmen zu seiner Bekämpfung.

[1] [2] [3] [9] [10] [11] [12] [13] [14] [15] [41] [42] [55] [58] DOJ würdigt AI-Tools bei historischer Betrugsbekämpfung im Gesundheitswesen

[4] [5] [6] [7] [16] [40] [44] [45] Deepfake-Statistiken & Trends 2025 | Schlüsseldaten & Einblicke - Keepnet

https://keepnetlabs.com/blog/deepfake-statistics-and-trends

[8] Deepfakes und die Krise des Wissens | UNESCO

https://www.unesco.org/en/articles/deepfakes-and-crisis-knowing

[17] [18] [19] [20] [21] [22] [23] [24] [53] [54] Gen AI steigert die Bedrohung durch synthetischen Identitätsbetrug - Federal Reserve Bank of Boston

[25] [26] [56] [57] [62] [64] Kranken- und Lebensversicherung AI Betrugserkennung | TruthScan

https://truthscan.com/solutions/health-life-commercial-insurance-fraud-detection-solution

[27] [43] Wie Deepfakes, Desinformation und KI den Versicherungsbetrug verstärken | Swiss Re

[28] DEA warnt vor elektronischem Verschreibungsbetrug - Apotheken-Praxis-News

[29] [39] Cybersecurity und Betrug im Gesundheitswesen: Ein tiefer Einblick in die größten Risiken und Schutzmaßnahmen von heute | CrossClassify

https://www.crossclassify.com/resources/articles/healthcare-cybersecurity-and-fraud/

[30] [31] [32] [59] Die sich entwickelnde Bedrohung durch gefälschte Telemedizin-Betrügereien, Mike Ruggio

https://insights.taylorduma.com/post/102jkzn/the-evolving-threat-of-deepfake-telemedicine-scams

[33] [34] Experten warnen vor Betrügern, die "Deepfakes" berühmter Ärzte in sozialen Medien verwenden

[35] [36] [37] Vertrauenswürdige TV-Ärzte "getäuscht", um in den sozialen Medien für Gesundheitsbetrug zu werben - BMJ Group

https://bmjgroup.com/trusted-tv-doctors-deepfaked-to-promote-health-scams-on-social-media/

[38] [PDF] Aktueller Stand der Forschung Ajit Appari und M. Eric Johnson

http://mba.tuck.dartmouth.edu/digital/Research/ResearchProjects/AJIJIEM.pdf

[46] [47] [48] [49] TruthScan - KI-Erkennung und Content-Sicherheit für Unternehmen

[50] [51] [52] [60] [61] AI Medical Record Fraud Detection | Healthcare CRO Solutions | TruthScan

https://truthscan.com/solutions/healthcare-cro-fraud-detection

[63] Wie gefährlich sind Deepfakes und andere KI-gestützte Betrugsfälle?