Einführung

Künstliche Intelligenz verändert die Landschaft des Finanzbetrugs in noch nie dagewesener Weise. Anfang 2024 nutzten Betrüger KI-generierte Deepfakes, um sich in einem Videoanruf als Führungskräfte auszugeben und einen Angestellten in Hongkong dazu zu bringen, Geld zu überweisen. $25 Millionen zu den Betrügern[1][2]. Vorfälle wie dieser zeigen, wie generative KI Kriminelle in die Lage versetzt, äußerst überzeugende Betrugsmaschen zu entwickeln, die auf Banken und ihre Kunden abzielen. Die Aufsichtsbehörden schlagen Alarm: Das US-Finanzministerium FinCEN hat Ende 2024 eine Warnung vor zunehmendem Betrug durch KI-generierte "Deepfake"-Medien herausgegeben, einschließlich gefälschter Identitätsdokumente, um Banküberprüfungen zu umgehen[3][4]. Dieses Whitepaper untersucht die neuesten KI-Betrugstrends bei Finanzdienstleistungen und erörtert, wie Institutionen ihre Abwehrmaßnahmen verstärken können. Wir untersuchen, wie Betrüger generative KI als Waffe einsetzen - von gefälschten Identitäten bis hin zu synthetischen Identitäten - und skizzieren Technologien und Strategien (einschließlich fortschrittlicher Erkennungstools wie TruthScan), die Betrugsteams und Führungskräfte einsetzen können, um dieser sich entwickelnden Bedrohung zu begegnen.

Die wichtigsten AI-Betrugstrends bei Finanzdienstleistungen

KI und maschinelles Lernen werden von bösartigen Akteuren genutzt, um Betrug in größerem Umfang und raffinierter durchzuführen. Bemerkenswert KI-gesteuerte Betrugstaktiken die sich auf Banken, Fintechs und Versicherer auswirken, sind:

- Deepfake-Imitationsbetrug: Kriminelle nutzen KI-generiertes Video und Audio um sich in Echtzeit als vertrauenswürdige Personen (CEOs, Kunden usw.) auszugeben. So wurden beispielsweise lebensechte, gefälschte Stimmen bei Vishing-Angriffen (Voice-Phishing) eingesetzt, um betrügerische Überweisungen zu genehmigen, und mit Hilfe von KI erstellte Videos haben Angestellte dazu gebracht, gefälschte Transaktionen zu genehmigen[1][5]. Diese synthetischen Medien erschweren es, festzustellen, ob man wirklich mit der Person spricht, für die man sich hält, und ermöglichen so Raubüberfälle von hohem Wert wie den oben beschriebenen $25M-Deepfake-Fall. Deepfakes werden immer erschwinglich und einfach zu produzierenSie benötigen nur 20-30 Sekunden Audio, um eine Stimme zu klonen, oder weniger als eine Stunde, um ein scheinbar authentisches Video zu erstellen.[6].

- KI-gestütztes Phishing und BEC: Generative KI beschleunigt Social-Engineering-Methoden wie Phishing-E-Mails und Kompromittierung von Geschäfts-E-Mails (BEC). KI-Chatbots können hochgradig personalisierte Betrugs-E-Mails in perfekter Geschäftssprache verfassen, den Schreibstil eines Geschäftsführers imitieren oder in großem Umfang überzeugende gefälschte Lieferantenrechnungen erstellen. In der Tat, Untergrund-Tools wie FraudGPT und WormGPT (ungefilterte Versionen von ChatGPT) sind aufgetaucht, um Cyberkriminelle bei der automatischen Erstellung von Phishing- und Malware zu unterstützen[7][8]. Das bedeutet, dass ein Möchtegern-Betrüger mit minimalen Kenntnissen mühelos ausgefeilte Phishing-Kampagnen oder bösartigen Code erstellen kann. Mit KI kann ein einziger Krimineller Tausende von maßgeschneiderten betrügerischen E-Mails oder Textnachrichten verschicken und so die Reichweite herkömmlicher Betrugsversuche erheblich vergrößern. Das Internet Crime Center des FBI hat bereits Folgendes beobachtet über $2,7 Milliarden durch BEC-Betrug im Jahr 2022 verloren, und die generative KI droht diese Verluste in den kommenden Jahren noch weiter zu erhöhen[9][10].

- Synthetische Identitäten und Dokumentenbetrug: Generative KI führt zu einem Boom bei synthetischem Identitätsbetrugeine der am schnellsten wachsenden Arten der Finanzkriminalität[11][12]. Betrüger kombinieren echte und gefälschte persönliche Daten, um "Frankenstein"-Identitäten zu schaffen, und nutzen dann KI, um realistische Belege vorlegen - von gefälschten Pässen und Kontoauszügen bis hin zu Lohnabrechnungen[7]. AI-Bildgeneratoren und -Bearbeitungstools können Folgendes fälschen authentisch aussehende IDs und Fotos die einer zufälligen Prüfung standhalten. Selbst die Überprüfung der Echtheit oder die Überprüfung von Selfies kann durch KI-manipulierte Bilder oder Videos umgangen werden. Durch die automatische Erstellung tausender falscher Identitäten (mit KI-generierten Profilbildern, sozialen Medien usw.) können Kriminelle massenhaft Bankkonten eröffnen oder Kredite beantragen und Geld waschen oder Kredite ausfallen lassen. Die Verluste durch synthetischen Identitätsbetrug wurden auf etwa $35 Milliarden im Jahr 2023[13]und die generative KI beschleunigt diesen Trend noch, indem sie gefälschte Identitäten billiger und schwieriger zu erkennen macht.

- Automatisierter Betrug und Hinterziehung: KI hilft nicht nur bei der Erstellung gefälschter Inhalte, sondern auch bei Betrügereien den Erfolg ihrer Vorhaben zu maximieren. Fortgeschrittene Bots können gestohlene Kreditkartendaten auf E-Commerce-Websites schnell testen, indem sie ML nutzen, um Erkennungsauslöser zu umgehen. KI kann Kriminellen dabei helfen, die schwächsten Glieder in der Sicherheit eines Unternehmens zu identifizieren oder sogar Sprachantworten zu synthetisieren, um die telefonische Identitätsprüfung zu umgehen. Eine kleine Industrie im Dark Web verkauft jetzt KI-Tools für "Betrug als Dienstleistung" für nur $20[14]. Diese Demokratisierung der KI-Fähigkeiten bedeutet, dass selbst Kriminelle auf niedriger Ebene hochentwickelte Betrugsangriffe starten können. Das Wettrüsten erstreckt sich auch auf die Umgehung der Entdeckung - Betrüger nutzen KI, um die Betrugsbekämpfungssysteme der Banken zu testen und ihre Vorgehensweise zu verfeinern, bis sie eine Methode finden, die durch die Filter schlüpft[15]. Kurz gesagt, KI ermöglicht es, Betrug zu begehen in einem nie dagewesenen Umfang und mit einer nie dagewesenen Effizienzund stellt die konventionelle Verteidigung in Frage.

Diese KI-gestützten Taktiken sind bereits sich mit alarmierender Geschwindigkeit vermehren. Traditionelle Betrugsmaschen wie Scheckfälschung oder Phishing gibt es schon seit Jahren, aber die KI steigert deren Umfang und Realitätsnähe. Die Daten sprechen eine deutliche Sprache: KI-Betrug ist Surfen.

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

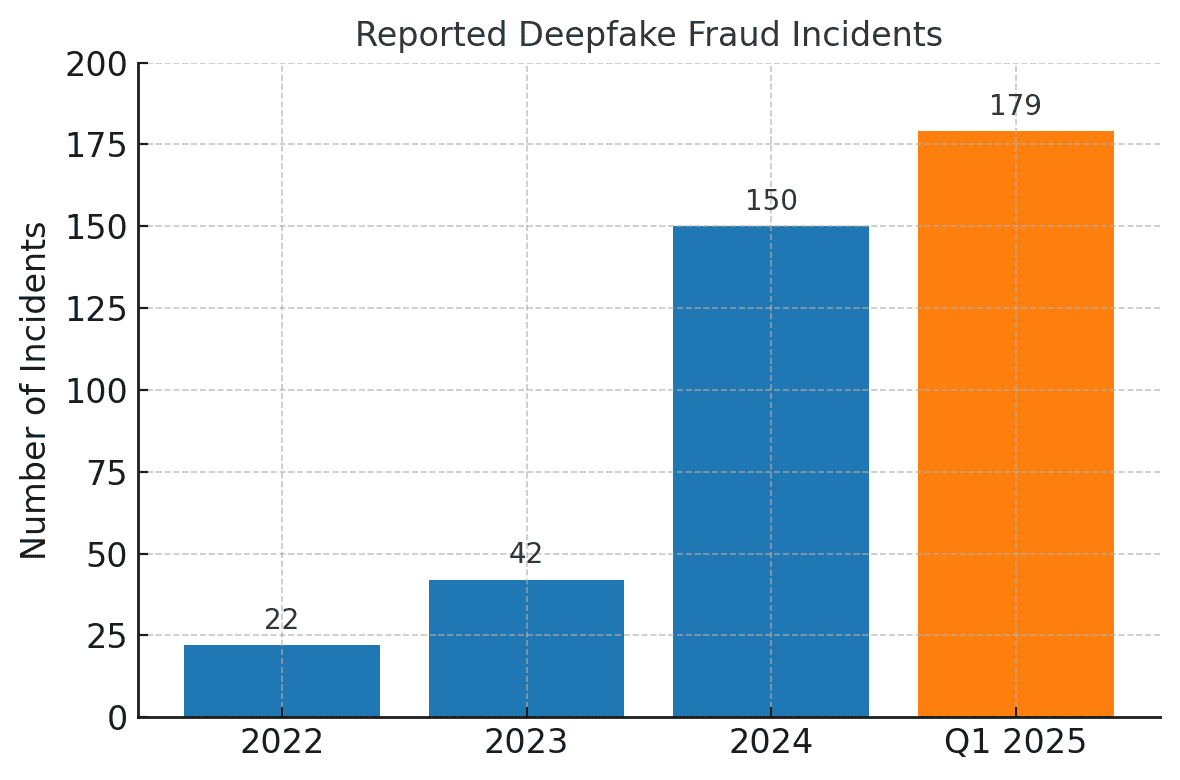

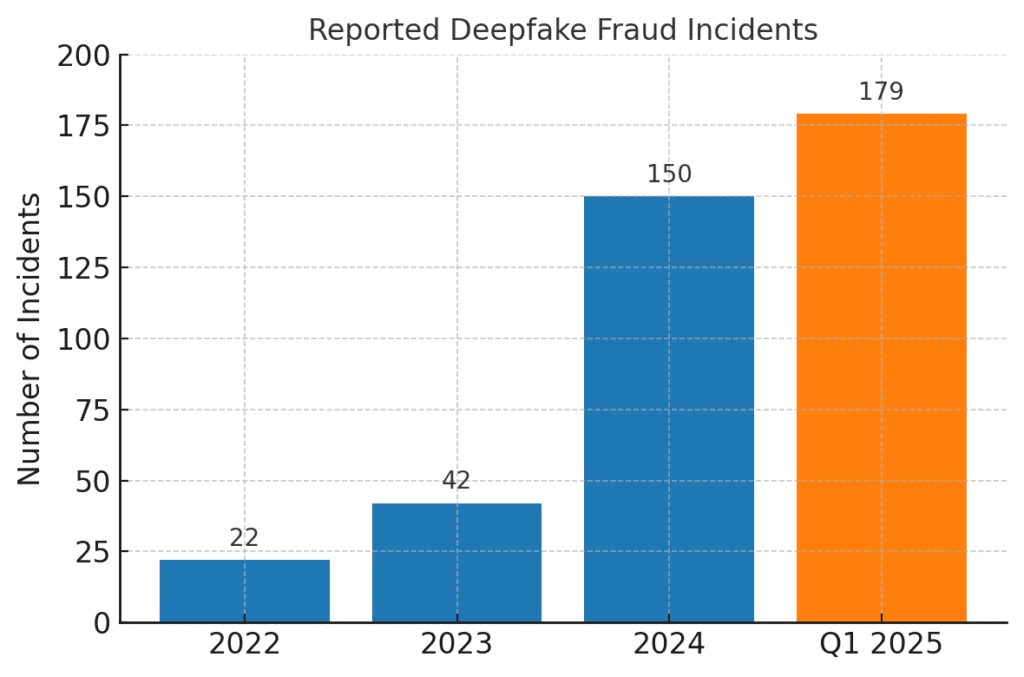

Die Zahl der Betrugsfälle im Zusammenhang mit Deepfake ist sprunghaft angestiegen. Im Jahr 2022 wurden nur 22 Deepfake-Betrugsfälle registriert, aber 2023 waren es 42 und 2024 explodierten die Vorfälle auf 150. Allein im ersten Quartal 2025, 179 Vorfälle von Deepfake-Betrug wurden gemeldet - mehr als für das gesamte Jahr 2024[16][17].

Jüngste Branchenanalysen spiegeln diese Trends wider. Einem Bericht zufolge ist ein 700% Anstieg der Deepfake-Vorfälle Fintech-Unternehmen im Jahr 2023 anvisieren[18]. Noch erschreckender ist, dass in Nordamerika ein 1,740% Anstieg der Betrugsfälle durch Fälschungen zwischen 2022 und 2023[19]. Finanzkriminelle übernehmen diese Werkzeuge schnell, weil sie funktionieren - viele Banken und Opfer sind noch nicht darauf vorbereitet, durch KI erzeugte Täuschungen zu erkennen.

Auswirkungen und Herausforderungen für Finanzinstitute

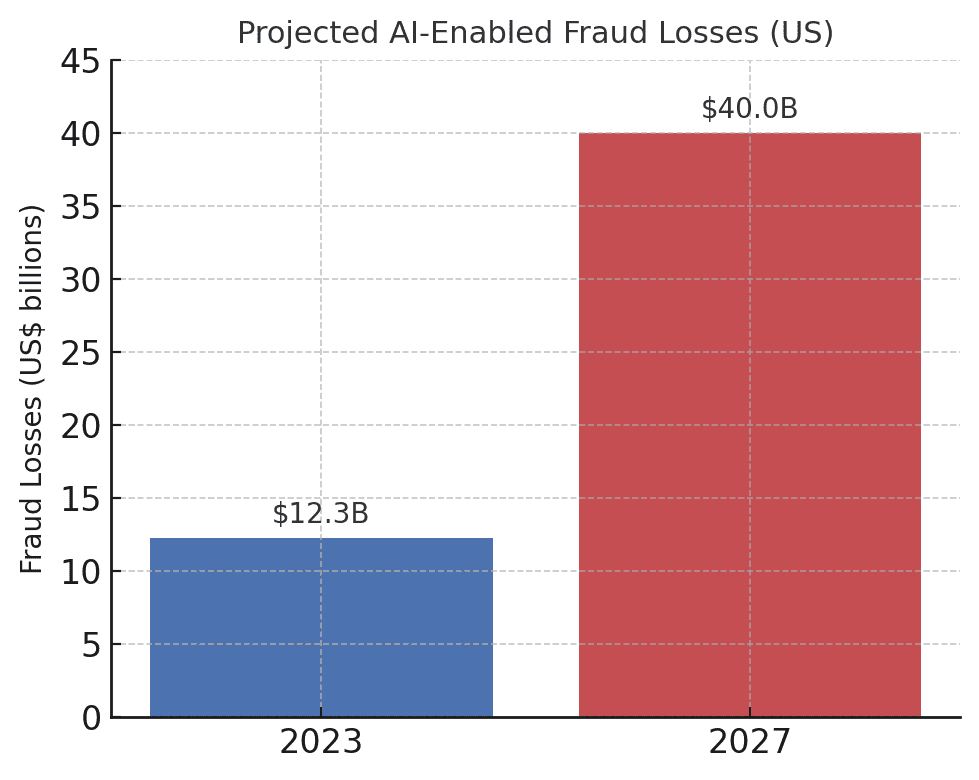

Der Anstieg von KI-gesteuertem Betrug stellt erhebliche Auswirkungen auf Finanzinstitute, ihre Kunden und das Finanzsystem im Allgemeinen. Die unmittelbarste Auswirkung ist der finanzielle Verlust. Branchenprognosen gehen davon aus, dass bis 2027, Betrugsverluste, die durch generative KI ermöglicht werden, könnten in den USA $40 Milliarden erreichenAnstieg von $12,3 Milliarden im Jahr 2023[20]. Dieser mehr als dreifache Anstieg (ein 32% CAGR) spiegelt wider, wie schnell das Betrugsrisiko in Dollar ausgedrückt wächst.

Die prognostizierten Verluste durch KI-gestützten Betrug steigen dramatisch an. Deloitte schätzt, dass die Verluste durch Finanzbetrug in Verbindung mit generativer KI in den USA von $12,3 Milliarden im Jahr 2023 bis $40 Milliarden bis 2027[20].

Neben den reinen Verlusten gibt es auch Reputationsverluste und Treuhandkosten. Die Verbraucher erwarten von ihren Banken, dass sie sie schützen - aber Betrügereien, die KI nutzen, untergraben das Vertrauen in digitale Kanäle. Wenn ein Kunde beispielsweise Opfer eines überzeugenden Deepfake-Betrugs wird (z. B. eines gefälschten Videoanrufs eines Bankangestellten), kann er die Bank für unzureichende Sicherheit verantwortlich machen. Öffentliches Vertrauen bei der Sprachüberprüfung, bei E-Mails und sogar bei Videokonferenzen kann untergehen, wenn das, was man sieht/hört, nicht mehr als real angenommen werden kann[21]. Umfragen zufolge betrachten 85% der Finanzfachleute in den USA/im Vereinigten Königreich Deepfake-Betrug als "existenzielle" Bedrohung für die Sicherheit ihres Unternehmens[22]. Mehr als die Hälfte der Unternehmen in diesen Märkten berichten, dass sie von einem Deepfake-Betrug betroffen sind, und alarmierenderweise 43% der betroffenen Personen gaben zu, dass der Angriff erfolgreich war sie zu täuschen[23]. Jeder erfolgreiche Vorfall verursacht nicht nur einen finanziellen Schaden, sondern untergräbt auch das Vertrauen der Kunden in das Institut.

Die Finanzunternehmen haben auch mit folgenden Problemen zu kämpfen operative und Compliance-Herausforderungen von KI-Betrug. Betrugsbekämpfungsteams sehen sich mit einer Flut von Warnungen und Vorfällen konfrontiert, was die Ermittlungsressourcen überfordert. Bestehende Betrugserkennungsmodelle (von denen viele auf Regeln oder älteren maschinellen Lerntechniken beruhen) haben möglicherweise Probleme, KI-synthetisierte Inhalte zu erkennen, die legitim aussehen. Tatsächlich sinkt die Genauigkeit von in Labors entwickelten hochmodernen Deepfake-Erkennungssystemen um fast 50%, wenn sie mit echte Deepfakes in freier Wildbahn[24]. Menschliches Personal schneidet nicht viel besser ab - Studien haben ergeben, dass Menschen qualitativ hochwertige Deepfake-Videos nur um die Hälfte erkennen können. 55%-60% der Zeitkaum besser als der Zufall[25]. Dies deutet darauf hin, dass die Banken ohne neue Tools einen großen Teil der KI-gesteuerten Betrugsversuche übersehen werden.

Außerdem gibt es eine regulatorische Dimension. Aufsichtsbehörden und Strafverfolgungsbehörden sind sich der Risiken bewusst (wie die FinCEN-Warnung zeigt) und erwarten von den Finanzinstituten, dass sie sich anpassen. Banken könnten im Zeitalter der KI mit strengeren Richtlinien für die Überprüfung von Kunden und die Meldung von Betrug konfrontiert werden. Wenn beispielsweise ein Bankangestellter durch einen Deepfake dazu verleitet wird, eine Überweisung in Höhe von $10 Millionen zu genehmigen, könnten die Aufsichtsbehörden die Kontrollen und Sorgfaltspflichten der Bank unter die Lupe nehmen. Die Bankgeheimnisgesetz umfasst nun ausdrücklich die Meldung von Verdachtsfällen von Cyberkriminalität und Deepfake-Aktivitäten[26][4]Das bedeutet, dass die Banken ihre Mitarbeiter darin schulen müssen, KI-generierte Betrugsindikatoren zu erkennen und in Verdachtsmeldungen zu melden. Ein Versäumnis, mit KI-gestützten Betrugstechniken Schritt zu halten, könnte zu Compliance-Verstößen oder rechtlicher Haftung führen, wenn Kunden oder Gegenparteien argumentieren, dass die Bank nicht genug getan hat, um vorhersehbare KI-gestützte Betrügereien zu verhindern.

Die vielleicht größte Herausforderung ist die die asymmetrische Natur dieser neuen Bedrohung. Generative KI senkt die Kosten und die Qualifikationshürde für Angreifer erheblich, während gleichzeitig der Umfang und der Realismus der Angriffe exponentiell zunehmen. Ein einziges virales Deepfake-Gerücht oder ein überzeugender Stimmenklon-Anruf kann Millionen von Dollar an Authentifizierungsinvestitionen zunichte machen. In der Zwischenzeit müssen die Verteidiger die Authentizität jeder Transaktion und Interaktion überprüfen - eine viel schwierigere Aufgabe. Es ist wirklich ein Wettrüsten: KI gibt Betrügern ein sich selbst aktualisierendes Instrumentarium an die Hand, mit dem sie die Sicherheit umgehen können, so dass auch die Banken ihre Verteidigungsmaßnahmen ständig aktualisieren müssen.[15][27]. Viele Finanzinstitute geben zu, dass sie nicht ausreichend vorbereitet sind - über 80% der Unternehmen haben keinen formellen Reaktionsplan für Deepfake-Angriffeund mehr als die Hälfte haben ihre Mitarbeiter nicht über Deepfake-Risiken geschult[28][29]. Diese Bereitschaftslücke bedeutet, dass Organisationen derzeit gefährdet sind, zeigt aber auch, wo Handlungsbedarf besteht.

Eine bemerkenswerte und ernüchternde Kennzahl stammt aus einem aktuellen Branchenbericht: 42,5% der Betrugsversuche im Finanzsektor sind inzwischen auf irgendeine Form von KI zurückzuführen[30]. Mit anderen Worten: Fast die Hälfte der Betrugsangriffe, mit denen Banken konfrontiert werden, haben eine KI-Komponente - sei es ein KI-generiertes Dokument, eine synthetische Stimme oder eine maschinell erzeugte Phishing-Nachricht. Diese Statistik unterstreicht, dass KI keine hypothetische zukünftige Bedrohung ist. Sie ist bereits da und zwingt Finanzinstitute dazu, sich anzupassen oder mit steigenden Verlusten zu rechnen.

Verteidigung gegen KI-gestützten Betrug: Strategien und Lösungen

Die Bekämpfung von KI-gesteuertem Betrug erfordert eine Weiterentwicklung der Betrugspräventionsstrategien. Herkömmliche Ansätze (wie manuelle Überprüfung oder statische Regel-Engines) sind den sich wandelnden KI-Betrügereien nicht gewachsen. Stattdessen müssen sich die Banken technology (like making sure they have a Secure SSL Certificate), training, and teamwork um das Blatt zu wenden. Im Folgenden werden wichtige Strategien und neue Lösungen vorgestellt:

- Einsatz von KI zur Bekämpfung von KI (fortgeschrittene Erkennungswerkzeuge): Die Finanzinstitute wenden sich zunehmend an KI-gestützte Erkennungslösungen um KI-generierte Inhalte und Anomalien zu erkennen. Im Grunde genommen müssen Sie Feuer mit Feuer bekämpfen. Neue Unternehmenstools wie TruthScan eine multimodale KI-Erkennung für Text, Bilder, Sprache und Video bieten, um die Authentifizierung von Inhalten in Echtzeit zu unterstützen[31]. So können Banken beispielsweise KI-Textdetektoren einsetzen, um eingehende Kommunikation (E-Mails, Chat-Nachrichten) auf Anzeichen von KI-generierter Sprache zu scannen, die auf eine Phishing-E-Mail oder eine gefälschte Kundenanfrage hindeuten könnten. Das KI-Texterkennungssystem von TruthScan kann KI-generierte Inhalte aus Modellen wie GPT-4 mit 99%+ Genauigkeitund sogar feststellen, welche Sätze wahrscheinlich von einer KI generiert wurden[32][33]. In ähnlicher Weise können KI-Tools für die Bildforensik Dokumente und Bilder verifizieren; ein AI-Bild-Detektor kann erkennen, ob ein vorgelegter Führerschein oder eine Rechnung eines Versorgungsunternehmens digital erstellt oder manipuliert wurde, indem es sie mit bekannten Mustern von KI-generierten Bildern vergleicht[34]. Für Audio-Bedrohungen verwenden die Banken jetzt Stimmverfälschungsdetektoren - Lösungen, die Anrufe auf die akustischen Fingerabdrücke von synthetischer Sprache analysieren. Der AI Voice Detector von TruthScan zum Beispiel sucht nach verräterischen Anzeichen für das Klonen von Stimmen und kann Überprüfung der Authentizität des Sprechers zur Verhinderung falscher Anrufe[35]. Durch die Integration dieser Detektoren über API in ihre Arbeitsabläufe können Finanzinstitute automatisch auf KI-Inhalte im Hintergrund von Transaktionen und Interaktionen prüfen. Dies stellt eine zusätzliche Verteidigungsebene dar, die mit Maschinengeschwindigkeit arbeitet und das auffängt, was menschliche Augen/Ohren möglicherweise übersehen.

- Implementierung von Multi-Faktor- und Out-of-Band-Verifizierung: Da es durch KI immer schwieriger wird, Stimmen oder Bildern zu vertrauen, sollten Banken verstärkt auf Verifizierungsmethoden setzen, die KI nicht so leicht fälschen kann. Dazu gehört die Multi-Faktor-Authentifizierung (MFA) über sichere Kanäle. Wenn beispielsweise eine Überweisungsanfrage per E-Mail oder Videoanruf kommt, sollte ein zweiter Faktor wie ein einmaliger Passcode, der an das bekannte Mobilgerät des Antragstellers gesendet wird, oder ein Rückruf auf eine vertrauenswürdige Telefonnummer in der Datei verlangt werden. Einige Banken fügen für risikoreiche Transaktionen "Aktivitätsprüfungen" hinzu, indem sie den Kunden z. B. bitten, ein Live-Selfie mit einer bestimmten Geste oder einem bestimmten Wort zu machen, was für ein Deepfake-Video schwieriger zu replizieren ist. Biometrische Authentifikatoren können mit Anti-Spoofing-Maßnahmen erweitert werden (z. B. Scannen nach 3D-Gesichtstiefe oder Überwachung der subtilen Augenbewegungen, die von Deepfakes oft nicht nachgeahmt werden können).[27]). Der Schlüssel liegt darin, einzelne Schwachstellen zu vermeiden. Selbst wenn eine künstliche Intelligenz einen Kanal täuschen kann (z. B. die Stimmverifizierung), kann eine koordinierte Out-of-Band-Prüfung oder ein biometrischer Test die notwendige Herausforderung bieten, um den Betrug aufzudecken. Null-Vertrauens-Prinzipien sollte angewandt werden: Jede unaufgeforderte oder unerwartete Anweisung (selbst von einer "bekannten" Führungskraft oder einem Kunden) sollte als verdächtig betrachtet werden, bis sie von unabhängiger Seite überprüft wurde.

- Mitarbeiterschulung und Sensibilisierung für Betrug: Technologie allein ist kein Allheilmittel - vor allem, weil Betrüger auf das schwächste Glied abzielen, und das ist oft das menschliche Vertrauen. Finanzinstitute sollten in regelmäßige Schulungen für Betrugspräventionsteams und Mitarbeiter an der Front über KI-basierte Betrügereien investieren. Die Mitarbeiter müssen lernen, die roten Fahnen von Deepfakes und Social Engineering zu erkennen. Dies könnte auch Schulungen zu subtilen Anomalien umfassen (z. B. Lippensynchronitätsprobleme in einem Videoanruf oder Audio mit unnatürlicher Intonation oder zu wenig Hintergrundgeräuschen - mögliche Anzeichen für eine synthetische Stimme). Ermutigung zu einer Kultur der ÜberprüfungDie Mitarbeiter sollten sich befugt fühlen, eine verdächtige Transaktion oder Anfrage anzuhalten und unabhängig zu überprüfen, auch wenn sie scheinbar vom CEO stammt. Der Fall des Versuch, die Stimme des Ferrari-CEO zu fälschen ist aufschlussreich - ein Exekutivbeamter deckte den Betrug nur auf, indem er eine persönliche Frage stellte, die der Hochstapler nicht beantworten konnte[36]. Simulierte Phishing-/Depfake-Übungen können ebenfalls nützlich sein. So wie Unternehmen Phishing-Simulationen durchführen, um ihre Mitarbeiter zu schulen, können sie auch eine gefälschte Sprachnachricht oder ein gefälschtes Videomeeting simulieren und prüfen, ob die Mitarbeiter dies erkennen. Auf diese Weise wird das Muskelgedächtnis für die Abwehr echter Angriffe geschult. Angesichts der Tatsache, dass mehr als 50% der Unternehmen haben keine Deepfake-Reaktionsprotokolle und nur wenige Schulungen durchgeführt[29]Die Einführung solcher Programme ist ein leichtes Unterfangen, um die Widerstandsfähigkeit zu verbessern.

- Betrugsanalyse und Erkennung von Anomalien: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier klingt AI-generiert oder übermäßig formelhaft (in Verbindung mit der bereits erwähnten KI-Texterkennung). Banken wie JPMorgan haben damit begonnen, umfangreiche Sprachmodelle für ihre interne Kommunikation zu verwenden, um Sätze oder Kontexte zu erkennen, die auf einen Social-Engineering-Versuch hindeuten könnten[37]. Zahlungsnetzwerke wie Mastercard scannen riesige Datensätze (Milliarden von Transaktionen) mit Hilfe von KI, um betrügerische Transaktionen zu erkennen, die bei herkömmlichen Regeln übersehen würden[38]. Die Schlussfolgerung ist, dass defensive KI muss ebenso innovativ sein wie offensive KI. Unternehmen sollten in Erwägung ziehen, KI-Modelle speziell zur Erkennung von Deepfake-Inhalten, synthetischen Identitäten und generativen Angriffsmustern zu entwickeln oder zu erwerben. Entscheidend ist, dass diese Modelle kontinuierlich an den neuesten Beispielen von KI-Betrug trainiert werden (eine Praxis, die als Online-Lernen oder föderiertes Lernen bezeichnet wird), damit sie mit den sich schnell entwickelnden Taktiken der Kriminellen Schritt halten[39][40].

- Zusammenarbeit und Informationsaustausch: Die Bekämpfung von KI-gestütztem Betrug erfordert eine Zusammenarbeit sowohl innerhalb als auch zwischen den Institutionen. Silo-Bemühungen sind weniger effektiv gegen eine Bedrohung, die Organisationsgrenzen überschreitet. Betrugspräventionsteams, Cybersicherheitsteams und IT Sicherheitsteams können zum Beispiel Deepfake-Erkennung in Videokonferenz-Tools einsetzen, während Betrugsteams Inhaltsscans in die Transaktionsüberwachung integrieren. Auf breiterer Ebene sollten sich Banken an Branchengruppen wie dem Financial Services Information Sharing and Analysis Center (FS-ISAC) beteiligen, um Informationen über neue KI-Betrugsmethoden auszutauschen[41]. Wenn eine Bank einen neuen Deepfake-Angriffsvektor entdeckt, kann der Austausch dieser Erkenntnisse anderen helfen, die Lücke zu schließen, bevor sie selbst betroffen sind. Gemeinsame Übungen oder "Red Team"-Simulationen mit Szenarien, die KI beinhalten (z. B. ein Deepfake-Betrug der Geschäftsleitung oder die Umgehung einer KI-generierten ID-Verifizierung), können über Branchenkonsortien oder mit Unterstützung der Aufsichtsbehörden durchgeführt werden. Die Aufsichtsbehörden selbst konzentrieren sich auf KI-Risiken, daher ist es sinnvoll, proaktiv mit ihnen zusammenzuarbeiten. Indem sie zu Standards und Richtlinien für den Einsatz von KI beitragen, können die Banken dazu beitragen, ein sichereres Ökosystem zu schaffen. Letztlich, da eine Bedrohung für eine Bank ist eine Bedrohung für alle in diesem Raum[42]Ein kollektiver Verteidigungsansatz wird die Fähigkeit aller Beteiligten stärken, KI-gestützten Betrug aufzudecken und zu verhindern.

- Kundenerziehung und Vertrauensmaßnahmen: Schließlich sollten die Finanzinstitute die Rolle der Kundenaufklärung nicht übersehen. Angesichts von Deepfakes und KI-Betrügereien, die auf die breite Öffentlichkeit abzielen (z. B. gefälschte Stimmen bei Großeltern-Betrügereien oder gefälschte, von KI generierte "Tech-Support"-Chats), können Banken dazu beitragen, die Kunden über diese Gefahren aufzuklären. Viele Banken versenden bereits Warnmeldungen über Phishing; sie können diese auf das Klonen von KI-Stimmen und Deepfake-Videos ausweiten und Tipps zur Überprüfung von Anfragen geben. Einige fortschrittliche Organisationen versenden Push-Benachrichtigungen oder Warnungen in ihren Apps, wenn eine bekannte Betrugsmasche im Umlauf ist (z. B. "Vorsicht: Betrüger können Stimmenklone von Familienmitgliedern verwenden und um Geld bitten")[43]. Auch wenn Angriffe nicht direkt verhindert werden können, kann die Aufklärung die Erfolgsquote senken und die Bank als Partner in Sachen Sicherheit stärken. Darüber hinaus sollten Banken, die in modernste Betrugsprävention investieren, dies den Kunden als Unterscheidungsmerkmal - Wenn Kunden beispielsweise wissen, dass alle Videoanrufe oder eingereichten Dokumente von KI auf ihre Echtheit geprüft werden (ohne sensible Methoden preiszugeben), können sie sicher sein, dass die Bank jedes verfügbare Instrument zu ihrem Schutz einsetzt. Der Erhalt des digitalen Vertrauens wird für Banken entscheidend sein, um die Vorteile der KI im Dienstleistungsbereich voll ausschöpfen zu können, daher sind Transparenz und kundenorientierte Schutzmaßnahmen Teil einer ganzheitlichen Verteidigung.

Die Rolle von AI Content Detection Services

Ein Eckpfeiler des Instrumentariums zur Betrugsbekämpfung im Zeitalter der KI ist der Einsatz von AI-Inhaltserkennungsdienste. Diese Dienste sind darauf spezialisiert, die "Fingerabdrücke" von KI-generierten Inhalten aufzuspüren, die menschlichen Prüfern entgehen könnten. TruthScan ist ein solcher Anbieter, der ein unternehmensgerechtes AI Detection Suite die mehrere Inhaltstypen umfassen. Finanzinstitute können diese Tools integrieren, um automatisch nach Fälschungs- und Betrugsindikatoren zu suchen:

- Überprüfung von Dokumenten und Bildern: Die Plattform von TruthScan ermöglicht den Banken Prüfung von Finanzdokumenten auf KI-generierten Betrug in Echtzeit[44]. Das heißt, wenn ein neues Konto eröffnet wird oder ein Kreditantrag mit einem Lichtbildausweis und einer Gehaltsabrechnung eingeht, kann das System diese Bilder sofort auf Anzeichen einer synthetischen Erstellung oder Manipulation analysieren. Mit über 99% Zielgenauigkeit[45]kann der AI Image Detector gefälschte ID-Bilder oder manipulierte PDFs erkennen, die ein Mensch für bare Münze nehmen würde. Diese Art von Überprüfung der Echtheit von Dokumenten ist von entscheidender Bedeutung, um synthetischen Identitätsbetrug zu verhindern, bevor Konten überhaupt eröffnet werden.

- Transaktionsüberwachung in Echtzeit: Durch den Einsatz von API-Integrationen kann sich TruthScan in die Transaktionsverarbeitung der Banken einklinken und Anomalien in Realzeit. Wenn eine Anweisung per E-Mail kommt, die verdächtig erscheint, kann der E-Mail-Betrugsdetektor den Inhalt der Nachricht analysieren und erkennen, ob sie wahrscheinlich von einem KI-Modell geschrieben wurde, das versucht, einen Anbieter oder eine Führungskraft zu täuschen[46]. Ähnlich verhält es sich mit der AI-Echtzeit-Detektor kann die Live-Kommunikation (z. B. Chats oder Kollaborationsplattformen) überwachen, um sofortige Warnungen auszusenden, wenn z. B. ein gefälschter Deepfake-Video-Feed während einer wichtigen Sitzung entdeckt wird[47][48]. Die kontinuierliche Überwachung mit sofortigen Warnmeldungen und automatischen Reaktionen trägt dazu bei, das Zeitfenster zu verkleinern, in dem Betrug unentdeckt bleiben kann.

- Sprach- und Video-Deepfake-Verteidigung: Für Call Center und Kundenbetreuer ist die Einbeziehung von TruthScan's AI Sprachdetektor fügt eine zusätzliche Sicherheitsebene hinzu. Wenn ein Betrüger anruft und sich als Kunde ausgibt, indem er einen Stimmenklon verwendet, kann das System den Ton des Anrufs analysieren und anzeigen, ob er KI-synthetisierte Elemente enthält (z. B. fehlende natürliche Mikropausen oder Artefakte in den Schallwellen)[35]. An der Videofront ist die Deepfake-Detektor wendet Computer-Vision-Algorithmen auf Videobilder an, um Ungereimtheiten wie unnatürliche Gesichtsbewegungen, merkwürdige Beleuchtung oder unpassende Lippensynchronität zu erkennen, die auf eine Fälschung hindeuten[49][50]. Indem sie die Integrität von Stimmen und Gesichtern bei wichtigen Interaktionen überprüfen, können Banken Betrügern das Handwerk legen, die versuchen, ihre Mitarbeiter zu täuschen. Diese Tools wirken wie ein Hightech-Lügendetektor für digitale Inhalte, der unsichtbar im Hintergrund arbeitet.

Es sei darauf hingewiesen, dass der Einsatz einer solchen Erkennungstechnologie kein "Plug-and-Play"-Allheilmittel ist; sie sollte kalibriert und auf die Arbeitsabläufe der Institution abgestimmt werden. Fehlalarme müssen vermieden werden (ein KI-Textdetektor könnte beispielsweise legitime Kommunikation auf der Grundlage von Vorlagen als verdächtig einstufen, bis er den Unterschied erkennt). Wenn diese Tools jedoch richtig integriert sind, verbessern sie die Fähigkeit einer Organisation deutlich betrügerische Inhalte erkennen, bevor sie Schaden anrichten. Außerdem erstellen sie Prüfpfade und analytische Berichte, die für die Einhaltung der Vorschriften und die kontinuierliche Verbesserung der Betrugsmodelle nützlich sind.

Entscheidend für die Wirksamkeit von KI-Erkennungsinstrumenten ist, dass ständige Aktualisierungen. Genauso wie Antivirensoftware neue Signaturen für neue Viren benötigt, müssen KI-Detektoren auf die neuesten Deepfake-Techniken und KI-Modelle umgeschult werden. Anbieter wie TruthScan aktualisieren ihre Algorithmen, um mit neuen generativen Modellen und Umgehungstaktiken umzugehen und eine hohe Genauigkeit zu gewährleisten, auch wenn sich die KI weiterentwickelt.[51]. Dies entlastet die internen Teams und stellt sicher, dass die Banken nicht den Krieg von gestern führen, während die Kriminellen zu neuen KI-Tricks übergehen.

Schlussfolgerung

Die Finanzdienstleistungsbranche steht im Kampf gegen Betrug an einem Scheideweg. Auf der einen Seite machen sich Kriminelle die generative KI zunutze, um Betrugsversuche zu starten, die überzeugender und verbreiteter sind als je zuvor. Auf der anderen Seite steht den Banken und Betrugsbekämpfern ein wachsendes Arsenal an KI-gesteuerten Abwehrmaßnahmen zur Verfügung. Die Institute, die erfolgreich sein werden, sind diejenigen, die die neue Bedrohungslandschaft zu erkennen und mit dem gleichen Einfallsreichtum zu reagieren. Das bedeutet, dass wir in fortschrittliche Erkennungsfunktionen investieren, mehrschichtige Überprüfungsverfahren integrieren, Mitarbeiter und Kunden schulen und eine Kultur der Wachsamkeit und Anpassung fördern müssen.

KI-gestützter Betrug ist ein schnelllebiges Ziel - der Deepfake-Betrug, mit dem ein Unternehmen heute getäuscht wurde, kann morgen durch neue Erkennungstechniken bekämpft werden, nur damit die Betrüger nächste Woche ihre Methoden ändern. Eine "branchenübliche" Strategie zur Betrugsprävention im Jahr 2025 ist daher eine, die auf Flexibilität und kontinuierliche Verbesserung setzt. Finanzunternehmen sollten ihre Betrugsabwehrsysteme als lebende, lernende Wesen die sich im Gleichschritt mit kriminellen Taktiken entwickeln. Die Nutzung von Partnerschaften mit Technologieanbietern ist eine intelligente Abkürzung zum Aufbau dieser Fähigkeiten. So kann beispielsweise die Zusammenarbeit mit spezialisierten Unternehmen wie TruthScan (das auf das Bank- und Finanzwesen zugeschnittene Lösungen anbietet) die Fähigkeit einer Institution beschleunigen KI-gestützten Betrug zu verhindern und gleichzeitig die Einhaltung von Vorschriften und das Vertrauen der Kunden zu wahren[52].

Letztlich geht es beim Schutz vor KI-gesteuertem Betrug nicht nur um Technologie, sondern um den Erhalt der grundlegenden Vertrauen die dem Finanzwesen zugrunde liegt. Kunden müssen darauf vertrauen können, dass ihre Bank eine echte Transaktion von einer Fälschung, einen echten Kunden von einem KI-Betrüger unterscheiden kann. Durch den Einsatz modernster KI-Erkennungstools, die Verstärkung von Verifizierungsprotokollen und einen Vorsprung vor neuen Bedrohungen können Finanzdienstleister dieses Vertrauen aufrechterhalten. Die Zukunft wird zweifellos noch mehr Betrugsversuche von Gegnern bringen, aber mit der richtigen Vorbereitung und den richtigen Investitionen können Banken sicherstellen, dass KI wird eher ein Vorteil als eine Bedrohung im Bereich der Betrugsbekämpfung. Es ist ein erreichbares Ziel: Die gleichen KI-Technologien, die zu stören drohen, können genutzt werden, um die Integrität unseres Finanzsystems zu schützen. Jetzt ist es an der Zeit, dass Betrugspräventionsteams und Führungskräfte entschlossen handeln, Einsatz fortschrittlicher Lösungen und Strategien, um die Betrüger zu überlisten und sichern die Zukunft des digitalen Finanzwesens.

Quellen: Jüngste Branchenberichte, Warnungen vor Vorschriften und Technologie-Whitepapers wurden durchgehend berücksichtigt (Deloitte[20][18], Weltwirtschaftsforum[19][24]U.S. Finanzministerium FinCEN[3][4]Federal Reserve[13], Keepnet Labs[16][30](u.a.), um Daten und Beispiele zu liefern. Alle Daten und Beispiele werden inline zitiert, damit der Leser sie weiter untersuchen kann.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake-Banking und KI-Betrugsrisiko | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Die Erkennung von gefährlicher KI ist in der Deepfake-Ära unerlässlich | World Economic Forum

[3] [4] [26] FinCEN veröffentlicht Warnung vor Betrugsversuchen mit Deepfake Media, die auf Finanzinstitute abzielen | FinCEN.gov

[7] [8] FraudGPT und GenAI: Wie werden Betrüger KI als nächstes einsetzen? | Alloy

[11] Synthetischer Identitätsbetrug: Wie KI das Spiel verändert - Federal Reserve Bank of Boston

[12] [13] Generative künstliche Intelligenz erhöht die Bedrohung durch synthetischen Identitätsbetrug

[16] [17] [22] [23] [28] [29] [30] Deepfake-Statistiken & Trends 2025 | Schlüsseldaten & Einblicke - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - KI-Erkennung und Content-Sicherheit für Unternehmen

[32] [33] [51] AI Detektor: AI-Texterkennung auf Unternehmensebene - TruthScan

[44] [45] [52] Banking AI Fraud Detection | CRO Solutions | TruthScan

[49] [50] Deepfake Detector - Identifizieren Sie gefälschte & AI Videos - TruthScan