Ein umfassender Leitfaden zum Verstehen, Erkennen und Verhindern von KI-Sprachbetrug im Unternehmen

Der $25-Millionen-Anruf, der nie stattgefunden hat

Im Februar 2024 erhält eine Finanzangestellte eines multinationalen Unternehmens in Hongkong einen Videoanruf von ihrem Finanzvorstand.

Die Stimme am anderen Ende war unverwechselbar, jeder Tonfall, jede Pause und sogar der leichte Akzent waren sofort zu erkennen.

Er bat sie dringend, 15 Überweisungen in Höhe von insgesamt $25 Millionen zu tätigen, um eine vertrauliche Übernahme abzuschließen.

Machen Sie sich nie wieder Sorgen über KI-Betrug. TruthScan Kann Ihnen helfen:

- Erkennen Sie AI-generierte Bilder, Text, Sprache und Video.

- Vermeiden Sie KI-gesteuerter Betrug in großem Umfang.

- Schützen Sie Ihre wichtigsten empfindlich Unternehmensvermögen.

Der CFO hat diese Entscheidung nie getroffen. Sie wurde vollständig von der KI generiert.

Dies war kein Einzelfall. Finanzinstitute verzeichnen einen steilen Anstieg von Betrugsfällen mit gefälschten Daten.

In den letzten drei Jahren ist die Zahl der Fälle um 2.137% gestiegen, und 42,5% aller Betrugsversuche in diesem Sektor sind auf KI zurückzuführen.

Trotz des Anstiegs des KI-Sprachbetrugs geben mehr als die Hälfte der Führungskräfte zu, dass ihre Mitarbeiter nicht darin geschult sind, Deepfake-Angriffe zu erkennen oder darauf zu reagieren; fast 80% der Unternehmen haben keine formellen Protokolle für den Umgang mit solchen Vorfällen.

Wie AI Voice Cloning funktioniert und warum es eine Bedrohung darstellt

Die moderne KI-Stimmensynthese benötigt erstaunlich wenig Daten. Nur wenige Sekunden Audio können eine Stimme mit einer Genauigkeit von bis zu 85% klonen.

Der Prozess besteht aus drei Hauptschritten:

- Datenerhebung: Betrüger sammeln Stimmproben aus öffentlichen Quellen wie Telefonkonferenzen, Podcast-Interviews, Social-Media-Clips oder sogar LinkedIn-Videoposts.

- Modellschulung: Die KI analysiert stimmliche Merkmale wie Tonhöhe, Tonfall, Akzent, Tempo und Atemmuster.

- Generation: Das System erzeugt eine synthetische Sprache, die so überzeugend ist, dass es selbst enge Kollegen täuschen kann.

Das Problem der Zugänglichkeit

Was diese Bedrohung noch gefährlicher macht, ist ihre Demokratisierung. Die Betrüger brauchen keine Ressourcen auf Hollywood-Niveau mehr.

Alles, was man braucht, ist eine zugängliche Software, um eine Stimme aus einem kurzen Social-Media-Clip zu klonen. Open-Source-Tools und Cloud-basierte KI-Dienste haben das Klonen von Stimmen für jeden mit grundlegenden technischen Kenntnissen zugänglich gemacht.

Warum Führungskräfte die Hauptzielscheibe für Betrug sind

Führungskräfte sind mit einer gefährlichen Mischung von Risikofaktoren konfrontiert.

Durch ihre öffentliche Präsenz in den sozialen Medien sind Stimmproben leicht zu finden, und ihre Autorität veranlasst die Mitarbeiter oft dazu, auf dringende Anfragen schnell zu reagieren.

Im Durchschnitt hat jede vierte Führungskraft nur ein begrenztes Verständnis der Deepfake-Technologie.

Aktuelle Statistiken zeichnen ein besorgniserregendes Bild

In einem 2024 Deloitte-Umfrage25,9% der Führungskräfte gaben an, dass ihr Unternehmen im vergangenen Jahr mit mindestens einem Deepfake-Vorfall konfrontiert war, der auf Finanz- oder Buchhaltungsdaten abzielte, und die Hälfte aller Befragten glaubt, dass solche Angriffe in den nächsten 12 Monaten zunehmen werden.

Besonders besorgniserregend: Nur 52% der Unternehmen fühlen sich sicher, dass sie ein Deepfake ihres CEO erkennen könnten.

Wie man AI-Voice-Betrug erkennt

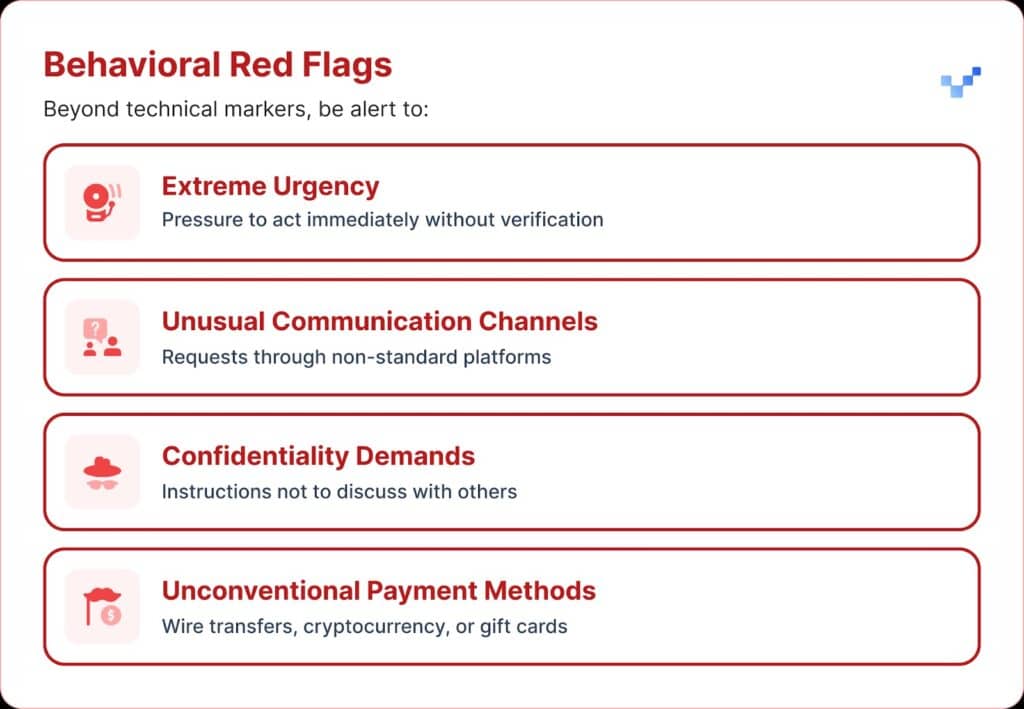

Wenn Sie eine verdächtige Sprachmitteilung erhalten, gibt es einige Warnzeichen, auf die Sie achten sollten.

AI-Sprachbetrüger klingen oft monoton oder flach. Vielleicht fällt Ihnen auch ein ungewöhnliches Tempo auf, mit seltsamen Pausen oder einem unnatürlichen Rhythmus.

Der Ton kann auch ein schwaches elektronisches Summen oder Echo aufweisen, insbesondere bei längeren Gesprächen.

Und in vielen Fällen wiederholt die Stimme begrenzte Phrasen, die wie ein Drehbuch oder einstudiert wirken.

Finanzielle Auswirkungen und die tatsächlichen Kosten

Die meisten Unternehmen verloren im Durchschnitt etwa $450.000, aber im Finanzdienstleistungssektor stiegen die Verluste auf über $603.000.

Und in den schwersten Fällen meldete 1 von 10 Unternehmen Verluste von mehr als $1 Million.

Dieser Trend hat schnell zugenommen. Frühere Untersuchungen aus dem Jahr 2022 ergaben, dass die durchschnittliche finanzielle Belastung durch Identitätsbetrug etwa $230.000 betrug, also fast die Hälfte der heutigen Zahl.

Voraussichtliche zukünftige Verluste

Laut dem Center for Financial Services von Deloitte könnten die durch KI-Betrug verlorenen Gelder in den USA von $12,3 Milliarden im Jahr 2023 auf $40 Milliarden im Jahr 2027 steigen. Das sind etwa 32% Wachstum pro Jahr.

Regionale Anfälligkeit

In Nordamerika stieg die Zahl der Deepfake-Betrugsfälle um 1740%.

Dieser signifikante regionale Anstieg deutet darauf hin, dass Nordamerika ein Hauptziel für Deepfake-Betrüger sein könnte, wahrscheinlich aufgrund der großen digitalen Wirtschaft und der weit verbreiteten Nutzung von Online-Diensten.

Strategische Ansätze zum Schutz von Führungskräften

1. Implementierung von Verifizierungsprotokollen

Eine Möglichkeit, den Schutz zu verstärken, ist die Verwendung eines "Safe-Word"-Systems, d. h. im Voraus vereinbarte Authentifizierungsphrasen, die mit wichtigen Mitarbeitern ausgetauscht werden.

Ein Betrüger, der KI-Stimmen klont, wird die richtigen Antworten auf Fragen zur persönlichen Verifizierung nicht kennen.

Eine weitere Sicherheitsmaßnahme ist die Überprüfung über mehrere Kanäle.

Jede ungewöhnliche finanzielle Anfrage sollte über einen separaten Kommunikationskanal bestätigt werden, wobei man sich niemals nur auf die ursprüngliche Kontaktmethode verlassen sollte.

Die Unternehmen sollten auch klare Regeln für die Eskalation mit Wartezeiten und Genehmigungsschritten für große Finanztransaktionen aufstellen, unabhängig davon, wer sie beantragt.

2. Achten Sie auf die digitale Belichtung

Ein weiterer Schutz besteht darin, die Anzahl der online verfügbaren Audio- und Videodateien von Führungskräften zu begrenzen. Je mehr Proben die Betrüger sammeln können, desto überzeugender werden ihre Klone.

Es ist auch hilfreich, klare Social-Media-Richtlinien für Führungskräfte festzulegen, insbesondere für die Veröffentlichung von Videos mit sauberem Ton.

Und wenn es um Konferenzen geht, sollten Unternehmen auf aufgezeichnete Vorträge oder Interviews achten, in denen über weite Strecken Stimmproben zu hören sind.

3. Technische Lösungen einführen

An dieser Stelle kommt der fortschrittlichen KI-Erkennungstechnologie eine entscheidende Bedeutung zu.

Organisationen benötigen eine unternehmensgerechte Sprachauthentifizierung und Deepfake-Erkennung Fähigkeiten, die bieten:

- Analyse in Echtzeit: Erkennen synthetischer Stimmen bei Live-Kommunikation

- Historische Verifizierung: Analysieren Sie aufgezeichnete Anrufe und Nachrichten auf ihre Echtheit

- Integrationsfähigkeiten: Nahtlose Zusammenarbeit mit bestehenden Kommunikationsplattformen

- Hohe Genauigkeitsraten: Minimierung von Fehlalarmen bei gleichzeitiger Erkennung raffinierter Fälschungen

4. Umfassende Schulungsprogramme

Führungsteams benötigen gezielte Schulungen zu KI-Sprachbedrohungen und Überprüfungsverfahren.

Ebenso wichtig ist es, die Mitarbeiter zu sensibilisieren.

Jeder, egal in welcher Funktion, sollte in der Lage sein, potenzielle Deepfakes zu erkennen und zu verhindern, dass Cyber-Bedrohungen in das Unternehmen eindringen.

Regelmäßige Simulationsübungen können diese Bereitschaft verstärken, indem Betrugsversuche per Telefon simuliert werden, um die Reaktionsverfahren zu testen und zu verfeinern.

Fortschrittliche AI-Spracherkennungslösungen

Herkömmliche Schutzmechanismen wurden für netzwerkbasierte Bedrohungen entwickelt, nicht für KI-gestützte menschliche Imitationen.

Die Hauptgründe dafür, dass Standard-Cybersicherheits-Tools nicht gegen sprachbasiertes Social Engineering vorgehen können:

- Keine Malware-Signatur: Sprachanrufe lösen keine herkömmlichen Sicherheitssysteme aus

- Faktor menschliches Vertrauen: Menschen vertrauen natürlich dem, was sie hören, insbesondere vertrauten Stimmen.

- Lücken in der Erkennungstechnologie: Trotz der Zunahme von KI-gesteuerten Betrugsversuchen, einschließlich Deepfakes, haben nur 22% der Finanzinstitute KI-basierte Betrugspräventionstools implementiert

Der Bedarf an spezialisierter Spracherkennung

Moderner Sprachbetrug erfordert moderne Erkennungsmöglichkeiten.

Unternehmenstauglich AI-Stimmerkennungssysteme kann:

- Analysieren Sie stimmliche Biomarker: Erkennen Sie subtile Unstimmigkeiten in synthetischer Sprache

- Verarbeitung in Echtzeit: Sofortige Alarmierung bei verdächtigen Anrufen

- Kontinuierliches Lernen: Anpassung an neue Sprachsynthesetechniken

- Integrationsfähig: Arbeit mit bestehender Kommunikationsinfrastruktur

Unternehmen, die sich ernsthaft gegen Sprachbetrug schützen wollen, müssen in eine speziell entwickelte KI-Erkennungstechnologie investieren, die der Komplexität der Bedrohungen, mit denen sie konfrontiert sind, gewachsen ist.

Sprachbetrug ist jetzt da, und er eskaliert

Im ersten Quartal 2025 verursachten Deepfake-Betrug und Identitätsdiebstahl Verluste in Höhe von über $200 Millionen.

Das Voice-Phishing mit KI-Klonen stieg sprunghaft an (442%), und mehr als 400 Unternehmen werden täglich mit Deepfake-CEO- oder CFO-Betrug angegriffen.

Zwar geben 56% der Unternehmen an, dass sie sich bei der Erkennung von Deepfakes sehr sicher fühlen, aber nur 6% haben tatsächlich verhindert, dass ihnen dadurch finanzielle Verluste entstehen.

Entscheidend ist nicht, ob Ihr Unternehmen ins Visier genommen wird, sondern ob Sie darauf vorbereitet sind.

Sprachbetrug verändert das Gesicht der Cybersicherheit. Herkömmliche Abwehrmechanismen können mit KI-gesteuerten Imitationen nicht mithalten.

Um geschützt zu sein, benötigen Unternehmen bessere Erkennungsinstrumente, strenge Schulungsprogramme und klare Überprüfungsverfahren.

Die Technologie, um sich zu wehren, ist bereits vorhanden. Die eigentliche Frage ist, ob Sie sie vor dem ersten Vorfall von Sprachbetrug einsetzen oder danach.