Forsikringssvindel er på vej ind i en ny æra drevet af kunstig intelligens. Sofistikerede svindelringe og ensomme svindlere udnytter generative AI-værktøjer til at producere falske krav, syntetiske identiteter, deepfaked bevismateriale og meget overbevisende efterligningssvindel. Dette whitepaper undersøger de seneste 2025 tendenser inden for AI-drevet forsikringssvindel - fra AI-genererede krav og dokumenter til deepfake voice-svindel - og skitserer, hvordan forsikringsselskaber kan reagere. Vi præsenterer de seneste data, cases fra den virkelige verden og strategiske indsigter for forsikringsfolk, svindelefterforskere, cybersikkerhedsteams, skadebehandlere og C-suite-ledere, som har brug for at forstå dette hurtigt udviklende trusselslandskab.

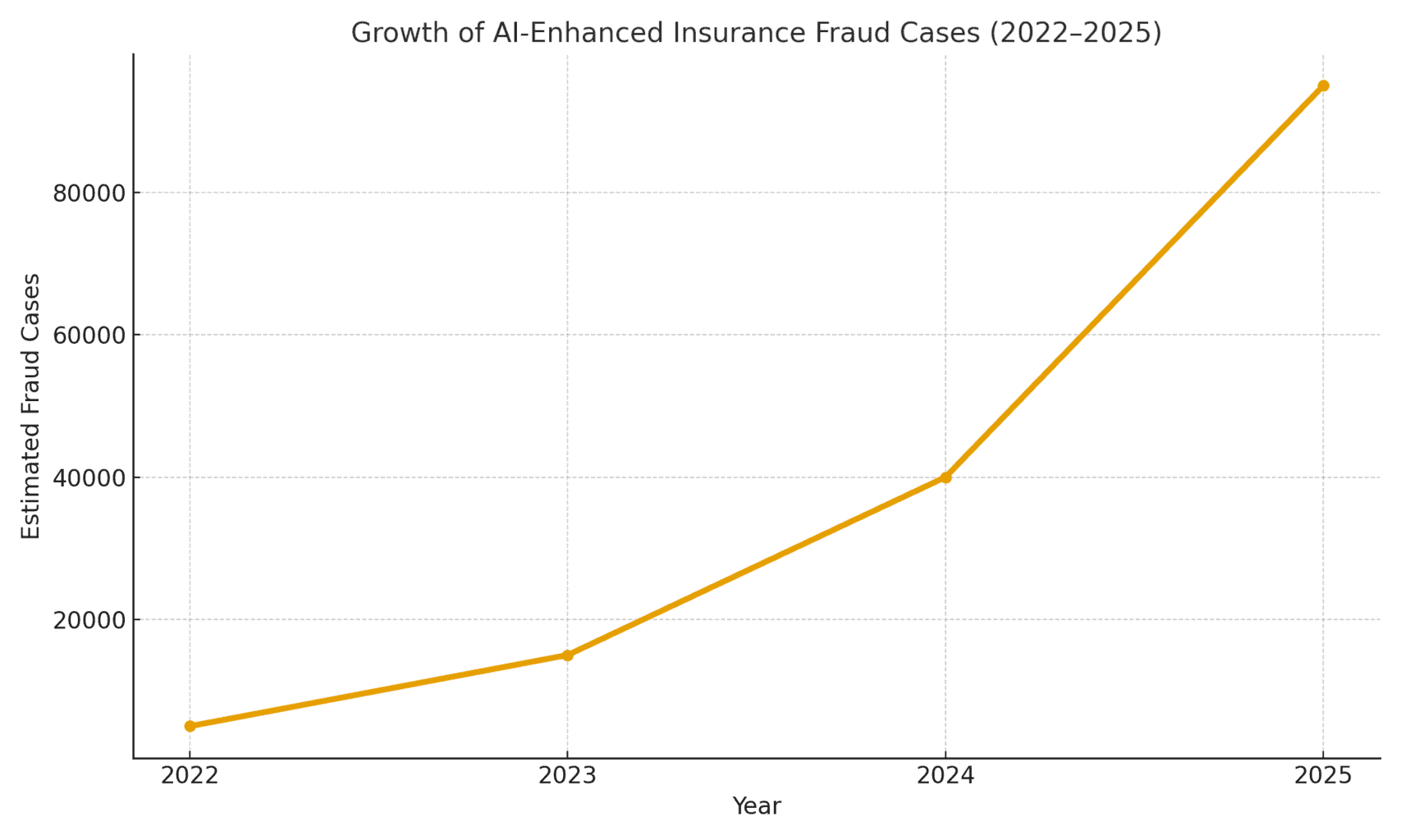

Truslens omfang: Svindel muliggjort af AI er stigende. En rapport fra 2025 om retsmedicinsk regnskab fandt, at AI-drevne svindelnumre står nu for over halvdelen af al digital økonomisk svindel[1]. Specifikt inden for forsikring observerede stemmesikkerhedsfirmaet Pindrop en 475% stigning i syntetiske stemmeangreb på forsikringsselskaber i 2024og bidrog til en stigning på 19% i forhold til året før i det samlede antal forsøg på forsikringssvindel.[2]. Forsikringsselskaberne står over for ca. 20 gange højere risiko for svindel end bankerdelvis på grund af stor afhængighed af dokumenter, billeder og stemmeverificeringer i krav[3]. Figur 1 nedenfor illustrerer den eksplosive vækst i AI-forstærket forsikringssvindel fra 2022 til 2025, da flere brancherapporter har indikeret tre- eller firecifrede procentvise stigninger fra år til år i opdaget AI-involvering i svindel.

Figur 1: Hurtig stigning i AI-forstærkede sager om forsikringssvindel (indekseret vækst 2022-2025). Branchedata viser eksponentielle stigninger i AI-genereret indhold, der findes i svigagtige krav, især siden 2023.[4][2]

AI-genererede påstande og falske beviser

En af de mest udbredte tendenser er brugen af generativ AI til at skabe helt fabrikerede forsikringskrav. Med avancerede AI-tekstgeneratorer kan svindlere skrive realistiske hændelsesbeskrivelser, lægerapporter eller politiforklaringer med et klik på en knap. Disse AI-skrivne fortællinger fremstår ofte polerede og troværdige, hvilket gør det sværere for forsikringsagenter at opdage uoverensstemmelser. For eksempel har svindlere brugt ChatGPT til at udarbejde detaljerede ulykkesbeskrivelser eller skadesrapporter, der lyder professionelle og overbevisende - en opgave, der engang krævede en betydelig indsats og skrivefærdigheder.

Mere bekymrende er det, at kriminelle nu parrer disse falske fortællinger med AI-genereret understøttende dokumentation. Billedgenereringsmodeller (som Midjourney eller DALL-E) og redigeringsværktøjer kan producere fotorealistiske billeder af skader og kvæstelser. Ifølge rapporter fra branchen er nogle chauffører begyndt at Indsendelse af AI-genererede billeder for at overdrive skader på køretøjer i bilskader[5]. Generativ AI kan skabe et billede af en smadret bil eller et oversvømmet hjem, som aldrig har eksisteret. Disse billeder er ofte mere realistisk end hvad ældre Photoshop-teknikker kunne opnå[6]hvilket gør dem svære at opdage med det blotte øje. I april 2025 bemærkede Zurich Insurance en stigning i antallet af skader med forfalskede fakturaer, fabrikerede reparationsoverslag og digitalt ændrede fotos, herunder tilfælde, hvor Registreringsnumre blev indsat med kunstig intelligens på billeder af bjærgede biler[7][8]. Sådanne falske beviser kan, når de kombineres med en veludformet AI-skrevet ansøgningsformular, slippe forbi manuelle anmeldelser.

En slående sag i Storbritannien involverede svindlere, der tog en Foto på sociale medier af en håndværkerbil og brug af AI til at tilføje en revnet kofangerog derefter indsende den sammen med en falsk reparationsfaktura på 1.000 pund som en del af et falsk ulykkeskrav.[9]. Svindelnummeret blev først opdaget, da efterforskerne bemærkede samme Foto af varevogn (før skaden) på ejerens Facebook-side[10]. Dette illustrerer et bredere fænomen: forsikringsselskaberne rapporterer en 300% springer i "shallowfake"-billedredigeringer (simple digitale manipulationer for at tilføje skader eller ændre detaljer) på bare ét år (2021-2022 vs. 2022-2023)[4]. Allianz UK advarede i 2024 om, at digitale fotoforvrængninger og falske dokumenter havde "alle tegn på at blive det seneste store svindelnummer, der rammer branchen".[4]. Zurichs chef for skadeservice bemærkede ligeledes, at Hvad der tidligere krævede iscenesættelse af et fysisk biluheld, kan nu klares helt bag en computer. - Svindlere kan "oprette et svigagtigt krav bag deres tastatur og udtrække betydelige summer" med falske totalskadebilleder og -rapporter.[11][12]. Dette skift øger ikke kun mængden af falske krav, men sænker også adgangsbarrieren for potentielle svindlere.

Du skal aldrig bekymre dig om AI-svindel igen. TruthScan Kan hjælpe dig:

- Opdag AI-generering billeder, tekst, stemme og video.

- Undgå at stor AI-drevet svindel.

- Beskyt dine mest følsom virksomhedsaktiver.

Ud over biler, Skader på ejendom og skader ser AI-assisteret inflation af tab. Der er rapporter om falske fotos til rejseforsikringer (f.eks. "skader" på bagagen eller iscenesatte tyverier) og AI-genererede kvitteringer for dyre varer, som aldrig er blevet købt. Livs- og sundhedsskader er heller ikke immune - svindlere har skabt falske lægeregninger og dødsattester ved hjælp af AI-dokumentforfalskere. Faktisk bemærkede Zurich, at deepfake-teknologi blev brugt til at skabe helt fiktive ingeniørvurderinger og medicinske rapporter i skadespakker[11]. Disse AI-genererede dokumenter, ofte med realistiske logoer og underskrifter, kan være umulige at skelne fra ægte papirarbejde. En ny bekymring for livsforsikringsselskaber er Svindel med nekrologer og dødsattester: Kriminelle kan bruge AI til at producere falske nekrologer eller lægeerklæringer for at understøtte et dødsfald for en person, der faktisk stadig er i live (eller som slet ikke har eksisteret, som vi ser i næste afsnit).

Syntetiske forsikringstagere og identiteter

Den måske mest snigende udvikling er Svindel med syntetisk identitet i forsikring. Syntetisk identitetssvindel går ud på at skabe en fiktiv person eller enhed ved at kombinere rigtige data (stjålne CPR-numre, adresser osv.) med opdigtede detaljer (falske navne, falske ID-dokumenter). Fremskridt inden for AI har gjort det trivielt nemt at generere realistiske personlige profiler - inklusive fotos og ID'er - for personer, der ikke findes[13][14]. Svindlere kan nu algoritmisk producere en fuldstændig falsk kunde, købe en police i deres navn og senere iscenesætte krav eller policeydelser for den falske identitet.

I livsforsikringssektoren har ordninger med syntetisk identitet skød i vejret. Industriforskning i 2025 anslår, at syntetisk identitetssvindel koster over $30 milliarder årligtog står for så meget som 80-85% af alle sager om identitetssvindel på tværs af finansielle tjenester[15][16]. Livsforsikringsselskaber er blevet ramt særligt hårdt: Svindlere er kendt for at sikre livsforsikringer for en fiktiv person og derefter "dræbe" personen på papiret for at få udbetalt dødsfaldsydelsen[17]. For eksempel kan en svindler oprette en syntetisk kunde "John Doe", betale præmier i et år og derefter indsende et krav med en falsk dødsattest og nekrolog for John Does alt for tidlige bortgang. Fordi identiteten blev opbygget omhyggeligt (kredithistorik, offentlige registre osv.), kan dødsfaldet se legitimt ud - indtil der ikke kan findes noget lig eller nogen rigtige slægtninge. Når bedrageriet bliver opdaget, er gerningsmændene for længst væk med udbetalingen.

Syntetiske identitetsordninger plager også sygeforsikring og bilforsikring. Kriminelle netværk skaber "Frankenstein"-identiteter ved at bruge børns eller ældres CPR-numre (som ikke har nogen kredithistorik) kombineret med AI-genererede navne og kørekort[15]. Derefter købe sundheds- eller bilpolicer til disse falske personer og kort tid efter anmelde store krav. En variant er syndikater, der opretter falske virksomheder (skuffeselskaber) - f.eks. et falsk lastbilfirma - og købe erhvervsforsikring for det, kun for senere at kræve erstatning for iscenesatte ulykker eller fiktive medarbejderes skader.[18][19]. Fordi virksomheden kun eksisterer på papir (med AI-genererede virksomhedsregistreringer og skatte-id'er), er dette "Entitetsbaseret" syntetisk svindel bliver ofte først afsløret, når skaden er udbetalt[18][20].

Hvorfor er syntetiske identiteter så effektive? For det første sejler de ofte gennem automatiserede identitetskontroller. Kreditbureauer og KYC-systemer kan finde ingen røde flag fordi identiteten indeholder nogle rigtige, gyldige data (f.eks. et rigtigt SSN med en ren straffeattest)[21]. I mellemtiden kan AI-genererede profilbilleder og ID-scanninger se helt autentiske ud - nutidens AI kan producere et menneskeansigt, som selv avanceret ansigtsgenkendelse kan acceptere som ægte. Det er resultatet: De fleste automatiserede systemer genkender disse profiler som legitime. og svindlen opdages først (hvis overhovedet) efter store tab[22].

Virkning i den virkelige verden: RGA rapporterer, at Syntetisk identitetssvindel i livsforsikring koster nu branchen omkring $30B om året og er vokset næsten 400% siden 2020[15][16]. U.S. Federal Trade Commission vurderer, at syntetiske ID'er udgør langt størstedelen af identitetssvindel.[16]. Disse tab rammer i sidste ende ærlige forsikringstageres tegnebøger - hver familie betaler anslået \$700 ekstra i præmier hvert år på grund af den bredere svindelbelastning på forsikringsselskaberne[15]. Forsikringsselskaberne reagerer ved at styrke verifikationen ved onboarding og krav: implementere databasetjek for identitetskobling, overvågning af flere policer på samme adresse og endda køre "liveness"-tests (selfie-videotjek for at sikre, at en skadelidt er en rigtig person, ikke bare et AI-billede).[23][24]. Men som vi skal se, modarbejder svindlerne med AI i den næste arena: deepfake stemmer og videoer.

Deepfake-stemmer og video-påstande

AI-genereret deepfakes af lyd og video tilføjer en alarmerende ny dimension til forsikringssvindel. I 2023 og 2024 var der flere tilfælde, hvor kriminelle brugte Kloning af stemme at udgive sig for at være enkeltpersoner over telefonen - en taktik, der oprindeligt blev set i forbindelse med bankkup (som det berygtede deepfake CEO-telefonopkald, der stjal $35 millioner i 2020), men som nu breder sig til forsikring. Svindlere kloner forsikringstageres, lægers eller skadesbehandleres stemmer og bruger dem i social engineering-svindel. Pindrops analyse fra 2024 advarede om, at "deepfakes, syntetisk stemmeteknologi og AI-drevne svindelnumre omformer svindel-landskabet", med stemmesvindel skalering med en hidtil uset hastighed[25]. De fandt ud af, at forsikrings-callcentre blev bombarderet af oversøiske dårlige skuespillere, der brugte voice deepfakes: For eksempel ville der komme opkald med en rigtig forsikringstagers stjålne SSN og personlige data, og hvis en agent svarede, ville de... Opkalderens AI-klonede stemme kan narre agenten gennem vidensbaseret autentificering og anmode om en svigagtig udbetaling[26]. I et forsikringsselskab på vestkysten brugte angribere gentagne gange denne metode til at forsøge at overtage konti og omdirigere udbetalinger, idet de udnyttede det faktum, at callcentrets ID-verifikation var afhængig af stemme- og personlige oplysninger, der kan forfalskes.[26].

Stemmeimitation er også blevet brugt på forbrugersiden: Svindlere har ringet til ulykkesofre eller modtagere, mens udgiver sig for at være forsikringsrepræsentanterDe bruger AI-stemmer til at lyde officielle for at stjæle følsomme oplysninger eller endda betalinger. Omvendt kan en svindler udgive sig for at være en kunde på en erstatningshotline for at anmelde et krav via telefon ved hjælp af en falsk stemme, der matcher kundens køn/alderog dermed omgå stemme-biometriske kontroller. De seneste statistikker over svindel er tankevækkende: brancheeksperter forventer, at 162% vækst i deepfake-svindelangreb mod forsikringsselskaber i det kommende år[27]og Pindrop indspillede en 475% stigning i syntetiske stemmeangreb i 2024 som tidligere nævnt[2]. Disse angreb overhaler hurtigt mere traditionelle cyber-svindel-vektorer.

Ud over telefonopkald, videobaserede deepfakes er ved at opstå i erstatningsprocessen. Mange forsikringsselskaber har indført virtuelle skadesinspektioner og videokonferencer (fremskyndet af pandemien) for at verificere tab eller interviewe skadelidte på afstand. Nu er svindlere udnytter AI-avatarer og deepfake-videoer til at narre disse verifikationer. Der har været rapporter om, at ansøgere har brugt AI-genererede avatarer i live videoopkald med justeringsfolk for at udgive sig for at være en anden eller for at skjule tegn på uoverensstemmelse[28]. For eksempel kan en svindelring bruge en deepfake "Live"-video af en formodet skadevolder, der viser sine skader via smartphonenår personen på kameraet i virkeligheden er en AI-syntetiseret komposit eller en hyret skuespiller iført ansigtsændrende filtre. Et spekulativt, men plausibelt scenarie er at bruge en deepfake af en Afdøde person: I en livrente- eller livsforsikringssvindel kan et familiemedlem bruge en deepfake-video af den nyligt afdøde under et rutinemæssigt proof-of-life-opkald for fortsat at modtage udbetalinger.[29]. Selv om der endnu ikke er offentliggjort nogen højprofileret sag af denne art, er forsikringsselskaberne forberedt på det. Tilsynsmyndighederne tager det også til efterretning - Der er drøftelser i gang i USA og Europa om at klassificere deepfakes under identitetstyveri og opdatere retningslinjerne for bevissikring inden for forsikring.[30].

At opdage deepfake-videoer og -lyd er meget udfordrende uden tekniske værktøjer. Menneskelige sagsbehandlere er ikke trænet i at skelne mellem subtile problemer med læbesynkronisering eller akustiske særheder. Der har dog været røde flag i nogle tilfælde: for eksempel unaturlige blink eller ansigtsfejl på video eller baggrundslydartefakter i et opkald, der gav efterforskerne et tip. Men alt i alt, deepfake forsikringssvindel er stadig i de tidlige stadierog retsforfølgelse er stadig sjælden - i 2023 var de juridiske definitioner uklare, og det var vanskeligt at bevise, at en video var AI-genereret uden ekspertanalyse.[31]. Det giver svindlerne en følelse af straffrihed. Våbenkapløbet er i gang: Forsikringsselskaberne vender sig nu mod retsmedicinsk AI til at bekæmpe AI, der anvender deepfake-detektionsalgoritmer til at undersøge mistænkelige videoer billede for billede for tegn på manipulation[24]. Leverandører af stemmebiometri udruller deepfake-stemmedetektorer, der analyserer spektrale mønstre og stemmekadence for ægthed.[32]. Vi vil diskutere disse defensive teknologier i et senere afsnit.

AI-forbedret phishing og svindel med falske identiteter

Ikke al AI-aktiveret svindel kommer gennem skadesafdelingen; nogle mål er kunder og medarbejdere via social engineering. Phishing-mails og -tekster udformet af AI er blevet en stor trussel på forsikringsområdet. Her bruger svindlere AI-chatbots og oversættelsesværktøjer til at generere meget overbevisende svindelkommunikation. For eksempel kan kriminelle efterligne et forsikringsselskabs branding og skrivestil for at sende masse-phishing-mails til forsikringstagere og fortælle dem, at "der er brug for hurtig handling for at forhindre annullering af policen" og henvise dem til en falsk hjemmeside. I modsætning til fortidens klodsede svindelmails, AI sikrer upåklagelig grammatik og endda personaliseringDet gør dem langt mere troværdige. Vi har set AI blive brugt til at scrape sociale medier for detaljer, der bliver flettet ind i spear-phishing-meddelelser, som f.eks. at henvise til et nyligt bilkøb i en falsk bilforsikringsmeddelelse.

En anden vektor er AI-støttet efterligning af agenter eller ledere. Der har været tilfælde, hvor svindlere klonede stemmen fra en ejer af et forsikringsagentur og efterlod telefonsvarerbeskeder til kunder, der bad om opdateringer af bankoplysninger - i realiteten et stemmephishing-angreb. På samme måde kan intern svindel stamme fra AI-efterligning: Et forsikringsselskabs finansafdeling blev næsten offer, da svindlere sendte en deepfake-lydbesked angiveligt fra den administrerende direktør at godkende en pengeoverførsel (en variant af "CEO-fraud", der nu er dækket af nogle e-kriminalitetsforsikringer)[33]). Disse former for AI-drevet efterligningssvindel steg 17% i 2023 ifølge Liberty Specialty Markets[33]og forventes at blive ved med at stige.

Forbrugerne bliver også udsat for svindel med syntetiske medier knyttet til forsikring. Koalitionen mod forsikringssvindel bemærker tilfælde af bedragere, der udgiver sig for at være forsikringstaksatorer, kontakter ulykkesofre og hævder, at de håndterer deres krav og derefter kræver øjeblikkelig betaling eller følsomme data[23]. Intetanende kunder, der er lettede over at høre fra en formodet repræsentant, vil måske adlyde, især hvis den, der ringer op, kender detaljer om deres ulykke (som AI kan få fra hacking eller offentlige kilder). Den offentlige bevidsthed om denne taktik er lav; derfor opfordrer eksperter i forebyggelse af svindel forsikringsselskaberne til at uddanne forsikringstagere i at verificere identiteten af opkaldere og e-mails[23][34]. Ligesom banker advarer kunder om phishing, er forsikringsselskaber i 2025 begyndt at inkludere advarsler om deepfake-svindel i deres kommunikation.

En fællesnævner for disse AI-forstærkede planer er brugen af lettilgængelige "fraud-as-a-service"-kits.[35]. På det mørke net kan kriminelle købe eller abonnere på værktøjer, der leverer præfabrikerede deepfake-stemmer, falske dokumentskabeloner, phishing-e-mailgeneratorer og meget mere. Denne demokratisering af AI-værktøjer betyder Selv lavtuddannede svindlere kan iværksætte sofistikerede svindelangreb[35]. For forsikringsselskaberne betyder det en syndflod af mere overbevisende svindelforsøg, der kommer fra alle vinkler - skadesanmeldelser, kundeservice, e-mail og endda sociale medier. Det understreger behovet for en flerstrenget forsvarsstrategi, der kombinerer teknologi, menneskelig årvågenhed og samarbejde på tværs af brancher.

Opdagelse og forsvar: Et AI-drevet svar

Bekæmpelse af AI-drevet svindel kræver AI-drevet forsvar. Forsikringsselskaberne vender sig i stigende grad mod avancerede detektionsteknologier og moderniserede processer for at imødegå angrebet. I bund og grund skal forsikringsselskaberne integrere Kontrolpunkter for indholdsgodkendelse i hele forsikringens livscyklus - fra tegning til skader og kundeinteraktioner - for at opsnuse AI-forfalskninger. Figur 2 viser en oversigt over de vigtigste svindeltyper, der er muliggjort af AI, og deres udbredelse, og de følgende afsnit beskriver, hvordan man kan opdage og afværge hver enkelt.

Figur 2: Typer af AI-forstærket forsikringssvindel i 2025 (anslået andel efter ordning). Falske billeder (manipulerede fotos af skader) og syntetiske identiteter er blandt de største kategorier, efterfulgt af AI-forfalskede dokumenter (f.eks. kvitteringer, certifikater) og deepfake audio/video-svindel.

1. Værktøjer til detektering af AI-indhold: Nye AI-detektionstjenester kan analysere tekst, billeder, lyd og video for at afgøre, om de er maskingenererede eller manipulerede. Forsikringsselskaber kan f.eks. udnytte løsninger som TruthScans AI-tekst- og billeddetektorer som bruger 99%+ præcis AI til at markere AI-skrevne dokumenter eller manipulerede fotos[36]. Et forsikringsselskab kunne integrere disse detektorer i deres skadesystem: Når et krav og dets beviser indsendes, kan tekstbeskrivelsen automatisk scannes for AI-genererede sprogmønstre, og alle uploadede billeder kan scannes for afslørende tegn på CGI eller redigering. Værktøjer i virksomhedsklassen kan Identificer AI-genereret tekst i dokumenter, e-mails og kommunikation med 99%-nøjagtighed[36]og på samme måde opdage AI-genererede eller manipulerede billeder for at sikre visuelt indholds autenticitet[36]. Det betyder, at en falsk ulykkesfortælling produceret af ChatGPT eller et falsk skadesbillede midt på rejsen vil blive markeret til manuel gennemgang, før kravet bliver behandlet. Forsikringsselskaber i 2025 indfører i stigende grad en sådan AI-indholdsgodkendelse - faktisk, 83% af professionelle inden for svindelbekæmpelse planlægger at integrere generativ AI-detektion inden 2025ifølge en ACFE-undersøgelse, op fra kun 18%, der bruger det i dag[37][38].

2. Identitetsbekræftelse og biometriske tjek: For at tackle syntetiske identiteter forbedrer forsikringsselskaberne også KYC-protokollerne med AI. Identitetsvalideringstjenester kan krydsverificere ansøgerdata mod flere databaser og bruge ansigtsgenkendelse med livstest. Hvis man f.eks. kræver en kort video-selfie under onboarding (og bruger ansigtsmatchning til det angivne ID), kan det forhindre mange syntetiske ID'er. Endnu mere højteknologiske virksomheder som TruthScan tilbyder billedanalyser, der kan få øje på AI-genererede profilbilleder, avatarer og syntetiske personbilleder - Deres AI-billeddetektor er trænet til at identificere ansigter lavet af generatorer som StyleGAN eller ThisPersonDoesNotExist[39]. Ved at bruge sådanne værktøjer kan et forsikringsselskab opdage, hvis en livsforsikringsansøgers selfie ikke er et rigtigt menneske. På stemmesiden, stemme-biometrisk autentificering til kundeserviceopkald kan hjælpe; moderne stemme-AI-detektorer er i stand til at identificere syntetiske stemmer og forsøg på stemmekloning i realtid[40]. For eksempel er TruthScans AI-stemmedetektering Systemet bruger akustisk analyse til at genkende AI-genererede stemmer og lydforfalskninger, før de narrer callcentermedarbejdere[40]. Disse løsninger fungerer som en firewall - hvis nogen ringer og udgiver sig for at være John Doe, og deres stemmeaftryk ikke matcher John Does autentiske stemme (eller matcher kendte deepfake-egenskaber), kan opkaldet blive markeret, eller der kan kræves yderligere identitetsbevis. Multifaktorautentificering (e-mail/SMS-bekræftelse, engangskoder osv.) gør det endnu sværere for efterlignere at overvinde.

3. Deepfake Video & Image Forensics: Når det drejer sig om videobeviser, er forsikringsselskaberne begyndt at implementere specialiseret kriminalteknisk analyse. Avanceret software kan analysere videometadata, billedkonsistens og fejlniveauer for at opdage deepfakes. Nogle værktøjer undersøger refleksioner, skygger og fysiologiske tegn (som puls i en persons hals på video) for at sikre, at en video er ægte. Retsmedicinske metadata er også værdifuld: Undersøgelse af filmetadata og generationsfodspor i billeder eller PDF'er kan afsløre, om noget sandsynligvis er produceret af et AI-værktøj.[41]. Forsikringsselskaberne bør for eksempel kræve originale fotofiler (som indeholder metadata) i stedet for bare skærmbilleder eller printede kopier. Zurichs svindelteam havde succes med at fange falske bilbilleder ved at lægge mærke til uregelmæssigheder i billedets metadata og analyse af fejlniveauet.[41]. Detektorer for e-mail-svindel kan ligeledes scanne indgående kommunikation for tegn på AI-skrevet phishing-indhold eller kendte ondsindede signaturer[42]. Mange forsikringsselskaber kører nu phishing-simuleringer og AI-udarbejdede svindeleksempler i medarbejderuddannelsen for at øge bevidstheden.

4. Procesændringer og menneskelig træning: Teknologi alene er ikke en sølvkugle. Forbedringer af processer der foretages, såsom hyppigere tilfældige personlige stikprøvekontroller af krav med høj værdi eller krav om fysisk dokumentation i visse tilfælde. Nogle forsikringsselskaber har udskudt den fuldautomatiske, direkte behandling af krav og genindfører menneskelig gennemgang af krav, der scorer højt på en risikomodel for AI-svindel. På den menneskelige side er uddannelse afgørende. Svindelefterforskere og taksatorer bliver trænet i at genkende røde AI-flag: f.eks. flere krav, der bruger samme ordlyd (ChatGPT-stil), billeder, der mangler ægte tilfældighed (f.eks. gentagne mønstre i det, der burde være organiske skader), eller stemmer, der lyder næsten rigtigt, men har en robotagtig kadence. Forsikringsselskaberne er også i gang med at uddanne kunderne: De udsender advarsler om svindel med deepfake-ordninger og rådgiver om, hvordan man kan bekræfte en forsikringsrepræsentants identitet (f.eks. ved at oplyse et kendt telefonnummer).

5. Fælles indsats: Samarbejdet i hele branchen er ved at tage fart. I Storbritannien har Insurance Fraud Bureau og Association of British Insurers dannet arbejdsgrupper om AI-svindel, og regeringens Charter om forsikringssvindel (2024) fremmer datadeling og fælles initiativer[43]. Globalt set samarbejder forsikringsselskaber med cybersikkerhedsfirmaer og AI-startups. Især dukker der nye forsikringsprodukter op: Liberty Mutual lancerede en E-kriminalitetsforsikring til SMV'er, der specifikt dækker deepfake-svindel og CEO-svindel[44][33]hvilket understreger, at denne risiko er meget reel. Det betyder også, at forsikringsselskaberne kan blive både ofre for og opklarere af AI-svindel - de udbetaler penge for en deepfake-svindel, hvis den ikke opdages, men tilbyder også dækning til andre, der udsættes for sådanne angreb.

Integrationen af detektionsteknologi i workflows kan visualiseres som et flerpunktsforsvar i kravets livscyklus. Som vist i Figur 3kan forsikringsselskaberne indsætte AI-verifikationstrin på Politisk anvendelse (til at screene for syntetiske identiteter via ID-dokumenter og selfie-tjek), på indsendelse af krav (til automatisk at analysere uploadede dokumenter, fotos eller lyd til AI-generering), under gennemgang/undersøgelse af krav (for at udføre deepfake-retsmedicinsk analyse af mistænkelige beviser og verificere eventuelle stemmeinteraktioner), og lige før udbetaling (en sidste identitetsgodkendelse for at sikre, at betalingsmodtageren er legitim). Ved at opdage svindel tidligt - ideelt set ved onboarding eller den første meddelelse om tab - sparer forsikringsselskaberne undersøgelsesomkostninger og undgår uretmæssige udbetalinger.

Figur 3: Integration af AI-detektionspunkter i forsikringens livscyklus. Ved onboarding af policen kontrollerer AI-baseret identitetsvalidering for syntetiske eller falske identiteter. Når et krav indsendes, scanner automatiserede detektorer kravtekst, dokumenter og billeder for AI-genereret indhold. Under gennemgang af krav verificerer specialiserede deepfake- og stemmeanalyseværktøjer eventuelle lyd- og videobeviser. Før udbetaling bekræfter biometrisk identitetsbekræftelse modtagerens identitet. Denne tilgang i flere lag hjælper med at opfange svindel i flere faser.

Forsikringsselskaberne behøver ikke at opbygge alle disse funktioner internt - mange henvender sig til virksomhedsløsninger som f.eks. TruthScans AI-detektionssuitesom tilbyder en række værktøjer, der kan API-integreres i forsikringsselskabernes systemer. For eksempel, TruthScans AI-billed- og deepfake-detekteringstjeneste kan bruges til at verificere ægtheden af billeder og videoer med over 99% nøjagtighed[45]. Deres AI-tekstdetektor markerer AI-skrevet tekst i krav eller e-mails[36]mens AI stemme-detektor Registrerer stemmekloning og verificerer højttalere for at stoppe telefonbedragerier[40]. Der er endda nicheværktøjer som en Detektor for falske kvitteringer til øjeblikkeligt at analysere fakturaer/kvitteringer for tegn på manipulation eller AI-genererede skrifttyper/layouts[46] - ekstremt nyttigt i betragtning af udbredelsen af falske reparationsregninger i skadesanmeldelser. Ved at anvende en kombination af disse værktøjer kan et forsikringsselskab drastisk forbedre sin opdagelsesrate for svindel. Et Fortune 500-forsikringsselskab rapporterede, at de fangede 97% af deepfake-forsøg i 2024 ved at bruge en lagdelt AI-screeningsmetode (tekst, billede, stemme) og derved undgå et anslået tab på \$20 mio.[47][48].

Konklusion

AI forvandler slagmarken for forsikringssvindel på globalt plan. Svindlere innoverer med generativ AI for at skabe usandheder, der er mere overbevisende end nogensinde - fra helt opdigtede personer og ulykker til efterligninger, der kan narre selv erfarne fagfolk. Dataene fra 2024-2025 viser en alarmerende vækst i disse AI-drevne ordninger, men de fremhæver også, at forsikringsselskaber, der investerer i opdagelse og forebyggelse, kan være et skridt foran. Ved at kombinere Banebrydende AI-detektionsteknologi - som billedkriminalitet, stemmegodkendelse og tekstanalyse - med opdaterede arbejdsgange og uddannelse kan branchen mindske risiciene uden at ofre den effektivitet, som digitale processer medfører.

I sin kerne er dette et teknologisk våbenkapløb[49]. Som en ekspert i forebyggelse af svindel bemærkede, "I denne nye virkelighed er årvågenhed den præmie, der skal betales"[50]. Forsikringsselskaber skal fremme en kultur af årvågenhed og udnytte de bedste tilgængelige værktøjer for at bevare tilliden til skadesprocessen. Det betyder, at man skal verificere dokumenters, stemmers og billeders sandhed med samme grundighed, som forsikringsselskaberne bruger til at vurdere risikoen. Det betyder også, at man skal samarbejde på tværs af branchen for at dele oplysninger om nye AI-svindeltaktikker og i fællesskab udvikle standarder (f.eks. standardkrav til metadata for indsendte medier eller branchens sortlister over kendte falske identiteter).

2025 er et vendepunkt: de forsikringsselskaber, der Proaktiv tilpasning til AI-drevet svindel vil beskytte deres kunder og balancer, mens de, der er langsomme til at reagere, kan blive mål for svindel, der skaber overskrifter. Den opmuntrende nyhed er, at teknologien til at slå igen findes og modnes hurtigt - den samme AI, som styrker svindlere, kan styrke forsikringsselskaber. Ved at implementere løsninger som TruthScans multimodale AI-detektionspakke til krav og identitetsverificering kan forsikringsselskaber dramatisk reducere succesraten for AI-genererede svindelforsøg.[51][52]. På den måde forhindrer de ikke kun tab, men sender også en klar besked til potentielle svindlere: Uanset hvor smarte værktøjerne er, Svindel vil blive afsløret.

Kort sagt er AI-drevet forsikringssvindel en formidabel udfordring, men den kan imødegås med et lige så intelligent forsvar. Med årvågenhed, tværfunktionel strategi og de rigtige teknologipartnere kan forsikringsbranchen fortsat opretholde det grundlæggende løfte, der er kernen i dens forretning - kun at betale legitime krav, og at gøre det hurtigt og sikkert i en stadig mere digital verden.

Referencer:

- Sammenslutningen af britiske forsikringsselskaber - Statistik over svindel 2023[53][54]

- Allianz & Zurich om AI-"shallowfake"-kravstigning -. The Guardian, 2024[4][11]

- Facia.ai - Det er det. "Deepfake forsikringssvindel: Hvordan AI omskriver reglerne," Oktober 2025[55][56]

- Koalition mod forsikringssvindel - Syntetisk svindel inden for forsikring (Quantexa), Dec 2024[21][17]

- RGA - "Svindelbekæmpelsens nye grænse: Syntetiske identiteter". Juni 2025[15][16]

- Pindrop - Rapport om stemmesvindel, via FierceHealthcare, juni 2025[2][3]

- At vende tal - "De bedste finansielle svindelmetoder 2025". Oktober 2025[1][57]

- TruthScan - AI Detection Platform (oversigt over tjenester), 2025[51][52]

- TruthScan - AI Image Detector produktside, 2025[45][39]

- TruthScan - AI Voice Detector produktside, 2025[40]

- TruthScan - Produktsiden for Fake Receipt Detector, 2025[46]

- Liberty Specialmarkeder - Pressemeddelelse fra Deepfake/Cyber Fraud Insurance, Marts 2025[33]

- Facia.ai - Det er det. Blog: Våbenkapløb om forebyggelse af forsikringssvindel, 2025[24][32]

- Forsikringsbranchen Storbritannien - "AI-genererede billeder bruges til motorsvindel," April 2025[7][58]

- The Guardian - "Falske billeder af bilskader alarmerer forsikringsselskaberne," Maj 2024[9][12]

[1] [35] [57] 2025 Finansiel svindel: AI-trusler og røde flag

https://www.turningnumbers.com/blog/top-financial-fraud-schemes-of-2025

[2] [3] [25] [26] Forsikringssvindel steg med 19% fra stemmeangreb i 2024

https://www.fiercehealthcare.com/payers/insurance-fraud-increased-19-synthetic-voice-attacks-2024

[4] [9] [10] [11] [12] Svindlere redigerer bilbilleder for at tilføje falske skader i britisk forsikringssvindel | Forsikringsbranchen | The Guardian

[5] [6] [7] [8] [43] [53] [54] [58] AI-genererede billeder bruges nu til svindel med bilforsikringer - rapport | Insurance Business UK

[13] [14] [15] [16] Fraud Fight's New Frontier: Syntetiske identiteter og et AI-våbenkapløb | RGA

[17] [18] [19] [20] [21] [22] JIFA: Syntetisk svindel: Med syntetisk svindel allerede i deres økosystem er forsikringsselskaberne nødt til at tænke mere som banker - InsuranceFraud.org

https://insurancefraud.org/publications/jifa-synthetic-fraud/

[23] [24] [28] [29] [30] [31] [32] [34] [41] [49] [50] [55] [56] Deepfake forsikringssvindel: Hvordan AI omskriver reglerne for forsikringskrav

https://facia.ai/blog/deepfake-insurance-fraud-how-ai-is-rewriting-the-rules-of-insurance-claims/

[27] [48] Den tavse trussel: Hvorfor forsikringssvindel flytter til telefonlinjen

https://www.modulate.ai/blog/the-silent-threat-why-insurance-fraud-is-moving-to-the-phone-line

[33] [44] E-kriminalitetsforsikring til SMV'er er rettet mod CEO-svindel og deepfakes - LSM | Insurance Business UK

[36] [42] [51] TruthScan - AI-detektering og indholdssikkerhed for virksomheder

[37] Undersøgelse: 8 ud af 10 svindelbekæmpere forventer at anvende generativ AI inden 2025

[38] Indsigt fra 2024-rapporten om benchmarking af teknologi til bekæmpelse af svindel

[39] [45] AI-billeddetektor spotter falske og manipulerede fotos - TruthScan

https://truthscan.com/ai-image-detector

[40] [52] AI-stemmedetektor til deepfakes og stemmekloning | TruthScan

https://truthscan.com/ai-voice-detector

[46] TruthScan Fake Receipt Detector | Bekræft kvitteringens ægthed

https://truthscan.com/fake-receipt-detector

[47] Fortune 500-forsikringsselskab opdager 97% af deepfakes og stopper syntetisk ...