Introduktion: En ny æra af AI-drevne angreb

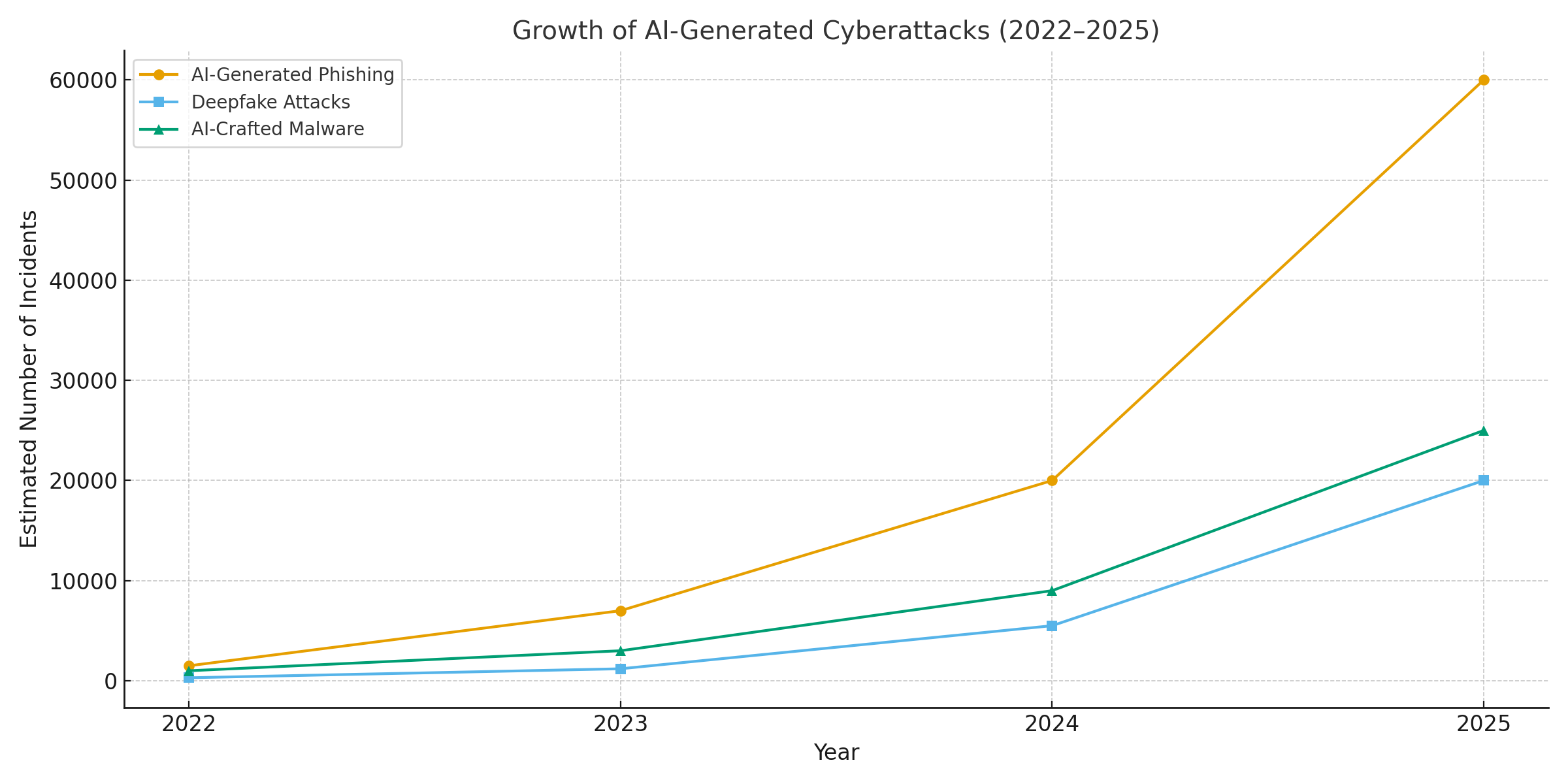

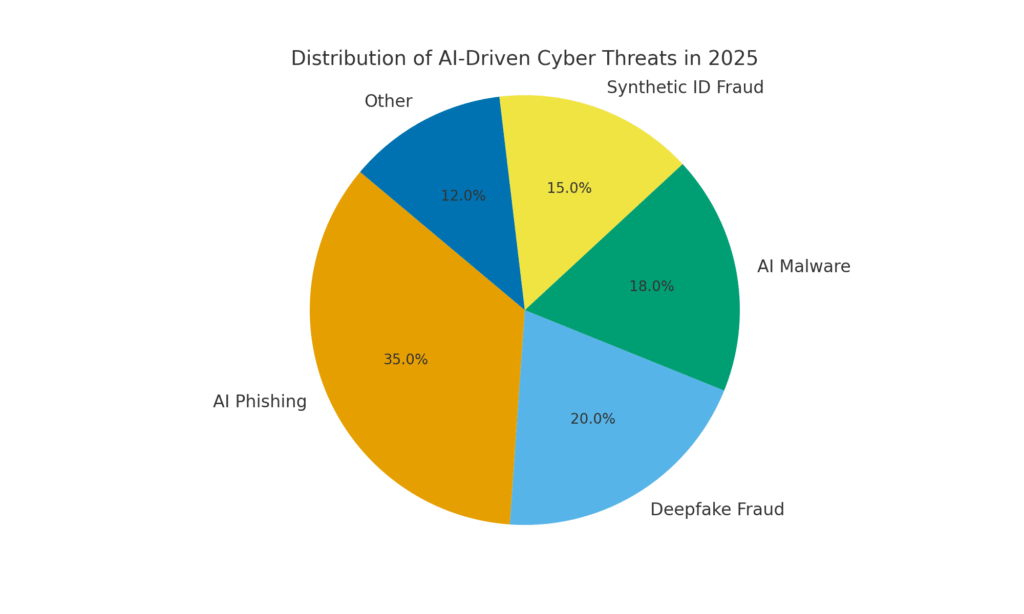

År 2025 har markeret et vendepunkt i cybersikkerheden. Generativ AI har sat skub i cyberangreb og gjort det muligt for trusselsaktører at lancere mere hyppig, realistisk og skalerbar kampagner end nogensinde før. I løbet af det seneste år er det blevet anslået, at 16% af de rapporterede cyberhændelser involverede angribere, der udnyttede AI-værktøjer (f.eks. billed- og sproggenereringsmodeller) for at forbedre social engineering[1]. Fra ultra-overbevisende phishing-mails til deepfake audio/video-svindel - ondsindede aktører bruger AI som våben på tværs af alle sektorer. Et flertal af sikkerhedseksperter tilskriver nu stigning i cyberangreb til generativ AIsom giver onde aktører hurtigere og smartere måder at udnytte ofre på.[2]. Generativ AI sænker effektivt kompetencegrænsen for cyberkriminalitet, samtidig med at den øger dens styrke.

Hvorfor er det så bekymrende? AI kan øjeblikkeligt producere poleret, kontekstbevidst indhold, der narrer selv trænede brugere. Den kan efterligne stemmer og ansigter med skræmmende nøjagtighed og endda generere ondsindet kode, der ændrer sig for at undgå at blive opdaget. Som følge heraf er cyberangreb blevet sværere at opdage og lettere at udføre. Den Verdens økonomiske forum advarer om, at 72% af organisationer har oplevet øgede cyberrisici - især social engineering og svindel - på grund af generativ AI's voksende muligheder.[3]. Hændelser i den virkelige verden bekræfter dette: I begyndelsen af 2024 brugte kriminelle en AI-genereret deepfake videoopkald at udgive sig for at være en virksomheds økonomidirektør og narre en medarbejder til at overføre $25,6 millioner til svindlerne[4]. Og i et andet tilfælde brugte nordkoreanske hackere AI-genererede falske ID-dokumenter at omgå sikkerhedstjek i en phishing-kampagne til forsvar[5]. Disse eksempler understreger, hvad der står på spil - generativ AI giver mulighed for svindel, der omgår både menneskelig og teknisk kontrol.

Men AI er også en del af løsningen. Avancerede detektionsværktøjer (som dem fra TruthScan) bruger AI mod AI - analyse af indhold for de subtile signaturer af maskingenerering. I dette whitepaper undersøger vi de største AI-drevne cybertrusler i 2025, og hvordan organisationer kan afbøde dem. Fra AI-genereret phishing til deepfake CEO-svindel, AI-skabt malware, syntetiske identiteterog meget mere, vil vi undersøge, hvordan generativ AI omformer angreb. Vi vil også diskutere konkrete forsvarsforanstaltninger, herunder Registrering af AI-indhold, deepfake forensics og identitetsbekræftelsesteknologier, der kan hjælpe sikkerhedsteams med at genvinde overtaget. Målet er at belyse, hvordan virksomheder, MSSP'er, CISO'er og svindelefterforskere kan integrere AI-detekteringsværktøjer på tværs af deres cybersikkerhedsstack for at imødegå denne bølge af AI-drevne trusler.

Du skal aldrig bekymre dig om AI-svindel igen. TruthScan Kan hjælpe dig:

- Opdag AI-generering billeder, tekst, stemme og video.

- Undgå at stor AI-drevet svindel.

- Beskyt dine mest følsom virksomhedsaktiver.

AI-genereret phishing og BEC: Svindel i hidtil uset omfang

En af de tydeligste virkninger af generativ AI har været på phishing og Kompromittering af forretningsmail (BEC) ordninger. AI-sprogmodeller kan udarbejde flydende, kontekstuelt skræddersyede e-mails på få sekunder - og eliminere de afslørende grammatiske fejl og akavede formuleringer, der engang afslørede phishing. Resultatet er en syndflod af meget overbevisende svindelmails og -tekster. I april 2025, over halvdelen af spammails (51%) blev skrevet af AI, op fra næsten nul to år tidligere[6]. Endnu mere alarmerende er det, at forskerne fandt ud af, at ca. 14% af e-mails med BEC-angreb var AI-genererede inden 2025[7] - et tal, der forventes at stige i takt med, at kriminelle tager værktøjer som ChatGPT i brug. Nogle undersøgelser anslår over 80% af phishing-mails kan nu få hjælp af AI til at udforme dem[8].

Mængden af disse AI-genererede lokkemidler er eksploderet. Sikkerhedsanalyser viser, at phishing-angreb forbundet med generativ AI steg med 1,265% på kort tid[9]. I en periode steg antallet af rapporter om phishing-hændelser 466% i et enkelt kvartal, hovedsageligt på grund af automatiserede phishing-sæt og bots, der pumper tilpasset lokkemad ud[9][10]. Hvorfor en sådan stigning? Fordi AI lader angribere skala deres operationer dramatisk. En enkelt kriminel kan bruge en AI-chatbot til at generere tusinder af personaliserede svindelmails rettet mod forskellige medarbejdere eller kunder, alt sammen på den tid, det plejede at tage at lave én. Denne masseautomatisering fik FBI til at advare om, at BEC-tab (som allerede var $2,7 milliarder i 2022) kun vil accelerere, da AI "truer med at skubbe disse tab endnu højere op".[11][12].

Ikke alene er der flere phishing-mails, de er også mere effektiv. Ofrene bliver i højere grad narret af det polerede sprog og de kontekstuelle detaljer, som AI kan inkorporere. I laboratorietest opnåede AI-skrevne phishing-e-mails en 54% klikfrekvens - langt over ~12% for traditionelle phishing-forsøg[13]. Disse beskeder læses som en ægte CEO's stil eller refererer til virkelige virksomhedsbegivenheder, hvilket sænker modtagernes parader. Angriberne bruger endda AI til at A/B-teste forskellige formuleringer og gentage de mest succesfulde kroge.[14]. Og i modsætning til mennesker laver AI ikke slåfejl eller bliver træt - den kan spytte endeløse varianter ud, indtil en slipper forbi filtre og narrer nogen.

Et godt eksempel: I midten af 2025 vil en Reuters undersøgelse afslørede, hvordan sydøstasiatiske svindlere udnyttede ChatGPT til at automatisere svindelkommunikation[15]. De genererede overbevisende bankmails og kundeservicetekster i massevis, hvilket øgede rækkevidden af deres planer betydeligt. Europæisk politi rapporterede ligeledes om AI-drevne phishing-kits, der blev solgt på det mørke web for under $20, hvilket gjorde det muligt for lavtuddannede aktører at lancere sofistikerede kampagner.[16][17]. Adgangsbarrieren for BEC og phishing er stort set forsvundet.

Defensive foranstaltninger - Stop AI Phish: I betragtning af angrebet må organisationer styrke deres e-mail- og meddelelseskanaler. Det er her Registrering af AI-indhold kan hjælpe. Værktøjer som TruthScans AI-tekstdetektor og specialiseret e-mail-scannere kan analysere indgående beskeder for statistiske markører for AI-genereret tekst. For eksempel kan TruthScan Email Scam Detector bruger naturlig sproganalyse til at markere e-mails, der sandsynligvis stammer fra en AI, selv om de ser legitime ud[18]. Disse detektorer undersøger ting som perfekt poleret grammatik, sætningskompleksitet og stilometriske mønstre, der er usædvanlige for menneskelige forfattere. Med Scanning i realtidkan mistænkelige e-mails sættes i karantæne eller markeres til gennemgang, før de når ud til brugerne. Virksomhedernes sikkerhedsteams er begyndt at implementere sådanne AI-drevne filtre på e-mail-gateways og messaging-platforme. I praksis tilføjer dette et nyt lag af forsvar oven på traditionelle spamfiltre - et lag, der udtrykkeligt er indstillet til at fange AI-skrevet indhold. Fra 2025 integrerer førende virksomheder løsninger som TruthScan via API i deres sikre e-mail-gateways og cloud-samarbejdssuiter, hvilket skaber et automatiseret kontrolpunkt for AI-genereret phishing indhold.

Deepfake stemme- og videoimitation: Bedrageriet "at se er at bedrage"

Den måske mest håndgribelige AI-drevne trussel i 2025 er fremkomsten af deepfake stemme- og videoangreb. Ved hjælp af AI-modeller kan kriminelle klone en persons stemme ud fra blot et par sekunders lyd eller generere en realistisk video af en persons ansigt ud fra en håndfuld fotos. Disse deepfakes bliver brugt som våben i forbindelse med svindel med høj indsats - fra CEO-svindel ("fake CEO"-opkald) til falske videokonferencer og meget mere. En nylig brancherapport afslørede 47% af organisationer har oplevet deepfake-angreb af en eller anden slags[19]. Og det er ikke kun teoretisk: Flere røverier i 2023-2025 har vist, at deepfakes kan overvinde den ultimative autentificering - vores egne øjne og ører.

En berygtet sag involverede en international bankoverførsel af $25 millioner efter at en medarbejder blev snydt af en deepfake-videokonference. Angriberne brugte AI til at syntetisere billedet af virksomhedens økonomidirektør under et Zoom-opkald, komplet med hendes stemme og væremåde, og instruerede medarbejderen i at overføre penge[4][20]. I en anden hændelse i Australien blev en lokal regering tabte $2,3 millioner da svindlere forfalskede både stemme og video fra byens embedsmænd for at godkende falske betalinger[21]. Og foruroligende nok bruger kriminelle AI-klonede stemmer i "bedsteforældresvindel" - de ringer til ældre og udgiver sig for at være deres pårørende i nød. De FBI og FinCEN udsendte i slutningen af 2024 advarsler om en stigning i svindel ved hjælp af AI-genererede "deepfake"-medier, herunder falske kundeserviceagenter og syntetiske identiteter til at omgå KYC-verificeringer[22].

Hyppigheden af deepfake-baserede forbrydelser stiger hurtigt. Ved udgangen af 2024 viste en analyse Et nyt deepfake-svindelforsøg fandt sted hvert femte minut. i gennemsnit[23]. Alene i 1. kvartal 2025 steg antallet af rapporterede deepfake-hændelser med 19% sammenlignet med alle af 2024[24][25]. Deepfakes tegner sig nu for anslået 6,5% af alle svindelangreb, a 2,137% stigning siden 2022[26][27]. Den nødvendige teknologi er blevet let tilgængelig - og kræver ofte så lidt som 30 sekunders lyd for at klone en stemme, eller under en times prøveoptagelser for at modellere en persons ansigt overbevisende[20]. Kort sagt, det har aldrig været nemmere at "forfalske" en betroet persons identitet og narrer ofrene til at udlevere penge eller oplysninger.

Forsvarsforanstaltninger - autentificering af virkeligheden: For at imødegå deepfake-trusler vender organisationer sig mod avancerede Detektion af syntetiske medier værktøjer. For eksempel, TruthScans AI-stemmedetektor og TruthScan Deepfake Detector bruger AI til at analysere lyd og video for tegn på manipulation. Disse systemer udfører frame-by-frame og waveform-analyse for at spotte artefakter som unaturlige ansigtsbevægelser, problemer med læbesynkronisering eller uregelmæssigheder i lydspektret, der afslører et AI-genereret klip. I tests opnåede TruthScans algoritmer 99%+ nøjagtighed ved identifikation af AI-genererede stemmer og opdagede manipulerede videobilleder i realtid[28][29]. Faktisk brugte forskere ved Genians Security Center for nylig TruthScans billedforensik til at analysere et falsk ID-kort, der blev brugt af nordkoreanske hackere - TruthScans deepfake-billeddetektor markerede dokumentet som uægte med 98% tillidog forpurrer spear-phishing-forsøget[5][30].

Til praktisk forsvar indsætter virksomheder disse detektionsfunktioner ved vigtige choke points. Bekræftelse af stemme tilføjes til callcenter-arbejdsgange - f.eks. når en "klient" anmoder om en stor overførsel via telefon, kan lyden køres gennem en stemme-deepfake-detektor for at sikre, at det virkelig er dem (og ikke en AI-efterligning). På samme måde, platforme til videokonferencer kan integrere live deepfake-scanning af deltagernes videostrømme for at fange eventuelle syntetiske ansigter. TruthScans deepfake-detektionssuite tilbyder for eksempel Analyse af videoopkald i realtid og ansigtsgodkendelse der kan tilsluttes Zoom eller WebEx via API[31][29]. Det betyder, at hvis nogen forsøger at deltage i et møde ved hjælp af en AI-skabt video af din CEO, kan systemet markere "mulig deepfake", før der sker nogen skade. Derudover omfatter vigtige transaktioner nu ofte et verifikationstrin (out-of-band eller multifaktor), der kan udnytte indholdsautentificering - f.eks. ved at kræve en kort mundtlig bekræftelse, der derefter kontrolleres af en AI-stemmedetektor for ægthed. Ved at kombinere disse værktøjer skaber virksomhederne et sikkerhedsnet: Selv hvis medarbejderne se eller høre noget plausibelt, vil en AI-retsmedicinsk undersøgelse bag kulisserne sætte spørgsmålstegn ved dets virkelighed. I et AI-gennemtrængt trusselslandskab, "Stol ikke på - kontroller" bliver mantraet for enhver tale- eller videokommunikation, der involverer penge eller følsom adgang.

AI-skabt malware og tilsløret kode: Udviklende trusler i koden

AI's indflydelse er ikke begrænset til social engineering - den ændrer også spillet inden for udvikling af malware og undvigende angrebskode. I 2025 afslørede Googles Threat Intelligence Group den første malware-stammer ved hjælp af AI under udførelse for at ændre deres adfærd[32][33]. Et eksempel, døbt PROMPTFLUXvar et ondsindet script, der faktisk kaldte på et AI-API (Googles Gemini-model) for at omskrive sin egen kode undervejsproducerer nye tilslørede varianter for at undgå at blive opdaget af antivirusprogrammer[34][35]. Denne "just-in-time"-udvikling af AI markerer et spring mod autonom, polymorf malware. Et andet eksempel, PROMPTSTEALbrugte en AI-kodningsassistent til at generere Windows-kommandoer i én linje til datatyveri og outsourcede dermed dele af sin logik til en AI-motor i realtid.[36][37]. Disse innovationer peger på en fremtid, hvor malware løbende kan ændre sig selv - ligesom en menneskelig pen-tester ville gøre det - for at overvinde forsvaret.

Selv uden on-the-fly AI bruger angribere AI under udviklingen til at skabe mere potent ondsindet kode. Generativ AI kan producere malware, der er meget tilsløretDen indeholder lag af forvirrende logik, som vanskeliggør reverse engineering. Ifølge trusselsrapporter, over 70% af de største brud i 2025 involverede en eller anden form for polymorf malware der ændrer sin signatur eller adfærd for at undgå at blive opdaget[38]. Derudover, 76% af phishing-kampagner bruger nu polymorfe taktikker som dynamiske URL'er eller AI-omskrevne payloads[38]. Værktøjer som dark-web-tilbuddene OrmGPT og SvindelGPT (ubegrænsede kloner af ChatGPT) giver selv ikke-eksperter mulighed for at generere malware-droppere, keyloggere eller ransomware-kode ved blot at beskrive, hvad de vil have[39]. Resultatet er en overflod af nye malware-varianter. I 2024 kom der for eksempel en info-stjæler kaldet BlackMamba opstod, der var udelukkende AI-genereretog brugte ChatGPT til at skrive sin kode i segmenter - hver udførelse producerede en lidt anderledes binær fil, hvilket forvirrede traditionel signaturbaseret antivirus[38]. Sikkerhedsforskere demonstrerede også AI-genererede polymorfe proof-of-concepts, der kunne omgå mange endpoint-beskyttelser.[40].

Dertil kommer, at angribere udnytter AI til at finjustere deres levering af malware. AI kan intelligent scripte phishing-mails (som omtalt), der indeholder malware-links. Det kan også hjælpe med at udvikle exploits - f.eks. ved at bruge AI til at finde nye sårbarheder eller optimere shellcode. Nationalstatslige aktører har angiveligt brugt avancerede AI-modeller til at hjælpe med at opdage zero-day exploits og udvikle skræddersyet malware til mål.[41]. Alle disse tendenser betyder, at malware i 2025 er mere snigende og tilpasningsdygtig. Den er ofte "samskabt" med AIhvilket gør det sværere at opdage ved hjælp af konventionelle regler.

Defensive foranstaltninger - AI vs. AI i malware-forsvar: At forsvare sig mod AI-skabt malware kræver en kombination af avanceret detektion og AI-drevet analyse på den defensive side. Mange organisationer udvider deres Endpoint-beskyttelse og EDR (Endpoint Detection & Response) med AI/ML-modeller, der leder efter adfærdsmønstre i AI-genereret kode. For eksempel kan pludselige on-host kodetransformationer eller usædvanlige API-opkaldsmønstre indikere noget i retning af, at PROMPTFLUX regenererer sig selv. På samme måde kan netværksovervågning fange uregelmæssigheder som malware, der når ud til AI-tjenester (hvilket ikke er "normalt" for brugerapplikationer). Leverandører træner ML-baserede detektorer på familier af AI-assisteret malware, der er identificeret indtil videre, hvilket forbedrer genkendelsen af disse nye trusler.

En ny løsning er integreret AI-indholdsscanning i udvikler- og build-pipelines. Det betyder, at man bruger AI-drevne detektorer til at analysere scripts, software-builds eller endda konfigurationsændringer for skadeligt eller AI-genereret indhold. For eksempel, TruthScans detektor i realtid kan anvendes til mere end blot tekst - dens multimodale analyse kan potentielt markere mistænkelig kode eller konfigurationsfiler ved at genkende, om de er maskingenererede med tilsløringsmønstre.[42][43]. Udviklingsteams og MSSP'er er begyndt at scanne infrastruktur-som-kode-scripts, PowerShell-logfiler og andre artefakter for tegn på AI-skrevne segmenter, der kunne indikere en angribers hånd. Selv om det er et nyt område, er det lovende: I et tilfælde brugte et sikkerhedsteam en AI-detektor til at fange en tilsløret phishing-kit-fil, der "føltes" AI-genereret og faktisk var en del af et angreb.[44]. Filens kode var alt for kompleks og ordrig (kendetegnende for AI-generering), og en AI-indholdsscanning bekræftede en høj sandsynlighed for, at den ikke var skrevet af mennesker[40].

Endelig er deling af trusselsinformation med fokus på AI-trusler afgørende. Når Google GTIG offentliggør detaljer om Prompt-baseret malware, eller når forskere rapporterer om nye AI-omgåelsesteknikker, bør organisationer inddrage dem i deres detektionsteknik. Adfærdsanalyse - ved at se efter handlinger som en proces, der starter et script, som omskriver den samme proces' kode - kan fange uregelmæssigheder, som AI-assisteret malware udviser. Kort sagt skal forsvarere bekæmpe ild med ild: implementer AI-drevne sikkerhedsværktøjer der kan tilpasse sig lige så hurtigt, som den AI-drevne malware gør. Det omfatter alt fra AI-forbedret antivirus til analyse af brugeradfærd, der kan identificere, hvornår en konto eller et system begynder at opføre sig "ikke helt menneskeligt". Ved at bruge AI til forsvar kan sikkerhedsteams imødegå de hastigheds- og skalafordele, som AI giver angriberne.

Syntetiske identiteter og AI-drevet svindel

Fra malware til en verden af svindel: Svindel med syntetisk identitet er eksploderet ved hjælp af generativ AI. Syntetisk identitetssvindel indebærer, at man skaber fiktive personer ved at kombinere ægte og falske data (f.eks. ægte SSN + falsk navn og dokumenter). Disse "Frankenstein"-identiteter bruges derefter til at åbne bankkonti, ansøge om kredit eller bestå KYC-tjek - hvilket i sidste ende resulterer i ubetalte lån eller hvidvaskning af penge. Det var allerede en af de hurtigst voksende typer svindel, og AI har nu hældt benzin på bålet. Tab som følge af syntetisk ID-svindel krydsede $35 milliarder i 2023[45]og i begyndelsen af 2025 viste nogle skøn, at næsten 25% af alle tab ved banksvindel skyldtes syntetiske identiteter[46]. Experians analytikere fandt ud af, at over 80% af svindel med nye konti på visse markeder er nu forbundet med syntetiske ID'er[19] - en forbløffende statistik, der understreger, hvor udbredt dette svindelnummer er blevet.

Generativ AI forstærker syntetisk svindel på flere måder. For det første gør AI det trivielt at producere "Opdrætterdokumenter" og digitale fodspor, der er nødvendige for at sælge en falsk identitet. Før i tiden kunne en svindler photoshoppe et ID eller manuelt oprette falske regninger. Nu findes der værktøjer til at generere autentisk udseende profilbilleder, ID-kort, pas, kontoudtog, selv profiler på sociale medier ved hjælp af AI-billedgeneratorer og sprogmodeller[47][48]. Man kan f.eks. bruge en AI til at skabe et realistisk billede af en person, der ikke findes (hvilket forhindrer nemme søgninger med omvendt billede), og generere et matchende falsk kørekort med det billede. AI kan også simulere "livstegn" fra en identitet - f.eks. skabe optegnelser over syntetiske forældre, adresser eller opslag på sociale medier at uddybe en baggrundshistorie[49]. Boston Fed bemærkede, at Gen AI endda kan producere deepfake lyd og video af en falsk person - For eksempel kan en syntetisk bruger "dukke op" i en selfie-bekræftelsesvideo, komplet med unikt ansigt og stemme, alt sammen AI-genereret.[50].

For det andet hjælper AI svindlere opskalere deres aktiviteter. I stedet for at forfalske en eller to identiteter ad gangen kan de programmatisk generere hundredvis eller tusindvis af komplette identitetspakker og automatisk udfylde nye kontoansøgninger i massevis.[51][52]. Nogle dark web-tjenester tilbyder effektivt "Syntetiske identiteter som en service"og bruger automatisering til at producere verificerede konti til salg. Under hjælpeprogrammerne til COVID-19-pandemien brugte kriminelle f.eks. bots med AI-genererede identiteter til at ansøge i massevis om lån og ydelser, hvilket overvældede systemet med falske ansøgere. Juniper Research anslår, at de globale omkostninger ved digital identitetssvindel (drevet af disse taktikker) vil stigning 153% inden 2030 sammenlignet med 2025[53].

Defensive foranstaltninger - Verificering af identitet i en AI-verden: Traditionelle metoder til identitetssikring kæmper mod AI-skabte forfalskninger. For at tilpasse sig indfører organisationer Verifikation af identitet og adfærd i flere lag understøttet af kunstig intelligens. Et vigtigt lag er avanceret retsmedicinske undersøgelser af dokumenter og billeder. For eksempel, TruthScans AI-billeddetektor og Detektor til falske dokumenter giver mulighed for at analysere uploadede ID'er, selfies eller dokumenter for tegn på syntese eller manipulation. Disse værktøjer undersøger artefakter på pixelniveau, uoverensstemmelser i belysningen og metadata for at afgøre, om et billede er AI-genereret eller manipuleret. De kan fange subtile tegn - som identiske baggrundsmønstre fra GAN-genererede fotos eller skrifttyper og mellemrum på et ID, der ikke matcher nogen kendt regeringsskabelon. Ved at implementere sådanne detektorer ved onboarding kan banker automatisk markere en ansøgers kørekort eller selfie, hvis det sandsynligvis er AI-genereret (for eksempel ville TruthScans system have markeret det falske militær-ID, der blev brugt i Kimsuky APT-phishing-sagen[5]). Ifølge en pressemeddelelse fra TruthScan er deres platform blevet brugt af finansielle institutioner til at validere dokumenters ægthed i stor skala og identificere deepfakes med ekstremt høj nøjagtighed.[54].

Et andet lag er adfærdsanalyse og krydsreferencetjek. Rigtige identiteter har dybde - mange års historie, offentlige registre, aktivitet på sociale medier osv. AI-genererede identiteter, uanset hvor polerede de er, mangler ofte disse dybe rødder. Banker og långivere bruger nu AI til at krydskorrelere ansøgningsdata med offentlige og beskyttede data: Viser denne persons telefonnummer og e-mail en brugshistorik? Giver enhedens eller IP'ens geolokalisering mening? Skriver de data i formularer på en menneskelig måde, eller copy-paster de (som bots gør)? AI-modeller kan trænes til at skelne mellem ægte kundeadfærd og syntetiske mønstre. Federal Reserve bemærkede, at "syntetiske identiteter er overfladiske, og det kan AI se" - AI-baseret verifikation kan hurtigt søge efter en identitets digitale fodaftryk og udløse alarmer, hvis der kun findes få eller ingen.[55]. I praksis anvender identitetsbekræftelsestjenester nu AI, der kontrollerer, om en brugers selfie matcher tidligere fotos (for at opdage ansigtsudskiftninger) og endda beder brugerne om tilfældige handlinger (som specifikke positurer eller sætninger) under livskontrol, hvilket gør det sværere for deepfakes at reagere korrekt.[56][57].

Endelig, kontinuerlig overvågning af kontoadfærd efter opstart hjælper med at fange syntetiske konti, der er sluppet igennem. Da disse konti ikke er knyttet til en rigtig persona, skiller deres brugsmønstre sig ofte ud (f.eks. ved at foretage perfekt timede transaktioner for at opbygge kredit og derefter maksimere den). AI-drevet svindelovervågning (som Sifts eller Feedzais platforme) kan identificere uregelmæssigheder i, hvordan konti bruges, og markere potentielle syntetiske konti til gennemgang. Kort sagt kræver bekæmpelse af AI-aktiveret identitetssvindel AI-aktiveret identitetssikring - der kombinerer retsmedicinske dokumenter, biometriske kontroller, datakorrelation og adfærdsanalyse. Den gode nyhed er, at de samme AI-fremskridt, som muliggør svindel, også bruges til at opdage den. TruthScan tilbyder for eksempel en pakke til identitetsbekræftelse der integrerer tekst-, billed- og stemmeanalyse for at undersøge nye brugere. Ved at udnytte disse værktøjer bemærkede en stor bank et betydeligt fald i vellykkede syntetiske kontoåbninger, selv om branchegennemsnittet steg. Våbenkapløbet fortsætter, men forsvarerne er ved at lære at spotte de svage "digitale tegn" på en syntetisk konto, uanset hvor godt AI forsøger at dække sine spor.

Integrering af AI-detektion på tværs af sikkerhedsstakken

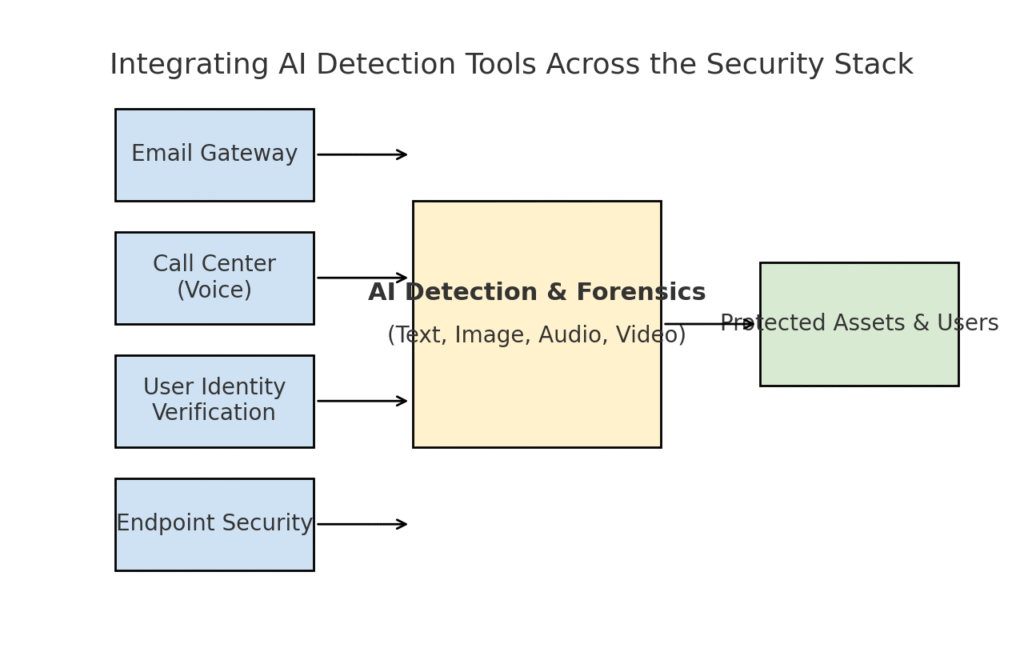

Vi har udforsket flere forskellige trusselsområder - phishing, deepfakes, malware, syntetisk svindel - alle forstærket af AI. Det er tydeligt, at intet enkelt værktøj eller engangsløsning vil løse udfordringen. I stedet har virksomhederne brug for en omfattende strategi for at Integrer AI-drevet detektion og verifikation i alle lag af deres cybersikkerhedsstack. Tilgangen skal afspejle angrebsfladen og dække e-mail, web, stemme, dokumenter, identitet og meget mere. Diagrammet nedenfor illustrerer, hvordan organisationer kan integrere TruthScans AI-detekteringsværktøjer (og lignende løsninger) på tværs af virksomhedens fælles sikkerhedslag:

Integration af AI-detekteringsværktøjer i flere lag af sikkerhedsstakken - fra e-mail-gateways og callcentre til brugerverifikation og endpoint-beskyttelse. AI-indholdsdetektering (center) analyserer tekst, billeder, lyd og video i realtid og giver input til håndhævelsespunkter, der beskytter aktiver og brugere.

I denne model, Multimodale AI-detektorer fungerer som en central hjerne der har grænseflader til forskellige sikkerhedskontroller:

- E-mail-gateways: Indgående e-mails passerer gennem en AI-tekst/scam-detektor, før de når indbakken. Dette hænger sammen med det phishing-forsvar, vi diskuterede - f.eks. ved at bruge TruthScans e-mail-svindeldetektor via API hos din e-mailudbyder til automatisk at sætte mistænkelige AI-genererede e-mails i karantæne[18]. Det kan også anvendes på meddelelsesplatforme (chat-apps, SMS-gateways) til at scanne indhold for phishing- eller svindelmønstre.

- Callcentre og stemmesystemer: Telefon- og VOIP-kanaler sikres ved at integrere voice deepfake detection. For eksempel kan en banks kundesupportlinje bruge TruthScans AI-stemmedetektor at analysere indgående opkaldslyd i realtid og advare, hvis en opkalders stemmeaftryk er syntetisk eller ikke matcher deres kendte profil[58][59]. Dette hjælper med at forhindre vishing og stemmeimitationsangreb (som falske CEO-opkald) i at lykkes.

- Processer til verificering af brugeridentitet: Under kontooprettelse eller højrisiko-brugerhandlinger (nulstilling af adgangskode, bankoverførsler) træder AI-drevet identitetsbekræftelse i kraft. Et uploadet foto-id undersøges af et billedteknisk værktøj (f.eks. for at tjekke, om det er AI-genereret eller et foto af et foto), og en selfie eller et videoopkald screenes af en deepfake-detektor. TruthScan's Deepfake-detektor kan bruges her til at udføre ansigtsautentificering - sikre, at personen på kameraet er ægte og matcher ID'et.[60][61]. Adfærdssignaler (skrivekadence, enhedskonsistens) kan også føres ind i AI-modeller for at opdage bots eller syntetiske identiteter.

- Slutpunkter og netværk: Endpoint-sikkerhedsagenter og proxyservere kan indarbejde AI-indholdsanalyse for filer og scripts. Hvis en endpoint EDR f.eks. ser et nyt script eller en EXE køre, kan den sende filens tekstindhold til en AI-detektor for at tjekke, om den ligner kendt AI-genereret malware eller udviser træk fra tilsløret AI-kode. På samme måde kan DLP-systemer (forebyggelse af datatab) bruge AI-tekstdetektering til at markere følsom tekst, der er AI-genereret (hvilket kan indikere, at en insider bruger AI til at udarbejde dataekfiltreringsmeddelelser eller forfalske rapporter). TruthScans Realtidsdetektor er designet til at indgå i sådanne arbejdsgange og tilbyder live-analyse af indhold på tværs af platforme med automatiserede svarmuligheder[42][62] (f.eks. automatisk blokering af en fil eller besked, hvis den er identificeret som AI-genereret malware eller desinformation).

Den vigtig fordel af denne integrerede tilgang er hastighed og konsistens. AI-angreb bevæger sig hurtigt - phishing-mails, falske stemmer og syntetiske data kan ramme mange kanaler på én gang. Ved at instrumentere alle disse kanaler med AI-detektion får en organisation synlighed i realtid og forsvar i dybden. Et team beskrev det som at skabe et "AI-immunsystem" for deres virksomhed: Hver gang noget kommunikeres (det være sig en e-mail, en dokumentupload, et stemmeopkald osv.), "sniffer" AI-immunsystemet det for fremmede (AI-genererede) signaturer og neutraliserer det, hvis det findes skadeligt.

TruthScans virksomhedssuite er et eksempel på dette, da den tilbyder en samlet platform dækker AI-detektion af tekst, billede, lyd og video, der kan implementeres modulært eller som en helhed[63][64]. Mange virksomheder starter med at implementere en eller to funktioner (f.eks. tekstdetektering i e-mails og billeddetektering i onboarding) og udvider derefter med andre, når de ser værdien. Det er vigtigt, at integrationen er gjort udviklervenlig - TruthScan og lignende tjenester leverer API'er og SDK'er, så sikkerhedsteams kan koble detektion ind i eksisterende systemer uden massiv ombygning. Uanset om det er en SIEM, en e-mail-gateway, en brugerdefineret bankapp eller et CRM-system, kan registreringen køre bag kulisserne og give advarsler eller automatiserede handlinger. For eksempel integrerede en stor social medieplatform API'er til indholdsmoderation for automatisk at fjerne deepfake-videoer inden for få minutter efter upload.[65][66]og forhindrer spredning af AI-genereret misinformation.

Konklusion: At være på forkant med udviklingen

Den hurtige udbredelse af AI-drevne trusler i 2025 har udfordret organisationer på nye måder. Angribere har fundet midler til at udnytte menneskelig tillid i stor skala - ved at efterligne stemmer og identiteter, automatisere social engineering, undgå forsvar gennem adaptiv kode og opfinde hele falske virkeligheder. Det er et skræmmende perspektiv for forsvarere, men ikke håbløst. Ligesom kriminelle udnytter AI, kan vi også få AI på sikkerhedens side. Fremkomsten af AI-indholdsdetektering, deepfake-forensics og syntetiske identitetsscannere giver os et stærkt modtræk mod disse nye trusler. Ved at anvende disse værktøjer og integrere dem på tværs af alle lag Som et forsvarsværk kan virksomheder dramatisk reducere risikoen for, at AI-drevne angreb slipper igennem. Tidlige brugere har allerede afværget svindelforsøg for flere millioner dollars ved at fange deepfakes på fersk gerning.[26]eller forhindret phishing-katastrofer ved at filtrere AI-skabte e-mails fra.

Ud over teknologien bør organisationer dyrke en kultur, hvor man "stoler på, men verificerer". Medarbejderne skal være opmærksomme på, at man i AI-æraen ikke altid tror, hvad man ser (eller hører) - en sund skepsis parret med verifikationsworkflows kan stoppe mange social engineering-tricks. Træning og bevidsthed kombineret med Automatiserede verifikationsværktøjer som TruthScanudgør et formidabelt forsvar. På en måde skal vi hæve barren for autentificering og validering af information. Digital kommunikation og dokumenter kan ikke længere tages for pålydende; deres oprindelse skal kontrolleres, enten maskinelt eller ved hjælp af en proces.

Når vi bevæger os fremad, kan vi forvente, at angriberne vil forfine deres AI-taktik yderligere - men vi kan også forvente fortsat innovation inden for defensiv AI. Katten-og-musen-dynamikken vil fortsætte. Succes for forsvarere vil afhænge af smidighed og deling af efterretninger. De, der hurtigt indarbejder ny trusselsinformation (f.eks. nye deepfake-detektionsteknikker eller opdaterede AI-modelsignaturer), vil holde sig foran angribere, der udnytter de nyeste AI-værktøjer. Samarbejde mellem industrien, den akademiske verden og regeringen vil også være afgørende i denne kamp, som det ses af de advarsler og rammer, der kommer fra agenturer som NIST's AI Risk Management Framework og samarbejde mellem banker om AI-detektering af svindel.

Afslutningsvis vil jeg sige, at cybersikkerhedsindustrien er midt i et AI-drevet paradigmeskifte. Truslerne er anderledes end for et årti siden, men vi møder dem med et lige så uhørt forsvar. Med en kombination af avanceret detektionsteknologi og en robust sikkerhedsstrategi kan vi kan afbøde risikoen ved generativ AI og endda vende den til vores fordel. Værktøjer som TruthScans AI-detektionspakke gør os i stand til at genopret tilliden i en verden uden tillid - for at sikre, at personen i den anden ende af linjen er ægte, at dokumentet i vores indbakke er autentisk, og at den kode, der kører i vores netværk, ikke er blevet manipuleret af en ondsindet AI. Ved at investere i disse muligheder nu vil organisationer ikke kun beskytte sig mod nutidens AI-aktiverede angreb, men også opbygge modstandsdygtighed over for morgendagens udviklende trusler. Konklusionen er klar: AI kan være med til at forstærke cyberangreb, men med den rette tilgang kan den også forstærke vores forsvar.

Kilder: Relevante data og eksempler er hentet fra 2025 trusselsefterretningsrapporter og eksperter, herunder Mayer Browns Cyber Incident Trends.[1][67], Fortinets oversigt over trusler i 2025[2][19]Barracuda-forskning om AI-e-mail-angreb[6][7], Google GTIG's rapport om AI-trusler[34], Boston Federal Reserve indsigt i syntetisk svindel[45][50]og TruthScans offentliggjorte casestudier og pressemeddelelser[30][26]blandt andre. Disse illustrerer omfanget af AI-drevne trusler og effektiviteten af AI-fokuserede modforanstaltninger i virkelige scenarier. Ved at lære af den slags intelligens og anvende avancerede værktøjer kan vi navigere trygt i en tid med AI-forstærket cyberrisiko.

[1] [67] 2025 Cyber Incident Trends What Your Business Needs to Know | Insights | Mayer Brown

[2] [3] [19] De bedste cybersikkerhedsstatistikker: Fakta, statistikker og brud i 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] AI-drevet svindel i finansielle tjenester: Nylige tendenser og løsninger | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan opdager nordkoreansk deepfake-angreb på forsvarsembedsmænd - Bryan County Magazine

[6] [7] [14] Halvdelen af spammen i din indbakke er genereret af AI - brugen af AI i avancerede angreb er på et tidligt stadie | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Q2 2025 Digital Trust Index: Data og indsigt i AI-svindel | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] AI-cybersikkerhedstrusler 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Seneste efterretninger om trusler | TruthScan

[18] [63] [64] TruthScan - AI-detektering og indholdssikkerhed for virksomheder

[23] [46] [56] [57] Deepfakes og indskud: Sådan bekæmper du generativ AI-svindel

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake-angreb og AI-genereret phishing: Statistik for 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] AI-stemmedetektor til deepfakes og stemmekloning | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identificer falske og AI-videoer - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Fremskridt i trusselsaktørers brug af AI-værktøjer | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackere tilslørede malware med detaljeret AI-kode

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] AI-detektion i realtid - TruthScan

https://truthscan.com/real-time-ai-detector

[44] EvilAI-operatører bruger AI-genereret kode og falske apps til langt ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Gen AI øger truslen om syntetisk identitetssvindel - Federal Reserve Bank of Boston

[53] Syntetisk identitetsbedrageri 2025: Strategier for AI-opdagelse og -forebyggelse