Úvod: Nová éra útoků řízených umělou inteligencí

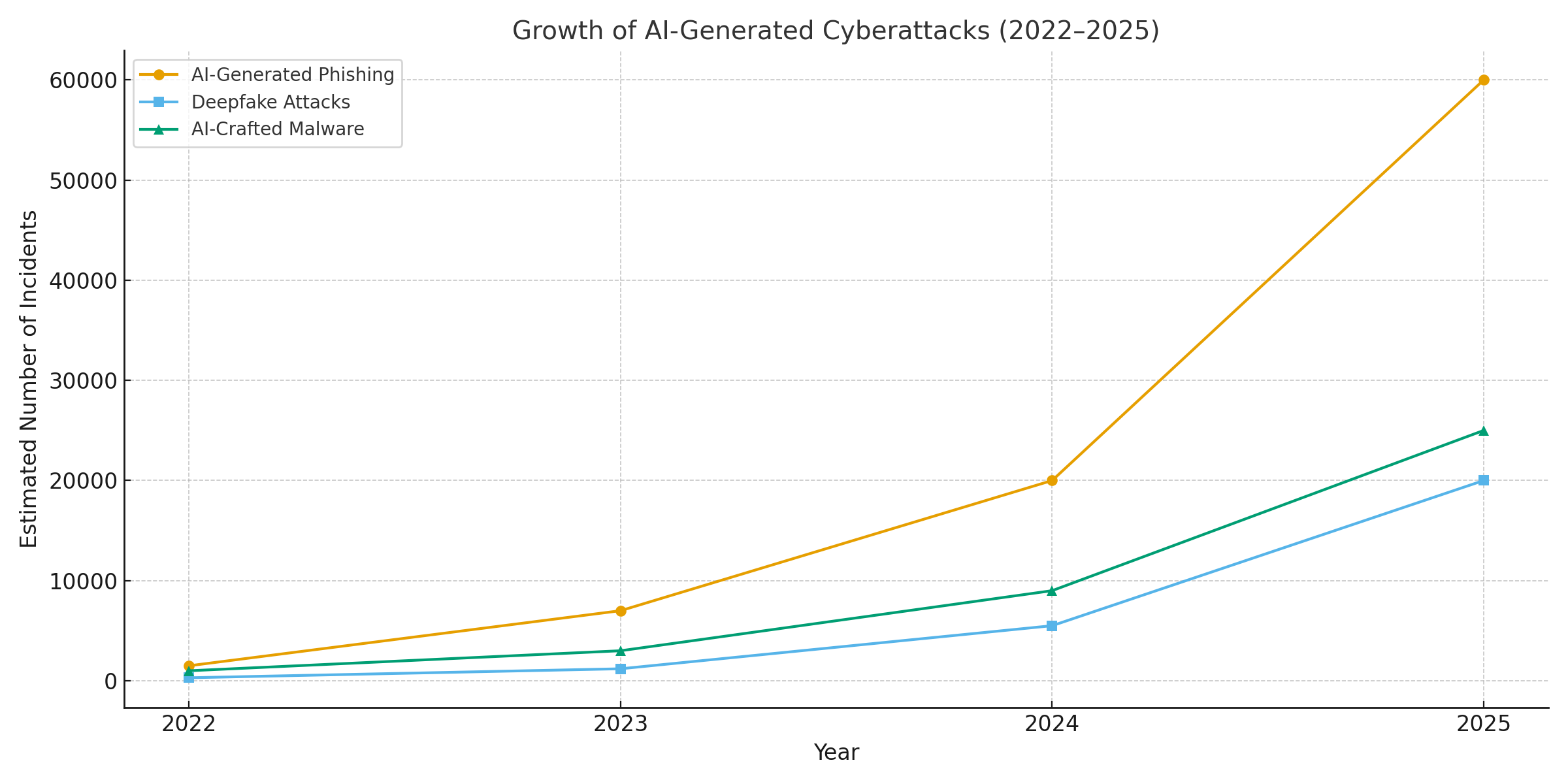

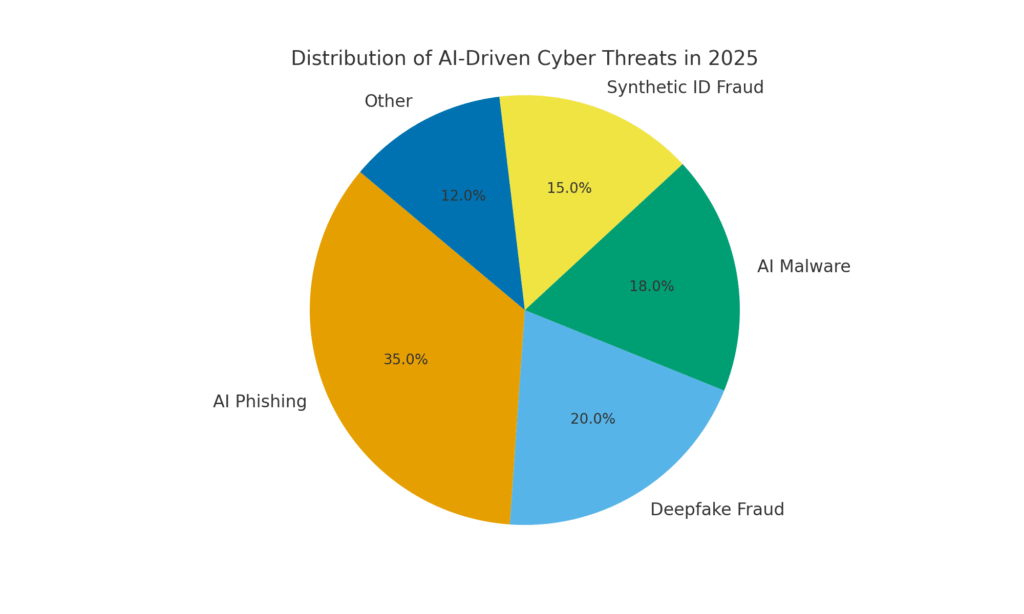

Rok 2025 představuje v oblasti kybernetické bezpečnosti zlomový bod. Generativní umělá inteligence posílila kybernetické útoky a umožnila aktérům hrozeb provádět stále více útoků. časté, realistické a škálovatelné. kampaní než kdykoli předtím. Ve skutečnosti se za poslední rok odhaduje, že 16% nahlášených kybernetických incidentů se týkalo útočníků využívajících nástroje umělé inteligence. (např. modely generování obrázků a jazyka) pro zlepšení sociálního inženýrství.[1]. Škodlivé subjekty využívají umělou inteligenci ve všech odvětvích, od velmi přesvědčivých podvodných e-mailů až po podvody s falešnými zvukovými a obrazovými záznamy. Většina bezpečnostních odborníků nyní přisuzuje nárůst kybernetických útoků díky generativní umělé inteligenci., která poskytuje zlým hráčům rychlejší a chytřejší způsoby, jak zneužít oběti.[2]. Generativní umělá inteligence efektivně snižuje laťku dovedností pro kybernetickou kriminalitu a zároveň zvyšuje její sílu.

Proč je to tak znepokojující? Umělá inteligence dokáže okamžitě vytvořit vybroušený obsah s ohledem na kontext, který oklame i vyškolené uživatele. Dokáže se s děsivou přesností vydávat za hlasy a tváře, a dokonce generovat škodlivý kód, který se mění, aby se vyhnul detekci. V důsledku toho se kybernetické útoky stávají hůře odhalitelné a snadněji proveditelné. Na adrese Světové ekonomické fórum varuje, že 72% organizací zaznamenalo zvýšená kybernetická rizika - zejména sociální inženýrství a podvody - kvůli rostoucím schopnostem generativní umělé inteligence.[3]. Skutečné události to potvrzují: Na začátku roku 2024 použili zločinci umělou inteligencí generovaný deepfake videohovor vydávat se za finančního ředitele společnosti a přimět zaměstnance k převodu. $25,6 milionu podvodníkům[4]. A v dalším případě severokorejští hackeři použili Falešné doklady totožnosti generované umělou inteligencí obejít bezpečnostní kontroly v obranné phishingové kampani.[5]. Tyto příklady zdůrazňují, co je v sázce - generativní umělá inteligence umožňuje podvody, které obcházejí lidské i technické kontroly.

Součástí řešení je však i umělá inteligence. Pokročilé detekční nástroje (jako například nástroje společnosti TruthScan) využívají AI proti Umělá inteligence - analýza obsahu s cílem zjistit jemné znaky strojového generování. V této bílé knize se budeme zabývat hlavními kybernetickými hrozbami roku 2025, které budou řízeny umělou inteligencí, a tím, jak je mohou organizace zmírnit. Z webu Phishing generovaný umělou inteligencí na deepfake CEO podvod, Malware vytvořený umělou inteligencí, syntetické identitya další, budeme zkoumat, jak generativní umělá inteligence mění podobu útoků. Probereme také konkrétní obranná opatření, např. Detekce obsahu pomocí umělé inteligence, hloubkové forenzní analýzy a technologie pro ověřování identity, které mohou bezpečnostním týmům pomoci znovu získat převahu. Cílem je osvětlit, jak mohou podniky, MSSP, CISO a vyšetřovatelé podvodů integrovat nástroje pro detekci umělé inteligence napříč celým systémem kybernetické bezpečnosti. čelit této vlně hrozeb poháněných umělou inteligencí.

Už nikdy se nemusíte obávat podvodů s umělou inteligencí. TruthScan Může vám pomoci:

- Detekce generované umělou inteligencí obrázky, text, hlas a video.

- Vyhněte se velké podvody řízené umělou inteligencí.

- Chraňte své nejzajímavější citlivé majetek podniku.

Phishing a BEC generované umělou inteligencí: podvody nebývalého rozsahu

Jedním z nejzřetelnějších dopadů generativní umělé inteligence je phishing a ohrožení firemní elektronické pošty (BEC) schémata. Jazykové modely s umělou inteligencí dokáží během několika vteřin připravit plynulé e-maily přizpůsobené kontextu a eliminovat gramatické chyby a neobratné fráze, které dříve prozrazovaly phishing. Výsledkem je záplava velmi přesvědčivých podvodných e-mailů a textů. Do dubna 2025, více než polovina nevyžádaných e-mailů (51%) byla napsána umělou inteligencí., oproti téměř nulovému stavu před dvěma lety[6]. Ještě znepokojivější je, že vědci zjistili, že přibližně 14% e-mailů s útoky BEC bylo vytvořeno umělou inteligencí. do roku 2025[7] - a očekává se, že tento počet bude stoupat s tím, jak si zločinci osvojí nástroje jako ChatGPT. Některé studie odhadují, že přes 80% phishingových e-mailů může nyní při jejich tvorbě pomáhat umělá inteligence.[8].

Objem těchto nástrah vytvořených umělou inteligencí prudce vzrostl. Bezpečnostní analýzy ukazují, že phishingové útoky spojené s generativní umělou inteligencí prudce vzrostly o 1,265% v krátkém časovém úseku[9]. V jednom období vzrostl počet hlášení phishingových incidentů o 466% v jednom čtvrtletí, a to především kvůli automatizovaným phishingovým sadám a botům, které vypouštějí přizpůsobené návnady.[9][10]. Proč takový nárůst? Protože umělá inteligence umožňuje útočníkům stupnice jejich činnosti výrazně. Jediný zločinec může pomocí chatbota s umělou inteligencí generovat tisíce personalizovaných podvodných e-mailů zaměřených na různé zaměstnance nebo zákazníky, a to vše v čase, který byl dříve potřebný k vytvoření jednoho. Tato masová automatizace vedla FBI k varování, že ztráty z BEC (které již v roce 2022 činily $2,7 miliardy) se budou jen zrychlovat, protože umělá inteligence "hrozí, že tyto ztráty ještě zvýší".[11][12].

Nejenže přibývá phishingových e-mailů, ale jsou také účinnější. Oběti jsou ve větší míře oklamány vybroušeným jazykem a kontextovými detaily, které může umělá inteligence zahrnout. V laboratorních testech dosáhly phishingové e-maily napsané umělou inteligencí úspěšnosti 54% míra prokliku - daleko vyšší než ~12% u tradičních pokusů o phishing.[13]. Tyto zprávy se čtou jako skutečný styl generálního ředitele nebo odkazují na skutečné firemní události, což snižuje ostražitost příjemců. Útočníci dokonce používají umělou inteligenci k testování různých frází a opakování nejúspěšnějších háčků.[14]. A na rozdíl od lidí umělá inteligence nedělá překlepy ani se neunaví - může chrlit nekonečné množství variant, dokud jedna neprojde filtrem a někoho neoklame.

Příklad: V polovině roku 2025 Reuters vyšetřování odhalilo, jak podvodníci z jihovýchodní Asie využívají ChatGPT k automatizaci podvodné komunikace.[15]. Hromadně vytvářeli přesvědčivé e-maily bank a texty zákaznického servisu, čímž značně zvýšili dosah svých schémat. Evropská policie podobně zaznamenala, že na temném webu se prodávají phishingové sady řízené umělou inteligencí za méně než $20, což aktérům s nízkou kvalifikací umožňuje spustit sofistikované kampaně.[16][17]. Bariéra vstupu pro BEC a phishing se v podstatě vypařila.

Obranná opatření - zastavení AI Phish: Vzhledem k tomuto náporu musí organizace posílit své e-mailové a komunikační kanály. Zde je třeba Detekce obsahu pomocí umělé inteligence může pomoci. Nástroje jako např. Detektor textu s umělou inteligencí společnosti TruthScan a specializované e-mailové skenery dokáže analyzovat příchozí zprávy na základě statistických znaků textu vytvořeného umělou inteligencí. Například Detektor e-mailových podvodů TruthScan používá analýzu přirozeného jazyka k označení e-mailů, které pravděpodobně pochází od umělé inteligence, i když vypadají legitimně.[18]. Tyto detektory zkoumají například dokonale vypilovanou gramatiku, složitost vět a stylistické vzorce, které jsou pro lidské autory neobvyklé. Pomocí stránek skenování v reálném čase, lze podezřelé e-maily umístit do karantény nebo označit ke kontrole dříve, než se dostanou k uživatelům. Podnikové bezpečnostní týmy začínají takové filtry řízené umělou inteligencí nasazovat na e-mailových branách a platformách pro zasílání zpráv. V praxi to znamená, že k tradičním spamovým filtrům se přidává nová obranná vrstva - výslovně vyladěná tak, aby zachytila obsah psaný umělou inteligencí. Od roku 2025 přední podniky integrují řešení, jako je TruthScan, prostřednictvím rozhraní API do svých zabezpečených e-mailových bran a sad pro cloudovou spolupráci, čímž vytvářejí automatizovaný kontrolní bod pro Phishing generovaný umělou inteligencí obsah.

Deepfake Voice & Video Impersonation: Podvod "Vidět klame"

Pravděpodobně nejzávažnější hrozbou v roce 2025 je vzestup umělé inteligence. deepfake hlasové a video útoky. Pomocí modelů umělé inteligence mohou zločinci naklonovat hlas člověka z několika vteřin zvuku nebo vytvořit realistické video obličeje z několika fotografií. Tyto deepfakes jsou využívány k podvodům s vysokými sázkami - od podvodů s generálními řediteli (telefonáty "falešných generálních ředitelů") až po falešné videokonference a další. Nedávná zpráva z oboru odhalila 47% organizací zažilo deepfake útoky nějakého druhu[19]. A není to jen teoretické: několik krádeží v letech 2023-2025 dokázalo, že deepfakes mohou překonat nejvyšší ověření - naše vlastní oči a uši.

Jeden z nechvalně známých případů se týkal mezinárodního bankovního převodu ve výši $25 milionů poté, co byl jeden ze zaměstnanců oklamán pomocí falešné videokonference. Útočníci použili umělou inteligenci k tomu, aby v hovoru přes Zoom syntetizovali podobu finančního ředitele společnosti, její hlas a způsoby chování, a dali zaměstnanci pokyn, aby převedl finanční prostředky.[4][20]. Při jiném incidentu v Austrálii místní vláda ztratil $2,3 milionu když podvodníci zfalšovali hlas i video městských úředníků, aby schválili podvodné platby.[21]. Znepokojivé je, že zločinci používají hlasy naklonované umělou inteligencí k "podvodům s prarodiči" - volají seniorům a vydávají se za jejich příbuzné v nouzi. Na stránkách . FBI a FinCEN koncem roku 2024 vydala varování před nárůstem podvodů s využitím "deepfake" média generovaná umělou inteligencí, včetně falešných agentů zákaznického servisu a syntetických identit, které umožňují obejít ověření KYC.[22].

Četnost trestných činů založených na deepfake rychle stoupá. Podle jedné z analýz by do konce roku 2024 mělo být každých pět minut se objevil nový deepfake podvod. v průměru[23]. Jen v 1. čtvrtletí roku 2025 vzrostl počet nahlášených deepfake incidentů o 19% ve srovnání s 1. čtvrtletím roku 2010. všechny roku 2024[24][25]. Deepfakes nyní představují odhadem 6,5% všech podvodných útoků, a 2,137% nárůst od roku 2022[26][27]. Potřebná technologie se stala snadno dostupnou - často stačí pouhá 30 sekund zvuku naklonovat hlas nebo pod hodinu ukázkového záznamu přesvědčivě vymodelovat obličej člověka.[20]. Stručně řečeno, nikdy nebylo snazší "zfalšovat" identitu důvěryhodné osoby. a vylákat od obětí peníze nebo informace.

Obranná opatření - ověřování skutečnosti: Organizace se v boji proti deepfake hrozbám obracejí na pokročilé technologie. detekce syntetických médií nástroje. Například, Detektor hlasu s umělou inteligencí společnosti TruthScan a Detektor hlubokých falzifikátů TruthScan využívat umělou inteligenci k analýze zvuku a videa a hledat známky manipulace. Tyto systémy provádějí analýzu jednotlivých snímků a průběhů a odhalují artefakty, jako jsou nepřirozené pohyby obličeje, problémy se synchronizací rtů nebo nepravidelnosti zvukového spektra, které prozrazují klip vytvořený umělou inteligencí. V testech dosáhly algoritmy TruthScan těchto výsledků 99%+ přesnost při identifikaci hlasů generovaných umělou inteligencí a v reálném čase detekoval zmanipulované videosnímky.[28][29]. Výzkumníci z Genians Security Center nedávno použili obrazovou forenzní analýzu TruthScan k analýze falešného občanského průkazu, který používali severokorejští hackeři - detektor falešných obrázků TruthScan označil dokument jako neautentický. 98% důvěra, zmaření pokusu o spear-phishing[5][30].

Pro praktickou obranu nasazují podniky tyto detekční funkce na klíčových místech. Ověřování hlasu se přidává do pracovních postupů call centra - např. když "klient" telefonicky požádá o velký převod, zvuk může být prohnán detektorem falešného hlasu, aby se zajistilo, že jde skutečně o něj (a ne o napodobeninu umělé inteligence). Podobně, videokonferenční platformy může integrovat živé hloubkové skenování videoproudů účastníků, aby zachytilo všechny syntetické obličeje. Sada pro detekci deepfake od společnosti TruthScan nabízí například tyto možnosti. analýza videohovorů v reálném čase a ověřování obličeje které se mohou připojit ke službě Zoom nebo WebEx prostřednictvím rozhraní API.[31][29]. To znamená, že pokud se někdo pokusí připojit ke schůzce pomocí videa vašeho generálního ředitele vytvořeného umělou inteligencí, systém může označit "možný deepfake" dříve, než dojde k poškození. Důležité transakce navíc nyní často zahrnují ověřovací krok (mimo pásmo nebo vícefaktorový), který může využívat ověřování obsahu - např. vyžaduje krátké ústní potvrzení, které je následně zkontrolováno detektorem hlasu AI na pravost. Vrstvením těchto nástrojů vytvářejí společnosti bezpečnostní síť: i když zaměstnanci viz nebo slyšet něco věrohodného, zákulisní forenzní AI zpochybní jeho reálnost. V prostředí prostoupeném hrozbami AI, "Nedůvěřuj - ověřuj" se stává mantrou pro jakoukoli hlasovou nebo video komunikaci týkající se peněz nebo citlivých přístupů.

Malware vytvořený umělou inteligencí a obfuskovaný kód: Vývoj hrozeb v kódu

Vliv umělé inteligence se neomezuje pouze na sociální inženýrství - mění také pravidla hry v oblasti vývoje malwaru a únikového útočného kódu. V roce 2025 odhalila skupina Threat Intelligence Group společnosti Google tzv. první kmeny malwaru využívající umělou inteligenci během provedení změny jejich chování[32][33]. Jeden z příkladů, nazvaný PROMPTFLUX, byl škodlivý skript, který ve skutečnosti volal rozhraní API umělé inteligence (model Gemini společnosti Google), aby přepisovat vlastní kód za běhu, které vytvářejí nové obfuskované varianty, aby se vyhnuly detekci antivirových programů.[34][35]. Tento "just-in-time" vývoj umělé inteligence znamená skok směrem k autonomnímu, polymorfnímu malwaru. Další ukázka, PROMPTSTEAL, použil asistenta kódování AI k vytváření jednořádkových příkazů systému Windows pro krádeže dat, čímž v podstatě v reálném čase přenechal části své logiky motoru AI.[36][37]. Tyto inovace ukazují na budoucnost, kdy se malware bude moci neustále modifikovat - podobně jako lidský pen-tester - a překonávat tak obranu.

I bez umělé inteligence za běhu používají útočníci umělou inteligenci během vývoje k vytváření silnějších škodlivých kódů. Generativní AI může vytvářet malware, který je vysoce zastřenýobsahující vrstvy matoucí logiky, které brání zpětnému inženýrství. Podle zpráv o hrozbách, více než 70% významných narušení v roce 2025 zahrnovalo nějakou formu polymorfního malwaru. který změní svůj podpis nebo chování, aby se vyhnul odhalení.[38]. Navíc, 76% phishingových kampaní nyní využívají polymorfní taktiky, jako jsou dynamické adresy URL nebo umělou inteligencí přepsaná užitečná zatížení.[38]. Nástroje, jako je nabídka dark-webu WormGPT a FraudGPT (neomezené klony ChatGPT) umožňují i neodborníkům vytvářet droppery malwaru, keyloggery nebo ransomware pouhým popisem toho, co chtějí.[39]. Výsledkem je velké množství nových variant malwaru. Například v roce 2024 se objevil zloděj informací s názvem BlackMamba se objevil, který byl generované výhradně umělou inteligencí, který používá ChatGPT k zápisu svého kódu v segmentech - každé spuštění vytváří mírně odlišnou binárku, což mate tradiční antivirové programy založené na signaturách.[38]. Výzkumníci v oblasti bezpečnosti také demonstrovali polymorfní důkazní koncepty generované umělou inteligencí, které mohou obejít mnoho ochran koncových bodů.[40].

Útočníci navíc využívají umělou inteligenci k vyladění svých útoků. doručení malwaru. Umělá inteligence dokáže inteligentně naskriptovat phishingové e-maily (jak bylo popsáno), které obsahují odkazy na malware. Může také pomoci s vývojem exploitů - např. pomocí AI najít nové zranitelnosti nebo optimalizovat shellcode. Aktéři z řad národních států údajně využívají pokročilé modely AI, které jim pomáhají při odhalování exploitů nultého dne a vývoji malwaru na míru cílovým skupinám.[41]. Všechny tyto trendy znamenají, že malware v roce 2025 bude skrytější a přizpůsobivější. Často je "spoluvytvářeny" s umělou inteligencí, což ztěžuje jeho odhalení pomocí běžných pravidel.

Obranná opatření - AI vs. AI v obraně proti malwaru: Obrana proti malwaru vytvořenému umělou inteligencí vyžaduje kombinaci pokročilé detekce a analýzy na straně obrany. Mnoho organizací rozšiřuje své ochrana koncových bodů a EDR (Endpoint Detection & Response) s modely AI/ML, které hledají vzorce chování kódu generovaného umělou inteligencí. Například náhlé transformace kódu na hostitelském počítači nebo neobvyklé vzory volání rozhraní API mohou naznačovat něco jako regeneraci PROMPTFLUX. Podobně může monitorování sítě zachytit anomálie, jako je malware, který se obrací na služby AI (což není "normální" pro uživatelské aplikace). Prodejci trénují detektory založené na ML. rodiny dosud identifikovaného malwaru s podporou umělé inteligence, což zlepšuje rozpoznávání těchto nových hrozeb.

Jedním z nově vznikajících řešení je integrované skenování obsahu umělou inteligencí do vývojových a sestavovacích procesů.. To znamená použití detektorů řízených umělou inteligencí k analýze skriptů, sestavení softwaru nebo dokonce změn konfigurace na škodlivý obsah nebo obsah generovaný umělou inteligencí. Např, Detektor TruthScan v reálném čase může být nasazena nejen na text - její multimodální analýza může potenciálně označit podezřelý kód nebo konfigurační soubory tím, že rozpozná, zda byly vytvořeny strojově s obfuskačními vzory.[42][43]. Vývojové týmy a MSSP začínají skenovat skripty infrastruktury jako kódu, protokoly PowerShellu a další artefakty, aby našli známky segmentů napsaných umělou inteligencí, které by mohly naznačovat, že je má na svědomí útočník. I když je tato oblast v počátcích, je slibná: v jednom případě bezpečnostní tým použil detektor AI k zachycení obfuskovaného souboru phishingové sady, který "vypadal" jako vytvořený AI a skutečně byl součástí útoku.[44]. Kód souboru byl příliš složitý a mnohomluvný (znaky generování umělou inteligencí) a kontrola obsahu umělou inteligencí potvrdila, že s vysokou pravděpodobností nebyl napsán člověkem.[40].

V neposlední řadě je zásadní sdílení zpravodajských informací o hrozbách zaměřených na umělou inteligenci. Když skupina Google GTIG zveřejní podrobnosti o malwaru založeném na Prompt nebo když výzkumníci ohlásí nové techniky napadení umělou inteligencí, organizace by je měly zahrnout do svého detekčního inženýrství. Analýza chování - hledání akcí, jako je spuštění skriptu procesem, který přepisuje kód téhož procesu, může zachytit anomálie, které vykazuje malware s podporou umělé inteligence. Stručně řečeno, obránci musí bojovat s ohněm ohněm: nasadit Bezpečnostní nástroje řízené umělou inteligencí které se dokáží přizpůsobit stejně rychle jako malware řízený umělou inteligencí. To zahrnuje vše od antivirových programů s podporou AI až po analýzu chování uživatelů, která dokáže rozpoznat, kdy se účet nebo systém začne chovat "ne zcela lidsky". Přijetím AI pro obranu mohou bezpečnostní týmy čelit výhodám rychlosti a rozsahu, které AI poskytuje útočníkům.

Syntetické identity a podvodná schémata poháněná umělou inteligencí

Přesun od malwaru do světa podvodů: podvody se syntetickou identitou se s pomocí generativní umělé inteligence velmi rozšířila. Syntetické podvody s identitou zahrnují vytváření fiktivních osob kombinací skutečných a falešných údajů (např. skutečné SSN + falešné jméno a doklady). Tyto "frankensteinovské" identity se pak používají k otevření bankovních účtů, žádosti o úvěr nebo k úspěšnému absolvování kontrol KYC - což nakonec vede k nesplaceným půjčkám nebo praní špinavých peněz. Již dříve se jednalo o jeden z nejrychleji rostoucích typů podvodů a umělá inteligence nyní přilila olej do ohně. Ztráty způsobené podvody se syntetickými doklady totožnosti v roce 2023 překročil $35 miliard.[45]a na začátku roku 2025 se podle některých odhadů téměř 25% všech ztrát z bankovních podvodů. byly způsobeny syntetickými identitami[46]. Analytici společnosti Experian zjistili, že více než 80% podvodů s novými účty. na některých trzích je nyní spojena se syntetickými ID.[19] - což je ohromující statistika, která dokládá, jak rozšířený je tento podvod.

Generativní umělá inteligence umocňuje syntetické podvody několika způsoby. Za prvé, umělá inteligence umožňuje triviální výrobu "chovatelské dokumenty" a digitální otisky potřebné k prodeji falešné identity. V minulosti mohl podvodník vytvořit občanský průkaz ve Photoshopu nebo ručně vytvořit falešné účty za komunální služby. Nyní existují nástroje, které umožňují generovat autenticky vypadající profilové fotografie, průkazy totožnosti, pasy, bankovní výpisy, dokonce i profily na sociálních sítích. pomocí generátorů obrazů a jazykových modelů AI[47][48]. Pomocí umělé inteligence lze například vytvořit realistickou fotografii hlavy neexistující osoby (což zabrání snadnému zpětnému vyhledávání) a vygenerovat odpovídající falešný řidičský průkaz s touto fotografií. Umělá inteligence může také simulovat "životní znaky" identity - např. vytvořit záznamy o syntetických rodičích, adresy nebo příspěvky na sociálních sítích. doplnit příběh[49]. Bostonský Fed uvedl, že Gen AI může dokonce produkovat deepfake audio a video falešné osoby - například syntetický uživatel by se mohl "objevit" ve videu s ověřením selfie, s unikátním obličejem a hlasem, a to vše vygenerované umělou inteligencí.[50].

Za druhé, AI pomáhá podvodníkům zvýšit rozsah jejich operace. Namísto jednoho nebo dvou padělaných identit najednou mohou programově generovat stovky nebo tisíce kompletních balíčků identit a automaticky hromadně vyplňovat žádosti o nové účty.[51][52]. Některé služby temného webu účinně nabízejí "Syntetické identity jako služba", které používají automatizaci k chrlení ověřených účtů k prodeji. Například během programů pomoci při pandemii COVID-19 zločinci používali boty s identitou vytvořenou umělou inteligencí, aby hromadně žádali o půjčky a dávky a zahltili systém falešnými žadateli. Jak předpokládá společnost Juniper Research, celosvětové náklady na podvody s digitální identitou (poháněné těmito taktikami) budou nárůst 153% do roku 2030 ve srovnání s rokem 2025[53].

Obranná opatření - ověřování identity ve světě umělé inteligence: Tradiční metody prokazování totožnosti mají problémy s padělky vytvořenými umělou inteligencí. Aby se přizpůsobily, přijímají organizace vícevrstvé ověřování identity a chování posílena umělou inteligencí. Klíčovou vrstvou je pokročilá forenzní analýza dokumentů a obrazů. Například, Detektor obrazu s umělou inteligencí TruthScan a Detektor falešných dokumentů umožňují analyzovat nahrané průkazy totožnosti, selfie nebo dokumenty, zda neobsahují známky syntézy nebo manipulace. Tyto nástroje zkoumají artefakty na úrovni pixelů, nesrovnalosti v osvětlení a metadata, aby určily, zda je obrázek vytvořený umělou inteligencí nebo zmanipulovaný. Mohou zachytit jemné náznaky - například shodné vzory pozadí z fotografií generovaných GAN nebo písma a rozestupy na průkazu totožnosti, které neodpovídají žádné známé vládní šabloně. Nasazením takových detektorů při nástupu do zaměstnání mohou banky automaticky označit řidičský průkaz nebo selfie žadatele, pokud je pravděpodobně vytvořen umělou inteligencí (například systém TruthScan by označil falešný vojenský průkaz použitý v případu phishingu Kimsuky APT[5]). Podle tiskové zprávy společnosti TruthScan používají její platformu finanční instituce k ověřování pravosti dokumentů ve velkém měřítku a k identifikaci falešných dokumentů s extrémně vysokou přesností.[54].

Další vrstvou je behaviorální analýza a křížové kontroly. Skutečné identity mají hloubku - dlouholetou historii, veřejné záznamy, aktivity na sociálních sítích atd. Identity generované umělou inteligencí, ať už jsou jakkoli vybroušené, často tyto hluboké kořeny postrádají. Banky a věřitelé nyní používají AI ke křížovému porovnávání údajů z žádostí s veřejnými a vlastními údaji: Ukazuje telefonní číslo a e-mail této osoby historii používání? Dává geolokace zařízení nebo IP smysl? Zadává údaje do formulářů lidským způsobem, nebo je kopíruje (jak to dělají boti)? Modely umělé inteligence lze vycvičit tak, aby rozlišovaly skutečné chování zákazníků od syntetických vzorců. Federální rezervní systém poznamenal, že "syntetické identity jsou povrchní a umělá inteligence to vidí." - Ověřování na základě umělé inteligence dokáže rychle vyhledat digitální stopu identity a vyvolat poplach, pokud se nenajde žádná nebo jen malá.[55]. V praxi nyní služby pro ověřování totožnosti využívají umělou inteligenci, která kontroluje, zda se selfie uživatele shoduje s předchozími fotografiemi (aby bylo možné odhalit záměnu obličeje), a během kontroly živosti dokonce vyzývá uživatele k náhodným akcím (jako jsou konkrétní pózy nebo fráze), což ztěžuje správnou reakci deepfakes.[56][57].

Nakonec, průběžné monitorování chování účtu po nástupu pomáhá zachytit syntetické účty, které proklouzly. Protože tyto účty nejsou vázány na skutečnou osobu, často nakonec vyniknou jejich vzorce používání (např. provádění dokonale načasovaných transakcí za účelem vybudování kreditu a jeho následné vyčerpání). Monitorování podvodů řízené umělou inteligencí (např. platformy Sift nebo Feedzai) může identifikovat anomálie ve způsobu používání účtů a označit potenciální syntetické účty ke kontrole. Souhrnně lze říci, že boj proti podvodům s identitou s využitím umělé inteligence vyžaduje Prokazování totožnosti pomocí umělé inteligence - kombinuje forenzní analýzu dokumentů, biometrické kontroly, korelaci dat a analýzu chování. Dobrou zprávou je, že stejné pokroky v oblasti umělé inteligence, které umožňují podvody, se používají i k jejich odhalování. Společnost TruthScan například nabízí tzv. sada pro ověřování totožnosti která integruje analýzu textu, obrazu a hlasu pro prověřování nových uživatelů. Díky využití těchto nástrojů zaznamenala jedna z velkých bank výrazný pokles úspěšně otevřených syntetických účtů, i když průměrné hodnoty v odvětví rostly. Závody ve zbrojení pokračují, ale obránci se učí rozpoznávat slabé "digitální znaky" syntetického účtu bez ohledu na to, jak dobře se umělá inteligence snaží zamést stopy.

Integrace detekce umělé inteligence napříč bezpečnostním systémem

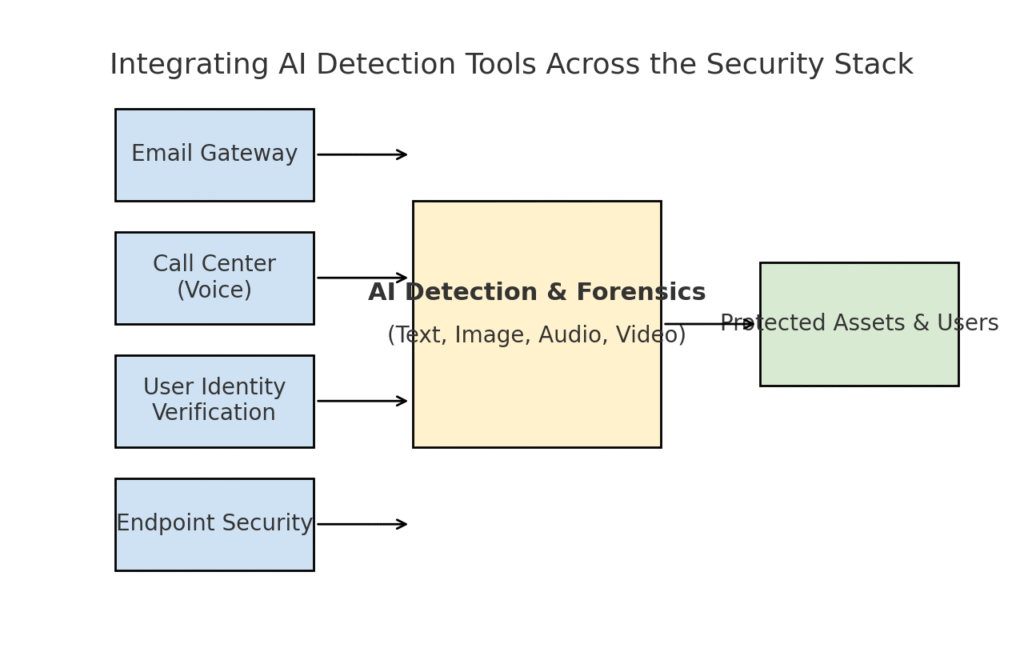

Prozkoumali jsme několik odlišných oblastí hrozeb - phishing, deepfakes, malware, syntetické podvody - a všechny jsme doplnili o umělou inteligenci. Je jasné, že žádný jediný nástroj nebo jednorázová oprava vyřeší tuto výzvu. Místo toho podniky potřebují komplexní strategii, která zakomponovat detekci a ověřování pomocí umělé inteligence do každé vrstvy. jejich zásobníku kybernetické bezpečnosti. Přístup musí odrážet plochu útoku a pokrývat e-mail, web, hlas, dokumenty, identitu a další oblasti. Níže uvedený diagram znázorňuje, jak mohou organizace integrovat nástroje pro detekci AI společnosti TruthScan (a podobná řešení) napříč běžnými vrstvami podnikového zabezpečení:

Integrace nástrojů pro detekci umělé inteligence na různých úrovních bezpečnostního balíčku - od e-mailových bran a call center až po ověřování uživatelů a ochranu koncových bodů. Detekce obsahu AI (centrum) analyzuje text, obrázky, zvuk a video v reálném čase a přispívá k bodům vynucení, které chrání aktiva a uživatele.

V tomto modelu, multimodální detektory AI fungují jako centrální mozek. který je propojen s různými bezpečnostními kontrolami:

- E-mailové brány: Příchozí e-maily procházejí před doručením do schránky detektorem textu/podvodu s umělou inteligencí. To souvisí s obranou proti phishingu, o které jsme hovořili - např. pomocí Detektor e-mailových podvodů TruthScan prostřednictvím rozhraní API u poskytovatele e-mailu automaticky umístit podezřelé e-maily generované umělou inteligencí do karantény.[18]. Lze jej použít i na platformy pro zasílání zpráv (chatovací aplikace, SMS brány) a skenovat obsah na phishingové nebo podvodné vzory.

- Call centra a hlasové systémy: Telefonní kanály a kanály VOIP jsou zabezpečeny integrací detekce falešného hlasu. Například linka zákaznické podpory banky by mohla používat Detektor hlasu s umělou inteligencí společnosti TruthScan analyzovat zvuk příchozího volajícího v reálném čase a upozornit, pokud je hlasový otisk volajícího syntetický nebo neodpovídá jeho známému profilu.[58][59]. To pomáhá zabránit úspěšným útokům typu vishing a vydávání se za hlas (např. falešné hovory s generálním ředitelem).

- Procesy ověřování totožnosti uživatele: Při zakládání účtu nebo rizikových akcích uživatele (reset hesla, bankovní převody) se spustí ověřování identity pomocí umělé inteligence. Nahraná identifikační fotografie je prověřena nástrojem pro forenzní analýzu obrázků (např. se zkontroluje, zda je vytvořena umělou inteligencí, nebo zda se jedná o fotografii fotografie) a selfie nebo videohovor je prověřen detektorem hlubokých podvrhů. TruthScan Detektor hlubokých falzifikátů lze využít k ověření pravosti obličeje - zajistit, aby osoba na kameře byla skutečná a odpovídala identifikačnímu číslu.[60][61]. Signály o chování (kadence psaní, konzistence zařízení) mohou být také vloženy do modelů umělé inteligence k odhalení botů nebo syntetických identit.

- Koncové body a síť: Agenti zabezpečení koncových bodů a proxy servery mohou zahrnovat analýzu obsahu souborů a skriptů pomocí umělé inteligence. Pokud například EDR koncového bodu zjistí, že se spouští nový skript nebo EXE, může odeslat textový obsah souboru detektoru umělé inteligence a zkontrolovat, zda se podobá známému malwaru generovanému umělou inteligencí nebo zda nevykazuje znaky obfuskovaného kódu umělé inteligence. Podobně mohou systémy DLP (prevence ztráty dat) používat detekci textu AI k označení citlivého textu, který byl vytvořen AI (což by mohlo znamenat, že zasvěcená osoba používá AI k přípravě zpráv o exfiltraci dat nebo falšování zpráv). TruthScan Detektor v reálném čase je navržen tak, aby se do těchto pracovních postupů zapojil a nabízel živou analýzu obsahu napříč platformami s možností automatické reakce.[42][62] (například automatické blokování souboru nebo zprávy, pokud je identifikována jako malware nebo dezinformace vytvořená umělou inteligencí).

Na stránkách klíčová výhoda tohoto integrovaného přístupu je rychlost a důslednost. Útoky umělé inteligence jsou rychlé - podvodné e-maily, falešné hlasy a syntetická data mohou zasáhnout mnoho kanálů najednou. Pokud všechny tyto kanály vybavíte detekcí AI, organizace získá přehled v reálném čase a hloubkovou obranu. Jeden tým to popsal jako vytvoření "AI imunitního systému" pro svůj podnik: kdykoli je něco sděleno (ať už je to e-mail, odeslání dokumentu, hlasový hovor atd.), AI imunitní systém to "očichá" na cizí (AI generované) signatury a neutralizuje to, pokud to shledá škodlivým.

Podniková sada TruthScan je toho příkladem, protože nabízí jednotná platforma pokrývající detekci textu, obrazu, zvuku a videa AI, kterou lze nasadit modulárně nebo jako celek.[63][64]. Mnoho společností začíná s nasazením jedné nebo dvou funkcí (například detekce textu v e-mailu a detekce obrázků v onboardingu) a poté, co zjistí, že se jim to vyplatí, rozšíří je o další. Důležité je, že integrace je přizpůsobena vývojářům - TruthScan a podobné služby poskytují rozhraní API a sady SDK, takže bezpečnostní týmy mohou detekci zapojit do stávajících systémů bez nutnosti rozsáhlých úprav. Ať už se jedná o SIEM, e-mailovou bránu, vlastní bankovní aplikaci nebo systém CRM, detekce může běžet za scénou a poskytovat upozornění nebo automatizované akce. Například velká platforma sociálních médií integrovala rozhraní API pro moderování obsahu, aby automaticky odstranila deepfake videa během několika minut po nahrání.[65][66], čímž se zabrání šíření dezinformací vytvářených umělou inteligencí.

Závěr: Zůstaňte na špici

Rychlé šíření hrozeb založených na umělé inteligenci v roce 2025 představuje pro organizace novou výzvu. Útočníci našli prostředky, jak zneužít důvěry lidí ve velkém měřítku - vydávají se za hlasy a identity, automatizují sociální inženýrství, obcházejí obranu pomocí adaptivního kódu a vytvářejí celé falešné reality. Pro obránce je to skličující vyhlídka, ale ne beznadějná. Stejně jako zločinci využívají umělou inteligenci, můžeme i my získat umělou inteligenci na stranu bezpečnosti. Vznik Detekce obsahu umělou inteligencí, forenzní analýza falešných dokumentů a skenery syntetické identity nám dává silné protiopatření proti těmto novým hrozbám. Nasazením těchto nástrojů a jejich integrace ve všech vrstvách obrany, mohou podniky výrazně snížit riziko, že jim útoky poháněné umělou inteligencí proklouznou. Prvním uživatelům se již podařilo zmařit mnohamilionové pokusy o podvody tím, že zachytili deepfakes přímo při činu.[26]nebo zabránil katastrofám způsobeným phishingem tím, že odfiltroval e-maily vytvořené umělou inteligencí.

Kromě technologií by organizace měly pěstovat kulturu "důvěřuj, ale prověřuj". Zaměstnanci by si měli být vědomi, že v éře umělé inteligence neznamená vždy vidět (nebo slyšet) věřit - zdravý skepticismus spojený s ověřovacími pracovními postupy může zastavit mnoho triků sociálního inženýrství. Školení a informovanost v kombinaci s automatické ověřovací nástroje, jako je TruthScan, tvoří hrozivou obranu. V jistém smyslu musíme zvýšit laťku pro ověřování a validaci informací. Digitální sdělení a dokumenty již nelze brát za bernou minci; jejich původ je třeba ověřit, a to buď strojově, nebo procesně.

S dalším vývojem očekávejte, že útočníci budou dále zdokonalovat své taktiky v oblasti umělé inteligence, ale také pokračující inovace v oblasti obranné umělé inteligence. Dynamika hry kočky s myší bude přetrvávat. Úspěch obránců bude záviset na agilita a sdílení zpravodajských informací. Ti, kteří rychle začlení nové informace o hrozbách (např. nové techniky detekce deepfake nebo aktualizované signatury modelů AI), budou mít náskok před útočníky využívajícími nejnovější nástroje AI. V tomto boji bude také zásadní spolupráce mezi průmyslem, akademickou obcí a vládou, jak je vidět z upozornění a rámců, které vznikají v agenturách, jako je rámec řízení rizik AI NIST a mezibankovní spolupráce v oblasti odhalování podvodů AI.

Závěrem lze říci, že odvětví kybernetické bezpečnosti se nachází uprostřed změny paradigmatu poháněné umělou inteligencí. Hrozby jsou jiné než před deseti lety, ale my jim čelíme stejně bezprecedentní obranou. Díky kombinaci pokročilé detekční technologie a robustní bezpečnostní strategie se nám může zmírnit rizika generativní umělé inteligence a dokonce ji obrátit v náš prospěch. Nástroje, jako je sada TruthScan pro detekci AI, nám umožňují obnovení důvěry ve světě s nulovou důvěrou - abychom se ujistili, že osoba na druhém konci linky je skutečná, že dokument v naší schránce je autentický a že kód běžící v naší síti nebyl pozměněn škodlivou umělou inteligencí. Investováním do těchto schopností nyní se organizace nejen ochrání před dnešními útoky využívajícími UI, ale také si vybudují odolnost proti vyvíjejícím se hrozbám zítřka. Závěr je jasný: Umělá inteligence možná posiluje kybernetické útoky, ale se správným přístupem může posílit i naši obranu.

Zdroje: Příslušné údaje a příklady byly čerpány z 2025 zpráv o hrozbách a od odborníků, včetně zprávy Mayer Brown Cyber Incident Trends.[1][67], Přehled hrozeb společnosti Fortinet za rok 2025[2][19], Výzkum společnosti Barracuda týkající se e-mailových útoků s umělou inteligencí[6][7], zpráva společnosti Google GTIG o hrozbách spojených s umělou inteligencí[34], Postřehy bostonské federální banky o syntetických podvodech[45][50]a zveřejněné případové studie a tiskové zprávy společnosti TruthScan.[30][26], mimo jiné. Ty ilustrují rozsah hrozeb řízených umělou inteligencí a účinnost protiopatření zaměřených na umělou inteligenci v reálných scénářích. Poučením se z těchto informací a nasazením nejmodernějších nástrojů můžeme s jistotou proplouvat érou kybernetických rizik podporovaných umělou inteligencí.

[1] [67] Trendy kybernetických incidentů v roce 2025 - co vaše firma potřebuje vědět | Insights | Mayer Brown

[2] [3] [19] Nejlepší statistiky kybernetické bezpečnosti: Fakta, statistiky a narušení pro rok 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Podvody řízené umělou inteligencí ve finančních službách: TruthScan: nejnovější trendy a řešení | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan odhalil severokorejský Deepfake útok na obranné úředníky - Bryan County Magazine

[6] [7] [14] Polovina spamu ve vaší schránce je generována umělou inteligencí - její využití v pokročilých útocích je v raném stádiu | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Index digitální důvěry za 2. čtvrtletí 2025: AI Fraud Data and Insights | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Kybernetické bezpečnostní hrozby v oblasti umělé inteligence v roce 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Nejnovější informace o hrozbách | TruthScan

[18] [63] [64] TruthScan - Podniková detekce umělé inteligence a zabezpečení obsahu

[23] [46] [56] [57] Deepfakes a depozity: Jak bojovat proti podvodům s generativní umělou inteligencí

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Deepfake útoky a phishing generovaný umělou inteligencí: statistiky za rok 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Detektor hlasu s umělou inteligencí pro hluboké podvrhy a klonování hlasu | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifikace falešných a AI videí - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] GTIG AI Threat Tracker: Pokroky v používání nástrojů umělé inteligence aktéry hrozeb | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackeři zamlžili škodlivý software slovním kódem umělé inteligence

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Detekce AI v reálném čase - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Operátoři EvilAI používají kód generovaný umělou inteligencí a falešné aplikace pro daleko...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] Generace AI zvyšuje hrozbu podvodů se syntetickou identitou - Federal Reserve Bank of Boston

[53] Syntetický podvod s identitou 2025: Strategie detekce a prevence umělé inteligence