Komplexní průvodce pro pochopení, odhalování a prevenci podvodů s hlasovou umělou inteligencí v podnicích

Hlasový hovor za $25 milionů, který se nikdy neuskutečnil

V únoru 2024 obdržela pracovnice finančního oddělení nadnárodní společnosti v Hongkongu videohovor od svého finančního ředitele.

Hlas na druhém konci byl nezaměnitelný, okamžitě poznal každé skloňování, každou pauzu a dokonce i lehký přízvuk.

Naléhavě ji požádal o zpracování 15 bankovních převodů v celkové výši $25 milionů za účelem dokončení důvěrné akvizice.

Už nikdy se nemusíte obávat podvodů s umělou inteligencí. TruthScan Může vám pomoci:

- Detekce generované umělou inteligencí obrázky, text, hlas a video.

- Vyhněte se velké podvody řízené umělou inteligencí.

- Chraňte své nejzajímavější citlivé majetek podniku.

Finanční ředitel tento hovor nikdy neprovedl. Byl kompletně vytvořen umělou inteligencí.

Nešlo o ojedinělý případ. Finanční instituce zaznamenávají prudký nárůst podvodů typu deepfake.

Za poslední tři roky se počet případů zvýšil o 2,137% a umělá inteligence je nyní příčinou 42,5% všech pokusů o podvod v tomto odvětví.

I přes prudký nárůst podvodů s hlasovou umělou inteligencí více než polovina vedoucích pracovníků firem přiznává, že jejich zaměstnanci nebyli vyškoleni, aby rozpoznali nebo reagovali na deepfake útoky; téměř 80% firem nemá zavedeny žádné formální protokoly pro řešení těchto incidentů.

Jak funguje klonování hlasu umělou inteligencí a proč představuje hrozbu

Moderní hlasová syntéza s umělou inteligencí potřebuje překvapivě málo dat. Pouhých několik sekund zvuku dokáže naklonovat hlas s přesností až 85%.

Proces se skládá ze tří hlavních kroků:

- Sběr dat: Podvodníci shromažďují hlasové vzorky z veřejných zdrojů, jako jsou konferenční hovory, rozhovory v podcastech, klipy na sociálních sítích nebo dokonce videozáznamy na LinkedIn.

- Modelové školení: Umělá inteligence analyzuje hlasové vlastnosti, jako je výška hlasu, tón, přízvuk, tempo a způsob dýchání.

- Generace: Systém vytváří syntetickou řeč dostatečně přesvědčivou na to, aby oklamal i blízké kolegy.

Problém s přístupností

Ještě nebezpečnější je demokratizace této hrozby. Podvodníci již nepotřebují zdroje na úrovni Hollywoodu.

Ke klonování hlasu z krátkého klipu na sociálních sítích stačí dostupný software; nástroje s otevřeným zdrojovým kódem a cloudové služby umělé inteligence zpřístupnily klonování hlasu komukoli se základními technickými dovednostmi.

Proč jsou vedoucí pracovníci nejčastějším cílem podvodů?

Vedoucí pracovníci čelí nebezpečné kombinaci rizikových faktorů.

Díky jejich veřejnému působení na sociálních sítích lze hlasové vzorky snadno najít a jejich autorita často vede zaměstnance k rychlému jednání v případě naléhavých požadavků.

V průměru jeden ze čtyř vedoucích pracovníků má omezené znalosti o technologii deepfake.

Současné statistiky jsou znepokojivým obrazem

V 2024 Průzkum společnosti Deloitte, 25,9% vedoucích pracovníků uvedlo, že jejich organizace čelily v uplynulém roce alespoň jednomu deepfake incidentu zaměřenému na finanční nebo účetní údaje, a polovina všech respondentů se domnívá, že v příštích 12 měsících bude takových útoků přibývat.

Nejvíce znepokojující je, že pouze 52% organizací si je jisto, že by dokázalo odhalit deepfake svého generálního ředitele.

Jak rozpoznat podvody s umělou inteligencí

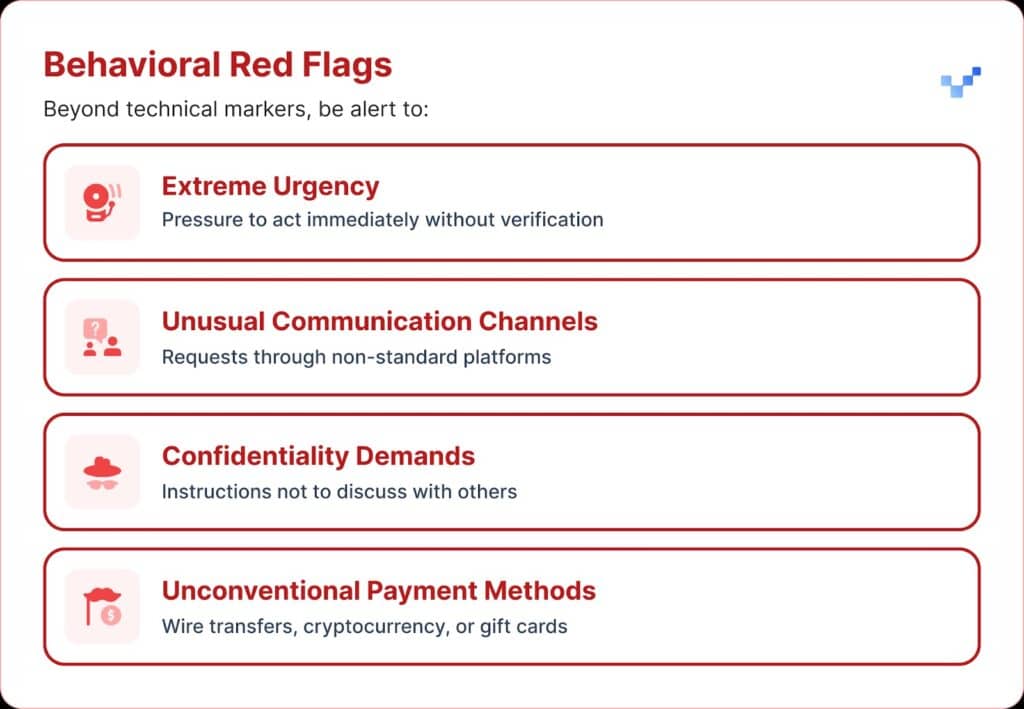

Když obdržíte podezřelou hlasovou komunikaci, je třeba si dát pozor na několik varovných signálů.

Hlasové podvody s umělou inteligencí často znějí monotónně nebo ploše. Můžete si také všimnout neobvyklého tempa s podivnými pauzami nebo nepřirozeným rytmem.

Zvuk může také obsahovat slabé elektronické bzučení nebo ozvěnu, zejména při delších hovorech.

V mnoha případech hlas opakuje omezené fráze, které působí jako napsané nebo nacvičené.

Finanční dopad a skutečné náklady

Většina organizací přišla v průměru o přibližně $450 000, ale v sektoru finančních služeb se ztráty vyšplhaly nad $603 000.

A v nejzávažnějších případech 1 z 10 organizací vykázala ztráty přesahující $1 milion.

Tento trend se rychle rozvíjí. Dřívější výzkum z roku 2022 naznačoval, že průměrná finanční zátěž podvodů s identitou činila přibližně $230 000, což je téměř polovina současného čísla.

Předpokládané budoucí ztráty

Podle Centra pro finanční služby společnosti Deloitte by se finanční ztráty způsobené podvody s umělou inteligencí v USA mohly zvýšit z $12,3 miliardy v roce 2023 na $40 miliard do roku 2027. To je přibližně 32% nárůstu každý rok.

Regionální zranitelnost

Severní Amerika zaznamenala 1740% nárůst počtu podvodů typu deepfake.

Tento výrazný regionální nárůst naznačuje, že Severní Amerika může být hlavním cílem podvodníků s falešnými údaji, pravděpodobně kvůli velké digitální ekonomice a rozšířenému využívání online služeb.

Strategické přístupy k ochraně výkonné moci

1. Zavedení ověřovacích protokolů

Jedním ze způsobů, jak posílit obranu, je použití systému "bezpečných slov", předem dohodnutých ověřovacích frází sdílených s klíčovými pracovníky.

Podvodník, který používá klonování hlasu pomocí umělé inteligence, nebude znát správné odpovědi na otázky týkající se ověření osobnosti.

Další ochranou je vícekanálové ověřování.

Jakýkoli neobvyklý finanční požadavek by měl být potvrzen prostřednictvím samostatného komunikačního kanálu, nikdy se nespoléhejte pouze na původní způsob kontaktu.

Společnosti by také měly stanovit jasná pravidla pro eskalaci, čekací lhůty a schvalovací kroky pro velké finanční transakce bez ohledu na to, kdo je požaduje.

2. Dávejte pozor na digitální expozici

Další úroveň ochrany spočívá v omezení množství výkonných zvukových a obrazových záznamů dostupných online. Čím více vzorků mohou podvodníci shromáždit, tím přesvědčivější jsou jejich klony.

Pomáhá také stanovit jasné pokyny pro vedoucí pracovníky sociálních médií, zejména pokud jde o zveřejňování videí s čistým zvukem.

A pokud jde o konference, organizace by si měly dávat pozor na nahrávky přednášek nebo rozhovorů, které prozrazují dlouhé úseky hlasových ukázek.

3. Nasazení technických řešení

Zde se stává rozhodující pokročilá technologie detekce umělé inteligence.

Organizace potřebují ověřování hlasu na podnikové úrovni a detekce hloubkových podvodů schopnosti, které poskytují:

- Analýza v reálném čase: Detekce syntetických hlasů během živé komunikace

- Historické ověření: Analýza nahraných hovorů a zpráv z hlediska pravosti

- Schopnosti integrace: Bezproblémová spolupráce se stávajícími komunikačními platformami

- Vysoká míra přesnosti: Minimalizace falešných poplachů při zachycení sofistikovaných padělků

4. Komplexní školicí programy

Vedoucí týmy potřebují cílené školení o hlasových hrozbách AI a postupech ověřování.

Stejně důležité je zvyšovat povědomí zaměstnanců.

Každý člověk na jakékoli pozici by měl být vybaven tak, aby dokázal rozpoznat potenciální deepfakes a zabránit vstupu kybernetických hrozeb do organizace.

Pravidelná simulační cvičení mohou tuto připravenost posílit pomocí falešných pokusů o hlasové podvody, které slouží k testování a zdokonalování postupů reakce.

Pokročilá řešení detekce hlasu s umělou inteligencí

Tradiční obranné systémy byly vytvořeny pro síťové hrozby, nikoliv pro vydávání se za člověka pomocí umělé inteligence.

Hlavní důvody, proč standardní nástroje kybernetické bezpečnosti nedokážou řešit sociální inženýrství založené na hlasu:

- Žádný podpis malwaru: Hlasové hovory nespustí tradiční bezpečnostní systémy

- Faktor lidské důvěry: Lidé přirozeně věří tomu, co slyší, zejména známým hlasům.

- Mezery v detekčních technologiích: Navzdory nárůstu pokusů o podvody řízené umělou inteligencí, včetně deepfakes, pouze 22% finančních institucí zavedlo nástroje pro prevenci podvodů založené na umělé inteligenci.

Potřeba specializované detekce hlasu

Moderní hlasové podvody vyžadují moderní detekční schopnosti.

Podniková třída Systémy detekce hlasu s umělou inteligencí může:

- Analýza hlasových biomarkerů: Detekce jemných nesrovnalostí v syntetické řeči

- Zpracování v reálném čase: Poskytování okamžitých upozornění při podezřelých voláních

- Průběžné učení: Přizpůsobení se novým technikám hlasové syntézy

- Připravenost k integraci: Práce se stávající komunikační infrastrukturou

Organizace, které to s ochranou proti hlasovým podvodům myslí vážně, musí investovat do účelové technologie detekce umělé inteligence, která dokáže odpovídat sofistikovanosti hrozeb, jimž čelí.

Podvody s hlasem jsou tu a jejich počet se zvyšuje

Vprvním čtvrtletí roku 2025 způsobily podvody a krádeže identity přes $200 milionů ztrát.

Hlasový phishing pomocí klonů umělé inteligence vyskočil o 442% a více než 400 firem denně je zasaženo podvody s falešnými generálními nebo finančními řediteli.

Zatímco 56% podniků tvrdí, že se cítí velmi jistě, pokud jde o rozpoznání deepfakes, pouze 6% podniků se skutečně vyhnulo finančním ztrátám z jejich strany.

Nezáleží na tom, zda se vaše organizace stane terčem útoku, ale na tom, zda jste na něj připraveni.

Hlasové podvody mění tvář kybernetické bezpečnosti. Tradiční obrana nedokáže držet krok s vydáváním se za umělou inteligenci.

Aby organizace zůstaly chráněny, potřebují lepší detekční nástroje, důkladné školicí programy a jasné ověřovací postupy.

Technologie, které umožňují bojovat, jsou již k dispozici. Otázkou je, zda ji použijete před prvním incidentem s hlasovými podvody, nebo až po něm.