Úvod

Umělá inteligence nebývalým způsobem mění prostředí finančních podvodů. Na začátku roku 2024 podvodníci použili hluboké podvrhy generované umělou inteligencí, aby se ve videohovoru vydávali za vedoucí pracovníky a podvedli zaměstnance v Hongkongu, aby převedl $25 milionů podvodníkům[1][2]. Podobné incidenty ukazují, jak generativní umělá inteligence umožňuje zločincům vytvářet velmi přesvědčivé podvody zaměřené na banky a jejich zákazníky. Regulační orgány bijí na poplach: FinCEN amerického ministerstva financí vydal koncem roku 2024 varování před rostoucím počtem podvodů využívajících "deepfake" média generovaná umělou inteligencí, včetně falešných dokladů totožnosti, které umožňují obejít bankovní ověřování.[3][4]. Tento dokument zkoumá nejnovější Trendy v oblasti podvodů s umělou inteligencí ve finančních službách a diskutuje o tom, jak mohou instituce posílit svou obranu. Prozkoumáme, jak podvodníci využívají generativní umělou inteligenci - od falešných vydávání se až po syntetické identity - a nastíníme technologie a strategie (včetně pokročilých detekčních nástrojů, jako jsou např. TruthScan), které mohou týmy pro boj s podvody a vedoucí pracovníci nasadit proti této vyvíjející se hrozbě.

Hlavní trendy v oblasti podvodů s umělou inteligencí ve finančních službách

Špatní aktéři využívají umělou inteligenci a strojové učení k provádění podvodů ve větším rozsahu a sofistikovanosti. Pozoruhodné Taktiky podvodů řízené umělou inteligencí dopady na banky, fintech a pojišťovny:

- Podvody s falešnými identitami: Zločinci používají Video a zvuk generované umělou inteligencí vydávat se za důvěryhodné osoby (generální ředitele, zákazníky atd.) v reálném čase. Například realistické deepfake hlasy byly použity při útocích typu vishing (voice phishing) k autorizaci podvodných bankovních převodů a videa vytvořená umělou inteligencí oklamala zaměstnance, aby schválili falešné transakce.[1][5]. Díky těmto syntetickým médiím je obtížné zjistit, zda skutečně mluvíte s osobou, o které si myslíte, že s ní mluvíte, což umožňuje krádeže velkých částek, jako je výše uvedený případ $25M deepfake. Deepfakes se stávají cenově dostupné a snadno vyrobitelné, které vyžadují pouhých 20-30 sekund zvuku ke klonování hlasu nebo méně než hodinu k vytvoření zdánlivě autentického videa.[6].

- Phishing a BEC s využitím umělé inteligence: Generativní umělá inteligence zvyšuje výkon systémů sociálního inženýrství, jako jsou phishingové e-maily. ohrožení firemní elektronické pošty (BEC). Chatboti s umělou inteligencí mohou připravovat vysoce personalizované podvodné e-maily v dokonalém obchodním jazyce, napodobovat styl psaní generálního ředitele nebo vytvářet přesvědčivé falešné faktury dodavatelů ve velkém měřítku. Ve skutečnosti se v podzemí objevují nástroje jako např. FraudGPT a WormGPT (nefiltrované verze ChatGPT), které pomáhají kyberzločincům automatizovat vytváření phishingu a malwaru.[7][8]. To znamená, že potenciální podvodník s minimálními dovednostmi může snadno vytvořit dokonalé phishingové kampaně nebo škodlivý kód. Díky umělé inteligenci může jediný zločinec rozeslat tisíce na míru šitých podvodných e-mailů nebo textových zpráv, což značně zvyšuje dosah tradičních pokusů o podvod. Centrum FBI pro internetovou kriminalitu již zaznamenalo, že více než $2,7 miliardy ztrát způsobených podvody BEC v roce 2022 a hrozí, že generativní umělá inteligence tyto ztráty v příštích letech ještě zvýší.[9][10].

- Syntetické identity a podvody s doklady: Generativní umělá inteligence podporuje rozmach podvodů se syntetickou identitou, jeden z nejrychleji rostoucích druhů finanční kriminality.[11][12]. Podvodníci kombinují skutečné a falešné osobní údaje, aby vytvořili "frankensteinovskou" identitu, a pak využívají umělou inteligenci k tomu, aby předložit reálné podklady. - od falešných pasů a bankovních výpisů po výplatní pásky.[7]. Generátory a nástroje pro úpravu obrázků AI mohou zfalšovat autenticky vypadající průkazy a fotografie které projdou běžnou kontrolou. Dokonce i kontroly živosti nebo ověřování selfie mohou být potenciálně překonány snímky nebo videem zmanipulovanými umělou inteligencí. Automatizovaným vytvářením tisíců falešných osob (každá s profilovými obrázky, sociálními sítěmi atd. generovanými umělou inteligencí) mohou zločinci hromadně otevírat bankovní účty nebo žádat o půjčky a prát peníze nebo nesplácet úvěry. Ztráty způsobené podvody se syntetickou identitou byly odhadnuty přibližně na $35 miliard v roce 2023[13], a generativní umělá inteligence tento trend jen urychluje tím, že zlevňuje a ztěžuje odhalování falešných identit.

- Automatizované podvody a úniky: Kromě vytváření falešného obsahu pomáhá umělá inteligence také podvodníkům. maximalizovat úspěch svých programů. Pokročilí boti mohou rychle otestovat ukradené údaje o kreditních kartách na stránkách e-shopů a pomocí ML se vyhnout spouštěčům detekce. Umělá inteligence může zločincům pomoci identifikovat nejslabší články zabezpečení organizace nebo dokonce syntetizovat hlasové odpovědi, aby překonali ověřování totožnosti pomocí telefonu. Na temném webu se nyní prodávají nástroje AI typu "podvod jako služba" za pouhých $20[14]. Tato demokratizace schopností umělé inteligence znamená, že i zločinci na nízké úrovni mohou provádět vysoce sofistikované podvodné útoky. Závody ve zbrojení se rozšiřují i na obcházení detekce - podvodníci využívají umělou inteligenci k prozkoumávání bankovních systémů proti podvodům a zdokonalují svůj přístup, dokud nenajdou metodu, která proklouzne filtry.[15]. Stručně řečeno, umělá inteligence umožňuje provádět podvody. v dosud nevídaném rozsahu a účinnosti, což zpochybňuje konvenční obranu.

Tyto taktiky využívající umělou inteligenci jsou již se množí alarmujícím tempem. Tradiční podvodná schémata, jako je padělání šeků nebo phishing, existují již léta, ale umělá inteligence zvyšuje jejich objem a realističnost. Data vypovídají jasně: Podvody s umělou inteligencí jsou prudce rostoucí.

Už nikdy se nemusíte obávat podvodů s umělou inteligencí. TruthScan Může vám pomoci:

- Detekce generované umělou inteligencí obrázky, text, hlas a video.

- Vyhněte se velké podvody řízené umělou inteligencí.

- Chraňte své nejzajímavější citlivé majetek podniku.

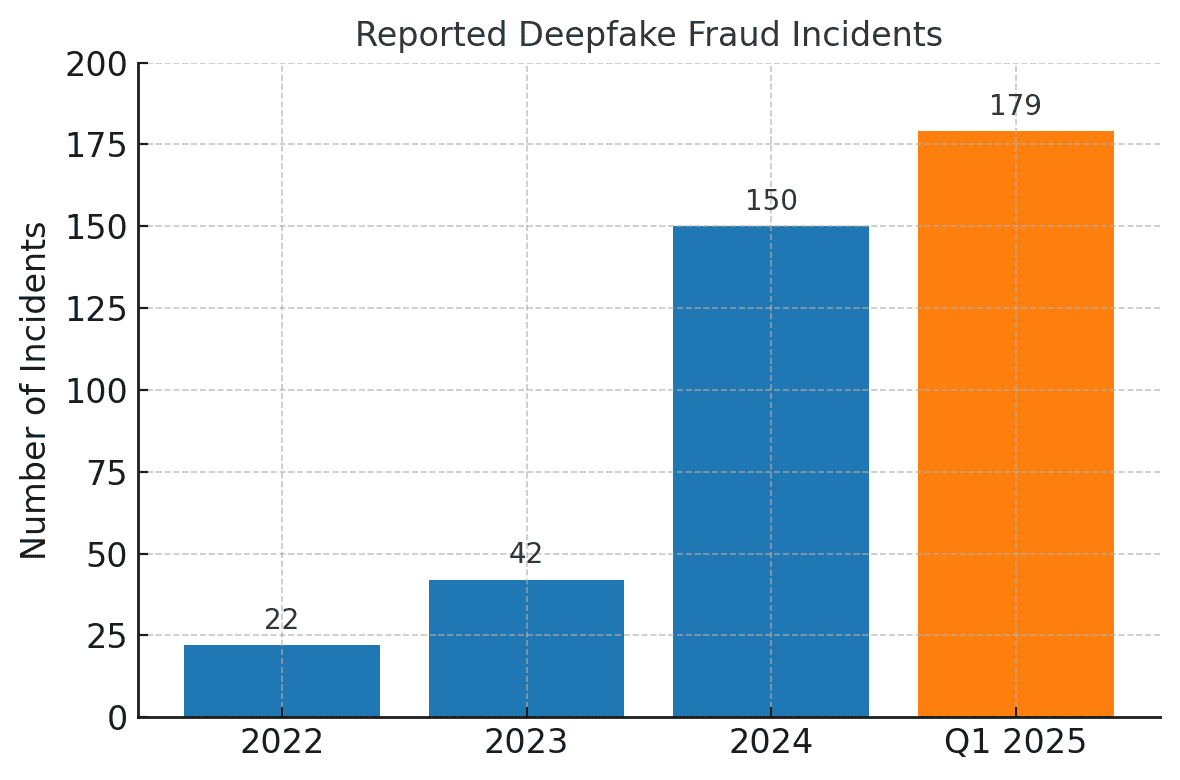

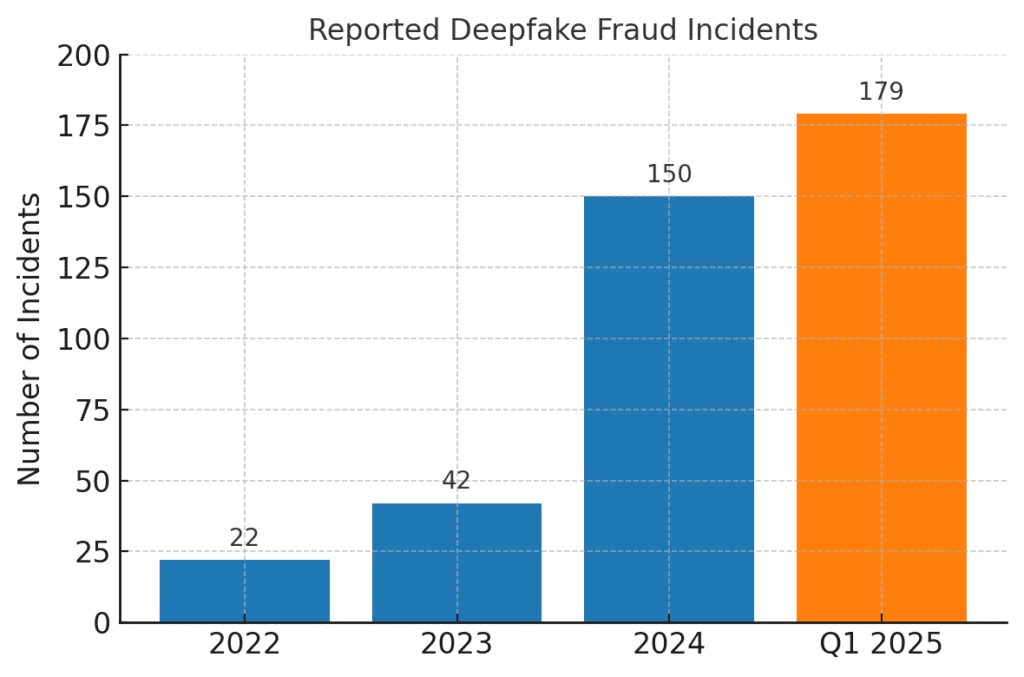

Počet případů podvodů souvisejících se službou Deepfake prudce vzrostl. V roce 2022 bylo zaznamenáno pouze 22 případů deepfake podvodů, ale v roce 2023 jich bylo 42 a v roce 2024 počet incidentů vzrostl na 150. Jen v prvním čtvrtletí roku 2025, 179 případů podvodů deepfake bylo hlášeno více než za celý rok 2024.[16][17].

Nedávné průmyslové analýzy tyto trendy potvrzují. Jedna ze zpráv zaznamenala 700% nárůst počtu případů deepfake zaměřené na fintech firmy v roce 2023[18]. Ještě více ohromující je, že v Severní Americe došlo k nárůstu 1,740% prudký nárůst případů deepfake podvodů v letech 2022 až 2023[19]. Finanční zločinci si tyto nástroje rychle osvojují, protože fungují - mnoho bank a obětí zatím není připraveno na odhalení podvodu vytvořeného umělou inteligencí.

Dopady a výzvy pro finanční instituce

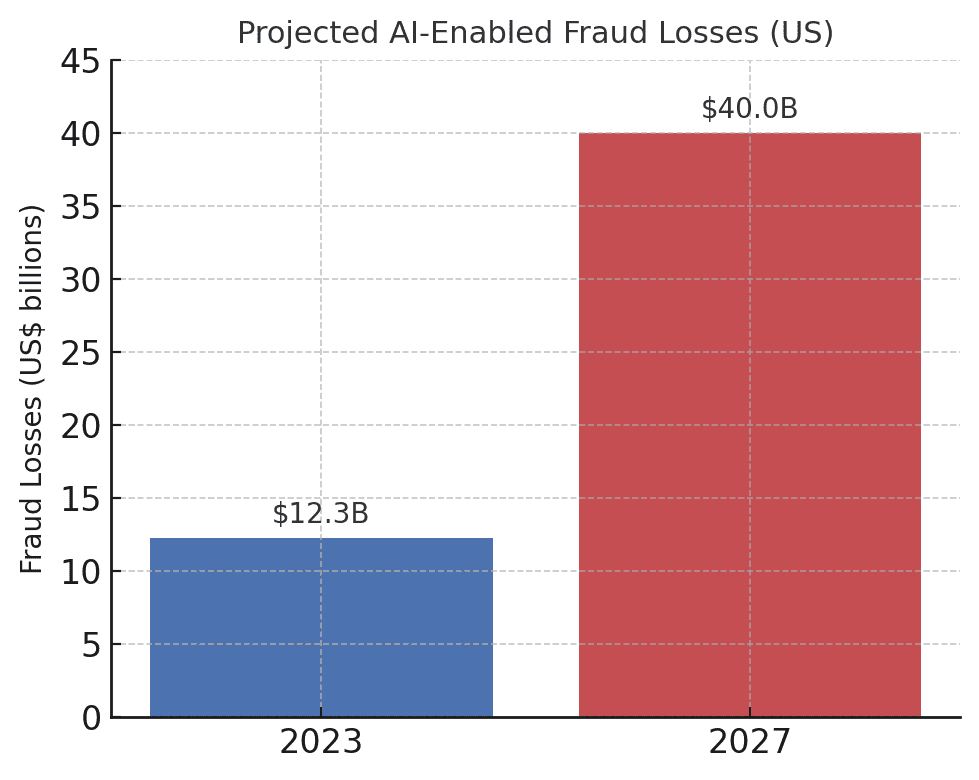

Vzestup podvodů řízených umělou inteligencí představuje významné dopady na finanční instituce, jejich zákazníky a širší finanční systém. Nejbezprostřednějším dopadem jsou peněžní ztráty. Odvětvové prognózy předpovídají, že do roku 2027, ztráty z podvodů umožněné generativní umělou inteligencí by mohly v USA dosáhnout $40 mld., což je o $12,3 miliardy více než v roce 2023.[20]. Tento více než trojnásobný nárůst (a 32% CAGR) odráží, jak rychle roste riziko podvodu v dolarovém vyjádření.

Předpokládané ztráty způsobené podvody s využitím umělé inteligence dramaticky rostou. Společnost Deloitte odhaduje, že ztráty z finančních podvodů v USA spojené s generativní umělou inteligencí vzrostou z 1,5 % na 2,5 %. $12,3 miliardy v roce 2023 na $40 miliard v roce 2027.[20].

Kromě hrubých ztrát jsou tu i ztráty na pověsti a ztráty na náklady na svěřenské fondy. Spotřebitelé očekávají, že je jejich banky ochrání, ale podvody využívající umělou inteligenci podkopávají důvěru v digitální kanály. Pokud se například zákazník stane obětí přesvědčivého deepfake podvodu (například falešného videohovoru bankéře), může banku obvinit z nedostatečného zabezpečení. Důvěra veřejnosti v hlasovém ověřování, e-mailech, a dokonce i videokonferencích může narušit, pokud "to, co vidíte/slyšíte", již nelze považovat za skutečné.[21]. Podle průzkumů považuje 85% finančních profesionálů v USA/Velké Británii deepfake podvody za "existenční" hrozbu pro bezpečnost své organizace.[22]. Více než polovina společností na těchto trzích hlásí, že se stala terčem podvodu na základě deepfake, a znepokojivé je, že více než polovina společností na těchto trzích se stala terčem podvodu na základě deepfake. 43% osob, které se staly terčem útoku, přiznalo, že útok byl úspěšný. v jejich oklamání[23]. Každý úspěšný incident způsobuje nejen finanční škody, ale také snižuje důvěru zákazníků v instituci.

Finanční firmy se také potýkají s provozní problémy a problémy s dodržováním předpisů před podvody s umělou inteligencí. Týmy pro boj proti podvodům se potýkají s nárůstem počtu upozornění a incidentů, což zatěžuje vyšetřovací zdroje. Stávající modely detekce podvodů (z nichž mnohé se spoléhají na pravidla nebo starší techniky strojového učení) mohou mít potíže s rozpoznáním obsahu syntetizovaného umělou inteligencí, který vypadá legitimně. U nejmodernějších systémů pro hloubkovou detekci falešných zpráv vyvinutých v laboratořích totiž klesá jejich přesnost téměř o 50%, když jsou konfrontovány s následujícími jevy deepfakes v reálném světě ve volné přírodě[24]. Lidé na tom nejsou o moc lépe - studie zjistily, že lidé dokáží rozpoznat kvalitní deepfake videa pouze kolem 55%-60% času, sotva lepší než náhoda[25]. To naznačuje, že bez nových nástrojů banky přehlédnou velkou část pokusů o podvody řízených umělou inteligencí.

K dispozici je také regulační rozměr. Regulační orgány a orgány činné v trestním řízení si rizika velmi dobře uvědomují (jak dokládá upozornění FinCEN) a očekávají, že se finanční instituce přizpůsobí. Banky mohou v éře umělé inteligence čelit přísnějším pokynům pro ověřování klientů a hlášení podvodů. Například pokud je zaměstnanec banky oklamán deepfake, aby schválil převod $10 milionů, mohou regulátoři pečlivě zkoumat kontrolní mechanismy a procesy hloubkové kontroly banky. Na adrese . Zákon o bankovním tajemství nyní výslovně zahrnuje hlášení podezření na kybernetickou kriminalitu a aktivity související s deepfake.[26][4], což znamená, že banky musí vyškolit zaměstnance, aby rozpoznávali a hlásili indikátory podvodů generované umělou inteligencí v hlášeních o podezřelých aktivitách (SAR). Neschopnost držet krok s technikami podvodů podporovanými umělou inteligencí by mohla vést k porušení předpisů nebo k právní odpovědnosti, pokud by klienti nebo protistrany tvrdili, že banka neudělala dost pro to, aby předešla předvídatelným podvodům podporovaným umělou inteligencí.

Asi největší výzvou je asymetrická povaha této nové hrozby. Generativní umělá inteligence výrazně snižuje náklady a kvalifikační bariéru pro útočníky a zároveň exponenciálně zvyšuje objem a realističnost útoků. Jediná virální fáma typu deepfake nebo přesvědčivý hlasový klonový hovor může zmařit milionové investice do ověřování. Zatímco obránci musí ověřovat pravost každé transakce a interakce, což je mnohem těžší úkol. Je to skutečně závod ve zbrojení: Umělá inteligence dává podvodníkům do rukou samoaktualizační sadu nástrojů, jak obejít zabezpečení, což vyžaduje, aby i banky neustále aktualizovaly své obranné systémy.[15][27]. Mnoho finančních institucí přiznává, že nejsou dostatečně připraveny - více než 80% společností nemá formální plán reakce na deepfake útoky.a více než polovina z nich neposkytla zaměstnancům žádné školení o rizicích deepfake.[28][29]. Tato mezera v připravenosti znamená, že organizace jsou v současné době zranitelné, ale také poukazuje na to, kde je třeba jednat.

Pozoruhodný a střízlivý údaj pochází z nedávné průmyslové zprávy: 42,5% pokusů o podvod ve finančním sektoru nyní zahrnuje nějakou formu umělé inteligence.[30]. Jinými slovy, téměř polovina podvodných útoků, se kterými se banky setkávají, obsahuje prvek umělé inteligence - ať už jde o dokument generovaný umělou inteligencí, syntetizovaný hlas nebo strojově generovanou podvodnou zprávu. Tato statistika zdůrazňuje, že AI není hypotetickou hrozbou budoucnosti; je již zde a nutí finanční instituce, aby se přizpůsobily, jinak budou čelit rostoucím ztrátám.

Obrana proti podvodům s využitím umělé inteligence: Strategie a řešení

Boj proti podvodům řízeným umělou inteligencí vyžaduje evoluci strategií prevence podvodů. Tradiční přístupy (jako je manuální ověřování nebo statická pravidla) se nemohou vyrovnat podvodům s umělou inteligencí, které se mění. Místo toho musí banky přijmout technology (like making sure they have a Secure SSL Certificate), training, and teamwork zvrátit situaci. Níže uvádíme klíčové strategie a nová řešení:

- Využití umělé inteligence v boji proti umělé inteligenci (pokročilé detekční nástroje): Finanční instituce se stále častěji obracejí na Detekční řešení na bázi umělé inteligence k identifikaci obsahu a anomálií vytvořených umělou inteligencí. V podstatě je třeba bojovat proti ohni ohněm. Nové podnikové nástroje, jako např. TruthScan nabízejí multimodální detekci AI v textu, obrázcích, hlasu a videu, která pomáhá ověřovat obsah v reálném čase.[31]. Banky mohou například nasadit detektory textu s umělou inteligencí, které budou skenovat příchozí komunikaci (e-maily, zprávy v chatu) a hledat v nich znaky jazyka generovaného umělou inteligencí, které by mohly naznačovat, že jde o phishingový e-mail nebo falešný dotaz zákazníka. Systém detekce textu psaného umělou inteligencí společnosti TruthScan dokáže identifikovat obsah psaný umělou inteligencí na základě modelů, jako je např. 99%+ přesnost, a dokonce určit, které věty jsou pravděpodobně vytvořeny umělou inteligencí.[32][33]. Podobně mohou nástroje pro forenzní analýzu obrazu s umělou inteligencí ověřovat dokumenty a obrazy. Detektor obrazu AI porovnáním předloženého řidičského průkazu nebo účtu za služby se známými vzory snímků vytvořených umělou inteligencí může zjistit, zda byl digitálně vytvořen nebo zmanipulován.[34]. V případě zvukových hrozeb začínají banky používat hlasové detektory falešných hlasů - řešení, která analyzují zvuk hovorů a hledají akustické otisky syntetické řeči. Například AI Voice Detector společnosti TruthScan naslouchá příznakům klonování hlasu a dokáže rozpoznat, zda se jedná o hlasový klon. ověřit pravost mluvčího zabránit podvodným voláním[35]. Integrací těchto detektorů prostřednictvím rozhraní API do svých pracovních postupů mohou finanční instituce automaticky prověřovat obsah umělé inteligence na pozadí transakcí a interakcí. To poskytuje další obrannou vrstvu, která funguje rychlostí stroje a zachytí to, co by lidským očím/uším mohlo uniknout.

- Implementace vícefaktorového a mimopásmového ověřování: Vzhledem k tomu, že je obtížnější důvěřovat hlasům nebo obrázkům, měly by banky více spoléhat na metody ověřování, které umělá inteligence nemůže snadno zfalšovat. To zahrnuje vícefaktorové ověřování (MFA) pomocí zabezpečených kanálů. Pokud například žádost o převod přijde e-mailem nebo prostřednictvím videohovoru, vyžadujte druhý faktor, například jednorázový přístupový kód zaslaný na známé mobilní zařízení žadatele nebo zpětné volání na důvěryhodné telefonní číslo v souboru. Některé banky přidávají kontroly "živosti" pro vysoce rizikové transakce - například požadují, aby zákazník pořídil živé selfie s konkrétním gestem nebo slovem, které je pro deepfake video obtížnější napodobit. Biometrické autentizátory lze rozšířit o opatření proti podvrhům (např. skenování 3D hloubky obličeje nebo sledování jemných pohybů očí, které deepfakes často nedokážou napodobit).[27]). Klíčové je vyhnout se jednotlivým bodům selhání. I když umělá inteligence dokáže oklamat jeden kanál (například hlasové ověření), koordinovaná kontrola mimo pásmo nebo biometrický test může poskytnout potřebnou výzvu k odhalení podvodu. Zásady nulové důvěry by se měl uplatňovat: považujte jakýkoli nevyžádaný nebo neočekávaný pokyn (dokonce i od "známého" vedoucího pracovníka nebo klienta) za podezřelý, dokud nebude ověřen nezávislým kanálem.

- Školení zaměstnanců a informovanost o podvodech: Samotná technologie není stříbrná kulka - zejména proto, že podvodníci se zaměřují na nejslabší článek, kterým je často lidská důvěra. Finanční instituce by měly investovat do pravidelného školení týmů prevence podvodů a zaměstnanců v první linii o podvodech založených na umělé inteligenci. Zaměstnanci se musí naučit rozpoznávat červené vlajky deepfakes a sociálního inženýrství. To může zahrnovat školení o jemných anomáliích (např. problémy se synchronizací rtů ve videohovoru nebo zvuk, který obsahuje nepřirozenou intonaci nebo příliš málo šumu v pozadí - potenciální příznaky syntetického hlasu). Podporujte kulturu ověření: zaměstnanci by se měli cítit oprávněni pozastavit podezřelou transakci nebo žádost a nezávisle ji ověřit, i když se zdá, že pochází od generálního ředitele. Případ Pokus o podvržení hlasu generálního ředitele Ferrari je poučné - výkonný pracovník odhalil lest pouze tím, že položil osobní otázku, na kterou podvodník nedokázal odpovědět.[36]. Užitečné mohou být také simulované nácviky phishingu/deepfake. Stejně jako společnosti provádějí simulace phishingu pro školení zaměstnanců, mohou simulovat deepfake hlasovou zprávu nebo falešnou videokonferenci a zjistit, zda ji zaměstnanci odhalí. Tím se buduje svalová paměť, která umožní odolávat skutečným útokům. Vzhledem k tomu, že více než 50% společností nemá žádné protokoly pro reakci na falešné informace a je málo proškoleno.[29], je zavedení takových programů nízko zavěšeným ovocem pro zlepšení odolnosti.

- Analýza podvodů a detekce anomálií: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier zvuky generované umělou inteligencí nebo příliš šablonovité (ve spojení s již zmíněnou detekcí textu umělou inteligencí). Banky jako JPMorgan začaly používat velké jazykové modely pro svou interní komunikaci, aby odhalily fráze nebo souvislosti, které by mohly naznačovat pokus o sociální inženýrství.[37]. Platební sítě, jako je Mastercard, skenují rozsáhlé soubory dat (miliardy transakcí) pomocí umělé inteligence, aby identifikovaly podvodné transakce, které by tradiční pravidla přehlédla.[38]. Z toho vyplývá, že obranná umělá inteligence musí být stejně inovativní jako útočná umělá inteligence. Firmy by měly zvážit vývoj nebo nákup modelů umělé inteligence speciálně pro detekci deepfake obsahu, syntetických identit a generativních vzorců útoků. Zásadní je, že tyto modely by měly být průběžně přeškolovány na nejnovější příklady podvodů s umělou inteligencí (postup nazývaný online učení nebo federativní učení), aby držely krok s rychle se vyvíjejícími taktikami zločinců.[39][40].

- Spolupráce a sdílení informací: Boj proti podvodům s využitím umělé inteligence bude vyžadovat spolupráci v rámci institucí i mezi nimi. Oddělené úsilí je méně účinné proti hrozbě, která překračuje organizační hranice. týmy pro prevenci podvodů, týmy kybernetické bezpečnosti a IT. musí pracovat ruku v ruce - například bezpečnostní týmy mohou v nástrojích pro videokonference nasadit hloubkovou detekci podvrhů, zatímco týmy zabývající se podvody integrují skenování obsahu do monitorování transakcí. Na širší úrovni by se banky měly zapojit do oborových skupin, jako je Centrum pro sdílení a analýzu informací o finančních službách (FS-ISAC), aby si mohly vyměňovat informace o nových podvodných schématech s umělou inteligencí.[41]. Pokud jedna banka objeví nový vektor deepfake útoku, sdílení tohoto poznatku může pomoci ostatním překonat mezeru dříve, než budou napadeni. Společná cvičení nebo simulace "červených týmů" se scénáři zahrnujícími umělou inteligenci (např. podvod s deepfake exekutivou nebo obcházení ověření totožnosti generované umělou inteligencí) lze provádět prostřednictvím odvětvových konsorcií nebo s podporou regulačních orgánů. Regulační orgány se samy zaměřují na rizika spojená s AI, takže je rozumné s nimi proaktivně spolupracovat. Přispíváním ke standardům a pokynům pro používání AI mohou banky pomoci utvářet bezpečnější ekosystém. V konečném důsledku, jelikož hrozba pro jednu banku je hrozbou pro všechny. v tomto prostoru[42], kolektivní obranný přístup posílí schopnost všech odhalovat podvody podporované umělou inteligencí a bránit jim.

- Vzdělávání zákazníků a opatření na podporu důvěry: V neposlední řadě by finanční instituce neměly přehlížet roli informovanosti zákazníků. Vzhledem k tomu, že deepfakes a podvody s umělou inteligencí cílí na širokou veřejnost (například falešné hlasy v podvodech na prarodiče nebo falešné chaty "technické podpory" generované umělou inteligencí), mohou banky pomoci vzdělávat zákazníky o těchto nebezpečích. Mnoho bank již zasílá upozornění na phishing; mohou je rozšířit o zmínku o klonování hlasů AI a deepfake videích a poskytnout rady, jak ověřit požadavky. Některé progresivní organizace zasílají oznámení push nebo varování ve svých aplikacích, pokud se šíří známý podvod (např. "Pozor: podvodníci mohou používat hlasové klony rodinných příslušníků a žádat o peníze").[43]. Vzdělávání sice přímo nezabrání útokům, ale může snížit jejich úspěšnost a posílit povědomí o tom, že banka je partnerem v oblasti bezpečnosti. Banky, které investují do nejmodernější prevence podvodů, by navíc měly tuto skutečnost klientům zdůraznit jako diferenciátor - například informování klientů o tom, že všechny videohovory nebo předložené dokumenty jsou skenovány umělou inteligencí kvůli ověření pravosti (bez prozrazení citlivých metod), může klienty ujistit, že banka využívá všechny dostupné nástroje k jejich ochraně. Zachování digitální důvěry bude pro banky zásadní, aby mohly plně využít výhod AI ve službách, proto jsou transparentnost a ochranná opatření zaměřená na zákazníky součástí komplexní obrany.

Úloha služeb detekce obsahu s umělou inteligencí

Základním kamenem souboru nástrojů proti podvodům v éře umělé inteligence je používání Služby detekce obsahu AI. Tyto služby se specializují na rozpoznávání "otisků prstů" obsahu vytvořeného umělou inteligencí, které by mohly proklouznout lidským recenzentům. Jedním z takových poskytovatelů je TruthScan, který nabízí podnikovou úroveň. Sada pro detekci umělé inteligence zahrnující více typů obsahu. Finanční instituce mohou tyto nástroje integrovat k automatické kontrole padělání a indikátorů podvodu:

- Ověřování dokumentů a obrázků: Platforma TruthScan umožňuje bankám testovat finanční dokumenty na podvody generované umělou inteligencí v reálném čase.[44]. To znamená, že při otevření nového účtu nebo žádosti o půjčku s průkazem totožnosti s fotografií a výplatní páskou může systém okamžitě analyzovat tyto snímky a hledat na nich známky syntetického vytváření nebo manipulace. S cílovou přesností přes 99%[45], detektor obrázků s umělou inteligencí dokáže zachytit falešné průkazy totožnosti nebo zfalšované soubory PDF, které by člověk mohl schválit v nominální hodnotě. Tento druh ověřování pravosti dokumentů má zásadní význam pro zastavení podvodů se syntetickou identitou ještě před otevřením účtů.

- Sledování transakcí v reálném čase: Nasazením integrace API se TruthScan může připojit ke zpracování transakcí bank a označit anomálie v. v reálném čase. Pokud přijde e-mailem pokyn, který se zdá být podezřelý, detektor e-mailového podvodu dokáže analyzovat obsah zprávy a zjistit, zda ji pravděpodobně napsal model umělé inteligence, který se snaží podvrhnout prodejce nebo vedoucího pracovníka.[46]. Stejně tak Detektor umělé inteligence v reálném čase může sledovat živou komunikaci (například chaty nebo platformy pro spolupráci) a poskytovat okamžitá upozornění, pokud je například během schůzky s vysokým rizikem zjištěn podvodný deepfake videokanál.[47][48]. Průběžné monitorování s okamžitými upozorněními a automatickými reakcemi pomáhá zkrátit dobu, kdy může dojít k neodhalenému podvodu.

- Obrana proti hlasovým a video falešným nahrávkám: Pro call centra a manažery vztahů je začlenění technologie TruthScan Detektor hlasu AI přidává další úroveň zabezpečení. Pokud podvodník volá a vydává se za klienta pomocí hlasového klonu, systém může analyzovat zvuk hovoru a označit, zda obsahuje prvky syntetizované umělou inteligencí (například chybějící přirozené mikropauzy nebo artefakty ve zvukových vlnách).[35]. Co se týče videa. Detektor hlubokých falzifikátů používá algoritmy počítačového vidění na snímky videa, aby zachytila nesrovnalosti - nepřirozené pohyby obličeje, podivné osvětlení nebo nesprávnou synchronizaci rtů -, které odhalují falešný obraz.[49][50]. Ověřováním integrity hlasů a tváří v klíčových interakcích mohou banky zabránit podvodníkům, kteří se snaží oklamat jejich zaměstnance. Tyto nástroje fungují jako high-tech detektor lži pro digitální obsah, který pracuje neviditelně v pozadí.

Je třeba poznamenat, že nasazení takové detekční technologie není všelékem; měla by být kalibrována a přizpůsobena pracovním postupům instituce. Je třeba se vypořádat s falešně pozitivními výsledky (například detektor textu s umělou inteligencí může označit legitimní komunikaci založenou na šabloně jako podezřelou, dokud se nenaučí rozlišovat). Při správné integraci však tyto nástroje výrazně zlepšují schopnost organizace odhalit podvodný obsah dříve, než způsobí škodu. Vytvářejí také auditní záznamy a analytické zprávy, které jsou užitečné pro dodržování předpisů a pro neustálé zlepšování modelů podvodů.

Účinnost nástrojů pro detekci UI závisí především na tom, zda jsou neustálé aktualizace. Stejně jako antivirový software vyžaduje nové signatury pro nové viry, i detektory umělé inteligence se musí přeškolit na nejnovější techniky deepfake a modely umělé inteligence. Prodejci, jako je TruthScan, aktualizují své algoritmy, aby zvládly nové generativní modely a taktiky vyhýbání se, a udržují tak vysokou přesnost i při vývoji AI.[51]. Tím se zbavíte břemene interních týmů a zajistíte, že banky nebudou bojovat ve včerejší válce, zatímco zločinci přejdou na nové triky s umělou inteligencí.

Závěr

Odvětví finančních služeb stojí v boji proti podvodům na křižovatce. Na jedné straně se zločinci rychle chopili generativní umělé inteligence, aby spustili podvody, které jsou přesvědčivější a rozšířenější než kdykoli předtím. Na straně druhé mají banky a bojovníci proti podvodům k dispozici stále širší arzenál obranných prostředků založených na umělé inteligenci. Dařit se bude těm institucím, které rozpoznat nové hrozby a reagovat na ně stejně vynalézavě.. To znamená investovat do pokročilých detekčních schopností, integrovat vícevrstvé ověřovací procesy, vzdělávat zaměstnance i zákazníky a podporovat kulturu ostražitosti a přizpůsobivosti.

Podvody využívající umělou inteligenci jsou rychle se měnícím cílem - podvod, který dnes oklamal společnost, může být zítra potlačen novými detekčními technikami, aby podvodníci příští týden změnili své metody. Proto je "standardní" strategie prevence podvodů v roce 2025 taková, která klade důraz na agilitu a neustálé zlepšování. Finanční organizace by měly ke svým systémům ochrany proti podvodům přistupovat jako živé, učící se subjekty které se vyvíjejí společně s kriminálními taktikami. Využití partnerství s poskytovateli technologií je chytrou zkratkou k vybudování těchto schopností. Například spolupráce se specializovanými firmami, jako je TruthScan (která nabízí řešení na míru pro bankovnictví a finančnictví), může urychlit schopnost instituce zabránit podvodům s využitím umělé inteligence a zároveň zachovat soulad s předpisy a důvěru zákazníků.[52].

Ochrana proti podvodům řízeným umělou inteligencí nakonec není jen o technologii - jde o zachování základních principů. trust která je základem financí. Zákazníci potřebují mít jistotu, že jejich banka dokáže rozeznat skutečnou transakci od falešné, skutečného klienta od podvodníka s umělou inteligencí. Zavedením špičkových nástrojů pro detekci AI, posílením ověřovacích protokolů a udržením náskoku před novými hrozbami mohou firmy poskytující finanční služby tuto důvěru udržet. Na cestě, která je před námi, se nepochybně objeví více pokusů o podvodné inovace ze strany protivníků, ale díky připravenosti a správným investicím mohou banky zajistit, že AI se stává spíše přínosem než hrozbou v oblasti prevence podvodů. Je to dosažitelný cíl: stejné technologie umělé inteligence, které hrozí narušením, lze využít k ochraně integrity našeho finančního systému. Nyní nastal čas, aby týmy pro prevenci podvodů a vedoucí pracovníci na úrovni C začali rozhodně jednat, zavádění pokročilých řešení a strategií, jak přelstít podvodníky. a zajistit budoucnost digitálních financí.

Zdroje: V celém textu jsou uvedeny odkazy na nedávné zprávy z odvětví, upozornění regulačních orgánů a technologické bílé knihy (Deloitte[20][18], Světové ekonomické fórum[19][24], Ministerstvo financí USA FinCEN[3][4], Federální rezervní systém[13], Keepnet Labs[16][30], mimo jiné), aby poskytl údaje a příklady. Všechny údaje a příklady jsou uvedeny na řádcích, aby je čtenáři mohli dále zkoumat.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking a riziko podvodů s umělou inteligencí | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] Odhalování nebezpečné umělé inteligence je v éře deepfake zásadní | Světové ekonomické fórum

[3] [4] [26] FinCEN vydává varování před podvodnými schématy s využitím falešných médií zaměřenými na finanční instituce | FinCEN.gov

[7] [8] FraudGPT a GenAI: Jak budou podvodníci využívat umělou inteligenci příště? | Slitina

[11] Podvody se syntetickou identitou: Jak umělá inteligence mění pravidla hry - Federal Reserve Bank of Boston

[12] [13] Generativní umělá inteligence zvyšuje hrozby podvodů se syntetickou identitou

[16] [17] [22] [23] [28] [29] [30] Deepfake statistiky a trendy 2025 | Klíčová data a poznatky - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Podniková detekce umělé inteligence a zabezpečení obsahu

[32] [33] [51] Detektor umělé inteligence: Detekce textu s umělou inteligencí na podnikové úrovni - TruthScan

[44] [45] [52] Odhalování podvodů pomocí umělé inteligence v bankovnictví | CRO Solutions | TruthScan

[49] [50] Deepfake Detector - Identifikace falešných a AI videí - TruthScan