Introdução

A inteligência artificial está transformando o cenário de fraudes financeiras de maneiras sem precedentes. No início de 2024, os fraudadores usaram deepfakes gerados por IA para se passar por executivos em uma chamada de vídeo - enganando um funcionário de Hong Kong para que transferisse $25 milhões para os golpistas[1][2]. Incidentes como esse demonstram como a IA generativa está capacitando os criminosos a criar golpes altamente convincentes que têm como alvo os bancos e seus clientes. Os órgãos reguladores estão soando o alarme: o FinCEN do Tesouro dos EUA emitiu um alerta no final de 2024 avisando sobre o aumento da fraude usando mídia "deepfake" gerada por IA, incluindo documentos de identidade falsos para contornar as verificações bancárias[3][4]. Este whitepaper examina os mais recentes Tendências de fraude de IA em serviços financeiros e discute como as instituições podem reforçar suas defesas. Exploramos como os fraudadores estão usando a IA generativa como arma - de falsas identidades a identidades sintéticas - e descrevemos a tecnologia e as estratégias (incluindo ferramentas avançadas de detecção como TruthScan) que as equipes de fraude e os executivos podem implementar para combater essa ameaça em evolução.

Principais tendências de fraude de IA em serviços financeiros

A IA e o aprendizado de máquina estão sendo aproveitados pelos malfeitores para realizar fraudes em maior escala e sofisticação. Notável Táticas de fraude orientadas por IA que afetam os bancos, as fintechs e as seguradoras incluem:

- Golpes de personificação de Deepfake: Os criminosos usam Vídeo e áudio gerados por IA para se passar por indivíduos confiáveis (CEOs, clientes etc.) em tempo real. Por exemplo, vozes deepfake realistas foram usadas em ataques de vishing (phishing de voz) para autorizar transferências eletrônicas fraudulentas, e vídeos criados por IA enganaram funcionários para que aprovassem transações falsas[1][5]. Essas mídias sintéticas dificultam saber se você está realmente falando com a pessoa que pensa que está, permitindo roubos de alto valor como o caso do deepfake $25M acima. As deepfakes estão se tornando econômico e fácil de produzirO sistema de áudio da Microsoft, que requer apenas 20 a 30 segundos de áudio para clonar uma voz, ou menos de uma hora para gerar um vídeo aparentemente autêntico[6].

- Phishing e BEC aprimorados por IA: A IA generativa está turbinando os esquemas de engenharia social, como e-mails de phishing e comprometimento de e-mail comercial (BEC). Os chatbots com IA podem redigir e-mails fraudulentos altamente personalizados em uma linguagem comercial perfeita, imitando o estilo de escrita de um CEO ou criando faturas falsas convincentes de fornecedores em escala. De fato, ferramentas clandestinas como FraudeGPT e WormGPT (versões não filtradas do ChatGPT) surgiram para ajudar os criminosos cibernéticos a automatizar a criação de phishing e malware[7][8]. Isso significa que um possível fraudador com habilidades mínimas pode gerar campanhas de phishing sofisticadas ou códigos maliciosos com facilidade. Com a IA, um único criminoso pode enviar milhares de e-mails ou mensagens de texto fraudulentas personalizadas, aumentando consideravelmente o alcance das tentativas de fraude tradicionais. O Internet Crime Center do FBI já observou mais de $2,7 bilhões perdidos com golpes de BEC em 2022, e a IA generativa ameaça aumentar ainda mais essas perdas nos próximos anos[9][10].

- Identidades sintéticas e fraude de documentos: A IA generativa está alimentando um boom na fraude de identidade sintéticaum dos tipos de crime financeiro que mais crescem[11][12]. Os fraudadores combinam dados pessoais reais e falsos para criar identidades "Frankenstein" e, em seguida, usam a IA para produzir documentos de apoio realistas - desde passaportes e extratos bancários falsos até contracheques[7]. AI podem forjar imagens e ferramentas de edição Identificações e fotos com aparência autêntica que passam por uma inspeção casual. Até mesmo verificações de vivacidade ou de selfies podem ser potencialmente derrotadas por imagens ou vídeos manipulados por IA. Ao automatizar a criação de milhares de personas falsas (cada uma com fotos de perfil geradas por IA, mídias sociais etc.), os criminosos podem abrir contas bancárias ou solicitar empréstimos em massa e lavar dinheiro ou não pagar o crédito. As perdas com fraudes de identidade sintética foram estimadas em cerca de $35 bilhões em 2023[13]A IA generativa está apenas acelerando essa tendência, tornando as identidades falsas mais baratas e mais difíceis de detectar.

- Fraude e evasão automatizadas: Além de criar conteúdo falso, a IA também ajuda os fraudadores maximizar o sucesso de seus esquemas. Os bots avançados podem testar rapidamente detalhes de cartões de crédito roubados em sites de comércio eletrônico, usando o aprendizado de máquina para evitar os gatilhos de detecção. A IA pode ajudar os criminosos a identificar os elos mais fracos na segurança de uma organização ou até mesmo sintetizar respostas de voz para anular a verificação de identidade baseada em telefone. Uma indústria caseira na dark web agora vende ferramentas de IA "fraude como serviço" por apenas $20[14]. Essa democratização dos recursos de IA significa que até mesmo criminosos de baixo escalão podem lançar ataques de fraude altamente sofisticados. A corrida armamentista se estende à evasão da detecção - os fraudadores usam a IA para sondar os sistemas antifraude dos bancos e refinar sua abordagem até encontrar um método que passe pelos filtros.[15]. Em resumo, a IA está permitindo que a fraude seja conduzida em uma escala e eficiência nunca antes vistas, desafiando as defesas convencionais.

Essas táticas habilitadas para IA já estão proliferando em um ritmo alarmante. Os esquemas tradicionais de fraude, como falsificação de cheques ou phishing, existem há anos, mas a IA está aumentando seu volume e realismo. Os dados contam uma história clara: A fraude com IA está crescente.

Nunca mais se preocupe com fraudes de IA. TruthScan Pode lhe ajudar:

- Detectar IA gerada imagens, texto, voz e vídeo.

- Evitar grande fraude impulsionada por IA.

- Proteja seus mais sensível ativos da empresa.

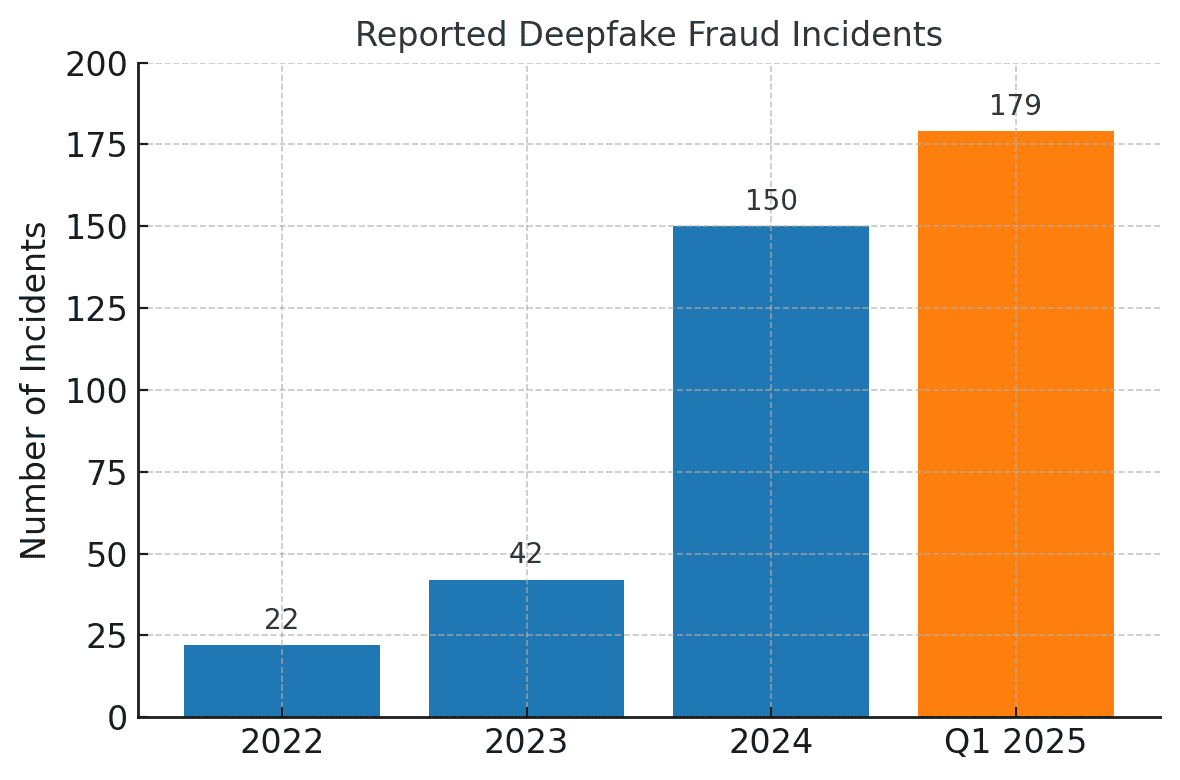

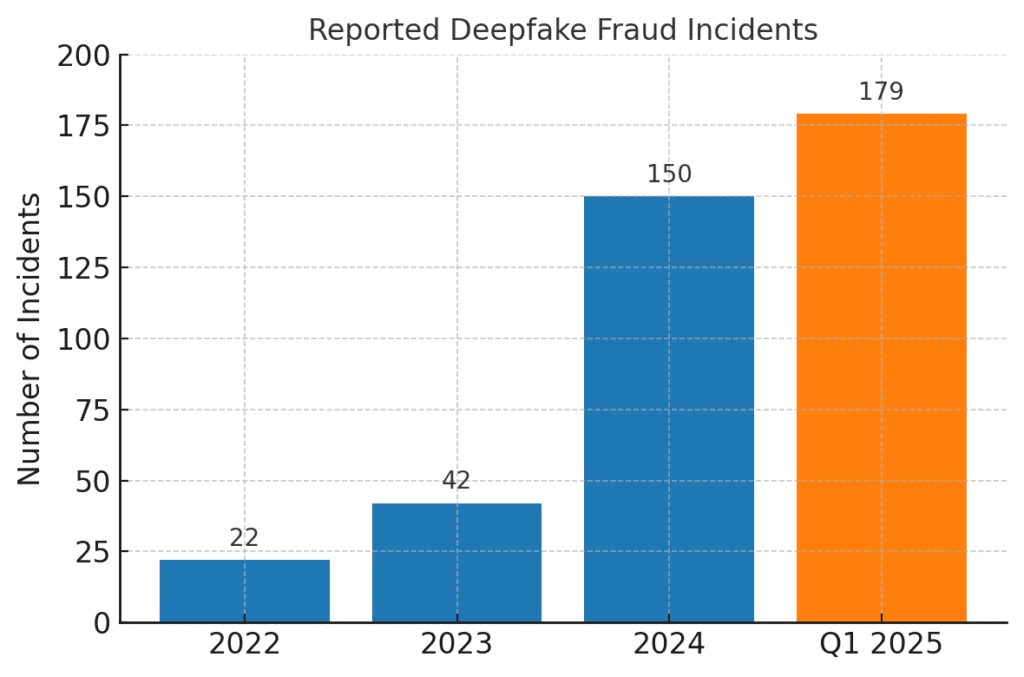

Os incidentes de fraude relacionados a deepfake dispararam. Em 2022, apenas 22 casos de fraude deepfake foram registrados, mas em 2023 foram 42 e, em 2024, os incidentes explodiram para 150. Apenas no primeiro trimestre de 2025, 179 incidentes de fraude deepfake foram registrados - excedendo o total de todo o ano de 2024[16][17].

Análises recentes do setor refletem essas tendências. Um relatório observou um 700% aumento nos incidentes de deepfake visando empresas de fintech em 2023[18]. Ainda mais surpreendente, a América do Norte registrou um 1,740% aumento nos casos de fraude deepfake entre 2022 e 2023[19]. Os criminosos financeiros estão adotando rapidamente essas ferramentas porque elas funcionam - muitos bancos e vítimas ainda não estão preparados para detectar fraudes geradas por IA.

Impactos e desafios para as instituições financeiras

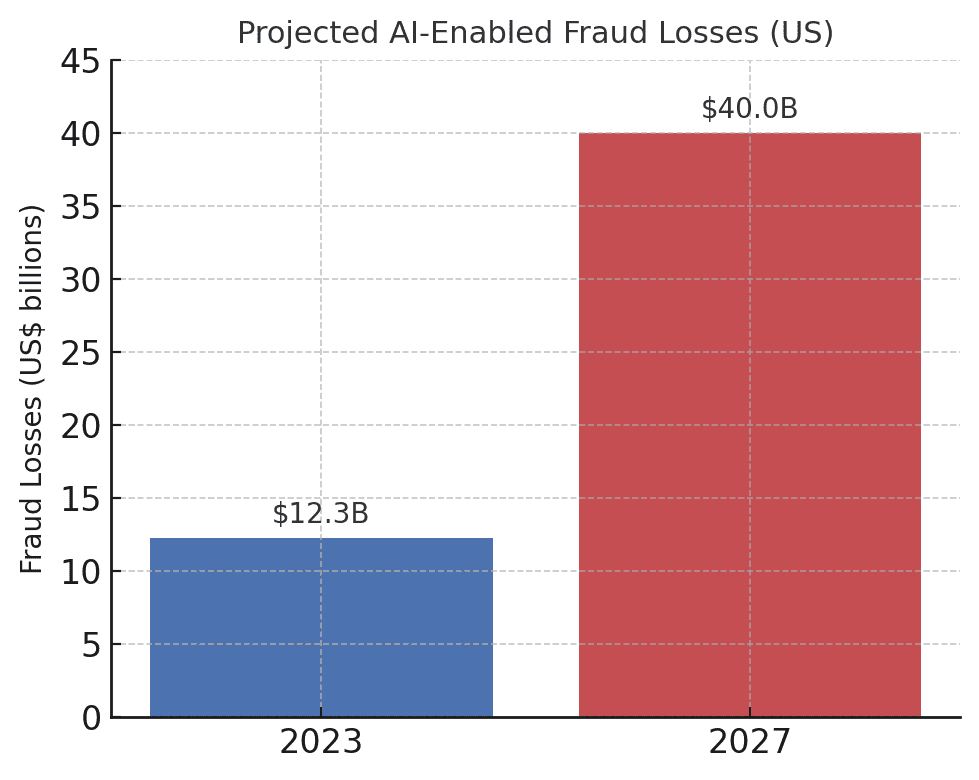

O surgimento de fraudes baseadas em IA representa impactos significativos sobre as instituições financeiras, seus clientes e o sistema financeiro em geral. O impacto mais imediato é a perda monetária. As previsões do setor preveem que até 2027, As perdas com fraudes possibilitadas pela IA generativa podem chegar a $40 bilhões nos EUA, acima dos $12,3 bilhões em 2023[20]. Esse aumento de mais de três vezes (a 32% CAGR) reflete a rapidez com que o risco de fraude está crescendo em termos de dólares.

As perdas projetadas com fraudes habilitadas por IA estão aumentando drasticamente. A Deloitte estima que as perdas com fraudes financeiras nos EUA ligadas à IA geradora aumentarão de $12,3 bilhões em 2023 para $40 bilhões em 2027[20].

Além das perdas brutas, há perdas de reputação e custos fiduciários. Os consumidores esperam que seus bancos os protejam, mas os golpes que usam IA estão minando a confiança nos canais digitais. Por exemplo, se um cliente for vítima de um golpe convincente de deepfake (como uma chamada de vídeo falsa do banco), ele poderá culpar o banco pela segurança inadequada. Confiança do público em verificação de voz, e-mails e até mesmo em videoconferências podem ser corroídos se "o que você vê/ouve" não puder mais ser considerado real[21]. De acordo com pesquisas, 85% dos profissionais de finanças nos EUA/Reino Unido veem os golpes de deepfake como uma ameaça "existencial" à segurança de suas organizações[22]. Mais da metade das empresas nesses mercados relatam ter sido alvo de um golpe alimentado por deepfake e, de forma alarmante 43% das pessoas visadas admitiram que o ataque foi bem-sucedido em enganá-los[23]. Cada incidente bem-sucedido não apenas causa danos financeiros, mas também reduz a confiança do cliente na instituição.

As empresas financeiras também estão lidando com desafios operacionais e de conformidade da fraude com IA. As equipes antifraude enfrentam um aumento de alertas e incidentes, o que sobrecarrega os recursos de investigação. Os modelos de detecção de fraude existentes (muitos dos quais dependem de regras ou de técnicas antigas de aprendizado de máquina) podem ter dificuldades para reconhecer conteúdo sintetizado por IA que pareça legítimo. De fato, os sistemas de detecção de deepfake de última geração desenvolvidos em laboratórios veem sua precisão cair em quase 50% quando confrontados com deepfakes do mundo real na natureza[24]. A equipe humana não se sai muito melhor - estudos descobriram que as pessoas só conseguem identificar vídeos deepfake de alta qualidade em torno de 55%-60% do tempo, pouco melhor que o acaso[25]. Isso indica que, sem novas ferramentas, os bancos deixarão passar uma grande parte das tentativas de fraude orientadas por IA.

Há também um dimensão regulatória. Os órgãos reguladores e as autoridades policiais estão bem cientes dos riscos (conforme evidenciado pelo alerta do FinCEN) e esperam que as instituições financeiras se adaptem. Os bancos podem enfrentar diretrizes mais rígidas sobre verificação de clientes e relatórios de fraude na era da IA. Por exemplo, se o funcionário de um banco for enganado por um deepfake para aprovar uma transferência de $10 milhões, os órgãos reguladores poderão examinar os controles e os processos de due diligence do banco. Os Lei de sigilo bancário agora inclui explicitamente a denúncia de suspeitas de crimes cibernéticos e atividades relacionadas a deepfake[26][4]Isso significa que os bancos devem treinar a equipe para reconhecer e relatar indicadores de fraude gerados por IA nos Relatórios de Atividades Suspeitas (SARs). Não acompanhar as técnicas de fraude aprimoradas por IA pode levar a violações de conformidade ou responsabilidade legal se os clientes ou contrapartes argumentarem que o banco não fez o suficiente para evitar fraudes previsíveis habilitadas por IA.

Talvez o maior desafio seja a natureza assimétrica dessa nova ameaça. A IA generativa reduz muito o custo e a barreira de habilidades para os invasores, ao mesmo tempo em que aumenta exponencialmente o volume e o realismo dos ataques. Um único boato viral de deepfake ou uma chamada de clone de voz convincente pode derrotar milhões de dólares de investimentos em autenticação. Enquanto isso, os defensores precisam verificar a autenticidade de cada transação e interação, uma tarefa muito mais difícil. É realmente uma corrida armamentista: A IA oferece aos fraudadores um kit de ferramentas de autoatualização para contornar a segurança, exigindo que os bancos também atualizem constantemente suas defesas[15][27]. Muitas instituições financeiras admitem que não estão adequadamente preparadas - mais de 80% das empresas não têm um plano de resposta formal para ataques deepfakee mais da metade não forneceu nenhum treinamento aos funcionários sobre os riscos de deepfake[28][29]. Essa lacuna de preparação significa que as organizações estão atualmente vulneráveis, mas também destaca onde é necessário agir.

Uma métrica digna de nota e preocupante vem de um relatório recente do setor: 42,5% das tentativas de fraude no setor financeiro agora envolvem alguma forma de IA[30]. Em outras palavras, quase metade dos ataques de fraude que os bancos encontram tem um componente de IA - seja um documento gerado por IA, uma voz sintetizada ou uma mensagem de phishing gerada por máquina. Essa estatística destaca que a IA não é uma ameaça hipotética do futuro; ela já está aqui, forçando as instituições financeiras a se adaptarem ou enfrentarem perdas crescentes.

Defesa contra fraudes viabilizadas por IA: Estratégias e soluções

O enfrentamento da fraude orientada por IA exige uma evolução nas estratégias de prevenção de fraudes. As abordagens tradicionais (como verificação manual ou mecanismos de regras estáticas) não são páreo para os golpes de IA que mudam de forma. Em vez disso, os bancos devem adotar technology (like making sure they have a Secure SSL Certificate), training, and teamwork para virar a maré. A seguir, descrevemos as principais estratégias e soluções emergentes:

- Aproveite a IA para combater a IA (ferramentas de detecção avançada): As instituições financeiras estão se voltando cada vez mais para Soluções de detecção com tecnologia de IA para identificar anomalias e conteúdo gerado por IA. Em essência, você precisa combater fogo com fogo. Novas ferramentas empresariais, como TruthScan oferecer detecção de IA multimodal em texto, imagens, voz e vídeo para ajudar a autenticar o conteúdo em tempo real[31]. Por exemplo, os bancos podem implantar detectores de texto com IA para examinar as comunicações recebidas (e-mails, mensagens de bate-papo) em busca de sinais de linguagem gerada por IA que possam indicar um e-mail de phishing ou uma consulta falsa do cliente. O sistema de detecção de texto com IA do TruthScan pode identificar conteúdo escrito com IA a partir de modelos como o GPT-4 com 99%+ precisãoe até mesmo identificar quais frases provavelmente são geradas por IA[32][33]. Da mesma forma, as ferramentas forenses de imagem de IA podem verificar documentos e imagens; um Detector de imagens AI pode sinalizar se uma carteira de motorista ou conta de luz enviada foi criada ou manipulada digitalmente, comparando-a com padrões conhecidos de imagens geradas por IA[34]. Para ameaças de áudio, os bancos estão começando a usar detectores de voz deepfake - soluções que analisam o áudio das chamadas em busca de impressões digitais acústicas de fala sintética. O Detector de Voz AI da TruthScan, por exemplo, escuta sinais reveladores de clonagem de voz e pode verificar a autenticidade do palestrante para evitar chamadas impostoras[35]. Ao integrar esses detectores via API em seus fluxos de trabalho, as instituições financeiras podem rastrear automaticamente o conteúdo de IA no plano de fundo das transações e interações. Isso fornece uma camada adicional de defesa que opera na velocidade da máquina, capturando o que os olhos/ouvidos humanos podem perder.

- Implementar verificação multifator e fora de banda: Como a IA torna mais difícil confiar em vozes ou imagens, os bancos devem confiar mais em métodos de verificação que a IA não possa falsificar facilmente. Isso inclui a autenticação multifator (MFA) usando canais seguros. Por exemplo, se uma solicitação de transferência bancária vier por e-mail ou chamada de vídeo, exija um segundo fator, como uma senha de uso único enviada para o dispositivo móvel conhecido do solicitante ou um retorno de chamada para um número de telefone confiável registrado. Alguns bancos estão adicionando verificações de "vivacidade" para transações de alto risco - por exemplo, solicitando que o cliente tire uma selfie ao vivo com um gesto ou uma palavra específica, o que é mais difícil de ser reproduzido por um vídeo deepfake. Os autenticadores biométricos podem ser aprimorados com medidas antifalsificação (por exemplo, escaneamento da profundidade do rosto em 3D ou monitoramento dos movimentos sutis dos olhos que os deepfakes geralmente não conseguem imitar).[27]). O segredo é evitar pontos únicos de falha. Mesmo que um deepfake de IA possa enganar um canal (por exemplo, verificação de voz), uma verificação fora de banda coordenada ou um teste biométrico pode oferecer o desafio necessário para revelar a fraude. Princípios de confiança zero deve ser aplicado: tratar qualquer instrução não solicitada ou inesperada (mesmo de um executivo ou cliente "conhecido") como suspeita até que seja verificada por meio de um canal independente.

- Treinamento de funcionários e conscientização sobre fraudes: A tecnologia por si só não é uma solução milagrosa, especialmente porque os fraudadores terão como alvo o elo mais fraco, que geralmente é a confiança humana. As instituições financeiras devem investir em treinamento regular para as equipes de prevenção de fraudes e para o pessoal da linha de frente sobre golpes baseados em IA. Os funcionários devem aprender a reconhecer os sinais de alerta de deepfakes e engenharia social. Isso pode incluir treinamento sobre anomalias sutis (por exemplo, problemas de sincronização labial em uma chamada de vídeo ou áudio que contenha entonação não natural ou muito pouco ruído de fundo - possíveis sinais de uma voz sintética). Incentive uma cultura de verificaçãoOs funcionários devem se sentir capacitados para interromper uma transação ou solicitação suspeita e verificá-la independentemente, mesmo que pareça ter vindo do CEO. O caso do Tentativa de falsificação de voz do CEO da Ferrari é instrutivo - um executivo só descobriu o estratagema ao fazer uma pergunta pessoal que o impostor não conseguiu responder[36]. Exercícios simulados de phishing/deepfake também podem ser úteis. Assim como as empresas realizam simulações de phishing para treinar a equipe, elas podem simular um correio de voz deepfake ou uma reunião de vídeo falsa e ver se os funcionários a detectam. Isso desenvolve a memória muscular para resistir a ataques reais. Considerando que mais de 50% das empresas não têm protocolos de resposta a deepfake e têm pouco treinamento em vigor[29]Para melhorar a resiliência, a instituição de tais programas é um fruto fácil de ser obtido.

- Análise de Fraude e Detecção de Anomalias: Banks should continue to use AI on the defensive side by enhancing their fraud analytics. Modern fraud detection systems employ machine learning models that analyze transactions in real time and flag anomalies or high-risk patterns. These models need to be updated to include signals indicative of AI-driven fraud. For example, an ML model can be trained to detect metadata or behavioral patterns associated with bot-driven account takeovers (e.g. impossibly fast form fill times, or perfectly consistent typing patterns that suggest an automated script). Language models can be used to analyze message content and flag if an email from a supplier sons gerados por IA ou excessivamente estereotipados (em conjunto com a detecção de texto por IA mencionada anteriormente). Bancos como o JPMorgan começaram a usar grandes modelos de linguagem em suas comunicações internas para identificar frases ou contextos que possam indicar uma tentativa de engenharia social[37]. As redes de pagamento, como a Mastercard, estão examinando vastos conjuntos de dados (bilhões de transações) com IA para identificar transações fraudulentas que as regras tradicionais não detectariam[38]. A conclusão é que IA defensiva deve ser tão inovador quanto a IA ofensiva. As empresas devem considerar o desenvolvimento ou a aquisição de modelos de IA especificamente para detectar conteúdo deepfake, identidades sintéticas e padrões de ataque generativos. Crucialmente, esses modelos devem ser continuamente retreinados nos exemplos mais recentes de fraude de IA (uma prática chamada de aprendizado on-line ou aprendizado federado) para que acompanhem o ritmo das táticas em rápida evolução dos criminosos[39][40].

- Colaboração e compartilhamento de informações: O combate à fraude com base em IA exigirá colaboração dentro e entre as instituições. Esforços isolados são menos eficazes contra uma ameaça que transcende as fronteiras organizacionais. Equipes de prevenção de fraudes, equipes de segurança cibernética e TI por exemplo, as equipes de segurança podem implementar a detecção de deepfake em ferramentas de videoconferência, enquanto as equipes de fraude integram varreduras de conteúdo no monitoramento de transações. Em um nível mais amplo, os bancos devem participar de grupos do setor, como o Centro de Análise e Compartilhamento de Informações de Serviços Financeiros (FS-ISAC), para trocar informações sobre novos esquemas de fraude de IA[41]. Se um banco descobrir um novo vetor de ataque de deepfake, o compartilhamento desse insight pode ajudar os outros a fechar a brecha antes de serem atingidos. Exercícios conjuntos ou simulações de "equipe vermelha" com cenários que envolvam IA (por exemplo, um golpe executivo de deepfake ou um desvio de verificação de identidade gerado por IA) podem ser realizados por meio de consórcios do setor ou com apoio regulatório. Os próprios órgãos reguladores estão se concentrando nos riscos de IA, portanto, é aconselhável envolver-se com eles de forma proativa. Ao contribuir com padrões e diretrizes para o uso da IA, os bancos podem ajudar a moldar um ecossistema mais seguro. Em última análise, uma vez que uma ameaça a um banco é uma ameaça a todos neste espaço[42]Com uma abordagem de defesa coletiva, a capacidade de todos de detectar e impedir fraudes aprimoradas por IA será fortalecida.

- Educação do cliente e medidas de confiança: Por fim, as instituições financeiras não devem ignorar o papel da conscientização do cliente. Com deepfakes e golpes de IA voltados para o público em geral (por exemplo, vozes falsas em golpes de avós ou falsos bate-papos de "suporte técnico" gerados por IA), os bancos podem ajudar a educar os clientes sobre esses perigos. Muitos bancos já enviam alertas sobre phishing; eles podem expandi-los para mencionar a clonagem de voz por IA e vídeos de deepfake, fornecendo dicas sobre como verificar solicitações. Algumas organizações progressistas enviam notificações push ou avisos em seus aplicativos se um golpe conhecido estiver circulando (por exemplo, "Cuidado: os fraudadores podem usar clones de voz de membros da família pedindo dinheiro")[43]. Embora não impeça diretamente os ataques, a educação pode reduzir a taxa de sucesso e reforçar que o banco é um parceiro na segurança. Além disso, os bancos que investem em prevenção de fraudes de última geração devem destacar esse fato para os clientes como uma forma de prevenção. diferenciador - Por exemplo, informar aos clientes que todas as videochamadas ou documentos enviados são verificados pela IA quanto à autenticidade (sem divulgar métodos confidenciais) pode garantir aos clientes que o banco está usando todas as ferramentas disponíveis para protegê-los. Preservar a confiança digital será fundamental para que os bancos aproveitem totalmente os benefícios da IA nos serviços, portanto, a transparência e as proteções focadas no cliente fazem parte de uma defesa holística.

Função dos serviços de detecção de conteúdo de IA

Uma pedra angular do kit de ferramentas antifraude na era da IA é o uso de Serviços de detecção de conteúdo de IA. Esses serviços são especializados em identificar as "impressões digitais" do conteúdo gerado por IA que podem passar despercebidas pelos revisores humanos. O TruthScan é um desses provedores que oferece uma solução de nível empresarial para a detecção de impressões digitais. Suíte de detecção de IA abrangendo vários tipos de conteúdo. As instituições financeiras podem integrar essas ferramentas para fazer a triagem automática de indicadores de falsificação e fraude:

- Verificação de documentos e imagens: A plataforma do TruthScan permite que os bancos testar documentos financeiros em busca de fraudes geradas por IA em tempo real[44]. Isso significa que, quando uma nova conta é aberta ou um pedido de empréstimo chega com um documento de identidade com foto e um contracheque, o sistema pode analisar instantaneamente essas imagens em busca de sinais de geração sintética ou adulteração. Com mais de 99% de precisão de alvo[45]Com o AI Image Detector, é possível detectar imagens de identificação falsas ou PDFs adulterados que um ser humano pode aprovar pelo valor nominal. Esse tipo de verificação da autenticidade do documento é fundamental para impedir a fraude de identidade sintética antes mesmo de as contas serem abertas.

- Monitoramento de transações em tempo real: Ao implantar integrações de API, o TruthScan pode se conectar ao processamento de transações dos bancos e sinalizar anomalias em em tempo real. Se uma instrução chegar por e-mail que pareça suspeita, o Email Scam Detector poderá analisar o conteúdo da mensagem e detectar se ela provavelmente foi escrita por um modelo de IA tentando falsificar um fornecedor ou executivo[46]. Da mesma forma, o Detector de IA em tempo real pode monitorar comunicações ao vivo (como bate-papos ou plataformas de colaboração) para fornecer alertas instantâneos se, por exemplo, um feed de vídeo deepfake impostor for detectado durante uma reunião de alto risco[47][48]. O monitoramento contínuo com alertas instantâneos e respostas automatizadas ajuda a reduzir a janela em que a fraude pode ocorrer sem ser detectada.

- Defesa contra deepfake de voz e vídeo: Para centrais de atendimento e gerentes de relacionamento, a incorporação da tecnologia TruthScan Detector de voz AI adiciona uma camada extra de segurança. Se um fraudador ligar se passando por um cliente usando um clone de voz, o sistema poderá analisar o áudio da chamada e sinalizar se ele contém elementos sintetizados por IA (como micropausas naturais ausentes ou artefatos nas ondas sonoras)[35]. Na frente de vídeo, o Detector de deepfake aplica algoritmos de visão computacional a quadros de vídeo para detectar inconsistências - como movimentos faciais não naturais, iluminação estranha ou sincronização labial incompatível - que revelam uma falsificação[49][50]. Ao verificar a integridade de vozes e rostos em interações importantes, os bancos podem impedir que impostores tentem enganar seus funcionários. Essas ferramentas funcionam como um detector de mentiras de alta tecnologia para conteúdo digital, operando de forma invisível em segundo plano.

Vale a pena observar que a implantação dessa tecnologia de detecção não é uma solução "plug-and-play"; ela deve ser calibrada e ajustada aos fluxos de trabalho da instituição. Os falsos positivos devem ser gerenciados (por exemplo, um detector de texto com IA pode sinalizar comunicações legítimas baseadas em modelos como suspeitas até que aprenda a diferença). No entanto, quando devidamente integradas, essas ferramentas melhoram consideravelmente a capacidade da organização de detectar conteúdo fraudulento antes que ele cause danos. Eles também geram trilhas de auditoria e relatórios analíticos que são úteis para a conformidade e para o aprimoramento contínuo dos modelos de fraude.

Crucialmente, a eficácia das ferramentas de detecção de IA depende de atualizações constantes. Assim como o software antivírus exige novas assinaturas para novos vírus, os detectores de IA precisam de retreinamento nas mais recentes técnicas de deepfake e modelos de IA. Fornecedores como o TruthScan atualizam seus algoritmos para lidar com novos modelos generativos e táticas de evasão, mantendo a alta precisão mesmo com a evolução da IA[51]. Isso alivia o fardo das equipes internas e garante que os bancos não estejam lutando a guerra de ontem enquanto os criminosos se movem para novos truques de IA.

Conclusão

O setor de serviços financeiros está em uma encruzilhada na luta contra a fraude. De um lado, os criminosos estão adotando rapidamente a IA generativa para lançar golpes que são mais convincentes e difundidos do que nunca. Por outro lado, os bancos e os combatentes de fraudes têm um arsenal crescente de defesas orientadas por IA à sua disposição. As instituições que prosperarão são aquelas que reconhecer o novo cenário de ameaças e responder com igual engenhosidade. Isso significa investir em recursos avançados de detecção, integrar processos de verificação em várias camadas, educar a equipe e os clientes e promover uma cultura de vigilância e adaptação.

A fraude habilitada por IA é um alvo que se movimenta rapidamente - o esquema de deepfake que enganou uma empresa hoje pode ser combatido por novas técnicas de detecção amanhã, apenas para que os fraudadores alterem seus métodos na próxima semana. Portanto, uma estratégia de prevenção de fraudes "padrão do setor" em 2025 é aquela que enfatiza a agilidade e a melhoria contínua. As organizações financeiras devem tratar seus sistemas de defesa contra fraudes como entidades vivas e em aprendizado que evoluem em conjunto com as táticas criminosas. Aproveitar as parcerias com fornecedores de tecnologia é um atalho inteligente para desenvolver esses recursos. Por exemplo, a colaboração com empresas especializadas como a TruthScan (que oferece soluções personalizadas para o setor bancário e financeiro) pode acelerar a capacidade de uma instituição de evitar fraudes habilitadas por IA e, ao mesmo tempo, manter a conformidade regulatória e a confiança do cliente[52].

Em última análise, a proteção contra a fraude impulsionada por IA não se trata apenas de tecnologia - trata-se de preservar os princípios fundamentais da segurança. confiança que sustenta as finanças. Os clientes precisam ter certeza de que seu banco pode distinguir uma transação real de uma falsa, um cliente real de um impostor de IA. Ao implantar ferramentas de detecção de IA de ponta, reforçar os protocolos de verificação e ficar à frente das ameaças emergentes, as empresas de serviços financeiros podem manter essa confiança. O caminho à frente, sem dúvida, apresentará mais tentativas de inovações de fraude por parte dos adversários, mas com preparação e os investimentos certos, os bancos podem garantir que A IA se torna mais um ativo do que uma ameaça no âmbito da prevenção de fraudes. É uma meta alcançável: as mesmas tecnologias de IA que ameaçam causar disrupção podem ser aproveitadas para proteger a integridade do nosso sistema financeiro. Agora é a hora de as equipes de prevenção de fraudes e os executivos de nível C agirem de forma decisiva, adoção de soluções e estratégias avançadas para superar os fraudadores e garantir o futuro das finanças digitais.

Fontes: Relatórios recentes do setor, alertas regulatórios e documentos técnicos de tecnologia foram referenciados em todo o processo (Deloitte[20][18], Fórum Econômico Mundial[19][24], Tesouro dos EUA FinCEN[3][4], Federal Reserve[13], Keepnet Labs[16][30]entre outros) para fornecer dados e exemplos. Todos os dados e exemplos são citados em linha para permitir que os leitores explorem mais.

[1] [9] [10] [14] [15] [18] [20] [37] [38] [42] [43] Deepfake banking e risco de fraude de IA | Deloitte Insights

[2] [5] [6] [19] [21] [24] [25] [27] [36] [39] [40] [41] A detecção de IA perigosa é essencial na era do deepfake | Fórum Econômico Mundial

[3] [4] [26] FinCEN emite alerta sobre esquemas de fraude envolvendo mídia Deepfake visando instituições financeiras | FinCEN.gov

[7] [8] FraudGPT e GenAI: como os fraudadores usarão a IA a seguir? | Alloy

[11] Fraude de identidade sintética: Como a IA está mudando o jogo - Federal Reserve Bank of Boston

[12] [13] A inteligência artificial generativa aumenta as ameaças de fraude de identidade sintética

[16] [17] [22] [23] [28] [29] [30] Estatísticas e tendências do Deepfake para 2025 - Principais dados e percepções - Keepnet

[31] [34] [35] [46] [47] [48] TruthScan - Detecção de IA empresarial e segurança de conteúdo

[32] [33] [51] Detector de IA: Detecção de texto com IA de nível empresarial - TruthScan

[44] [45] [52] Detecção de fraude por IA no setor bancário | Soluções CRO | TruthScan

[49] [50] Deepfake Detector - Identifique vídeos falsos e com IA - TruthScan