Introdução: Uma nova era de ataques orientados por IA

O ano de 2025 marcou um ponto de inflexão na segurança cibernética. A IA generativa sobrecarregou os ataques cibernéticos, permitindo que os agentes de ameaças lancem mais frequentes, realistas e escalonáveis campanhas do que nunca. De fato, no ano passado, estima-se que 16% dos incidentes cibernéticos relatados envolveram atacantes que utilizaram ferramentas de IA (por exemplo, modelos de geração de imagem e linguagem) para aprimorar a engenharia social[1]. De e-mails de phishing ultraconvincentes a golpes de áudio/vídeo deepfake, os agentes mal-intencionados estão usando a IA como arma em todos os setores. A maioria dos profissionais de segurança agora atribui a aumento dos ataques cibernéticos à IA generativaO que proporciona aos malfeitores maneiras mais rápidas e inteligentes de explorar as vítimas[2]. A IA generativa está efetivamente diminuindo o nível de habilidade para o crime cibernético e, ao mesmo tempo, aumentando sua potência.

Por que isso é tão preocupante? A IA pode produzir instantaneamente conteúdo polido e sensível ao contexto que engana até mesmo usuários treinados. Ela pode se passar por vozes e rostos com uma precisão assustadora e até mesmo gerar códigos maliciosos que se transformam para evitar a detecção. Como resultado, os ataques cibernéticos se tornaram mais difíceis de detectar e mais fáceis de executar. Os Fórum Econômico Mundial alerta que 72% das organizações observaram um aumento dos riscos cibernéticos - especialmente engenharia social e fraude - devido aos crescentes recursos da IA generativa[3]. Incidentes no mundo real confirmam isso: No início de 2024, os criminosos usaram um chamada de vídeo deepfake para se fazer passar pelo diretor financeiro de uma empresa e enganar um funcionário para que ele transfira $25,6 milhões para os fraudadores[4]. E em outro caso, os hackers norte-coreanos usaram Documentos de identidade falsos gerados por IA para contornar verificações de segurança em uma campanha de phishing de defesa[5]. Esses exemplos destacam os riscos - a IA generativa está capacitando golpes que contornam os controles humanos e técnicos.

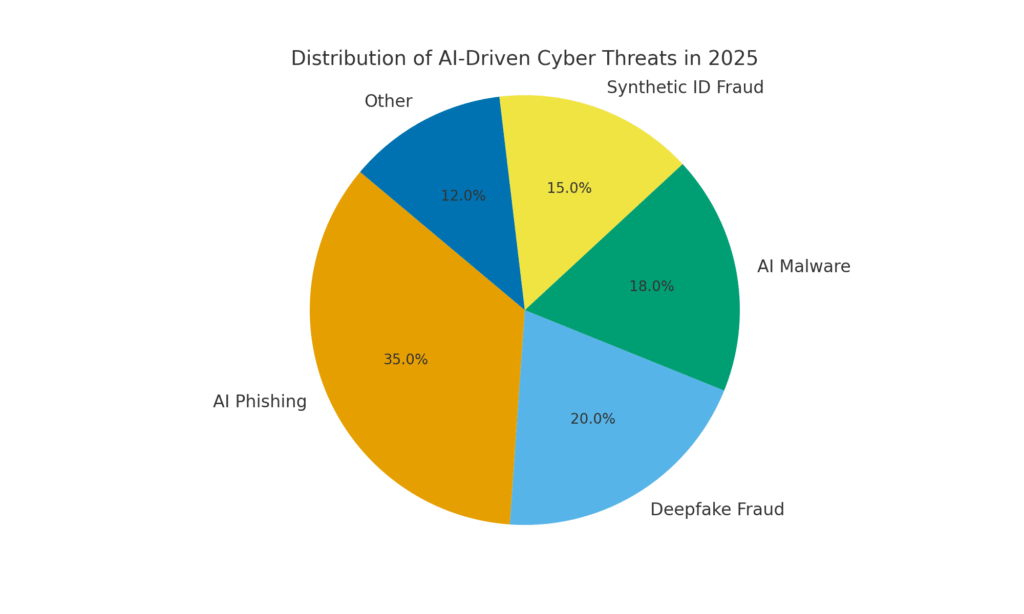

No entanto, a IA também faz parte da solução. Ferramentas de detecção avançadas (como as do TruthScan) usam IA contra IA - análise de conteúdo para detectar as assinaturas sutis da geração de máquinas. Neste whitepaper, examinaremos as principais ameaças cibernéticas orientadas por IA de 2025 e como as organizações podem mitigá-las. De Phishing gerado por IA para deepfake Fraude do CEO, Malware criado por IA, identidades sintéticase muito mais, exploraremos como a IA generativa está remodelando os ataques. Também discutiremos medidas defensivas concretas, incluindo Detecção de conteúdo com IAA pesquisa de dados de fraude, a análise forense de deepfake e as tecnologias de verificação de identidade que podem ajudar as equipes de segurança a recuperar a vantagem. O objetivo é esclarecer como as empresas, os MSSPs, os CISOs e os investigadores de fraudes podem integrar ferramentas de detecção de IA em sua pilha de segurança cibernética para combater essa onda de ameaças baseadas em IA.

Nunca mais se preocupe com fraudes de IA. TruthScan Pode lhe ajudar:

- Detectar IA gerada imagens, texto, voz e vídeo.

- Evitar grande fraude impulsionada por IA.

- Proteja seus mais sensível ativos da empresa.

Phishing e BEC gerados por IA: golpes em escala sem precedentes

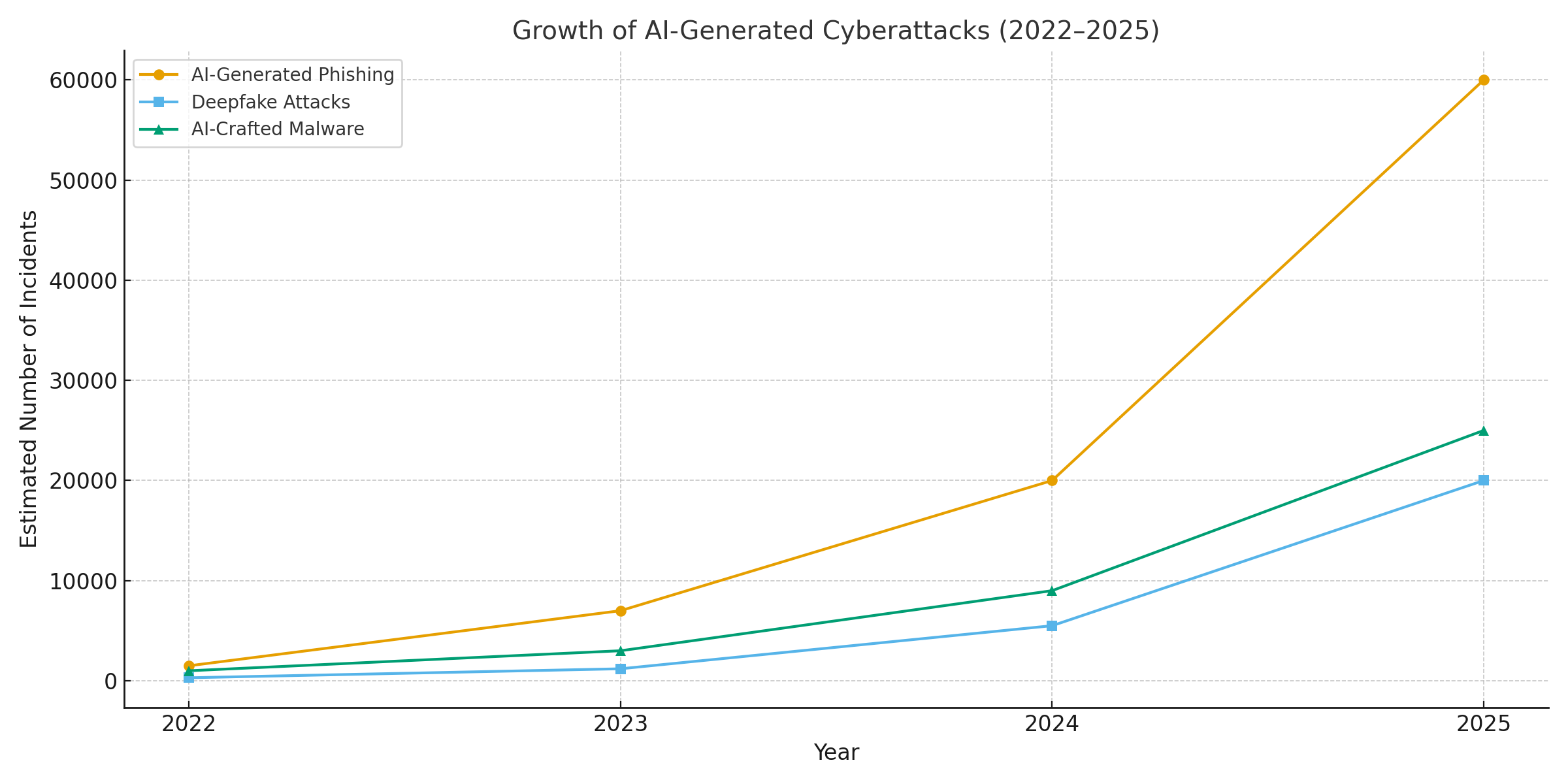

Um dos impactos mais claros da IA generativa foi sobre phishing e comprometimento de e-mail comercial (BEC) esquemas. Os modelos de linguagem de IA podem redigir e-mails fluentes e contextualmente adaptados em segundos, eliminando os erros gramaticais e as frases estranhas que antes denunciavam o phishing. O resultado é uma enxurrada de e-mails e textos de golpes altamente convincentes. Até abril de 2025, mais da metade dos e-mails de spam (51%) estavam sendo escritos por IA, em comparação com praticamente zero dois anos antes[6]. Ainda mais alarmante, os pesquisadores descobriram que cerca de 14% de e-mails de ataque de BEC foram gerados por IA até 2025[7] - um número que deve aumentar à medida que os criminosos adotam ferramentas como o ChatGPT. Alguns estudos estimam que sobre 80% de e-mails de phishing podem agora ter a ajuda da IA para criá-los[8].

O volume dessas iscas geradas por IA explodiu. As análises de segurança mostram que os ataques de phishing vinculados à IA generativa aumentaram em 1,265% em um curto espaço de tempo[9]. Em um período, os relatórios de incidentes de phishing aumentaram 466% em um único trimestreA maioria dos casos de phishing é causada por kits de phishing automatizados e bots que lançam iscas personalizadas[9][10]. Por que esse pico? Porque a IA permite que os atacantes escala suas operações de forma drástica. Um único criminoso pode usar um chatbot de IA para gerar milhares de e-mails de golpes personalizados direcionados a diferentes funcionários ou clientes, tudo no tempo que costumava ser necessário para criar um. Essa automação em massa levou o FBI a alertar que as perdas com BEC (que já eram de $2,7 bilhões em 2022) só irão acelerar, pois a IA "ameaça aumentar ainda mais essas perdas"[11][12].

Além de haver mais e-mails de phishing, eles também estão mais eficaz. As vítimas são enganadas em taxas mais altas pela linguagem refinada e pelos detalhes contextuais que a IA pode incorporar. Em testes de laboratório, os e-mails de phishing escritos por IA alcançaram um Taxa de cliques do 54% - muito acima do ~12% para tentativas de phishing tradicionais[13]. Essas mensagens parecem o estilo de um CEO genuíno ou fazem referência a eventos reais da empresa, baixando a guarda dos destinatários. Os invasores usam até mesmo a IA para fazer testes A/B com frases diferentes e repetir os ganchos mais bem-sucedidos[14]. E, ao contrário dos seres humanos, a IA não comete erros de digitação nem se cansa - ela pode lançar infinitas variantes até que uma passe pelos filtros e engane alguém.

Caso em questão: Em meados de 2025, um Reuters A investigação expôs como os golpistas do sudeste asiático aproveitaram o ChatGPT para automatizar as comunicações de fraude[15]. Eles geraram e-mails bancários convincentes e textos de atendimento ao cliente em massa, aumentando enormemente o alcance de seus esquemas. A polícia europeia também relatou que kits de phishing orientados por IA estão sendo vendidos na dark web por menos de $20, permitindo que agentes pouco qualificados lancem campanhas sofisticadas[16][17]. A barreira de entrada para BEC e phishing praticamente desapareceu.

Medidas defensivas - Como interromper o Phish de IA: Diante desse ataque, as organizações precisam fortalecer seus canais de e-mail e mensagens. É nesse ponto que Detecção de conteúdo com IA pode ajudar. Ferramentas como Detector de texto com IA do TruthScan e especializados scanners de e-mail pode analisar as mensagens recebidas em busca de marcadores estatísticos de texto gerado por IA. Por exemplo, o Detector de fraudes de e-mail TruthScan usa análise de linguagem natural para sinalizar e-mails que provavelmente se originaram de uma IA, mesmo que pareçam legítimos[18]. Esses detectores examinam aspectos como gramática perfeitamente polida, complexidade de frases e padrões estilométricos que são incomuns para escritores humanos. Com varredura em tempo realCom a IA, os e-mails suspeitos podem ser colocados em quarentena ou sinalizados para revisão antes de chegarem aos usuários. As equipes de segurança corporativa estão começando a implementar esses filtros orientados por IA em gateways de e-mail e plataformas de mensagens. Na prática, isso adiciona uma nova camada de defesa aos filtros de spam tradicionais - uma camada explicitamente ajustada para capturar conteúdo escrito por IA. A partir de 2025, as principais empresas estão integrando soluções como o TruthScan via API em seus gateways de e-mail seguros e suítes de colaboração em nuvem, criando um ponto de verificação automatizado para Phishing gerado por IA conteúdo.

Falsa imitação de voz e vídeo: A fraude do "ver para crer"

Talvez a ameaça mais visceral impulsionada pela IA em 2025 seja o surgimento de ataques de voz e vídeo deepfake. Usando modelos de IA, os criminosos podem clonar a voz de uma pessoa a partir de apenas alguns segundos de áudio ou gerar um vídeo realista do rosto de alguém a partir de um punhado de fotos. Esses deepfakes estão sendo usados como arma para golpes de falsificação de identidade de alto risco, desde fraudes de CEOs (chamadas de "CEOs falsos") até videoconferências falsas e muito mais. Um relatório recente do setor revelou 47% das organizações sofreram ataques de deepfake de algum tipo[19]. E não se trata apenas de teoria: vários roubos em 2023-2025 provaram que os deepfakes podem derrotar a autenticação definitiva - nossos próprios olhos e ouvidos.

Um caso infame envolveu uma transferência bancária internacional de $25 milhões depois que um funcionário foi enganado por uma videoconferência deepfake. Os invasores usaram IA para sintetizar a imagem do CFO da empresa em uma chamada do Zoom, com sua voz e maneirismos, instruindo o funcionário a transferir fundos[4][20]. Em outro incidente na Austrália, um governo local perda de $2,3 milhões quando os golpistas falsificaram a voz e o vídeo de funcionários da cidade para aprovar pagamentos fraudulentos[21]. E, de forma preocupante, os criminosos estão usando vozes clonadas por IA em "golpes dos avós", ligando para idosos e se passando por seus parentes em perigo. As FBI e FinCEN emitiu alertas no final de 2024 sobre um aumento nas fraudes usando Mídia "deepfake" gerada por IAincluindo agentes de atendimento ao cliente falsos e identidades sintéticas para contornar as verificações de KYC[22].

A frequência de crimes baseados em deepfake está aumentando rapidamente. Até o final de 2024, uma análise mostrou um novo golpe de deepfake estava ocorrendo a cada cinco minutos em média[23]. Somente no primeiro trimestre de 2025, os incidentes de deepfake relatados aumentaram 19% em comparação com todos de 2024[24][25]. As falsificações profundas agora representam cerca de 6,5% de todos os ataques de fraude, a 2.137% aumento desde 2022[26][27]. A tecnologia necessária se tornou facilmente acessível, muitas vezes exigindo apenas 30 segundos de áudio para clonar uma voz, ou menos de uma hora de filmagem de amostra para modelar o rosto de uma pessoa de forma convincente[20]. Em resumo, nunca foi tão fácil "falsificar" a identidade de uma pessoa confiável e enganar as vítimas para que entreguem dinheiro ou informações.

Medidas defensivas - Autenticando a realidade: Para combater as ameaças de deepfake, as organizações estão recorrendo a detecção de mídia sintética ferramentas. Por exemplo, Detector de voz com IA do TruthScan e Detector de falsificação profunda TruthScan usam IA para analisar áudio e vídeo em busca de sinais de manipulação. Esses sistemas realizam análises quadro a quadro e de forma de onda para detectar artefatos como movimentos faciais não naturais, problemas de sincronização labial ou irregularidades espectrais de áudio que denunciam um clipe gerado por IA. Nos testes, os algoritmos do TruthScan alcançaram 99%+ precisão na identificação de vozes geradas por IA e detectou quadros de vídeo manipulados em tempo real[28][29]. De fato, os pesquisadores do Genians Security Center recentemente usaram a análise forense de imagens do TruthScan para analisar uma carteira de identidade falsa usada por hackers norte-coreanos - o detector de imagens deepfake do TruthScan sinalizou o documento como não autêntico com 98% confiança, frustrando a tentativa de spear-phishing[5][30].

Para uma defesa prática, as empresas estão implantando esses recursos de detecção nos principais pontos de estrangulamento. Verificação de voz está sendo adicionada aos fluxos de trabalho do call center - por exemplo, quando um "cliente" solicita uma grande transferência por telefone, o áudio pode ser executado por meio de um detector de deepfake de voz para garantir que seja realmente ele (e não uma imitação de IA). Da mesma forma, plataformas de videoconferência pode integrar a varredura de deepfake ao vivo dos fluxos de vídeo dos participantes, para detectar rostos sintéticos. O conjunto de detecção de deepfake do TruthScan, por exemplo, oferece análise de chamadas de vídeo em tempo real e autenticação facial que pode se conectar ao Zoom ou WebEx via API[31][29]. Isso significa que se alguém tentar participar de uma reunião usando um vídeo criado por IA do seu CEO, o sistema poderá sinalizar "possível deepfake" antes que qualquer dano seja causado. Além disso, as transações importantes agora costumam incluir uma etapa de verificação (fora de banda ou multifator) que pode aproveitar a autenticação de conteúdo - por exemplo, exigindo uma breve confirmação falada que é então verificada por um detector de voz de IA quanto à autenticidade. Ao colocar essas ferramentas em camadas, as empresas criam uma rede de segurança: mesmo que os funcionários ver ou ouvir algo plausível, um forense de IA nos bastidores questionará sua realidade. Em um cenário de ameaças permeado por IA, "Não confie - verifique" torna-se o mantra para qualquer comunicação de voz ou vídeo que envolva dinheiro ou acesso confidencial.

Malware criado por IA e código ofuscado: Ameaças em evolução no código

A influência da IA não se limita à engenharia social - ela também está mudando o jogo no desenvolvimento de malware e no código de ataque evasivo. Em 2025, o Threat Intelligence Group do Google descobriu o primeiras cepas de malware usando IA durante execução para alterar seu comportamento[32][33]. Um exemplo, apelidado de PROMPTFLUXOO script malicioso que, na verdade, chamava uma API de IA (modelo Gemini do Google) para reescrever seu próprio código em tempo realA empresa está produzindo novas variantes ofuscadas para evitar a detecção de antivírus[34][35]. Essa evolução da IA "just-in-time" marca um salto em direção a um malware autônomo e polimórfico. Outro exemplo, PROMPTSTEALA empresa, que usou um assistente de codificação de IA para gerar comandos de uma linha do Windows para roubo de dados, essencialmente terceirizando partes de sua lógica para um mecanismo de IA em tempo real[36][37]. Essas inovações apontam para um futuro em que o malware poderá se transformar continuamente - assim como um pen-tester humano faria - para derrotar as defesas.

Mesmo sem a IA em tempo real, os invasores estão usando a IA durante o desenvolvimento para criar códigos mal-intencionados mais potentes. A IA generativa pode produzir malware que é altamente ofuscadocontendo camadas de lógica confusa que dificultam a engenharia reversa. De acordo com relatórios de informações sobre ameaças, mais de 70% das principais violações em 2025 envolveram alguma forma de malware polimórfico que altera sua assinatura ou comportamento para evitar a detecção[38]. Além disso, 76% de campanhas de phishing agora empregam táticas polimórficas, como URLs dinâmicos ou cargas úteis reescritas por IA[38]. Ferramentas como as ofertas da dark-web WormGPT e FraudeGPT (clones irrestritos do ChatGPT) permitem que até mesmo os não especialistas gerem droppers de malware, keyloggers ou códigos de ransomware simplesmente descrevendo o que desejam[39]. O resultado é uma abundância de novas variantes de malware. Por exemplo, em 2024, um ladrão de informações chamado BlackMamba surgiu que foi totalmente gerado por IAusando o ChatGPT para escrever seu código em segmentos - cada execução produzia um binário ligeiramente diferente, confundindo os antivírus tradicionais baseados em assinaturas[38]. Os pesquisadores de segurança também demonstraram provas de conceito polimórficas geradas por IA que poderiam burlar muitas proteções de endpoint[40].

Além disso, os invasores estão aproveitando a IA para ajustar seus entrega de malware. A IA pode criar scripts inteligentes de e-mails de phishing (conforme discutido) que contêm links de malware. Ela também pode ajudar no desenvolvimento de exploits, por exemplo, usando a IA para encontrar novas vulnerabilidades ou otimizar o shellcode. Segundo informações, agentes de estados-nação usaram modelos avançados de IA para ajudar a descobrir explorações de dia zero e desenvolver malware personalizado para alvos[41]. Todas essas tendências significam que o malware em 2025 será mais furtivo e mais adaptável. Ele é frequentemente "co-criado" com IAo que dificulta a detecção por meio de regras convencionais.

Medidas defensivas - IA vs. IA na defesa contra malware: A defesa contra malware criado por IA requer uma combinação de detecção avançada e análise com tecnologia de IA no lado defensivo. Muitas organizações estão aumentando suas proteção de endpoints e EDR (Endpoint Detection & Response) com modelos de IA/ML que procuram os padrões de comportamento do código gerado pela IA. Por exemplo, transformações repentinas de código no host ou padrões incomuns de chamadas de API podem indicar algo como o PROMPTFLUX se regenerando. Da mesma forma, o monitoramento da rede pode detectar anomalias, como malware que alcança os serviços de IA (o que não é "normal" para aplicativos de usuários). Os fornecedores estão treinando detectores baseados em ML no famílias de malware assistido por IA identificados até o momento, melhorando o reconhecimento dessas novas ameaças.

Uma solução emergente é varredura integrada de conteúdo de IA em pipelines de desenvolvimento e criação. Isso significa usar detectores orientados por IA para analisar scripts, compilações de software ou até mesmo alterações de configuração em busca de conteúdo mal-intencionado ou gerado por IA. Por exemplo, Detector em tempo real do TruthScan pode ser implantado além do texto - sua análise multimodal pode sinalizar códigos ou arquivos de configuração suspeitos, reconhecendo se eles foram gerados por máquina com padrões de ofuscação[42][43]. As equipes de desenvolvimento e os MSSPs estão começando a examinar scripts de infraestrutura como código, logs do PowerShell e outros artefatos em busca de sinais de segmentos escritos por IA que possam indicar a mão de um invasor. Embora seja uma área incipiente, ela se mostra promissora: em um caso, uma equipe de segurança usou um detector de IA para capturar um arquivo de kit de phishing ofuscado que "parecia" gerado por IA e que, na verdade, fazia parte de um ataque[44]. O código do arquivo era excessivamente complexo e detalhado (marcas registradas da geração de IA), e uma varredura de conteúdo de IA confirmou uma alta probabilidade de não ter sido escrito por humanos[40].

Por fim, o compartilhamento de inteligência contra ameaças focado em ameaças de IA é crucial. Quando o Google GTIG publicar detalhes sobre malware baseado em Prompt ou quando os pesquisadores relatarem novas técnicas de evasão de IA, as organizações devem inseri-las em sua engenharia de detecção. Análise comportamental - procurando ações como um processo que gera um script que reescreve o código do mesmo processo - pode detectar anomalias que o malware assistido por IA exibe. Em resumo, os defensores devem combater fogo com fogo: implementar Ferramentas de segurança orientadas por IA que possam se adaptar tão rapidamente quanto o malware orientado por IA. Isso inclui tudo, desde o antivírus aprimorado por IA até a análise do comportamento do usuário, que pode identificar quando uma conta ou um sistema começa a agir de forma "não muito humana". Ao adotar a IA para defesa, as equipes de segurança podem combater as vantagens de velocidade e escala que a IA concede aos invasores.

Identidades sintéticas e esquemas de fraude alimentados por IA

Passando do malware para o mundo da fraude: fraude de identidade sintética explodiu com a ajuda da IA generativa. A fraude de identidade sintética envolve a criação de personas fictícias por meio da combinação de dados reais e falsos (por exemplo, SSN real + nome e documentos falsos). Essas identidades "Frankenstein" são então usadas para abrir contas bancárias, solicitar crédito ou passar por verificações de KYC, o que acaba resultando em empréstimos não pagos ou lavagem de dinheiro. Esse tipo de fraude já era um dos que mais cresciam, e a IA agora colocou lenha na fogueira. Perdas por fraude de identificação sintética cruzou $35 bilhões em 2023[45]e, no início de 2025, algumas estimativas indicavam quase 25% de todas as perdas com fraudes bancárias foram devidos a identidades sintéticas[46]. Os analistas da Experian descobriram que mais de 80% de fraude em novas contas em determinados mercados está agora vinculado a IDs sintéticas[19] - uma estatística surpreendente que ressalta o quanto esse golpe se tornou difundido.

A IA generativa amplifica a fraude sintética de algumas maneiras. Em primeiro lugar, a IA torna trivial a produção de "documentos do criador" e as pegadas digitais necessárias para vender uma identidade falsa. No passado, um fraudador podia usar Photoshop em uma identidade ou criar manualmente contas de serviços públicos falsas. Atualmente, existem ferramentas para gerar fotos de perfil, identidades, passaportes, extratos bancários e até mesmo perfis de mídia social com aparência autêntica usando geradores de imagens de IA e modelos de linguagem[47][48]. Por exemplo, é possível usar uma IA para criar uma foto realista da cabeça de uma pessoa que não existe (impedindo pesquisas fáceis de imagens reversas) e gerar uma carteira de motorista falsa correspondente com essa foto. A IA também pode simular "sinais vitais" de uma identidade - por exemplo, criando registros de pais sintéticos, endereços ou publicações em mídias sociais para dar corpo a uma história de fundo[49]. O Boston Fed observou que a IA Gen pode até mesmo produzir áudio e vídeo deepfake de uma pessoa falsa - Por exemplo, um usuário sintético poderia "aparecer" em um vídeo de verificação de selfie, com rosto e voz exclusivos, tudo gerado por IA[50].

Em segundo lugar, a IA ajuda os fraudadores aumentar a escala suas operações. Em vez de forjar uma ou duas identidades de cada vez, eles podem gerar programaticamente centenas ou milhares de pacotes completos de identidade e preencher automaticamente novos aplicativos de conta em massa[51][52]. Alguns serviços da dark web estão efetivamente oferecendo "Identidades sintéticas como um serviço"A IA está usando a automação para produzir contas verificadas para venda. Durante os programas de auxílio à pandemia da COVID-19, por exemplo, os criminosos usaram bots com identidades geradas por IA para solicitar em massa empréstimos e benefícios, sobrecarregando o sistema com candidatos falsos. De acordo com os projetos da Juniper Research, o custo global da fraude de identidade digital (alimentada por essas táticas) será de aumento de 153% até 2030 em comparação com 2025[53].

Medidas defensivas - Verificando a identidade em um mundo de IA: Os métodos tradicionais de comprovação de identidade estão lutando contra as falsificações criadas por IA. Para se adaptar, as organizações estão adotando verificação de identidade e comportamento em várias camadas reforçado pela IA. Uma camada fundamental é a avançada análise forense de documentos e imagens. Por exemplo, Detector de imagens com IA do TruthScan e Detector de documentos falsos oferecem a capacidade de analisar IDs, selfies ou documentos carregados em busca de sinais de síntese ou adulteração. Essas ferramentas examinam artefatos em nível de pixel, inconsistências de iluminação e metadados para determinar se uma imagem foi gerada ou manipulada por IA. Elas podem detectar pistas sutis, como padrões de fundo idênticos de fotos geradas por GAN ou fontes e espaçamento em uma identificação que não correspondem a nenhum modelo governamental conhecido. Ao implantar esses detectores na integração, os bancos podem sinalizar automaticamente a carteira de motorista ou a selfie de um candidato se ela for provavelmente gerada por IA (por exemplo, o sistema TruthScan teria sinalizado a identidade militar falsa usada no caso de phishing Kimsuky APT).[5]). De acordo com um comunicado à imprensa da TruthScan, sua plataforma tem sido usada por instituições financeiras para validar a autenticidade de documentos em escala, identificando falsificações profundas com precisão extremamente alta[54].

Outra camada é análise comportamental e verificações de referência cruzada. As identidades reais têm profundidade: anos de história, registros públicos, atividade de mídia social etc. As identidades geradas por IA, por mais refinadas que sejam, geralmente não têm essas raízes profundas. Bancos e credores agora usam IA para fazer a correlação cruzada de dados de aplicativos com dados públicos e proprietários: O número de telefone e o e-mail dessa pessoa mostram um histórico de uso? A geolocalização do dispositivo ou do IP faz sentido? Ela está digitando dados em formulários de forma humana ou copiando e colando (como fazem os bots)? Os modelos de IA podem ser treinados para distinguir o comportamento genuíno do cliente de padrões sintéticos. O Federal Reserve observou que "As identidades sintéticas são superficiais, e a IA pode ver isso" - A verificação baseada em IA pode pesquisar rapidamente o rastro digital de uma identidade e emitir alarmes se for encontrado pouco ou nenhum[55]. Na prática, os serviços de verificação de identidade agora empregam IA que verifica se a selfie de um usuário corresponde a fotos anteriores (para detectar trocas de rosto) e até mesmo solicita aos usuários ações aleatórias (como poses ou frases específicas) durante as verificações de vivacidade, tornando mais difícil para os deepfakes responderem corretamente[56][57].

Finalmente, monitoramento contínuo A análise do comportamento da conta após a integração ajuda a detectar contas sintéticas que passaram despercebidas. Como essas contas não estão vinculadas a uma pessoa real, seus padrões de uso muitas vezes acabam se destacando (por exemplo, fazer transações perfeitamente sincronizadas para aumentar o crédito e, em seguida, atingir o limite máximo). O monitoramento de fraudes orientado por IA (como as plataformas da Sift ou da Feedzai) pode identificar anomalias na forma como as contas são usadas, sinalizando possíveis sintéticos para análise. Em resumo, o combate à fraude de identidade habilitada por IA requer Comprovação de identidade habilitada para IA - combinando análise forense de documentos, verificações biométricas, correlação de dados e análise comportamental. A boa notícia é que os mesmos avanços de IA que possibilitam a fraude também estão sendo usados para detectá-la. O TruthScan, por exemplo, oferece um suíte de verificação de identidade que integra análise de texto, imagem e voz para examinar novos usuários. Ao aproveitar essas ferramentas, um grande banco observou uma queda significativa nas aberturas bem-sucedidas de contas sintéticas, mesmo quando as médias do setor estavam aumentando. A corrida armamentista continua, mas os defensores estão aprendendo a identificar os fracos "sinais digitais" de um sintético, não importa o quanto a IA tente encobrir seus rastros.

Integração da detecção de IA em toda a pilha de segurança

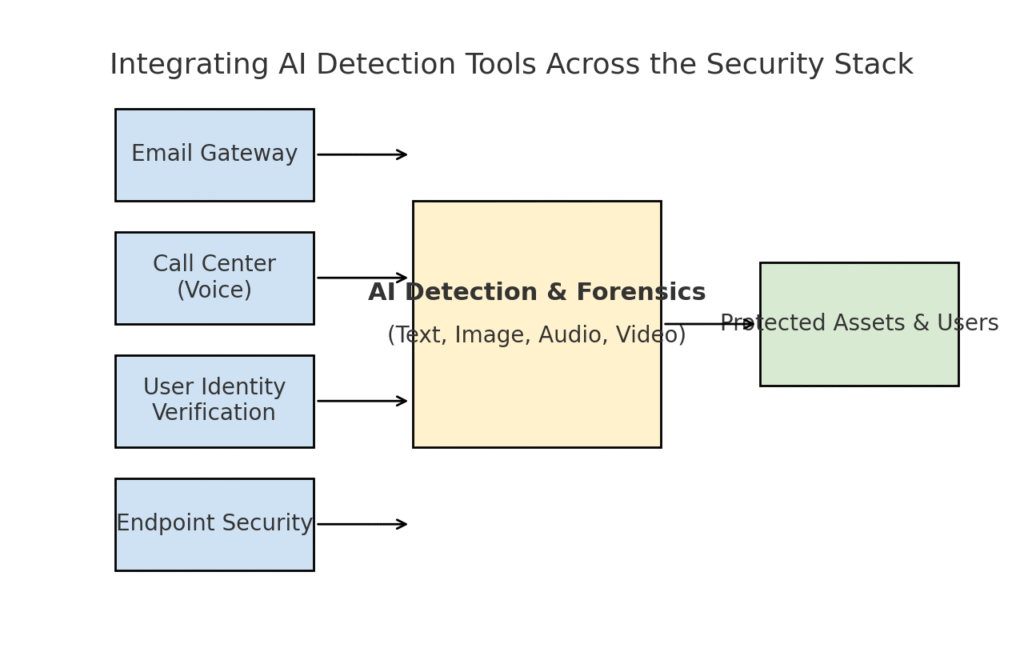

Exploramos várias áreas distintas de ameaças - phishing, deepfakes, malware, fraudes sintéticas - todas potencializadas pela IA. Está claro que nenhuma ferramenta única ou correção única resolverá o desafio. Em vez disso, as empresas precisam de uma estratégia abrangente para incorporar detecção e verificação com base em IA em todas as camadas de sua pilha de segurança cibernética. A abordagem deve refletir a superfície de ataque, abrangendo e-mail, Web, voz, documentos, identidade e muito mais. O diagrama abaixo ilustra como as organizações podem integrar as ferramentas de detecção de IA do TruthScan (e soluções semelhantes) em camadas comuns de segurança corporativa:

Integração de ferramentas de detecção de IA em várias camadas da pilha de segurança, desde gateways de e-mail e call centers até verificação de usuários e proteção de endpoints. A detecção de conteúdo de IA (centro) analisa texto, imagens, áudio e vídeo em tempo real, alimentando pontos de aplicação que protegem ativos e usuários.

Nesse modelo, Os detectores multimodais de IA funcionam como um cérebro central que faz interface com vários controles de segurança:

- Gateways de e-mail: Os e-mails recebidos passam por um detector de texto/scam de IA antes de chegar à caixa de entrada. Isso está relacionado à defesa contra phishing que discutimos - por exemplo, usar Detector de fraudes de e-mail do TruthScan via API em seu provedor de e-mail para colocar automaticamente em quarentena e-mails suspeitos gerados por IA[18]. Ele também pode ser aplicado a plataformas de mensagens (aplicativos de bate-papo, gateways de SMS) para verificar o conteúdo em busca de padrões de phishing ou fraude.

- Centrais de atendimento e sistemas de voz: Os canais telefônicos e VOIP são protegidos com a integração da detecção de deepfake de voz. Por exemplo, a linha de suporte ao cliente de um banco poderia usar Detector de voz com IA do TruthScan analisar o áudio do chamador em tempo real e alertar se a impressão de voz do chamador for sintética ou não corresponder ao seu perfil conhecido[58][59]. Isso ajuda a evitar que ataques de vishing e de personificação de voz (como chamadas falsas para o CEO) sejam bem-sucedidos.

- Processos de verificação da identidade do usuário: Durante a criação da conta ou ações de alto risco do usuário (redefinições de senha, transferências bancárias), a verificação de identidade orientada por IA entra em ação. Uma foto de identificação carregada é examinada por uma ferramenta forense de imagem (por exemplo, verificando se foi gerada por IA ou se é uma foto de uma foto), e uma selfie ou chamada de vídeo é examinada por um detector de deepfake. O sistema TruthScan Detector de deepfake pode ser utilizado aqui para realizar a autenticação facial, garantindo que a pessoa na câmera seja real e corresponda à ID[60][61]. Sinais comportamentais (cadência de digitação, consistência do dispositivo) também podem ser inseridos em modelos de IA para detectar bots ou identidades sintéticas.

- Endpoints e rede: Os agentes de segurança de endpoint e os servidores proxy podem incorporar a análise de conteúdo de IA para arquivos e scripts. Por exemplo, se um EDR de endpoint vir um novo script ou EXE sendo executado, ele poderá enviar o conteúdo de texto do arquivo a um detector de IA para verificar se ele se assemelha a um malware conhecido gerado por IA ou se apresenta características de código de IA ofuscado. Da mesma forma, os sistemas de DLP (prevenção de perda de dados) podem usar a detecção de texto de IA para sinalizar textos confidenciais gerados por IA (o que pode indicar que um insider está usando IA para redigir mensagens de exfiltração de dados ou falsificar relatórios). O sistema TruthScan Detector em tempo real foi projetado para se conectar a esses fluxos de trabalho, oferecendo análise ao vivo de conteúdo em todas as plataformas com opções de resposta automatizada[42][62] (por exemplo, bloqueio automático de um arquivo ou mensagem se for identificado como malware ou desinformação gerados por IA).

O principal benefício dessa abordagem integrada é velocidade e consistência. Os ataques de IA se movem rapidamente - e-mails de phishing, vozes falsas e dados sintéticos podem atingir muitos canais ao mesmo tempo. Ao instrumentar todos esses canais com detecção de IA, uma organização ganha visibilidade em tempo real e defesa em profundidade. Uma equipe descreveu isso como a criação de um "sistema imunológico de IA" para sua empresa: sempre que algo é comunicado (seja um e-mail, um upload de documento, uma chamada de voz etc.), o sistema imunológico de IA "fareja" as assinaturas estrangeiras (geradas por IA) e as neutraliza se forem consideradas mal-intencionadas.

A suíte corporativa do TruthScan é um exemplo disso, pois oferece um plataforma unificada abrangendo detecção de IA de texto, imagem, áudio e vídeo que pode ser implantada de forma modular ou como um todo[63][64]. Muitas empresas começam implantando um ou dois recursos (por exemplo, detecção de texto em e-mail e detecção de imagem na integração) e depois expandem para outros quando percebem o valor. É importante ressaltar que a integração é facilitada para o desenvolvedor - O TruthScan e serviços semelhantes fornecem APIs e SDKs para que as equipes de segurança possam conectar a detecção aos sistemas existentes sem a necessidade de uma reengenharia maciça. Seja um SIEM, um gateway de e-mail, um aplicativo bancário personalizado ou um sistema CRM, a detecção pode ser executada nos bastidores e alimentar alertas ou ações automatizadas. Por exemplo, uma grande plataforma de mídia social integrou APIs de moderação de conteúdo para remover automaticamente vídeos deepfake minutos após o upload[65][66]impedindo a disseminação de desinformação gerada por IA.

Conclusão: Ficando à frente da curva

A rápida proliferação de ameaças orientadas por IA em 2025 desafiou as organizações de novas maneiras. Os invasores descobriram meios de explorar a confiança humana em escala - personificando vozes e identidades, automatizando a engenharia social, evitando defesas por meio de código adaptável e fabricando realidades falsas inteiras. É uma perspectiva assustadora para os defensores, mas não desesperadora. Assim como os criminosos estão aproveitando a IA, também podemos colocar a IA do lado da segurança. O surgimento de Detecção de conteúdo de IA, análise forense de deepfake e scanners de identidade sintética nos dá poderosos contra-ataques a essas novas ameaças. Ao implementar essas ferramentas e integrando-os em todas as camadas Com o uso de um sistema de defesa de inteligência artificial, as empresas podem reduzir drasticamente o risco de ataques com tecnologia de IA. Os primeiros usuários já frustraram tentativas de fraude multimilionárias ao capturar deepfakes em flagrante[26]ou evitou desastres de phishing filtrando e-mails criados por IA.

Além da tecnologia, as organizações devem cultivar uma cultura de "confiar, mas verificar". Os funcionários devem estar cientes de que, na era da IA, ver (ou ouvir) nem sempre é acreditar - um ceticismo saudável, aliado a fluxos de trabalho de verificação, pode impedir muitos estratagemas de engenharia social. Treinamento e conscientização, combinados com ferramentas de verificação automatizada, como o TruthScanformam uma defesa formidável. De certa forma, precisamos elevar o nível de autenticação e validação das informações. As comunicações e os documentos digitais não podem mais ser considerados pelo seu valor nominal; sua procedência precisa ser verificada, seja por máquina ou por processo.

À medida que avançamos, esperamos que os atacantes refinem ainda mais suas táticas de IA, mas também esperamos inovação contínua na IA defensiva. A dinâmica de gato e rato persistirá. O sucesso dos defensores dependerá de agilidade e compartilhamento de inteligência. Aqueles que incorporarem rapidamente a nova inteligência contra ameaças (por exemplo, novas técnicas de detecção de deepfake ou assinaturas atualizadas de modelos de IA) ficarão à frente dos invasores que utilizam as ferramentas de IA mais recentes. As colaborações entre o setor, a academia e o governo também serão vitais nessa luta, conforme observado pelos alertas e estruturas que estão surgindo de agências como a estrutura de gerenciamento de riscos de IA do NIST e as colaborações entre bancos na detecção de fraudes por IA.

Para concluir, o setor de segurança cibernética está no meio de uma mudança de paradigma impulsionada pela IA. As ameaças são diferentes daquelas de uma década atrás, mas estamos enfrentando-as com defesas igualmente sem precedentes. Com uma combinação de tecnologia de detecção avançada e estratégia de segurança robusta, nós pode mitigar os riscos da IA generativa e até mesmo transformá-la em nossa vantagem. Ferramentas como o conjunto de detecção de IA do TruthScan nos permitem restaurar a confiança em um mundo de confiança zero - para garantir que a pessoa do outro lado da linha seja real, que o documento em nossa caixa de entrada seja autêntico e que o código executado em nossa rede não tenha sido adulterado por uma IA mal-intencionada. Ao investir nesses recursos agora, as organizações não apenas se protegerão dos ataques atuais habilitados por IA, mas também criarão resiliência contra as ameaças em evolução do futuro. A conclusão é clara: A IA pode estar sobrecarregando os ataques cibernéticos, mas, com a abordagem certa, ela também pode sobrecarregar nossas defesas.

Fontes: Dados e exemplos relevantes foram extraídos de 2025 relatórios e especialistas em inteligência de ameaças, incluindo o Cyber Incident Trends da Mayer Brown[1][67], resumo das ameaças de 2025 da Fortinet[2][19]Pesquisa da Barracuda sobre ataques de e-mail com IA[6][7]Relatório de ameaças de IA do Google GTIG[34]Boston Federal Reserve insights sobre fraude sintética[45][50]e os estudos de caso e comunicados de imprensa publicados pela TruthScan[30][26]entre outros. Isso ilustra o escopo das ameaças orientadas por IA e a eficácia das contramedidas focadas em IA em cenários do mundo real. Ao aprender com essa inteligência e implantar ferramentas de ponta, podemos navegar com confiança na era do risco cibernético aprimorado por IA.

[1] [67] Tendências de incidentes cibernéticos em 2025 O que sua empresa precisa saber | Insights | Mayer Brown

[2] [3] [19] Principais estatísticas de segurança cibernética: Fatos, estatísticas e violações para 2025

https://www.fortinet.com/resources/cyberglossary/cybersecurity-statistics

[4] [11] [12] [16] [17] [20] [22] [47] [48] [52] Fraude orientada por IA em serviços financeiros: Tendências e soluções recentes | TruthScan

https://truthscan.com/blog/ai-driven-fraud-in-financial-services-recent-trends-and-solutions

[5] [26] [30] [54] TruthScan detecta ataque Deepfake norte-coreano contra autoridades de defesa - Bryan County Magazine

[6] [7] [14] Metade do spam em sua caixa de entrada é gerada por IA - seu uso em ataques avançados está em um estágio inicial | Barracuda Networks Blog

https://blog.barracuda.com/2025/06/18/half-spam-inbox-ai-generated

[8] [10] Índice de confiança digital do segundo trimestre de 2025: Dados e percepções sobre fraudes de IA | Sift

https://sift.com/index-reports-ai-fraud-q2-2025

[9] [13] [24] [25] [38] [39] Ameaças à segurança cibernética da IA em 2025: $25.6M Deepfake

https://deepstrike.io/blog/ai-cybersecurity-threats-2025

[15] [21] Inteligência de ameaças mais recente | TruthScan

[18] [63] [64] TruthScan - Detecção de IA empresarial e segurança de conteúdo

[23] [46] [56] [57] Deepfakes e depósitos: Como combater a fraude de IA generativa

https://www.amount.com/blog/deepfakes-and-deposits-how-to-fight-generative-ai-fraud

[27] Ataques Deepfake e phishing gerado por IA: estatísticas de 2025

https://zerothreat.ai/blog/deepfake-and-ai-phishing-statistics

[28] [58] [59] Detector de voz com IA para falsificações profundas e clonagem de voz | TruthScan

https://truthscan.com/ai-voice-detector

[29] [31] [60] [61] [65] [66] Deepfake Detector - Identifique vídeos falsos e com IA - TruthScan

https://truthscan.com/deepfake-detector

[32] [33] [34] [35] [36] [37] [41] Rastreador de ameaças de IA do GTIG: Avanços no uso de ferramentas de IA por atores de ameaças | Google Cloud Blog

https://cloud.google.com/blog/topics/threat-intelligence/threat-actor-usage-of-ai-tools

[40] Hackers ofuscam malware com código de IA verboso

https://www.bankinfosecurity.com/hackers-obfuscated-malware-verbose-ai-code-a-29541

[42] [43] [62] Detecção de IA em tempo real - TruthScan

https://truthscan.com/real-time-ai-detector

[44] Operadores da EvilAI usam código gerado por IA e aplicativos falsos para ...

https://www.trendmicro.com/en_us/research/25/i/evilai.html

[45] [49] [50] [51] [55] A geração de IA está aumentando a ameaça de fraude de identidade sintética - Federal Reserve Bank of Boston

[53] Fraude de identidade sintética 2025: Estratégias de detecção e prevenção de IA