Οι δόλιες δραστηριότητες με βάση το Deepfake στον επιχειρηματικό κόσμο σημείωσαν τεράστια άνοδο τους τελευταίους δώδεκα μήνες.

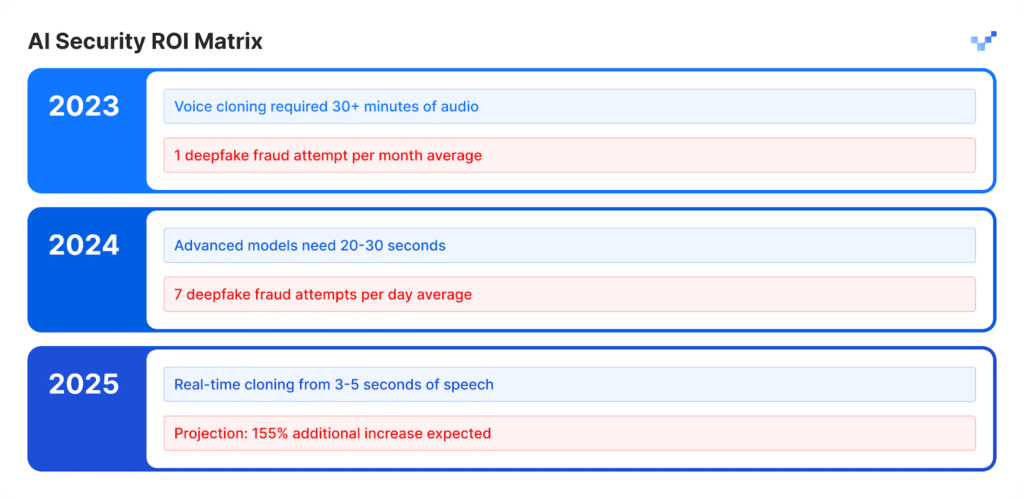

Το 2025 Voice Intelligence & Security Report από την Pindrop αποκαλύπτει ότι οι επιθέσεις που βασίζονται στη φωνή έχουν αυξηθεί κατά 1300% περισσότερο από την προηγούμενη μηνιαία εμφάνισή τους, επειδή συμβαίνουν πλέον επτά φορές την ημέρα.

Η έρευνα των 1,2 δισεκατομμυρίων κλήσεων πελατών μέσω της έκθεσης αποδεικνύει ότι η εξέλιξη αυτή αντιπροσωπεύει κάτι περισσότερο από την τυπική αύξηση του ηλεκτρονικού εγκλήματος, διότι σηματοδοτεί μια πλήρη αλλαγή στις επιχειρησιακές μεθόδους απάτης.

Το πρότυπο ανάπτυξης δεν δείχνει ότι ακολουθεί σταδιακή πορεία ανάπτυξης. Ο ταχύς ρυθμός αυτής της αναστάτωσης έχει οδηγήσει σε πλήρη μετασχηματισμό των οικονομικών συστημάτων που βασίζονται στην εμπιστοσύνη.

Πολλαπλές στατιστικές δείχνουν την πλήρη έκταση αυτής της εξελισσόμενης κρίσης.

Το Identity Theft Resource Center κατέγραψε αύξηση 148% στις απάτες με πλαστοπροσωπία κατά τη διάρκεια του χρονικού διαστήματος από τον Απρίλιο του 2024 έως τον Μάρτιο του 2025.

Το συνολικό ποσό των απωλειών από απάτες κατά τη διάρκεια του 2024 έφθασε τα $16,6 δισεκατομμύρια, ενώ παρουσίασε αύξηση 33% από τα στοιχεία του 2023.

Οι τεχνολογικές εξελίξεις της τεχνητής νοημοσύνης έχουν μετατρέψει την εξαπάτηση σε μια βιομηχανική επιχείρηση που διεξάγει τις δραστηριότητές της σε βιομηχανικό επίπεδο.

Έκθεση σε εκτελεστικό επίπεδο

Οι οικονομικές επιθέσεις deepfake έχουν στοχεύσει περισσότερα από 25% εκτελεστικά συστήματα που διαχειρίζονται τόσο οικονομικές όσο και λογιστικές λειτουργίες.

Ο αριθμός των στελεχών που προβλέπουν ότι οι οικονομικές επιθέσεις deepfake θα αυξηθούν το επόμενο έτος ξεπέρασε τα 50%.

Ανατομία μιας βιομηχανικής επίθεσης

Κλωνοποίηση φωνής: Από λεπτά σε στιγμές

Τα μοντέλα ομιλίας τεχνητής νοημοσύνης έχουν παρουσιάσει εξαιρετική ανάπτυξη κατά τη διάρκεια των προηγούμενων ετών.

Το βασικό δωρεάν λογισμικό επιτρέπει στους χρήστες να δημιουργούν συνθετικές φωνές μέσω σύντομων ηχογραφήσεων φωνής, οι οποίες παλαιότερα απαιτούσαν εκτεταμένο ηχητικό υλικό και εξειδικευμένα εργαλεία που χρειάζονταν πολλές ημέρες για να ολοκληρωθούν.

Η έξοδος τεχνητής ομιλίας ταιριάζει με τη φυσική ποιότητα των ανθρώπινων φωνητικών εκφράσεων.

Μην ανησυχείτε ποτέ ξανά για την απάτη με τεχνητή νοημοσύνη. TruthScan Μπορεί να σας βοηθήσει:

- Ανίχνευση AI που παράγεται εικόνες, κείμενο, φωνή και βίντεο.

- Αποφύγετε το σημαντική απάτη με βάση την τεχνητή νοημοσύνη.

- Προστατέψτε τα πιο ευαίσθητο περιουσιακά στοιχεία της επιχείρησης.

Αντίκτυπος ανά κλάδο:

- Ο ασφαλιστικός τομέας είδε τις επιθέσεις συνθετικής φωνής να αυξάνονται κατά 475% καθ' όλη τη διάρκεια αυτής της περιόδου.

- Ο τραπεζικός κλάδος κατέγραψε αύξηση κατά 149% σε δραστηριότητες απάτης που βασίζονται στη φωνή.

- Τα κέντρα επαφής θα αντιμετωπίσουν πιθανές απώλειες από απάτες ύψους $44,5 δισεκατομμυρίων ευρώ κατά τη διάρκεια της επόμενης πενταετίας.

- Τα περιστατικά ασφαλείας κοστίζουν στις επιχειρήσεις κατά μέσο όρο $600.000 ανά περιστατικό.

Το νέο πρόσωπο της απάτης: Απάτη: Εκλεπτυσμένη και γυαλισμένη

Οι απατεώνες χρησιμοποιούν πλέον προηγμένες επιθέσεις deepfake που ξεπερνούν τα βασικά μηνύματα ηλεκτρονικού ταχυδρομείου απάτης, επειδή οι επιθέσεις τους έχουν άψογη γραμματική και εμφανίζονται σε κατάλληλες στιγμές, ενώ φαίνονται εξαιρετικά αυθεντικές.

Αυτές οι επιθέσεις λειτουργούν με σκοπό να παρακάμψουν τόσο τα προγραμματισμένα συστήματα ασφαλείας όσο και τις ανθρώπινες διαδικασίες κρίσης.

Μελέτη περίπτωσης: WPP

Οι εγκληματίες επιχείρησαν να εκτελέσουν ένα περίτεχνο σχέδιο απάτης μέσω της δημιουργίας ενός ψεύτικου λογαριασμού WhatsApp υπό τον CEO της WPP συνδυάζοντας έναν κλώνο φωνής που μιμούνταν τη φωνή του Mark Read με την αναπαραγωγή βίντεο στο YouTube για ψεύτικες εκφράσεις του προσώπου του Mark Read, ενώ χρησιμοποίησαν καταγεγραμμένα βίντεο από δημόσιους τομείς.

Οι επιτιθέμενοι πραγματοποίησαν την επίθεσή τους μέσω του Microsoft Teams και έστειλαν πειστικά ψεύτικα μηνύματα μέσω μεθόδων πλαστοπροσωπίας και τακτικών κοινωνικής μηχανικής για να δημιουργήσουν μια ψευδή αίσθηση επείγοντος επιχειρηματικού χαρακτήρα.

Οι επιτιθέμενοι έφτασαν σε ένα σημείο όπου σχεδόν πέτυχαν τον στόχο τους.

Η εξαπάτηση των επιτιθέμενων δεν πέτυχε επειδή εισήγαγαν μικρές ασυνέπειες στην αφήγησή τους, οι οποίες έκαναν το θύμα να αμφισβητήσει την ιστορία τους.

Το περιστατικό απέδειξε ότι οι προηγμένες τεχνικές εξαπάτησης της τεχνητής νοημοσύνης μπορούν να ξεγελάσουν ακόμη και έμπειρους επαγγελματίες λόγω της ρεαλιστικής και περίπλοκης φύσης τους.

Ασία-Ειρηνικός: Ασία: Το παγκόσμιο hotspot

Η περιοχή Ασίας-Ειρηνικού έχει γίνει το παγκόσμιο κέντρο για τις δραστηριότητες απάτης με βάση την τεχνητή νοημοσύνη. Ο αριθμός των επιθέσεων που σχετίζονται με την ΤΝ κατά τη διάρκεια του 2024 αυξήθηκε κατά 194% σε σύγκριση με το 2023.

Γιατί εδώ; Η ταχεία υιοθέτηση των ψηφιακών πληρωμών σε συνδυασμό με τα ανεπαρκή συστήματα προστασίας από την απάτη στην περιοχή την κατέστησαν ιδανικό περιβάλλον για τη δράση των επιτιθέμενων.

Βασικά περιφερειακά δεδομένα:

- Η μέση οικονομική ζημία από κάθε περιστατικό ανέρχεται σε $600.000.

- Η ανάκτηση των κλεμμένων κεφαλαίων παραμένει κάτω από 5% σε όλες τις περιπτώσεις.

- Οι οικονομικές απώλειες που σχετίζονται με το Deepfake και ξεπερνούν το $1 εκατομμύριο επηρέασαν περισσότερα από 10% χρηματοπιστωτικά ιδρύματα.

Η περιοχή αποτελεί σημαντικό στόχο για απάτες με βάση την τεχνητή νοημοσύνη, επειδή οι εργαζόμενοι εργάζονται εξ αποστάσεως και τα εργαλεία σύνθεσης φωνής είναι εύκολα προσβάσιμα.

Πέρα από τη φωνή: Απάτη πολλαπλών διανυσμάτων είναι εδώ

Α 704% Αύξηση των επιθέσεων ανταλλαγής προσώπων

Ο αριθμός των επιθέσεων ανταλλαγής προσώπων αυξήθηκε κατά 704% κατά τη διάρκεια του 2023 σύμφωνα με την iProov, ενώ η απάτη με ένεση στο διαδίκτυο μέσω κινητών τηλεφώνων αυξήθηκε κατά 255%.

Ο συνολικός αριθμός των προσπαθειών απάτης περιλαμβάνει τώρα 42,5% απόπειρες που δημιουργούνται από τεχνητή νοημοσύνη και οι οποίες πετυχαίνουν σε 30% των περιπτώσεων.

Τα αναφερόμενα περιστατικά ασφαλείας καταδεικνύουν μια συνεχή εξέλιξη των απειλών που επηρεάζουν διάφορα συστήματα.

Ο πίνακας τρωτότητας των επιχειρήσεων

- Ο τομέας του λιανικού εμπορίου είδε αύξηση των δόλιων δραστηριοτήτων κατά 107% κατά τη διάρκεια του 2024 και οι ειδικοί προβλέπουν ότι οι περιπτώσεις απάτης θα διπλασιαστούν το 2025.

- Οι επιτιθέμενοι χρησιμοποιούν deepfakes για να παρακάμψουν τα συστήματα επαλήθευσης ταυτότητας που προστατεύουν από τις διαδικασίες KYC.

- Τα συστήματα τεχνητής νοημοσύνης παράγουν τεχνητά προφίλ προσώπου τα οποία καταφέρνουν να εξαπατούν τα συστήματα αναγνώρισης προσώπου.

- Οι επιτιθέμενοι χρησιμοποιούν συνθετικό περιεχόμενο για τη δημιουργία παραπλανητικών νομικών εγγράφων και διαπιστευτηρίων μέσω μεθόδων παραποίησης εγγράφων.

Η υπόθεση Μπραντ Πιτ: Πιτ: Ψυχολογική απάτη με βάση την Τεχνητή Νοημοσύνη

Ένας Γάλλος σχεδιαστής εσωτερικών χώρων έπεσε θύμα μιας εξελιγμένης απάτης τεχνητής νοημοσύνης, όταν μετέφερε σχεδόν $1 εκατομμύριο σε απατεώνες κατά τη διάρκεια πολλών μηνών.

Η στρατηγική επίθεσης:

- Ο απατεώνας επικοινώνησε αρχικά με το θύμα προσποιούμενος τη μητέρα του Μπραντ Πιτ.

- Ο βαθύς ψεύτικος ήχος και οι εικόνες που δημιουργήθηκαν από τεχνητή νοημοσύνη βοήθησαν στη διατήρηση της ψευδαίσθησης με την πάροδο του χρόνου.

- Τα πλαστά ιατρικά αρχεία και τα έγγραφα που έμοιαζαν με νομικά έγγραφα προσέθεσαν ένα επίπεδο αξιοπιστίας στο σύστημα.

- Το περιεχόμενο πολυμέσων διατήρησε την ψευδή ταυτότητα πιστευτή για αρκετούς μήνες.

Ένα άτομο που δεν ήταν νέο στην τεχνολογία έπεσε θύμα μιας απλής απάτης.

Το θύμα λειτουργούσε ως ιδιοκτήτης επιχείρησης, ο οποίος αγνοούσε ότι αλληλεπιδρούσε με την τεχνητή νοημοσύνη.

Το περιστατικό καταδεικνύει το προηγμένο επίπεδο εξαπάτησης που μπορεί να επιτύχει η σύγχρονη τεχνολογία deepfake.

Το κενό ανίχνευσης: Γιατί οι περισσότερες εταιρείες είναι απροετοίμαστες

Κρίση ευαισθητοποίησης στην κορυφή

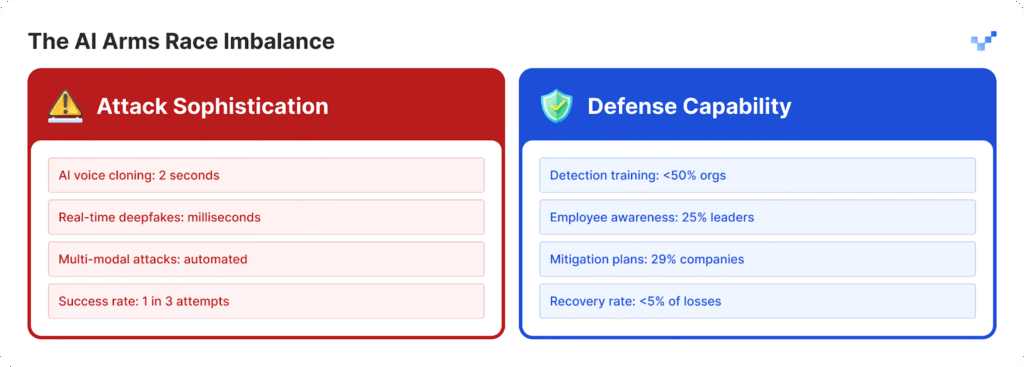

Οι οργανισμοί δυσκολεύονται να προστατευτούν από τις αυξανόμενες επιθέσεις επειδή δεν έχουν αναπτύξει επαρκείς στρατηγικές άμυνας.

- Οι ηγέτες σε 25% των οργανισμών δείχνουν περιορισμένη κατανόηση για τις λειτουργίες της τεχνολογίας deepfake.

- Οι οργανισμοί δυσκολεύονται να προσδιορίσουν την ικανότητά τους να ανιχνεύουν επιθέσεις deepfake επειδή 32% από αυτές παραμένουν αβέβαιες.

- Περισσότεροι από τους μισούς οργανισμούς δεν παρέχουν στα μέλη του προσωπικού τους εκπαίδευση σχετικά με τις απειλές που βασίζονται στην ΤΝ.

- Οι περισσότεροι οργανισμοί δεν έχουν καθιερωμένα σχέδια ή συγκεκριμένα πρωτόκολλα για να χειρίζονται τις απειλές deepfake.

Για τους οργανισμούς που αρχίζουν να καλύπτουν αυτό το κενό ετοιμότητας, εργαλεία όπως τα TruthScan προσφέρουν ένα κρίσιμο πρώτο βήμα.

Σχεδιασμένο για ανίχνευση περιεχομένου τεχνητής νοημοσύνης σε πραγματικό χρόνο, το TruthScan επισημαίνει ύποπτα οπτικά στοιχεία, κείμενο και μέσα ενημέρωσης σε πολλαπλές μορφές, βοηθώντας τις ομάδες να εντοπίσουν τη συνθετική χειραγώγηση πριν προκαλέσει ζημιά.

Η τρωτότητα του ανθρώπινου παράγοντα

Η έρευνα της McAfee δείχνει ότι 70% των ανθρώπων αδυνατούν να διακρίνουν μεταξύ αυθεντικών φωνών και φωνητικών κλώνων.

Το πρόβλημα κλιμακώνεται επειδή 40% των ανθρώπων θα απαντούσαν σε ένα φωνητικό μήνυμα όταν νομίζουν ότι ανήκει σε κάποιον που αγαπούν και χρειάζεται βοήθεια.

Η πιο επικίνδυνη απειλή για την ασφάλεια των επιχειρήσεων προκύπτει σήμερα από τον συνδυασμό ρεαλιστικού περιεχομένου που δημιουργείται από τεχνητή νοημοσύνη με τεχνικές ψυχολογικής χειραγώγησης.

Το τεχνολογικό χάσμα διευρύνεται

Το πρόβλημα των $40 δισεκατομμυρίων

Η Deloitte προβλέπει ότι η απάτη με βάση την τεχνητή νοημοσύνη θα φτάσει τα $40 δισεκατομμύρια στις Ηνωμένες Πολιτείες μέχρι το 2027, ενώ η τρέχουσα εκτίμηση για το 2023 ανέρχεται σε $12,3 δισεκατομμύρια.

Ο ετήσιος ρυθμός ανάπτυξης για την περίοδο αυτή θα φθάσει τους 32% σύμφωνα με τις προβλέψεις.

Ο οικονομικός αντίκτυπος περιλαμβάνει:

- Η άμεση οικονομική ζημία προκύπτει από τις δραστηριότητες συνθετικής απάτης.

- Συμβαίνει κλοπή προσωπικών ταυτοτήτων μαζί με εκτεταμένη κατάχρηση προσωπικών πληροφοριών.

- Οι επιχειρηματικές δραστηριότητες υφίστανται διαταραχές λόγω του χρόνου που απαιτείται για την εγκληματολογική έρευνα.

- Οι επιχειρήσεις πρέπει να πληρώνουν κανονιστικές κυρώσεις επειδή δεν εφαρμόζουν κατάλληλα μέτρα προστασίας δεδομένων.

- Οι επιχειρήσεις υφίστανται μόνιμη βλάβη στη φήμη τους μετά τη δημοσιοποίηση των πληροφοριών τους.

Κέντρα επαφής σε κίνδυνο

Ο αριθμός των περιπτώσεων απάτης στο λιανικό εμπόριο θα φτάσει τη μία σε κάθε 56 κλήσεις εξυπηρέτησης πελατών έως το 2025. Η κρίση του κέντρου επαφών θα επιδεινωθεί επειδή οι δραστηριότητες απάτης που υποστηρίζονται από την τεχνητή νοημοσύνη θα αυξηθούν σε υψηλούς όγκους.

Οι κυβερνήσεις αρχίζουν να αντιδρούν

Στις ΗΠΑ.

- Η Ομοσπονδιακή Επιτροπή Εμπορίου θέσπισε νέους κανόνες που εμποδίζουν τους χρήστες να χρησιμοποιούν λογισμικό μίμησης φωνής.

- Το FBI προειδοποιεί πλέον το κοινό για επιθέσεις phishing που χρησιμοποιούν τεχνολογία τεχνητής νοημοσύνης.

- Αρκετές αμερικανικές πολιτείες έχουν θεσπίσει νέα νομοθεσία που επικεντρώνεται στη ρύθμιση της τεχνολογίας deepfake.

Παγκοσμίως

- Ο νόμος της ΕΕ για την τεχνητή νοημοσύνη απαιτεί όλο το περιεχόμενο που παράγεται με τεχνητή νοημοσύνη να φέρει εμφανή σημάδια ότι έχει παραχθεί από τεχνητή νοημοσύνη.

- Πολλά έθνη έχουν αναπτύξει διεθνείς συμφωνίες που τους επιτρέπουν να επιβάλλουν τους νόμους τους σε διάφορες χώρες.

- Οι πλατφόρμες τεχνητής νοημοσύνης πρέπει να αποδεικνύουν ότι τα συστήματά τους διαθέτουν μέτρα για την αποτροπή μη εξουσιοδοτημένης χρήσης της τεχνολογίας τους.

Η ευκαιρία συμμόρφωσης

Οι οργανισμοί που εφαρμόζουν σήμερα προηγμένα συστήματα ανίχνευσης απάτης με τεχνητή νοημοσύνη θα καθιερωθούν ως ηγέτες της αγοράς.

Οι οργανισμοί θα ανταποκριθούν στους επερχόμενους κανονισμούς πριν από τους άλλους, επειδή οι ανταγωνιστές τους πρέπει να ξοδέψουν χρόνο για να τους προλάβουν.

Ένα νέο πρότυπο ασφάλειας

Η αύξηση των επιθέσεων deepfake 1300% έχει μετατρέψει τις επιχειρήσεις ψηφιακής εμπιστοσύνης σε κάτι περισσότερο από ένα απλό θέμα κυβερνοασφάλειας.

Η στρατηγική στροφή:

- Οι σύγχρονες απειλές έχουν ξεπεράσει τα σημερινά συστήματα περιμετρικής άμυνας, τα οποία δεν παρέχουν πλέον επαρκή προστασία.

- Οι ειδικοί ασφαλείας που έχουν περάσει χρόνια στον τομέα τους αντιμετωπίζουν τώρα επιθέσεις deepfake στις οποίες δεν μπορούν να αμυνθούν.

- Η τρέχουσα προσέγγιση "εμπιστεύομαι αλλά επαληθεύω" δεν είναι πλέον αποτελεσματική, διότι η επαλήθευση πρέπει να γίνει μόνιμη επιχειρησιακή διαδικασία.

- Πρέπει να αναπτυχθούν συστήματα ανίχνευσης σε πραγματικό χρόνο, επειδή οι χειροκίνητες μέθοδοι εντοπισμού δεν μπορούν να ανιχνεύσουν απειλές πριν αυτές γίνουν απειλές.

Το μέλλον ανήκει στους προετοιμασμένους

Οι οργανισμοί πρέπει να επιλέξουν μεταξύ της άμεσης ανάπτυξης συστημάτων ανίχνευσης AI για να σταματήσουν την απάτη deepfake από το να φτάσει την προβλεπόμενη αύξηση 155% το 2025 ή να διακινδυνεύσουν τη δημόσια αποκάλυψη των συστημάτων τους.

Οι οργανισμοί που θα δράσουν τώρα θα υπερασπιστούν την οικονομική τους υγεία, ενώ παράλληλα θα οικοδομήσουν συστήματα εμπιστοσύνης που θα εξασφαλίσουν τη θέση τους ως ηγέτες στη μελλοντική αγορά που βασίζεται στην τεχνητή νοημοσύνη.

Οι εταιρείες που εντόπισαν πρώτες τις απειλές ΤΝ και ανέπτυξαν γρήγορα λύσεις θα επιτύχουν στη μάχη ΤΝ εναντίον ΤΝ.

Αναφορές

- Pindrop (12 Ιουνίου 2025): "Pindrop's 2025 Voice Intelligence & Security Report" - 1,300% deepfake fraud surge, call analysis data

- Unite.AI (20 ώρες πριν): "Deepfakes, Voice Clones Fuel 148% Surge in AI Impersonation Scams" - Identity Theft Resource Center statistics

- Ομάδα-IB (6 Αυγούστου 2025): "The Anatomy of a Deepfake Voice Phishing Attack" - Asia-Pacific 194% surge, financial impact data

- J.P. Morgan (2025): "AI Scams, Deep Fakes, Impersonations" - $16,6 δισεκατομμύρια απώλειες απάτης, 33% αύξηση

- Incode (20 Δεκεμβρίου 2024): "Top 5 Cases of AI Deepfake Fraud From 2024" - έρευνα στελεχών της Deloitte, λεπτομέρειες της υπόθεσης WPP

- Eftsure US (2025): "Deepfake statistics (2025): Κενά κατάρτισης, στατιστικές εμπιστοσύνης των εργαζομένων

- Security.org (26 Αυγούστου 2025): "2024 Deepfakes Guide and Statistics" - Στατιστικά στοιχεία θυμάτων κλωνοποίησης φωνής, ρυθμιστικό τοπίο

- Αμερικανικός Δικηγορικός Σύλλογος (2025): "What Deepfake Scams Teach Us About AI and Fraud" - Μελέτη περίπτωσης Brad Pitt, νομικές επιπτώσεις

- Axios (15 Μαρτίου 2025): "AI voice-cloning scams: FTC.